研究背景

- 当前点击率预估模型没有完全挖掘特征交互的潜力

- 特征的表征学习与特征的交互存在冲突

- 笛卡尔积的方法比当前的点击率预估模型效果都好

- 算法模型的效率和效果的平衡

- 阿里巴巴线上业务量级和耗时的考虑

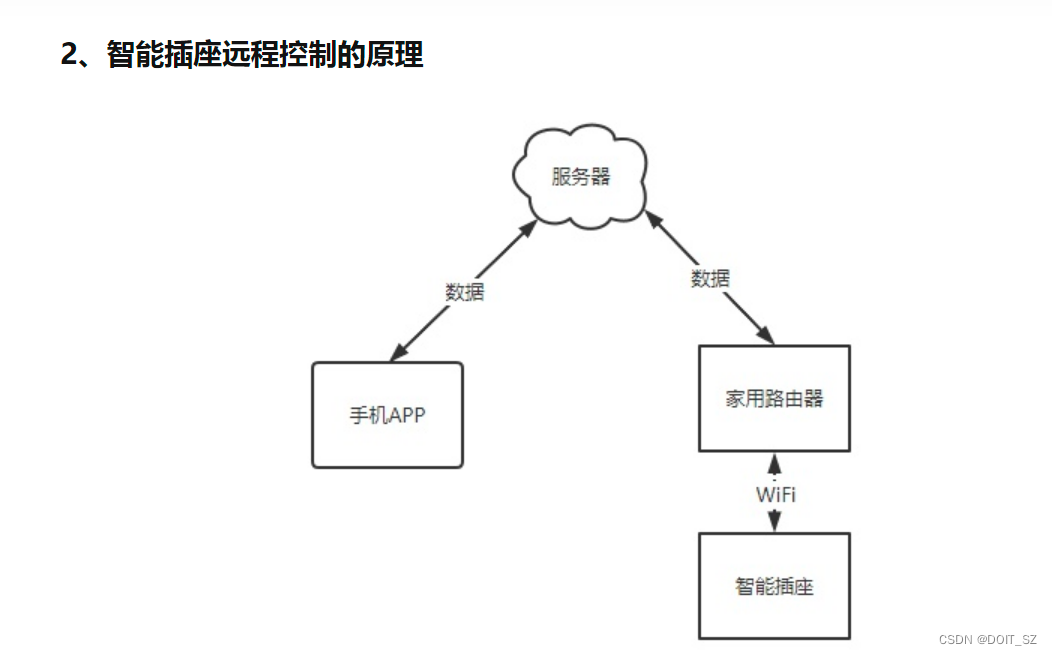

当前模型的特征交互的相关方法

论文研究成果

这篇论文的主要贡献

- 强调了特征交叉建模的重要性

- 提出一个轻量级的模型(CAN)

- 在公开数据集和工业环境进行了验证有效性

- 提出了一种工业部署技术

研究意义

• 想为特征交互走一条新的路

• 工业落地的产物

摘要核心

- 网络结构的非线性抽取特征是一种隐式特征表征

- 当前的ctr模型无法完全捕获特征的相互组合

- 作者提出一种网络结构Co-Action Network

- Co-Action Network 综合参数,存储,计算等的考量,能够进行在线部署

- 阿里巴巴线上效果ctr 提升12% , RPM 提升8%

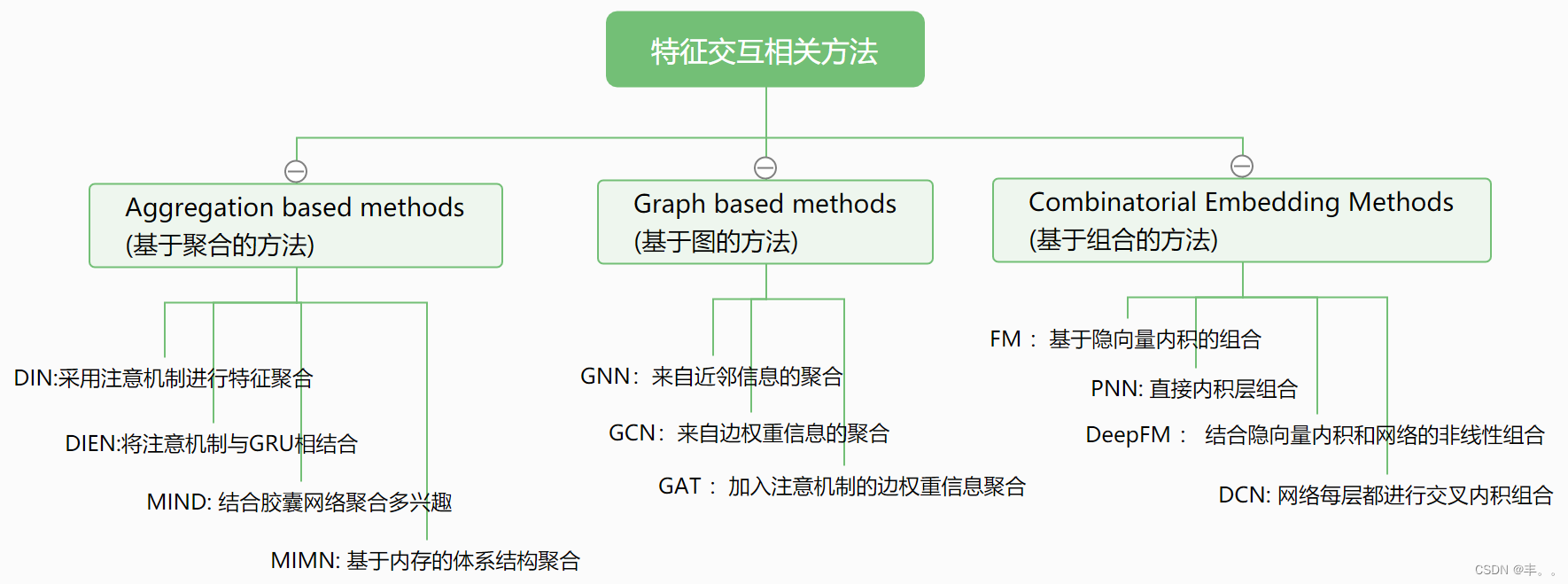

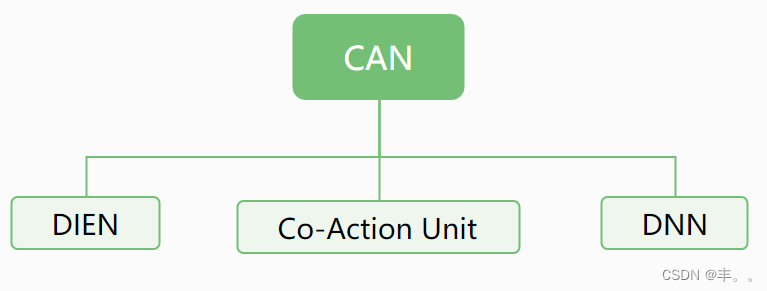

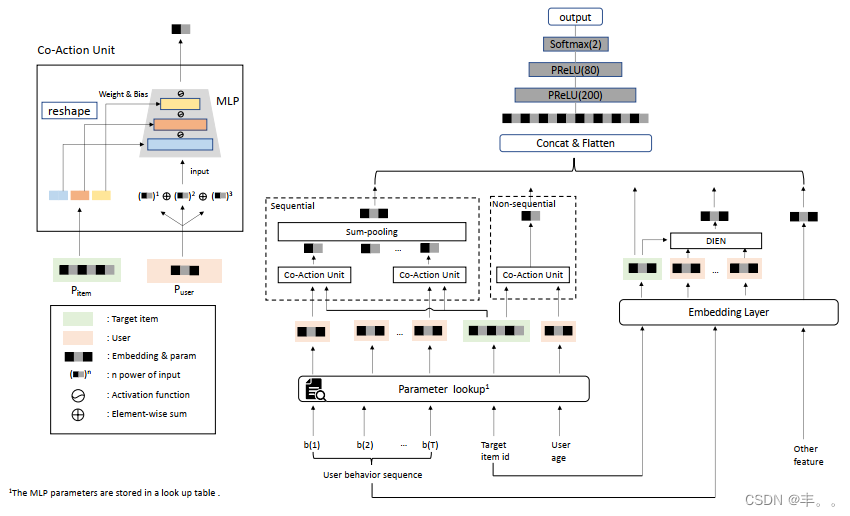

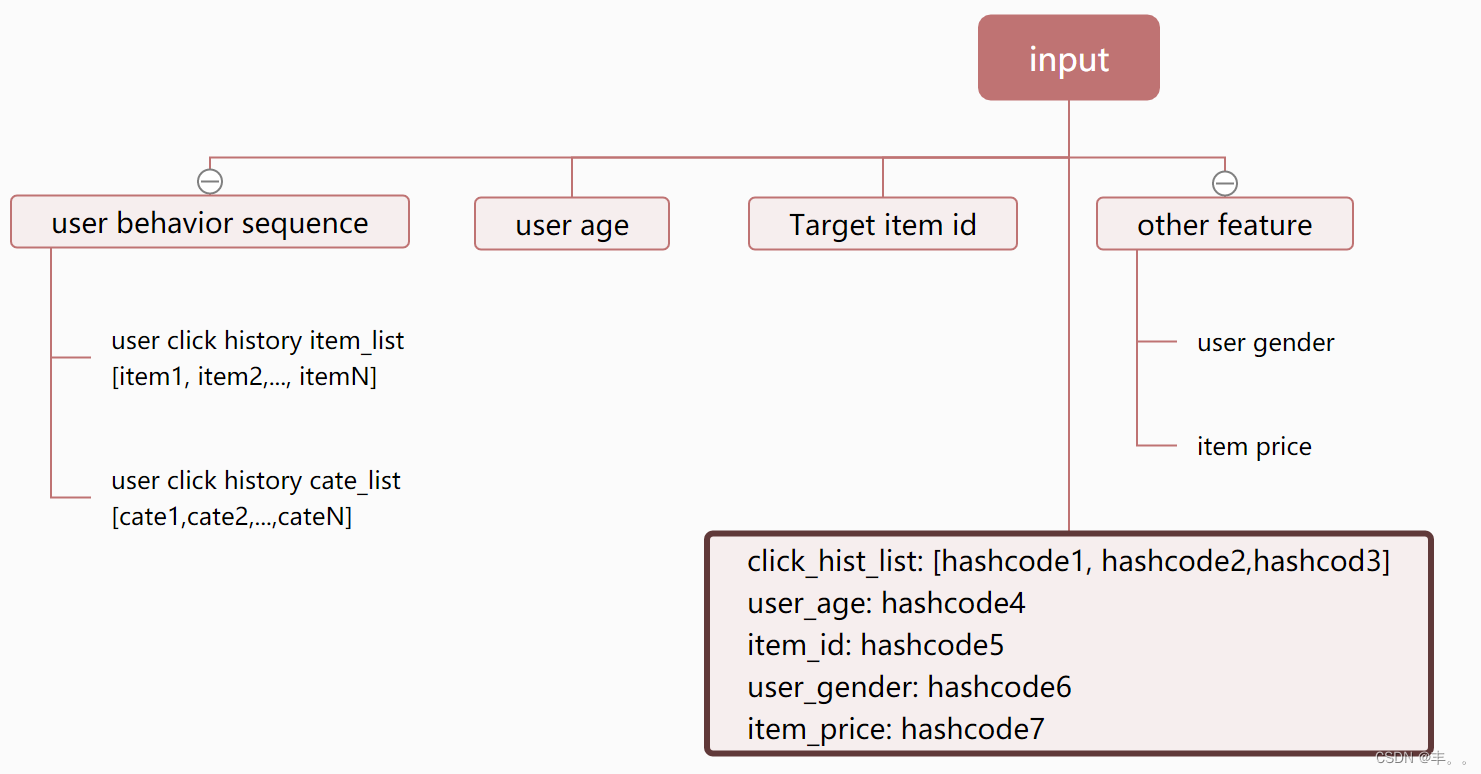

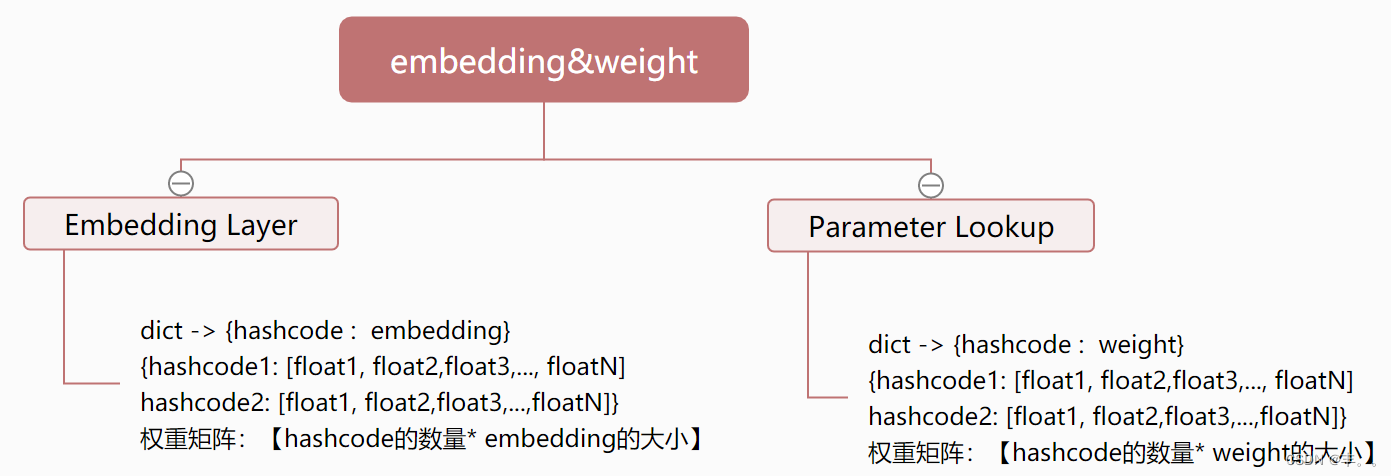

模型结构

Co-Action Unit结构

实验结果

概念引入-消融实验

消融实验类似于“控制变量法”。

假设在一个算法中,使用了A,B,C,取得了不错的效果,但是这个时候并不知道这不错的效果是由于A,B,C中哪一个起的作用,于是你保留A,B,移除C进行实验来看一下C在整个系统中所起的作用。

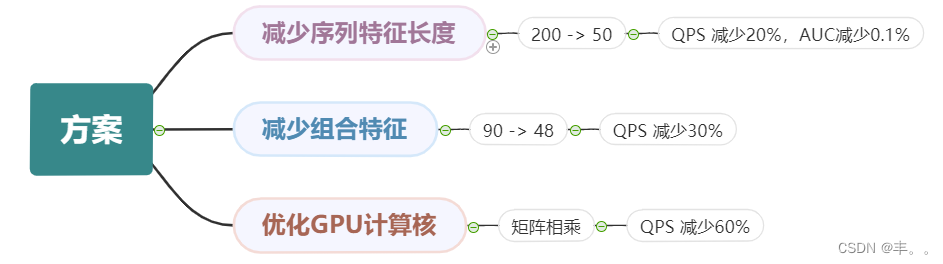

线上部署方案

核心思路:尽可能的减少参数的量,从而达到减少计算量和存储量的目的

原文(机翻)

CAN:重新访问功能协同作用的点击率预测

周国瑞,卞维杰∗

吴凯伦,任乐健,皮琦,张玉晶,肖灿,盛祥荣,莫娜,罗新辰,张驰,乔先杰,项世明,盖坤,

朱晓强,徐健

阿里巴巴集团

中国,北京

摘要

受深度学习成功的启发,近年来,工业点击率 (i ndust ri al Cl i ck -

Through R at e, C TR )预测模 型已经 从传统 的浅层 方法过 渡到深 层方

法。深 度神 经网络(De ep Neural Net works , DNNs )具有 自动学 习原

始特 征非 线 性交 互作 用的 能 力, 然而 , 非线 性特 征交 互 作用 是以

隐式 方式 学 习的 。原 始特 征 之间 的非 线 性交 互很 难捕 捉 ,对 原始

特征之间 的交互 进行显 式建 模有利 于 C TR 预测。协同 作用是 指特

征对最终 预测的 集体效 应。 认为现 有的 C TR 模型没有 充分挖 掘特

征协 同作 用 的潜 力。 我们 进 行了 实验 , 表明 特征 协同 作 用的 效果

被 严 重 低 估 了 。 基 于 我 们 的 观 察 , 提 出 了 特 征 协 同 作 用 网 络

(feat ure Co -Action Net work,简称 C A N)来探索 特征协 同作用 的潜

力。 提出 的 模型 可以 高效 有 效地 捕捉 特 征协 同作 用, 提 高了 模型

性能 ,同 时 降低 了存 储和 计 算消 耗。 在 公共 数据 集和 工 业数 据集

上的实验 结果表 明,该 C AN 模 型的性 能大大 优于现 有的 C TR 模

型 。到 目 前 为 止 ,C AN 已 经 部 署 在 阿里 巴 巴 展 示 广告 系 统 中,

CTR 平均提升 了 12% ,RP M 平均提 升了 8 %。

关键字

CTR预测,神经网络,特征交叉

1 介绍

随着 机器 学习 模 型, 特别 是 推荐 系统 中的 模 型越 来越 复 杂, 如何

有效 高效 地处 理 丰富 的输 入 特征 成为 一个 至 关重 要的 问 题。 对于

工业 环境 下的 在 线推 荐, 模 型通 常是 在十 亿 规模 的二 值 化稀 疏特

征上进 行训 练, 采用 one-hot 编码[3,22]。每 个特征 也可 以看 作是

一个唯 一的 ID ,先 映射 到低 维嵌入 ,然 后再 馈送到 模型 中。 处理

大规 模输 入的 一 个简 单方 法 是考 虑每 个特 征 是独 立的 。 在这 种假

设下 ,特 征之 间 不存 在联 系 ,因 此可 以直 接 训练 一个 广 义线 性模

型,根据特征 的组 合(例如 ,拼 接)来估 计点 击率 。

然而,在推荐系统中,像“推荐 项目”和“用户点击 历史”这样

的特征是高度 相关的[21,22]。,存在特征对最终预测目标的集体效

应,如

∗ 周国瑞和卞维杰对这项研究做出了同样的贡献。 通讯作者 :周国瑞。{g uo rui 。 xg r,。尾戒缠住

了 bwj kailun。 wu k ai lun lejian。rlj } @alibab a— —i n c. c o m

作为点击率,即功能协同。比如,一个点击历史中有“泳 衣”的女

性用户,由于“泳 衣”和“护 目镜”的共同 作用,很可能 会点击一

个推荐的“护目镜 ”。特征协 同可以被认为 是对一组原始 特征的子

图进行建模。如果子图只由两个特征组成,那么对特征协同作用的

建模相当 于对两个 id 之间的 边进行 建模。 协同作用 的效果 解释了

一组特征如何与优化目标相关联。如图 1 所示,特征协 同作用显式

地将特征对[𝐴,𝐴 ]桥接到目标 标签上。

近年 来, 一些 研 究工 作致 力于 模型 特 征协 同。 这些 方 法可 以分

为三 类。 基于 聚 集的 方法[5,10,11,21,22]主 要研 究如 何聚 集用 户的

历史行 为序 列, 以获 得 C TR 预测 的判 别表 示。这 些方 法利 用特 征

协同作用(feature co -acti on) 来建 模 每 个 用 户 动 作 在历 史 行 为 序列

中的 权 重。 然后 对 加权 后 的用 户行 为 序列 进 行和 池 化, 以表 示用

户兴 趣。 基于 图的 方 法[6,9,15]将特 征视 为 节点 ,连 接成 有向 图或

无向 图 。在 这种 情 况下 , 特征 协同 作 用作 为 沿边 传 播信 息的 边权

值。 与 将特 征协 同 作用 建 模为 权重 的 聚合 和 基于 图 的方 法不 同,

组合 嵌入 方法[12,14,19]通过显 式组 合特 征 嵌入 来对 特征 协同 作用

建模。

尽管已有 方法在 不同程 度上 改善了 C TR 预测,但仍 存在一 些不

足之 处 。基 于聚 合 的方 法 和基 于 图的 方法 仅 通过 边 权值 对 特征的

相互 作 用进 行建 模 ,但 边 仅用 于 信息 聚合 而 不用 于 信息 增 强。另

一方 面, 组 合嵌 入 方法 结合 两 个特 征 的嵌 入来 建 模特 征 协同 作用 。

例 如,P NN[12] 执行 两 个 特 征的 内 积 或 外 积来 增 强 输 入。 组 合嵌

入方 法 的一 个主 要 缺点 是 嵌入 同 时承 担了 表 示学 习 和协 同 建模的

责任 。表 示 法学 习 和协 同建 模 可能 会 相互 冲突 , 从而 限 制了 性能 。

在本 文中 ,我 们 强调 了特 征协 同建 模 的重 要性 ,并 认 为最 先进

的方 法 严重 低估 了 协同 的 重要 性。 由 于表 达 能力 有 限, 这些 方法

无法 捕 捉到 特征 协 同。 捕 获特 征协 同 以增 强 输入 的 重要 性在 于,

它可 以 降低 模型 学 习和 捕 获协 同的 难 度。 假 设存 在 一个 最优 函数

∗ ( ) 建模特征 A 和 特征 B 之 间的 相互 作用, 即学 习

arXiv: 2011.05625 v1 [cs。IR] 11 11 月

2020

2021 年 4 月 21 日会议,斯洛文尼亚卢布尔雅那

图 1:特征协同作用的示意图。

通过在输入阶段显式地 提供𝐴 ∗ (𝐴,𝐴 ),可以大大 减轻难度。

为了 验证 我们 的假 设, 即当 前的 方法 无法 完全 捕获 特征 协同 作

用, 我们 重新 研 究了 最先 进 的方 法并 设计 了 实验 ,以 表 明探 索特

征协 同作 用潜 力 的简 单方 法 可以 提高 性能 。 例如 ,如 果 选择 了特

征𝐴和𝐴 ,那 么𝐴和𝐴 的共 现被 视为 一个 新 特征 并馈 送到 模型 中。

我们 将这 一基 线 称为 笛卡 尔 积模 型。 虽然 笛 卡尔 积是 做 协同 建模

最直 接的 方法 , 但它 有一 些 严重 的缺 陷, 比 如参 数量 巨 大, 完全

独立 嵌入 ,特 征 频率 学习 低 。然 而, 令人 惊 讶的 是, 根 据本 文的

一些 初步 实验 , 我们 发现 大 多数 最先 进的 组 合嵌 入方 法 都完 全被

笛卡 尔积 打败 了 。我 们推 测 ,这 种情 况可 能 是由 于表 达 性差 ,无

法学习这些方 法的 嵌入平 衡表 示和 协同 建模。

为 此 , 提 出 特 征 协 同 作 用 网 络 (feat ure C o -Acti on Net work ,

C AN),该网络 能够 在输入 阶段 捕捉特 征的 协同作 用, 有效利 用不

同特征对 之间 的互信 息和公 共信 息。C AN 对向 量生成 网络进 行参

数化 ,而 不 是直 接对 乘积 向 量进 行参 数 化。 重新 参数 化 减少 了额

外的参数 ( 2× ) 来 ( ×𝐴 )(N 为 特征数 ,D / T 为带 D 的参数

尺寸,T ≪ N 和 D < T),同 时实现 更好 的性 能。具 体而 言,C AN

区分 用于 表 示学 习的 嵌入 空 间和 用于 协 同行 为建 模的 嵌 入生 成网

络 ,其 中 , 协同 行 为 嵌 入空 间 衍 生了 嵌 入 生 成网 络 。 这样 C AN

丰富 表示 学习 的 表达 能力 , 缓解 表示 学习 和 协同 学习 之间 的 冲突 。

与笛卡尔 积模 型相比 ,由于 参数 利用率 的提高 ,C AN 显著降 低存

储和计算开 销。

本工作的主要贡献总结如下:

•我 们 强 调特 征 协 同 建 模 的 重 要性 , 这 被 最 先 进 的方 法 严 重

低估 了 。具 体 地 说, 我 们回 顾 了现 有 的建 模 特征 协 同 的方

法。 实 证结 果 表 明, 这 些方 法 无法 捕 捉笛 卡 尔积 基 线 的性

能 。这 表 明 ,现 有 的 C TR 模 型 没有 充 分 挖掘 原 始 特 征协

同作用的 潜力 。

•基 于我 们 的 观 察 ,我 们 提 出 了 一个 轻 量 级 的模 型 , 协 同作

用网络 (C AN) , 来 建 模 原 始 特 征 之 间 的 协 同 作 用 。 所 提

出的模型 可 以有 效 地

周国瑞、卞伟杰等。

并有 效 捕捉 特 征 协同 作 用, 在 提高 模 型 性能 的 同时 降 低了

存储和计算消 耗。

•我们在 公共 数据 集和 工业环 境上 进行 了广 泛的 实验 。一 致的

优效性 验证了 C AN 的疗效 。到 目前 为止 ,C AN 已经 部署

在阿里 巴巴 展示 广告系 统中 。C AN 的 部署 带来了 平均 12%

的 CTR 和 8 % 的 RP M 升力 。

•我们介绍了 在工业 环境 中部署 C AN 的技 术。C AN 利用 特征

协同 作 用的 想 法 和我 们 学到 的 经验 教 训 可以 推 广到 其 他设

置,因此对 研究人 员和工 业从 业者都 感兴趣 。

2 相关工作

模型特征 协同用于 C TR 预测已 有一些 研究工 作。这 些方法 可以分

为三 类:基于聚 合的 方法 、基 于图 的 方法 和组 合嵌 入方 法。 我们在

下面的小节 中做一 个简单 的介 绍。

2.1 基于聚合的 方法

深度 点 击率 预 测模 型 通常 遵循 嵌 入和 M LP 范 式 。在 这 些方 法中 ,

首 先 将 大规 模 稀 疏 输 入 特 征(id) 映射 到 低 维 嵌 入 向 量中 , 然 后以

分组 方 式聚 合到 固 定长 度 的向 量中 。 最终 连 接的 向 量作 为输 入输

入到多 层感 知器(M LP )。近 年来 ,研 究人员 对 C TR 预测模 型进行

了大 量的 研 究, 重 点是 学习 如 何通 过 聚集 特征 来 获得 判 别性 表示 。

利用 C NN 、R NN 、Trans form er 和 C aps ul e 等不 同的 神经 架构 来聚

合特征。DIN[22] 是 采 用注 意 机 制 进 行 特 征 聚 合 的代 表 作 之 一。

它利 用 注意 力局 部 地激 活 给定 目标 物 品的 历 史行 为 ,并 成功 捕捉

到用 户兴 趣 的多 样 性特 征。 DIEN[21]进 一步 提出 了 一种 辅助 损失

来 捕 获 历 史 行 为 中 的 潜 在 兴 趣 。 此 外 , DIE N 将 注 意 力 机 制 与

GR U 相结合 ,对 用户 兴趣的 动态 演化 进行 建模, 实现 特征 聚集。

M IND[10]认为单 个向 量可 能不 足以 捕捉 用户 和物 品之 间的 复杂模

式。M I ND 中 引 入胶 囊网 络 和动 态路 由 机制 ,学 习 多种 表示 来聚

合 原始 特 征 。而 且 , 受 序列 到 序 列学 习[17] 任务 中 自 注意 架 构成

功的启 发,[5]中 引入了 Trans form er 用于特 征聚 合。M I M N[11]提

出了 一 种基 于内 存 的架 构 来聚 合特 征 ,并 解 决长 期 用户 兴趣 建模

的挑战。

2.2 基于图的方法

图包 含节 点 和边 ,其 中 ID 特 征可 以 用节 点 嵌入 表示 , 特征 协同

作 用 可 以沿 边 建 模 。 基 于 图 的 方法 , 如 图 神 经 网 络(GNNs )[6]对

每个 节点 进行 特 征传 播, 其 中邻 域信 息被 聚 合。 特征 协 同作 用被

建模为边缘权 重, 用于特 征传 播

目标

一

个

B

共同行动

目标

一

个

B

CAN:重新访问功能的协同作用,以预测点击率

平滑 局部 沿边 缘嵌 入 的节 点。[2]首 先提 出 了一 种基 于谱 图的 卷积

网络 扩展 到用 于特 征传 播的 图。GC N[9]通 过用 重 新定 义的 传播矩

阵堆 叠 一阶 切比 雪 夫多 项 式滤 波器 层 ,进 一 步简 化 了图 卷积 。在

GC Ns 中, 边是 预 定义 的 ,边 权 值 是一 维 实值 。 权重 用 于聚 合邻

域信息,以建模特征协同作用。 [18] 提 出 了图 注 意 力 网 络 (graph

at t enti on net works,简称 GAT), 学习 在每 个中间 层分 配不 同的边

权值。 GAT 还通 过边 权值来 描述 特征 的协 同作用 ,但 由于 采用了

注 意 力 机 制 , GAT 中 的 权 值 是 节 点 的 函 数 。 注 意 力 机 制 使 得

GAT 能够 更 有 效 地 建模 特 征 协 同 作 用。 也 有 一 些 工作[15,16,20]

利用 不 同节 点之 间 的元 路 径进 行嵌 入 学习 。 尽管 基 于图 的方 法在

图结 构 化数 据上 取 得了 巨 大成 功, 但 特征 协 同作 用 仅通 过表 示连

接词 强 度的 一维 权 重来 建 模。 表达 能 力可 能 不足 以 建模 特征 协同

作用。

2.3 组合嵌入方法

组合嵌入方 法用组 合嵌入 的方 法来度 量特征 的相互 作用。F M 分 解

机(Factori zati on Machines, 简称[14])是 浅层模 型时代 具有代 表性的

方法。在 F M 中, 特征的 协同作 用被建 模为 特征潜 在向量 的内积 。

然而,F M 在不同 类型 的场间 相互作 用中使 用相同 的潜在 向量, 这

可能导致耦 合梯度 问题, 降低 模型容 量[13]。耦 合梯度 问题是 由于

在不同类型 的场间 相互作 用中 使用相 同的潜 在向量 引起的 ,其中 两

个本应独立 的特征 在梯度 更新 过程中 向同一 方向更 新。此 外,F M

的代表功率 受到其 浅层特 性的 限制。 受深度 学习成 功的启 发,C TR

预测模型已 经从传 统的浅 层方 法过渡 到现代 的深层 方法。dnn 在位

级建模非线 性交互 方面非 常强 大,然 而,特 征协同 作用是 以隐式 方

式学习的。 已有研 究表明 ,通 过组合 特征向 量显式 地表示 模型特 征

协同作用有 利于 C TR 预测。 wi de & deep[3]人 工设计 的笛卡 尔产品

特性作为“ wi de”模 块的输 入,它 是一种 广义线 性模型 。将" wide

"模块与深度神 经网络 相结合 ,预 测最终 得分, 用于 C TR 预测。

DeepF M [7]引入了一 个因子 分解机 器作为 wi de & deep 中的“ wide”

模块,不需 要手动 构造笛 卡尔 乘积特 征。Qu 等 人[12]提 出了基 于

产品的神经 网络(P NN),它 引入了 一个产 品层来 捕获领 域间类 别之

间的特征协 同作用 。产品 层的 输出作 为输入 输入到 下面的 DNN,

用于 最终 的 预测 。深 度 交叉 网 络(DC N)[19]在 每一 层应 用 特征 交叉 。

虽然与普通 DNN 相比, 这些方 法获得 了显著 的性能 增益, 但它 们

仍然存在一 些局限 性。具 体来 说,每 个 ID 的嵌 入同时 承担 了表示

学习和协同 建模的 责任。 表示 之间的 相互干 扰

第 21

雅那

次会议,2021 年 4 月,斯洛文尼亚卢布尔

学习和合作建模可能会损害性能。因此,组合嵌入的限制并没

有充分利 用特 征协 同 的力 量 。

在本节中, 首先简 要介绍了 C TR 预测中特征的 协同作用 。然后我

们重 新 回顾 建模 特 征协 同 的最 先 进的 方法 。 在广 告 系统 中 ,用户

点击广告的 C TR ⁺ 是 通过以下 方式计算 的:

=DNN((1),…,𝐴(𝐴𝐴),𝐴(𝐴1),…,𝐴(𝐴𝐴 )),

其中{𝐴1,…,𝐴 }是用户特征的集合,包括浏览历 史、点击历史、

用户简介特征等,{𝐴1,…,𝐴 }为项特征集。的 (·) ∈R 将稀疏的

id 映射为可学习的稠密向量作为 DNN 的输入。除了这些一元术语外,

一些工作还将特征交互建模为 DNN 的额外输入:

=DNN((1 ), … , 𝐴(𝐴𝐴),𝐴(𝐴1), …,𝐴(𝐴𝐴),{𝐴(𝐴𝐴 ,𝐴𝐴 )}𝐴 ,𝐴), ,

在哪 里 ({𝐴

, } , )∈r 表示 项 特征 之间 的特 征交 互𝐴 和

用户特征𝐴 。特 征交互 的加入 改善了 预测结 果,这 表明 来自不同

组的特征的 组合提 供了额外 的信息 。直观的 原因是在 C TR 预测任

务中 , 一些 特征 组 合与 标 签的 关 系比 单独 的 特征 本 身更 强 。以用

户点 击 行为 为例 , 由于 用 户兴 趣 的存 在, 用 户点 击 历史 与 用户可

能点 击 的目 标物 品 之间 存 在较 强 的关 系。 因 此, 将 用户 点 击历史

记录与目标 项目相 结合是一 种有效的 C TR 预测共现特征 。我们把

这种与标签有 较强关系 的特征交 互称为特 征共现。

仔细 回顾 以往 基于 深度 神经 网络 的方 法, 可以 发现 一些 深度 神

经网 络即 使 不使 用组 合特 征 作为 输入 , 也能 够捕 获特 定 特征 之间

的交互 作用。 例如, DIN 和 DIEN 使用注 意机制 来捕 捉用户 行为

特征 和物 品 之间 的交 互。 但 这些 方法 的 弱点 在于 局限 于 用户 兴趣

序列 上的 特 征交 互, 且都 是 处理 特征 的 嵌入 向量 ,而 在 低维 空间

中处理规则 的嵌入 向量, 往往 会丢失 大量的 原始信 息。

最直 接的 实现 方法 是 直接 学习 每个 组 合特 征的 嵌入 向量 , 例如 ,

笛卡 尔 积。 然而 , 存在 一 些严 重 的缺 陷。 首 先是 参 数爆 炸 问题。

例如, 大小为𝐴 和𝐴的两 个特 征做笛 卡尔 积。笛 卡尔 积集的 参数空

间相对 于原有 的参 数空间 会从𝐴 (𝐴 + 𝐴 )扩展到𝐴 (𝐴×𝐴 ),这 将给在

线系 统 带来 很大 的 负担 。 此外 , 两个 包含 相 同特 征 的组 合 之间没

有信息共享 ,这也 限制了 笛卡 尔积的 表示能 力。

一些作品尝试使用特殊的网络结构来建模特征交互。然而,

这些结构 大多 与

基于特征协同作用的 CTR 预测 3

.

第 21

雅那

届会议,2021 年 4 月,斯洛文尼亚卢布尔

彼此之间没有 任何 特征组 的表 示差 异[4,7]。

4 协同作用网络

为了 利用 协 同特 征而 不受 笛 卡尔 积等 以 往工 作的 限制 。 本文 提出

了一 种 协 同网 络(C AN) 来有 效 地捕 捉 域间 的 交 互。 根 据上 面 的分

析 ,之 前 的 工作 并 没 有 充分 挖 掘 特征 协 同 作 用的 潜 力 。该 C AN

借鉴 笛卡 尔 积中 特征 组 合的 独立 编 码思 想, 引入 可 插拔 模块 ——

协同 单元 。 协同 作用 单元 侧 重于 扩展 参 数空 间, 并有 效 地应 用参

数对 特征 协 同作 用进 行建 模 。具 体而 言 ,该 协同 单元 充 分利 用一

侧的参数 ,构建 一个适 用于 另一侧 的多层 感知器 M LP 。这种 特征

交叉 范式 为 模型 带来 了更 多 的灵 活性 。 一方 面, 增加 参 数维 数意

味着扩 大 M LP 参数和 层数;另一 方面 ,与 具有 相同 特征 的不 同特

征组 合之 间 不共 享信 息的 笛 卡尔 积相 比 ,协 同单 元提 高 了参 数的

利用率 ,因为 m lp 直接 来自特 征嵌入 。此 外,为 了在 模型中 纳入

高阶 信息 , 我们 引入 了多 阶 增强 ,它 显 式地 为共 同作 用 单元 构造

了一 个多 项 式输 入。 多阶 信 息促 进了 模 型的 非线 性, 有 助于 更好

地估 计特 征 的协 同作 用。 此 外, 提出 了 包括 嵌入 独立 性 、组 合独

立性 和阶 独 立性 在内 的多 层 次独 立性 , 通过 扩大 参数 空 间来 保证

协同的学习 独立性 。

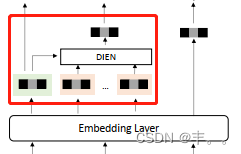

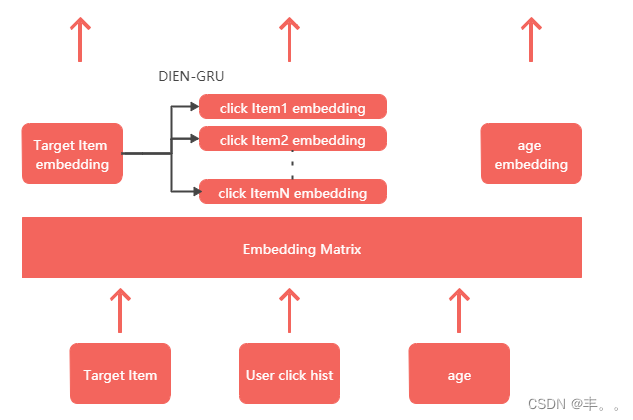

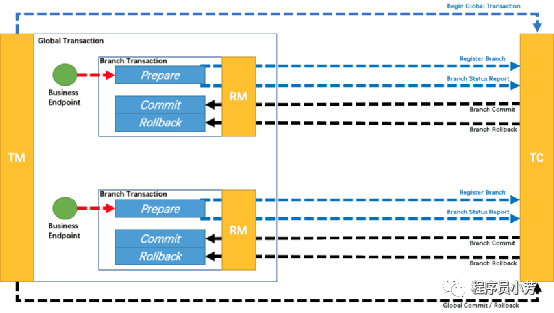

4.1 体系结构概述

CAN 的整体 结 构如 图 2 所示 。用 户 和目 标 项目 的 特征 以 两种 方式 输 入 CAN。

在 第一 种 方 式 中 ,用 户𝐴 的 所 有特 征𝐹𝐹𝐹𝐹 和 目标 物 品𝐴𝐹𝐹𝐹𝐹 使用 嵌 入层 编

码为 密 集 向量 , 然 后连 接 为𝐴𝐹𝐹𝐹𝐹 和𝐴𝐹𝐹𝐹𝐹 ,分别 。 第二 种 方 式, 部 分功 能

来 自𝐴𝐹𝐹𝐹𝐹 和𝐴𝐹𝐹𝐹𝐹 被 选 中并 映 射 到 参 数𝐴𝐹𝐹𝐹𝐹 和𝐴𝐹𝐹𝐹𝐹 联 合 行动 单 元 。

协同 单 元的 操 作符 定 义为𝐴(𝐴.𝐹𝐹𝐹𝐹 ,𝐴𝐹𝐹𝐹𝐹 ),发挥 MLP 的作用 ,其 参 数取

自𝐹𝐹𝐹𝐹 ,其输入 来 自𝐴𝐹𝐹𝐹𝐹 。合作单 元 的具 体 实施 在 第 4.2 节中 阐 述。

协同网络的最终结构表示为:

ˆ=款(𝐹𝐹 𝐹𝐹 𝐹 ,𝐹𝐹 𝐹𝐹𝐹 , (𝐹𝐹𝐹 𝐹𝐹 ,𝐹 𝐹𝐹 𝐹𝐹 ,Θ𝐹 𝐹𝐹 ) ,Θ 𝐹𝐹𝐹 ) , ( 1)

在哪里 为点击行为的预测概率,Θ𝐹𝐹𝐹 协同行动单元的查找表参数是

否设置,Θ𝐹 𝐹 为 DNN 的参数集。ground truth 表示为 ∈{0,1},我

们最终最小化的交叉熵损失函数之间 ` `和标签 :

在 Θ 为特征嵌入的参数集。

周国瑞、卞伟杰等。

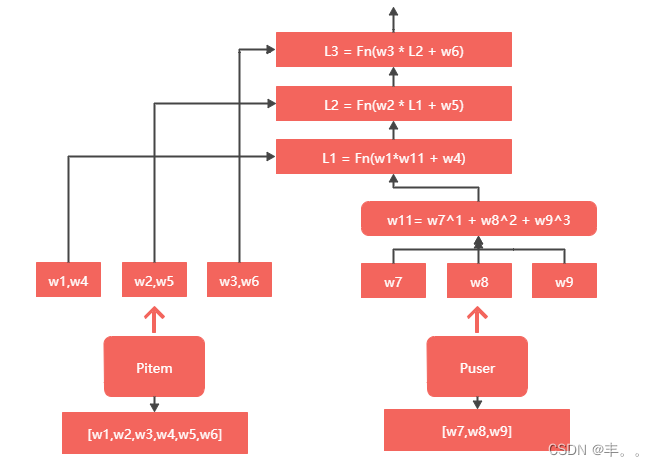

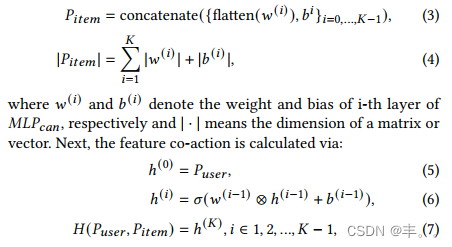

4.2 共同作用单元

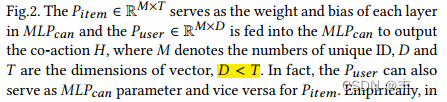

协同 单 元的 详 细结 构 如 图 2 的左 侧 所示 。 的 𝐹𝐹𝐹𝐹 ∈R

× 作为 中每 一层 的

权值 和 偏置 𝐹𝐹𝐹

𝐹𝐹𝐹 和 𝐹𝐹𝐹𝐹 ∈R

× 馈入 𝐹𝐹𝐹

𝐹𝐹𝐹 来输 出协 同 动作𝐴 ,其

中𝐴 表 示 唯一 ID 的数 字 ,𝐴 和𝐴 是向 量 的 维数 ,𝐴<𝐴 。事实 上 ,𝐴 .𝐹𝐹𝐹𝐹 也

可 以 作为𝐴𝐴𝐴𝐹𝐹𝐹 参数 ,反之亦然 , 为𝐴𝐹𝐹𝐹𝐹 。 从 经验 来 看 , 在 广 告系 统

中 ,候 选 项 目 是 所有 项 目 中 的 一小 部 分 , 因 此其 数 量 小 于 用户 点 击 历 史中 的

项 目 。 因 此 我 们选 择𝐴𝐹𝐹𝐹𝐹 作 为𝐴𝐴𝐴𝐹𝐹𝐹 参数 。𝐴 的维数𝐹𝐹𝐹𝐹 和𝐴𝐴𝐴 的

输入维数是一样的吗𝐹𝐹𝐹 而𝐴 的𝐹𝐹𝐹𝐹 具有更高的维度 , 因 为 它 是 权 重和 偏

差的 容 器。 在 下面 的 部分 中 ,我 们 表示 𝐹𝐹𝐹𝐹 和 𝐹𝐹𝐹𝐹 为简 单起 见 ,为 具

体项 目 特征 ID 和用 户特 征 ID 的参数 , 其中𝐴𝐴𝐴𝐴𝐴∈R𝐴 和𝐴𝐴𝐴𝐴𝐴∈R𝐴 。

将𝐴𝐴𝐴𝐴𝐴进行 重 塑并 分 割 为所 有 的 权重 矩 阵 和 偏置 向 量 𝐹𝐹𝐹𝐹𝐹𝐹 层。这 个

过程可以 公式 化 为:

𝐹𝐹𝐹𝐹𝐹=连 接( {平( ( )),𝐹𝐹} = 0,…, − 1) , ( 3)

在哪里 (𝐴 )和 (𝐴 )表示𝐴𝐴𝐴的第 i 层的权值和偏置𝐹𝐹𝐹 ,分别表示,|·|

表示矩阵或向量的维数。接下来,通过:计算特征协同作用:

其中⊗ 和𝐴表示 矩阵乘 法和 激活函 数,𝐴 是前面 定义 的特征 协同作

用。 对 于像 用户 点 击历 史 这样 的 序列 特征 , 协同 作 用单 元 应用于

每个项目, 后面是 序列上 的求 和池。

与其 他方 法相 比 ,我 们提 出的 协 同行 动单 元可 以 实现 至少 三个

优势 。 首先 ,与 以 往在 不 同类 型 的场 间相 互 作用 中 使用 相 同的潜

在向量 不同 ,协 同作 用单 元利用 dnn 的计算 能力 ,通 过动 态参数

和输 入 而不 是固 定 模型 来 耦合 两 个分 量特 征 ,这 为 保证 两 个场特

征的 更 新和 避免 耦 合梯 度 提供 了 更大 的能 力 。其 次 ,可 学 习参数

的尺 度 更小 。协 同 学习 的 最终 目 标是 学习 每 个协 同 特征 的 优秀表

示向量。但 是,直接 学习构件 特征的 carst ein 积的嵌入需 要学习相

当大规模的 参数。例 如,考虑 两个具有 两个𝐴 id 数量的特 征。如果

我们 通 过学 习它 们 笛卡 尔 积的 嵌 入来 学习 共 同作 用 表示 , 参数尺

度应该 是 ( 2× ), 在哪里 为嵌 入的 维数。 但是 ,通过 使用协

同单元, 这个尺 度会减小 到𝐴 (𝐴×𝐴 ),其中𝐴是协 同单元 参数的维

数,远小 于𝐴。参数 少,不 仅有利于 学习, 还能有 效减轻 在线系统

的负 担 。第 三, 与 以往 其 他作 品 相比 ,协 同 单元 对 新特 征 组合具

有更 好 的泛 化能 力 。给 定 一个 新 的特 征组 合 ,只 要 之前 训 练了双

方的嵌入,协 同单元仍 然可以工 作。

(7)

(5)

(6)

(4)

ML P 参 数 存 储 在 一 个 查 找 表 中 。

图 2:协同作用网络的整体框架。给定目标物品和用户特征,嵌入层将稀疏特征编码为密集嵌入。同时,选取部分特征进行

协同建模。每个项目特征通过 MLP 表查找对应一个多层感知器(Multi - Layer Perceptron,简称 MLP),而用户特征则作为

MLP 的输入。输出特征协同作用与公共特征嵌入一起用于做出最终的 CTRs 预测。该图以彩色观看效果最好。

4.3 多阶增强

前面提到的特征协同基本是在一阶特征上形成的。然而,特征相互

作用可以在高阶上进行估计。虽然协同单元可以隐式地学习高阶特

征交互,但学习过程被认为是漫长的。为此,我们在协同作用单元

中显式地引入多阶信息,以获得多项式输入。这是通过应用𝐴𝐴𝐴实

现的𝐹𝐹𝐹 对𝐴的不同阶𝐹𝐹 𝐹 𝐹 :

其中𝐴为订 单数。 注意, 在𝐴 = 1 时使 用 S eLU 作为激 活函数 。否

则,我们 利用 Tanh 来避免 高次项 带来的 数值问 题。多 阶增强 有效

地提 升了 模 型协 同建 模的 非 线性 拟合 能 力, 而不 会带 来 额外 的计

算和存储成 本。

4.4 多级独立性

学习独立性是协同建模的主要关注点之一。为了保证学习独立性,

我们根据重要性从不同 方面提出了三 个层次的策略:

第一 个 层次 ,参 数 独立 性 ,这 是必 要 的。 如 第 4.1 节 所 述, 我

们的方法区分了表示学习和协同建模的参数。参数独立性是我

们 CAN 的 基 础。

第二 级, 组 合独 立 性, 这是 推 荐的 。 特征 协同 作 用随 着 特征组

合数量的增加而线性增长。根据经验,选择目标物品特征 “li ke

item _id”和 “cat egory_i d”作为权 重侧 嵌入, 而用 户特征 则用 于输

入侧。由于 权重侧嵌 入可以 与几个输 入侧相结 合,反之 亦然, 我们

的方法 以指 数方 式扩大 了它 们的 维度 。假 设有𝐴权 重侧 嵌入 和𝐴输

入侧嵌入,我 们将权重 侧嵌入的 维数扩展 为𝐴次和𝐴次

(

8

)

(

9

)

输出

Softmax (2)

PReL U

(80)

PReL U (200)

Concat & Flatten

顺序 非时序的

协同作用单元

Su m-p o o lin g … …

协同作用单元

协同作用单元

二 亚

乙 基

三 胺

…

嵌入层 …

参数 lookup1

b

(1 ) b (2 )…b (T)

用户行为序 列

目标物

品 id

用 户

年 龄 其他功

能

协同作用单元

W eig h t & Bias

重塑 MLP

( )

1

(

输 入

) 2 ( )

3

Pite m 脓

:目标物品

:用 户

:嵌入和参 数

( n : 输入的 n 次 幂

:激活函数 :元素和

能否:重游功能协同作用预测点击率 2021

那

年 4 月 21 日会议,斯洛文尼亚卢布尔雅

Conference ' 21, 2021 年 4 月,卢布尔雅那,斯

洛文尼亚

输入端:

其中|𝐴|是 𝐹𝐹𝐹𝐹𝐹𝐹 。在正向传递中,这些嵌入被分成几个部分来完成

MLP 操作。

第三层,订单独立性,这是可选的。为了进一步提高多阶输入中

协同建模的灵活 性,我们的方 法针对不同 的阶做了不 同的权重侧嵌

入。权重边嵌入的维 数相应增加𝐴 𝐴 𝐴𝐴 𝐴𝐴倍,类似于等式 1 0。注

意,作为𝐴 𝐴𝐴 𝐹𝐹 𝐹 在不同的阶项中没有共享参数,因此公式 8 中的

近似是不可行的。

协同 独立 有助 于协 同建 模, 但同 时也 带来 了额 外的 内存 访问 和

计算 成本 。 在独 立级 别和 部 署成 本之 间 存在 权衡 。从 实 证上 看,

模型 使用 的 独立 性水 平越 高 ,模 型需 要 的训 练数 据就 越 多。 在我

们的 广告 系 统中 ,使 用了 三 个独 立级 别 ,但 由于 缺乏 训 练样 本,

在公共数据 集中只 使用嵌 入独 立。

5 实验

在本 节中 ,我 们 将详 细介 绍实 验 。第 5.1 节首 先介 绍了 所使 用的

数据集 ,包 括亚 马逊数 据集 、淘 宝数 据集 和 Avazu 数 据集 ,然后

介绍 了之 前的 方 法和 实现 细节 。 在第 5.2 节中 详细 阐述 了结 果和

讨论。 第 5.3 节 阐述了 消融 研究 。第 5.4 节 介绍 了模 型的 普适性 和

泛化。 工业 数据 和部署 优化 的实 验结 果在 s ec5.5 中显 示。 公共数

据集和实验代 码均 已提供 1。

5.1 实验设置

数据集。实验 使用了三 个可公开 访问的数 据集:亚马 逊、淘 宝和

Avazu 进行点击 率预测。 这些数 据集的特 征如下:

•亚马逊 dat as et 2 包 含来自 亚马逊 的产品 评论和 元数据 。在 2 4

个产品类别 中,我 们选择 B ooks 子集 ,其中 包含 75053 个

用户,358367 个项目 和 1583 个类 别。由 于该亚 马逊数 据集

最初不是 C TR s 预测 数据 集,因 此没有 提供负 样本。 按照

之前的工作 [11,21,22], 我们随 机选择 没有被 特定用 户评价

的产品作为 该用户 的负样 本, 并创建 相应的 用户行 为序列

(点击和不点 击)。最大 序列长 度限制 在 100 条 以内。

•淘宝 datas et3 是 淘宝推荐系统 中用户行为的 集合。该数据 集包

含约 100 万用户 ,他们的行为 包括点击、购 买、向购物车添 加

商品和商品偏好。点击 行为

1 h ttp s : / /g i t h u b . c o m / C A N - P a p e r / C o - A c t i o n - N e t w o rk

2 http://jmcauley.ucsd.edu/data/amazon/

3 https://tianchi.aliyun.com/dataset/dataDetail?dataId=649

周国瑞、卞伟杰,等。

对每 个 用户 都 采 取, 并 根据 时 间戳 进 行 排序 , 构建 用 户行

为序列。最 大序列 长度限 制在 200 条以内 。

•Avazu dat as et 4 是一个移动广 告数据集 ,包括 1 1 天(10 天用于

培训,1 天用于 测试)由 Avazu 提供的真 实工业 数据 。对于

亚马 逊 和 淘宝 数 据集 , 基于 用 户 行为 序 列对 特 征协 同 行为

进行建模。 而对于 Avazu 数据集,由 于 Avazu 数据 集包含

多个 数据 字段 ,适 合 验证 序列/非 序列 对 特征 协同 建模 的影

响, 因 此 采用 离 散特 征 对特 征 协 同建 模 。在 训 练过 程 中,

第 10 天作为验 证集。

表 1 总结了数据集统计数据表 1 :本 文 使 用 的 数 据集 。

数据

集

培训 验证 特征尺寸

亚马逊(图书) 135040 14976 450000

淘宝 691456 296192 5159463

Avazu 36387240 403793 6763060

基线。本文采用 DIEN 作为 C AN 的基本模 型。注意,任何 其他

模型都是允许的,因为协同作用单元是可插拔的模块。为了验证该

方法的有效性,将 C AN 与现 有的特征交互 方法进行了比 较。为了

公平比较,DIEN 被用作这些 方法的基础。

•DIEN[21]设计了一 个兴 趣提取 层, 从用 户行为 序列 中捕 获用

户兴 趣 。进 一步 使 用兴 趣 演化 层对 兴 趣演 化 过程 进 行建 模。

•笛卡尔积 是两个 集合的 乘法 ,形成 所有有 序对 的集合 。有序

对的 第一 个 元素 属于 第一 个 集合 ,第 二 个对 属于 第 二个集

合。

•PNN[12]使用产 品层和 全连接层 来探索高 阶特征交 互。

•NC F [8]提 出 了 一种 神 经 网络 结 构 , 用于 学 习 用户 和 项 目的

潜在特征 , 并使 用 神 经网 络 对协 同 过 滤进 行 建模 。

•DeepF M [7]是一 种新 的神 经网 络架 构, 采用 乘积 层结 合因子

分解机的推荐 能力 和深度 学习 能力 。

实现细节。我们使用 Tensorflow[1]实现了 C AN。对于𝐴 𝐹𝐹 𝐹 𝐹 ,

采用八层 M LP 模型,权 重维度 设置为 4×4,得到(4 * 4+4)×8 =

160(含偏倚)。𝐴的阶数𝐹 𝐹𝐹 𝐹 设置为 2。从头训练模型,用高斯分布

初始化模型参数(均值为 0,标准差为 0.01)。我们使用 Adam 对训练

进行优化,批大 小设置为 128,学习率设 置为 0.001。使用 200 ×

100 × 2 的三层 M LP 进行最终的 CTR 预测。采用常用指标 AUC 评

估模型性能。

4 https://www.kaggle.com/c/avazu-ctr-prediction

(1

1)

(10)

CAN:重新访问功能的协同作用,以预测点击率

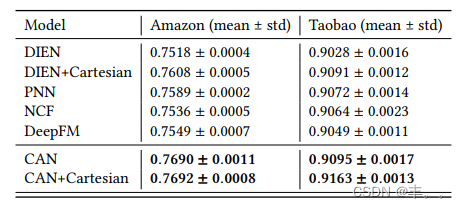

表 2:与其他方法在亚 马逊图书和淘宝 数据集上的比较

模型 亚马逊(平均值±标准

差)

淘宝(平均值±性病)

DIEN 0.7518± 0.000 4 0.9028± 0.0016

DIEN+笛卡尔 0.7608± 0.000 5 0.9091± 0.0012

PNN 0.7589± 0.000 2 0.9072± 0.0014

NCF 0.7536± 0.000 5 0.9064± 0.0023

DeepFM 0.7549± 0.000 7 0.9049± 0.0011

CAN 0.7690±0.0011 0.9095±0.0017

CAN+笛卡尔 0.7692±0.0008 0.9163±0.0013

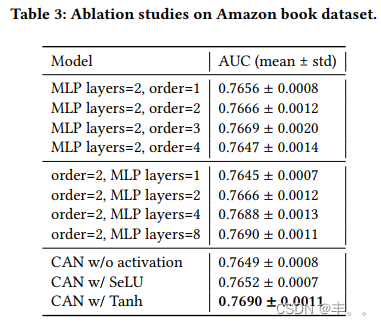

表 3:亚马逊图书数据集的消融研究

模型 AUC(平均值±标

准差)

MLP 层数=2,顺序=1

MLP 层数=2,顺序=2

MLP 层数=2,顺序=3

MLP 层数=2,顺序=4

0.7656±0.0008

0.7666±0.0012

0.7669±0.0020

0.7647±0.0014

阶数=2,MLP 层数=1

阶=2,MLP 层数= 2 阶

=2,MLP 层数= 4 阶

=2,MLP 层数= 8

0.7645±0.0007

0.7666±0.0012

0.7688±0.0013

0.7690±0.0011

CAN w/o 激活 CAN

w/ SeLU CAN w/

Tanh

0.7649±0.0008

0.7652±0.0007

0.7690±0.0011

5.2 结果

表 2 是在 亚马逊 和淘宝 数据 集上的 实验结 果。可 以看到 ,该 C AN

方法 在 两个 数据 集 上的 性 能都 优 于其 他最 先 进的 方 法。 与 基础模

型 DIEN 相比,C AN 分 别提高 1.7%和 2.1%的 AUC。同时 ,该方

法 C AN 比其他协 同方法 有较大 差距, 证明了 该方法 在协同 建模上

的有效 性。 值得 注意 的是 ,与 P NN、 NC F 、DeepF M 等其 他组合

嵌入 方 法相 比, 笛 卡尔 积 方法 作 为单 纯的 表 示学 习 方法 能 够取得

更好 的 性 能, 这 说 明这 些 组 合嵌 入 方 法虽 然 能 够提 取 出 一些 coacti on 特 征的 信 息 , 但 它们 确 实 能 够 学 习到 具 有 优 秀 表示 和 coacti on 的嵌入 。相 比之下 ,C AN 的 表示 效果 要优 于笛 卡尔 积表示

和组合表 示方法 ,说明 基于 网络的 C AN 机制 能够学 习协同 表示的

表示能力和 协同能 力。

5.3 消融研究

为了调 查每 种成 分的影 响, 我们 进行 了几项 消融 研究 ,如表 3 所

示。

多阶首 先,我 们评 估了多 阶的影 响。 在第 1 个订单 项的基 础上 ,

逐步添加了 第 2、3 和 4 个订 单项 。从一 阶到二 阶,A UC 提升了 a

2021 年 4 月,斯洛文尼亚卢布尔雅那,第 21 届

会议

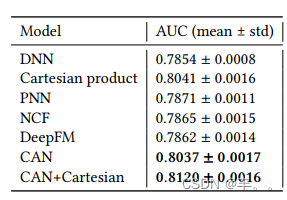

表 4:Avaz u 数据集上使用 16 种特征组合(DNN 除外)的不

同方法的结果。由于 Avazu 数据集不包含序列特征,因此

采用 DNN 作为基本模型。

模型 AUC(平均值±标

准差)

DNN 0.7854± 0.000 8

笛卡儿积 0.8041± 0.001 6

并通

过

0.7871± 0.001 1

NCF 0.7865± 0.001 5

DeepFM 0.7862± 0.001 4

CAN 0.8037±0.0017

CAN+笛卡尔 0.8120±0.0016

很多 。之 后, 随着 订单 的 增长 ,差 距开 始缩 小, 甚至 造 成负 面影

响。多阶对性能增益有边际影响,因此在实际应用中 2 或 3 次幂项

是合适的。

M LP 深度。第二,我们展示 了𝐴𝐴𝐴的影响𝐹 𝐹𝐹 架构对协同建模

的影响。具体而言,我们训练的模型具有不同的 M LP 层数,分别为

1、2、4 和 8。MLP 层的输入和输出维度相同。一般来说,更深的

M LP 会带来更高的性能。而当层数超过 4 时,AUC 增益不明显,

即;, 8 层 M LP 仅增加 0.02%的 AUC。主要原因是,对于这样一个

深度架构来说,训练样本是不够的。

激活 功能 。第 三, 我们 比较 了不 同激 活函 数 的影 响。 从表 中可

以看出, 非线性使 AUC 提高了 0.03 0.41%。在阶数= 2 条件下,

Tanh 比 S eLU 表现出更显 著的性能,因 为 Tanh 起到了规整器的作

用,避免了高阶情况下 的数值问题。

5.4 模型的普适性和泛化

为了 验 证 C A N 特 征 的通 用 性和 泛化 性 ,从 第 二代 的角 度 对 C A N

与 其 他 方 法 进 行了 比 较: 使 用 非 序 列 成分 对 协 同 作 用 特 征 进 行验

证,在训 练时 使用 未 见的 协 同作 用特 征 对样 本 进行 预 测。

虽然 C AN 主 要是 为包 含大 量行 为序 列的 真实 工业 数据 设计 的,

但它仍 然能 够处 理非顺 序输 入。 Avazu 数据 集包 含 2 4 个 数据 字段 ,

我们 选 择 其中 的 9 个 字 段构 建 1 6 种 特征 组 合。 如 表 4 所 示,

CAN 的性 能优于 大多 数方 法, 与笛卡 尔乘 积相 当。

泛化 在真 实的 商 业场 景中 ,每 天都 会 出现 无数 个特 征 组合 ,这

就需 要 C TR 模型 的快 速响应 。泛 化对 于实 际应用 来说 是相 当重 要

的。 为 此, 我们 从 测试 集 中去 除包 含 现有 特 征组 合 的样 本。 通过

这种 方 式, 我们 获 得了 一 个新 的测 试 集, 其 特征 组 合对 于训 练良

好的 模型 来 说是 全 新的 。请 注 意, 我 们只 要求 特 征组 合 为零 镜头 ,

而不是 所有 特征 。从表 5 中 可以 看出, 笛卡 尔积 在这 种设 置下是

无效 的 ,因 为它 依 赖于 训 练良 好的 协 同嵌 入 ,而 在 这种 设置 下是

不可用的

会议 21,2021 年 4 月,卢布尔雅那,斯洛文尼亚

表 5:亚马逊数据集中不同方法处理新特征组合的结果。

方法 AUC(平均值±标

准差)

二亚

乙基

三胺

0.7028± 0.0013

二亚乙基三胺+

笛卡儿

0.7040± 0.0013

NCF 0.7066± 0.0019

DeepFM 0.7073± 0.0012

CAN 0.7132±0.0017

设置。与其他方法相比,该方法对新特征组合仍具有较好的 C AN 泛

化能力。在实际工业环境中,由于特征组合非常稀疏,使用 C AN 处

理新特征组合要容易得多,只要 𝐹𝐹𝐹𝐹𝐹 和 𝐹𝐹𝐹𝐹𝐹 都训练有素。

5.5 工业数据的结果

在线 服务 和 挑战 。一 开始 , 我们 在系 统 上部 署了 笛 卡尔 式的 产品

模型, 造成 了很 多麻 烦。一 方面 ,即 使使用 IDs 频率 滤波, 模型

规模也 在以极 快的速 度扩 大。另 一方 面,额 外的 × IDs 会带

来大量 的嵌入 查找操 作和 系统响 应延迟 。相 比之下 ,C AN 在这方

面要友好得 多。为了 将 C AN 部 署到我们 的广告系 统上,我 们选择

了 21 个特征,其 中包括 6 个广告特 征和 1 5 个用户特征来 生成特

征组合,这 样由于协 同独立, 额外分配 了 2 1 个嵌入空间。 显著增

加的 嵌入 空 间仍 然导 致在 线 服务 的沉 重 压力 。由 于 用户 特征 大多

是长度 超过 100 的行 为序 列,需 要额 外的内 存访 问, 从而导 致响

应延 迟上 升 。此 外, 特征 协 同作 用的 计 算成 本随 着 特征 组合 的数

量线性增长, 这也给我 们的系统 带来了相 当大的响 应延迟。

解决方案。为了解决这些问题,很多工作都致力于减少响应

延迟。我 们 从三 个 方 面简 化 了模 型

方面:

•序列截断。16 个用户特征的长度从 50 到 200 不等。为了降低

内存访问成本,我们简单地对我们的用户特征应用序列截断,

例如,所有长度为 200 的用户行为序列都减少到 5 0。最近的

行为被保留。序列截断使 QPS(Query P er S econd)提高了 20%,

AUC 下降了 0.1%,在可接受的范围内。

•组合减少。6 个广告 功能和 1 5 个用户功能可 以获得 多达 9 0

个功 能 组合 , 这是 一个 沉 重的 负 担。 从 经验 来 看, 广 告特

征和 用 户特 征 同类 型的 组 合可 以 更好 地 模拟 特 征共 现 。根

据这一原则,我们保留了像 “it em _i d” 和

“i t em _cli ck_hi story” 以 及 “cat- egory_i d” 和

“cat egory_cli ck_his tory” 这 样 的 组合 , 并 删除 了 一 些 不 相

关的 组 合。 组 合数 量从 9 0 个 减 少到 4 8 个 ,QPS 提 高了

30%。

周国瑞、卞伟杰等。

表 6:真实在线广告系统的 CTR 和 RPM 收益

CTR RPM

场景一 +

11.4%

+

8.8%

Scene2 +

12.5%

+

7.5%

• 计 算 内 核 优 化 。 协 同 计 算 指 的 是 一 个 耗 时 的 大 矩 阵 乘 法

𝐹𝐹𝐹𝐹 和 𝐹𝐹 𝐹 𝐹 , 形状为 [B at ch_si ze × K × di m_i n ×

dim _out] × [Batch_si ze × K × s eq_l en × di m_i n],其中 K、

seq_l en、di m_i n、dim _out 分别表示特征协同作用的个数、用

户行为序列的长度、M LP 的输入维数和输出维数。在我们的

例子中,dim _i n 和 di m_out 不是常用的形状,因此这样的矩

阵乘法没有被 BLAS (B asi c Li near Algebra Subprogram s)很好

地优化。为了 解决这一 问题,重 新编写了 内部计算 逻辑,带

来 了 60% 的 QP S 提升 。 此 外, 由 于 这 个矩 阵 乘 法之 后 是

seq_l en 维上的求和池化,我们进一步在矩阵乘法和求和池化

之间进行了核 融合。通 过这样做 ,避免了 矩阵乘法 输出的中

间 GPU 内存写入,又带来了 47%的 QPS 提升。

通过一系列 的优化, 使 C AN 能够 在主要 流量上稳 定地在线 服务。

在我们的系 统中,C TR 预测步骤需要 12m s,使用的 C AN 可以处

理每个 GP U 近 1 K 的 QPS 。表 6 显示了 在我们的 在线 A / B 测试中,

CAN 对 C TR 和 RP M (R evenue Per mile)的改善 。

6 结论

在本文中,我们强调了特征协同建模的重要性,这一点被之前

的工作低估了。受笛卡尔乘积模型的启发,本文利用一种特殊

设计 的 网络 —— 协 同网 络(C o -Acti on net work,简 称 C A N), 提出

了 一 种 新 的 特 征 交 叉 范 式 。 通 过 一 个 灵 活 的 模 块 ——co-act i on

unit,C AN 将表 示 学习 和协 同 行为 建 模分 离开 来 。此 外 ,在 协同

单元中引入了多阶增强和多级独立,进一步提升了特征协同建

模能 力 。实 验结 果 表明 , 该方法 C AN 优 于已 有 方法 , 对新 的特

征组 合 具有 更好 的 泛化 能 力。 目前 ,该 C AN 被 部署 在 阿里 巴巴

的展示广 告系 统中 , 服务 于 主要 流量 。

参考文献

[1 ] M a rt in A b ad i 、 A shi sh A g a rw a l 、 P au l B a rha m 、 E u g en e B revd o 、陈志峰、 C rai g

Ci t ro 、格雷格 S .C o rrad o 、 An dy D a vi s 、J e ffrey D e a n、 M a tt hi eu D e vi n 、 S anj a y

G h e m a w at 、 Ia n Go od fel lo w 、 A n d re w H a rp、 G e o ffrey Irv in g 、M i ch a e l Is a rd 、 贾

杨庆、 R a fal J o z efo w i c z 、L uk as z K a is e r、 M an ju n at h K u dlu r、 Jo sh L e v en be rg 、

D a nd e lio n M an e、 R a ja t M o ng a、 Sh e rry M o o re 、 D e rek M u rray 、 Ch ris O l ah 、

M i k e S c hus t e r、J on at ho n S hl e ns 、 B en oi t S te in e r、 Ily a S ut sk e v e r、 K u n al T al w a r、

P au l T u ck e r 、 V i n c en t V an ho u ck e 、 V i j ay V a s ud ev a n, F e rn an d a V ié ga s, O rio l

V in y al s, P et e W a rd e n, M a rt in W at t en b e rg, M a rti n W i ck e, Yu Y u an , 郑晓 强 。 201 5 。

T e ns o rFlo w : 异 构 系 统 上 的 大 规 模 机 器 学 习 。 h tt ps: // w w w .t e nso rflo w .o rg / 软件可

从 tensorfl o w. o rg 获得 。

[2 ] J o an B run a, W oj ci e ch Z are mb a, A rth ur S zl a m, Y a nn L e Cu n。 201 4.图 上 的谱 网 络和

局部连接网络。第二届学习表示国际会议程序。班夫, A B , 加拿 大 。

CAN:为点击率预测重新审视特征协同动作

[3 ] H e ng -T z e C he ng, L ev en t K o c, J e re mi ah H a rm s en, T al S ha k ed, T us h a r Ch an dra, H ri shi

A rad hy e, Gl e n A nd e rs on ,格 雷 格 Co rrado , W ei Ch ai , M u st a fa Ispi r, 等 20 16 。推

荐系 统 的 广泛 和 深 度学 习 。 第 1 届 深 度 学习 推 荐系 统 研 讨会 论 文 集。 A C M , 7 -

10。

[4 ] M i c h aël D e ffe rra rd , X a vi e r B ress on, Pi e rre V an d e rg h eyn st . 201 6 。 基于 快 速 局 部化

光谱滤波的图上卷积神经网络 (C onv ol ut io n al N eu ra l N e t w o rk s )。 在 神 经 信 息处

理系统的进展 29 。 西 班牙 巴 塞 罗 那, 38 37 - 3845。

[5 ]冯宇 飞, 吕福 宇, 沈伟 辰 ,王 梦涵 ,孙 飞, 朱宇 , 杨克 平。 2 019 。用 于点 击率 预测

的深度会话兴趣网络。第 28 届国 际人 工智 能联 合会议 论文 集, 2301 -2 307 。

[6 ] M arc o G o ri , G a b ri e l e M o n fa rdi ni , 和 F ran c o S c a rs e ll i. 20 05 。 图 域学 习 的 新 模型 。

IE E E 神经网络 国 际 联 合会 议 论 文 集 , 第 2 卷。 IE E E 729 - 734。

[7 ]郭慧峰,唐瑞明,叶云明,李振国,何秀强。20 17 。 D e e p fm: 基 于 因 子 分 解 机的

ct r 预 测 神 经网 络 。 发 表 于第 26 届 国际 人 工 智 能 联合 会 议 论 文 集。 澳 大 利 亚墨

尔本。, 2782 - 2788。

[8 ]何向 南 ,廖 丽 子, 张 汉旺 , 聂立 强 ,胡 霞 ,蔡 达 生。 201 7。 神 经协 同 过滤 。 第 26

届万维网国际会议论文集。 173 - 182。

[9 ]托马斯 ·n · 基普夫和马克斯 ·韦林。 201 7 。 图 卷 积 网络 的 半 监 督 分 类 。 第 五届

学习表示国际会议论文集。法国土伦。

李 超 , 刘 志 远 ,吴 梦 梦 , 徐 玉 池 , 赵 欢 , 黄 丕 培 , 康国 梁 , 陈 其 伟 ,李 W e i,李狄

伦 。20 19 。 天猫 推 荐 用动 态 路 由的 多 兴 趣网 络 。 第 28 届 A C M 信 息与 知 识 管理

国际会议论文集 ,2 61 5-26 23 。

[1 1 ]皮 琦 , 边 伟杰 , 周 国 瑞 ,朱 晓 强 , 盖坤 。 201 9 。针 对 点 击 率预 测 的 长 顺 序用 户 行

为建 模 实践 。 第 25 届 美 国计 算 机学 会 知识 发 现 与数 据 挖 掘 SIG K D D 国际会议论

文集,1059-106 8。

会议 21,2021 年 4 月,卢布尔雅那,斯洛文尼亚

[12 ]曲 艳茹 ,蔡 涵 ,任 侃, 张 伟南 , 余勇 ,文 颖 ,王 军。 201 6。 基于 产 品的 神经 网 络,

用于用户响应预测。第 16 届 数据 挖掘 国际 会议 论文集 。 IE E E 1149 - 1154。

[1 3 ]曲 彦 儒 , 方 伯辉 , 张 伟 南, 唐 瑞 明 ,牛 敏 哲 , 郭慧 峰 , 于 勇, 何 秀 强 。 20 19 。 基

于产品的神经网络,用于多领域分类数据上的用户响应预测。 A C M 信 息 系统

学报 37,1(201 9), 5:1 -5: 35 。

[1 4] St e ffen R en dl e. 20 10 。分 解 机器 。 第 10 届 国 际数 据 挖掘 会 议论 文 集。 IE E E 99 5 -

1000。

[1 5 ]石川,胡彬彬,赵伟鑫, P hi lip S. Y u. 201 9 。用于推荐的异构信息网络嵌入。

IE E E 知识与数 据工 程 学 报 31 ,2 (2 01 9), 357 -370 。

[1 6]孙 益 舟, 韩 佳伟 , 闫熙峰, Phi li p S. Yu , 吴天 义 。20 11 。 Pa th - S i m:异构 信 息网 络

中基 于 M et a P at h 的 T o p-K 相 似 搜 索。 V L D B E nd o w m en t 学 报 4, 11 (2 011 ),9 92 -

1003。

[1 7 ] A sh is h V a s w a ni, N o a m S h a z e e r, N ik i P a rm a r, J a ko b U s zk o rei t, L li on Jo n es, A i d an

N . Go m e z , L u k as z K a is e r, Ill i a Po los uk hi n. 2 01 7 。 A t t ent io n i s Al l y ou N e e d 。

《神经信息处 理 系 统 的 进 展 》3 0 。5 998 - 6008。

[1 8] P et a r V e li c kov i c, G ui ll e m Cu c u rul l, A ra nt xa C as an ov a, Ad ri a na Ro m e ro, Pi et ro L i ò ,

Y osh u a B eng io. 20 18 。 图注 意 力 网络 (G ra ph A t te nt ion N et w o rks )。 第 六届 学 习表

征国际会议议事录。加拿大温哥华, BC 省 。

[19 ]王若 曦、傅斌 、傅刚、 王明亮。2 017。广 告点击预 测的深度 与交叉网 络。在 A D K D D '

17 的议事录。12:1-12:7。

[2 0 ]赵欢 、 姚 全 明 、李 建 达 、 宋 阳 秋、 李 迪 伦 。2 017 。 异 构 信 息网 络 上 基 于 元 图的 推

荐 融合 。 第 23 届 A C M S IG K D D 知 识 发 现 和 数据 挖 掘 国际 会 议 论文 集 63 5 -64 4 。

[2 1 ]周 国 瑞 , 某 娜 ,范 英 , 皮 琦 , 边伟 杰 , 周 畅 , 朱晓 强 , 盖 坤 。 20 19 。 用 于 点击 率

预测 的 深度 兴 趣进 化 网络 。 在 第 33 届 AAAI 人 工 智能 会 议论 文 集中 。 檀香 山 ,

美国夏威夷,5941 -594 8。

[22 ]周 国瑞, 朱晓强 ,宋辰 如,范 英, 朱涵, 马晓, 闫阳辉 ,金俊 琪,李 涵,盖 坤。 20 18。

深度兴趣网络 用于点击 率预测。 在第 24 届 A CM S IG K D D 知识 发现与数 据挖掘国际

会议论文集中。ACM , 1059 - 1068。

![[附源码]Node.js计算机毕业设计房屋租赁管理系统Express](https://img-blog.csdnimg.cn/c0c1c3dec823433187833ea5a6415bf0.png)

![[附源码]Node.js计算机毕业设计房屋中介管理信息系统Express](https://img-blog.csdnimg.cn/8092944f6c614d5f971e16fdfcfa6e56.png)

![[附源码]Python计算机毕业设计SSM基于web的图书借阅管理系统(程序+LW)](https://img-blog.csdnimg.cn/2e94a2f41e914a67b91119faaf616e64.png)