语音合成旨在根据文本合成特定说话人的语音。先进语音合成模型展示了强大的生成能力,无论是生成高水平的细节还是其生成的多样性,都让人印象深刻。个性化语音生成需求的增加对语音合成模型提出了挑战,尤其是在域外(OOD; Out-Of-Distribution)的训练未见场景中。

与通常可控的语音合成不同,域外文本到语音的风格转换旨在迁移域外参考样本(Custom Reference)的声学风格(例如,音色、情感和韵律等),进而合成高质量、高相似度语音,主要受到两个方面的挑战:

1. 风格建模和转换:高表现力语音具有高动态范围,通常难以控制和转换。许多合成模型只学到了输入数据的平均分布,并且缺乏细粒度风格建模能力;

2. 模型泛化:当预测时参考样本的声学风格分布与训练数据存在差异时,合成语音的质量和相似性往往会显著降低。

论文标题:

GenerSpeech: Towards Style Transfer for Generalizable Out-Of-Domain Text-to-Speech

论文链接:

https://arxiv.org/abs/2205.07211

代码链接:

https://github.com/Rongjiehuang/GenerSpeech

在今年的人工智能顶级会议 NeurIPS 2022 上,浙江大学与 SEA AI Lab 提出了全新的可建模未见风格(音色、情感和韵律)的可泛化语音合成模型 GenerSpeech。针对域外风格迁移的性能损失问题,提出了基于解耦表征学习的可泛化文本编码器和多层级风格编码器,实现了对未见语者、情感、韵律的可泛化零样本迁移与高质量无监督风格建模,在风格相似度上提升 1 倍偏好,解决高质量、可控性、可泛化的跨模态序列映射问题。

研究背景

可泛化语音合成的旨在生成域外风格(音色、情感和韵律)的语音,面临以下挑战:1)高表现力语音中的动态风格特征难以建模;2)模型应足够鲁棒以泛化于音色、情感和韵律未见的域外语音。

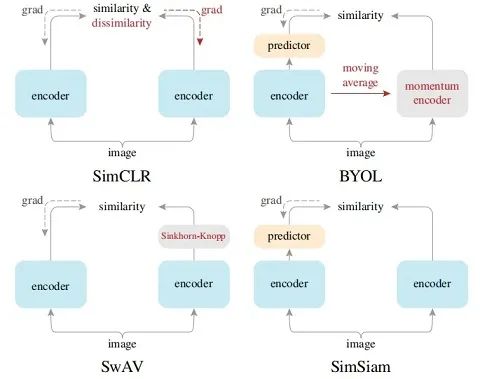

研究人员提出了几种建模和传递风格属性的方法:1)全局风格转换使用基于全局特征 [1](Global Style Token)建模语音风格。2)细粒度隐变量风格则采用 VAE 来表示细粒度韵律变量,为每个音素提供不同的韵律特征。然而,这些方法在捕捉不同的风格特征方面非常有限,无法同时准确迁移的语者、情感和韵律波动。

研究人员研究了提高模型对未见风格(语者、韵律、情感等)语音泛化能力的方法:

1)数据驱动方法。提高模型鲁棒性的一种流行方法是在大数据集上进行预训练,以扩展数据分布。但这种数据饥饿的方法需要许多数据样本,这通常是昂贵的;

2)风格小样本学习 [2] 则使用有限数据进行微调来适应新数据,或是采用元学习 [3] 来适应训练中没有见过的风格。该方法依赖于一个强有力的假设,即域外语音可用于模型微调训练,而这在实践中并不总是成立的。如何通过零次样本 (Zero-Shot)学习,迁移域外未见语音的风格仍然是一个开放的问题。

整体方案思路

域外未见语音(OOD; Out-Of-Distribution)的风格迁移,旨在生成与参考语音的风格(例如,说话者身份、情感和韵律)高度相似的样本,该域外参考语音具有与训练数据不同的声学条件,是训练不可见的。

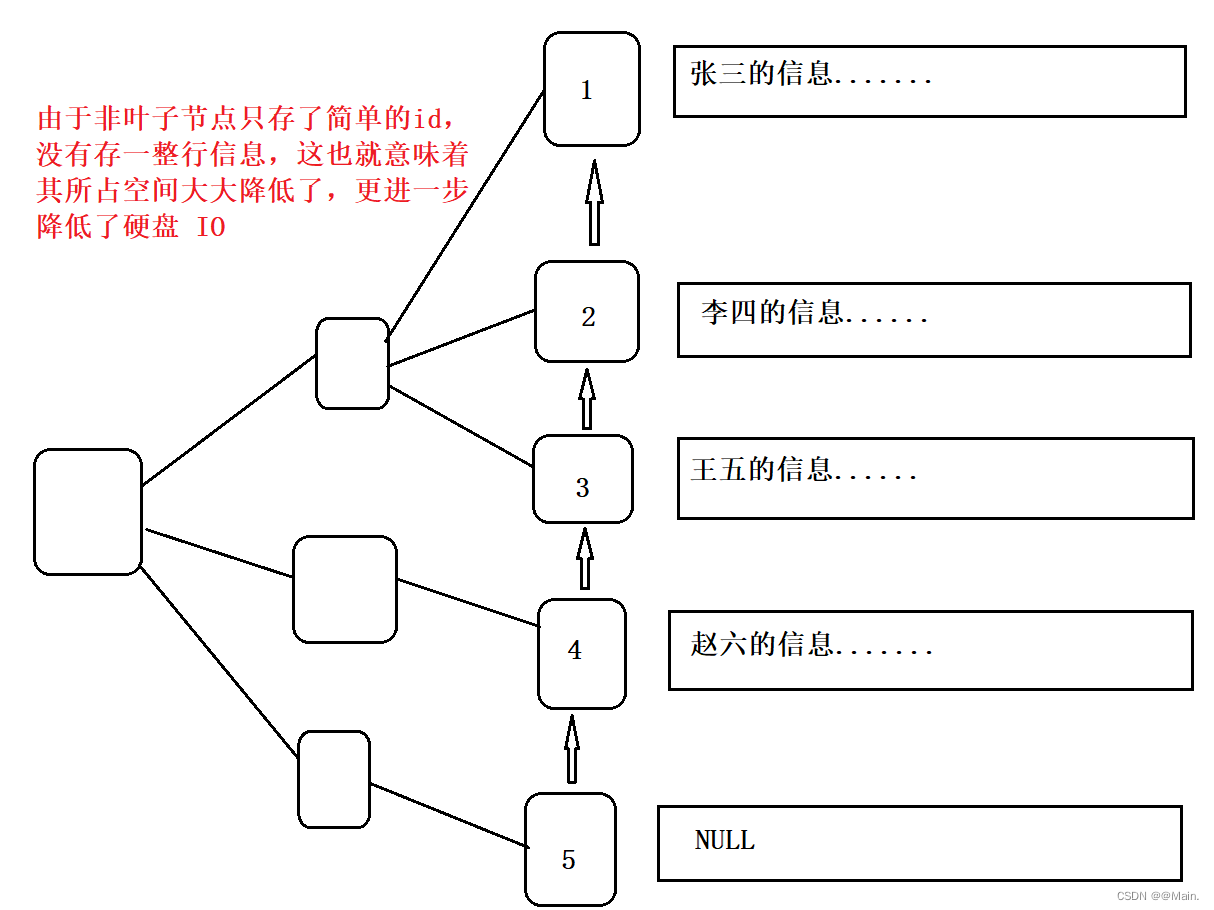

实现更好泛化性的一种直观方法,是通过解耦表示学习将模型分解为领域不可知 (Domain-Agnostic)和领域特定(Domain-Specific)的部分。因此,为了提高文本到语音合成中的通用性,我们设计了几种方法来分别建模语音中的风格不可知(语言内容)和风格特定(例如,语者、情感和韵律)成分:

1)为了提升模型泛化性,我们提出了混合风格层(MSLN)来消除语言内容表示中的风格信息。

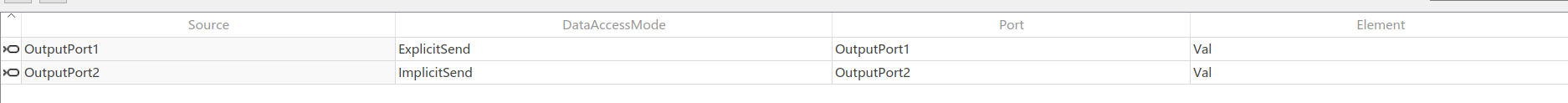

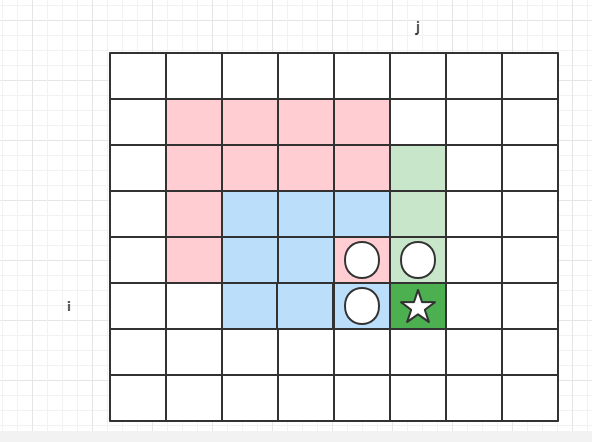

2)为了增强建模和传递风格属性,我们引入了多级(Multi-Level)风格编码器,该编码器由语者和情感特征的全局编码器,以及细粒度风格建模的三个(帧级、音素级和词级)局部编码器组成。

3)为了重构高表现力语音样本中的细节,我们使用了基于流模型的后处理网络来微调输出,以生成细粒度、高质量样本。

2.1 可泛化文本编码器

源域和目标域之间的分布差异通常阻碍了模型的泛化能力。我们提出的混合风格层归一化来消除语音序列中的风格信息,以防止来自具有域外(OOD)自定义语音的话语的风格转换中的退化,并预测风格不可知的韵律变化。

用于说话人自适应的条件层归一化可以基于样式嵌入,自适应地执行归一化输入特征的尺度和偏移。这里,两个简单的线性层 和 将风格嵌入 作为输入,并分别输出比例和偏移向量:

为了解耦风格信息并学习风格不可知的文本表征,一个简单的解决方案是以不匹配、混淆的的风格信息为条件扰动文本序列,并阻止其生成风格一致的文本表征。我们利用领域泛化的最新进展 [4],通过扰动训练样本中的风格信息,设计了混合风格层归一化,以提升模型泛化性:

最后,我们采用音高预测器(Style-Agonistic Predictor)来预测风格不可知的韵律变化。通过在可泛化的文本编码器中使用混合风格层归一化,风格不可知(语言内容)和风格特定(例如,说话者身份、情感和韵律)信息相分离,提高语音合成模型的泛化性。

2.2 多级风格建模编码器

我们使用可泛化的 wav2vec 2.0 模型 [5] 来捕捉全局风格特征,包括语者和情感声学表征。wav2vec 2.0 是用于语音表示学习的自监督框架,遵循预训练和微调的两阶段训练过程,并已被证明其学习高判别性表征的能力。同时,我们也试验了基于 CNN 的卷积风格编码器 [6],其对语者和情感的建模表现也足够突出。

为了捕捉细粒度韵律细节,我们考虑了帧、音素和词三级别的特征。多层级的风格编码器共享相同的模型结构:输入序列经过几个卷积层后,仅在音素和词级编码器进行池化操作,以实现不同层级的风格化。随后,将学习的隐层序列通过瓶颈层进行量化,以有效地消除非韵律信息。

我们引入了风格到文本表征对齐层(Style-To-Content Alignment),以将可变长度的风格表征与文本表征对齐,用于学习风格和文本表征的时间对齐。我们采用 Scaled Dot Product 作为注意力机制模块,并堆叠多层以获得更好的对齐性能,逐渐将表征风格化。最后,我们利用音高预测器(Style-Specific Predictor)来生成风格特定的韵律变化。

高表现力语音通常包含丰富且高动态的细节,然而广泛应用的 Transformer 解码器很难生成高清晰度样本。因此为了进一步提高合成样本的质量和相似性,我们引入了基于流模型 [7] 的后处理网络来细化解码器输出。

实验结果

当文本与参考音频一致时,我们的模型可以泛化到域外未见风格(语者、情感、韵律等)的语音。在音频质量和风格相似性方面,与基准模型相比,GenerSpeech 获得了最高的主客观评测分数。多级风格编码器帮助生成与域外参考样本的风格更匹配的语音样本,清楚地反映正确的说话人特征、音高和共振峰范围。

我们还探讨了模型在非并行风格迁移中的鲁棒性,即模型根据参考样本的韵律风格合成具有不同文本内容的语音。相对于基线,评分者更偏好于本模型合成的样本结果。所提出的多级风格编码器显著改进了模型的风格感知能力,允许在域外未见参考样本的指导下,完成任一文本的高质量、高表现力风格迁移。

参考文献

[1] Wang Y, Stanton D, Zhang Y, et al. Style tokens: Unsupervised style modeling, control and transfer in end-to-end speech synthesis. In Proc. ICML 2018.

[2] Chen M, Tan X, Li B, et al. AdaSpeech: Adaptive Text to Speech for Custom Voice. In Proc. ICLR 2021

[3] Min D, Lee D B, Yang E, et al. Meta-stylespeech: Multi-speaker adaptive text-to-speech generation. In Proc. ICML 2021.

[4] Zhou K, Yang Y, Qiao Y, et al. Domain generalization with mixstyle. In Proc. ICLR 2021.

[5] Baevski A, Zhou Y, Mohamed A, et al. wav2vec 2.0: A framework for self-supervised learning of speech representations. In Proc. NeurIPS 2020.

[6] Wan L, Wang Q, Papir A, et al. Generalized end-to-end loss for speaker verification In Proc. ICASSP 2018.

[7] Ren Y, Liu J, Zhao Z. Portaspeech: Portable and high-quality generative text-to-speech. In Proc. NeurIPS 2021.

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

![[附源码]Node.js计算机毕业设计大悦城电竞赛事管理系统Express](https://img-blog.csdnimg.cn/114da38b708642cdbb855c0a178b8474.png)