概要

随着互联网的发展,大量的数据被存储在网络上,而我们需要从中获取有用的信息。Python作为一种功能强大且易于学习的编程语言,被广泛用于网络爬虫的开发。本文将详细介绍Python爬虫所需的技术及其原理,并提供相关的代码案例。

1. HTTP请求与响应

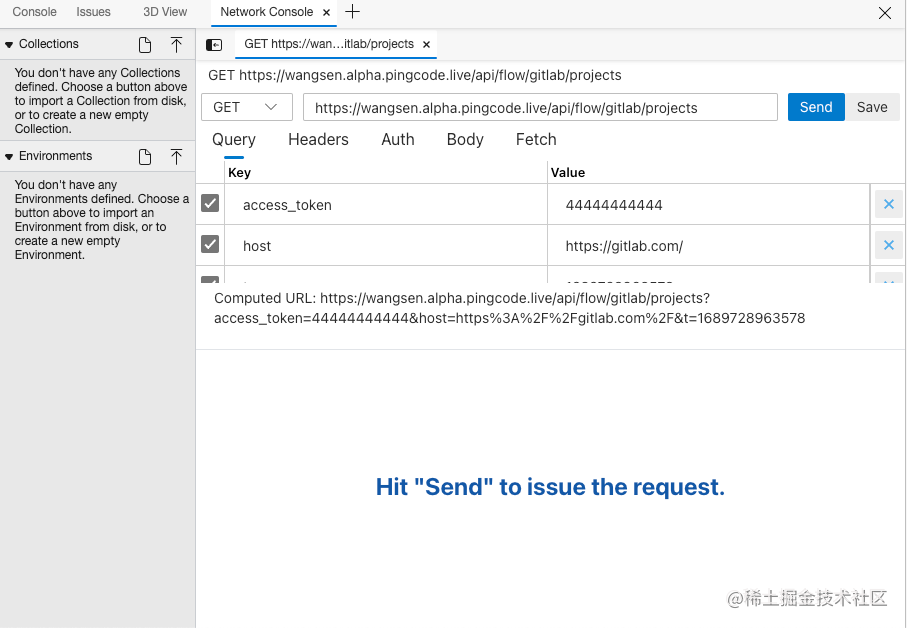

在爬取网页数据之前,我们需要了解HTTP协议,它是在Web上进行数据交互的基础协议。HTTP请求与响应是爬虫工作的基础,我们需要了解它们的结构和交互方式。

1.1 HTTP请求

HTTP请求由请求行、请求头和请求体组成。其中,请求行包括请求方法、请求的URL和协议版本;请求头包含了用于描述请求的各种信息;请求体是可选项,用于传输请求的数据。下面是一个HTTP请求的示例:

GET /path/to/resource HTTP/1.1 Host: www.example.com User-Agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3 Accept: text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8 ...

在Python中,我们可以使用requests库发送HTTP请求。下面是一个使用requests库发送GET请求的示例代码:

import requests url = 'http://www.example.com' response = requests.get(url) print(response.text)

1.2 HTTP响应

HTTP响应由响应行、响应头和响应体组成。响应行包含了响应的状态码和状态消息;响应头包含了用于描述响应的各种信息;响应体是实际返回的数据。下面是一个HTTP响应的示例:

HTTP/1.1 200 OK Content-Type: text/html; charset=utf-8 Content-Length: 1234 ... <html> ... </html>

在Python中,我们可以使用requests库获取HTTP响应。下面是一个获取HTTP响应的示例代码:

import requests url = 'http://www.example.com' response = requests.get(url) print(response.status_code) print(response.headers) print(response.text)

2. 网页解析技术

爬虫需要从网页中提取有用的数据,而网页通常采用HTML或XML格式存储。为了解析网页,我们可以使用以下几种技术。

2.1 正则表达式

正则表达式是一种强大的文本匹配技术,我们可以使用它来提取网页中的数据。例如,我们可以使用正则表达式提取HTML中的所有链接。

下面是一个使用正则表达式提取HTML中的链接的示例代码:

import re

html = '< a href=" ">Example</ a>'

links = re.findall('< a href="([^"]*)">([^<]*)</ a>', html)

for link in links:

print(link[0], link[1])

2.2 XPath

XPath是一种用于在XML文档中定位节点的语言,它可以与HTML文档一样使用。我们可以使用XPath提取网页中的数据。例如,我们可以使用XPath提取HTML中的所有链接。

下面是一个使用XPath提取HTML中的链接的示例代码(需要使用lxml库):

from lxml import etree

html = '< a href="http://www.example.com">Example</ a>'

tree = etree.HTML(html)

links = tree.xpath('//a')

for link in links:

print(link.get('href'), link.text)

2.3 BeautifulSoup

BeautifulSoup是一个HTML和XML解析库,提供了简单灵活的API。我们可以使用BeautifulSoup解析网页并提取数据。

下面是一个使用BeautifulSoup解析HTML并提取链接的示例代码(需要使用beautifulsoup4库):

from bs4 import BeautifulSoup

html = '< a href="http://www.example.com">Example</ a>'

soup = BeautifulSoup(html, 'html.parser')

links = soup.find_all('a')

for link in links:

print(link.get('href'), link.text)

2.4 提取数据

有了解析后的HTML内容,我们可以根据具体的需求,使用CSS选择器或XPath表达式来定位和提取所需的数据。

下面示范了使用BeautifulSoup提取网页中所有超链接的代码:

links = soup.select('a')

for link in links:

href = link['href']

text = link.get_text()

print(href, text)

在这个示例中,我们使用soup.select()方法配合CSS选择器字符串'a',选取网页中所有的<a>标签。然后使用link['href']和link.get_text()分别提取超链接的URL和文字内容。

2.5 数据存储与再处理

爬虫获取到数据后,通常需要将其保存起来供后续处理和分析。常见的存储方式有保存为文件(如CSV、JSON格式),或者存储到数据库中。

以下是一个使用csv库将提取的数据保存为CSV文件的示例代码:

import csv

data = [['url', 'text'], [href, text]]

with open('output.csv', 'w', newline='') as file:

writer = csv.writer(file)

writer.writerows(data)

在这个示例中,我们首先准备好要保存的数据data,其中包含了提取到的URL和文字内容。然后使用csv.writer()和writerows()方法将数据写入到CSV文件中。

3. 爬虫框架

在实际的爬虫开发中,我们通常会使用一些爬虫框架,它们提供了更高级别的抽象和更方便的功能。以下是一些常用的Python爬虫框架。

3.1 Scrapy

Scrapy是一个快速、可扩展且高级别的Web爬取框架。它提供了强大的抓取功能和数据处理能力,使爬虫开发更加高效。下面是一个使用Scrapy爬取网页的示例代码:

import scrapy class MySpider(scrapy.Spider): name = 'example.com' start_urls = ['http://www.example.com'] def parse(self, response): # 处理响应 # 提取数据 # 发送更多请求 pass

3.2 BeautifulSoup + requests

BeautifulSoup和requests的组合是另一种常用的爬虫开发方式。使用BeautifulSoup解析网页,使用requests发送HTTP请求。

下面是一个使用BeautifulSoup和requests爬取网页的示例代码:

import requests from bs4 import BeautifulSoup url = 'http://www.example.com' response = requests.get(url) soup = BeautifulSoup(response.text, 'html.parser') # 处理页面,提取数据

3.3 Selenium

Selenium是一种自动化浏览器工具,可以模拟浏览器行为。它通常与浏览器驱动一起使用,如ChromeDriver。使用Selenium可以解决一些JavaScript渲染的网页爬取问题。

下面是一个使用Selenium模拟浏览器爬取网页的示例代码(需要使用selenium库):

from selenium import webdriver

driver = webdriver.Chrome('path/to/chromedriver')

driver.get('http://www.example.com')

# 处理页面,提取数据

driver.quit()

4. 其他

除了了解基本的爬虫工作原理,还需要掌握一些相关的技术,以便更好地应对各种复杂情况。下面是几个常用的技术要点:

4.1 User-Agent伪装

为了防止网站屏蔽爬虫,我们可以在发送HTTP请求时设置User-Agent头部,将其伪装成浏览器的请求。这样可以减少被服务器识别为爬虫的概率。

Python requests库可以通过设置headers参数来添加自定义的HTTP头部。

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

response = requests.get(url, headers=headers)

4.2 反爬虫策略与解决方法

为了防止被爬虫抓取数据,网站可能会采取一些反爬虫策略,如限制请求频率、设置验证码、使用动态加载等。对于这些情况,我们可以采取以下解决方法:

-

限制请求频率:可以通过设置合适的时间间隔来控制请求的频率,避免过快访问网站。

-

验证码识别:可以使用第三方的验证码识别库(如Tesseract-OCR)来自动识别并输入验证码。

-

动态加载页面:对于使用JavaScript动态加载的页面,可以使用Selenium库模拟浏览器行为进行处理。

4.3 网页登录与Session管理

有些网站需要登录后才能获取到所需的数据。在这种情况下,我们可以通过模拟登录行为,发送POST请求并记录登录后的Session信息,以便后续的数据访问。

下面是一个使用requests库模拟登录的示例代码:

import requests

login_url = 'https://example.com/login'

data = {

'username': 'your_username',

'password': 'your_password'

}

response = requests.post(login_url, data=data)

session = response.cookies

data_url = 'https://example.com/data'

response = requests.get(data_url, cookies=session)

data = response.text

在这个示例中,我们首先发送POST请求模拟登录,将用户名和密码作为表单数据data发送给登录页面login_url,并保存返回的Session信息。

然后我们可以使用requests.get()方法发送GET请求,同时将保存的Session信息作为cookies参数传入,以便获取登录后的数据。

5. 实例:爬取简书网站文章信息

为了更好地演示Python爬虫的技术和原理,我们选取了简书网站作为示例。我们将爬取简书网站中的热门文章列表,提取出每篇文章的标题、作者和链接。

以下是完整的实现代码:

import requests

from bs4 import BeautifulSoup

# 发送HTTP请求

url = 'https://www.jianshu.com'

response = requests.get(url)

html = response.text

# 解析HTML内容

soup = BeautifulSoup(html, 'html.parser')

# 提取数据

articles = soup.select('.note-list li')

data = []

for article in articles:

title = article.select('a.title')[0].string.strip()

author = article.select('.name')[0].string.strip()

href = 'https://www.jianshu.com' + article.select('a.title')[0]['href']

data.append([title, author, href])

# 数据存储

import csv

with open('jianshu_articles.csv', 'w', newline='', encoding="utf-8") as file:

writer = csv.writer(file)

writer.writerows(data)

在这个示例中,我们首先发送GET请求获取简书网站的HTML内容,然后使用BeautifulSoup库进行解析。

接着,我们使用CSS选择器字符串.note-list li选取所有文章的外层容器,并使用CSS选择器和字典键值对的方式提取文章的标题、作者和链接。

最后,我们采用CSV格式将提取的数据保存到了名为jianshu_articles.csv的文件中。

结语

本文详细介绍了Python爬虫所需的技术及其原理,包括HTTP请求与响应、网页解析技术和爬虫框架。通过掌握这些技术,我们可以有效地开发出强大且高效的Python爬虫。希望本文能对你理解和掌握Python爬虫有所帮助。

请注意,在进行网络爬虫时,需要遵守网站的使用条款,并遵守相关法律法规。同时,合理使用爬虫技术,不对网络资源进行滥用和破坏。

欢迎点赞收藏转发,感谢🙏