🏆本篇论文发现了一种全局引导的局部匹配度(Global-guided Local Affinity (GLA))特征,用于构造上下文语义信息。基于此特性,作者设计了自适应上下文模块,构建自适应金字塔上下文网络(APCNet)。在不使用COCO数据集预训练模型的情况下,获得了2019年PASCAL VOC2012最高的分数

84.2%

文章目录

- 解决的问题

- 思路和主要过程

- 最优上下文向量的理想性质

- APCNet:Adaptive Pyramid Context Network

- 实验结果

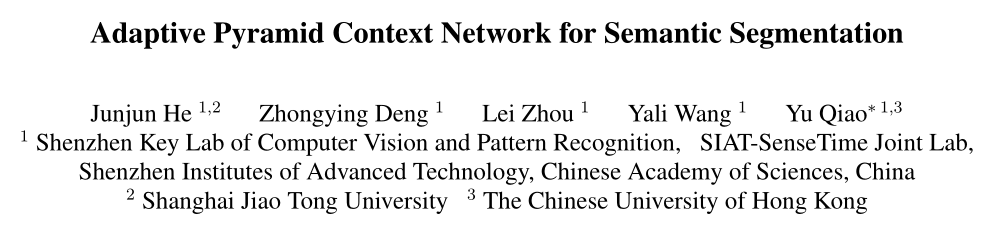

会议/期刊:CVPR2019

论文题目:《Adaptive Pyramid Context Network for Semantic Segmentation》

论文链接:Adaptive Pyramid Context Network for Semantic Segmentation

开源代码:Junjun2016/APCNet: Adaptive Pyramid Context Network for Semantic Segmentation (APCNet CVPR’2019) (github.com)

解决的问题

-

局部卷积感受野较小,且主要描述核心区域,忽略边界周围的背景。

-

不同物体可能有相似的特征,如木桌和椅子有相似的纹理,会造成歧义

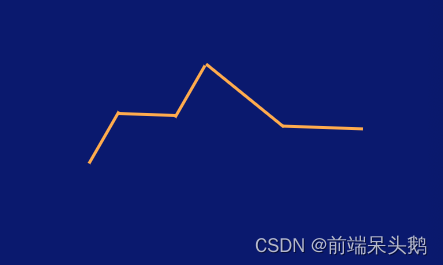

如下图,图片中的马和雪容易相互影响

同时,在以前的工作中,利用局部像素分配权重的方式,忽略了上下文信息。

-

不同数据集有不同的语境,传统的特征域自适应效果差,作者希望探索什么是最佳语境。

思路和主要过程

最优上下文向量的理想性质

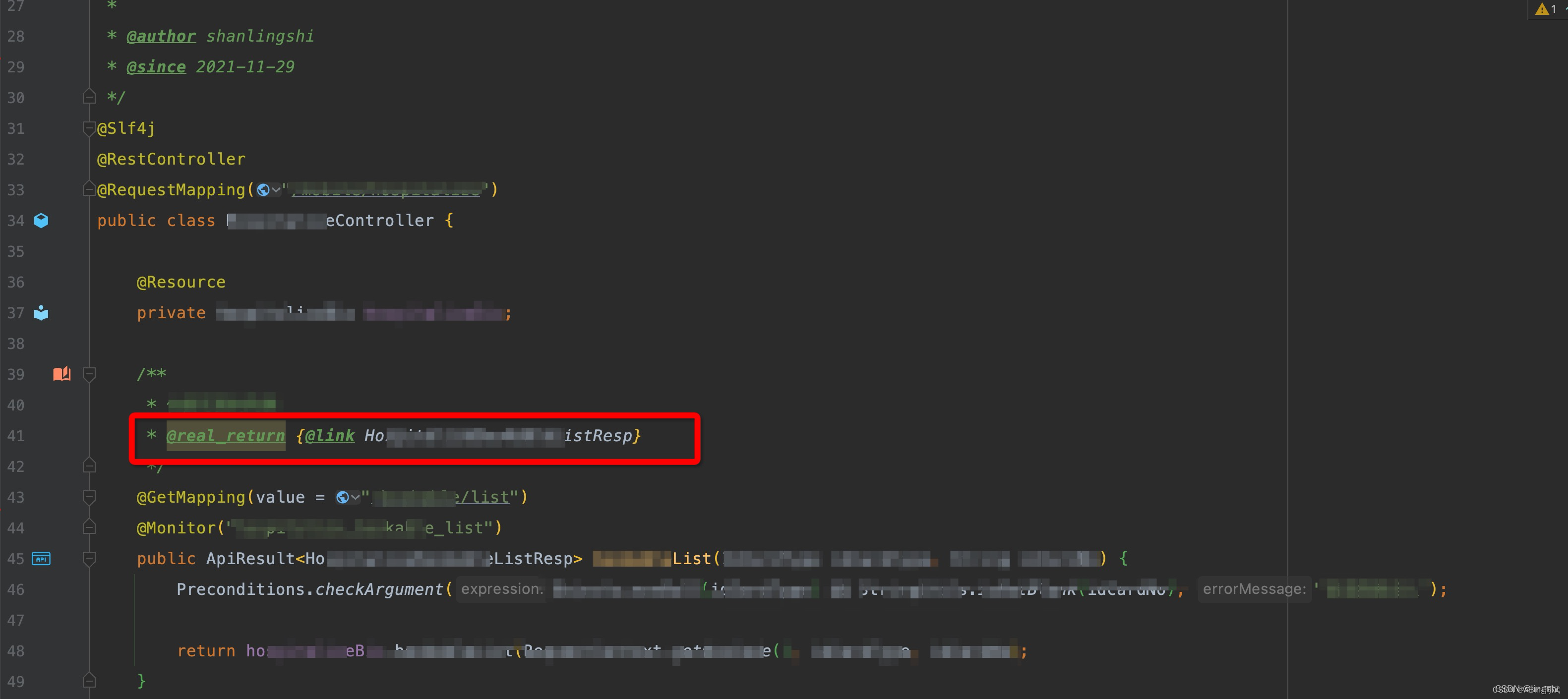

为了解决第三个问题,最近的一些工作DeepLabV3+、PSANet将上下文向量聚合到局部卷积特征以提高分割性能。

这些方法在构造上下文向量的方式上各不相同,并且在不同的数据集上执行不同的操作。所以有一个自然的问题,什么是语义分割的最佳语境。作者试图通过研究最优上下文向量应该表现出的理想性质来解决这个问题。最优上下文向量原则上应该可以描述与局部特征互补的、与分割相关的图像内容,同时,该向量应该与尽可能少的无关信息紧凑。具体地说,论文总结了以下三个关键属性:

-

多尺度

-

适应性:如何自动识别重要的区域

-

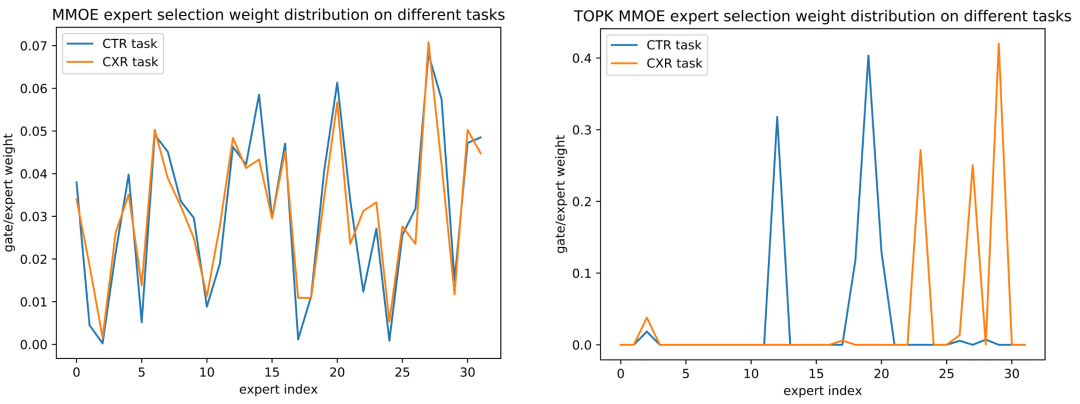

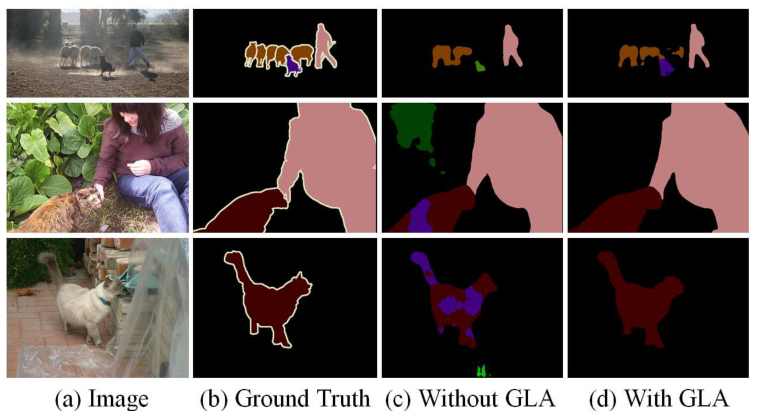

GLA:全局引导的局部匹配度

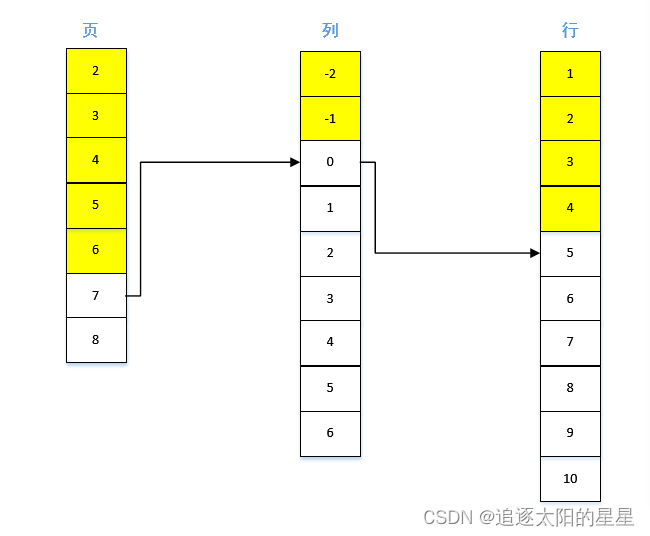

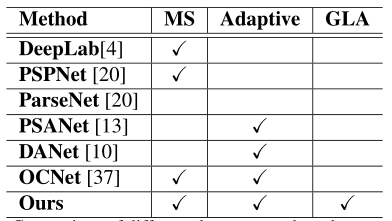

作者还总结了先前网络中这三个属性的分布情况

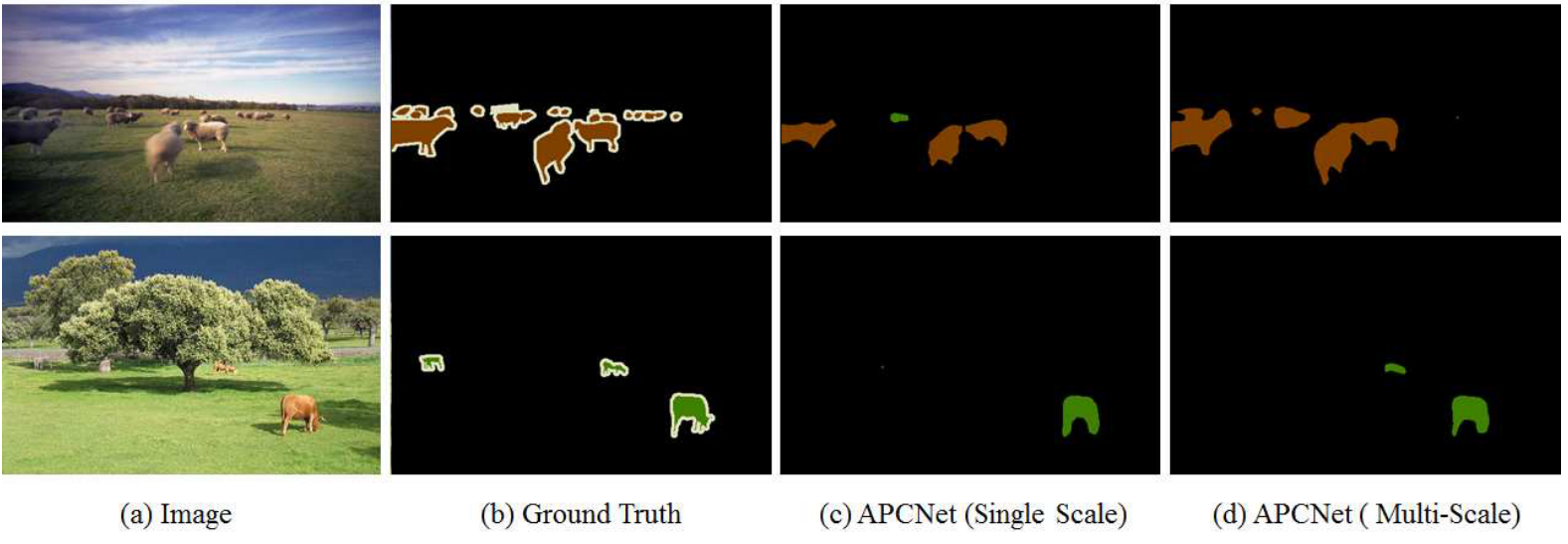

PS:MS: multi-scale, GLA: global-guided local affinity.

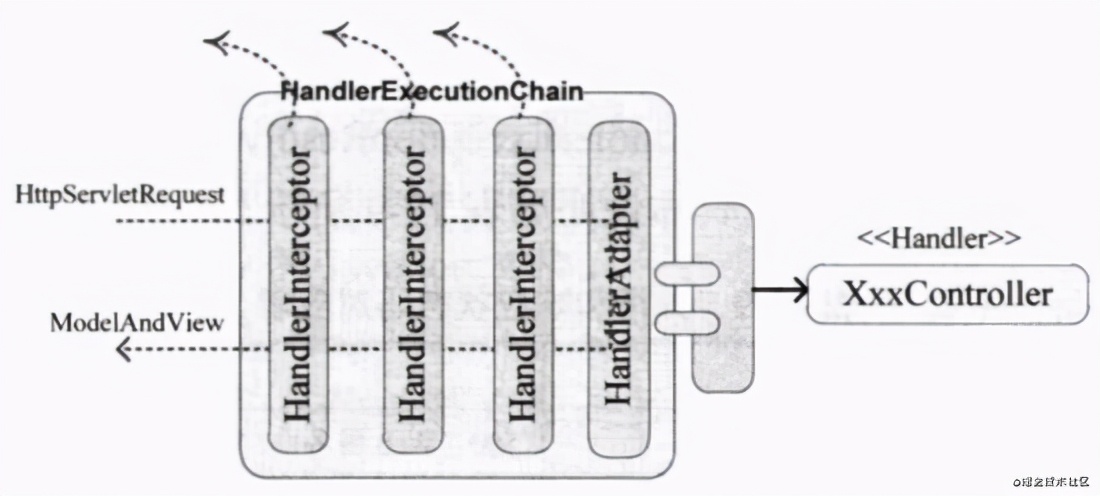

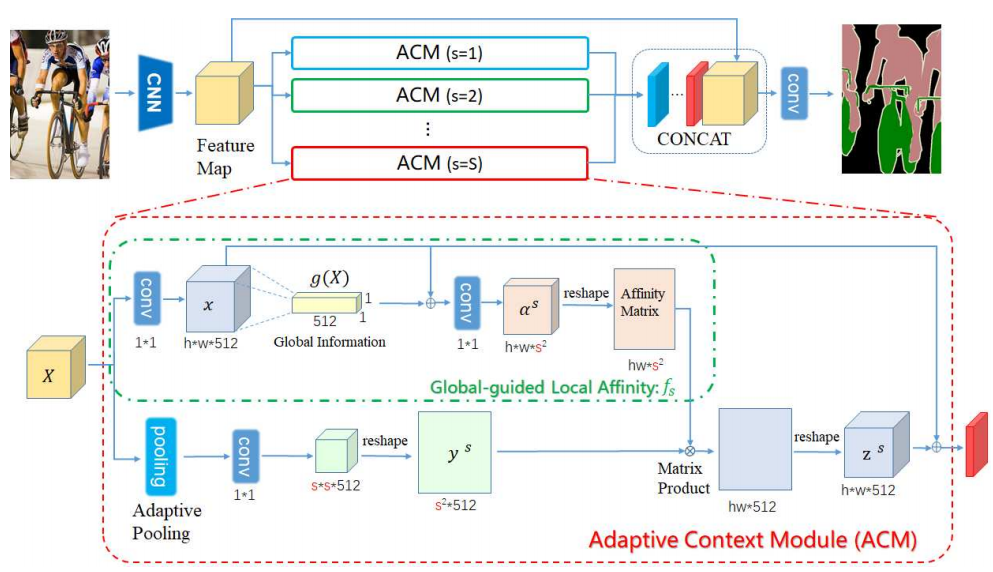

APCNet:Adaptive Pyramid Context Network

-

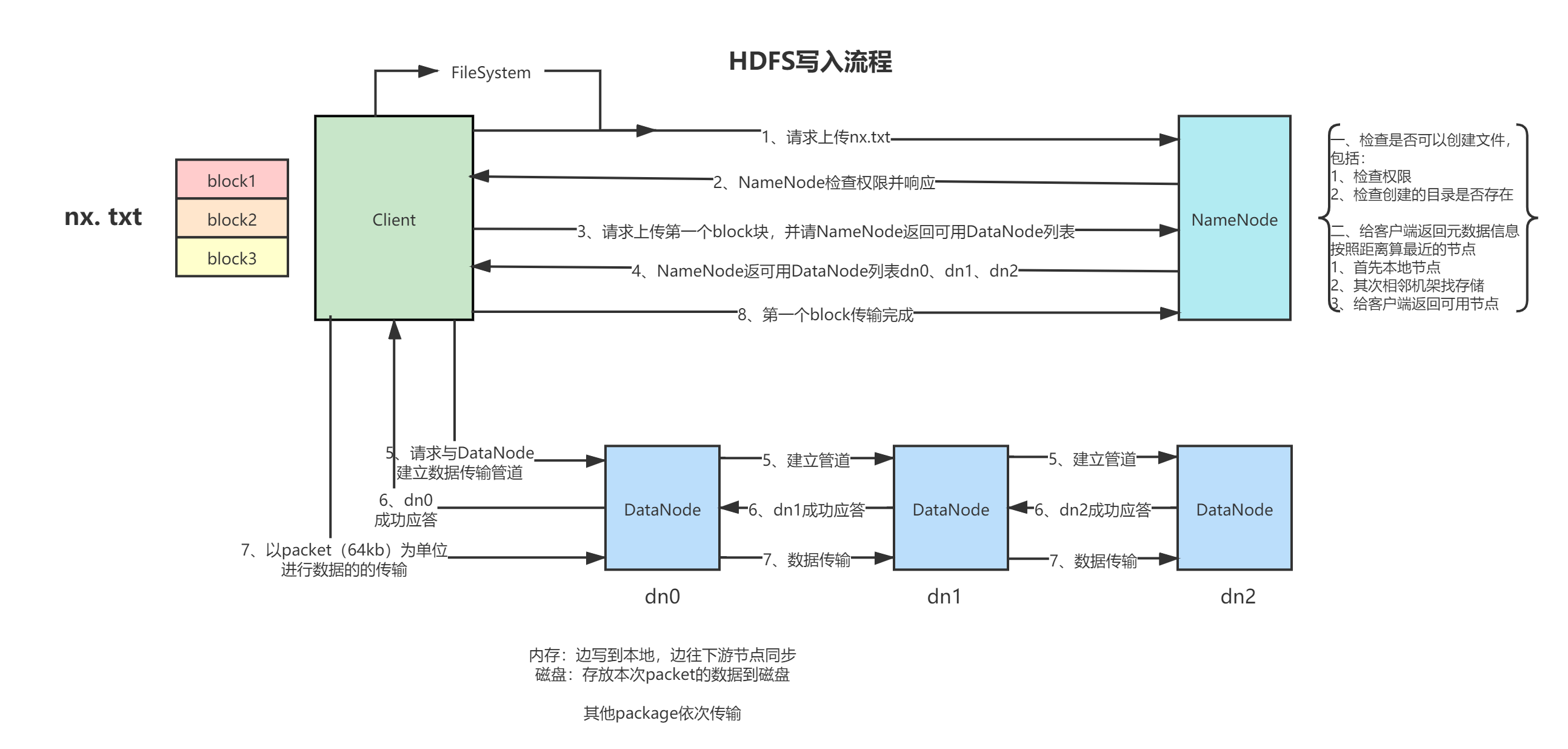

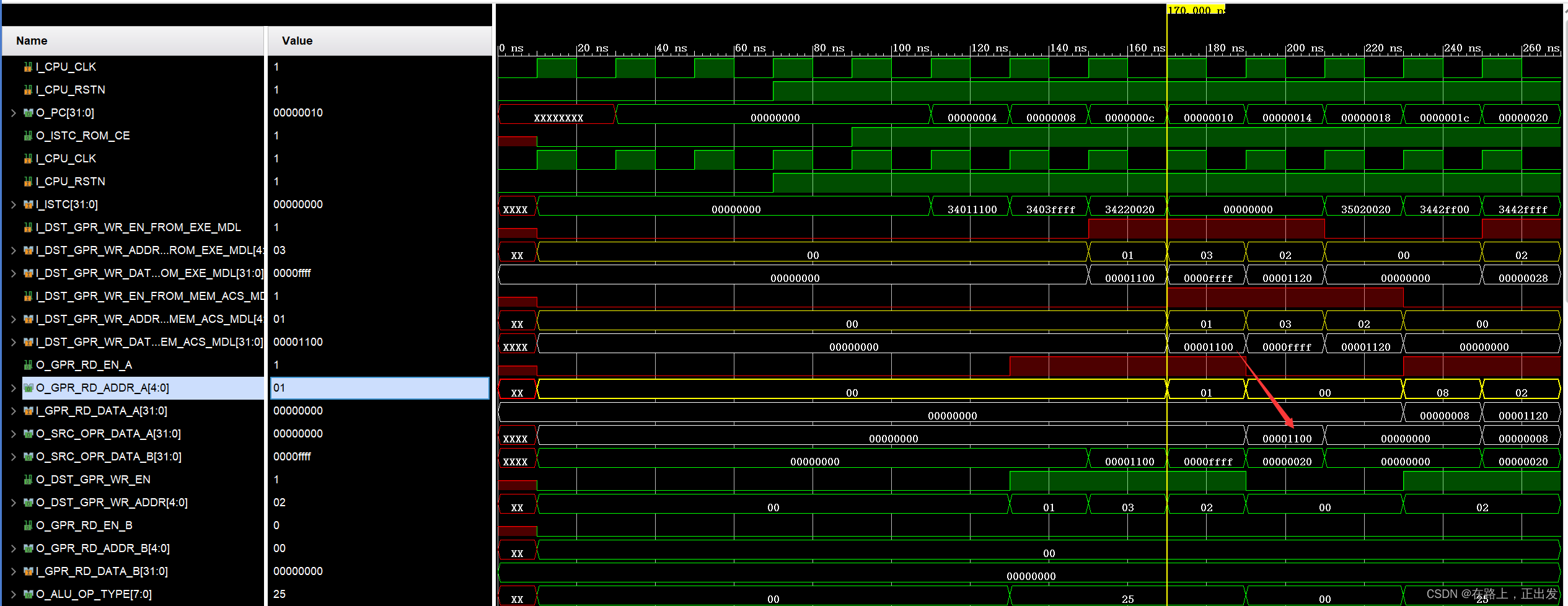

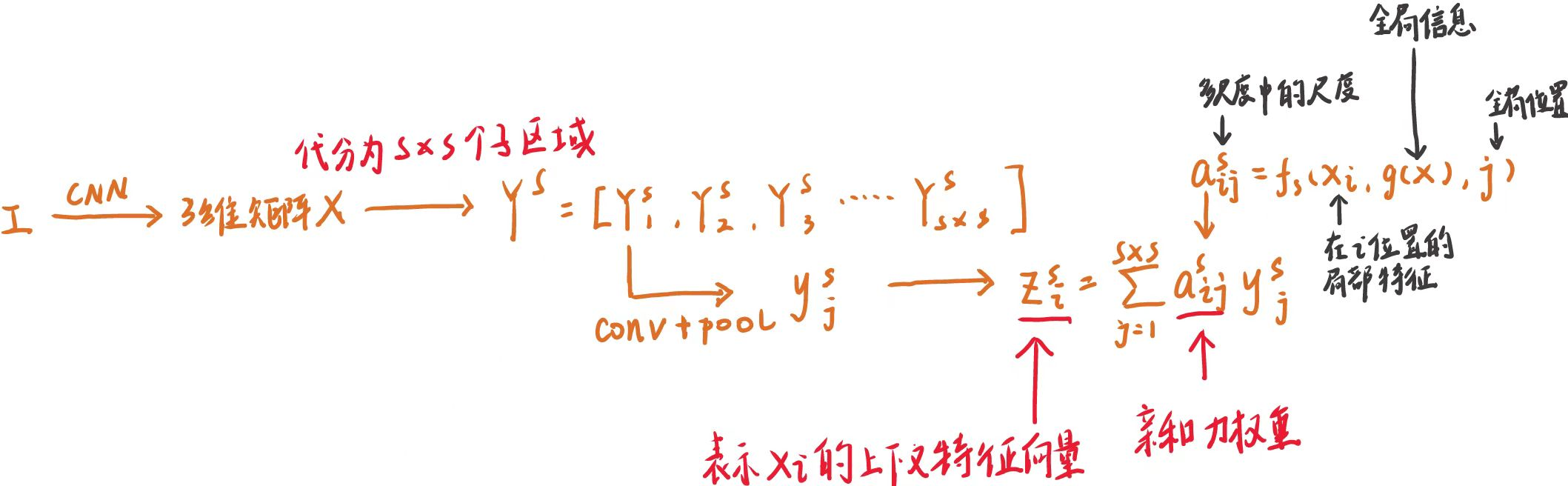

将输入图片经过主干网络卷积后,得到特征矩阵X(Feature Map),特征矩阵X分解为多个不同尺度,馈送到自适应上下文模块(ACM)以估计每个局部位置的自适应上下文向量。

-

对于不同s的ACM模块,又分为两个支路

-

1️⃣第一条(上路)是经过一个 1 ∗ 1 1*1 1∗1 的卷积,得到 h ∗ w ∗ 512 h*w*512 h∗w∗512 的特征矩阵,然后再平铺为一个长度为512的全局向量g(x),g(x)表示图片中的全局信息

-

将特征矩阵x和g(x)相乘。此步骤的意义是:利用局部特征x(i)和全局向量g(x),来计算每个局部位置i的全局亲和量 a i a_i ai(我觉得翻译成匹配度更好一点)

-

将GLA的亲和系数 a s a_s as 由3D矩阵( h ∗ w ∗ s 2 h*w*s^2 h∗w∗s2)reshape成2D矩阵 h w ∗ s 2 hw*s^2 hw∗s2,等待输入。这个过程就是计算 f s ( x i , g ( x ) , j ) f_s(x_i,g(x),j) fs(xi,g(x),j) 的过程

-

2️⃣第二条(下路)经过自适应池化+卷积,获取全局信息,得到 s ∗ s ∗ 512 s*s*512 s∗s∗512 的卷积,然后再reshape成 s 2 ∗ 512 s^2*512 s2∗512 的2维矩阵 y s y^s ys,然后再和 f s ( x i , g ( x ) , j ) f_s(x_i,g(x),j) fs(xi,g(x),j)相乘

-

最后reshape得到一个3维矩阵 z s z^s zs,这样,一个s的ACM模块就构建好了。它的输入输出都是一个 h ∗ w ∗ 512 h*w*512 h∗w∗512的矩阵

-

-

将特征矩阵X(Feature Map)和ACM(s=1、2、3………)矩阵拼接在一起,得到分割结果

上图用数学可以表示为:

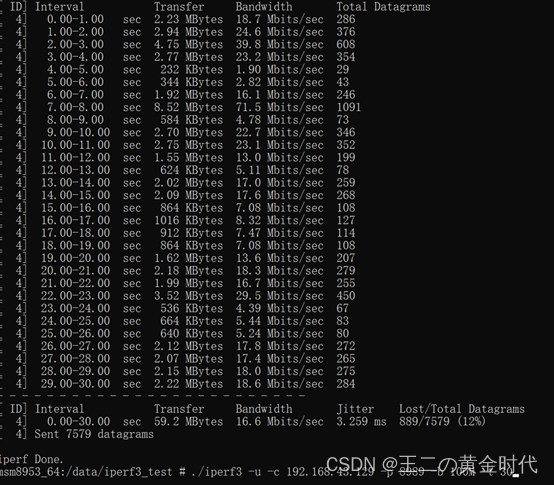

实验结果

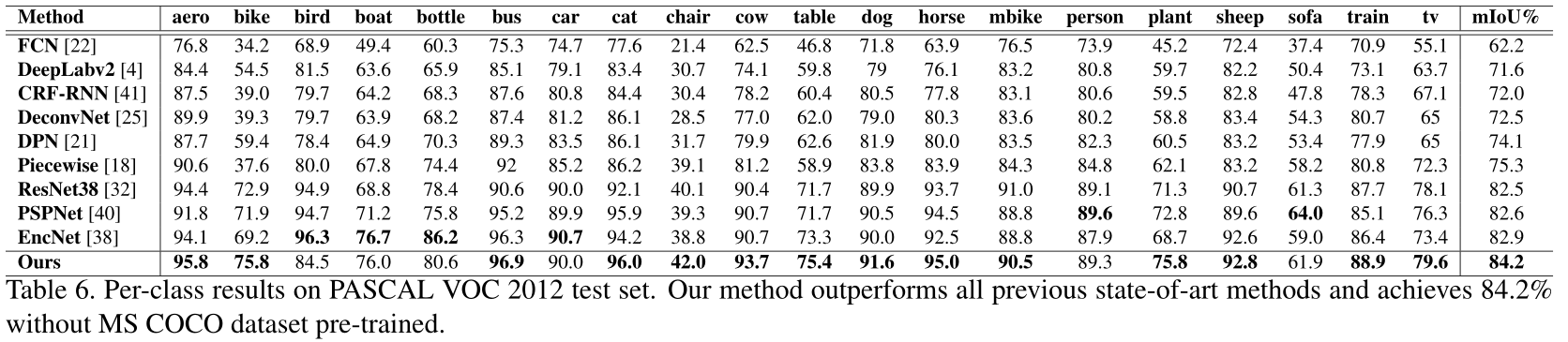

在不经过COCO预训练的情况下,mIoU达到84.2%

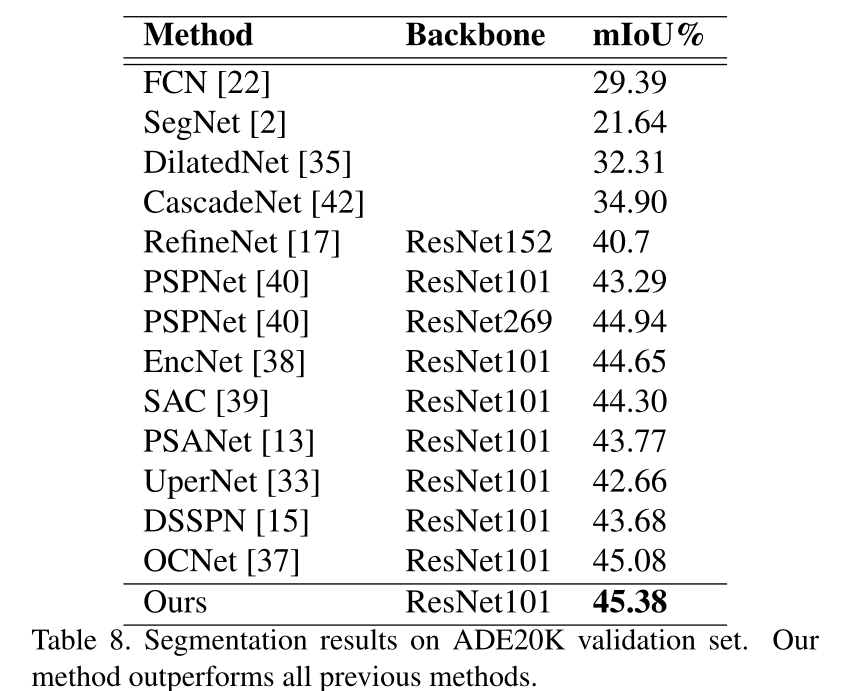

在ADE20K验证集上,达到45.38%的mIoU