目录

1 引言

2 支持向量机的理论基础

1. 什么是支持向量,它们在模型中的作用是什么?

2. 线性支持向量机的数学原理

3. 解释如何通过核技巧来处理非线性问题

4. 支持向量机的优点和局限

3 支持向量机的实践

1. 如何使用Python的sklearn库创建和训练支持向量机模型?

2. 如何进行模型的评估?

3. 如何使用交叉验证和网格搜索进行模型选择和调参?

4 实战案例:文本分类

1. 简单介绍案例背景和目标。

2. 展示如何读取和分析数据。

3. 创建并训练支持向量机模型,以及评估模型性能。

4. 如何解读模型参数,以及模型结果的业务解读。

5 超越支持向量机

1. 当支持向量机不满足需求时,我们可以使用什么模型(如神经网络)。

2. 支持向量机与其他模型(如逻辑回归,决策树等)的比较。

结语

1. 支持向量机的重要性和局限性。

2. 对后续的学习内容的预告。

1 引言

支持向量机(SVM)是一种被广泛应用于分类、回归、甚至是异常检测任务的强大且灵活的监督学习模型。基于其结构风险最小化的原则,SVM试图找到一个超平面使得两类样本间隔最大,从而提高模型的泛化能力。SVM不仅在面对线性可分问题上有出色的表现,而且通过所谓的“核技巧”也能有效处理非线性问题。举例来说,SVM在处理文本分类、图像识别、生物信息学等领域的问题时都有卓越的表现。

2 支持向量机的理论基础

1. 什么是支持向量,它们在模型中的作用是什么?

在SVM中,支持向量指的是最接近决策边界的数据点,即这些数据点对决策边界产生直接影响。换句话说,如果移除这些支持向量,那么决策边界(超平面)将会改变。这也说明了“支持向量机”的名字的由来,因为这些向量“支持”着决策的边界。

2. 线性支持向量机的数学原理

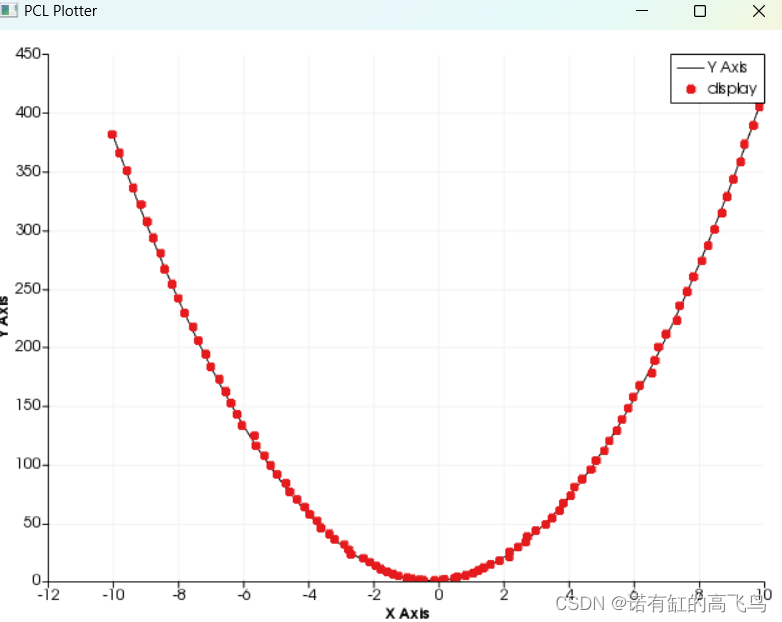

线性支持向量机的目标是寻找一个能最大化两类样本间距离的超平面。数学上,这个问题可以转化为求解一个凸二次规划问题。超平面的形式为f(x) = w*x + b,其中w是权重向量,b是偏置项。求解过程涉及到拉格朗日乘数法和KKT条件。

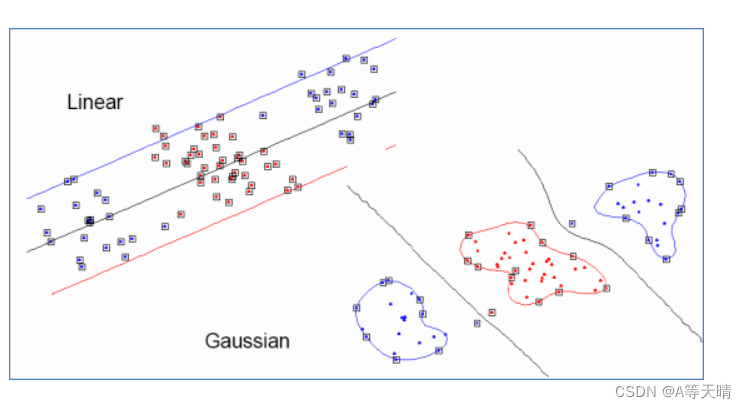

3. 解释如何通过核技巧来处理非线性问题

在许多情况下,原始的特征空间可能无法线性分隔。这时,我们可以通过核技巧将数据映射到一个更高维度的空间,在那里数据变得线性可分。常用的核函数有线性核、多项式核、径向基函数核(RBF)等。

4. 支持向量机的优点和局限

SVM具有以下优点:它可以处理高维度的数据;它只关注支持向量,因此对于大样本数据集,SVM的效率较高;它通过使用不同的核函数可以解决非线性问题。

然而,SVM也有其局限性:对于噪声数据和离群点敏感;对于非线性问题,选择和调整合适的核函数可能需要很多经验和技巧;处理大规模数据集时,需要大量的计算资源。

3 支持向量机的实践

1. 如何使用Python的sklearn库创建和训练支持向量机模型?

Sklearn库提供了非常方便的接口来创建和训练支持向量机模型。首先我们需要导入所需的模块,然后创建一个SVM模型实例,并调用fit方法来训练模型。

from sklearn import svm

from sklearn.datasets import make_classification

# 生成模拟的分类数据

X, y = make_classification(n_samples=100, n_features=2, n_informative=2, n_redundant=0, random_state=42)

# 创建SVM模型实例

model = svm.SVC(kernel='linear')

# 训练模型

model.fit(X, y)

在这个例子中,我们使用线性核创建了一个SVM模型,然后用生成的分类数据进行训练。

2. 如何进行模型的评估?

模型训练完成后,我们可以用测试数据集对其进行评估。常见的评估指标有准确率(accuracy),精确率(precision),召回率(recall)和F1得分。

from sklearn.metrics import classification_report

from sklearn.model_selection import train_test_split

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 训练模型

model.fit(X_train, y_train)

# 进行预测

y_pred = model.predict(X_test)

# 打印分类报告

print(classification_report(y_test, y_pred))

3. 如何使用交叉验证和网格搜索进行模型选择和调参?

交叉验证是一种评估模型泛化能力的方法,而网格搜索则是一种寻找最优参数的方法。Sklearn提供了GridSearchCV来实现这两个功能。

from sklearn.model_selection import GridSearchCV

# 定义参数网格

param_grid = {'C': [0.1, 1, 10, 100], 'gamma': [1, 0.1, 0.01, 0.001], 'kernel': ['linear', 'poly', 'rbf']}

# 创建GridSearchCV实例

grid = GridSearchCV(svm.SVC(), param_grid, refit=True, verbose=2, cv=5)

# 执行网格搜索

grid.fit(X_train, y_train)

# 打印最优参数

print(grid.best_params_)

# 使用最优参数的模型进行预测

grid_predictions = grid.predict(X_test)

# 打印分类报告

print(classification_report(y_test, grid_predictions))

这个例子中,我们定义了一个参数网格,包含三个参数:C,gamma和kernel。然后用GridSearchCV进行网格搜索,最后用找到的最优参数的模型进行预测和评估。

4 实战案例:文本分类

1. 简单介绍案例背景和目标。

在这个案例中,我们将使用支持向量机(SVM)来处理一个常见的机器学习任务:文本分类。具体来说,我们将使用20 Newsgroups数据集,这是一个用于文本分类、文本挖掘和信息检索研究的国际标准数据集。数据集包含约20000篇新闻,分布在20个不同的新闻组中。我们的目标是根据这些新闻的内容,准确地预测它们所属的新闻组。

2. 展示如何读取和分析数据。

读取和分析数据是任何机器学习项目的开始,我们通常会使用pandas和numpy等工具进行数据处理和分析。在这个案例中,我们可以使用sklearn库提供的函数直接加载20 Newsgroups数据集。

from sklearn.datasets import fetch_20newsgroups

# 加载数据

newsgroups_train = fetch_20newsgroups(subset='train')

# 查看数据

print(list(newsgroups_train.target_names))

3. 创建并训练支持向量机模型,以及评估模型性能。

在训练模型之前,我们首先需要将文本数据转化为可以输入到模型中的数值形式。这可以通过一种称为TF-IDF的技术来实现。然后我们可以创建SVM模型并进行训练。

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn import svm

from sklearn.metrics import classification_report

# 将文本数据转化为TF-IDF向量

vectorizer = TfidfVectorizer()

vectors = vectorizer.fit_transform(newsgroups_train.data)

# 创建SVM模型

model = svm.SVC(kernel='linear')

# 训练模型

model.fit(vectors, newsgroups_train.target)

# 在测试数据上评估模型

newsgroups_test = fetch_20newsgroups(subset='test')

vectors_test = vectorizer.transform(newsgroups_test.data)

pred = model.predict(vectors_test)

print(classification_report(newsgroups_test.target, pred, target_names=newsgroups_test.target_names))

4. 如何解读模型参数,以及模型结果的业务解读。

在SVM模型中,最重要的参数就是支持向量和它们对应的系数,它们决定了决策边界的位置。我们可以通过model.support_vectors_和model.dual_coef_来获取这些信息。但在高维空间中,这些信息很难直观地理解。

从业务角度来看,文本分类可以用在许多场景,比如新闻分类、情感分析、垃圈过滤等。在这个案例中,我们的模型可以根据新闻的内容准确地预测出它所属的类别,这对于新闻推荐、自动标签生成等任务有很大的帮助。

5 超越支持向量机

1. 当支持向量机不满足需求时,我们可以使用什么模型(如神经网络)。

支持向量机是一种强大的机器学习模型,特别适用于中小规模的分类问题。然而,当我们面对大规模的数据或者非常复杂的非线性问题时,神经网络可能是一个更好的选择。特别是深度学习,如卷积神经网络(CNN)和循环神经网络(RNN)等模型,在处理图像、语音、文本等复杂数据时表现出极高的性能。

2. 支持向量机与其他模型(如逻辑回归,决策树等)的比较。

支持向量机、逻辑回归和决策树都是常用的分类模型,各有优缺点:

-

支持向量机的主要优点是可以有效处理线性和非线性问题,尤其在中小规模的高维数据上表现出色。但是,SVM模型训练时间长,对于大规模数据不太适用,而且对于参数和核函数的选择敏感,这需要专业知识和经验。

-

逻辑回归是一种简单但强大的线性分类器。它的主要优点是模型简单,易于理解和实施,可以给出预测概率。缺点是处理不好非线性问题。

-

决策树的优点是简单直观,人们可以直接看到决策过程。决策树可以处理线性和非线性数据,不需要预处理数据,如规范化。但决策树容易过拟合,对噪声和异常值敏感。

结语

1. 支持向量机的重要性和局限性。

支持向量机是一种强大的分类方法,具有良好的理论基础,能够有效处理高维数据和非线性问题。然而,SVM也有其局限性,比如对于大规模的数据处理效率不高,对参数和核函数的选择较为敏感。

2. 对后续的学习内容的预告。

虽然我们已经介绍了几种常见的机器学习模型,但机器学习的世界远不止这些。接下来,我们将进入一种全新的模型——神经网络。神经网络是近年来人工智能领域最热门的话题之一,它强大的学习能力和广泛的应用领域都值得我们深入学习和探索。

![LeetCode[912]排序数组](https://img-blog.csdnimg.cn/7034baa5a8204b4caf4057f0a9ea3a75.png)