【Kafka】Kafka的Broker概述

文章目录

- 【Kafka】Kafka的Broker概述

- 1. Broker的工作流程

- 1.1 Zookeeper存储的Kafka信息

- 1.2 Broker 总体工作流程

- 1.3 Broker重要参数

- 2. 节点服役和退役

- 2.1 服役新节点

- 2.2 退役旧节点

- 3. Kafka副本

- 3.1 副本信息

- 3.2 Leader选举流程

- 3.3 Leader 和 Follower 故障处理细节

- 3.4 分区副本分配

- 3.5 手动调整分区副本存储

- 3.6 Leader Partition 负载均衡

1. Broker的工作流程

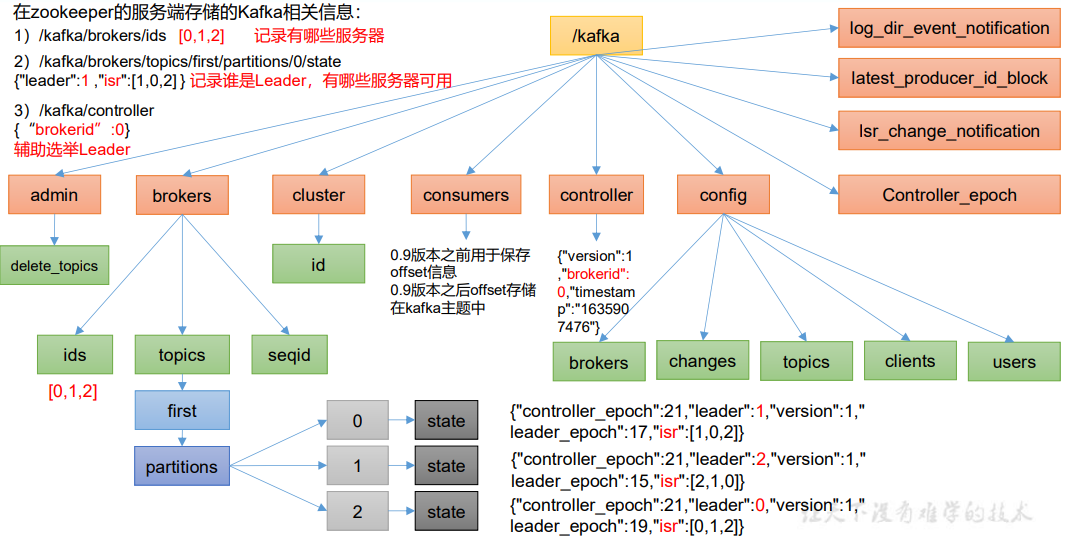

1.1 Zookeeper存储的Kafka信息

1.2 Broker 总体工作流程

1.3 Broker重要参数

| 参数名称 | 描述 |

|---|---|

| replica.lag.time.max.ms | ISR 中,如果 Follower 长时间未向 Leader 发送通 信请求或同步数据,则该 Follower 将被踢出 ISR。 该时间阈值,默认 30s。 |

| auto.leader.rebalance.enable | 默认是 true。 自动 Leader Partition 平衡。 |

| leader.imbalance.per.broker.percentage | 默认是 10%。每个 broker 允许的不平衡的 leader 的比率。如果每个 broker 超过了这个值,控制器 会触发 leader 的平衡。 |

| leader.imbalance.check.interval.seconds | 默认值 300 秒。检查 leader 负载是否平衡的间隔时间。 |

| log.segment.bytes | Kafka 中 log 日志是分成一块块存储的,此配置是 指 log 日志划分 成块的大小,默认值 1G。 |

| log.index.interval.bytes | 默认 4kb,kafka 里面每当写入了 4kb 大小的日志 (.log),然后就往 index 文件里面记录一个索引。 |

| log.retention.hours | Kafka 中数据保存的时间,默认 7 天。 |

| log.retention.minutes | Kafka 中数据保存的时间,分钟级别,默认关闭。 |

| log.retention.ms | Kafka 中数据保存的时间,毫秒级别,默认关闭。 |

| log.retention.check.interval.ms | 检查数据是否保存超时的间隔,默认是 5 分钟。 |

| log.retention.bytes | 默认等于-1,表示无穷大。超过设置的所有日志总 大小,删除最早的 segment。 |

| log.cleanup.policy | 默认是 delete,表示所有数据启用删除策略; 如果设置值为 compact,表示所有数据启用压缩策 略。 |

| num.io.threads | 默认是 8。负责写磁盘的线程数。整个参数值要占 总核数的 50%。 |

| num.replica.fetchers | 副本拉取线程数,这个参数占总核数的 50%的 1/3 |

| log.flush.interval.messages | 强制页缓存刷写到磁盘的条数,默认是 long 的最 大值,9223372036854775807。一般不建议修改, 交给系统自己管理。 |

| log.flush.interval.ms | 每隔多久,刷数据到磁盘,默认是 null。一般不建 议修改,交给系统自己管理。 |

2. 节点服役和退役

2.1 服役新节点

- 克隆集群中任意一个节点,以node3节点为例,关闭node3节点,克隆该节点为node4

- 开启node4,修改ip地址,修改主机名为node4

- 重启node3和node4

- 修改node4中的kafka的broker.id为3

- 删除node4中kafka目录下的data目录和logs目录

- 启动node1,node2,node3中的kafka集群

- 单独启动node4中的kafka,这样就完成了新节点的服役。

但是我们发现,新节点服役之后,之前创建的topic还是只存在之前的节点中,于是我们创建一个要均衡的主题。

- 创建一个要均衡的主题。

[atguigu@hadoop102 kafka]$ vim topics-to-move.json

//粘贴如下内容

{

"topics": [

{"topic": "first"}

],

"version": 1

}

- 生成一个负载均衡的计划。

[atguigu@hadoop102 kafka]$ bin/kafka-reassign-partitions.sh --bootstrap-server hadoop102:9092 --topics-to-move-json-file topics-to-move.json --broker-list "0,1,2,3" --generate

Current partition replica assignment

{"version":1,

"partitions":[

{"topic":"first","partition":0,"replicas":[0,2,1],"log_dirs":["any","any","any"]},

{"topic":"first","partition":1,"replicas":[2,1,0],"log_dirs":["any","any","any"]},

{"topic":"first","partition":2,"replicas":[1,0,2],"log_dirs":["any","any","any"]}

]

}

Proposed partition reassignment configuration

{"version":1,

"partitions":[

{"topic":"first","partition":0,"replicas":[2,3,0],"log_dirs":["any","any","any"]},

{"topic":"first","partition":1,"replicas":[3,0,1],"log_dirs":["any","any","any"]},

{"topic":"first","partition":2,"replicas":[0,1,2],"log_dirs":["any","any","any"]}

]

}

- 创建副本存储计划(所有副本存储在broker0、broker1、broker2、broker3 中)。

[atguigu@hadoop102 kafka]$ vim increase-replication-factor.json

//粘贴如下内容

{"version":1,"partitions":[

{"topic":"first","partition":0,"replicas":[2,3,0],"log_dirs":["any","any","any"]},

{"topic":"first","partition":1,"replicas":[3,0,1],"log_dirs":["any","any","any"]},

{"topic":"first","partition":2,"replicas":[0,1,2],"log_dirs":["any","any","any"]}

]

}

- 执行副本存储计划

[atguigu@hadoop102 kafka]$ bin/kafka-reassign-partitions.sh --bootstrap-server hadoop102:9092 --reassignment-json-file increase-replication-factor.json --execute

- 验证副本存储计划

[atguigu@hadoop102 kafka]$ bin/kafka-reassign-partitions.sh --bootstrap-server hadoop102:9092 --reassignment-json-file increase-replication-factor.json --verify

Status of partition reassignment:

Reassignment of partition first-0 is complete.

Reassignment of partition first-1 is complete.

Reassignment of partition first-2 is complete.

Clearing broker-level throttles on brokers 0,1,2,3

Clearing topic-level throttles on topic first

2.2 退役旧节点

退役node4节点,退役旧节点操作如下:

- 创建一个要均衡的主题

[atguigu@hadoop102 kafka]$ vim topics-to-move.json

{

"topics": [

{"topic": "first"}

],

"version": 1

}

- 创建执行计划

[atguigu@hadoop102 kafka]$ bin/kafka-reassign-partitions.sh --bootstrap-server hadoop102:9092 --topics-to-move-json-file topics-to-move.json --broker-list "0,1,2" --generate

Current partition replica assignment

{"version":1,"partitions":[

{"topic":"first","partition":0,"replicas":[2,0,1],"log_dirs":["any","any","any"]},

{"topic":"first","partition":1,"replicas":[3,1,2],"log_dirs":["any","any","any"]},

{"topic":"first","partition":2,"replicas":[0,2,3],"log_dirs":["any","any","any"]}

]

}

Proposed partition reassignment configuration

{"version":1,"partitions":[

{"topic":"first","partition":0,"replicas":[2,0,1],"log_dirs":["any","any","any"]},

{"topic":"first","partition":1,"replicas":[0,1,2],"log_dirs":["any","any","any"]},

{"topic":"first","partition":2,"replicas":[1,2,0],"log_dirs":["any","any","any"]}

]

}

- 创建副本存储计划(所有副本存储在 broker0、broker1、broker2 中)

[atguigu@hadoop102 kafka]$ vim increase-replication-factor.json

{"version":1,"partitions":[

{"topic":"first","partition":0,"replicas":[2,0,1],"log_dirs":["any","any","any"]},

{"topic":"first","partition":1,"replicas":[0,1,2],"log_dirs":["any","any","any"]},

{"topic":"first","partition":2,"replicas":[1,2,0],"log_dirs":["any","any","any"]}

]

}

- 执行副本存储计划

[atguigu@hadoop102 kafka]$ bin/kafka-reassign-partitions.sh --bootstrap-server hadoop102:9092 --reassignment-json-file increase-replication-factor.json --execute

- 验证副本存储计划

[atguigu@hadoop102 kafka]$ bin/kafka-reassign-partitions.sh --bootstrap-server hadoop102:9092 --reassignment-json-file increase-replication-factor.json --verify

Status of partition reassignment:

Reassignment of partition first-0 is complete.

Reassignment of partition first-1 is complete.

Reassignment of partition first-2 is complete.

Clearing broker-level throttles on brokers 0,1,2,3

Clearing topic-level throttles on topic first

- 在退役节点上执行停止命令

bin/kafka-server-stop.sh

3. Kafka副本

3.1 副本信息

- Kafka副本作用:提高数据可靠性

- Kafka默认副本1个,生产环境一般配置2个,保证数据可靠性;太多副本会增加磁盘存储空间,增加网络上数据传输,降低效率。

- Kafka中副本分为:Leader 和 Follower 。Kafka生产者只会把数据发往 Leader,然后 Follower 找 Leader 进行同步数据。

- Kafka分区中所有副本统称为

AR(Assigned Replicas)。- AR=ISR+OSR

- ISR:表示和Leader保持同步的Follower集合,如果Follower长时间未向Leader发送通信请求或同步数据,则该Follower将被踢出ISR。该时间阈值由

replica.lag.time.max.ms参数设定,默认30s。Leader发生故障之后,就会从ISR中选举新的Leader - OSR:表示Follower与Leader副本同步时,延迟过多的副本。

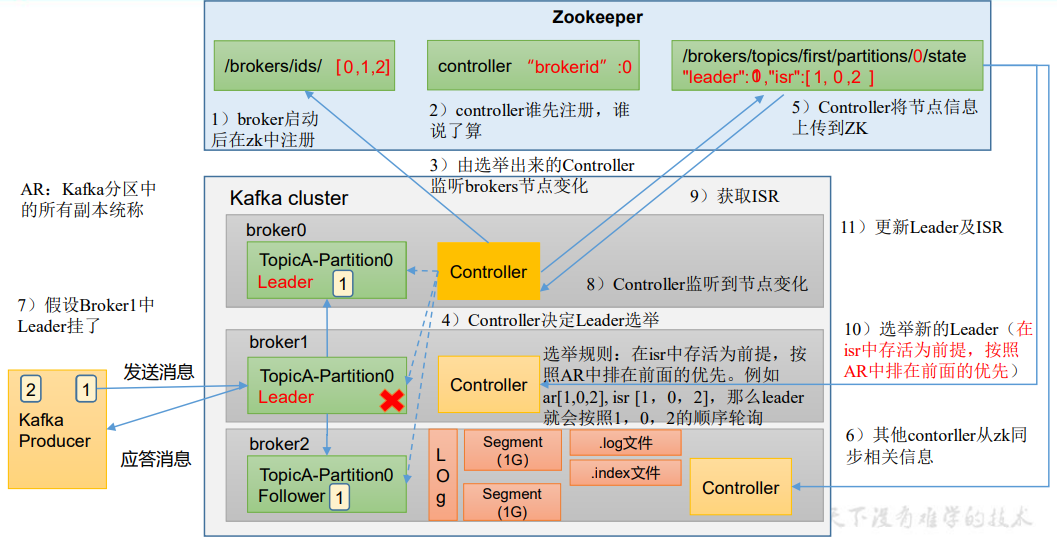

3.2 Leader选举流程

Kafka集群中有一个broker的Controller会被选举为Controller Leader,负责管理集群broker的上下线,所有topic的分区副本分配和Leader选举等工作。

Controller的信息同步工作是依赖于Zookeeper的。

Leader选举流程如下:

- broker启动后依次在ZK中注册。

- 由第一个注册的broker中的Controller监听brokers节点的变化

- 由第一个Controller决定Leader的选举

- 选举规则:在isr中存活作为前提,按照AR中排在前面的优先。例如ar[1,0,2],isr[1,0,2],那么leader就会按照1,0,2的顺序轮询。

- Controller将节点信息上传到ZK,其他broker的Controller从ZK中同步相关信息

- 假设Broker1中的Leader挂了,由于第一个Controller一直监听brokers节点的变化,于是拉取ISR进行新的Leader选举

3.3 Leader 和 Follower 故障处理细节

- LEO(Log End Offset):每个副本的最后一个offset,LEO其实就是最新的offset + 1

- HW(High Watermark):所有副本中最小的LEO

Follower故障:

- Follower发生故障后会被临时提出ISR

- 这个期间Leader和Follower继续接收数据

- 待该Follower恢复后,Follower会读取本地磁盘记录的上次的HW,并将log文件高于HW的部分截掉,从HW开始向Leader进行同步

- 等该Follower的LEO大于等于该Partition的HW,即Follower追上Leader之后,就可以重新加入ISR了。

Leader故障:

- Leader发生故障之后,会从ISR中选出一个新的Leader

- 为保证多个副本之间的数据一致性,其余的Follower会先将各自的log文件高于HW的部分截掉,然后从新的Leader同步数据

注意:这只能保证副本之间的数据一致性,并不能保证数据不丢失或者不重复。

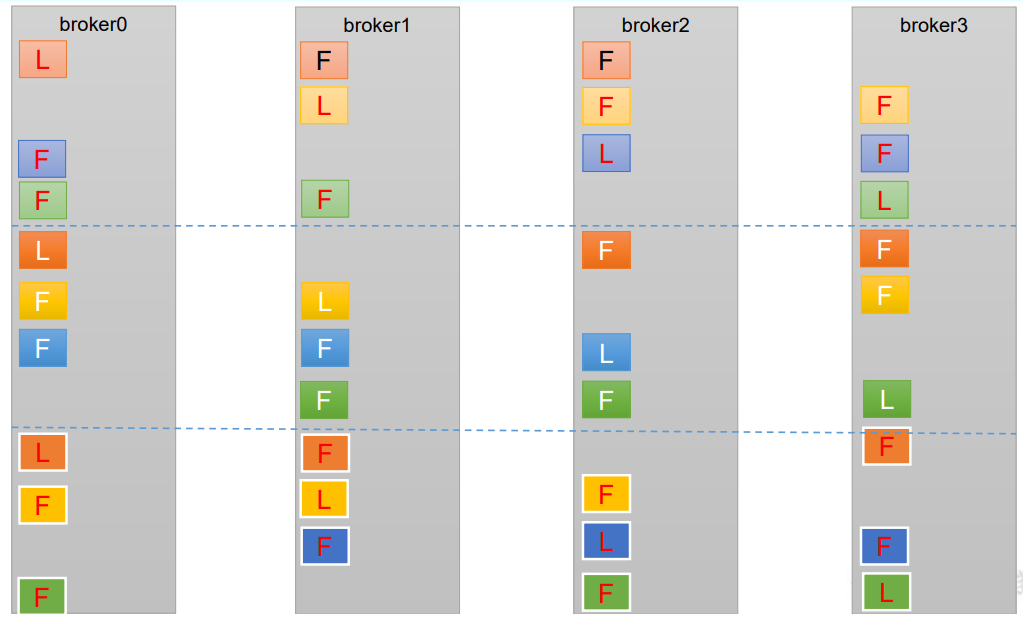

3.4 分区副本分配

如果kafka服务器只有4个节点,那么设置kafka的分区数大于服务器台数,在kafka底层如何分配存储副本呢?

- 创建16个分区,3个副本

bin/kafka-topics.sh --bootstrap-server hadoop102:9092 --create --partitions 16 --replication-factor 3 --topic second

- 查看分区和副本情况

[atguigu@hadoop102 kafka]$ bin/kafka-topics.sh --bootstrap-server hadoop102:9092 --describe --topic second

Topic: second4 Partition: 0 Leader: 0 Replicas: 0,1,2 Isr: 0,1,2

Topic: second4 Partition: 1 Leader: 1 Replicas: 1,2,3 Isr: 1,2,3

Topic: second4 Partition: 2 Leader: 2 Replicas: 2,3,0 Isr: 2,3,0

Topic: second4 Partition: 3 Leader: 3 Replicas: 3,0,1 Isr: 3,0,1

Topic: second4 Partition: 4 Leader: 0 Replicas: 0,2,3 Isr: 0,2,3

Topic: second4 Partition: 5 Leader: 1 Replicas: 1,3,0 Isr: 1,3,0

Topic: second4 Partition: 6 Leader: 2 Replicas: 2,0,1 Isr: 2,0,1

Topic: second4 Partition: 7 Leader: 3 Replicas: 3,1,2 Isr: 3,1,2

Topic: second4 Partition: 8 Leader: 0 Replicas: 0,3,1 Isr: 0,3,1

Topic: second4 Partition: 9 Leader: 1 Replicas: 1,0,2 Isr: 1,0,2

Topic: second4 Partition: 10 Leader: 2 Replicas: 2,1,3 Isr: 2,1,3

Topic: second4 Partition: 11 Leader: 3 Replicas: 3,2,0 Isr: 3,2,0

Topic: second4 Partition: 12 Leader: 0 Replicas: 0,1,2 Isr: 0,1,2

Topic: second4 Partition: 13 Leader: 1 Replicas: 1,2,3 Isr: 1,2,3

Topic: second4 Partition: 14 Leader: 2 Replicas: 2,3,0 Isr: 2,3,0

Topic: second4 Partition: 15 Leader: 3 Replicas: 3,0,1 Isr: 3,0,1

这样分配的目的是为了负载均衡,让每个节点均匀分配副本

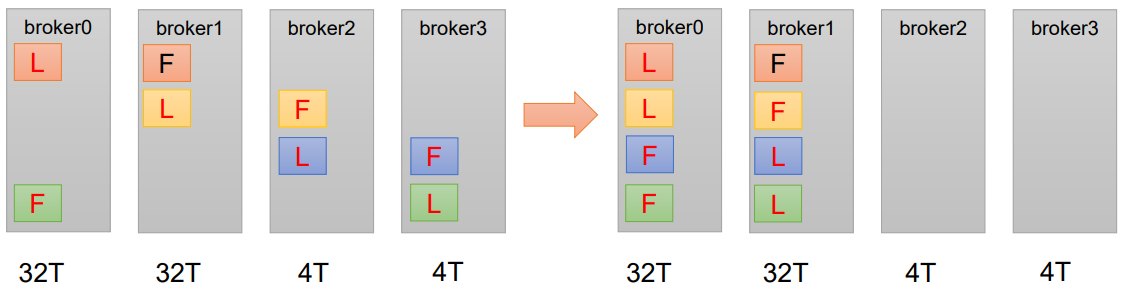

3.5 手动调整分区副本存储

在生产环境中,每台服务器的配置和性能不一致,但是Kafka只会根据自己的代码规则创建对应的分区副本,就会导致个别服务器存储压力较大。所以需要手动调整分区副本的存储。

需求:创建一个新的topic,4个分区,2个副本,名称为three。将该topic的所有副本都存储到broker0和broker1两台服务器上。

手动调整分区副本存储的步骤如下:

- 创建一个新的topic,名称为three

bin/kafka-topics.sh --bootstrap-server hadoop102:9092 --create --partitions 4 --replication-factor 2 --topic three

- 查看分区副本存储情况

bin/kafka-topics.sh --bootstrap-server hadoop102:9092 --describe --topic three

- 创建副本存储计划(所有副本都指定存储在broker0,broker1中)

vim increase-replication-factor.json

//粘贴如下内容

{

"version":1,

"partitions":[

{"topic":"three","partition":0,"replicas":[0,1]},

{"topic":"three","partition":1,"replicas":[0,1]},

{"topic":"three","partition":2,"replicas":[1,0]},

{"topic":"three","partition":3,"replicas":[1,0]}

]

}

- 执行副本存储计划

bin/kafka-reassign-partitions.sh --bootstrap-server hadoop102:9092 --reassignment-json-file increase-replication-factor.json --execute

- 验证副本存储计划

bin/kafka-reassign-partitions.sh --bootstrap-server hadoop102:9092 --reassignment-json-file increase-replication-factor.json --verify

- 查看分区副本存储情况

bin/kafka-topics.sh --bootstrap-server hadoop102:9092 --describe --topic three

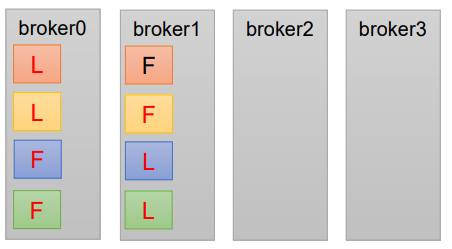

3.6 Leader Partition 负载均衡

正常情况下,Kafka本身会自动把Leader Partition均匀分散在各个机器上,来保证每台机器的读写吞吐量都是均匀的。但是如果某些broker宕机,会导致Leader Partition过于几种在其他少部分几台broker上,这会导致少数几台broker的读写请求压力过高,其他宕机的broker重启之后都是follower partition,读写请求很低,造成集群负载不均衡。

auto.leader.rebalance.enable,默认是true。自动Leader Partition平衡。leader.imbalance.per.broker.percentage,默认是10%。每个broker允许的不平衡的leader的比率。如果每个broker超过了这个值,控制器会触发leader的平衡。leader.imbalance.check.interval.seconds,默认值300s,检查leader负载是否平衡的间隔时间。

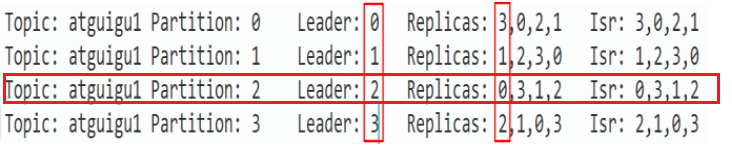

假设集群只有一个主题如下图所示:

针对broker0节点,分区2的AR优先副本是0节点,但是0节点却不是Leader节点,所以不平衡数加1,AR副本总数是4,所以broker0节点不平衡率为1/4>10%,需要重平衡。

broker2、broker3节点和broker0不平衡率一样,需要再平衡。Broker1的不平衡数为0,不需要再平衡。

| 参数名称 | 描述 |

|---|---|

| auto.leader.rebalance.enable | 默认是 true。 自动 Leader Partition 平衡。生产环 境中,leader 重选举的代价比较大,可能会带来 性能影响,建议设置为 false 关闭。 |

| leader.imbalance.per.broker.percentage | 默认是 10%。每个 broker 允许的不平衡的 leader 的比率。如果每个 broker 超过了这个值,控制器 会触发 leader 的平衡。 |

| leader.imbalance.check.interval.seconds | 默认值 300 秒。检查 leader 负载是否平衡的间隔时间。 |

![[NISACTF 2022]checkin](https://img-blog.csdnimg.cn/img_convert/1892ac0aa5205deedf990641435e0d98.png)

![[工业互联-18]:常见EtherCAT主站方案:SOEM的Windows/Linux解决方案](https://img-blog.csdnimg.cn/bf230e029edb4274bd884f32ac792541.png)