MV-Map

MV-Map: Offboard HD-Map Generation with Multi-view Consistency

论文:https://arxiv.org/pdf/2305.08851.pdf

code:https://github.com/ZiYang-xie/MV-Map

代码未开源

总体网络结构

简述

论文首次提出以非车载的方式产生高精度地图。可以视为在HDMapNet的优化版本,多三阶段网络,非端到端的,融合多帧图像。

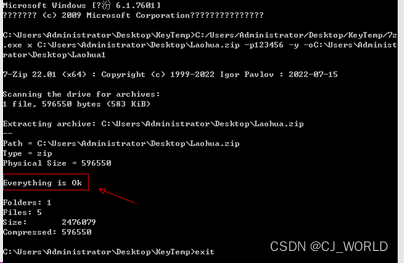

首先以连续多帧周视图像作为输入,经过backbone+encoder+decoder获得各帧特征图和语义地图。其次,论文利用a voxelized neural radiance field(Voxel-NeRF)对输入的多帧图像进行三维重建,可以有效解决某帧图像中车线被遮挡的问题。

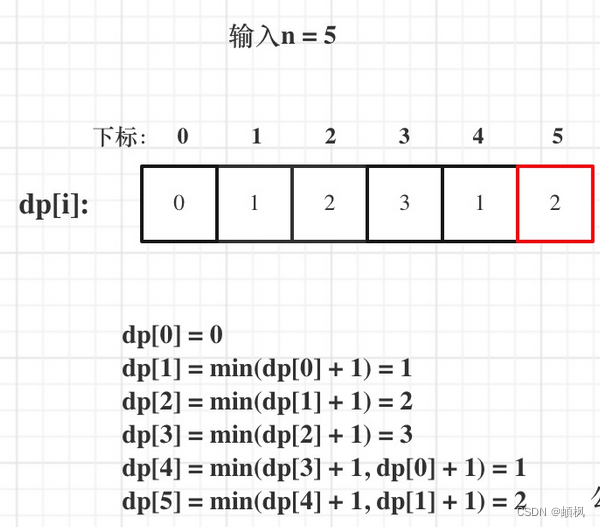

然后,论文提出一个不确定性网络(a uncertainty network),对于BEV 中任意坐标点(x,y),获取其在图像坐标系下的坐标点,Voxel-NeRF可以利用该坐标点得到3D位置坐标。将BEV下坐标点和三维重建后的3D位置坐标做差值,可以两者的一致性。网络最终输出置信度分数。

结合置信度分数最终生成高精地图。

训练和推理

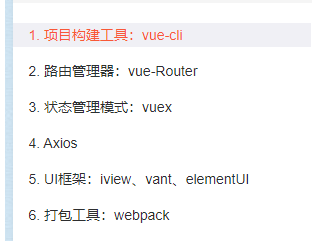

Onboard Model

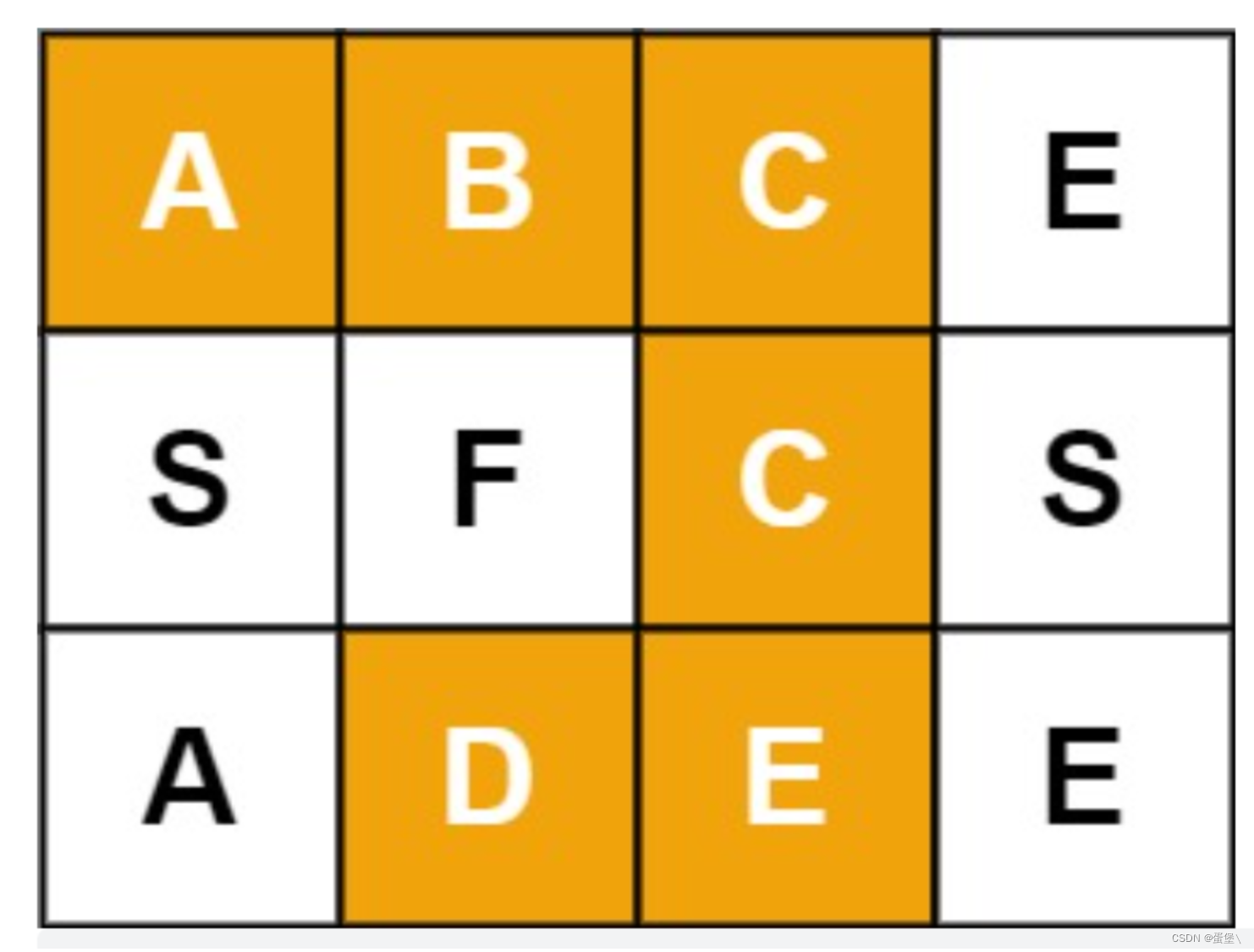

采用resnet50+SimpleBEV encoder+HDMapNet decoder网络结构,最终输出BEV特征和语义地图。该模型独立训练。

Voxel-NeRF

训练nuscenes数据集中全部的850个场景,包括训练集和测试集。训练迭代30000次,平均每个场景在一个A40GPU上训练需要15分钟。该模型独立训练。

Uncertainty Network

训练nuscenes其中的50个场景数据,验证集为nuscenes中全部验证集(150个场景)。在训练时,输入是5帧数据,推理时为一个小视频流。在一个A100GPU上,训练5个epochs花费大概30分钟。

结果

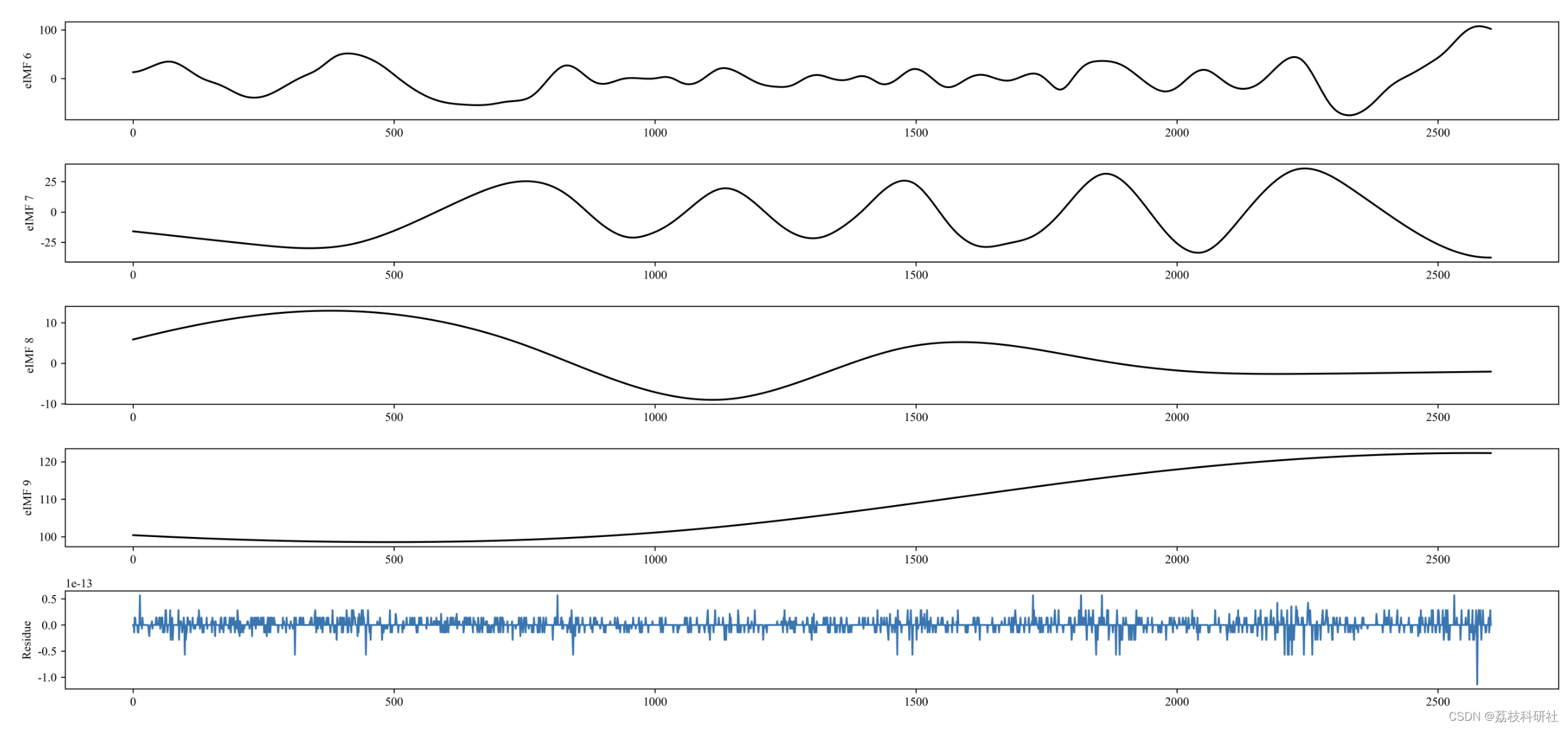

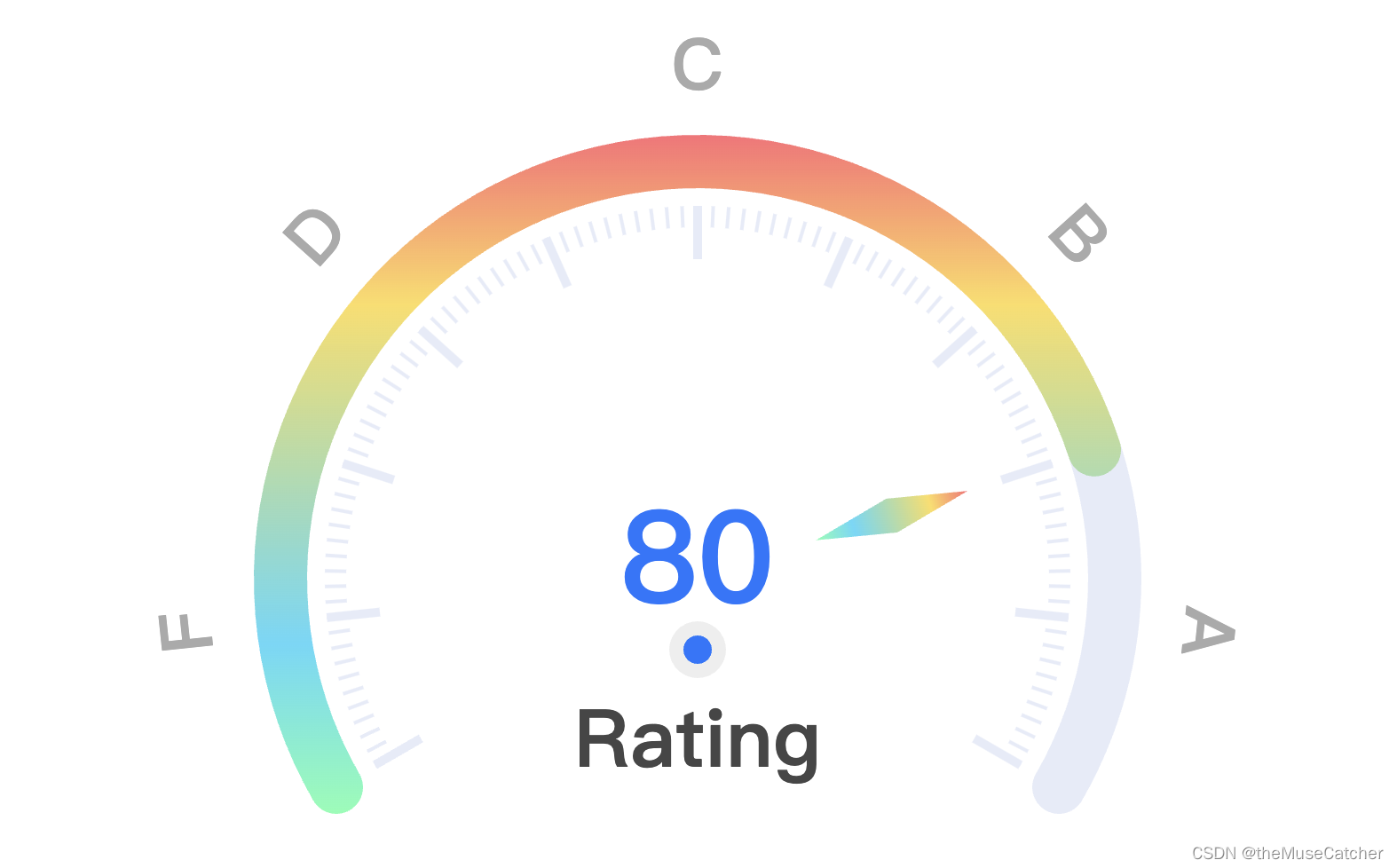

MV-Map与HDMapNet的比较

MV-Map在正常天气和雨天的比较

MV-Map和HDMapNet在IOU上的比较

video

git上的演示视频,链接。

https://www.youtube.com/embed/SN14oTyMFrk