目录

一、LVS群集简介

1.群集的含义和应用场景

2.性能扩展方式

3.群集的分类

负载均衡(LB)

高可用(HA)

高性能运算(HPC)

二、LVS负载均衡群集简介及搭建

1.负载均衡群集架构

2.三种工作模式

3.启用LVS虚拟服务

4.LVS调度算法

(1)固定调度算法

(2)动态调度算法

5.使用ipvsadm管理工具

6.部署实例

(1)配置nfs共享存储器

(2)配置节点服务器

(3)配置负载调度服务器

一、LVS群集简介

1.群集的含义和应用场景

群集是为解决某个特定问题将多台计算机组合起来形成的单个系统,由多台主机构成,但对外只表现为一个整体,相当于一台大型计算机提供服务。

互联网应用中,随着站点对硬件性能、响应速度、服务稳定性、数据可靠性等要求越来越高,单台服务器已经无法满足负载均衡及高可用的要求,所有产生了LVS群集技术提供稳定高效服务。

2.性能扩展方式

- 纵向扩展——对服务器的CPU、内存、硬盘等硬件进行升级或者扩容来实现,但存在性能上限会有瓶颈,成本昂贵,收效比不高等问题。

- 横向扩展——通过增加服务器主机数量来应该高并发的场景。

3.群集的分类

负载均衡(LB)

提高应用系统的响应效率,处理更多的访问请求,减少延迟,提高并发和负载能力。

LB的负载分配依赖于主节点的分流算法,将来自客户机的访问请求分担给多个服务器节点,从而缓解整个系统的负载压力。例如“DNS轮询”,“反向代理”等。

高可用(HA)

提高应用系统的可靠性,减少服务中断时间,确保服务的连续性。

HA的工作方式包括双工和主从两种模式,双工即所有节点同时在线,主从则只有主节点在线,但当出现故障时从节点能自动切换为主节点。例如“故障切换”,“双机热备”等。

高性能运算(HPC)

以提高应用系统的CPU运算速度、扩展硬件资源和分析能力为目标,获得相当于大型、超级计算机的高性能运算能力。

高性能依赖于“分布式运算”、“并行计算”,通过专用硬件和软件将多个服务器的CPU、内存等资源整合在一起,实现只有大型、超级计算机才具备的计算能力。例如,“云计算”,“网格计算”等。

二、LVS负载均衡群集简介及搭建

负载均衡群集是目前企业中用的最多的群集类型

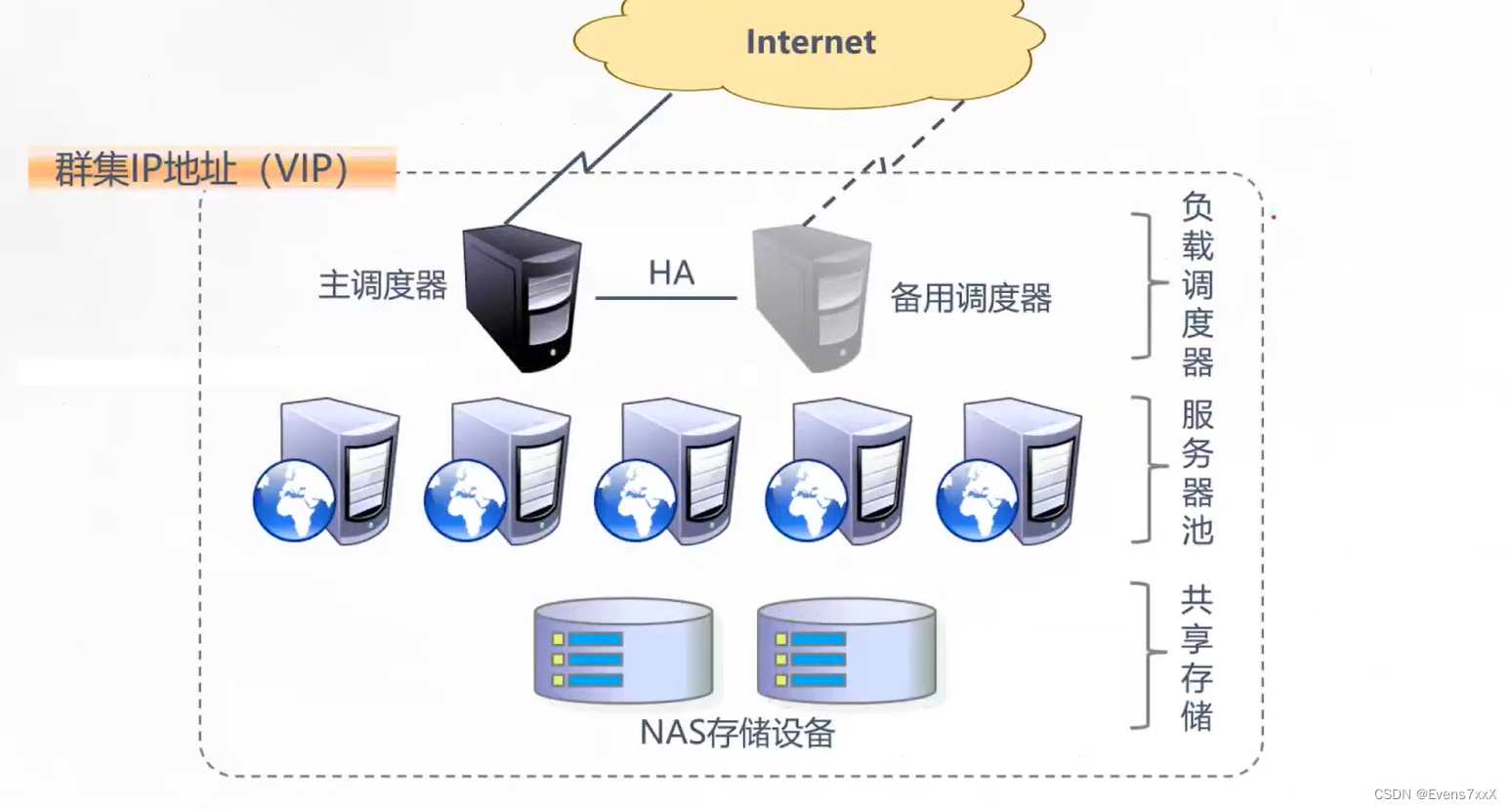

1.负载均衡群集架构

第一层,负载调度器(Load Balancer或Director)

访问整个群集系统的唯一入口,对外使用所有服务器共有的VIP地址,也称为群集IP地址。通常会配置主、备两台调度器实现热备份,当主调度器失效以后能够平滑替换至备用调度器,确保高可用性。

第二层,服务器池(Server Pool)

群集所提供的应用服务、由服务器池承担,其中每个节点具有独立的RIP地址(真实IP),只处理调度器分发过来的客户机请求。当某个节点暂时失效时,负载调度器的容错机制会将其隔离,等待错误排除以后再重新纳入服务器池。

第三层,共享存储(Share Storage)

为服务器池中的所有节点提供稳定、一致的文件存取服务,确保整个群集的统一性。共享存储可以使用NAS设备,或者提供NFS共享服务的专用服务器。

2.三种工作模式

NAT(地址转换)

调度器作为所有节点服务器的网关,既作客户端的访问入口,也作节点服务器响应的访问出口,也就意味着调度器将成为整个集群系统的瓶颈。

由于再转发过程中做了地址转发,对于节点服务器的安全性比其它模式较好。

调度器至少要有2个网卡,一个承载VIP用于接收客户端的请求,另一个用于使用私有IP在同一个局域网中与节点服务器相互通信。

DR(直接路由)

调度器只负责接收客户端的请求,并根据调度算法转发给节点服务器;节点服务器在处理完请求后是直接响应返回给客户端,响应的数据包不经过调度器。

性能比NAT模式高。

调度器和节点服务器使用私有IP在同一个局域网中与节点服务器相互通信。

TUN(IP隧道)

架构与DR相类似,但是节点服务器分散在互联网各个位置,都具有独立的公网IP,通过专用IP隧道与调度器相互通信。

3.启用LVS虚拟服务

LVS现在已成为Linux内核的一部分,默认编译为ip_vs模块,必要时能够自动调用。在CentOS 7系统中,以下操作可以手动加载ip_vs模块,并查看当前系统中ip_vs模块的版本信息。

4.LVS调度算法

(1)固定调度算法

轮询调度(rr):将请求依次分配给不同的RS节点,即RS节点中均摊分配。适合于RS所有节点处理性能接近的情况。

加权轮询调度(wrr):依据不同RS的权值分配任务。权值较高的RS将优先获得任务,并且分配到的连接数将比权值低的RS更多。相同权值的RS得到相同数目的连接数。

目的地址哈希调度(dh):以目的地址为关键字查找一个静态hash表来获得所需RS。

源地址哈希调度(sh):以源地址为关键字查找一个静态hash表来获得需要的RS。

(2)动态调度算法

最小连接数调度(lc):IPVS表存储了所有活动的连接。LB会比较将连接请求发送到当前连接最少的RS。

加权最小连接数调度(wlc):假设各台RS的权值依次为x,当前tcp连接数依次为y,依次去y/x为最小的RS作为下一个分配的RS。

基于地址的最小连接数调度(lblc):将来自同一个目的地址的请求分配给同一台RS,此时这台服务器是尚未满负荷的。否则就将这个请求分配给连接数最小的RS,并以它作为下次分配的首先考虑。

5.使用ipvsadm管理工具

ipvsadm [选项]

常用选项

| -A | 添加虚拟服务器 |

| -D | 删除整个虚拟服务器 |

| -s | 指定负载调度算法(轮询:rr、加权轮询:wrr、最少连接:lc、加权最少连接:wlc) |

| -a | 表示添加真实服务器(节点服务器) |

| -d | 删除某一个节点 |

| -t | 指定 VIP地址及 TCP端口 |

| -r | 指定 RIP地址及 TCP端口 |

| -m | 表示使用 NAT群集模式 |

| -g | 表示使用 DR模式 |

| -i | 表示使用 TUN模式 |

| -w | 设置权重(权重为 0 时表示暂停节点) |

| -p 60 | 表示保持长连接60秒(默认关闭连接保持) |

| -l | 列表查看 LVS 虚拟服务器(默认为查看所有) |

| -n | 以数字形式显示地址、端口等信息,常与" -l " 选项组合使用。ipvsadm -ln |

6.部署实例

实验准备

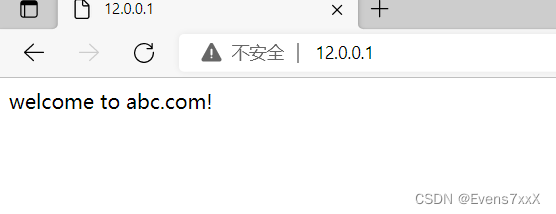

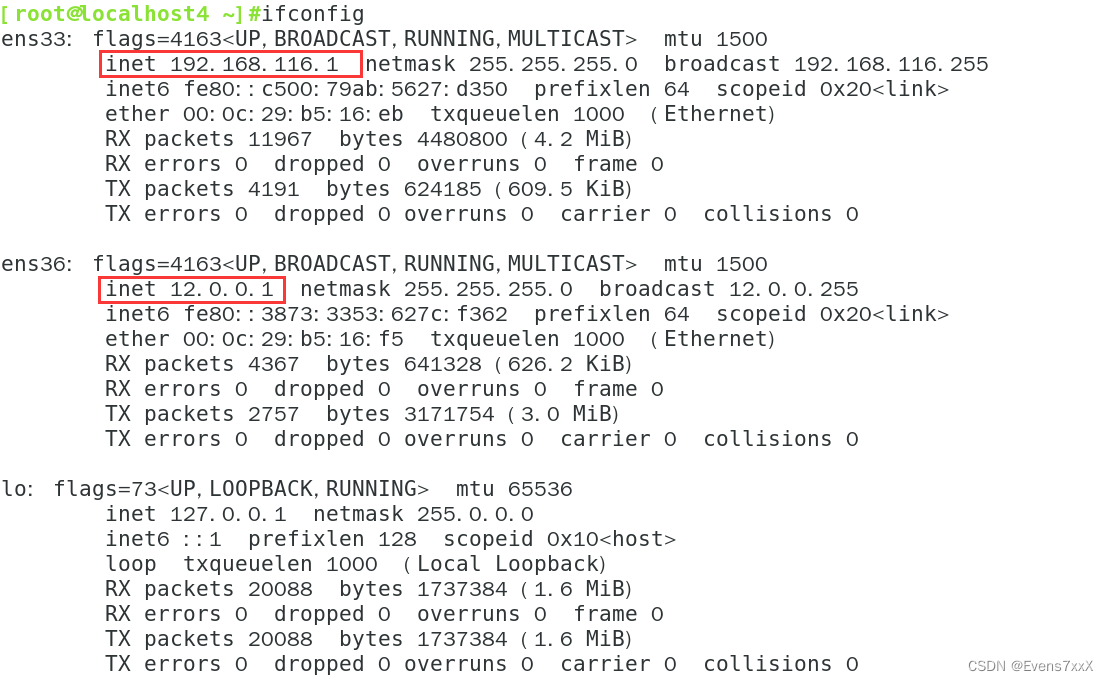

负载调度器:内网关 ens33:192.168.116.1,外网关 ens36:12.0.0.1

Web节点服务器1:192.168.116.10

Web节点服务器2:192.168.116.20

NFS服务器:192.168.116.50

客户端:12.0.0.12

(1)配置nfs共享存储器

#关闭防火墙和selinux

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0

#下载nfs服务

yum install nfs-utils rpcbind -y

systemctl start rpcbind.service

systemctl start nfs.service

systemctl enable nfs.service

systemctl enable rpcbind.service

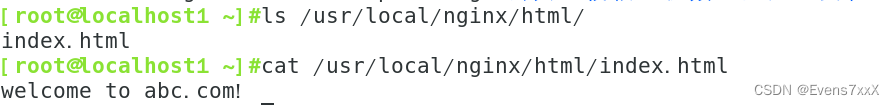

#创建两个共享目录

cd /opt/

mkdir abc def

chmod 777 abc/ def/

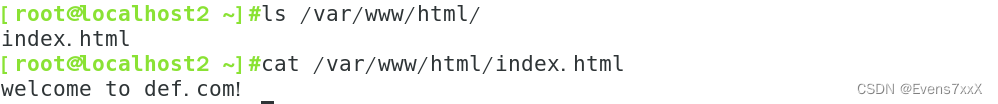

echo 'welcome to abc.com!' > abc/index.html

echo 'welcome to def.com!' > def/index.html

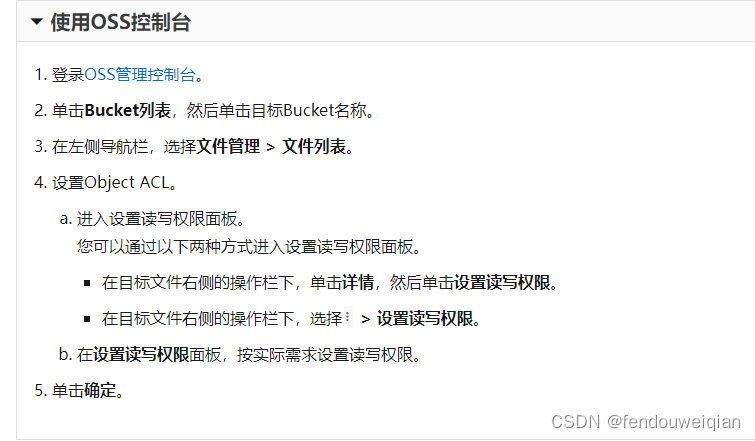

#修改nfs发布策略

vim /etc/exports

/usr/share *(ro,sync)

/opt/abc 192.168.116.0/24(rw,sync)

/opt/def 192.168.116.0/24(rw,sync)

#在线发布

exportfs -rv

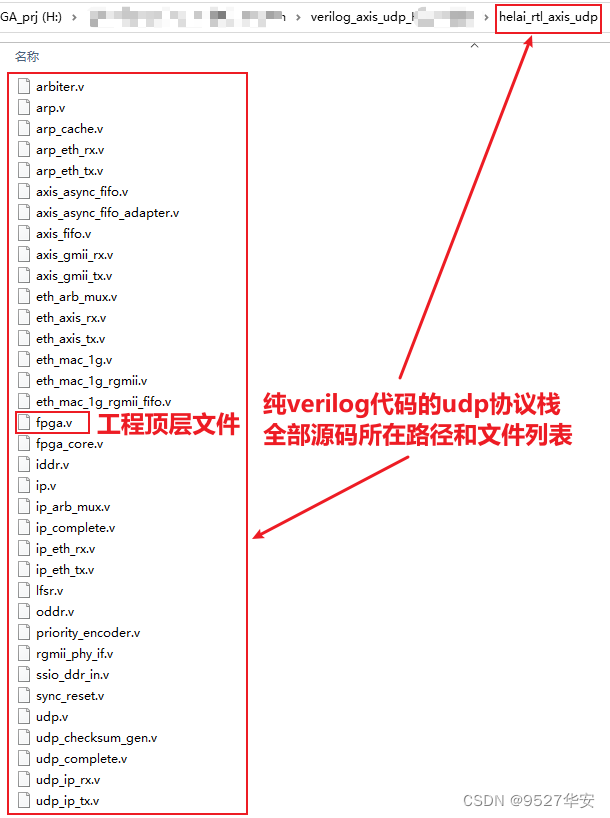

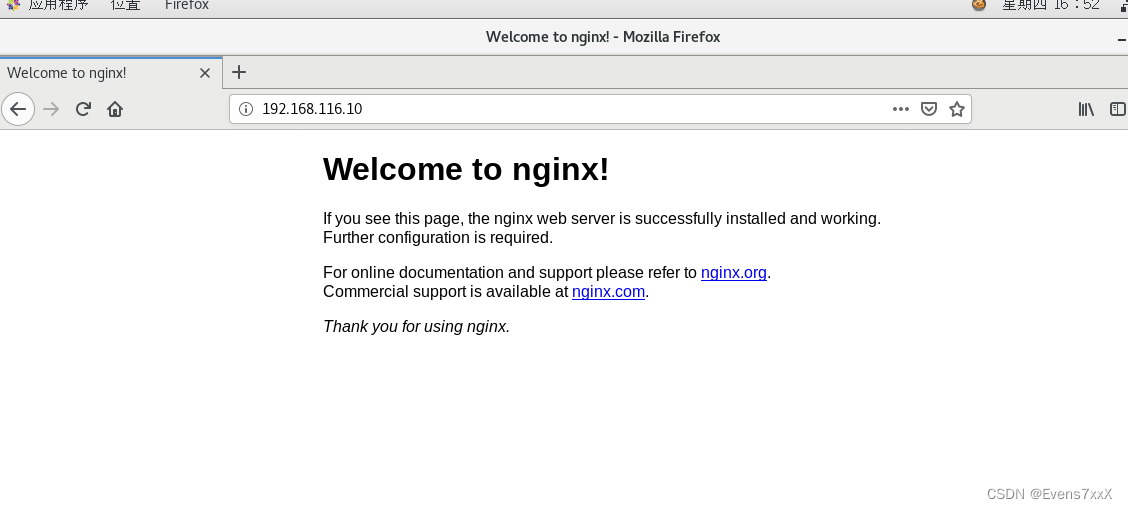

(2)配置节点服务器

首先需要节点服务器提供web服务(apache、nginx等都可以)

将网页根目录挂载到共享存储服务器

web服务器1(nginx)

#启动nfs服务并共享

systemctl start rpcbind nfs

mount 192.168.116.50:/opt/abc /usr/local/nginx/html/

web服务器2(apache)

#启动nfs服务并共享

systemctl start rpcbind nfs

mount 192.168.116.50:/opt/def /var/www/html/

(3)配置负载调度服务器

配置网卡

#关闭防火墙和selinux

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0

#添加ip转发功能

echo 'net.ipv4.ip_forward=1' >> /etc/sysctl.conf

sysctl -p

#设置SNAT地址转发

iptables -F

iptables -t nat -F

iptables -t nat -A POSTROUTING -s 192.168.116.0/24 -o ens33 -j SNAT --to-source 12.0.0.1

#下载ipvsdam并加载ip_vs通用模块

yum -y install ipvsadm

modprobe ip_vs

#添加并启动ipvsadm

ipvsadm-save > /etc/sysconfig/ipvsadm

systemctl start ipvsadm.service

systemctl enable ipvsadm.service

#添加lvs策略

ipvsadm -A -t 12.0.0.1:80 -s rr -p 5

ipvsadm -a -t 12.0.0.1:80 -r 192.168.116.10:80 -m -w 1

ipvsadm -a -t 12.0.0.1:80 -r 192.168.116.20:80 -m -w 1

#启用策略

ipvsadm

#保存策略(恢复可使用 ipvsadm-restore < /etc/sysconfig/ipvsadm)

ipvsadm-save > /etc/sysconfig/ipvsadm

使用外网客户端访问测试(等待连接保持失效后刷新,都能访问到则实现负载均衡)