三天热度果然名不虚传,写作的效率有所下降,但是只要坚持二十一天就能养成习惯啦!冲冲冲!

上一节回顾 文章链接

在上一章我们将词的概念,通过n-gram组合成了n个词的切片,终于将前后词之间建立了一个联系,可以根据词的关系,逐步看见句子之间的相似度,以及根据高频词能够判断文章之间的关联程度。

上一节todo

- 相关代码未补充完整预计明后两天停更新新内容,将前面进行代码补全。

- 编辑距离忘了补充。

- jieba的详细介绍以及如何自己制作词典没有介绍。

写在第四节和第五节前面的引入部分

one-hot向量表示文本的不足之处

- one-hot太稀疏

回到1-gram和2-gram的例子:

-

我喜欢看电影

用单词出现次数来表示:【“我”:1.“喜欢”:1,“看”:1,“电影”,1】 -

我喜欢看电影。

用2-词片段出现次数来表示:【“我喜欢”:1.“喜欢看”:1,“看电影”:1】

现在我们对“我”,“喜欢”,“看”,“电影” 进行编码,最简单的其实是我们一直以来的,按照索引,[1,0,0,0]第0个是“我”,[0,1,0,0]这是“喜欢”,而在不同的文章和规则下,比如2-gram下的,[1,0,0]表示“我喜欢”,在很长的文章里,则有数千甚至过万的词,编码格式为 [1,0,0…0],即为one-hot编码,为此,英文采用了基础词+前缀+后缀进行编码等奇思妙想来充分利用一些“0”,但这依然很稀疏。

- one-hot近义词同义词很难体现

如果按abc顺序进行排序,则“爱戴”,“尊敬”很难体现其应用场景相似相近,因为点乘永远是0。

如果按偏旁部首排序,则“抵达”和“到达”很难体现其意义相近,同理

如果按出现频率排序,按上一节tfidf,我们明白,高频词只有出现在少部分文章的时候,才具有意义,否则我们是会将其判断为停用词,即没有意义的词。

如果用哈希表和预先拥有的知识构建词典,我觉得这个想法不错,但工作量巨大。

总之,one-hot的最大优点在于简单灵活、清晰明了,对于指定的、小文本任务中,依然发挥着十分重要的作用。而为了解决稀疏问题和词之间的语义联系等,我们可以阅读第四节 word2vec 和第五节 SVD 啦!

第四节 word2vec

概念

这个概念写的不是很符合我的心意,我们试试inscode

inscode字写得多,其实就会更加全面一些,但是单从回答依然可能看的是一头雾水,因此我还是会用通俗易懂的方式理解一下概念。

理解

还是从例子引入

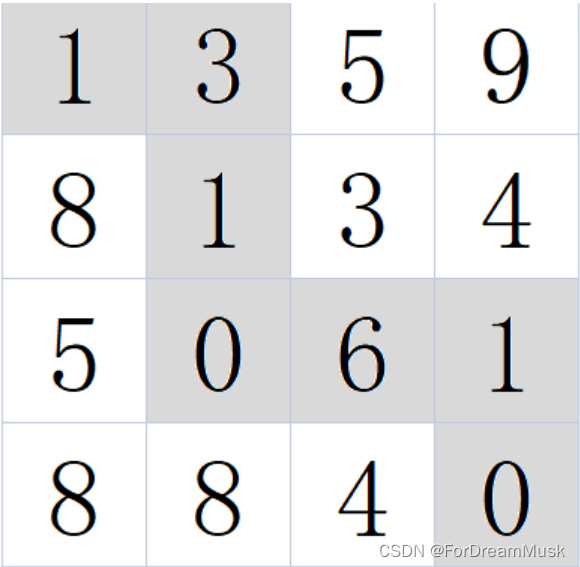

设x1 = 苹果, x2 = 水果 x3 ≈ 中华田园犬,x4 = 狗

由苹果与水果的关系,中华田园犬与狗的关系都是被包含关系,于是理论上我们能确定一个关系式:word2vec (x2) - word2vec(x1) =(≈) word2vec(x4) - word2vec(x3)

- word2vector的目标将原本的一个词/词切片,经过编码就会变成一个低维度的向量(一个word 变成了 vector)比如有1万词,可能降低到16维,然后通过向量唯一表示该词

- word2vector的向量应用这个向量可以描述词于词之间的关系,比如水果到苹果的向量之差就等于中华田园犬到狗之差。

- word2vector的向量的进一步推理自然而然的,苹果换成香蕉,仍然成立

f(水果) - f(香蕉) ≈ f(狗) - f(中华田园犬) ≈ f(水果) - f(苹果),我们发现word2vector居然完成了f(香蕉) ≈ f(苹果),可以得到向量空间上两个向量的距离是靠近的!同时他们是唯一表示的,因此不会是等号。 - 关于距离与相似度 描述向量之间的距离有很多种,有多少种距离,就有更多种相似度的度量方法!

埋一个坑:做一个向量距离、相似度的整理与总结

实现方法

上面是一些理论性的东西, 相信有了上面四个点的例子和推理,我们能对word2vector有了一个清晰的认识,而具体如何找到这个函数f(x),达到所需效果,现在更多会使用神经网络实现,我们可以忘记所有方法,把握两个关键点即可使用任何方法实现。

-

将10000个字用16个维度表表示

-

解决 f(香蕉) ≈ f(苹果)的方法:

训练数据:基于大量的文本,用词语的前后词语来判断,如1:我去上海玩耍;2:我去南京玩耍,此时,上海和南京会被判断为类似,此时通过f(上海) = f(南京) 来调整权重。