文章目录

- 一、分类|识别相关(12篇)

- 1.1 Pseudo-Bag Mixup Augmentation for Multiple Instance Learning Based Whole Slide Image Classification

- 1.2 Improving Primate Sounds Classification using Binary Presorting for Deep Learning

- 1.3 Challenges of Zero-Shot Recognition with Vision-Language Models: Granularity and Correctness

- 1.4 Fast Recognition of birds in offshore wind farms based on an improved deep learning model

- 1.5 Positive Label Is All You Need for Multi-Label Classification

- 1.6 Subclass-balancing Contrastive Learning for Long-tailed Recognition

- 1.7 Fine-grained 3D object recognition: an approach and experiments

- 1.8 UTRNet: High-Resolution Urdu Text Recognition In Printed Documents

- 1.9 An Efficient Deep Convolutional Neural Network Model For Yoga Pose Recognition Using Single Images

- 1.10 A Novel Two Stream Decision Level Fusion of Vision and Inertial Sensors Data for Automatic Multimodal Human Activity Recognition System

- 1.11 Differentially Private Video Activity Recognition

- 1.12 NCIS: Deep Color Gradient Maps Regression and Three-Class Pixel Classification for Enhanced Neuronal Cell Instance Segmentation in Nissl-Stained Histological Images

一、分类|识别相关(12篇)

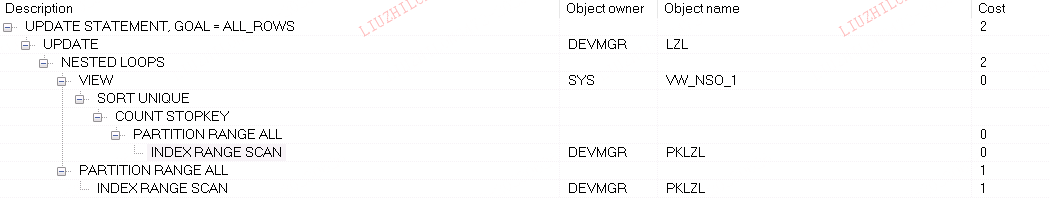

1.1 Pseudo-Bag Mixup Augmentation for Multiple Instance Learning Based Whole Slide Image Classification

基于多示例学习的全幻灯片图像分类的伪袋混合增强

论文地址:

https://arxiv.org/abs/2306.16180

鉴于十亿像素图像建模的特殊情况,多实例学习(MIL)已成为全幻灯片图像(WSI)分类最重要的框架之一。 在当前实践中,大多数 MIL 网络在训练中经常面临两个不可避免的问题:i)WSI 数据不足,ii)神经网络固有的数据记忆性质。 这些问题可能会阻碍MIL模型充分有效的训练,抑制WSI上分类模型的持续性能提升。 受Mixup基本思想的启发,本文提出了一种伪袋混合(PseMix)数据增强方案来改进MIL模型的训练。 该方案通过伪袋将一般图像的 Mixup 策略推广到特殊的 WSI,从而应用于基于 MIL 的 WSI 分类。 在伪袋的配合下,我们的 PseMix 实现了 Mixup 策略中的关键尺寸对齐和语义对齐。 此外,它被设计为一种适应 MIL 的高效、解耦方法,既不涉及耗时的操作,也不依赖于 MIL 模型预测。 比较实验和消融研究是专门为评估我们的 PseMix 的有效性和优势而设计的。 测试结果表明,PseMix 通常可以提高 MIL 网络在 WSI 分类中的性能。 此外,它还可以提高 MIL 模型的泛化能力,并提高其对补丁遮挡和噪声标签的鲁棒性。

1.2 Improving Primate Sounds Classification using Binary Presorting for Deep Learning

基于深度学习的二值预分类改进灵长类语音分类

论文地址:

https://arxiv.org/abs/2306.16054

在野生动物观察和保护领域,涉及录音机器学习的方法越来越受欢迎。 不幸的是,该研究领域的可用数据集通常不是最佳的学习材料; 样品可能标记较弱、长度不同或信噪比较差。 在这项工作中,我们引入了一种通用方法,首先重新标记 MEL 谱图表示的子段,以在实际的多类分类任务上实现更高的性能。 对于二进制预排序和分类,我们利用卷积神经网络(CNN)和各种数据增强技术。 我们在具有挑战性的 \textit{ComparE 2021} 数据集上展示了这种方法的结果,其任务是对不同灵长类物种的声音进行分类,并报告与相对装备的模型基线相比,显着更高的准确性和 UAR 分数。

1.3 Challenges of Zero-Shot Recognition with Vision-Language Models: Granularity and Correctness

视觉语言模型零射识别面临的挑战:粒度和正确性

论文地址:

https://arxiv.org/abs/2306.16048

本文研究了在开放世界环境中将视觉语言模型(VLM)应用于零样本视觉识别任务的挑战,重点关注 CLIP 等对比视觉语言模型。 我们首先检查 VLM 在不同粒度级别的概念上的性能。 我们提出了一种公平评估两种实验设置下的性能差异的方法,并发现 VLM 更擅长识别细粒度概念。 此外,我们发现 VLM 的相似度分数并不能严格反映给定视觉输入的文本输入的正确性。 我们提出了一个评估协议来测试我们的假设,即分数可能会偏向信息更丰富的描述,并且嵌入之间相似性分数的性质使得 VLM 难以识别相似但错误的描述之间的正确性。 我们的研究强调了在开放世界环境中使用 VLM 的挑战,并为未来提高其零样本能力的研究提出了方向。

1.4 Fast Recognition of birds in offshore wind farms based on an improved deep learning model

基于改进深度学习模型的海上风电场鸟类快速识别

论文地址:

https://arxiv.org/abs/2306.16019

风力发电机组的安全是海上风电场稳定运行的前提。 然而,鸟害对风力发电机和风力发电机叶片的安全运行构成直接威胁。 此外,每年有数百万只鸟类被风力涡轮机杀死。 为了保护生态环境、维护海上风机安全运行,并针对当前目标检测算法在夜间等弱光环境下检测能力较低的问题,提出一种改进方法 通过将 CBAM 注意力机制和 RetinexNet 网络集成到 YOLOv5 中来提高网络性能。 首先,将训练集图像输入集成CBAM注意力模块的YOLOv5网络进行训练,并存储最优权重模型。 然后,使用Decom-Net和Enhance-Net对低光图像进行增强和去噪,并在最佳权重模型上测试准确性。 此外,采用k-means++聚类算法优化anchor box选择方法,解决了初始质心不稳定的问题,取得了更好的聚类效果。 实验结果表明,该模型在鸟类检测任务中的准确率可以达到87.40%,提升了21.25%。 该模型可以实时检测风力发电机附近的鸟类,并且在夜间、阴雨和震动的情况下表现出很强的稳定性,证明该模型可以保证风力发电机的安全稳定运行。

1.5 Positive Label Is All You Need for Multi-Label Classification

正标签是多标签分类所需的全部

论文地址:

https://arxiv.org/abs/2306.16016

由于难以注释每幅图像中的各种语义标签,多标签分类(MLC)在训练数据中不可避免地受到标签噪声的影响。 为了减轻噪声标签的影响,现有方法主要致力于通过经过训练的 MLC 模型来识别和纠正标签错误。 然而,这些方法在训练中仍然涉及烦人的噪声标签,这可能导致噪声标签的识别不精确并削弱性能。 在本文中,考虑到负标签远远多于正标签,并且大多数噪声标签来自负标签,我们直接丢弃数据集中的所有负标签,并提出一种称为正无标签多标签分类的新方法 (PU-MLC)。 通过将正向无标签学习扩展到 MLC 任务,我们的方法仅使用正标签和无标签数据训练模型,并在损失函数中引入自适应重新平衡因子和自适应温度系数,以减轻标签分布的灾难性不平衡和过度平滑 训练中的概率。 我们的PU-MLC简单有效,适用于MLC和带有部分标签的MLC(MLC-PL)任务。 对 MS-COCO 和 PASCAL VOC 数据集的大量实验表明,我们的 PU-MLC 在 MLC 和 MLC-PL 设置上实现了显着改进,并且注释更少。 代码将被发布。

1.6 Subclass-balancing Contrastive Learning for Long-tailed Recognition

用于长尾识别的子类平衡对比学习

论文地址:

https://arxiv.org/abs/2306.15925

类别分布不平衡的长尾识别自然出现在实际的机器学习应用中。 现有的方法,如数据重新加权、重采样和监督对比学习,以引入头类和尾类实例之间的不平衡为代价来强制类平衡,这可能会忽略前者潜在的丰富语义子结构,并夸大后者的偏差 。 我们通过一种新颖的“子类平衡对比学习(SBCL)”方法克服了这些缺点,该方法将每个头类聚类为与尾类大小相似的多个子类,并强制表示以捕获原始类之间的两层类层次结构 及其子类。 由于聚类是在表示空间中进行并在训练过程中更新,因此子类标签保留了头类的语义子结构。 同时,它并不过分强调尾类样本,因此每个单独的实例对表示学习的贡献是相等的。 因此,我们的方法实现了实例平衡和子类平衡,同时原始类标签也是通过不同类的子类之间的对比学习来学习的。 我们通过一系列长尾基准数据集评估 SBCL,它实现了最先进的性能。 此外,我们还对 SBCL 进行了广泛的分析和消融研究,以验证其优势。

1.7 Fine-grained 3D object recognition: an approach and experiments

细粒度三维物体识别方法与实验

论文地址:

https://arxiv.org/abs/2306.15919

三维(3D)物体识别技术正在作为汽车自动驾驶等先进技术的核心技术。 3D 对象识别有两套方法:(i) 手工制作的方法,如全局正交对象描述符 (GOOD),以及 (ii) 基于深度学习的方法,如 MobileNet 和 VGG。 然而,需要知道这些方法中哪一种在已知类别数量随时间增加的开放领域中效果更好,并且系统应该使用很少的训练示例来了解新的对象类别。 在本文中,我们首先实现了一个离线 3D 对象识别系统,该系统将对象视图作为输入并生成类别标签作为输出。 在离线阶段,使用基于实例的学习(IBL)来形成新的类别,并使用K折交叉验证来评估获得的对象识别性能。 然后,我们通过将代码集成到模拟教师测试中,以在线方式测试所提出的方法。 因此,我们得出的结论是,使用深度学习特征的方法更适合开放式时尚。 此外,我们观察到,将手工制作的特征和深度学习特征结合起来可以提高分类的准确性。

1.8 UTRNet: High-Resolution Urdu Text Recognition In Printed Documents

UTRNet:印刷文档中的高分辨率乌尔都语文本识别

论文地址:

https://arxiv.org/abs/2306.15782

在本文中,我们提出了一种利用高分辨率、多尺度语义特征提取来解决印刷乌尔都语文本识别挑战的新方法。 我们提出的 UTRNet 架构是一种混合 CNN-RNN 模型,在基准数据集上展示了最先进的性能。 为了解决以前的工作的局限性,即难以概括乌尔都语脚本的复杂性和缺乏足够的带注释的真实世界数据,我们引入了 UTRSet-Real,这是一个包含超过 11,000 个带注释的大规模带注释的真实世界数据集 lines 和 UTRSet-Synth,一个包含 20,000 条线的合成数据集,与现实世界非常相似,并对现有 IIITH 数据集的基本事实进行了修正,使其成为未来研究更可靠的资源。 我们还提供 UrduDoc,这是用于扫描文档中乌尔都语文本行检测的基准数据集。 此外,我们还开发了一种在线工具,通过将 UTRNet 与文本检测模型集成,从印刷文档中进行端到端乌尔都语 OCR。 我们的工作不仅解决了乌尔都语 OCR 目前的局限性,还为该领域的未来研究铺平了道路,并促进乌尔都语 OCR 技术的持续进步。

1.9 An Efficient Deep Convolutional Neural Network Model For Yoga Pose Recognition Using Single Images

一种用于单幅图像瑜伽姿势识别的高效深卷积神经网络模型

论文地址:

https://arxiv.org/abs/2306.15768

姿势识别涉及设计算法以在 2D/3D 空间中定位人体关节,并对估计的关节位置进行推断以预测姿势。 瑜伽姿势由一些非常复杂的姿势组成。 它给计算机视觉算法带来了各种挑战,如遮挡、类间相似性、类内变异性、视点复杂性等。本文提出了 YPose,一种高效的深度卷积神经网络 (CNN) 模型,用于从 RGB 图像中识别瑜伽体式。 该模型由以下四个步骤组成:(a)首先,使用基于分割的方法对感兴趣区域(ROI)进行分割,以从原始图像中提取ROI; (b) 其次,这些精炼图像被传递到基于 EfficientNets 主干的 CNN 架构进行特征提取; © 第三,添加了改编自密集连接网络架构的密集细化块,以学习更多样化的特征; (d)第四,应用全局平均池化和全连接层对瑜伽姿势的多级层次结构进行分类。 所提出的模型已在 Yoga-82 数据集上进行了测试。 它是一个公开可用的瑜伽姿势识别基准数据集。 实验结果表明,所提出的模型在该数据集上达到了最先进的水平。 所提出的模型获得了 93.28% 的准确率,比早期的最先进模型 (79.35%) 有所提高,裕度约为 13.9%。 该代码将公开。

1.10 A Novel Two Stream Decision Level Fusion of Vision and Inertial Sensors Data for Automatic Multimodal Human Activity Recognition System

多通道人体活动自动识别系统中视觉和惯性传感器数据的两流决策层融合

论文地址:

https://arxiv.org/abs/2306.15765

本文提出了一种新颖的多模式人类活动识别系统。 它使用视觉和惯性传感器的双流决策级融合。 在第一个流中,原始 RGB 帧被传递到基于部分亲和场的姿势估计网络以检测用户的关键点。 然后对这些关键点进行预处理,并以滑动窗口的方式输入到专门设计的卷积神经网络中,以进行空间特征提取,然后使用正则化 LSTM 来计算时间特征。 然后,LSTM 网络的输出被输入到全连接层进行分类。 在第二个流中,从惯性传感器获得的数据经过预处理并输入到正则化 LSTM 中进行特征提取,然后输入全连接层进行分类。 在此阶段,使用决策级融合来融合两个流的 SoftMax 分数,从而给出最终预测。 进行了大量的实验来评估性能。 四个多模态标准基准数据集(UP-Fall 检测、UTD-MHAD、Berkeley-MHAD 和 C-MHAD)用于实验。 该系统在 UP-Fall 检测、UTDMHAD、Berkeley-MHAD 和 C-MHAD 数据集上获得的准确率分别为 96.9%、97.6%、98.7% 和 95.9%。 这些结果远远优于当前最先进的方法。

1.11 Differentially Private Video Activity Recognition

不同的隐私视频活动识别

论文地址:

https://arxiv.org/abs/2306.15742

近年来,差分隐私在图像分类方面取得了显着的进步; 然而,其在视频活动识别中的应用仍未得到充分探索。 本文解决了将差分隐私应用于视频活动识别的挑战,这些挑战主要源于:(1)整个视频所需的隐私级别与当代视频架构处理的输入数据的性质之间的差异,这些数据通常是短的、分段的 剪辑; (2) 视频数据集相对于图像分类数据集的复杂性和庞大规模,这使得传统的差分隐私方法不够充分。 为了解决这些问题,我们提出了 Multi-Clip DP-SGD,这是一种通过基于剪辑的分类模型来实施视频级差分隐私的新颖框架。 该方法对每个视频中的多个剪辑进行采样,对它们的梯度进行平均,并在 DP-SGD 中应用梯度剪辑,而不会造成额外的隐私损失。 此外,我们采用了参数高效的迁移学习策略,使模型可针对大规模视频数据集进行扩展。 通过对 UCF-101 和 HMDB-51 数据集的广泛评估,我们的方法表现出了令人印象深刻的性能,在 UCF-101 上以 epsilon=5 的隐私预算实现了 81% 的准确率,与直接应用 DP- 相比,提高了 76% 新元。 此外,我们证明了我们的迁移学习策略是通用的,可以增强跨一系列数据集(包括 CheXpert、ImageNet、CIFAR-10 和 CIFAR-100)的差分隐私图像分类。

1.12 NCIS: Deep Color Gradient Maps Regression and Three-Class Pixel Classification for Enhanced Neuronal Cell Instance Segmentation in Nissl-Stained Histological Images

NCIS:用于Nissl染色组织图像增强神经元实例分割的深度颜色梯度图回归和三类像素分类

论文地址:

https://arxiv.org/abs/2306.15784

事实证明,深度学习在医学图像分析中比其他方法更有效,包括分割单个细胞这一看似简单但具有挑战性的任务,这是许多生物学研究的重要步骤。 比较神经解剖学研究就是一个例子,其中神经元细胞的实例分割对于细胞结构表征至关重要。 本文提出了一种端到端框架,可以自动分割大脑尼氏染色组织学图像中的单个神经元细胞,从而为研究大脑细胞结构的变化提供可靠的形态和结构分析。 采用类似 U-Net 的架构,以 EfficientNet 作为编码器和两个解码分支,用于回归四种颜色梯度图,并将像素分类为接触细胞、细胞体或背景之间的轮廓。 解码分支通过注意门连接以共享相关特征,并且它们的输出被组合以返回单元的实例分割。 该方法在大脑皮层和小脑的图像上进行了测试,优于其他最近基于深度学习的细胞实例分割方法。