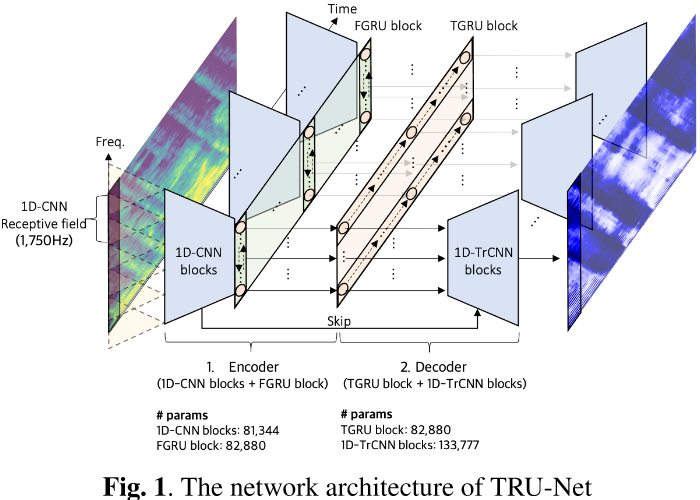

一、简述

不管是基于CUDA还是基于TensorRT进行模型推理,都是分三个阶段,将数据从内存拷贝到显存,进行推理,将推理结果从显存拷贝到内存。

关于TensorRT推理,可以参考之前的博客。

机器学习笔记 - windows基于TensorRT的UNet推理部署_坐望云起的博客-CSDN博客NVIDIA TensorRT是一个用于高性能深度学习推理的平台。TensorRT适用于使用CUDA平台的所有NVIDIA GPU。所以如果需要基于TensorRT部署,至少需要一个NVIDIA显卡,算力5.0以上,比Maxwell更新的架构,可以参考下表。需要安装cuda、cudnn。还用到了到了OpenCV,这里是基于TensorRT的c++的api。https://skydance.blog.csdn.net/article/details/130756415 驱动版本是517.00