文章目录

- 自动驾驶

- 感知

- 传感器

- 多模态传感器融合

- BEV

- Corner Cases

- 缩写

未完待续。。。

自动驾驶

来自:浅谈自动驾驶技术与挑战

L0:主动刹车、盲点监测、车道偏离预警和车身稳定系统都属于 L0 级别的自动驾驶;

L1:如车道保持系统,定速巡航系统等应属于 L1 级别的自动驾驶

L2:可以同时自动进行加减速和转向的操作,也意味着自适应巡航功能和车道保持辅助系统可以同时工作;

L3:而目前公认的 L3 级自动驾驶入门门槛必须是带有激光雷达。

感知

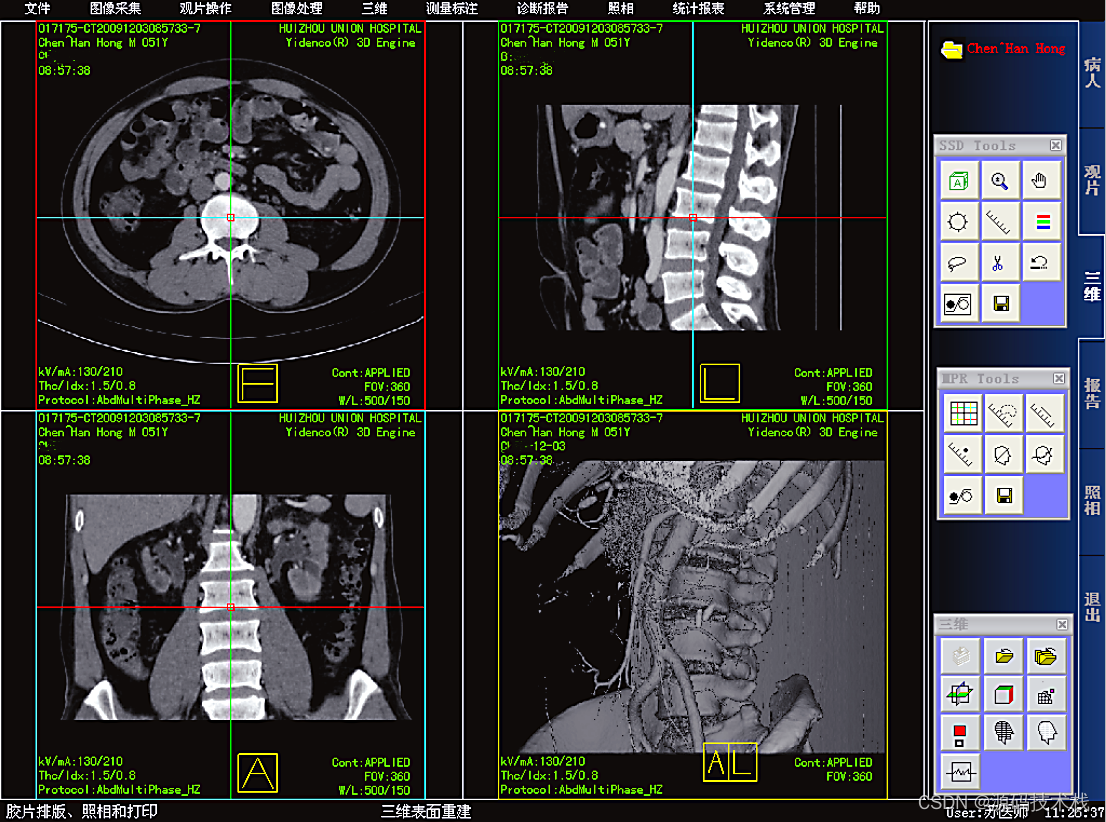

传感器

时代浪潮下的个体境遇:一位自动驾驶工程师的自述

在ADAS领域,毫米波雷达算是一位老兵了,业界已经有十分成熟的产品,成本低,可靠性高,但存在的问题是在城市工况下的误检和漏检很多。在激光雷达和图像衬托下,它显得有些多余了,

自动驾驶中的视觉方案都有哪些?一文尽览!

2D摄像头所得到的都是真实世界在透视视图(Perspective View)下的投影(世界坐标系到图像坐标系)。它并不知道这个障碍物距离车辆的距离,也不知道障碍物的实际三维形状和大小。

想要得到3D空间的信息,一个最直接的方法就是采用激光雷达(LiDAR)。

LiDAR输出的3D点云可以直接用来获取障碍物的距离和大小(3D物体检测),以及场景的深度(3D语义分割)。

点云的优势在于距离和深度感知精确,而图像的优势在于语义信息更加丰富。

LiDAR也有其缺点,比如成本较高,车规级产品量产困难,受天气影响较大等等。因此,单纯基于摄像头的3D感知仍然是一个非常有意义和价值的研究方向。

-

单目3D感知

虽然可以利用先验知识和图像中的上下文信息,基于单目的3D感知的准确度并不能完全令人满意。尤其是当采用深度学习的策略时,算法的准确度非常依赖于数据集的大小和质量。对于数据集中没有出现过的场景,算法在深度估记和物体检测上都会有较大的偏差。

-

双目3D感知

双目视觉可以解决透视变换带来的歧义性,因此从理论上来说可以提高3D感知的准确度。但是双目系在硬件和软件上要求都比较高。硬件上来说需要两个精确配准的摄像头,而且需要保证在车辆运行过程中始终保持配准的正确性。软件上来说算法需要同时处理来自两个摄像头的数据, 计算复杂度较高,保证算法的实时性就更加困难。

自动驾驶需要计算机视觉来理解和导航环境。计算机视觉的作用是:

检测车道线

检测其他物体——环境中的车辆、人类、动物

跟踪检测到的物体

预测他们可能的运动

因此我根据车道线的标准宽度估计了像素到米的转换

多模态传感器融合

来自:

-

《Multi-modal Sensor Fusion for Auto Driving Perception: A Survey》(arXiv-2022)

-

自动驾驶多模态传感器融合的综述

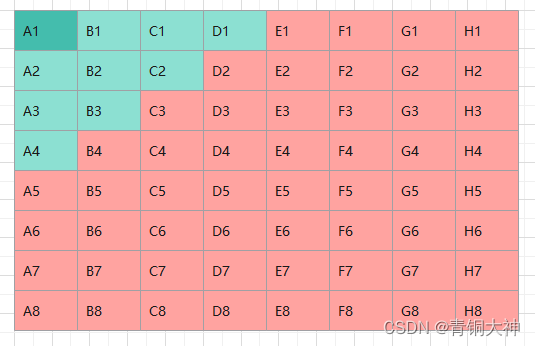

前融合

深度融合

后融合(ensemble method)

非对称融合

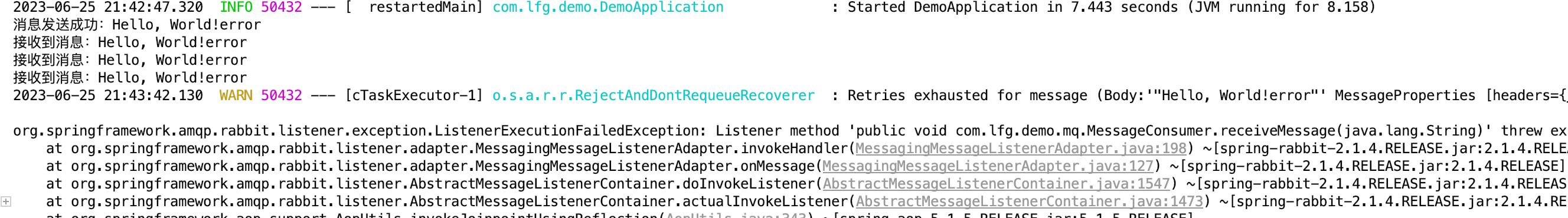

基于弱融合的方法通常使用基于规则的方法来利用一种模态数据作为监督信号,以指导另一模态的交互

BEV

来自:展望未来 | AI大模型在自动驾驶的应用

高精度地图应用过程中无法做到实施更新、法规风险高、高成本的三大问题难以解决。

BEV (Bird’s eye view,鸟瞰图) 感知算法通过将不同视角的摄像头采集到的图片统一转换到上帝视角,相当于车辆实施生成活地图,补足了自动驾驶后续决策所需要的道路拓扑信息,因而可以实现去高精度地图化。

自动驾驶算法“重感知,轻地图”趋势明确。

ICRA 2022杰出论文:把自动驾驶2D图像转成鸟瞰图,模型识别准确率立增15%

Corner Cases

如何在自动驾驶的视觉感知中检测极端情况?

《Corner Cases for Visual Perception in Automated Driving:Some Guidance on Detection Approaches》(arXiv-2021)

例子

翻译版本

缩写

- ADAS,Advanced Driving Assistant System,高级驾驶辅助系统

- CAS,Collision Avoidance System,防撞系统