点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

作者介绍

范嘉骏

清华大学计算机技术专业二年级研究生,主要研究深度强化学习

报告题目

可学习的行为控制,超越DeepMind和OpenAI突破Atari人类世界纪录

内容简介

探索问题一直是深度强化学习(DRL)中的主要挑战之一。最近的研究工作大多采用基于种群的方法(Population-Based)来处理这个问题。这些方法通过从不同探索策略的种群中选择具有不同行为策略的样本,以获取多样性。此外,这些方法还使用自适应策略选择器来控制行为策略。然而,行为策略的选择空间在很大程度上受限于预定义的策略种群,进一步限制了行为的多样性。

在本文中,我们提出了一个称为可学习行为控制(LBC)的通用框架,以解决以下限制:

a) 通过制定混合行为映射来扩大行为选择空间,从而从所有策略中获取样本;

b) 为行为选择构建一个统一的可学习过程。

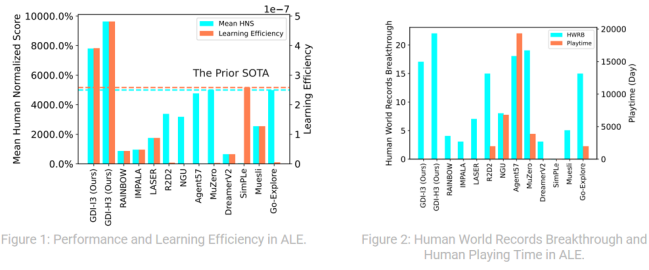

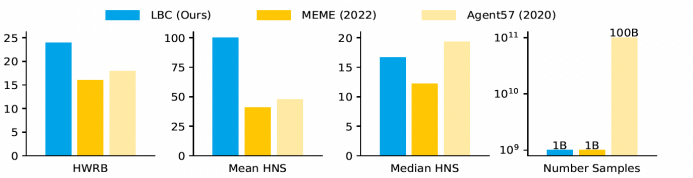

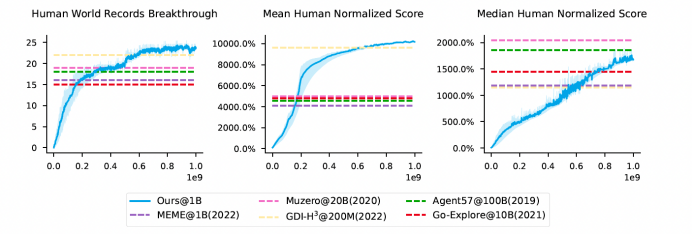

我们将LBC引入异策略(off-policy)actor-critic方法,并通过基于bandit的元控制器优化行为映射的选择来实现行为控制。我们的算法在Atari领域取得了新的SOTA结果,在数据量降低数十倍到百倍的情况下,平均数和中位数性能都远远超越其他同类型算法,并且创造了24项新的人类世界纪录。这证明了我们的方法在不降低样本效率的情况下具有显著的性能优势。

01

Motivation

当前的强化学习(RL)算法在取得最先进的结果方面通常需要大量的数据,例如Agent57需要一千亿数据,MuZero需要两百亿数据。对于现实任务而言,这样庞大的数据量是难以接受的,因此我们的第一个研究动机是提高强化学习算法的样本效率或学习效率,使其在不浪费大量样本的情况下能够取得良好的学习效果。

此外,当前的RL算法很难在样本效率和最终性能之间取得平衡。通常,样本效率高的算法会导致性能下降,而性能好的算法则需要浪费大量样本。因此,我们的第二个研究动机是寻找一种能够同时实现高样本效率和不损失算法性能的方法。

最后,许多RL算法声称取得了超越人类世界记录的水平,但实际上它们并没有超越全部人类世界纪录。基于这一点,我们的最后一个研究动机是希望能够真正超越全部人类世界纪录,从而实现真正的超人类水平的算法。

总的来说,我们的工作主要有三个目标:提升样本效率、保证算法性能不下降,并希望能够突破全部人类世界纪录。

02

Generalized Data Distribution Iteration (GDI)

我们设计算法的初衷是通过主动采集更好的数据来促进Agent更高效地学习,并最终实现更好的性能。

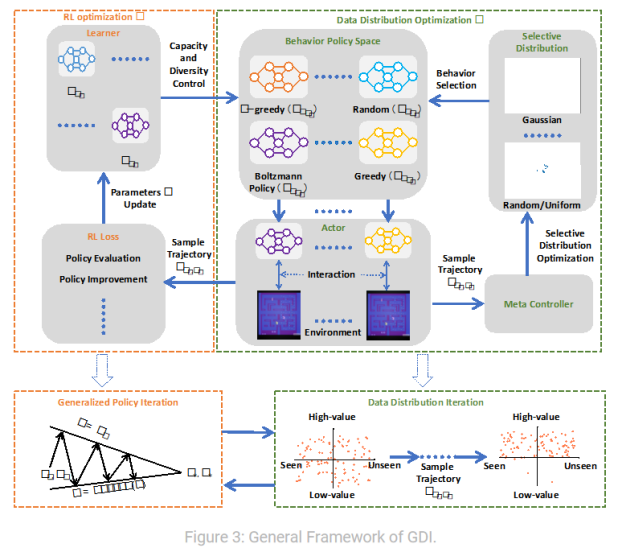

在已有的提升强化学习(RL)算法样本效率的工作中,我们观察到这些算法在数据采集过程中常常会重复采样低质量、低价值的数据。因此,在我们在ICML 2022的一篇名为GDI的工作中,我们将优化采样数据分布的过程引入原始RL框架中。通过不断优化采样数据分布,我们能够避免重复采样低质量的数据。简单来说,GDI旨在利用更好的数据对RL进行训练,以提高样本效率和最终性能。

为了实现数据分布的优化,我们发现在RL中,数据分布通常由采样策略控制。因此,我们将数据分布优化转化为采样策略的优化。通过持续优化采样策略,我们可以不断获取高价值的数据,避免重复采集低质量的数据,从而显著提高算法的样本效率。然而,GDI并没有提供一种通用的采样策略控制方法,而可学习行为控制(LBC)的目标之一就是提供一种通用的采样策略控制方法。

03

Behavior Control Formulation

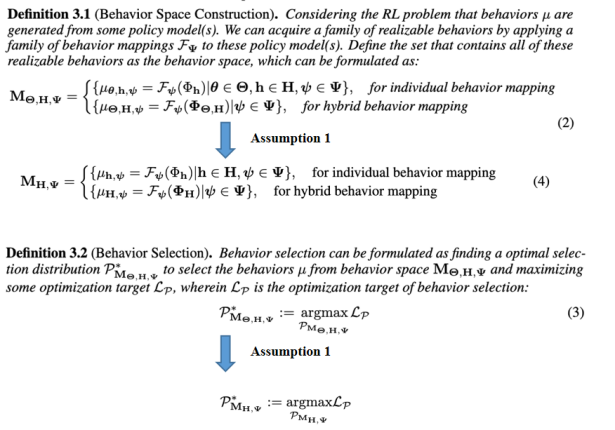

为了实现一种通用的采样策略控制方法,我们首先对采样策略控制这一过程进行了规范化。我们将强化学习(RL)算法中的采样策略控制分为两个步骤。在第一步中,我们建立了采样策略的选择空间,明确了可供选择的采样策略以及用于控制采样策略的因素。在第二步中,我们优化了采样策略的选择分布。

首先,我们明确了可被选择的采样策略,并确定了影响采样策略控制的因素。这样,我们就构建了采样策略的选择空间。

其次,我们通过优化采样策略的选择分布来实现控制。这意味着我们通过调整采样策略的概率分布,使得更符合我们的目标和需求的策略被选择更频繁。这样,我们能够优化采样策略的选择,以提高算法的效率和性能。

通过这两个步骤,我们能够形成一种通用的采样策略控制方法,以适应不同的RL算法和任务。

04

Behavior Control

基于采样策略的定义,通常有两种方法来控制采样策略。第一种方法是策略模型选择,这是相关工作中常见的方法。简单来说,这种方法通过选择不同的策略模型来生成不同的采样策略。然而,该方法存在一个问题,即策略模型的数量是有限的,这导致采样策略的选择空间也是有限的。

为了解决这个问题,我们选择了优化行为映射来控制采样策略。行为映射可以通过连续参数化,因此我们可以使用较少的模型来获得更大的采样策略空间。这种方法提供了一种在强化学习(RL)算法中实现采样策略控制的方式。

通过优化行为映射,我们可以对采样策略进行灵活的调整,以适应不同的任务和目标。相比于仅依赖有限策略模型的选择,优化行为映射的方法能够提供更大的灵活性和扩展性,从而实现更多样化、更高效的采样策略控制。

05

Hybrid Behavior Mapping

但是,当前并没有能够在population-based RL方法中使用的行为映射。于是,我们提出了一种在任意个模型中构建行为映射的方法,其中包括三个主要步骤。

首先,我们希望强化学习(RL)代理能够自主地调整不同学习到的策略在采样策略中的贡献程度。为此,我们引入了一个表示每个学习策略对采样策略贡献的变量,称为ω(omega)。

其次,为了鼓励探索,我们使RL代理能够自动地调整每个学习策略的熵。这意味着我们通过调整学习策略的熵,实现了对探索和利用之间的权衡。

最后,我们使用一个蒸馏函数g,从一系列学习策略中蒸馏出采样策略。这样,每个采样策略都能够实现对多个学习策略在探索和利用之间的权衡。

通过以上步骤,我们能够构建出一种能够灵活地调整不同学习策略在采样策略中的贡献度、平衡探索和利用的权衡的行为映射方法。这使得每个采样策略都能够有效地利用多个学习策略,并在探索和利用之间取得平衡。

06

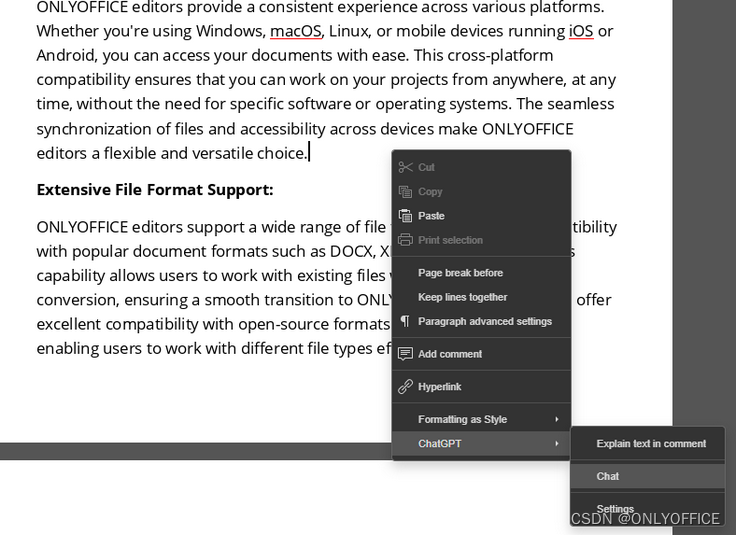

Learnable Behavior Control

如上图所示是我们的算法框架,我们通过上述的三个步骤构建混合行为映射,同时采用meta-controller来优化这一过程,即通过优化行为映射来优化采样策略的选择,从而优化数据分布。

07

Experiment

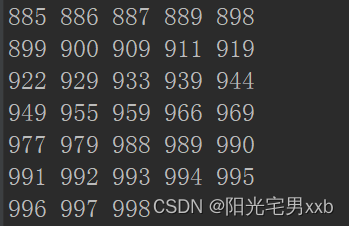

如上图所示,我们的算法在进行大量实验后在Atari领域取得了令人瞩目的成果。实验结果显示,我们的算法在平均数和中位数性能方面远超过其他同类型算法,并且创造了24项新的人类世界纪录。这些结果表明我们的算法在性能上显著优于现有方法。

在我们的训练过程中,我们还发现了一些人类难以想象的高效快速刷分策略,这些策略获得了难以超越的高分。这显示了我们的算法在发现新的、高效的策略方面具有独特的优势。

通过大量实验验证,我们的算法在Atari领域取得了显著的SOTA结果。这些结果不仅在性能上超越了其他同类型算法,还创造了新的人类世界纪录,并展示了我们算法在探索高效策略方面的突出能力。

上图展示了我们的方法和Muzero的综合比较。从图中可以看出,在数据量减少20倍的前提下,所提方法在大部分任务上都能够超越Muzero。然而在一些奖励极其稀疏的任务中,我们的方法并没有Muzero有效。为此,我们将在未来的工作中解决这一问题,这也是我们在Atari任务上存在的最后一个明显的短板。

08

Conclusion and Research Map

我们的工作主要围绕如何实现强化学习算法中的采样策略控制的问题展开。我们已经证明了它的优越性,提出了一种可以应用在不同RL算法中实习和分析采样策略控制的通用方法。未来,我们希望能够将采样策略控制引入到更多的RL领域中,提升其样本效率和性能,并希望能够统一RL中的采样策略控制。

提

醒

点击“阅读原文”跳转2:37:09可以查看回放哦!

往期精彩文章推荐

记得关注我们呀!每天都有新知识!

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了1100多位海内外讲者,举办了逾550场活动,超600万人次观看。

我知道你

在看

哦

~

点击 阅读原文 查看回放!

![C国演义 [第五章]](https://img-blog.csdnimg.cn/d2737b51c7934171b801a59b45177d53.png)