![]()

第一部分 阿里巴巴DATAx

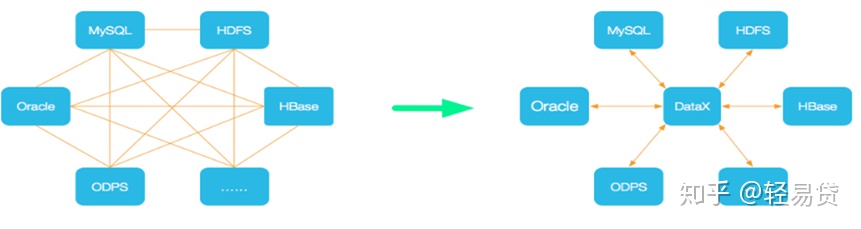

DataX 是阿里开源的一个异构数据源离线同步工具,致力于实现包括关系型数据库(MySQL、Oracle等)、HDFS、Hive、ODPS、HBase、FTP等各种异构数据源之间稳定高效的数据同步功能。

DataX设计理念

DataX本身作为数据同步框架,将不同数据源的同步抽象为从源头数据源读取数据的Reader插件,以及向目标端写入数据的Writer插件,理论上DataX框架可以支持任意数据源类型的数据同步工作。同时DataX插件体系作为一套生态系统, 每接入一套新数据源该新加入的数据源即可实现和现有的数据源互通。

DataX框架设计

DataX本身作为离线数据同步框架,采用Framework + plugin架构构建。将数据源读取和写入抽象成为Reader/Writer插件,纳入到整个同步框架中。

1. Reader:Reader为数据采集模块,负责采集数据源的数据,将数据发送给Framework。

2. Writer: Writer为数据写入模块,负责不断向Framework取数据,并将数据写入到目的端。

3. Framework:Framework用于连接reader和writer,作为两者的数据传输通道,并处理缓冲,流控,并发,数据转换等核心技术问题。

DataX插件体系

DataX目前已经有了比较全面的插件体系,主流的RDBMS数据库、NOSQL、大数据计算系统都已经接入,目前支持数据如下图,详情请点击:DataX数据源参考指南

DataX核心架构

核心模块介绍:

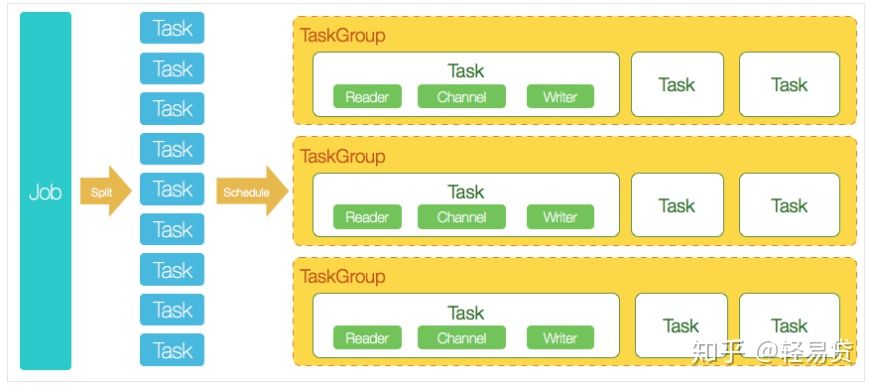

- DataX完成单个数据同步的作业,我们称之为Job,DataX接受到一个Job之后,将启动一个进程来完成整个作业同步过程。DataX Job模块是单个作业的中枢管理节点,承担了数据清理、子任务切分(将单一作业计算转化为多个子Task)、TaskGroup管理等功能。

- DataXJob启动后,会根据不同的源端切分策略,将Job切分成多个小的Task(子任务),以便于并发执行。Task便是DataX作业的最小单元,每一个Task都会负责一部分数据的同步工作。

- 切分多个Task之后,DataX Job会调用Scheduler模块,根据配置的并发数据量,将拆分成的Task重新组合,组装成TaskGroup(任务组)。每一个TaskGroup负责以一定的并发运行完毕分配好的所有Task,默认单个任务组的并发数量为5。

- 每一个Task都由TaskGroup负责启动,Task启动后,会固定启动Reader—>Channel—>Writer的线程来完成任务同步工作。

- DataX作业运行起来之后, Job监控并等待多个TaskGroup模块任务完成,等待所有TaskGroup任务完成后Job成功退出。否则,异常退出,进程退出值非0。

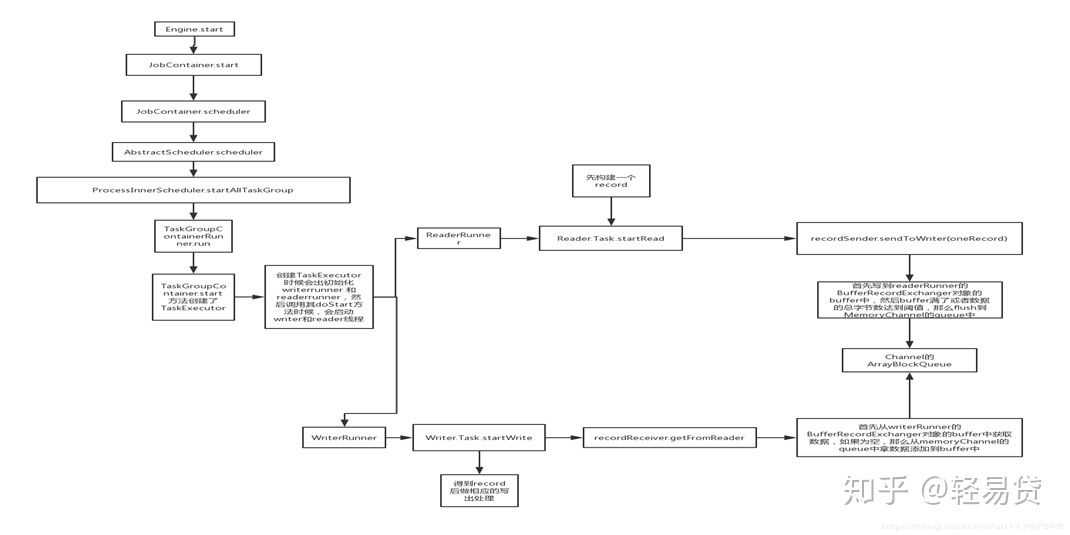

DataX执行流程

1、解析配置,包括job.json、core.json、plugin.json三个配置

2、设置jobId到configuration当中

3、启动Engine,通过Engine.start()进入启动程序

4、设置RUNTIME_MODE到configuration当中

5、通过JobContainer的start()方法启动

6、依次执行job的preHandler()、init()、prepare()、split()、schedule()、- post()、postHandle()等方法。

7、init()方法涉及到根据configuration来初始化reader和writer插件,这里涉及到jar包热加载以及调用插件init()操作方法,同时设置reader和writer的configuration信息

8、prepare()方法涉及到初始化reader和writer插件的初始化,通过调用插件的prepare()方法实现,每个插件都有自己的jarLoader,通过集成URLClassloader实现而来

9、split()方法通过adjustChannelNumber()方法调整channel个数,同时执行reader和writer最细粒度的切分,需要注意的是,writer的切分结果要参照reader的切分结果,达到切分后数目相等,才能满足1:1的通道模型

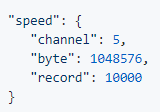

10、channel的计数主要是根据byte和record的限速来实现的(如果自己没有设置了channel的个数),在split()的函数中第一步就是计算channel的大小

11、split()方法reader插件会根据channel的值进行拆分,但是有些reader插件可能不会参考channel的值,writer插件会完全根据reader的插件1:1进行返回

12、split()方法内部的mergeReaderAndWriterTaskConfigs()负责合并reader、writer、以及transformer三者关系,生成task的配置,并且重写job.content的配置

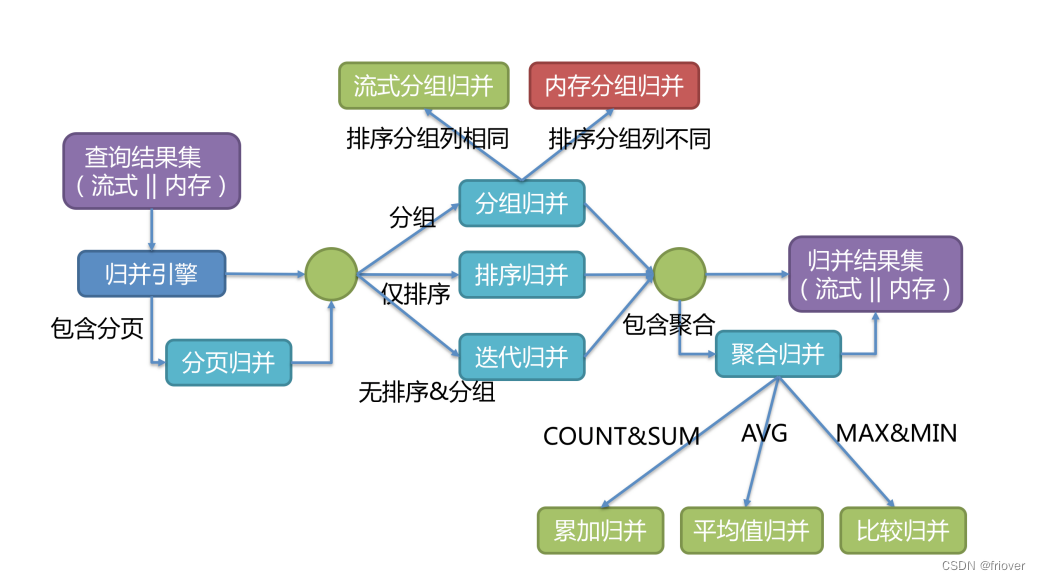

13、schedule()方法根据split()拆分生成的task配置分配生成taskGroup对象,根据task的数量和单个taskGroup支持的task数量进行配置,两者相除就可以得出taskGroup的数量14、schdule()内部通过AbstractScheduler的schedule()执行,继续执行startAllTaskGroup()方法创建所有的TaskGroupContainer组织相关的task,TaskGroupContainerRunner负责运行TaskGroupContainer执行分配的task。

15、taskGroupContainerExecutorService启动固定的线程池用以执行TaskGroupContainerRunner对象,TaskGroupContainerRunner的run()方法调用taskGroupContainer.start()方法,针对每个channel创建一个TaskExecutor,通过taskExecutor.doStart()启动任务。

DataX和sqoop的比较

我们公司用的是sqoop,针对自身总结的缺点:

1.由于mysql的表结构变更,引起的数据抽取失败。(目前添加监控,自动更改还需要开发)

2.抽取速度有待提高,对于大表,指定多个map,可能会导致数据重复,需要单独做处理。

3.不支持mongoDB

4.启动的速度比较慢

在测试DataX中发现的问题:

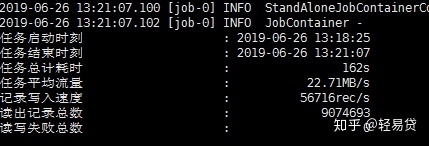

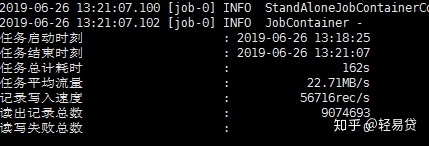

1.目前公司表中基本上没有自增主键,对于数据量大的表(目前数据量还有待测试),抽取速度慢(6千万的表7116rec/s,两千万的速度在7902rec/s,1千万的表在19307rec/s 左右),如果有自增主键或者整型的索引字段,速度是56716rec/s ,使用uuid生成的主键,会存在主键切分不均匀现象(可以修改源码)。

2.目前开源版本只支持单机模式,需要依赖调度系统(在每个节点上部署客户端)

3.不支持自动创建表和分区,写入的hdfs路径必须存在(可以后期修改源代码,或者使用脚本生成)

4.生成配置文件比较繁琐(每张表需要生成一张配置文件,可以使用代码生成)

DataX的优点总结

1.除比较大的表之外,速度明显比sqoop快(表数据量3000万分界点并且表没有自增的整型主键,前面是sqoop 22:27 - 35:58 一共751s,后面是指定5个channel时间162s,第三个是一个channel时间是471s,大表sqoop也比较慢,使用多个map,然后去重,分为两个阶段)。

2.Datax的速度可以配置,可以根据我们的实际情况控制

3.日志相比于sqoop比较完善和人性化。

4.对于脏数据的处理

- 在大量数据的传输过程中,必定会由于各种原因导致很多数据传输报错(比如类型转换错误),这种数据DataX认为就是脏数据。DataX目前可以实现脏数据精确过滤、识别、采集、展示,提供多种的脏数据处理模式。

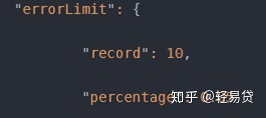

- Job支持用户对于脏数据的自定义监控和告警,包括对脏数据最大记录数阈值(record值)或者脏数据占比阈值(percentage值),当Job传输过程出现的脏数据大于用户指定的数量/百分比,DataX Job报错退出。

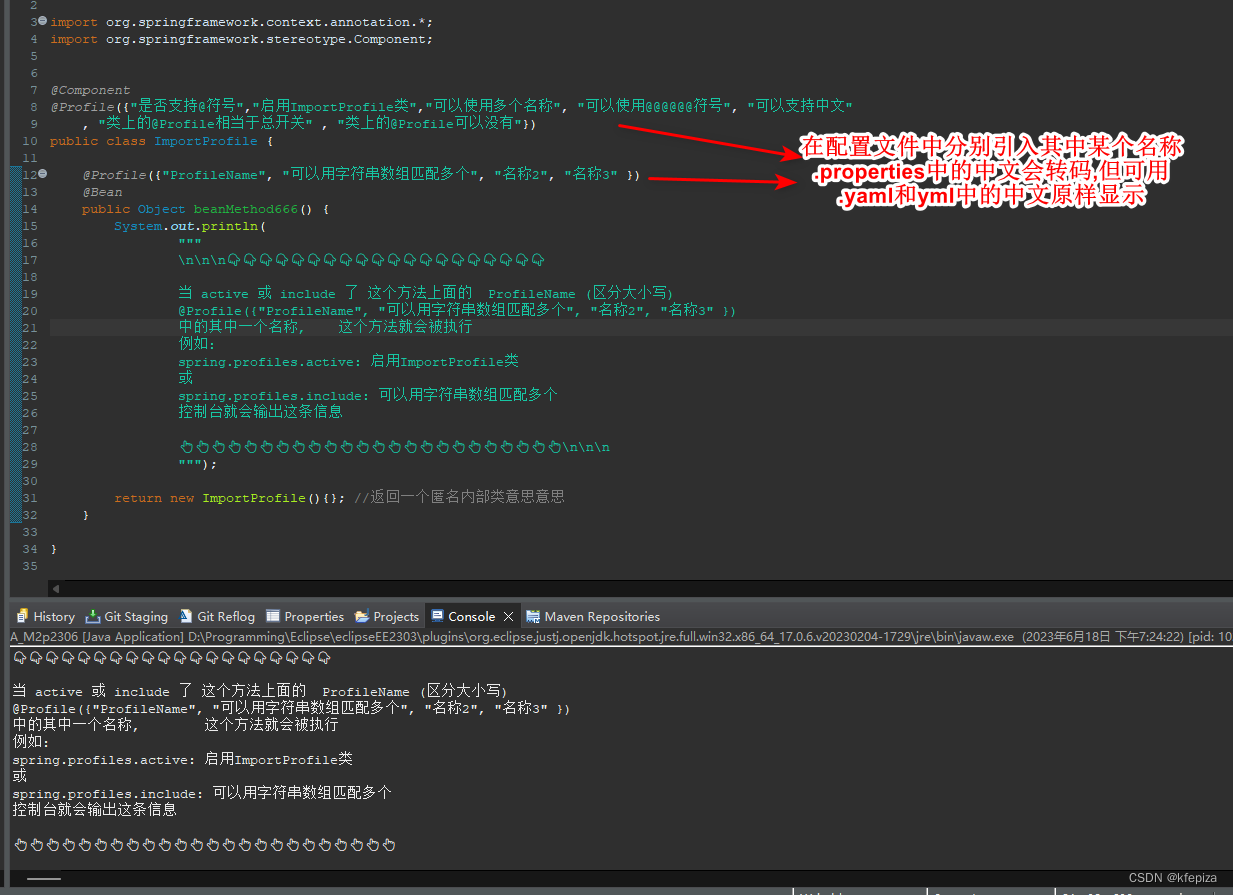

- 图中的配置的意思是当脏数据大于10条,或者脏数据比例达到0.05%,任务就会报错

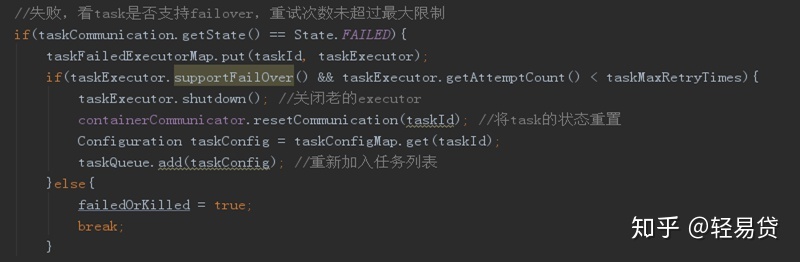

5.健壮的容错机制:DataX作业是极易受外部因素的干扰,网络闪断、数据源不稳定等因素很容易让同步到一半的作业报错停止。因此稳定性是DataX的基本要求,在DataX 3.0的设计中,重点完善了框架和插件的稳定性。

6.丰富的数据转换功能

DataX作为一个服务于大数据的ETL工具,除了提供数据快照搬迁功能之外,还提供了丰富数据转换的功能,让数据在传输过程中可以轻松完成数据脱敏,补全,过滤等数据转换功能,另外还提供了自动groovy函数,让用户自定义转换函数。

第二部分 FlinkCDC -- Change Data Capture--捕数据库中数据变更的获技术

1. CDC在广义的概念上,只要是能捕获数据变更的技术,我们都可以称之为 CDC 。目前通常描述的 CDC 技术主要面向数据库的变更,是一种用于捕获数据库中数据变更的技术.

2,cdc的种类

CDC 的技术方案非常多,目前业界主流的实现机制可以分为两种:

基于查询的 CDC:

◆离线调度查询作业,批处理。把一张表同步到其他系统,每次通过查询去获取表中最新的数据;

◆无法保障数据一致性,查的过程中有可能数据已经发生了多次变更;

◆不保障实时性,基于离线调度存在天然的延迟。

基于日志的 CDC:

◆实时消费日志,流处理,例如 MySQL 的 binlog 日志完整记录了数据库中的变更,可以把 binlog 文件当作流的数据源;

◆保障数据一致性,因为 binlog 文件包含了所有历史变更明细;

◆保障实时性,因为类似 binlog 的日志文件是可以流式消费的,提供的是实时数据。

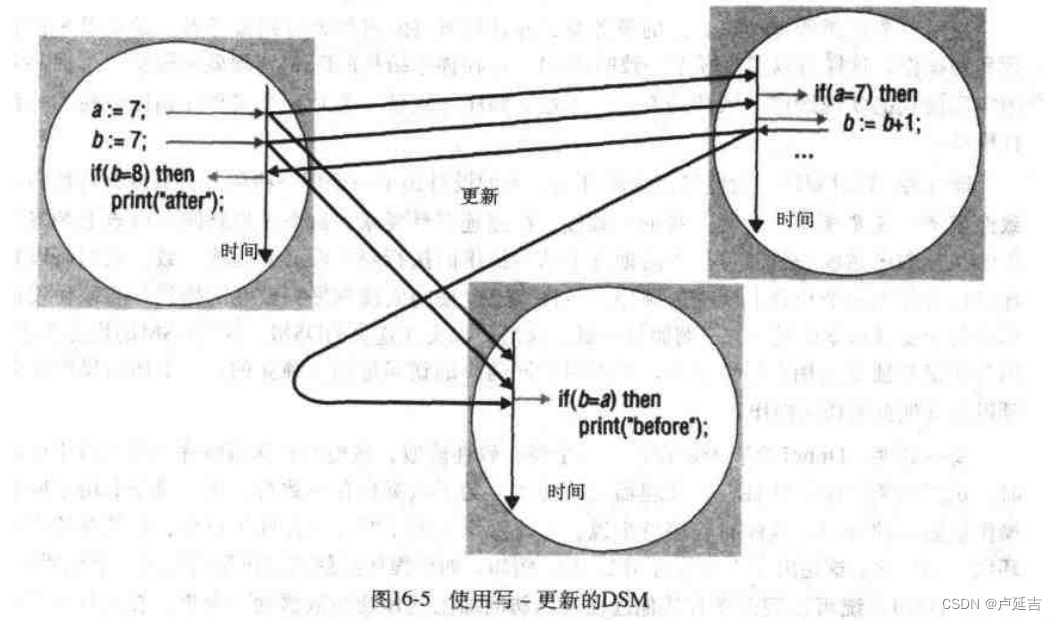

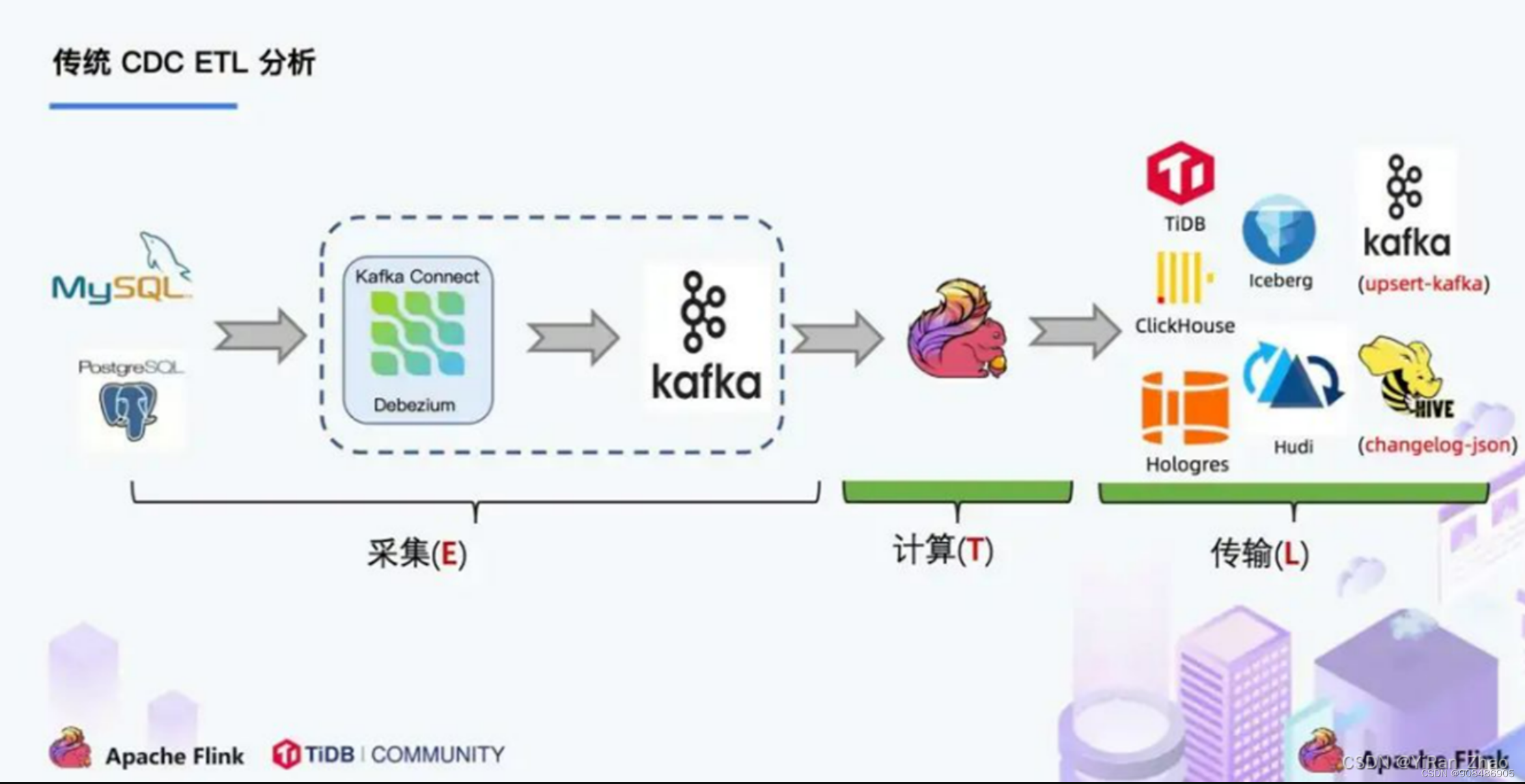

3,传统的cdc和flink的cdc

传统的cdc

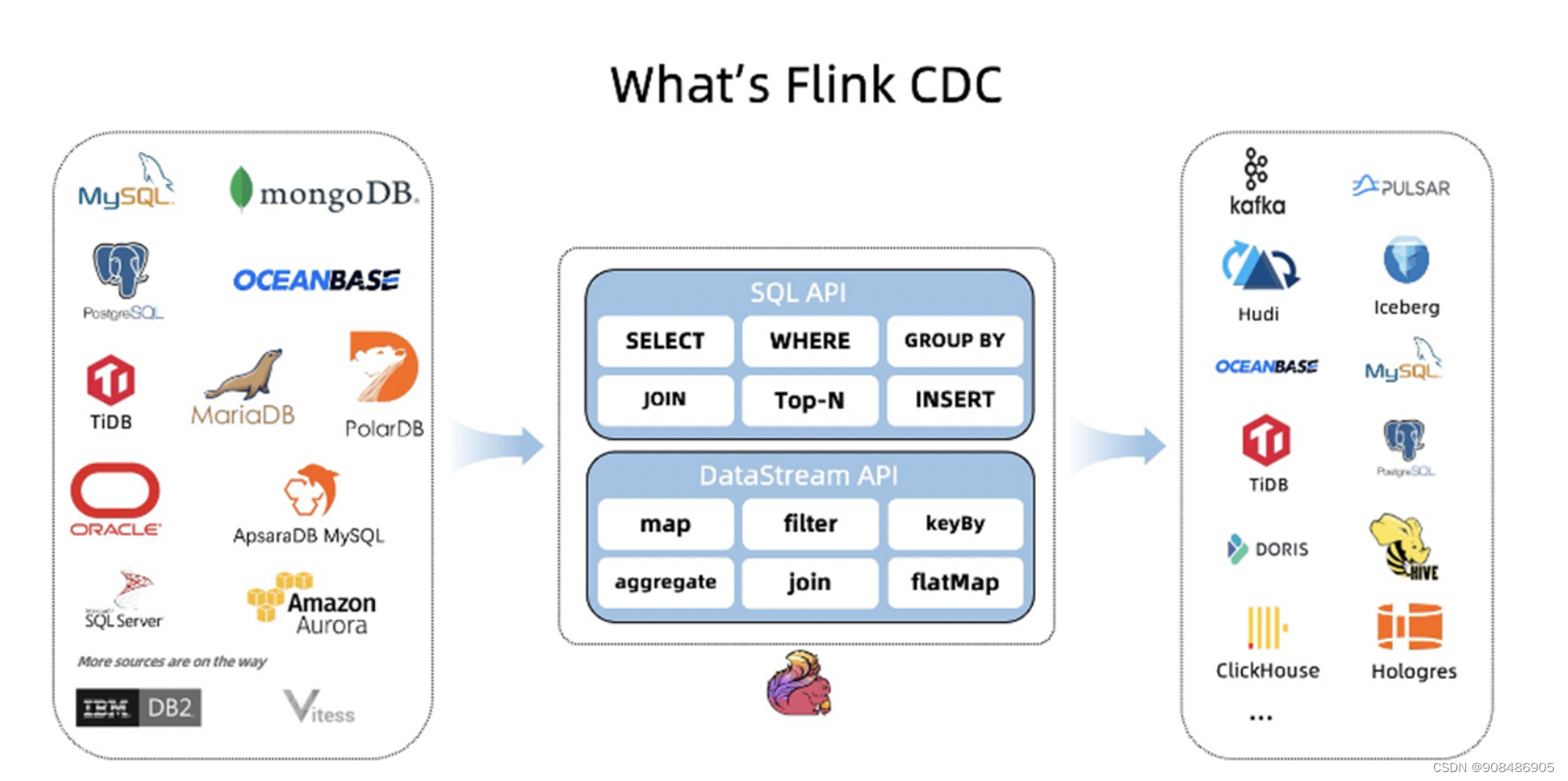

flink 的cdc

4,flink cdc 发展史

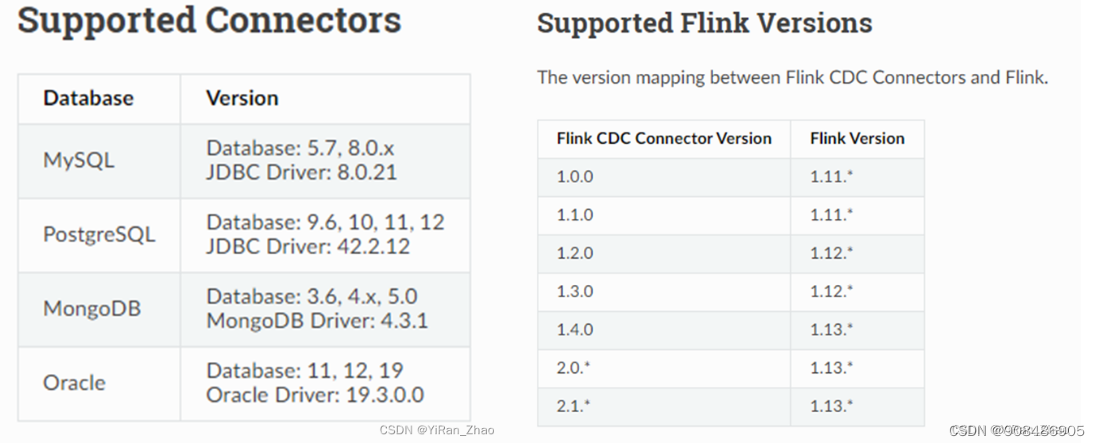

5,Flink CDC Connectors

Connectors — Flink CDC documentation

Flink CDC Connectors 是 Flink 的一组 Source 连接器,是 Flink CDC 的核心组件,这些连接器负责从 MySQL、PostgreSQL、Oracle、MongoDB 等数据库读取存量历史数据和增量变更数据

6,flink cdc对应flink的版本支持

7,cdc的版本介绍

Flink cdc1.x

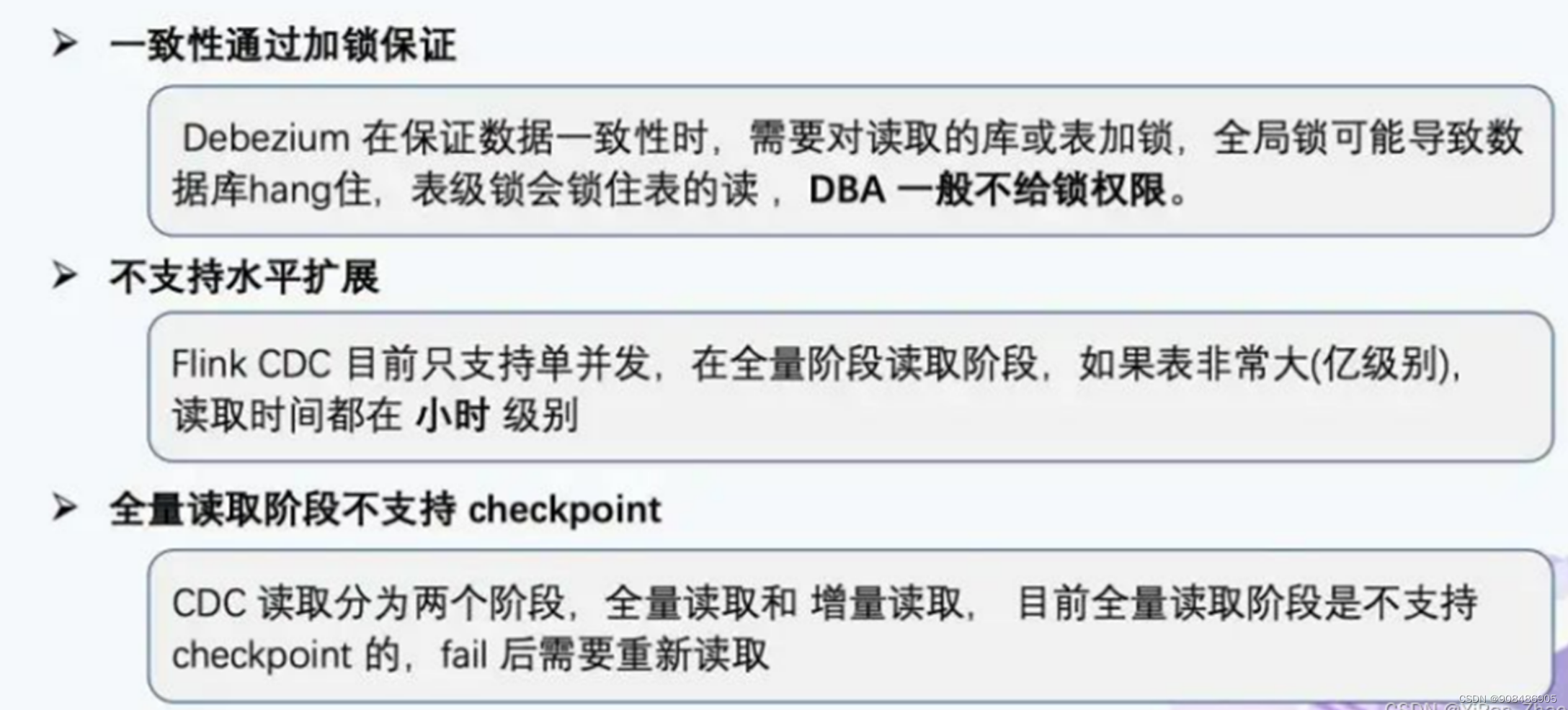

全量 + 增量读取的过程需要保证所有数据的一致性,因此需要通过加锁保证,但是加锁在数据库层面上是一个十分高危的操作。底层 Debezium 在保证数据一致性时,需要对读取的库或表加锁,全局锁可能导致数据库锁住,表级锁会锁住表的读,DBA 一般不给锁权限。

不支持水平扩展,因为 Flink CDC 底层是基于 Debezium,起架构是单节点,所以Flink CDC 只支持单并发。在全量阶段读取阶段,如果表非常大 (亿级别),读取时间在小时甚至天级别,用户不能通过增加资源去提升作业速度。

全量读取阶段不支持 checkpoint:CDC 读取分为两个阶段,全量读取和增量读取,目前全量读取阶段是不支持 checkpoint 的,因此会存在一个问题:当我们同步全量数据时,假设需要 5 个小时,当我们同步了 4 小时的时候作业失败,这时候就需要重新开始,再读取 5 个小时。

Flink cdc2.x

[1] DBLog - 无锁算法论文:https://arxiv.org/pdf/2010.12597v1.pdf

[2] Flink FLIP-27 设计文档:https://cwiki.apache.org/confluence/display/FLINK/FLIP-27%3A+Refactor+Source+Interface