回归预测 | MATLAB实现SSA-CNN-BiGRU麻雀算法优化卷积双向门控循环单元多输入单输出回归预测

预测效果

基本介绍

MATLAB实现SSA-CNN-BiGRU麻雀算法优化卷积双向门控循环单元多输入单输出回归预测,运行环境Matlab2020b及以上。优化正则化率、学习率、隐藏层单元数。

1.MATLAB实现SSA-CNNBiGRU麻雀算法优化卷积双向门控循环单元多输入单输出回归预测;

2.输入多个特征,输出单个变量,多输入单输出回归预测;

3.多指标评价,评价指标包括:R2、MAE、MSE、RMSE等,代码质量极高;

4.麻雀算法优化参数为:学习率,隐含层节点,正则化参数;

5.excel数据,方便替换,运行环境2020及以上。

模型描述

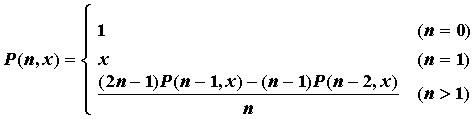

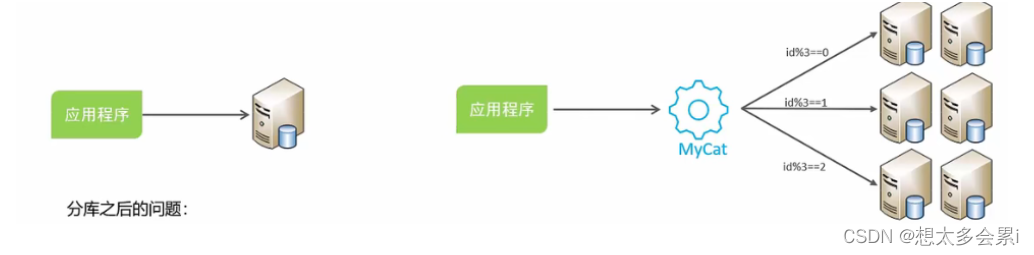

麻雀算法是一种启发式优化算法,可以用来寻找函数的最优解。卷积门控循环单元是一种神经网络结构,可以用于序列建模任务。多输入单输出回归预测是一种常见的机器学习任务,即给定多个输入变量,预测一个输出变量的值。

将这三个部分结合起来,可以采用麻雀算法来优化BiGRU网络的超参数,以最小化多输入单输出回归预测任务的损失函数。具体来说,可以将网络看作一个函数,输入为多个变量的序列,输出为一个标量。通过麻雀算法搜索最优的权重和超参数,可以使得这个函数在给定数据上的预测误差最小化。

需要注意的是,使用麻雀算法优化神经网络需要大量的计算资源和时间,并且需要对优化过程进行合理的调参。因此,在实践中需要仔细考虑是否使用这种方法,以及如何进行实验设计和超参数调整。此外,还需要注意选择合适的损失函数、数据预处理方法和评估指标等。最好先对单一模型进行测试,确保其性能达到预期,然后再尝试使用麻雀算法进行优化。

程序设计

- 完整源码和数据获取方式1:私信博主,同等价值程序兑换;

- 完整程序和数据下载方式2(订阅《组合优化》专栏,同时获取《组合优化》专栏收录的任意6份程序,数据订阅后私信我获取):MATLAB实现SSA-CNN-GRU麻雀算法优化卷积门控循环单元多输入单输出回归预测

%% 获取最优种群

for j = 1 : SearchAgents

if(fitness_new(j) < GBestF)

GBestF = fitness_new(j);

GBestX = X_new(j, :);

end

end

%% 更新种群和适应度值

pop_new = X_new;

fitness = fitness_new;

%% 更新种群

[fitness, index] = sort(fitness);

for j = 1 : SearchAgents

pop_new(j, :) = pop_new(index(j), :);

end

%% 得到优化曲线

curve(i) = GBestF;

avcurve(i) = sum(curve) / length(curve);

end

%% 得到最优值

Best_pos = GBestX;

Best_score = curve(end);

%% 得到最优参数

NumOfUnits =abs(round( Best_pos(1,3))); % 最佳神经元个数

InitialLearnRate = Best_pos(1,2) ;% 最佳初始学习率

L2Regularization = Best_pos(1,1); % 最佳L2正则化系数

%

inputSize = k;

outputSize = 1; %数据输出y的维度

% 参数设置

opts = trainingOptions('adam', ... % 优化算法Adam

'MaxEpochs', 20, ... % 最大训练次数

'GradientThreshold', 1, ... % 梯度阈值

'InitialLearnRate', InitialLearnRate, ... % 初始学习率

'LearnRateSchedule', 'piecewise', ... % 学习率调整

'LearnRateDropPeriod', 6, ... % 训练次后开始调整学习率

'LearnRateDropFactor',0.2, ... % 学习率调整因子

'L2Regularization', L2Regularization, ... % 正则化参数

'ExecutionEnvironment', 'gpu',... % 训练环境

'Verbose', 0, ... % 关闭优化过程

'SequenceLength',1,...

'MiniBatchSize',10,...

'Plots', 'training-progress'); % 画出曲线

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/128577926?spm=1001.2014.3001.5501

[2] https://blog.csdn.net/kjm13182345320/article/details/128573597?spm=1001.2014.3001.5501

![[学习笔记] [机器学习] 12. [下] HMM 隐马尔可夫算法(马尔科夫链、HMM 三类问题、前后后向算法、维特比算法、鲍姆-韦尔奇算法、API 及实例)](https://img-blog.csdnimg.cn/2e81c06446854ac7bd9487b754fd3c4d.png#pic_center)