章节一:引言

在当今的数字时代,数据成为了无处不在的关键资源。大数据的崛起为企业提供了无限的机遇,同时也带来了前所未有的挑战。为了有效地处理和分析大规模数据集,必须依靠强大的工具和技术。在本文中,我们将探讨Python在大数据领域的应用,重点介绍Hadoop、Spark和Pyspark,并分享一些数据处理的技巧。

章节二:Hadoop和Python

Hadoop是一个开源的分布式存储和处理大规模数据的框架。它提供了高容错性和可扩展性,使得处理大数据集变得更加容易。虽然Hadoop主要使用Java编写,但Python也可以与Hadoop进行集成,为数据处理和分析提供便利。

一个常见的使用案例是使用Python编写Hadoop Streaming脚本。通过Hadoop Streaming,我们可以将Python脚本作为MapReduce作业的Mapper和Reducer来运行。这种方式使得开发人员能够使用Python的强大数据处理库(如Pandas和NumPy)来处理大规模数据集。下面是一个简单的示例代码:

#!/usr/bin/env python

import sys

for line in sys.stdin:

words = line.strip().split()

for word in words:

print(word + "\t1")

以上代码将输入的文本按单词切分,并输出每个单词和计数1。通过Hadoop Streaming,我们可以将该脚本与Hadoop集群集成,从而实现高效的大数据处理。

章节三:Spark和Python

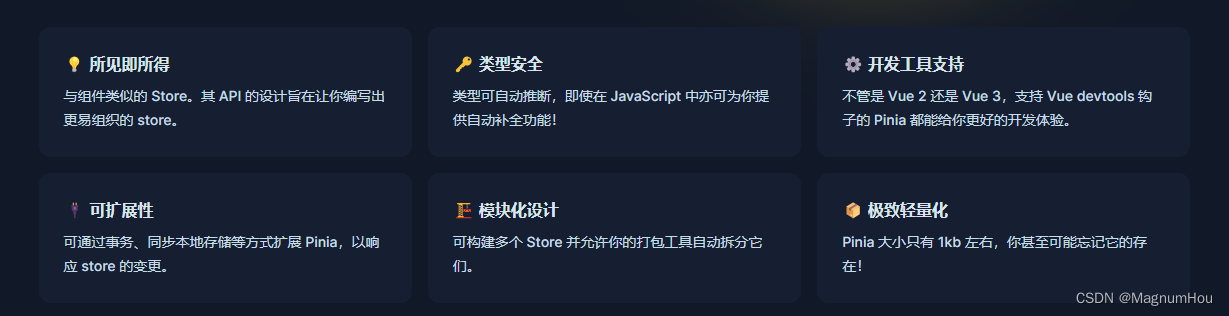

Spark是另一个强大的大数据处理框架,它提供了比Hadoop更快速和易于使用的接口。与Hadoop不同,Spark可以使用多种编程语言进行开发,包括Python。通过PySpark,我们可以使用Python编写Spark应用程序,并利用Spark的分布式计算能力进行大规模数据处理和分析。

一个常见的PySpark应用是使用DataFrame API进行数据处理。DataFrame是一种分布式数据集,类似于关系型数据库中的表。我们可以使用Python的Pandas库来处理本地数据,然后将其转换为Spark DataFrame进行分布式处理。下面是一个示例代码:

from pyspark.sql import SparkSession

spark = SparkSession.builder.getOrCreate()

# 从本地CSV文件创建Spark DataFrame

df = spark.read.csv("data.csv", header=True, inferSchema=True)

# 使用PySpark的内置函数进行数据处理

result = df.filter(df["age"] > 30).groupBy("occupation").count()

# 将结果写入Parquet文件

result.write.parquet("output.parquet")

以上代码演示了如何使用PySpark读取本地CSV文件并进行数据处理,然后将结果写入Parquet文件。通过PySpark的灵活性和Python的易用性,我们可以轻松地进行复杂的数据处理和分析操作。

章节四:数据处理技巧

在大数据处理过程中,掌握一些数据处理技巧可以提高效率和准确性。以下是几个常用的数据处理技巧:

数据清洗:大数据集通常包含缺失值、异常值和重复值等问题。使用Python的库(如Pandas和PySpark)可以轻松地进行数据清洗操作,例如删除缺失值、处理异常值和去除重复记录。

特征工程:特征工程是将原始数据转化为可供机器学习算法使用的特征的过程。Python提供了各种特征工程技术和库(如Scikit-learn和PySpark的MLlib),包括特征选择、特征变换和特征构建等。

数据聚合与汇总:对于大规模数据集,常常需要进行数据聚合和汇总操作,以便进行更深入的分析。利用PySpark的聚合函数和分组操作,可以方便地计算各种统计指标和生成摘要报告。

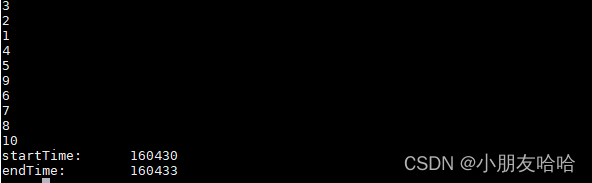

并行处理:大数据处理的一个重要挑战是处理速度。利用Python的并行处理技术(如多线程和分布式计算),可以加快数据处理的速度。在PySpark中,使用RDD(弹性分布式数据集)和DataFrame等数据结构,可以实现分布式并行处理。

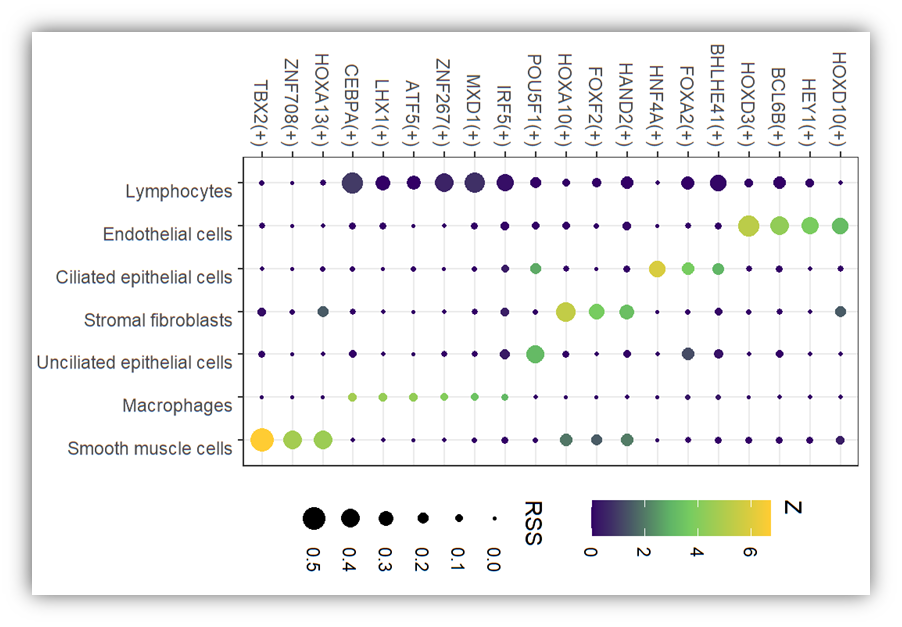

数据可视化:数据可视化是理解和传达大数据分析结果的重要手段。Python提供了丰富的数据可视化库(如Matplotlib和Seaborn),可以绘制各种图表和图形,帮助用户更好地理解和解释数据。

章节五:结论

Python在大数据处理中发挥着重要的作用,特别是与Hadoop、Spark和Pyspark等框架的集成。通过Python强大的数据处理库和易用的编程语法,我们可以处理和分析大规模数据集,从中获得有价值的信息和见解。掌握一些数据处理技巧,如数据清洗、特征工程、数据聚合与汇总、并行处理和数据可视化,可以提高大数据处理的效率和准确性。随着大数据时代的不断演进,Python将继续在大数据领域发挥重要作用,并成为数据科学家和工程师们的首选工具之一。

希望本文能够帮助读者更好地理解Python在大数据处理中的应用和数据处理技巧,为大数据分析提供一些有用的指导和启发。通过不断学习和实践,读者可以不断探索和应用Python在大数据领域的新技术和工具,进一步提升数据处理和分析的能力。大数据时代带来了无限的机遇和挑战,而Python作为一种强大的编程语言,在大数据处理中具有广泛的应用前景。