目录

- 1 查看数据分布

- 2 当前集群部署拓扑

- 3 扩容TiKV节点

- 3.1 编写扩容脚本

- 3.2 执行扩容命令

- 3.2.1 命令格式

- 3.2.2 执行命令

- 3.3 验证扩容信息

- 3.3.1 查看节点信息

- 3.3.2 通过dashboard查看

- 4 缩容TiKV节点

- 4.1 查看节点信息

- 4.2 执行缩容操作

- 4.2.1 缩容命令

- 4.2.2 执行命令

- 4.3 验证缩容信息

- 4.3.1 查看节点信息

- 4.3.2 通过dashboard查看

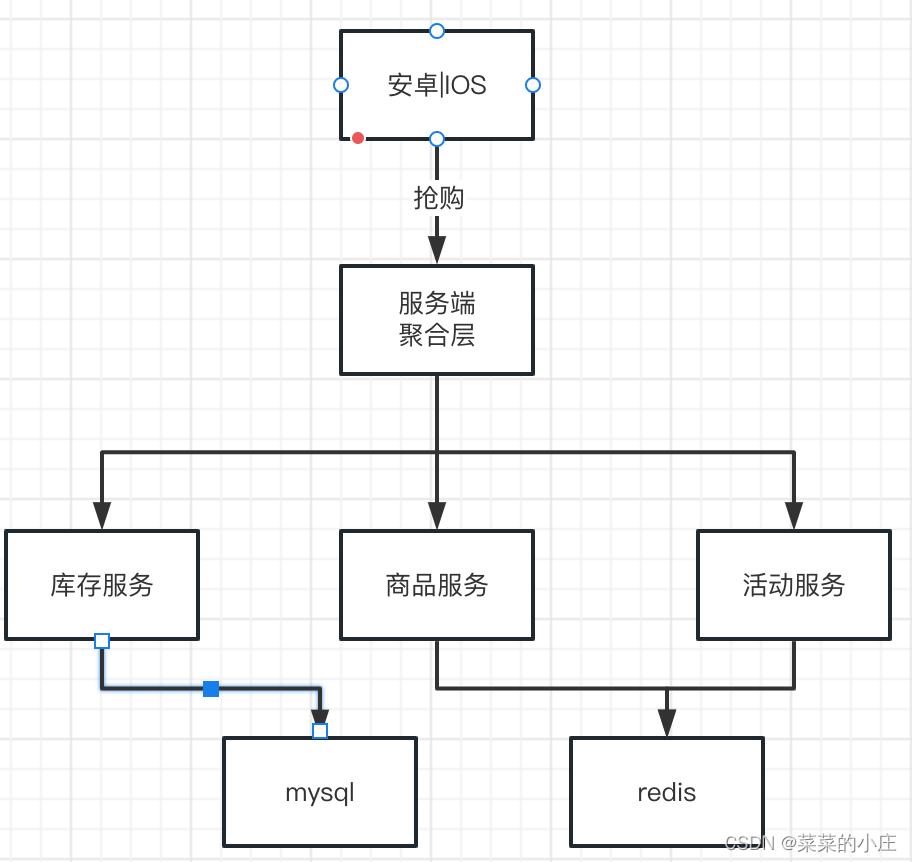

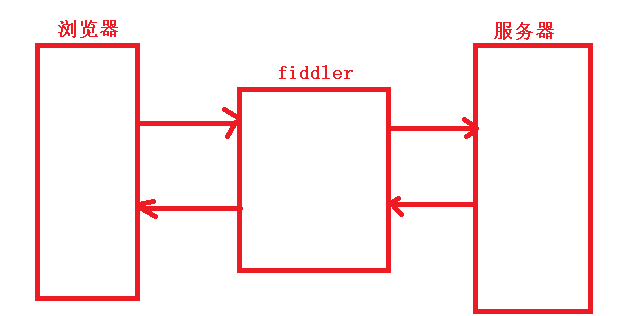

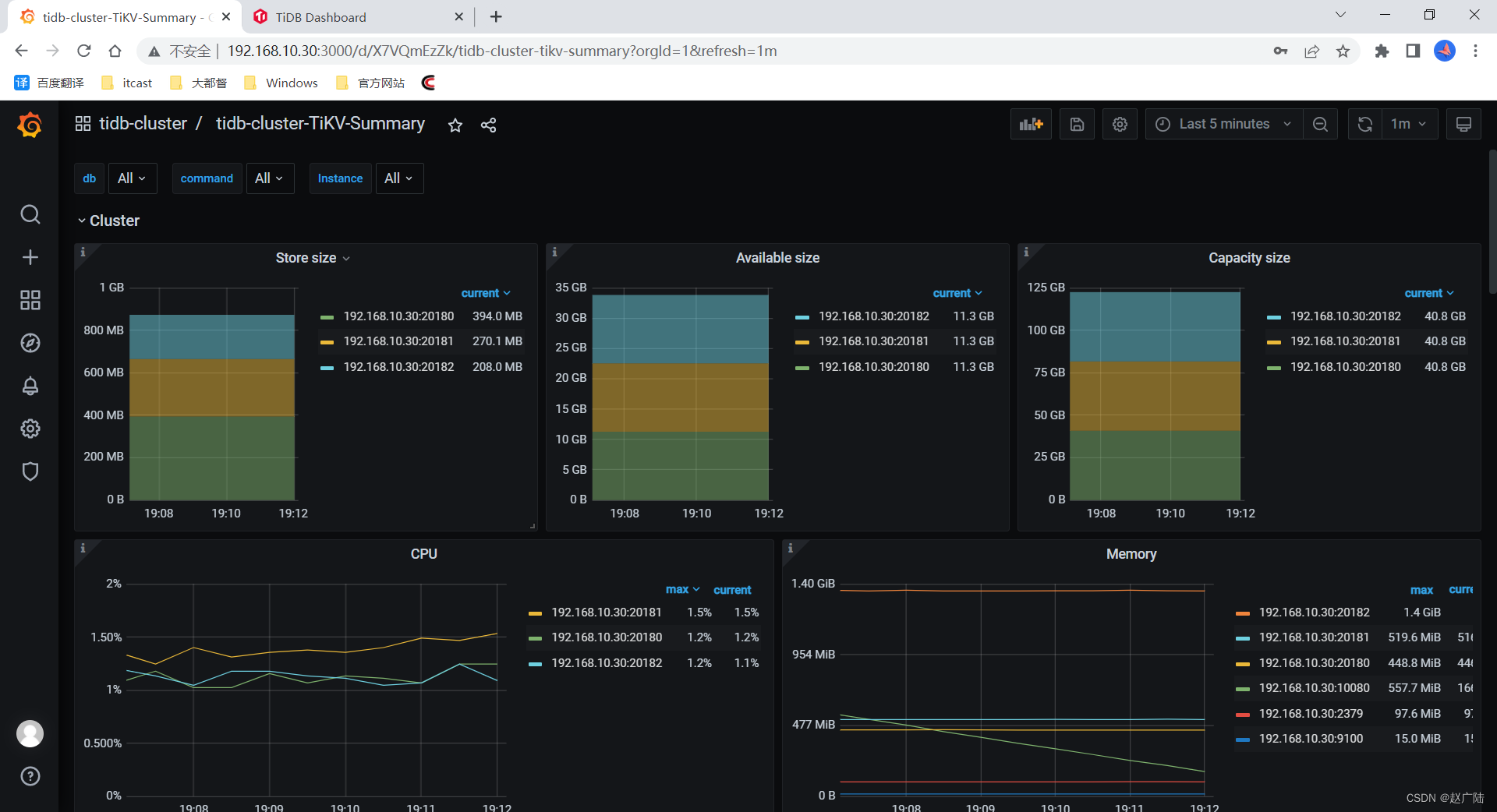

1 查看数据分布

可以在gafana中的

tidb-cluster-tikv-summary查看tidb的数据在服务器中的分布情况

2 当前集群部署拓扑

| 实例 | IP | 端口 | 存储路径 | 部署路径 |

|---|---|---|---|---|

| grafana | 192.168.10.30 | 3000 | – | /tidb-deploy/grafana-3000 |

| pd | 192.168.10.30 | 2379/2380 | /tidb-data/pd-2379 | /tidb-deploy/pd-2379 |

| prometheus | 192.168.10.30 | 9090 | /tidb-data/prometheus-9090 | /tidb-deploy/prometheus-9090 |

| tidb | 192.168.10.30 | 4000/10080 | – | /tidb-deploy/tidb-4000 |

| tiflash | 192.168.10.30 | 9000/8123/3930/20170/20292/8234 | /tidb-data/tiflash-9000 | /tidb-deploy/tiflash-9000 |

| tikv | 192.168.10.30 | 20160/20180 | /tidb-data/tikv-20160 | /tidb-deploy/tikv-20160 |

| tikv | 192.168.10.30 | 20161/20181 | /tidb-data/tikv-20161 | /tidb-deploy/tikv-20161 |

| tikv | 192.168.10.30 | 20162/20182 | /tidb-data/tikv-20162 | /tidb-deploy/tikv-20162 |

3 扩容TiKV节点

需要扩容一个TiKV节点

| 实例 | IP | 端口 | 存储路径 | 部署路径 |

|---|---|---|---|---|

| tikv | 192.168.10.30 | 20163/20183 | /tidb-data/tikv-20163 | /tidb-deploy/tikv-20163 |

3.1 编写扩容脚本

在 scale-out.yaml 文件添加扩容拓扑配置

[root@linux30 tidb]# vi scale-out.yaml

xxxxxxxxxx

tikv_servers:

- host: 192.168.10.30

ssh_port: 22

port: 20163

status_port: 20183

deploy_dir: /opt/tidb/tidb-deploy/tikv-20163

data_dir: /opt/tidb/tidb-data/tikv-20163

config:

server.labels:

host: logic-host-4

3.2 执行扩容命令

3.2.1 命令格式

tiup cluster scale-out <cluster-name> scale-out.yaml -p

- cluster-name:TiDB集群名称

- p:使用密码方式登录当前机器

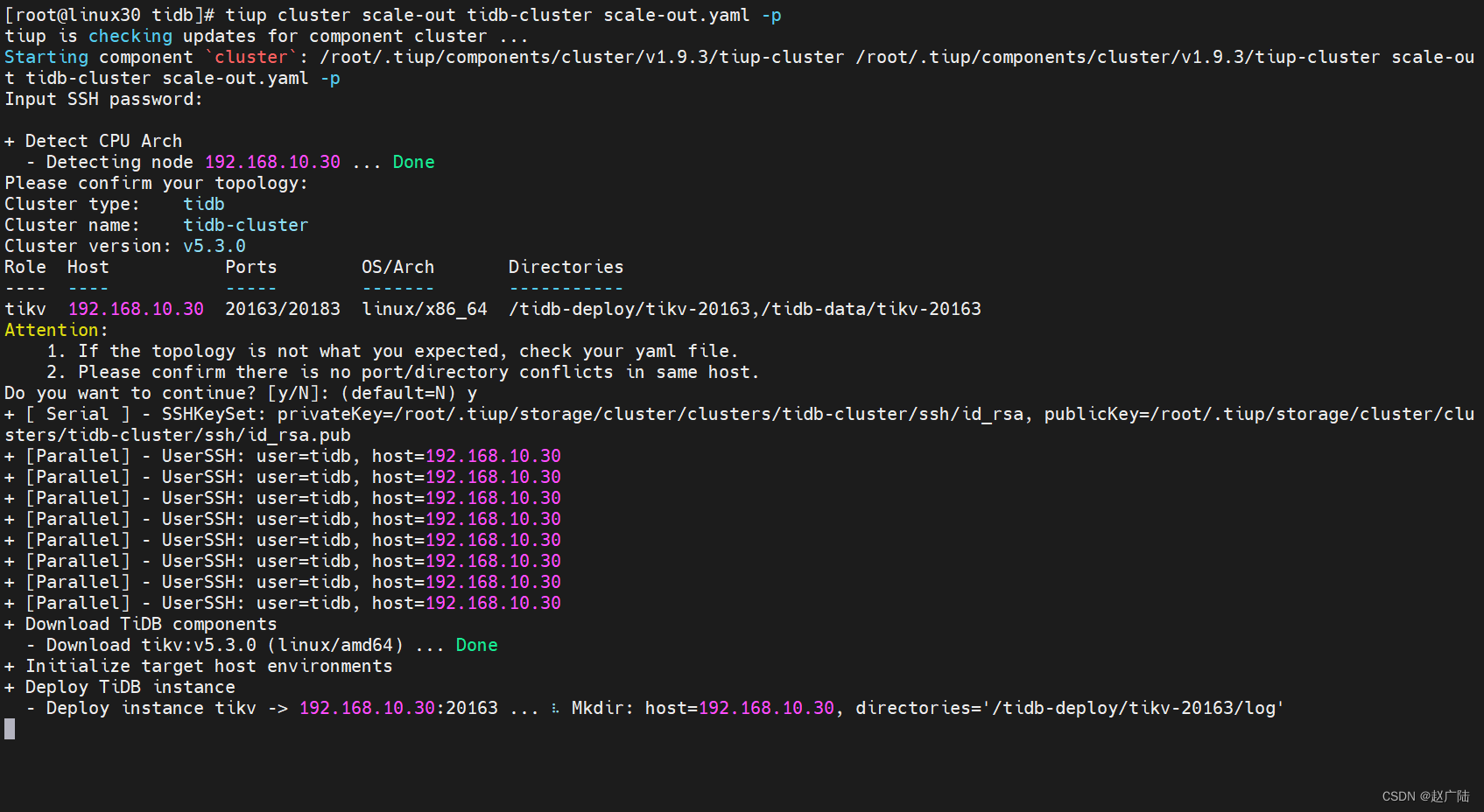

3.2.2 执行命令

[root@linux30 tidb]# tiup cluster scale-out tidb-cluster scale-out.yaml -p

输入命令后,确认输入机器密码

出现

successfully表示节点扩容成功

3.3 验证扩容信息

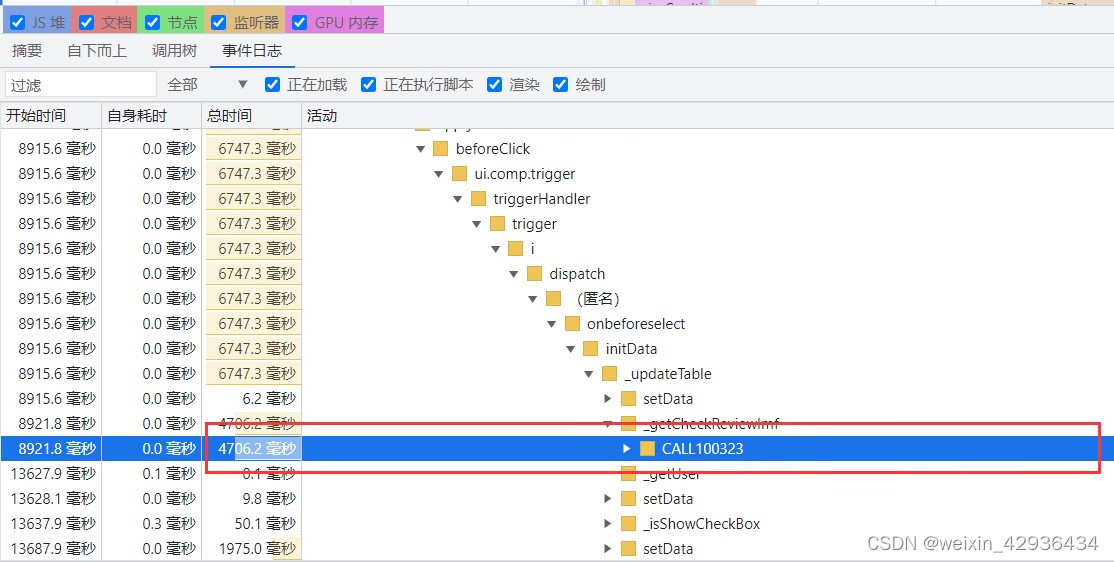

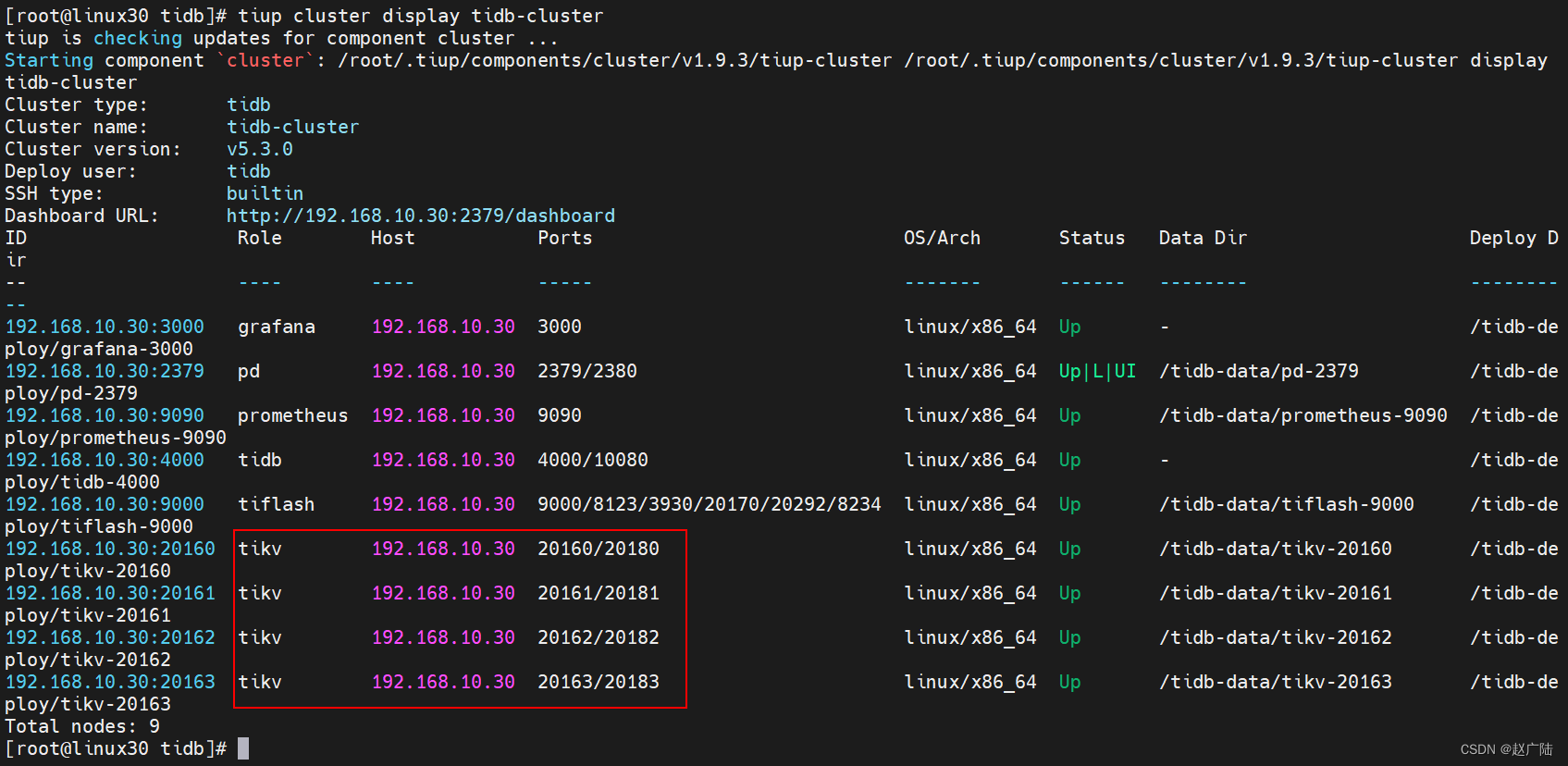

3.3.1 查看节点信息

tiup cluster display tidb-cluster

我们看到Tikv已经增加了一个节点

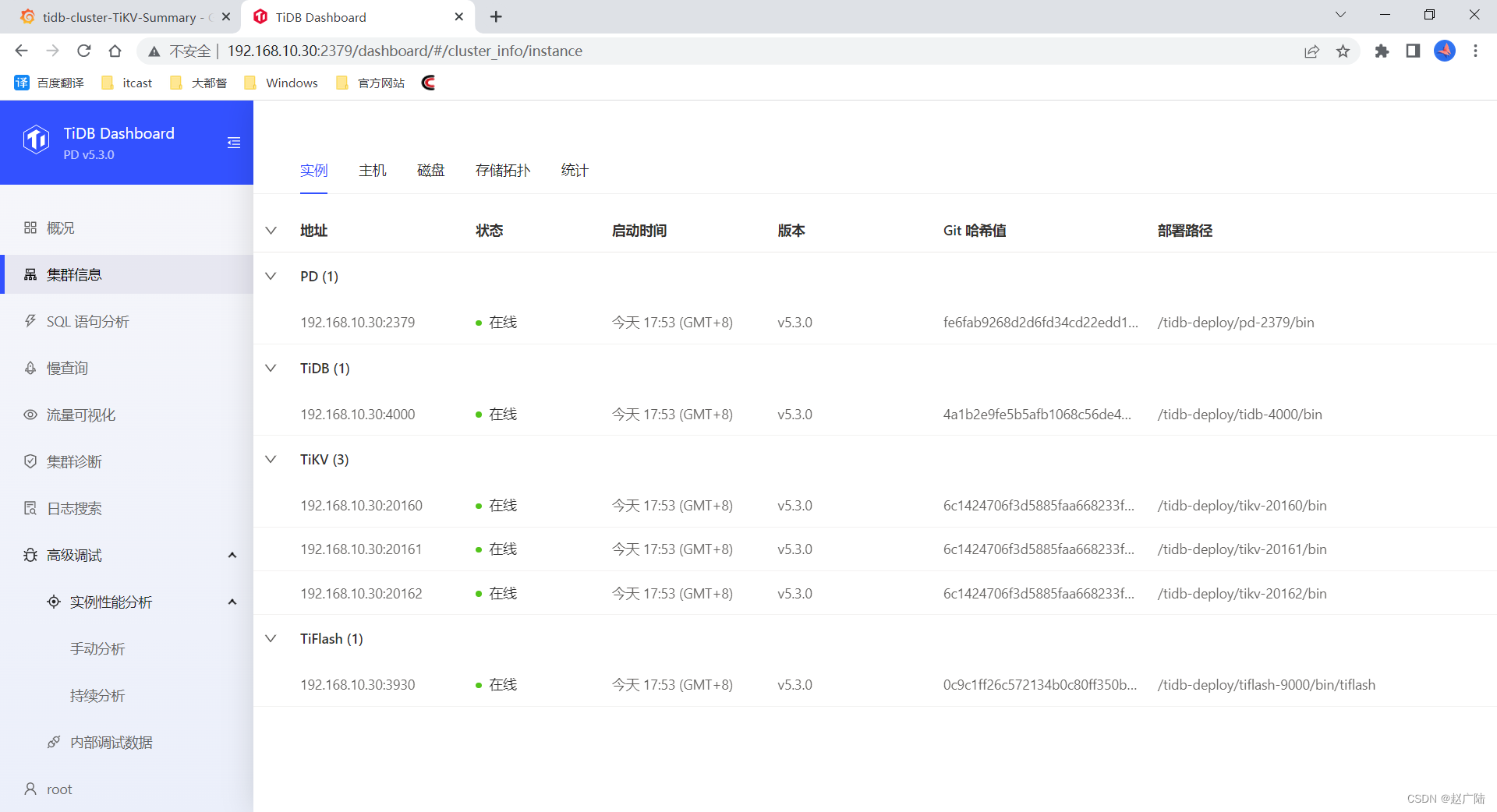

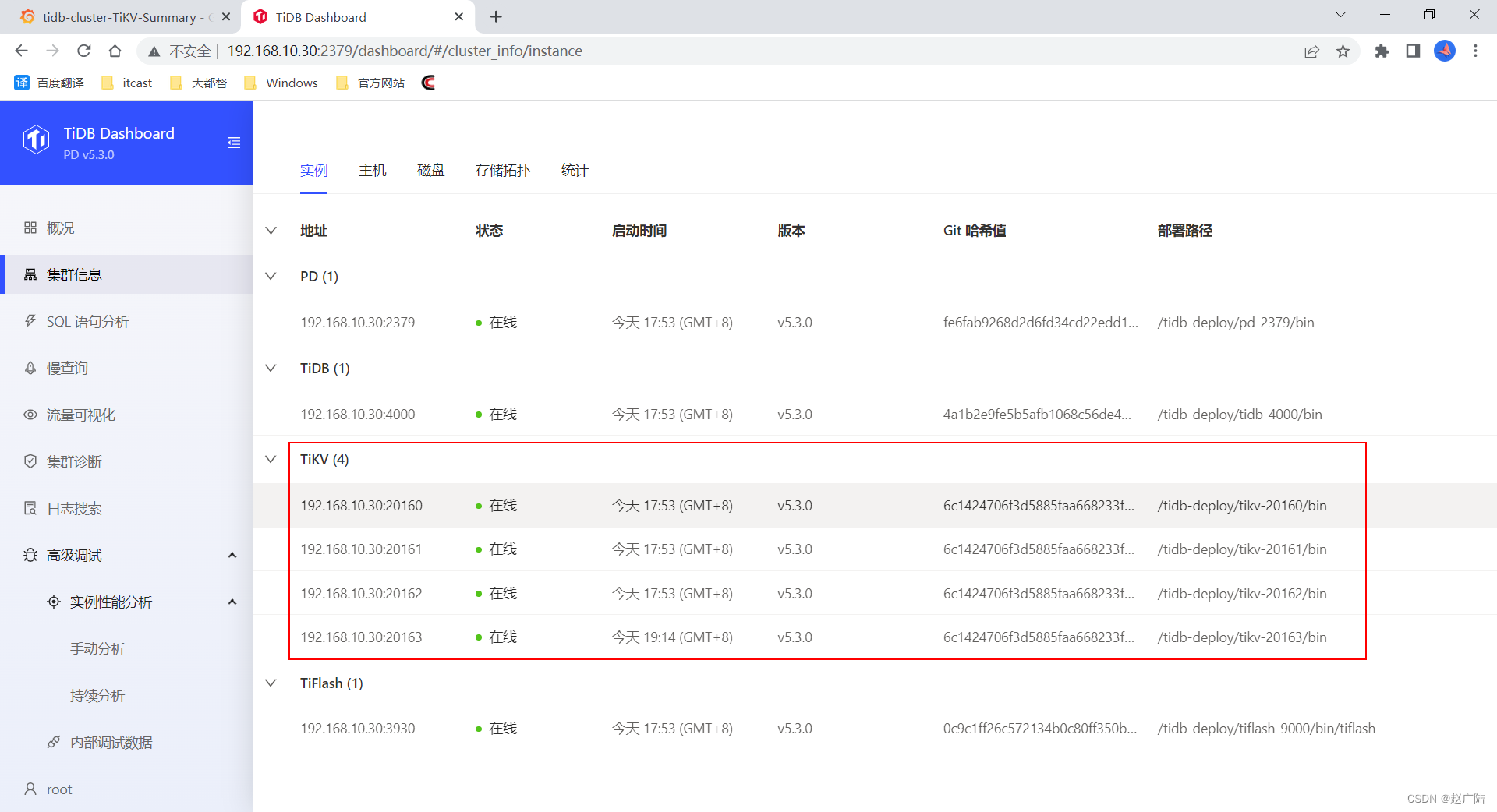

3.3.2 通过dashboard查看

也可以看到扩容的节点信息

4 缩容TiKV节点

4.1 查看节点信息

[root@linux30 tidb]# tiup cluster display tidb-cluster

当前TiKV是4个节点

4.2 执行缩容操作

4.2.1 缩容命令

tiup cluster scale-in <cluster-name> --node 192.168.64.152:20163

参数解释

- cluster-name:集群名称

- node:需要删除的节点地址

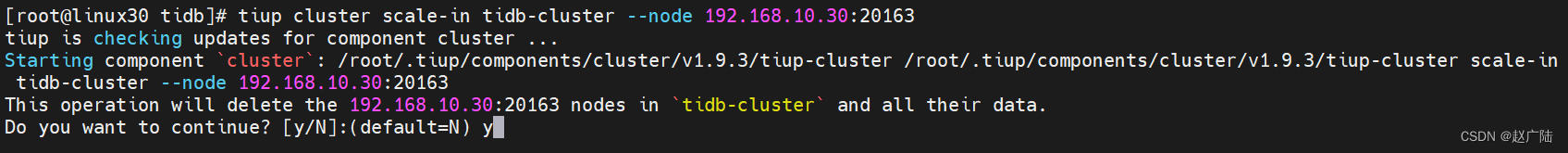

4.2.2 执行命令

[root@linux30 tidb]# tiup cluster scale-in tidb-cluster --node 192.168.10.30:20163

出现确认操作后,输入y确认执行就可以执行缩容操作了

4.3 验证缩容信息

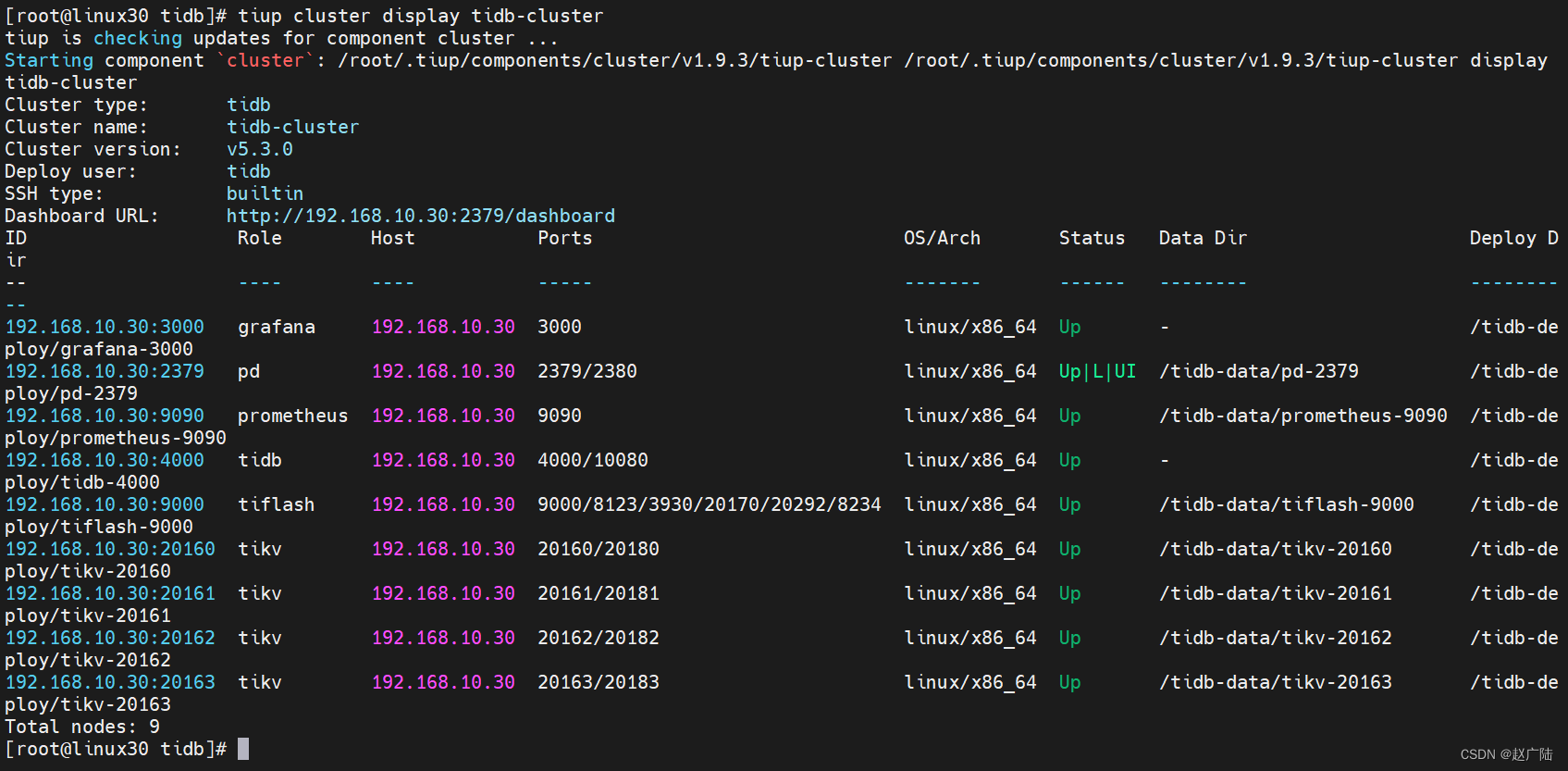

4.3.1 查看节点信息

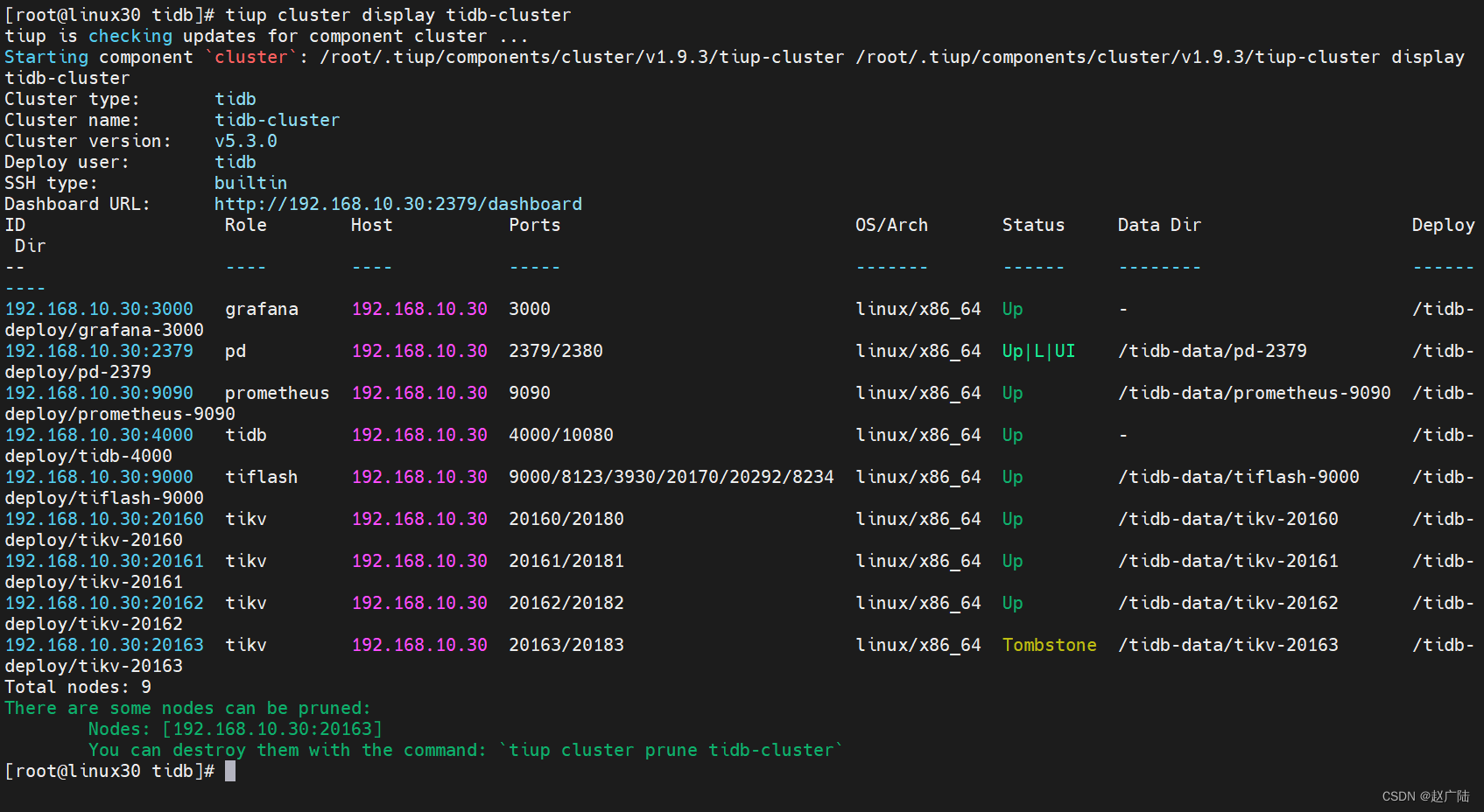

tiup cluster display tidb-cluster

我们看到需要缩容的节点状态是

Tombstone说明已经下线,下线需要一定时间,下线节点的状态变为Tombstone就说明下线成功

4.3.2 通过dashboard查看

也可以看到缩容的节点已经不存在了,说明缩容成功