文章目录

- 1. Colab和Google云端硬盘

- 1.1 建立项目文件和jupyter文件

- 1.2 Colab运行时选择

- 1.3 关联Colab中的文件和Google云端硬盘的文件

- 2. Colab和MMPose

- 2.1 环境配置

- 2.2 配置文件修改

- 3. Colab相关知识

1. Colab和Google云端硬盘

参考:

- 利用Colab上的TPU训练Keras模型(完整版)

- 使用colab进行深度学习训练

- 利用colab实现AI绘画自由

1.1 建立项目文件和jupyter文件

进入谷歌云,建立一个当前项目的文件夹,同时里面必须有一个.ipynb文件(后续直接用colab打开这个文件),项目结构类似:

|--OpenMMLab

|--Exercise1

|--checkpoint

|--outputs

|--Config

|--exercise1.ipynb

|--Exercise2

...

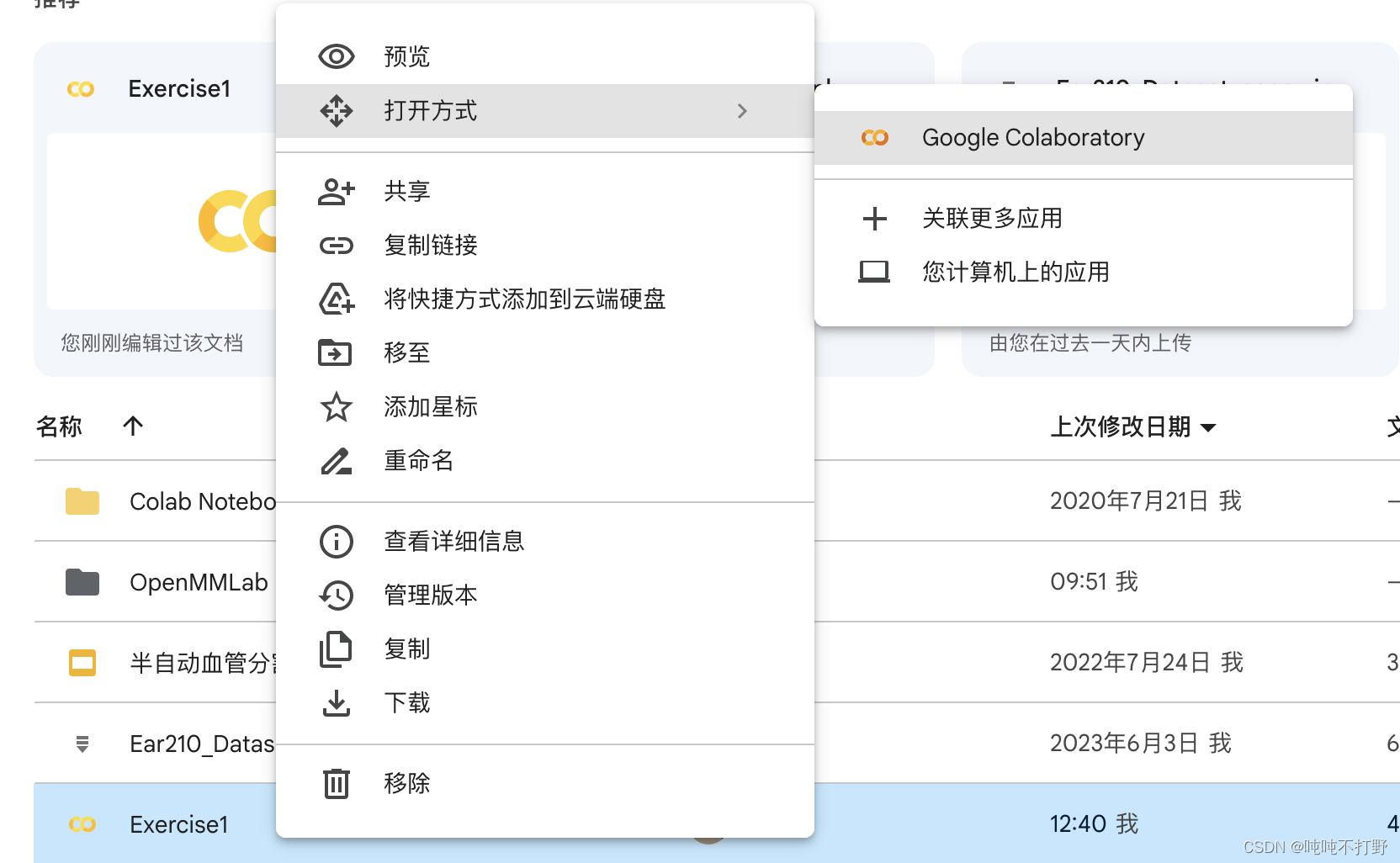

总之把你希望要保留的文件都建立相应的文件夹,然后第一次打开.ipynb的时候,记得选择Colab,此时,这个文件就和Google云端硬盘关联了,在colab中对这个文件进行修改,会保存到Google云端硬盘中。

1.2 Colab运行时选择

有两种方式可以选:

- 修改->笔记本设置,可以选GPU,也可以选TPU,随便选吧

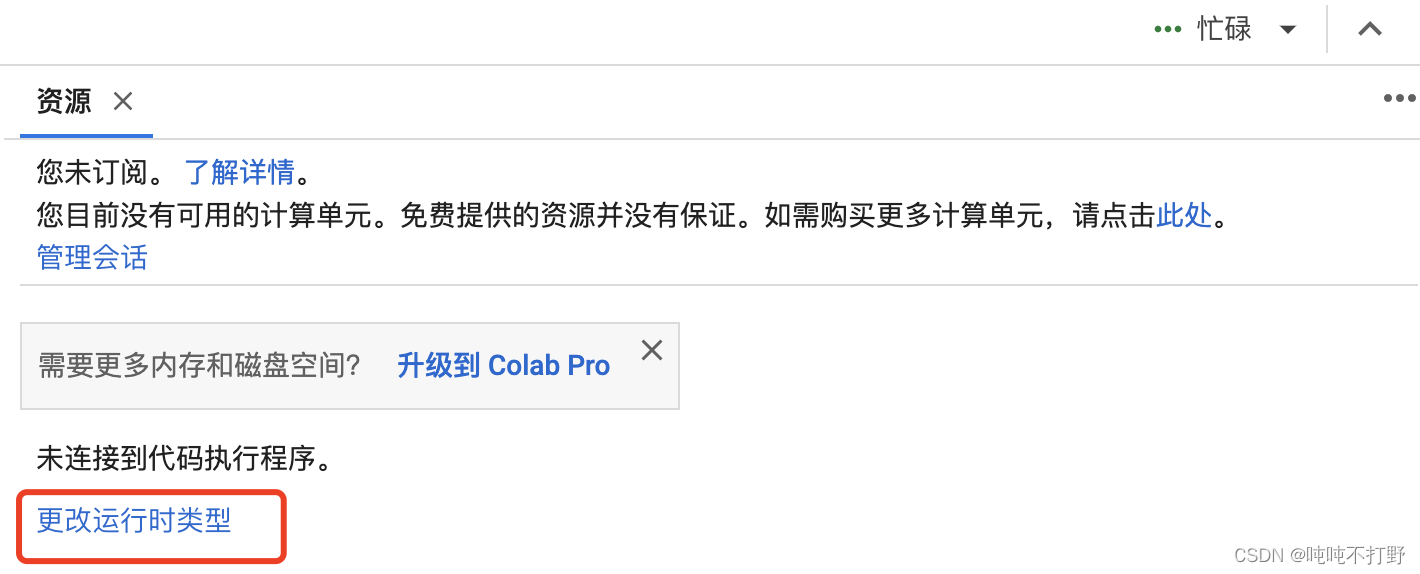

- 右上角有个资源显示,点击,选择

更改运行时类型

注意:

- 选择更改运行时类型后,之前程序运行的变量和文件都会被删除(jupyter文件不会删除,之前建立的和Google文件的关联,包括上传的文件,都会倍删除)。

- 所以一定要先选好运行时,再去进行剩下的操作。

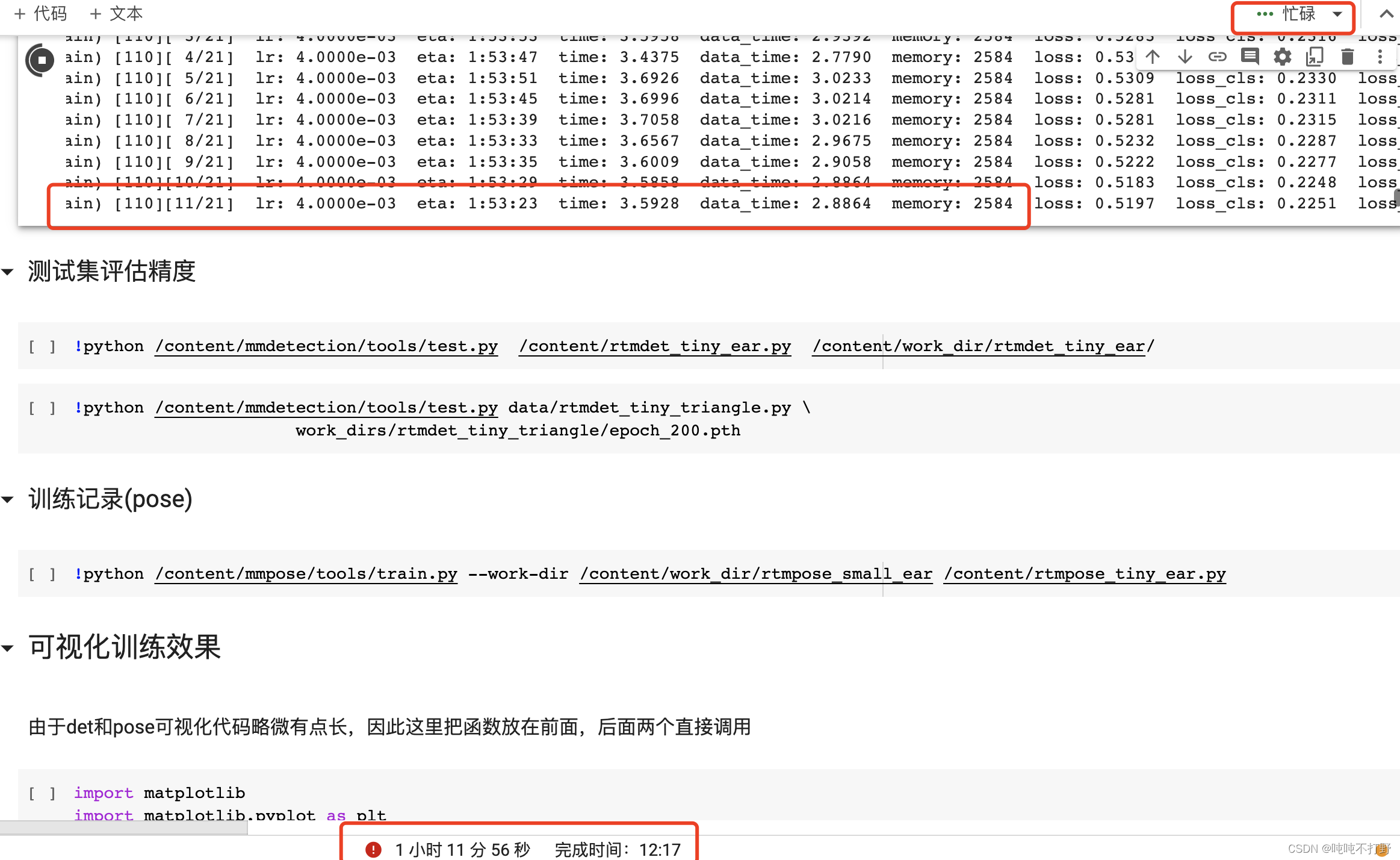

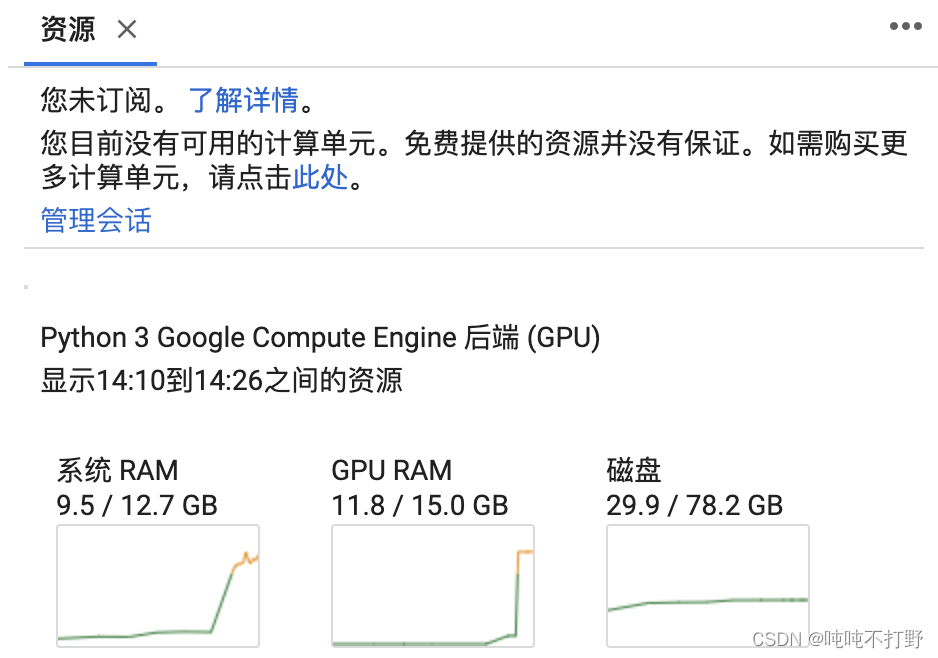

- 选好运行时之后,右上方会变成“正在初始化” “分配”之类的状态,分配完成后,能看到RAM及磁盘使用情况说明分配到资源了,如果显示“重新连接”或者“忙碌”状态,说明没有分到。。

- 但是我遇到了一开始有分配资源,能看到RAM等,但是跑了一段时间,变成忙碌了。。同时下面还显示红色叹号时间,但是训练还在继续(而且好像还是在GPU上训练的。)

1.3 关联Colab中的文件和Google云端硬盘的文件

由于Colab中的命令行是pro版本才可以使用的,所以想使用命令行只能在jupyter借助! cmd来实现

注意,先选好运行时,再进行文件的关联,不然去新的运行时之后,还要再重来一遍。

!pwd

> /content

# 说明当前默认的根目录是/content

from google.colab import drive

drive.mount('/content/drive')

# 可以理解成本机和镜像里文件对应的意思,即 Colab中的/content 对应Google云端硬盘的 /content/drive

# 这只是目录对应,但是如果想在Colab看到这个文件,需要建立关联(软连接)

!ln -s /content/drive/'My Drive'/OpenMMLab /content/OpenMMLab

#建立软连接后,就可以在Colab左侧看到这个文件夹了,在Colab中对/content/OpenMMLab中内容进行的操作,在Google中也可以看到

# 如果搞不清在Colab的路径,就

import os

print(os.getcwd())

另外,如果要解压文件的话,例如:

# 关联到content的直接目录下

!ln -s /content/drive/'My Drive'/Ear210_Dataset_coco.zip /content

# 解压要指定目录,用-d,如果不指定解压目录的话,你就找不到解压后的文件夹了。。

!unzip /content/Ear210_Dataset_coco.zip -d /content/

参考:stackoverflow.com-Extract Google Drive zip from Google colab notebook

2. Colab和MMPose

2.1 环境配置

# 查看当前版本,Colab的环境非常新,是py3.10+pytorch 2.0.1+cu118

!pip show torch

> Name: torch

Version: 2.0.1+cu118

Summary: Tensors and Dynamic neural networks in Python with strong GPU acceleration

Home-page: https://pytorch.org/

Author: PyTorch Team

Author-email: packages@pytorch.org

License: BSD-3

Location: /usr/local/lib/python3.10/dist-packages

Requires: filelock, jinja2, networkx, sympy, triton, typing-extensions

Required-by: fastai, torchaudio, torchdata, torchtext, torchvision, triton

环境太新,导致后面安装mmcv的时候找不到现成的wheel,需要从tar.gz编译,编译一直过不去,mmcv一直卡在:Building wheels for collected packages: mmcv。可以看看文档,后来使用编译还是会卡住。

参考:

- Installation takes forever #1386

- Colab stuck at Building wheels for collected packages: mmcv-full #6909

- mmcv Documentation-常见问题-安装问题,P65

所以对Colab中默认的torch版本降级,

"""

1. 降级pytorch

py3.10支持的torch版本,和参考链接里不太一样,自己可以根据提示支持的版本去调整。

"""

!pip3 install install torch==1.11.0+cu113 torchvision==0.12.0+cu113 torchaudio==0.11.0+cu113 -f https://download.pytorch.org/whl/cu113/torch_stable.html

"""

2.安装其他包

由于pycocotools这个包容易出问题,所以安装完可以再确认一下

"""

!pip install -U openmim

!mim install mmengine

!pip install opencv-python pillow matplotlib seaborn tqdm pycocotools -i https://pypi.tuna.tsinghua.edu.cn/simple

!pip show pycocotools #确认

"""

3. 安装OpenMMLab系列的包,用mim安装

"""

!mim install 'mmcv==2.0.0rc3'

!mim install "mmdet>=3.0.0rc6"

"""

4. 从git安装mmpose和mmdetection

"""

import os

print(os.getcwd()) # 随时查看自己的当前执行目录,不然可能就会安装到自己不希望的位置

> /content

#------1.mmpose--------

# 删掉原有的 mmpose 文件夹(如有)

!rm -rf mmpose

!git clone https://github.com/open-mmlab/mmpose.git -b tutorial2023

# 进入主目录

import os

os.chdir('mmpose')

print(os.getcwd())

!mim install -e .

!pip show mmpose # 验证

> Name: mmpose

Version: 1.0.0

Summary: OpenMMLab Pose Estimation Toolbox and Benchmark.

Home-page: https://github.com/open-mmlab/mmpose

#-------2. mmdetection------

#先切换目录

print(os.getcwd())

os.chdir('../')

print(os.getcwd())

>/content/mmpose

/content

# 删掉原有的 mmdetection 文件夹(如有)

!rm -rf mmdetection

# 从 github 上下载最新的 mmdetection 源代码

!git clone https://github.com/open-mmlab/mmdetection.git -b 3.x

# 进入主目录

os.chdir('mmdetection')

print(os.getcwd())

!pip install -v -e .

!pip show mmdet #验证

>Name: mmdet

Version: 3.0.0

Summary: OpenMMLab Detection Toolbox and Benchmark

Home-page: https://github.com/open-mmlab/mmdetection

#-----3. 检查环境---------

os.chdir('../') #切换会默认目录/content,为后续执行做准备

print(os.getcwd())

>/

# 检查 Pytorch

import torch, torchvision

print('Pytorch 版本', torch.__version__)

print('CUDA 是否可用',torch.cuda.is_available())

# 检查 mmcv

import mmcv

from mmcv.ops import get_compiling_cuda_version, get_compiler_version

print('MMCV版本', mmcv.__version__)

print('CUDA版本', get_compiling_cuda_version())

print('编译器版本', get_compiler_version())

> Pytorch 版本 1.11.0+cu113

CUDA 是否可用 True

MMCV版本 2.0.0

CUDA版本 11.3

编译器版本 GCC 9.3

参考:colab安装mmcv-full和mmclassification

2.2 配置文件修改

由于是初学,所以这里并不改什么网络结构,训练参数,只是改一下数据文件位置,保证这个程序能跑起来。

当前的目录结构:

|--content

|--Ear210_Keypoint_Dataset_coco

|--rtmdet_tiny_ear.py

|--mmpose

|--mmdetection

|--.exercise1.ipynb(其实应该还有个隐藏的exercise.ipynb文件,就是你当前执行所在的笔记本)

rtmdet_tiny_ear.py文件中的数据配置

# 数据集类型及路径

dataset_type = 'CocoDataset'

# 如果 rtmdet_tiny_ear.py和Ear210_Keypoint_Dataset_coco同级,可以直接

data_root = 'Ear210_Keypoint_Dataset_coco/' #主要是这个

# 否则 最好

data_root = '/content/Ear210_Keypoint_Dataset_coco/' #主要是这个

metainfo = {'classes': ('ear',)}

NUM_CLASSES = len(metainfo['classes'])

训练使用的命令:

# 为了防止找不到,所以都直接使用了一个绝对目录

!python /content/mmpose/tools/train.py --work-dir /content/work_dir/rtmpose_small_ear /content/rtmpose_tiny_ear.py

如果不在命令行指定,或在config中修改work_dir的话,

- 则默认就是在当前这个jupyter执行的同级目录下创建work_dir,

- 例如:

work_dir = './work_dirs/rtmdet_tiny_ear',都没有/content,所以默认会放在一个当前用户不可见的位置。

跑的时候可以看看,GPU利用率大概是多高,可以调调。

参考:

- ✅mmdetection-Train a model

- mmdetectionV2 + colab 超详细目标检测攻略,学生党入门必看

3. Colab相关知识

参考:Colaboratory-常见问题解答

1. 我的笔记本存储在什么地方?可以共享吗?

Colab 笔记本存储在 Google 云端硬盘上,也可以从 GitHub 加载。您可以共享 Colab 笔记本,就像使用 Google 文档或表格一样。只需点击任一 Colab 笔记本右上角的“共享”按钮,或按照相关 Google 云端硬盘文件共享说明操作。

2. Colab 中的笔记本可以运行多久?

Colab 会优先处理交互式计算。如果您的系统处于空闲状态,运行时将超时。

- 在免费版 Colab 中,笔记本最长可以运行 12 小时,具体取决于实际可用情况和您的使用模式。Colab Pro、Pro+ 和随用随付方案会基于您的计算单元余量为您提供更多可用的计算资源。

- 通常,笔记本最长可以运行 12 小时,具体取决于实际可用情况和您的使用模式。购买 Pro、Pro+ 或随用随付方案后,如果您的可用计算单元已用尽,那么代码执行可在后端终止。

如果您有足够的计算单元,Colab Pro+ 支持代码连续执行长达 24 小时。只有在代码执行终止后才会应用空闲超时。

所以最好设置当前页面一直是活跃状态,

- 参考使用Colab训练步骤(有点mmdetection内容),

- 但是把上面js代码放到浏览器的console报错了。

- 上面的那种设置已经无效了,新的可用的是:stackoverflow.com-How to keep the google colab running without disconnecting in 2022

在浏览器的开发者工具的控制台里,输入以下函数

var sw = function ConnectButton(){

console.log("Connect pushed");

document.querySelector("#top-toolbar > colab-connect-button").shadowRoot.querySelector("#connect").click()

}

setInterval(ConnectButton,60000);

# 如果要清除上面的触发器的话,可以。不用sw接也可以,默认function会返回一个数值,clear那个数值即可

clearInterval(sw)

但是好像用处不大???

参考:

- stackoverflow.com:Stop setInterval call in JavaScript