note

-

基础理论:大模型的基础理论是什么?

-

网络架构:Transformer是终极框架吗?

-

高效计算:如何使大模型更加高效?

-

高效适配:大模型如何适配到下游任务?

-

可控生成:如何实现大模型的可控生成?

-

安全可信:如何改善大模型中的安全伦理问题?

-

认知学习:如何使大模型获得高级认知能力?

-

创新应用:大模型有哪些创新应用?

-

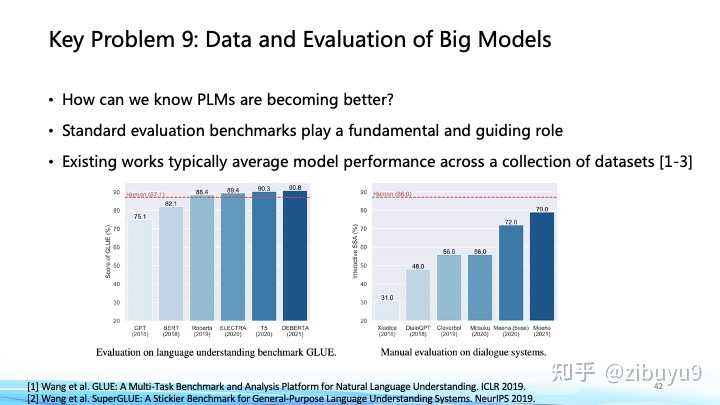

数据评价:如何评估大模型的性能?

-

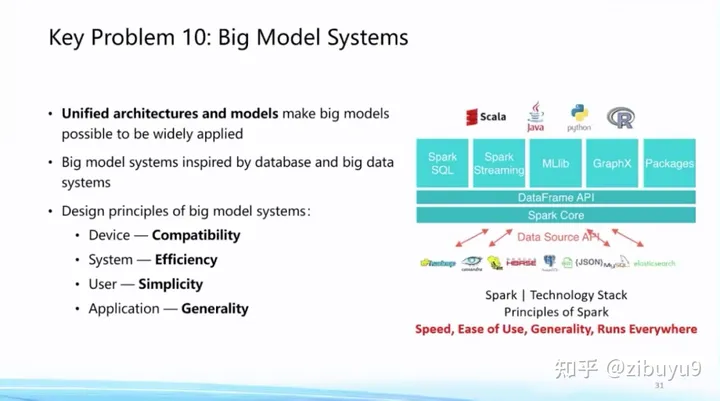

易用性:如何降低大模型的使用门槛?

文章目录

- note

- 方向一:大模型的基础理论问题

- 方向二:大模型的网络架构问题

- 方向三:大模型的高效计算问题

- 方向四:大模型的高效适配问题

- 方向五:大模型的可控生成问题

- 方向六:大模型的安全伦理问题

- 方向七:大模型的认知学习问题

- 方向八:大模型的创新应用问题

- 方向九:大模型的数据和评估问题

- 方向十:大模型的易用性问题

- Reference

读了清华刘致远老师zh上的回答后,简单做下这十个问题的总结,具体完整内容参考:https://www.zhihu.com/question/595298808/answer/3047369015。

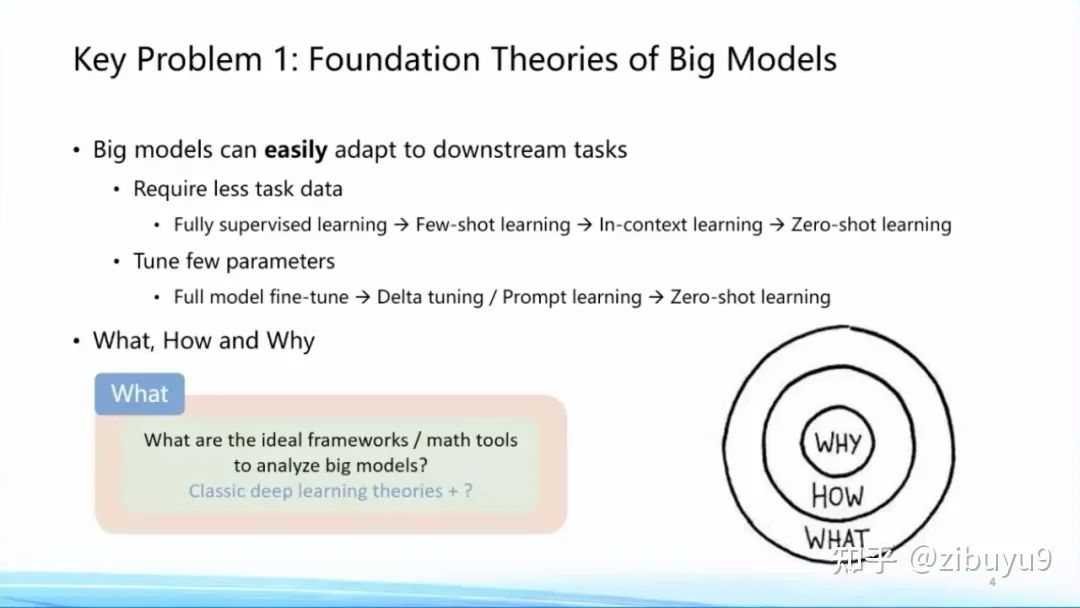

方向一:大模型的基础理论问题

随着全球大炼模型不断积累的丰富经验数据,人们发现大模型呈现出很多与以往统计学习模型、深度学习模型、甚至预训练小模型不同的特性:

- 如Few/Zero-Shot Learning、In-Context Learning、Chain-of-Thought能力;

- 已被学术界关注但还未被公众广泛关注的如Emergence、Scaling Prediction、Parameter-Efficient Learning(我们称为Delta Tuning)、稀疏激活和功能分区特性,等等。

- What——大模型学到了什么:参考论文[1]

- How—— 如何训好大模型:随着模型规模不断增大(Scaling)的过程,如何掌握训练大模型的规律 [2],其中包含众多问题,例如数据如何准备和组合,如何寻找最优训练配置,如何预知下游任务的性能,等等 [3]。这些是 How 的问题。

- Why——大模型为什么好:这方面已经有很多非常重要的研究理论[4,5,6],包括过参数化等理论,但终极理论框架的面纱仍然没有被揭开。

仓库 BMPrinciples [https://github.com/openbmb/BMPrinciples],收集和记录大模型发展过程中的现象。

参考文献:

[1] Wei et al. Emergent Abilities of Large Language Models. TMLR 2022.

[2] Kaplan et al. Scaling Laws for Neural Language Models. 2020

[3] OpenAI.GPT-4 technical report. 2023.

[4] Nakkiran et al. Deep double descent: Where bigger models and more data hurt. ICLR 2020.

[5] Bubeck et al. A universal law of robustness via isoperimetry. NeurIPS 2021.

[6] Aghajanyan et al. Intrinsic dimensionality explains the effectiveness of language model fine-tuning. ACL 2021.

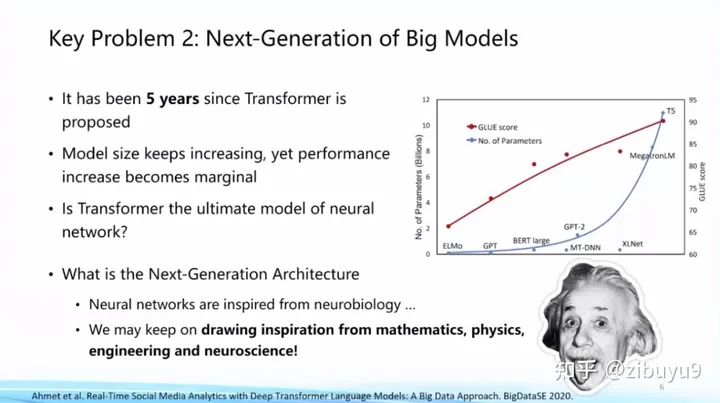

方向二:大模型的网络架构问题

能否找到比Transformer更好、更高效的网络框架。

有学者受到数学相关方向的启发,提出非欧空间Manifold网络框架,尝试将某些几何先验知识放入模型,这些都是最近比较新颖的研究方向。

参考文献:

[1] Chen et al. Fully Hyperbolic Neural Networks. ACL 2022.

[2] Gu et al. Efficiently Modeling Long Sequences with Structured State Spaces. ICLR 2022.

[3] Gu et al. Combining recurrent, convolutional, and continuous-time models with linear state space layers. NeurIPS 2021.

[4] Weinan, Ee. A proposal on machine learning via dynamical systems. Communications in Mathematics and Statistics.

[5] Maass, Wolfgang. Networks of spiking neurons: the third generation of neural network models. Neural networks.

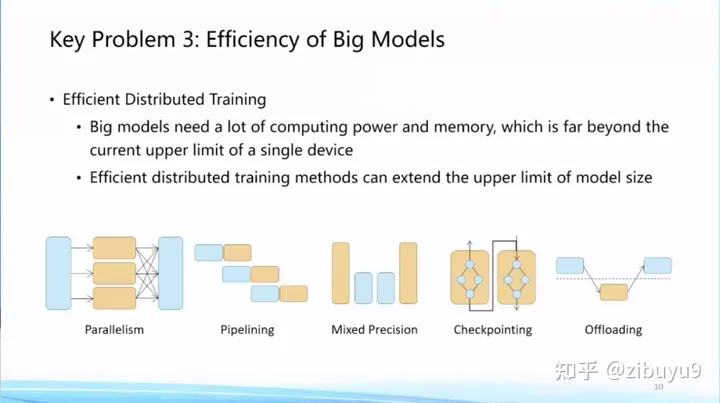

方向三:大模型的高效计算问题

需要建设更加高效的分布式训练算法体系,这方面很多高性能计算学者已经做了大量探索,例如,通过模型并行[9]、流水线并行[8]、ZeRO-3[1] 等模型并行策略将大模型参数分散到多张 GPU 中,通过张量卸载、优化器卸载等技术[2]将 GPU 的负担分摊到更廉价的 CPU 和内存上,通过重计算[7] 方法降低计算图的显存开销,通过混合精度训练[10]利用 Tensor Core 提速模型训练,基于自动调优算法 [11, 12] 选择分布式算子策略等 。

目前,模型加速领域已经建立了很多有影响力的开源工具,国际上比较有名的有微软DeepSpeed、英伟达Megatron-LM,国内比较有名的是OneFlow、ColossalAI等。而在这方面OpenBMB社区推出了BMTrain,能够将GPT-3规模大模型训练成本降低90%以上。

大模型一旦训练好准备投入使用,推理效率也成为重要问题,一种思路是将训练好的模型在尽可能不损失性能的情况下对模型进行压缩。这方面技术包括模型剪枝、知识蒸馏、参数量化等等。大模型呈现的稀疏激活现象也能够用来提高模型推理效率,基本思想是根据稀疏激活模式对神经元进行聚类分组,每次输入只调用非常少量的神经元模块即可完成计算,我们把这个算法称为MoEfication [5]。

参考文献:

[1] Samyam Rajbhandari et al. ZeRO: memory optimizations toward training trillion parameter models. SC 2020.

[2] Jie Ren et al. ZeRO-Offload: Democratizing Billion-Scale Model Training. USENIX ATC 2021.

[3] Dettmers et al. LLM.int8(): 8-bit Matrix Multiplication for Transformers at Scale. NeurIPS 2022.

[4] Zhang et al. BMCook: A Task-agnostic Compression Toolkit for Big Models. EMNLP 2022 Demo.

[5] MoEfication: Transformer Feed-forward Layers are Mixtures of Experts. Findings of ACL 2022.

[6] The Lazy Neuron Phenomenon: On Emergence of Activation Sparsity in Transformers. ICLR 2023.

[7] Training Deep Nets with Sublinear Memory Cost. 2016.

[8] Fast and Efficient Pipeline Parallel DNN Training. 2018.

[9] Megatron-lm: Training multi-billion parameter language models using model parallelism. 2019.

[10] Mixed Precision Training. 2017.

[11] Unity: Accelerating {DNN} Training Through Joint Optimization of Algebraic Transformations and Parallelization. OSDI 2022.

[12] Alpa: Automating Inter- and {Intra-Operator} Parallelism for Distributed Deep Learning. OSDI 2022.

方向四:大模型的高效适配问题

- 模型适配:对齐,更好应用于下有任务

- 方案一是提示学习(Prompt Learning),即从训练和下游任务的形式上入手,通过为输入添加提示(Prompts)[1,2,3] 来将各类下游任务转化为预训练中的语言模型任务,实现对不同下游任务以及预训练-下游任务之间形式的统一,从而提升模型适配的效率。实际上,现在流行的指令微调(Instruction Tuning)就是使用提示学习思想的具体案例。

- 方案二是参数高效微调(Parameter-effcient Tuning 或Delta Tuning)[4, 5, 6],基本思想是保持绝大部分的参数不变,只调整大模型里非常小的一组参数,这能够极大节约大模型适配的存储和计算成本,而且当基础模型规模较大(如十亿或百亿以上)时参数高效微调能够达到与全参数微调相当的效果。目前,参数高效微调还没有获得像提示微调那样广泛的关注,而实际上参数高效微调更反映大模型独有特性。

参考文献:

[1] Tom Brown et al. Language Models are Few-shot Learners. 2020.

[2] Timo Schick et al. Exploiting Cloze Questions for Few-Shot Text Classification and Natural Language Inference. EACL 2021.

[3] Tianyu Gao et al. Making Pre-trained Language Models Better Few-shot Learners. ACL 2021.

[4] Ning Ding et al. Parameter-efficient Fine-tuning for Large-scale Pre-trained Language Models. Nature Machine Intelligence.

[5] Neil Houlsby et al. Parameter-Efficient Transfer Learning for NLP. ICML 2020.

[6] Edward Hu et al. LoRA: Low-Rank Adaptation of Large Language Models. ICLR 2022.

[7] Ning Ding et al. OpenPrompt: An Open-Source Framework for Prompt-learning. ACL 2022 Demo.

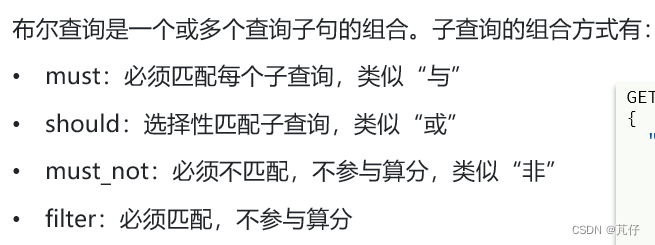

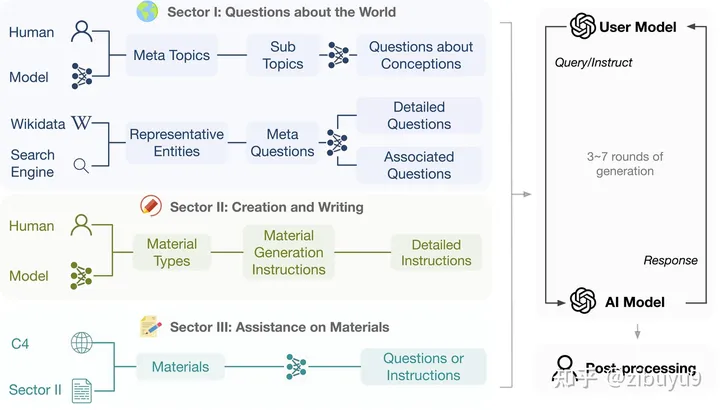

方向五:大模型的可控生成问题

在ChatGPT出现前,已经有很多可控生成的探索方案,例如利用提示学习中的提示词来控制生成过程。可控生成方面也长期存在一些开放性问题,例如如何建立统一的可控生成框架,如何建立科学客观的评测方法等等。

ChatGPT在可控生成方面取得了长足进步,现在可控生成有了相对成熟的做法:

- (1)通过指令微调(Instruction Tuning)[1, 2, 3] 提升大模型意图理解能力,使其可以准确理解人类输入并进行反馈;

- (2)通过提示工程编写合适的提示来激发模型输出。这种采用纯自然语言控制生成的做法取得了非常好的效果,对于一些复杂任务,我们还可以通过思维链(Chain-of-thought)[4] 等技术来控制模型的生成。

该技术方案的核心目标是让模型建立指令跟随(Instruction following)能力。最近研究发现,获得这项能力并不需要特别复杂的技术,只要收集足够多样化的指令数据进行微调即可获得不错的模型。这也是为什么最近涌现如此众多的定制开源模型。当然,如果要想达到更高的质量,可能还需要进行RLHF等操作。

参考文献:

[1] Jason Wei et al. Finetuned language models are zero-shot learners. ICLR 2022.

[2] Victor Sanh et al. Multitask Prompted Training Enables Zero-Shot Task Generalization. ICLR 2022.

[3] Srinivasan Iyer. OPT-IML: Scaling Language Model Instruction Meta Learning through the Lens of Generalization. Preprint 2022.

[4] Jason Wei et al. Chain of thought prompting elicits reasoning in large language models. NeurIPS 2022.

[5] Ning Ding et al. Enhancing Chat Language Models by Scaling High-quality Instructional Conversations. Preprint 2023.

方向六:大模型的安全伦理问题

大模型生成内容和相关应用也存在多种多样的伦理问题。例如,有人利用大模型生成假新闻怎么办?如何避免大模型产生偏见和歧视内容?学生用大模型来做作业怎么办?

在大模型伦理方面,如何实现大模型与人类价值观的对齐是重要的命题。此前研究表明模型越大会变得越有偏见[5],ChatGPT后兴起的RLHF、RLAIF等对齐算法可以很好地缓解这一问题,让大模型更符合人类偏好,生成质量更高。相比于预训练、指令微调等技术,基于反馈的对齐是很新颖的研究方向,其中强化学习也是有名的难以调教,有很多值得探讨的问题。

参考文献:

[1] Wang et al. On the Robustness of ChatGPT: An Adversarial and Out-of-distribution Perspective. Arxiv 2023.

[2] Ali Borji. A Categorical Archive of ChatGPT Failures. Arxiv 2023.

[3] https://openai.com/blog/governance-of-superintelligence

[4] Cui et al. A Unified Evaluation of Textual Backdoor Learning: Frameworks and Benchmarks. NeurIPS 2022 Datasets & Benchmarks.

[5] Lin et al. TruthfulQA: Measuring How Models Mimic Human Falsehoods. ACL 2022.

方向七:大模型的认知学习问题

ChatGPT Plugins的出现使其支持使用联网和数学计算等工具,被称为OpenAI的“App Store”时刻。工具学习必将成为大模型的重要探索方向,为了支持开源社区对大模型工具学习能力的探索,开发了工具学习引擎 BMTools [4],它是一个基于大语言模型的开源可扩展工具学习平台,将各种工具(如文生图模型、搜索引擎、股票查询等)的调用流程都统一在了同一个框架下,实现了工具调用流程的标准化和自动化。开发者可以通过BMTools,使用给定的大模型API(如ChatGPT、GPT-4)或开源模型调用各类工具接口完成任务。

此外,现有大部分努力都集中在单个预训练模型的能力提升上,而在单个大模型已经比较能打的基础上,未来将开启从单体智能到多体智能的飞跃,实现多模型间的交互、协同或竞争。例如,最近斯坦福大学构建了一个虚拟小镇,小镇中的人物由大模型扮演 [5],在大模型的加持下,不同角色在虚拟沙盒环境中可以很好地互动或协作,展现出了一定程度的社会属性。多模型的交互、协同与竞争将是未来极具潜力的研究方向。

参考文献:

[1] Qin, Yujia, et al. “Tool Learning with Foundation Models.” arXiv preprint arXiv:2304.08354 (2023).

[2] Nakano, Reiichiro, et al. “Webgpt: Browser-assisted question-answering with human feedback.” arXiv preprint arXiv:2112.09332 (2021).

[3] Qin, Yujia, et al. “WebCPM: Interactive Web Search for Chinese Long-form Question Answering.” arXiv preprint arXiv:2305.06849 (2023).

[4] BMTools: https://github.com/OpenBMB/BMTools

[5] Park, Joon Sung, et al. “Generative agents: Interactive simulacra of human behavior.” arXiv preprint arXiv:2304.03442 (2023).

[6] AgentVerse: https://github.com/OpenBMB/AgentVerse

方向八:大模型的创新应用问题

如在法律智能、生物医学展开了一些探索。例如,早在2021年与幂律智能联合推出了首个中文法律智能预训练模型 Lawformer,能够更好地处理法律领域的长篇文书;也提出了能够同时建模化学表达式和自然语言的统一预训练模型KV-PLM,在特定生物医学任务上能够超过人类专家,相关成果曾发表在《自然-通讯》(Nature Communications)上并入选编辑推荐专栏(Editor’s Highlights)。

参考文献:

[1] Zeng, Zheni, et al. A deep-learning system bridging molecule structure and biomedical text with comprehension comparable to human professionals. Nature communications 13.1 (2022): 862.

[2] Jumper, John, et al. Highly accurate protein structure prediction with AlphaFold. Nature 596.7873 (2021): 583-589.

[3] Assael, Yannis, et al. Restoring and attributing ancient texts using deep neural networks. Nature 603.7900 (2022): 280-283.

[4] Xiao, et al. Lawformer: A pre-trained language model for Chinese legal long documents. AI Open, 2021.

方向九:大模型的数据和评估问题

最近出现的大模型评价方式可以大致分为以下几类:

- 自动评价法:很多研究者提出了新的自动化评估方式,譬如通过选择题的形式[5],收集人类从小学到大学的考试题以及金融、法律等专业考试题目,让大模型直接阅读选项给出回答从而能够自动评测,这种方式比较适合评测大模型在知识储备、逻辑推理、语义理解等维度的能力。

- 模型评价法:也有研究者提出使用更加强大的大模型来做裁判[6]。譬如直接给GPT4等模型原始问题和两个模型的回答,通过编写提示词让GPT4扮演打分裁判,给两个模型的回答进行打分。这种方式会存在一些问题,譬如效果受限于裁判模型的能力,裁判模型会偏向于给某个位置的模型打高分等,但优势在于能够自动执行,不需要评测人员,对于模型能力的评判可以提供一定程度的参考。

- 人工评价法:人工评测是目前来看更加可信的方法,然而因为生成内容的多样性,如何设计合理的评价体系、对齐不同知识水平的标注人员的认知也成为了新的问题。目前国内外研究机构都推出了大模型能力的“竞技场”,要求用户对于相同问题不同模型的回答给出盲评。这里面也有很多有意思的问题,譬如在评测过程中,是否可以设计自动化的指标给标注人员提供辅助?一个问题的回答是否可以从不同的维度给出打分?如何从网络众测员中选出相对比较靠谱的答案?这些问题都值得实践与探索。

参考文献:

[1] OpenAI. GPT-4 Technical Report. 2023.

[2] Driess D, Xia F, Sajjadi M S M, et al. PaLM-E: An embodied multimodal language model[J]. arXiv preprint arXiv:2303.03378, 2023.

[3] Zhang A, Fei H, Yao Y, et al. Transfer Visual Prompt Generator across LLMs[J]. arXiv preprint arXiv:2305.01278, 2023.

[4] Yao Y, Dong Q, Guan J, et al. Cuge: A chinese language understanding and generation evaluation benchmark[J]. arXiv preprint arXiv:2112.13610, 2021.

[5] Chiang, Wei-Lin et al. Vicuna: An Open-Source Chatbot Impressing GPT-4 with 90%* ChatGPT Quality. 2023.

[6] Huang, Yuzhen et al. C-Eval: A Multi-Level Multi-Discipline Chinese Evaluation Suite for Foundation Models. arXiv preprint arXiv:2305.08322, 2023.

方向十:大模型的易用性问题

OpenBMB开源社区,全称Open Lab for Big Model Base,陆续发布了一套覆盖训练、微调、压缩、推理、应用的全流程高效计算工具体系,目前包括 高效训练工具 BMTrain、高效压缩工具 BMCook、低成本推理工具 BMInf、工具学习引擎 BMTools,等等。

Reference

[1] 刘知远:大模型值得探索的十个研究方向