1. 解决了什么问题?

3D 视觉感知任务,包括基于多相机图像的 3D 目标检测和分割,对于自动驾驶系统非常重要。与基于 LiDAR 的方法相比,基于相机图像的方法能够检测到更远距离的目标,识别交通信号灯、交通标识等信息。有一些方法使用单目画面,然后进行跨相机的后处理操作;这类方法的缺点就是各图像是分开处理的,无法取得跨相机的画面信息,因而效果和效率都比较差。

与单目方法相比,BEV 是表示周围环境的常用方法,它能清晰呈现目标的位置和大小,适合自动驾驶感知和规划任务。但现有的基于 BEV 的检测方法所提供的 BEV 特征要么不够鲁棒,无法准确地预测 3D 目标;要么深度信息不够准确。

人类视觉系统会通过时间信息推理出目标的运动状态与被遮挡物体,但现有的方法很少考虑时间信息。在驾驶过程中,目标移动速度很快,直接使用各时间戳的 BEV 特征,会增加计算成本与干扰信息,因此不是最佳的。

2. 提出了什么方法?

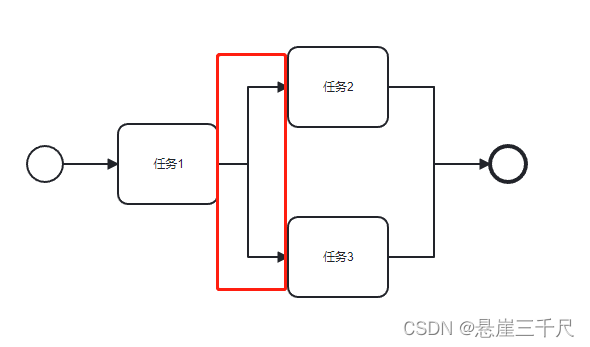

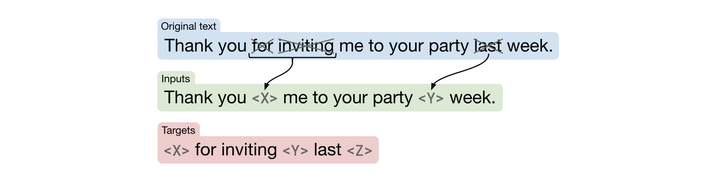

本文提出了 BEVFormer,一个基于 transformer 的 BEV encoder,通过预先定义的网格状 BEV queries 实现信息在时间和空间内的交互。BEVFormer 包括三个部分:

- 网格形状的 BEV queries,通过注意力机制灵活地融合空间和时间特征;

- 空间 cross-attention 模块,从多个相机画面聚合空间特征;

- 时间 self-attention 模块,从历史 BEV 特征提取时间信息,有助于预测运动物体的速度以及被遮挡的目标。

2.1 整体架构

如上图,BEVFormer 包括 6 个标准的 encoder 层,以及 3 项特殊设计,即 BEV queries、空间 cross-attention 和时间 self-attention。BEV queries 是网格形状的可学习参数,在 BEV 空间内,对多相机的画面利用注意力机制 query 特征。

推理时,在时间戳 t t t,将多相机画面输入进主干网络 ResNet,获取不同相机画面的特征 F t = { F t i } i = 1 N v i e w F_t=\lbrace F_t^i \rbrace_{i=1}^{N_{view}} Ft={Fti}i=1Nview, F t i F_t^i Fti是第 t t t时刻、第 i i i个相机画面的特征, N v i e w N_{view} Nview是画面的个数。保留时间戳 t − 1 t-1 t−1的 BEV 特征 B t − 1 B_{t-1} Bt−1。在每个 encoder 层,首先使用 BEV queries Q Q Q,通过时间 self-attention 对 BEV 特征 B t − 1 B_{t-1} Bt−1查询时域信息。然后通过空间 cross-attention 使用 Q Q Q来查询多相机特征 F t F_t Ft的空间信息。在 FFN 后,encoder 层输出优化后的 BEV 特征,作为下一个 encoder 层的输入。一共经过 6 个 encoder 层,就得到了时间戳 t t t的 BEV 特征 B t B_t Bt。接下来,使用 B t B_t Bt进行后续的 3D 检测和语义分割任务。

2.2 BEV Queries

定义一组网格状的可学习参数 Q ∈ R H × W × C Q\in \mathbb{R}^{H\times W\times C} Q∈RH×W×C,作为 BEVFormer 的 queries,其中 H , W H,W H,W是 BEV 平面的高度和宽度。Query Q p ∈ R 1 × C Q_p\in \mathbb{R}^{1\times C} Qp∈R1×C位于 p = ( x , y ) p=(x,y) p=(x,y),负责 BEV 平面的相应的格子。BEV 平面上的每个网格都对应着真实世界的 s s s米长度。BEV 特征的中心对应着车辆自身(ego)的位置。在输入 BEVFormer 前,在 queries Q Q Q中加入可学习的 positional encoding。

2.3 Spatial Cross-Attention

因为多相机 3D 感知的输入尺度太大,原始的 multi-head attention 的计算成本就过高。因此,作者基于 deformable attention 设计了空间 cross-attention,每个 BEV query

Q

Q

Q只和相机画面内的兴趣区域(RoI)发生作用。

如上图(b),将 BEV 平面的每个 query 变为 pillar-like query,从该 pillar 中采样

N

r

e

f

N_{ref}

Nref个 3D reference points,然后再将这些点映射到 2D 画面。对于一个 BEV query,映射的 2D 点只会落到某些画面里面,这些画面叫做

V

h

i

t

\mathcal{V}_{hit}

Vhit。将这些 2D 点看作为 query

Q

p

Q_p

Qp的 reference points,然后从

V

h

i

t

\mathcal{V}_{hit}

Vhit画面中提取这些 reference points 的特征。最后,计算这些采样特征的加权和,作为空间 cross-attention 的输出。SCA 计算如下:

SCA

(

Q

p

,

F

t

)

=

1

∣

V

h

i

t

∣

∑

i

∈

V

h

i

t

∑

j

=

1

N

r

e

f

DeformAttn

(

Q

p

,

P

(

p

,

i

,

j

)

,

F

t

i

)

\text{SCA}(Q_p, F_t)=\frac{1}{\left| \mathcal{V}_{hit}\right|}\sum_{i\in \mathcal{V}_{hit}}\sum_{j=1}^{N_{ref}}\text{DeformAttn}(Q_p, \mathcal{P}(p,i,j),F_t^i)

SCA(Qp,Ft)=∣Vhit∣1i∈Vhit∑j=1∑NrefDeformAttn(Qp,P(p,i,j),Fti)

其中 i i i是相机画面索引, j j j是 reference point 的索引, N r e f N_{ref} Nref是每个 BEV query pillar 中 reference points 的个数。 F t i F_t^i Fti是第 i i i个相机画面的特征。对于每个 BEV query Q p Q_p Qp,使用一个映射函数 P ( p , i , j ) \mathcal{P}(p,i,j) P(p,i,j)获取第 i i i个画面上 p = ( x , y ) p=(x,y) p=(x,y)位置的第 j j j个 reference point。

接下来,介绍如何使用映射函数 P \mathcal{P} P从图像上获取 reference point。首先计算 p = ( x , y ) p=(x,y) p=(x,y)位置上 Q p Q_p Qp对应的真实世界的坐标 ( x ′ , y ′ ) (x',y') (x′,y′):

x ′ = ( x − W 2 ) × s ; y ′ = ( y − H 2 ) × s x'=(x-\frac{W}{2})\times s;\quad\quad y'=(y-\frac{H}{2})\times s x′=(x−2W)×s;y′=(y−2H)×s

这里

H

,

W

H,W

H,W是 BEV queries 空间的高度和宽度,

s

s

s是 BEV 网格的大小,

(

x

′

,

y

′

)

(x',y')

(x′,y′)是坐标位置。在 3D 空间,

(

x

′

,

y

′

)

(x',y')

(x′,y′)处的目标可能出现在

z

′

z'

z′高度。因此,作者预先定义了一组 anchor heights

{

z

j

′

}

j

=

1

N

r

e

f

\lbrace z'_j \rbrace_{j=1}^{N_{ref}}

{zj′}j=1Nref,确保我们可以获取不同高度的信息。这样,对于每个 query

Q

p

Q_p

Qp,得到一个柱状的 3D reference points

(

x

′

,

y

′

,

z

j

′

)

j

=

1

N

r

e

f

(x',y',z'_j)_{j=1}^{N_{ref}}

(x′,y′,zj′)j=1Nref。最后,通过相机参数矩阵,将 3D reference points 映射到不同的相机画面中:

P

(

p

,

i

,

j

)

=

(

x

i

j

,

y

i

j

)

\mathcal{P}(p,i,j)=(x_{ij}, y_{ij})

P(p,i,j)=(xij,yij)

where

z

i

j

⋅

[

x

i

j

y

i

j

1

]

T

=

T

i

⋅

[

x

′

y

′

z

j

′

1

]

T

.

\text{where}\quad z_{ij}\cdot \left[ x_{ij}\quad y_{ij}\quad 1 \right]^T = T_i \cdot \left[ x' \quad y'\quad z'_j\quad 1 \right]^T.

wherezij⋅[xijyij1]T=Ti⋅[x′y′zj′1]T.

其中, P ( p , i , j ) \mathcal{P}(p,i,j) P(p,i,j)是第 j j j个 3D reference point ( x ′ , y ′ , z j ′ ) (x',y',z'_j) (x′,y′,zj′)映射到第 i i i个画面的 2D 点。 T i ∈ R 3 × 4 T_i\in \mathbb{R}^{3\times 4} Ti∈R3×4是第 i i i个相机的参数矩阵。

2.4 Temporal Self-Attention

时间信息对于视觉系统也非常重要,有助于预测运动物体的速度,或者检测遮挡物体。于是,作者设计了 temporal self-attention,融合历史 BEV 特征来表征当前的环境。

给定时间戳 t t t的 BEV queries Q Q Q和 t − 1 t-1 t−1时间戳的历史 BEV 特征 B t − 1 B_{t-1} Bt−1。首先基于车辆自身的运动,将 B t − 1 B_{t-1} Bt−1与 Q Q Q对齐,保证同一网格内的特征对应着同一个真实的世界坐标。将对齐后的历史 BEV 特征 B t − 1 B_{t-1} Bt−1记为 B t − 1 ′ B'_{t-1} Bt−1′。但是从 t − 1 t-1 t−1到 t t t,真实世界的目标运动偏移是各不相同的。因此,作者通过 TSA 层对特征间的时间关系建模:

TSA ( Q p , { Q , B t − 1 ′ } ) = ∑ V ∈ { Q , B t − 1 ′ } DeformAttn ( Q p , p , V ) \text{TSA}(Q_p, \lbrace Q,B'_{t-1} \rbrace)=\sum_{V\in\lbrace Q,B'_{t-1} \rbrace}\text{DeformAttn}(Q_p, p, V) TSA(Qp,{Q,Bt−1′})=V∈{Q,Bt−1′}∑DeformAttn(Qp,p,V)

Q p Q_p Qp表示 p = ( x , y ) p=(x,y) p=(x,y)处的 BEV query。$\lbrace Q,B’{t-1}\rbrace 是将 是将 是将Q 和 和 和B’{t-1} c o n c a t 起来,预测 T S A D e f o r m A t t n 的偏移量 concat 起来,预测 TSA DeformAttn 的偏移量 concat起来,预测TSADeformAttn的偏移量\Delta p$。对于每个序列中的第一个样本,TSA 会退化为一个不带时间信息的 self-attention,用 BEV queries { Q , Q } \lbrace Q,Q \rbrace {Q,Q}代替 { Q , B t − 1 ′ } \lbrace Q,B'_{t-1} \rbrace {Q,Bt−1′}。

2.5 实验

2.5.1 Training

对于时间戳 t t t的样本,从过去 2 秒的连续帧中另外选取 3 个样本,这个随机采样策略能增强车辆自身运动的多样性。将这4个样本的时间戳分别记做 t − 3 , t − 2 , t − 1 t-3,t-2,t-1 t−3,t−2,t−1和 t t t。前 3 个时间戳负责递归地产生 BEV 特征 { B t − 3 , B t − 2 , B t − 1 } \lbrace B_{t-3},B_{t-2},B_{t-1} \rbrace {Bt−3,Bt−2,Bt−1}。对于 t − 3 t-3 t−3时间戳的初始样本,TSA 会退化为 self-attention。在 t t t时刻,模型基于多相机输入和 B t − 1 B_{t-1} Bt−1,产生 BEV 特征 B t B_t Bt,这样 B t B_t Bt就包含了横跨 4 个样本的时间和空间信息。最后将 B t B_t Bt输入进检测和分割 heads,计算相应的损失。

2.5.2 Inference

推理时,按时间顺序在视频的每一帧上做预测。保留前一时间戳的 BEV 特征在后面使用,这个在线推理策略节约了大量时间。

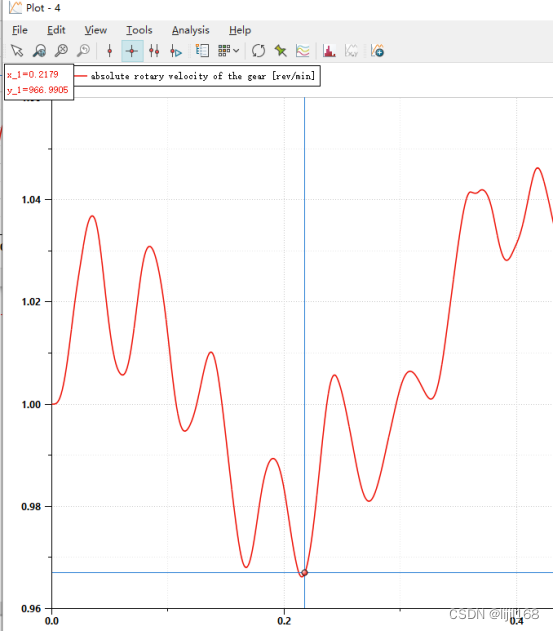

从下图可看出,BEVFormer 能够检测出高度遮挡的目标。

#3. 有什么优点?

在 nuScenes test 数据集上,取得了

56.9

%

56.9\%

56.9%的 NDS,与基于 LiDAR 的方法相近。BEVFormer 能够显著提高速度的预测准确率和低可见度情况下的目标召回率。

![[CTF/网络安全] 攻防世界 command_execution 解题详析](https://img-blog.csdnimg.cn/0f3d2a3d813a48318d09c20a07995b56.png#pic_center)