bootstrap:是一种统计方法,也是一种思想,简单说就是在所有样本集中进行有放回地抽样,抽取n个样本。如果不清楚样本的分布,bootstrap是一种合适的方法。

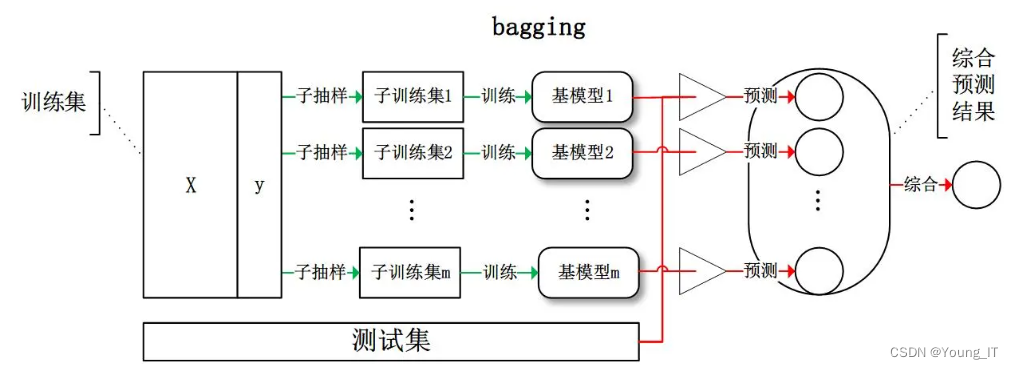

bagging:Bagging方法在训练过程中,各基分 类器之间无强依赖,可以进行并行训练。其中很著名的算法之一是基于决策树基 分类器的随机森林(Random Forest)。为了让基分类器之间互相独立,将训练集 分为若干子集(当训练样本数量较少时,子集之间可能有交叠)。Bagging方法更 像是一个集体决策的过程,每个个体都进行单独学习,学习的内容可以相同,也 可以不同,也可以部分重叠。但由于个体之间存在差异性,最终做出的判断不会 完全一致。在最终做决策时,每个个体单独作出判断,再通过投票的方式做出最 后的集体决策

boosting:Boosting方法训练基分类器时采用串行的方式,各个基分类器之间有依赖。 它的基本思路是将基分类器层层叠加,每一层在训练的时候,对前一层基分类器分错的样本,给予更高的权重。测试时,根据各层分类器的结果的加权得到 最终结果。

Bagging代表算法-RF(随机森林)

RF:Random Forest

其中的Random就是指

1.训练样本选择方面的Random:

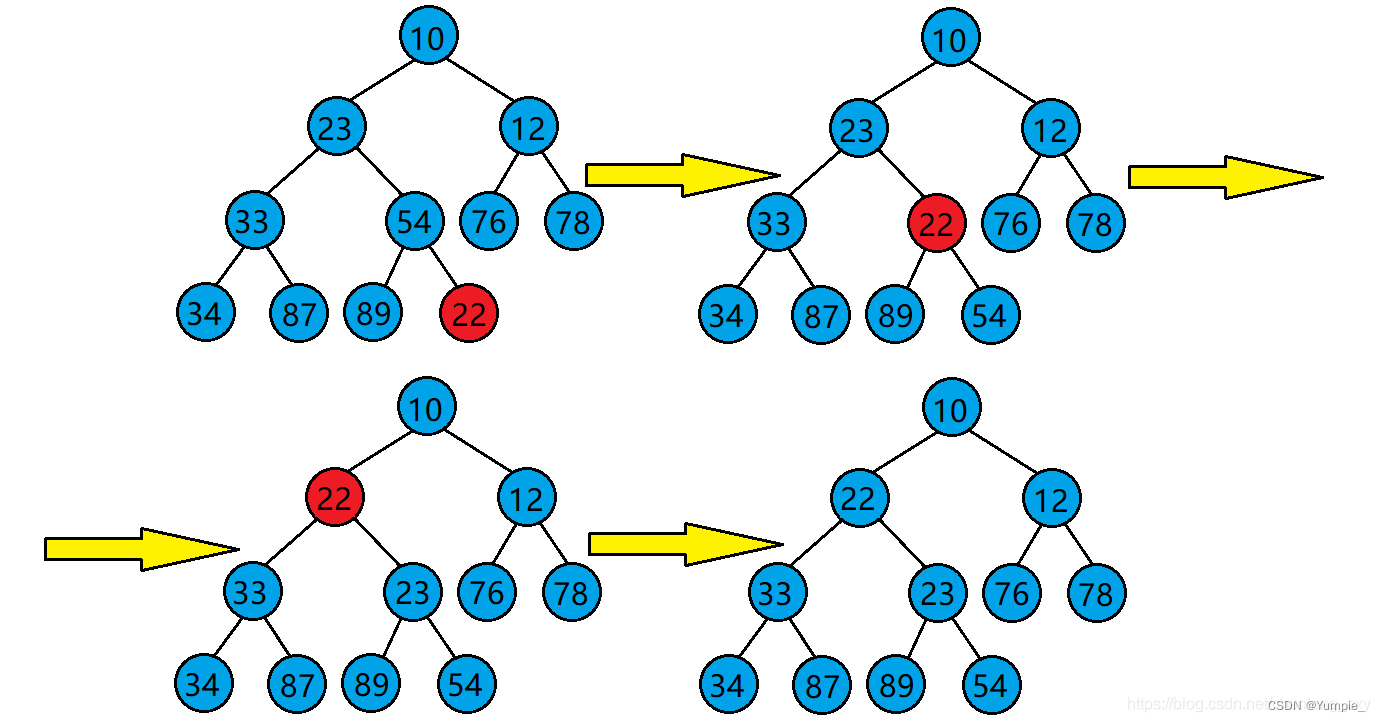

Bootstrap方法随机选择子样本

2.特征选择方面的Random:

属性集中随机选择k个属性,每个树节点分裂时,从这随机的k个属性,选择最优的(如何选择最优又有各种最大增益的方法,不在本文讨论范围内)。

流程

1.用Bootstrap方法的方式构造一棵决策树。

2.用1的方法构造很多决策树,每棵决策树都最大可能地进行生长而不进行剪枝,许多决策树构成一片森林,决策树之间没有联系

3.测试数据进入每一棵决策树,每棵树做出自己的判断,然后进行投票选出最终所属类别(默认每棵树权重一致)

部分图文来自:总结:Bootstrap(自助法),Bagging,Boosting(提升) - 简书

![[网鼎杯 2020 青龙组]jocker 题解](https://img-blog.csdnimg.cn/cecf98eac1cf43a0a4ce46c9f41af6a1.png)