学习像素级膨胀滤波的高效率单图像去噪

- 1 Introduction

- 3 Methodology

- 3.1 逐像素图像滤波解调

- 3.2 可学习像素级膨胀滤波

- Kernel prediction network(核预测网络)

- Multi-dilated image filtering and fusion(多扩张图像滤波与融合)

- 3.3 RainMix:真实世界与合成数据的桥梁

- 4 Experiments

- 4.1 Setups

- 4.2 Rain100H&1400数据集对比

- 4.3 真实SPA雨数据集对比

- 4.4 真实雨滴数据集比较

- 4.5 消融研究

- 5 Conclusions

1 Introduction

现有的方法往往对雨模型做了具体的假设,难以涵盖现实世界中多种多样的情况,必须采用复杂的优化或逐步细化,然而,对于许多效率关键的应用来说,这严重影响了这些方法的效率和有效性。

为了填补这一空白,在本文中,我们将单图像的解题视为一般的图像增强问题,并最初提出了一种无模型的解题方法,即EfficientDeRain。它能够在10毫秒(即平均约6毫秒)内处理下雨的图像,比最先进的方法(即RCDNet)快80多倍,同时实现类似的去雨效果。

我们首先提出了一种新的像素级膨胀滤波方法,该方法利用核预测网络中像素级的核对雨天图像进行滤波,从而有效地预测出每个像素对应的多尺度核。

然后,为了消除合成数据与真实数据之间的差距,我们进一步提出了一种有效的数据增强方法(即RainMix),该方法有助于训练网络进行真实雨图像处理。我们对合成和真实的雨数据集进行了综合评估,以证明我们的方法的有效性和效率。

我们在[https:// github.com/tsingqguo/efficientderain.git](https:// github.com/tsingqguo/efficientderain.git)中发布了EfficientDeRain。

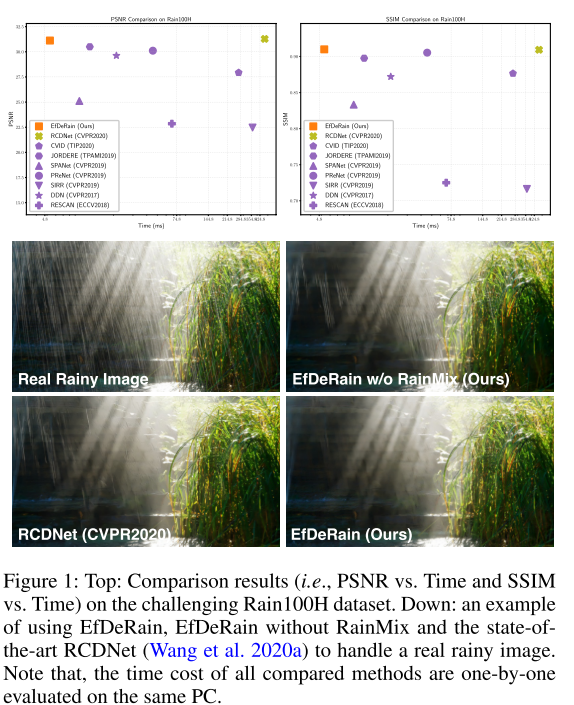

图1:

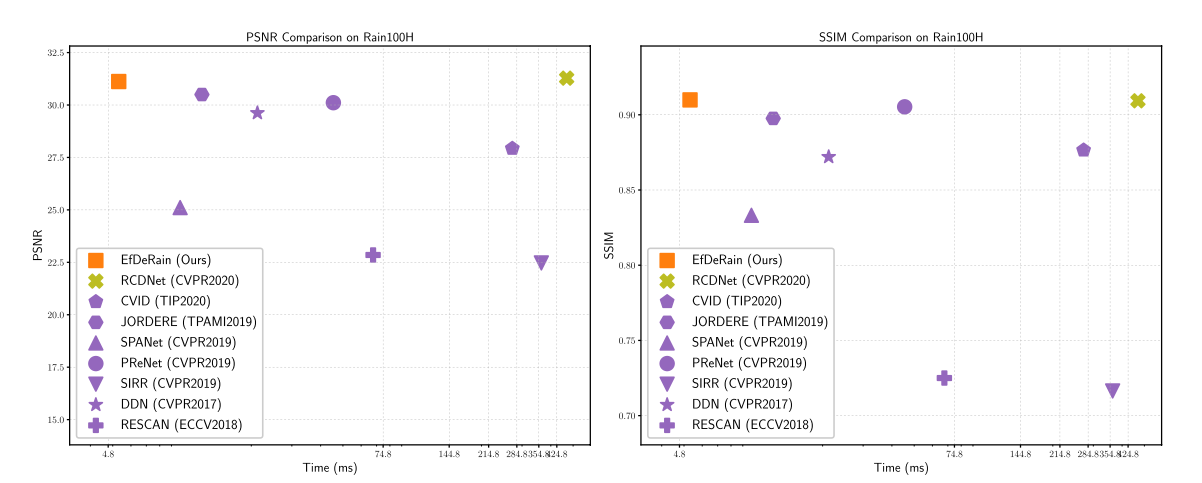

顶部:具有挑战性的Rain100H数据集上的比较结果(即PSNR vs. Time和SSIM vs. Time)。

下部:一个使用EfDeRain的例子,不使用RainMix的EfDeRain和最先进的RCDNet (Wang et al. 2020a)来处理真实的雨天图像。请注意,所有比较方法的时间成本都是在同一台电脑上逐一计算的。

我们在合成和真实的雨数据集上展示了我们的方法的优势,实现了高性能和高效率的脱除。如图1所示,我们的方法(即EfDeRain)运行速度大约比最先进的方法RCDNet (Wang et al. 2020a)快88倍,PSNR和SSIM性能相似。此外,在配备了RainMix后,EfDeRain可以在真实的雨天图像上取得比RCDNet更好的可视化效果。

3 Methodology

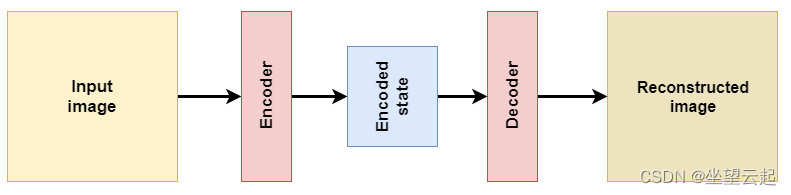

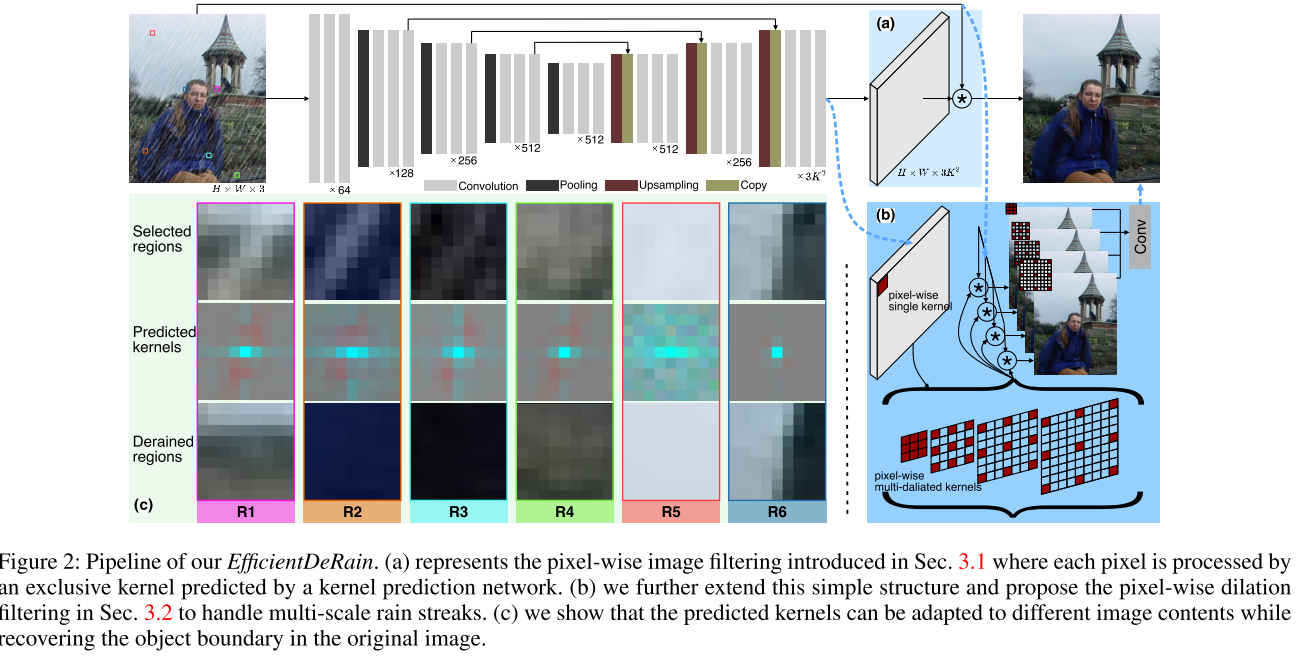

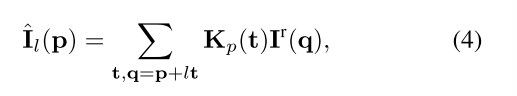

3.1 逐像素图像滤波解调

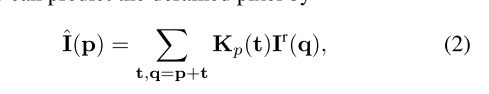

在本部分中,我们提出了一种基于图像滤波的无模型解推理方法。一般来说,雨可以被认为是一种退化,可能会导致遮挡、雾、运动模糊等效果。因此,采用图像滤波方法对其进行处理是合理的,可以有效地解决各种退化问题。具体来说,我们通过像素级滤波器处理输入的雨天图像Ir∈RH×W 1

其中ˆI∈RH×W是估计得到的图像,o表示逐像素滤波操作,每个像素都由它的独占核处理,K∈RH×W×K2包含所有像素的核。具体来说,在对Ir的第p个像素进行解算时,我们有它的专属核,即k的第p个位置的向量,对其进行整形,记为Kp∈RK×K。我们用p作为像素的2D坐标。然后,我们可以预测出被去除的像素 其中t的取值范围为(−K−1 2,−K−1 2)~ (K−1 2,K−1 2)。

其中t的取值范围为(−K−1 2,−K−1 2)~ (K−1 2,K−1 2)。

接下来思考两个问题:

①如何有效、高效地估计空间变量、尺度变量和语义感知内核。

②如何训练一个强大的脱轨DNN,用合成数据来弥补与真实去雨的差距。

解答:

①多膨胀核预测网络,3.2节。

②简单而有效的增雨方法,记作RainMix,3.3节。

3.2 可学习像素级膨胀滤波

Kernel prediction network(核预测网络)

我们建议以下雨的图像作为输入,估计用于脱除的像素级核K

其中KPN(·)表示类unet网络,其结构如图2所示。

Multi-dilated image filtering and fusion(多扩张图像滤波与融合)

为了使我们的方法能够在不损害效率的情况下处理多尺度的降雨条纹,我们通过扩张卷积的思想将每个预测核扩展到三个尺度(Yu and Koltun 2016)。

对于卷积层,我们建议将式1中的像素级滤波扩展到像素级膨胀滤波(Yu and Koltun 2016)

式中l为控制同一滤波器适用范围的膨胀系数。在实际应用中,我们考虑了4个量表,即l = 1,2,3,4。通过Eq. 4,我们可以得到四张解析图像,ˆI1,ˆI2,ˆI3,ˆI4。然后,我们使用大小为3 × 3的卷积层对这四幅图像进行融合,得到最终的输出。

3.3 RainMix:真实世界与合成数据的桥梁

我们在算法1中展示了基于rainmix的学习算法。

4 Experiments

4.1 Setups

**数据集。**为了全面验证和评价我们的方法,我们对4个流行的数据集进行了比较和分析实验,包括Rain100H (Yang et al. 2017, 2019)、Rain1400 (Fu et al. 2017)合成数据集、最近提出的SPA真实降雨数据集(Wang et al. 2019)和真实Raindrop数据集(Qian et al. 2018)。

**度量。**我们采用常用的峰值信噪比(PSNR)和结构相似度(SSIM)作为所有数据集的定量评价指标。一般来说,PSNR和SSIM越大,脱模效果越好。

Baselines。9+5 共14个去雨方法。需要注意的是,所有比较方法的时间成本都是在同一台PC上,使用Intel Xeon CPU (E5-1650)和NVIDIA Quadro P6000 GPU逐一计算的。

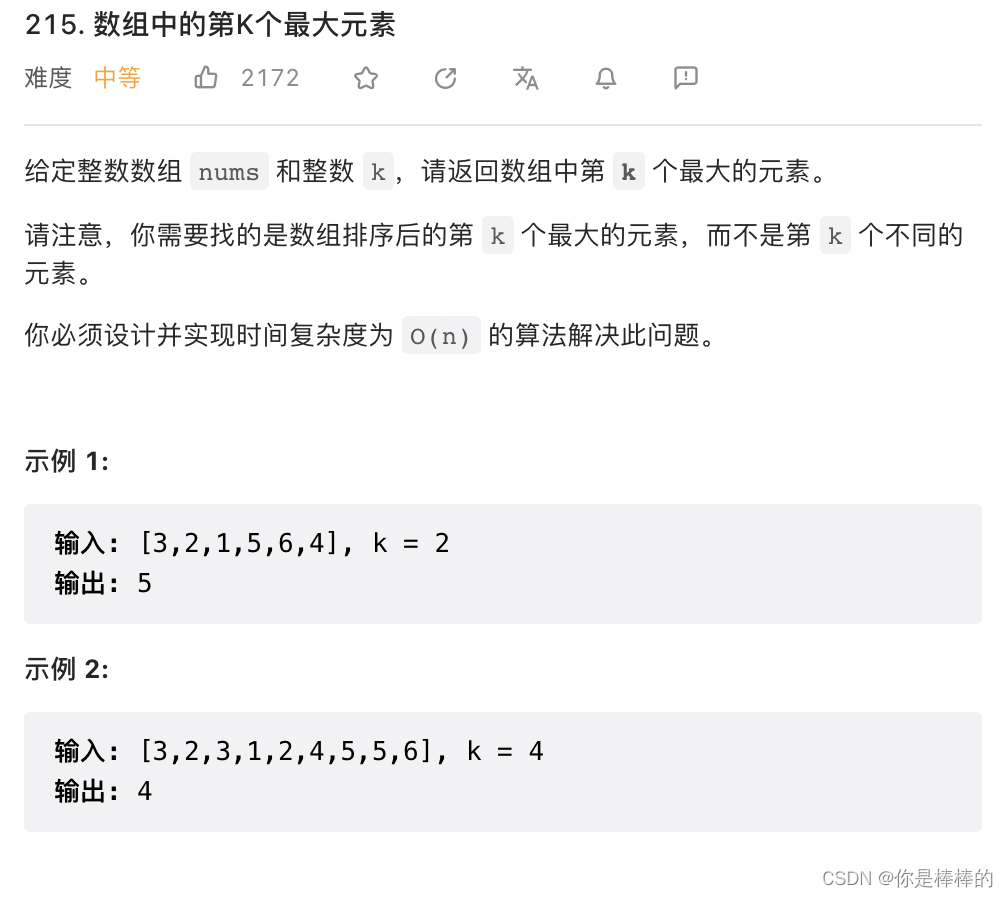

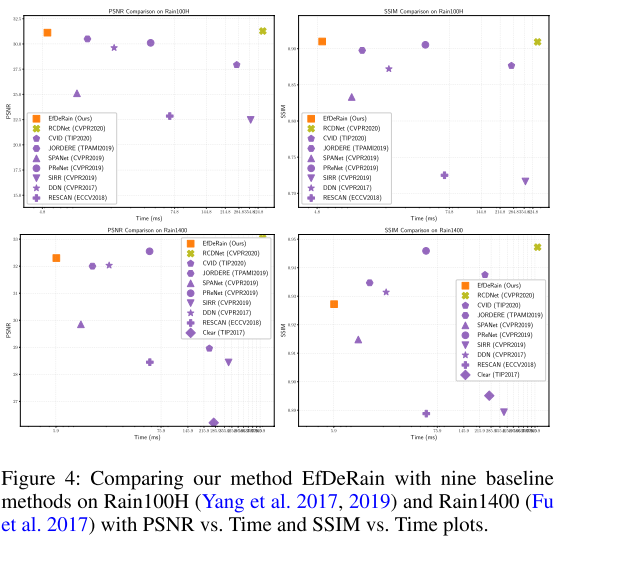

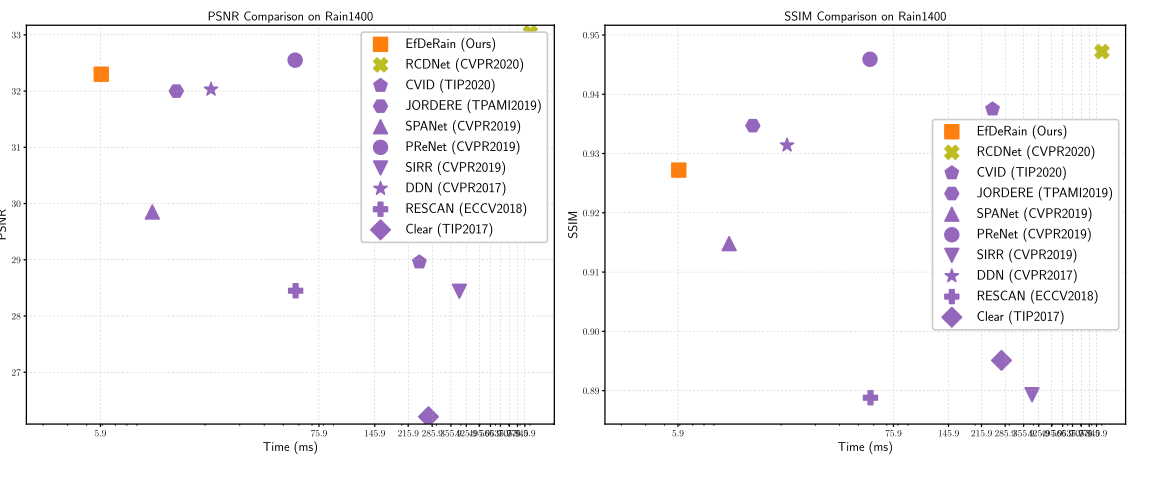

4.2 Rain100H&1400数据集对比

在Rain100H和Rain1400数据集上,我们将我们的方法与图4中的9个基线方法进行了比较。一般来说,我们的方法,即EfDeRain,在两个数据集上使用顶级方法获得可比的PSNR或SSIM时,获得了最低的时间成本。

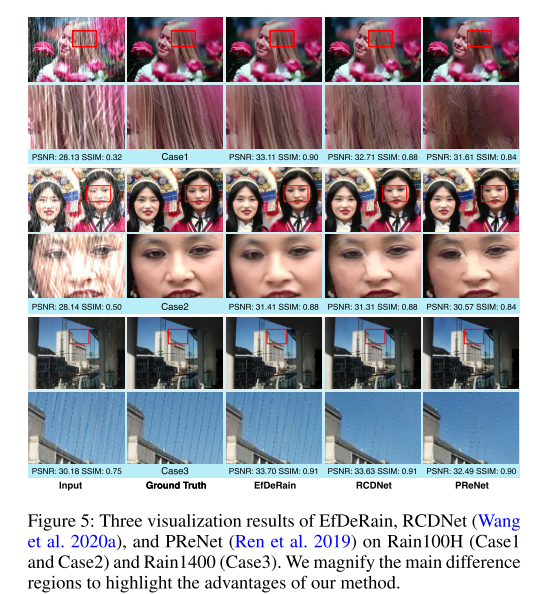

我们进一步将EfDeRain的可视化结果与目前最先进的基线方法RCDNet和PReNet进行比较,如图5所示

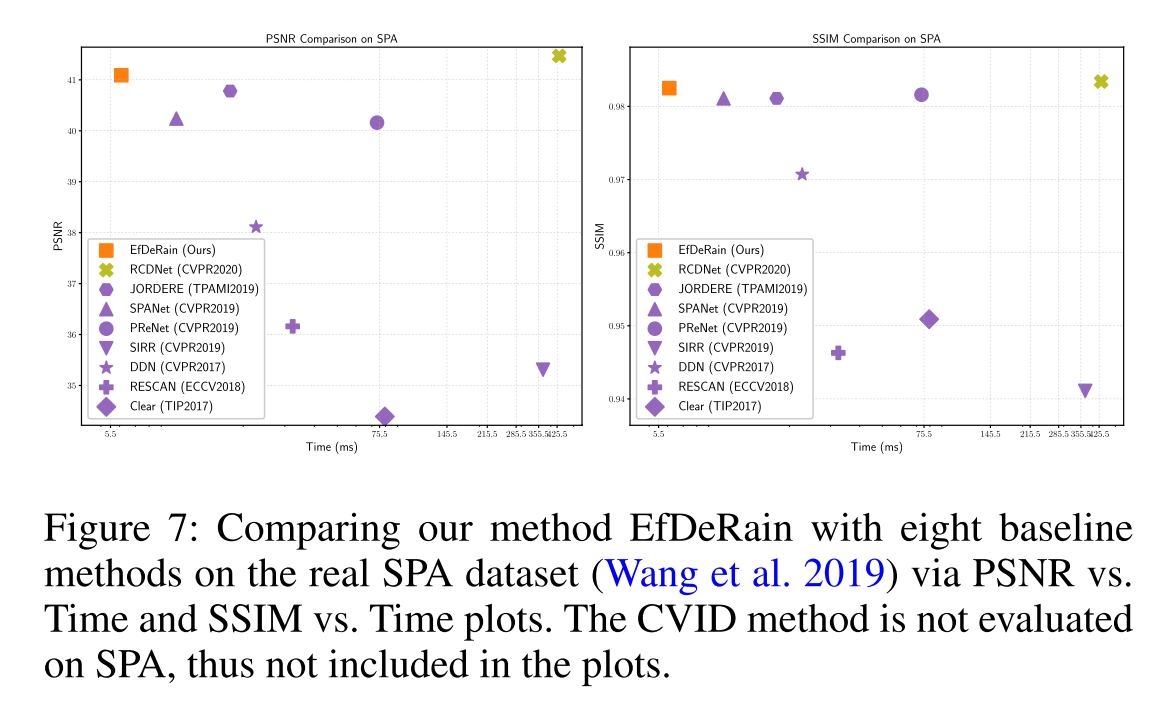

4.3 真实SPA雨数据集对比

我们进一步将我们的方法与SPA数据集上的8种基线方法进行比较(Wang et al. 2019),其中雨图像是真实的,它的地面真相是通过人类标记和多帧融合获得的。 如图7所示,我们的方法与最优方法RCDNet取得了几乎相同的PSNR和SSIM,并且在运行效率比RCDNet高出71倍以上的情况下优于其他所有基线。

如图7所示,我们的方法与最优方法RCDNet取得了几乎相同的PSNR和SSIM,并且在运行效率比RCDNet高出71倍以上的情况下优于其他所有基线。

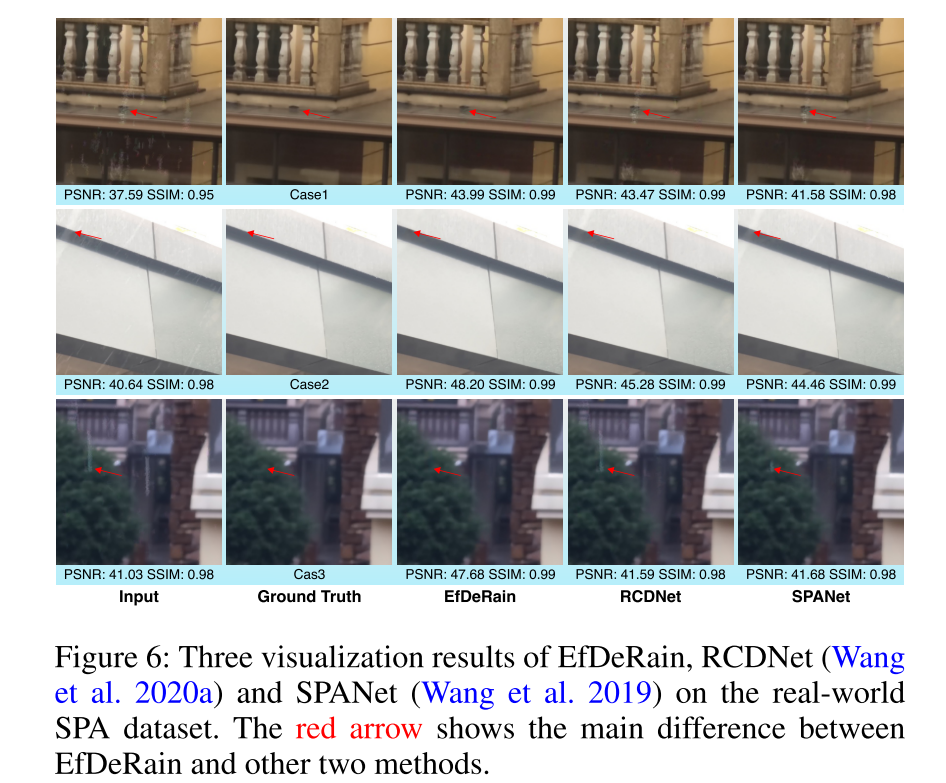

我们还直观地将我们的方法与图6中的RCDNet和SPANet进行了比较。结果表明,该方法能够较好地处理不同模式下的雨迹,并取得了比RCDNet和SPANet更好的可视化效果,其中红色箭头显示了与另外两种模型的主要区别。

我们还直观地将我们的方法与图6中的RCDNet和SPANet进行了比较。结果表明,该方法能够较好地处理不同模式下的雨迹,并取得了比RCDNet和SPANet更好的可视化效果,其中红色箭头显示了与另外两种模型的主要区别。

4.4 真实雨滴数据集比较

除了在雨天条纹图像数据集上,我们还在去雨滴任务上比较了我们的方法,以显示我们的方法的泛化能力。我们培养了我们方法的能力。我们在Raindrop数据集上训练我们的网络(Qian et al. 2018),并将其与6种最先进的基线方法进行比较。

特别是,DeRaindrop方法(Qian et al. 2018)是专门针对这个问题设计的,其中雨滴的区域是由一个注意循环网络感知的。我们的方法在不改变任何架构或超参数的情况下,与竞争的SSIM相比DeRaindrop获得了第二好的结果,并优于所有其他的DeRaindrop方法,证明了我们的方法的有效性和通用性。

4.5 消融研究

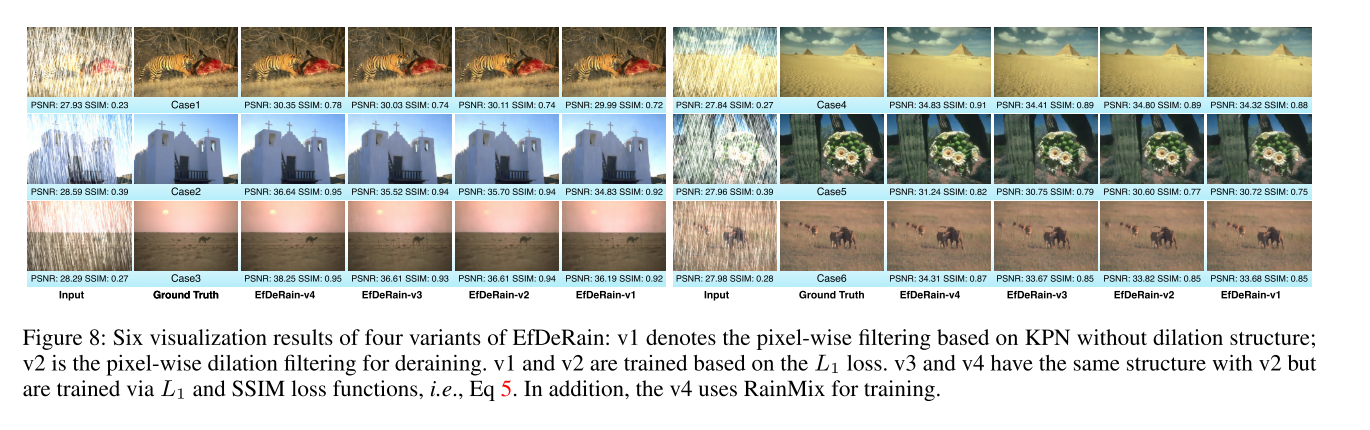

我们通过图8中的Rain100H可视化结果进一步验证了我们的贡献的优势

此外,我们对图9中的SPA数据集进行可视化比较,以验证我们的RainMix的有效性。 因此,我们的RainMix增强了我们的方法在去除真实的雨迹的能力,即使雨的模式非常多样化。在所有的情况下,如果我们不使用RainMix,我们观察到总会存在一些无法处理的大雨痕迹,如图中红色箭头所示(红色箭头显示了两个版本之间的主要区别。黄色箭头表示没有被人类标记的雨滴也被我们的方法去除)。

因此,我们的RainMix增强了我们的方法在去除真实的雨迹的能力,即使雨的模式非常多样化。在所有的情况下,如果我们不使用RainMix,我们观察到总会存在一些无法处理的大雨痕迹,如图中红色箭头所示(红色箭头显示了两个版本之间的主要区别。黄色箭头表示没有被人类标记的雨滴也被我们的方法去除)。

5 Conclusions

在本文中,我们提出了一种新的无模型脱模方法,称为EfficientDeRain。我们的方法不仅可以实现显著的高性能,而且运行效率比最先进的方法超过80倍。首先,我们提出并设计了一种新颖的像素级膨胀滤波方法,其中每个像素由脱机训练的核预测网络估计的多尺度核进行滤波。其次,我们提出了一种简单而有效的训练网络的数据增强方法,即RainMix,弥合了合成数据和真实数据之间的差距。最后,我们在流行的和具有挑战性的综合数据集Rain100H和Rain1400,以及真实世界的数据集SPA和Raindrop上进行了大规模的评估,全面验证了我们的方法在效率和脱除质量方面的优势。

未来,我们将研究脱轨对其他计算机视觉任务的影响,例如,目标分割(Guo et al. 2018, 2017c)和目标跟踪(Guo et al. 2020c,a, 2017a,b),使用最先进的DNN测试工作(Xie et al. 2019a;Du等人2019年;Xie et al. 2019b;Ma等。2018a,b, 2019)。我们也想从对抗式攻击方法的角度来研究单图像,例如,(Guo et al. 2020b;Wang et al. 2020b;Cheng et al. 2020a;Gao等人2020年;Cheng et al. 2020b;田等人,2020年)。