Kubeadm方式搭建K8S集群

环境准备

在虚拟机里安装三台centos 7.x操作系统

配置系统名称和ip地址(同一网段)如:

| 角色 | IP |

|---|---|

| master | 192.168.66.100 |

| node1 | 192.168.66.101 |

| node2 | 192.168.66.102 |

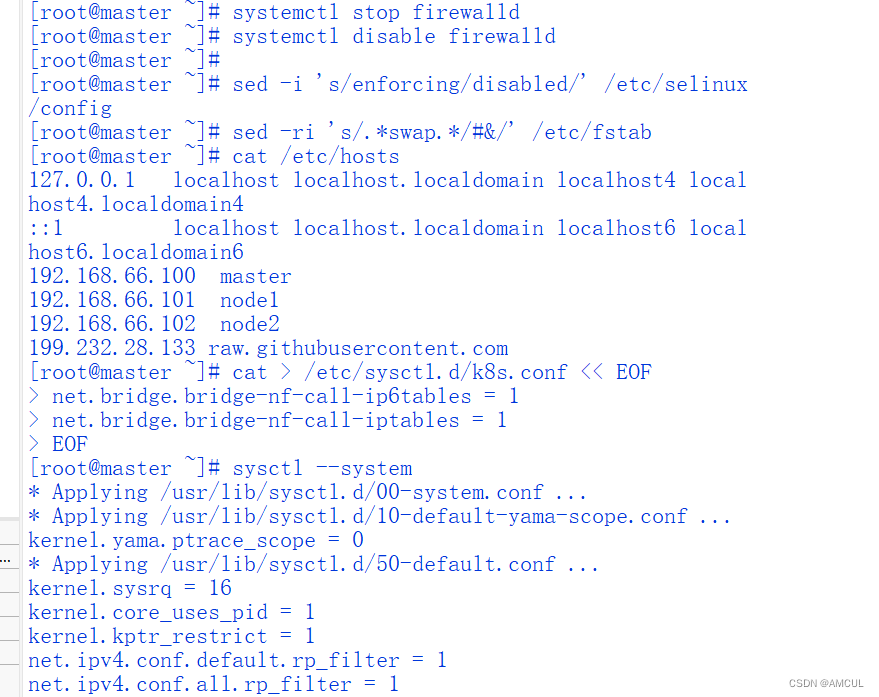

三台机器都要执行的命令:(使用xshell执行命令更方便)

# 关闭防火墙

systemctl stop firewalld

systemctl disable firewalld

# selinux永久关闭

sed -i 's/enforcing/disabled/' /etc/selinux/config

# swap永久关闭

sed -ri 's/.*swap.*/#&/' /etc/fstab

# 添加hosts

cat >> /etc/hosts << EOF

192.168.66.100 master

192.168.66.101 node1

192.168.66.102 node2

EOF

# 将桥接的IPv4流量传递到iptables的链

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

# 生效

sysctl --system

# 时间同步

yum install ntpdate -y

ntpdate time.windows.com

安装Docker(三台机器都需要安装)

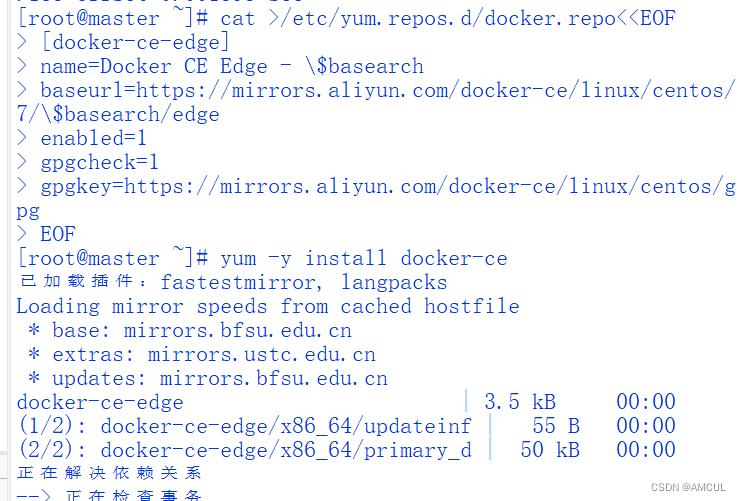

配置Docker的阿里yum源

cat >/etc/yum.repos.d/docker.repo<<EOF

[docker-ce-edge]

name=Docker CE Edge - \$basearch

baseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/\$basearch/edge

enabled=1

gpgcheck=1

gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg

EOF

以yum方式安装docker

# yum安装

yum -y install docker-ce

# 查看docker版本

docker --version

# 启动docker

systemctl enable docker

systemctl start docker

配置docker的镜像源

cat >> /etc/docker/daemon.json << EOF

{

"registry-mirrors": ["https://b9pmyelo.mirror.aliyuncs.com"]

}

EOF

重启docker

systemctl restart docker

添加kubernetes软件源

配置yum的k8s软件源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

安装kubeadm,kubelet和kubectl

由于版本更新频繁,这里指定版本号部署:

# 安装kubelet、kubeadm、kubectl,同时指定版本

yum install -y kubelet-1.18.0 kubeadm-1.18.0 kubectl-1.18.0

# 设置开机启动

systemctl enable kubelet

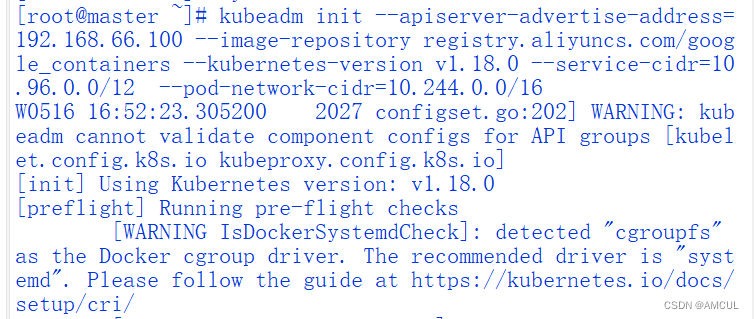

部署master节点

在master节点执行(此处的192.168.66.100为小编master机器的ip,需更换)

kubeadm init --apiserver-advertise-address=192.168.66.100 --image-repository registry.aliyuncs.com/google_containers --kubernetes-version v1.18.0 --service-cidr=10.96.0.0/12 --pod-network-cidr=10.244.0.0/16

等待其出现成功提示

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-SQ2t7Y1r-1684324168159)(C:\Users\123\AppData\Roaming\Typora\typora-user-images\image-20230516181608215.png)]](https://img-blog.csdnimg.cn/1509d4ec5c6c4fbb88b60289b9b2d9cb.png)

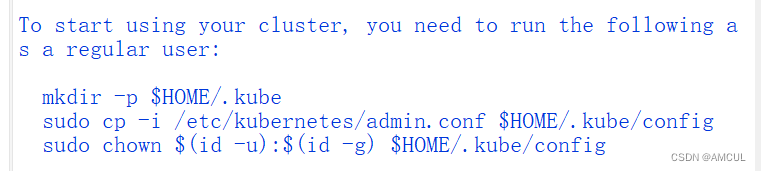

然后按提示在master节点上输入提示命令

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

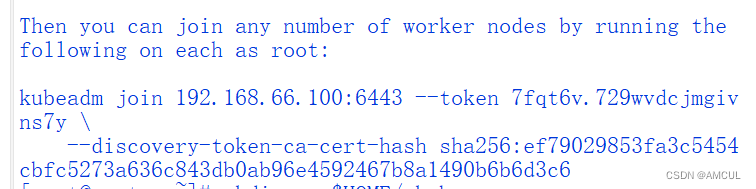

按照master生成的代码向集群添加新节点(node1和node2上的操作)

在node1和node2上执行在master上产生的kubeadm join命令:(根据实际而定,下面的是小编机器上的,仅供参考)

kubeadm join 192.168.66.100:6443 --token 7fqt6v.729wvdcjmgivns7y \

--discovery-token-ca-cert-hash sha256:ef79029853fa3c5454cbfc5273a636c843db0ab96e4592467b8a1490b6b6d3c6

我们就可以去Master节点 执行下面命令查看情况

kubectl get node

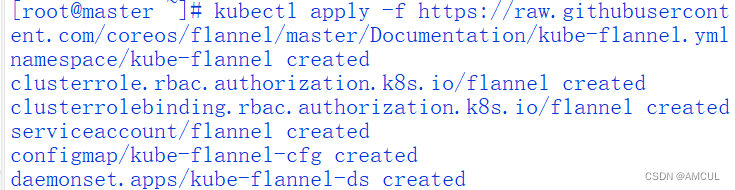

部署CNI网络插件

上面的状态还是NotReady,下面我们需要网络插件,来进行联网访问

# 添加

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

# 查看状态

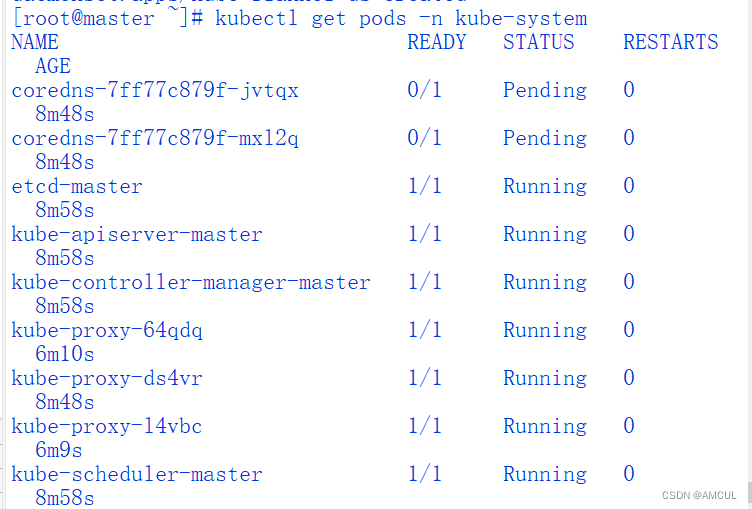

kubectl get pods -n kube-system

此时还有未处于running状态的pod,再等些时间,再查看状态,全部变为running状态时,执行下面命令查看:

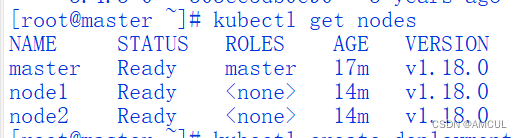

kubectl get node

运行完成后,此时可以发现,已经变成了Ready状态。若还存在NotReady状态的节点,再等些时间,然后执行kubectl get pods -n kube-system命令,若状态为running,再执行kubectl get node查看即可

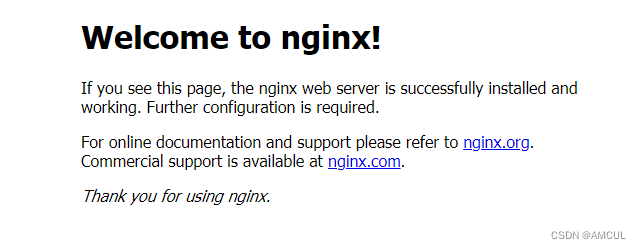

测试kubernetes集群

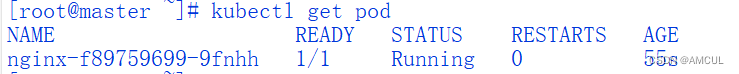

在Kubernetes集群中创建一个pod,验证是否正常运行:

# 下载nginx

kubectl create deployment nginx --image=nginx

# 查看状态

kubectl get pod

出现Running状态时,表示已经成功运行了

下面我们就需要将端口暴露出去,让其它外界能够访问

# 暴露端口

kubectl expose deployment nginx --port=80 --type=NodePort

# 查看一下对外的端口

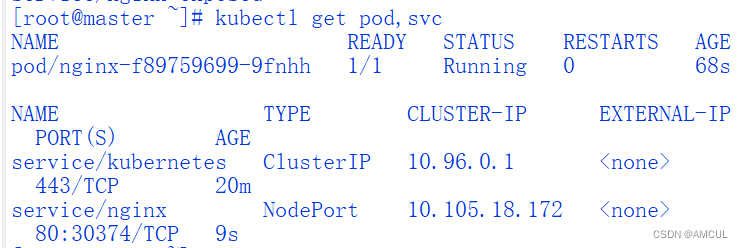

kubectl get pod,svc

能够看到,我们已经成功暴露了 80端口 到 30374上

在浏览器上,访问如下地址(任一一个节点的ip加上面显示的端口)

http://192.168.66.102:30374/

发现我们的nginx已经成功启动了