视频作者:菜菜TsaiTsai

链接:【技术干货】菜菜的机器学习sklearn【全85集】Python进阶_哔哩哔哩_bilibili

n_clusters是KMeans中的k,表示着我们告诉模型我们要分几类。这是KMeans当中唯一一个必填的参数,默认为8类,但通常我们的聚类结果会是一个小于8的结果。

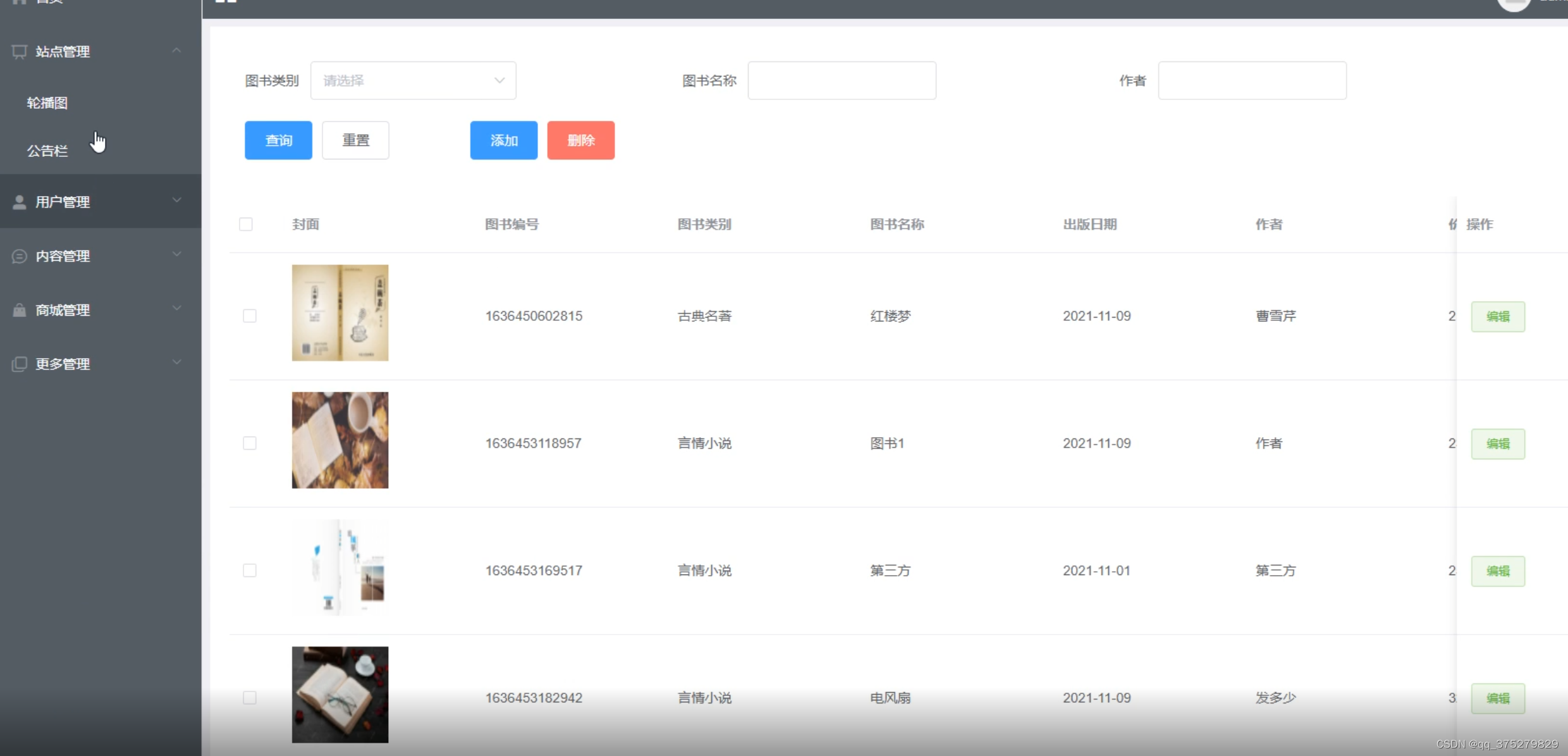

在自建数据集上演示KMeans的基本使用

from sklearn.datasets import make_blobs

import matplotlib.pyplot as plt

import pandas as pd

from sklearn.cluster import KMeans

X,y = make_blobs(n_samples=500,n_features=2,centers=4,random_state=1)

fig,ax1 = plt.subplots(1)

# fig为画布,ax1为对象,画图需要在对象上画图,例如ax1.plot()

# 相比于之前直接画图,这里利用的是子图对象,里面1表示有1个图。如果只有一个数字,就像上面的情况,不同的子图在同一列上堆叠。两个数subplots(2,3)就是熟悉的两行三列的子图

# 需要注意的是,由于subplots(1)只有一个子图,因此ax1只有一个对象,如果有多个子图ax1就会成为一个列表,需要选择其中的元素来使用

fig,ax1 = plt.subplots(1)

ax1.scatter(X[:,0],X[:,1],marker='o',s=8)

plt.show()

![![[附件/Pasted image 20221115211640.png|350]]](https://img-blog.csdnimg.cn/0c9b4d4fbc784eb3b877dbb752f4c57d.png)

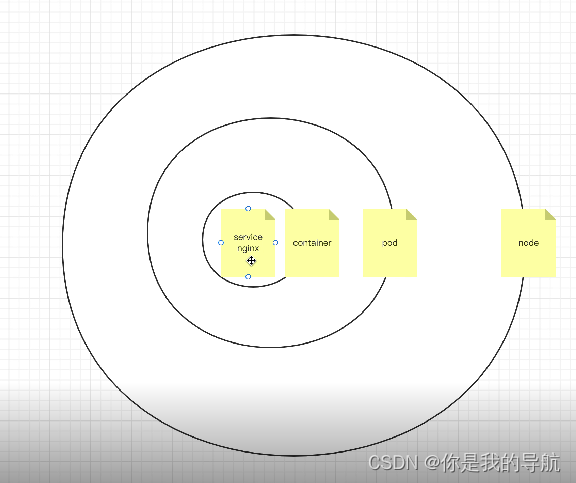

color = ['red','pink','orange','grey']

fig,ax1 = plt.subplots(1)

for i in range(4):

ax1.scatter(X[y==i,0],X[y==i,1],c=color[i],s=8,marker='o')

plt.show()

![![[附件/Pasted image 20221115211657.png|350]]](https://img-blog.csdnimg.cn/582641387fac4192aec365385e6e1834.png)

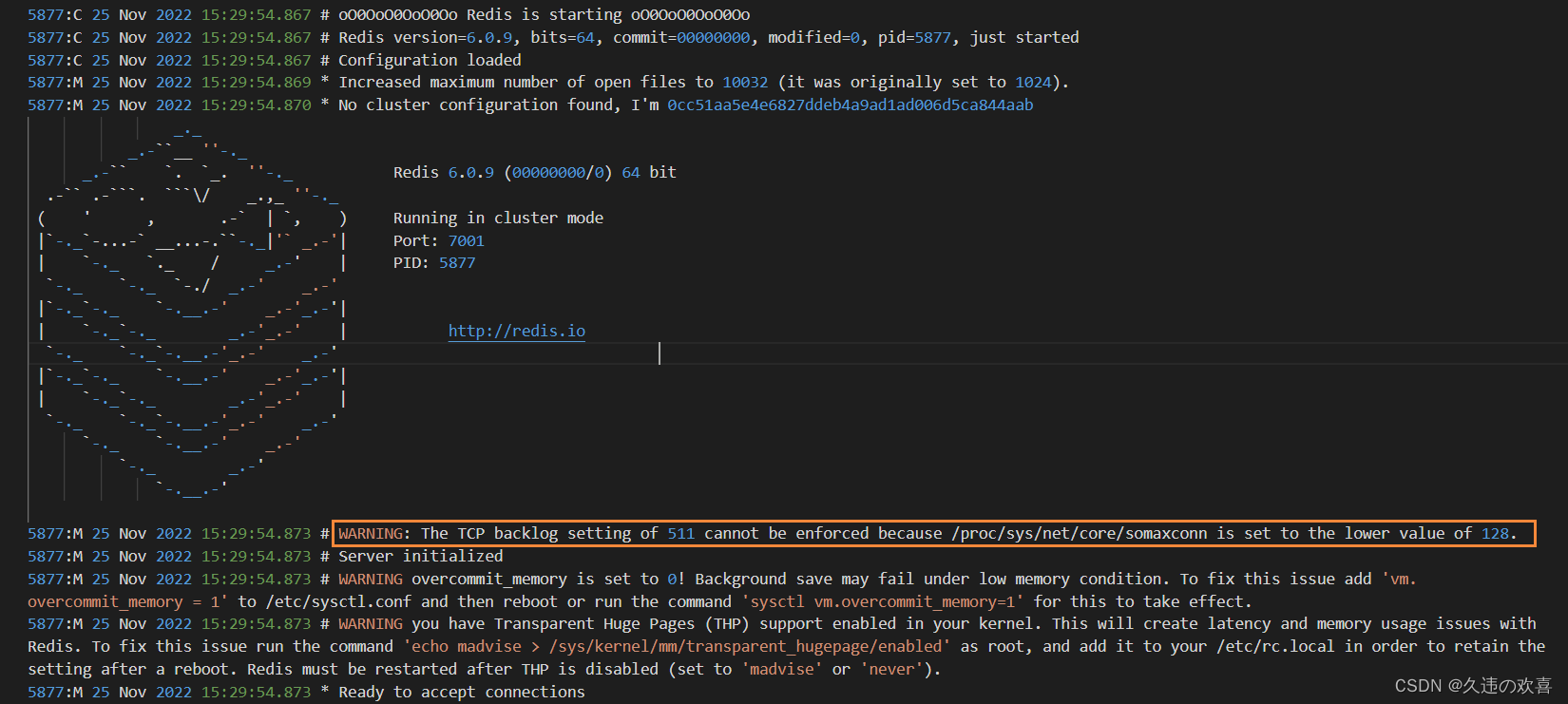

这里为了展示KMeans的聚类效果,所以k先设定为3

n_clusters = 3

cluster = KMeans(n_clusters=n_clusters,random_state=0).fit(X)

# 建模的目的是为了找出质心

# 这就告诉我们建模后的模型可以用于预测新的数据集

y_pred = cluster.labels_ # labels_返回fit输入的矩阵的聚类结果

y_pred.shape,set(y_pred)

---

((500,), {0, 1, 2})

pre = cluster.fit_predict(X)

# fit和predict可以分开,假设我们有一个极大的数据集500000条数据,我们切片取出2000条来fit建模,然后predict用于整个500000的数据集上,速度回快很多,效果不会差太多

pd.Series(pre == y_pred).value_counts()

---

True 500

dtype: int64

cluster_smallsub = KMeans(n_clusters=n_clusters,random_state=0).fit(X[:200])

y_pred_ = cluster_smallsub.predict(X)

pd.Series(y_pred == y_pred_).value_counts()

# 这个能说明用整体样本中取出来的小样本进行聚类,效果也可以很好

# 这里需要注意的是,进行不同的尝试的时候可能会出现大量False,这是因为在两次聚类时使用的标签不同

# 例如第一次聚类123属于同一类,标签为0,第二次聚类123也属于同一类,但标签为1,这时就会出现大量False

---

True 499

False 1

dtype: int64

# 质心

centroid = cluster.cluster_centers_

centroid

---

array([[-8.09286791, -3.50997357],

[-1.54234022, 4.43517599],

[-7.0877462 , -8.08923534]])

centroid = cluster_smallsub.cluster_centers_

# 如果上面两个聚类的结果出现大量False这里可以对比质心,只要质心差不多,就可以认为聚类效果基本相同

centroid

---

array([[-8.17006713, -3.44720552],

[-1.44388438, 4.52237093],

[-7.3963476 , -8.08221442]])

# 整体平方和

inertia = cluster.inertia_

inertia

---

1903.5342237665059

color = ['red','pink','orange']

fig,ax1 = plt.subplots(1)

for i in range(n_clusters):

ax1.scatter(X[y_pred==i,0],X[y_pred==i,1],c=color[i],s=8,marker='o')

ax1.scatter(centroid[:,0],centroid[:,1],c='k',s=20,marker='x')

plt.show()

![![[附件/Pasted image 20221115212129.png|350]]](https://img-blog.csdnimg.cn/62602337d8b54482b0a35d39f77668bf.png)

其实inertia来评价KMeans效果有很大的局限性

n_clusters = 4

cluster_ = KMeans(n_clusters=n_clusters,random_state=0).fit(X)

inertia_ = cluster_.inertia_

inertia_

---

908.3855684760603

n_clusters = 5

cluster_ = KMeans(n_clusters=n_clusters,random_state=0).fit(X)

inertia_ = cluster_.inertia_

inertia_

---

811.0952123653016

n_clusters = 6

cluster_ = KMeans(n_clusters=n_clusters,random_state=0).fit(X)

inertia_ = cluster_.inertia_

inertia_

---

728.2827697678249

n_clusters = 500

cluster_ = KMeans(n_clusters=n_clusters,random_state=0).fit(X)

inertia_ = cluster_.inertia_

inertia_

---

0.0

可以看到,随着k的增大,KMeans的inertia单调减小,甚至当k=样本个数的时候inertia为0。我们生成数据集的时候指定有4簇,因此我们可以认为4簇是最好的,但是如果单纯的追求最小化inertia,我们甚至可设定k=500,显然这是错误的,所以我们要寻找更好的指标

这个例子也告诉我们,我们最小化inertia的前提是:有一个确定n_clusters