本地部署 Dolly V2

- 1. 什么是 Dolly V2

- 2. Github 地址

- 3. 安装 Miniconda3

- 4. 创建虚拟环境

- 5. 部署 Dolly V2

- 6. 编写测试程序

- 7. 运行测试程序

1. 什么是 Dolly V2

Databricks的dolly-v2-12b,是一个在 Databricks 机器学习平台上训练的指令跟随型大型语言模型,被授权用于商业用途。基于 pythia-12b,Dolly 在大约 15000 条指令/响应微调记录 databricks-dolly-15k 上进行训练,这些记录由 Databricks 员工在 InstructGPT 论文中的能力领域生成,包括头脑风暴、分类、封闭式QA、生成、信息提取、开放式QA和总结。dolly-v2-12b 不是一个最先进的模型,但确实表现出令人惊讶的高质量指令跟随行为,这是它所基于的基础模型的特点。

2. Github 地址

https://huggingface.co/databricks/dolly-v2-12b

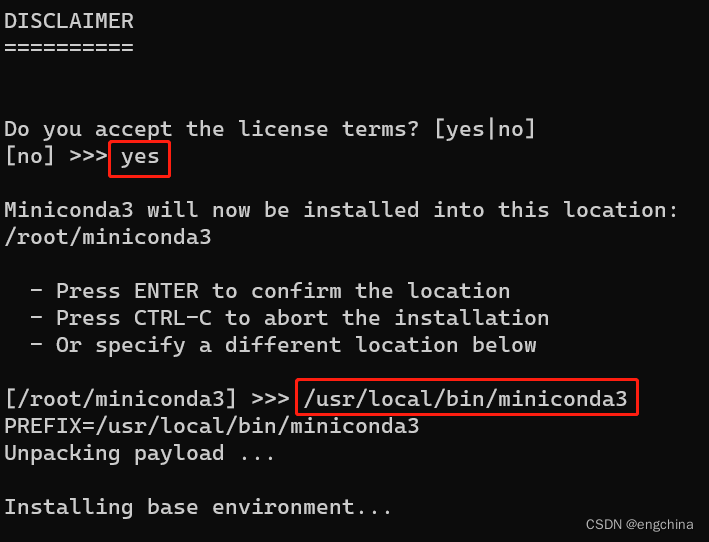

3. 安装 Miniconda3

下载 Conda 安装脚本,

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

运行安装脚本,

bash Miniconda3-latest-Linux-x86_64.sh

按提示操作。当提示是否初始化 Conda 时,输入 “yes”,

安装完成后,关闭当前终端并打开新终端,这将激活 Conda,

sudo su - root

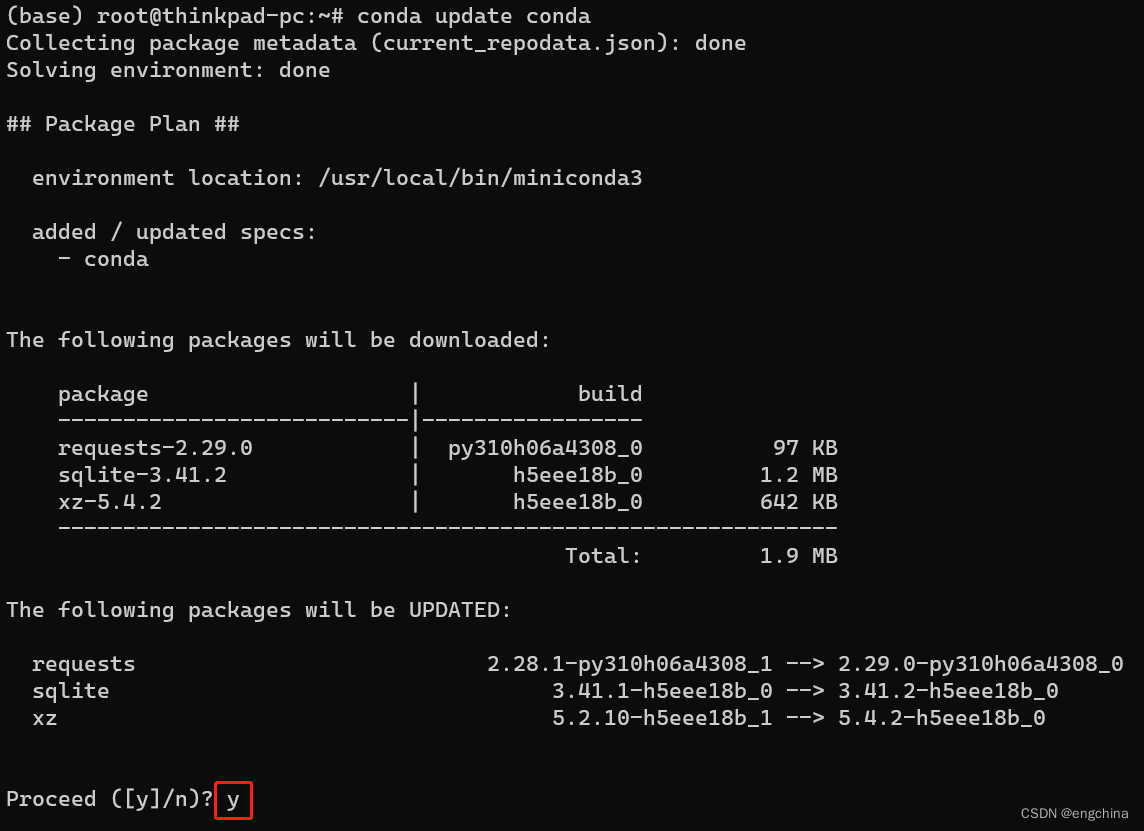

更新 Conda 至最新版本,

conda update conda

添加必要的 Conda 通道以获取更多软件包,

conda config --add channels conda-forge

conda config --add channels defaults

测试是否安装成功,

conda list

如果显示 Conda 及其内部包的列表,则说明安装成功。

4. 创建虚拟环境

conda create -n dolly python==3.10.4

conda activate dolly

5. 部署 Dolly V2

git lfs install

git clone https://huggingface.co/databricks/dolly-v2-12b

pip3 install "accelerate>=0.16.0,<1" "transformers[torch]>=4.28.1,<5" "torch“

6. 编写测试程序

cat << EOF > dolly.py

import torch

from transformers import pipeline

generate_text = pipeline(model="databricks/dolly-v2-12b", torch_dtype=torch.bfloat16, trust_remote_code=True, device_map="auto")

text = "how could i get up early?"

print("Question:" + text)

resp = generate_text(text)

print("Dolly's Answer:")

print(resp[0]["generated_text"])

EOF

7. 运行测试程序

python dolly.py

输出结果示例,

Question:how could i get up early?

Dolly's Answer:

Here are some ways to get up early:

1. Sleep until the morning

2. Wait for the sunrise

3. Wake up at the time when the birds are chirping

4. Turn on some good music

5. Light some candles

完结!