Hadoop的安装与配置

推荐按照我的博客下载hadoop,spark,pyspark以及scala这样版本搭配更好。

如果觉得自己不会版本搭配可私聊博主。

scala的安装和配置:https://blog.csdn.net/weixin_41957626/article/details/130548174

spark的安装和配置:https://blog.csdn.net/weixin_41957626/article/details/130548275

1.下载

官网:https://archive.apache.org/dist/hadoop/common/

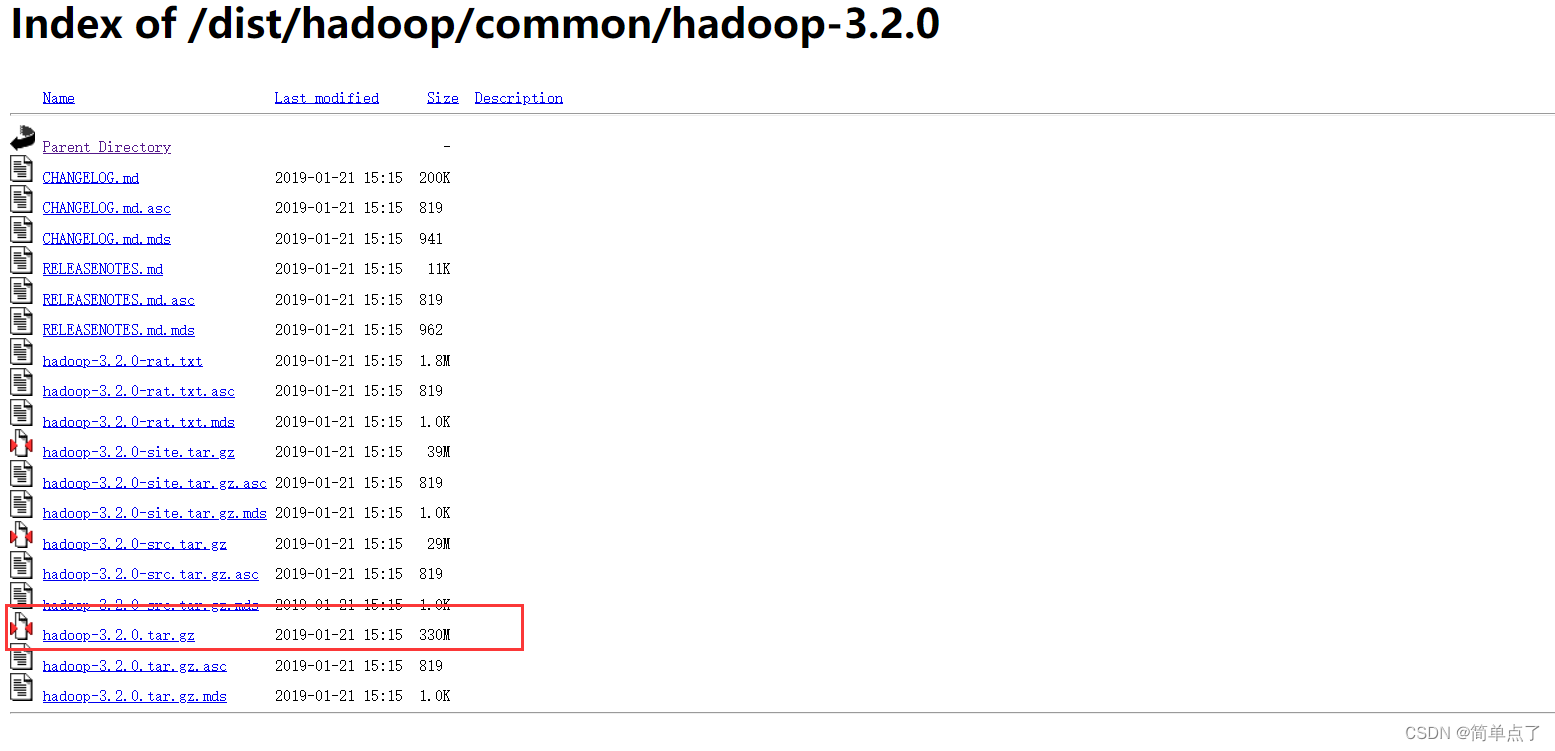

1.下载地址

Index of /dist/hadoop/common/hadoop-3.2.0

2.Windows环境推荐下载 msi文件

我下载的是3.2是我的环境最优的配置

3.找一个自己想安装的位置解压。

2.安装和配置

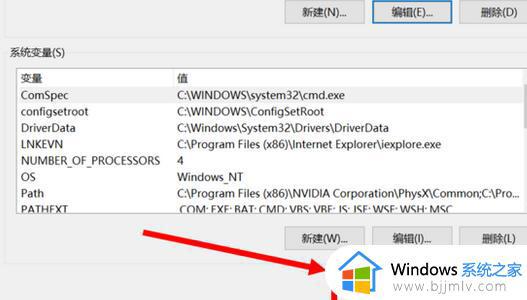

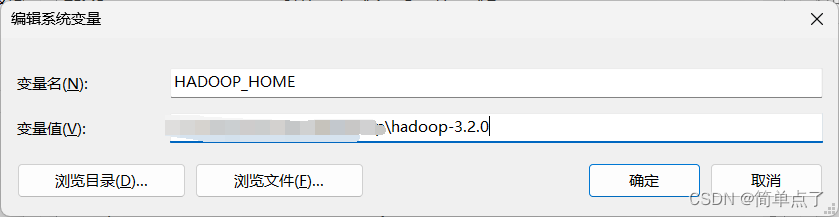

安装需要手动配置环境变量

1.打开系统的环境变量

HADOOP_HOME:安装路径,bin的上一级。

找到你的hadoop\bin目录找下里面有没有winutils.exe文件,如果没有的话,我们需要去下载。

winutils.exe

下载地址

GitHub - steveloughran/winutils: Windows binaries for Hadoop versions (built from the git commit ID used for the ASF relase)

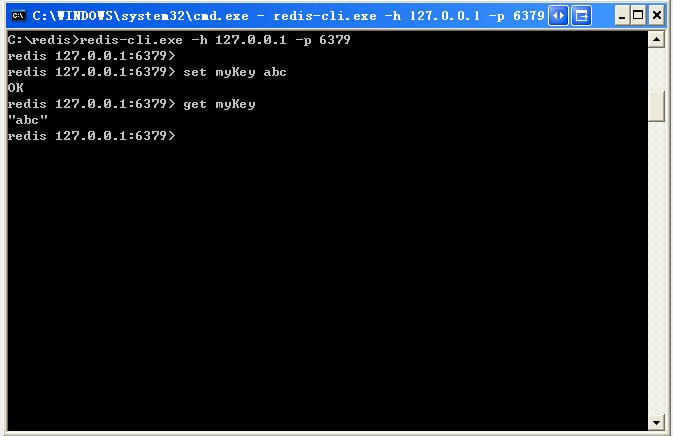

3.测试

需要安装完spark输入spark-shell没有出现任何报错说明配置成功!!!

spark的安装和配置:https://blog.csdn.net/weixin_41957626/article/details/130548275

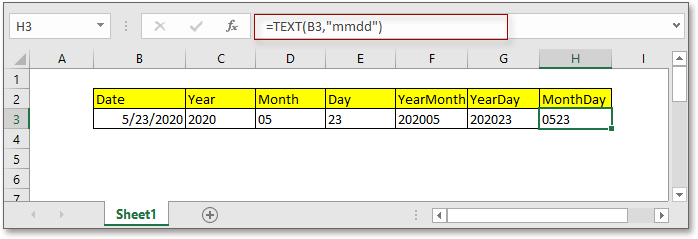

![[ Azure 云计算从业者 | AZ-900 ] Chapter 06 | 认识与了解 Azure 中相关的计算服务](https://img-blog.csdnimg.cn/a96a93b244d3474ea486758a2b64011b.png)