深度学习模型参数太多,本地服务器部署没有问题,但是如果部署到移动端、边缘端,像手机、树莓派等,它们的性能不能满足,所以我们要压缩模型大小,让他们可以部署到边缘端

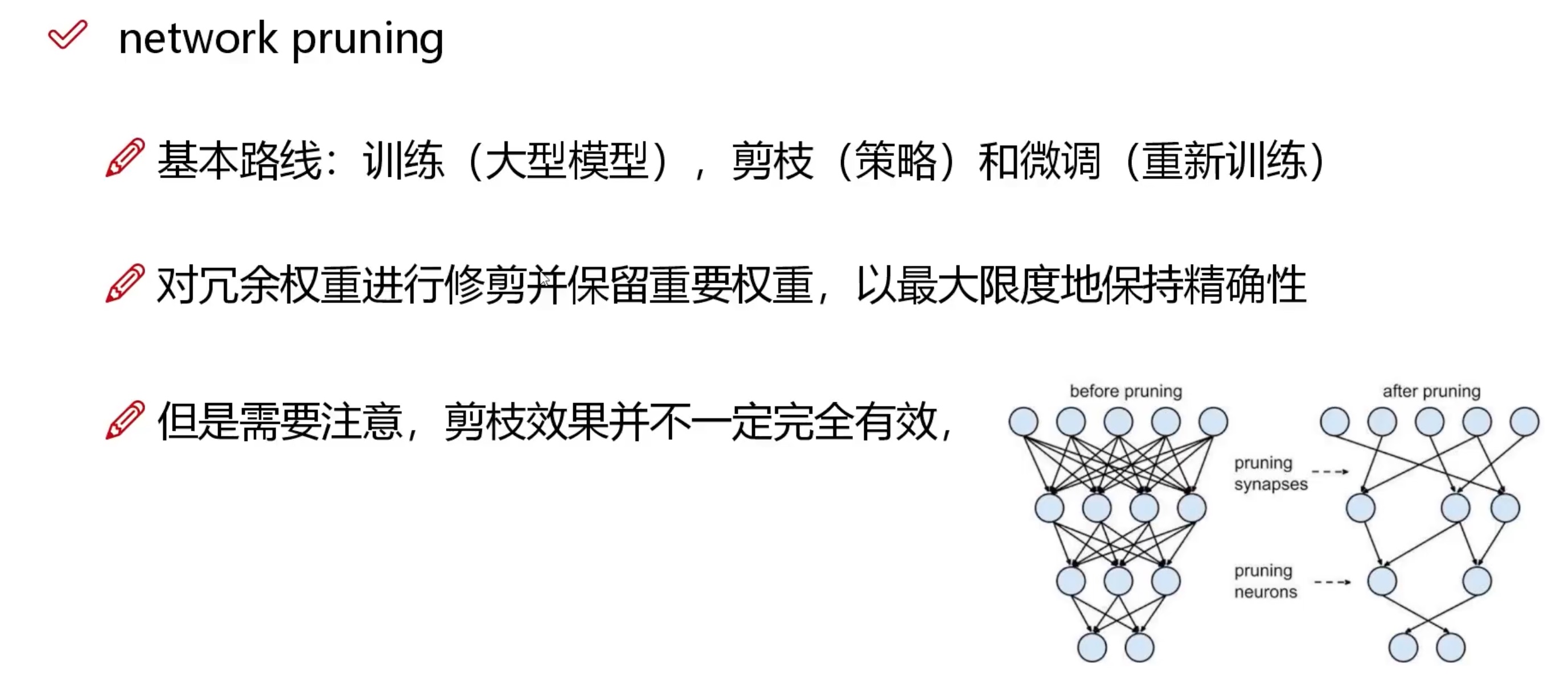

模型压缩:使用轻量化的模型压缩技术,如剪枝(pruning)和量化(quantization),来减小深度学习模型大小

- 通过剪枝可以去除冗余的权重参数和不必要的神经元,从而减小模型的尺寸。

- 量化可以将浮点数权重参数转换为更小的整数,从而减少存储和计算开销。

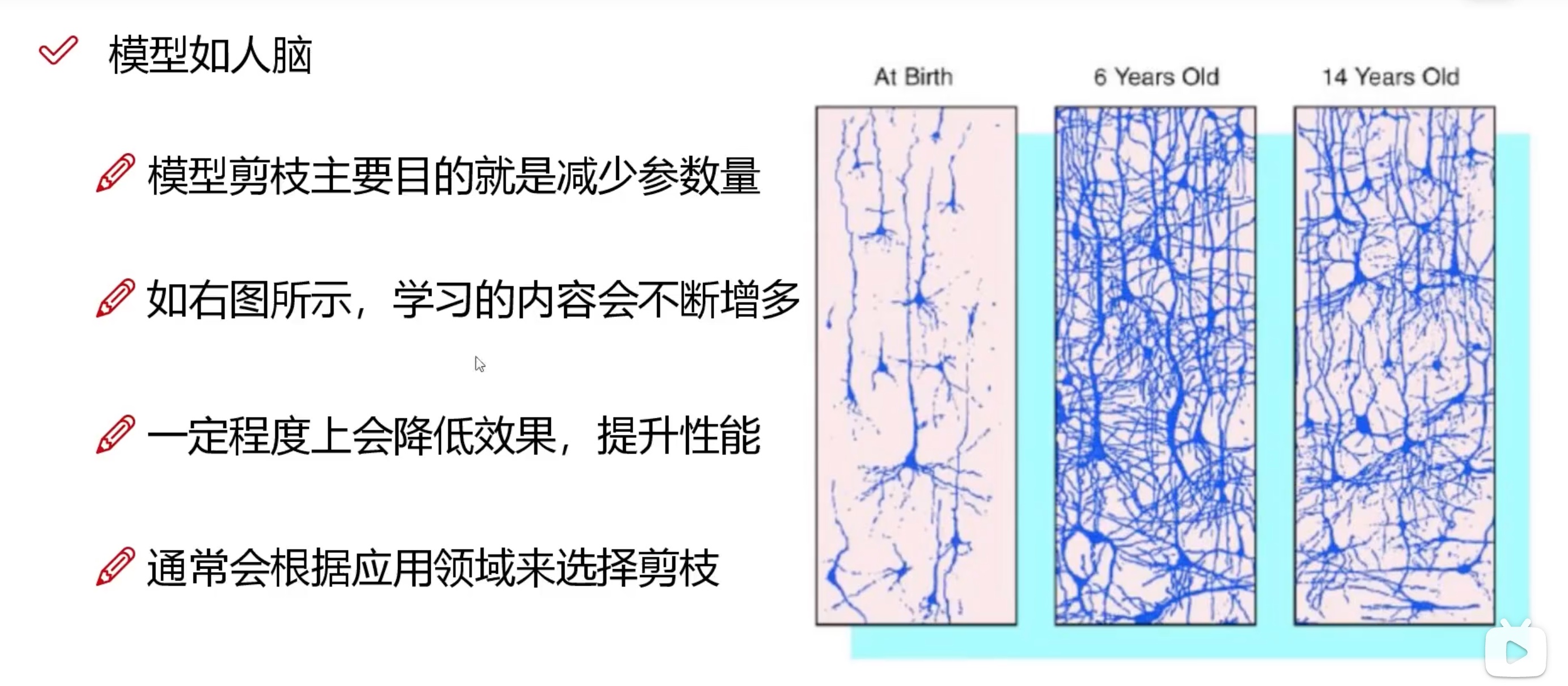

可以类比人脑

深度学习模型有点玄学,最好还是在一开始设计好模型,比后期做剪枝操作要强

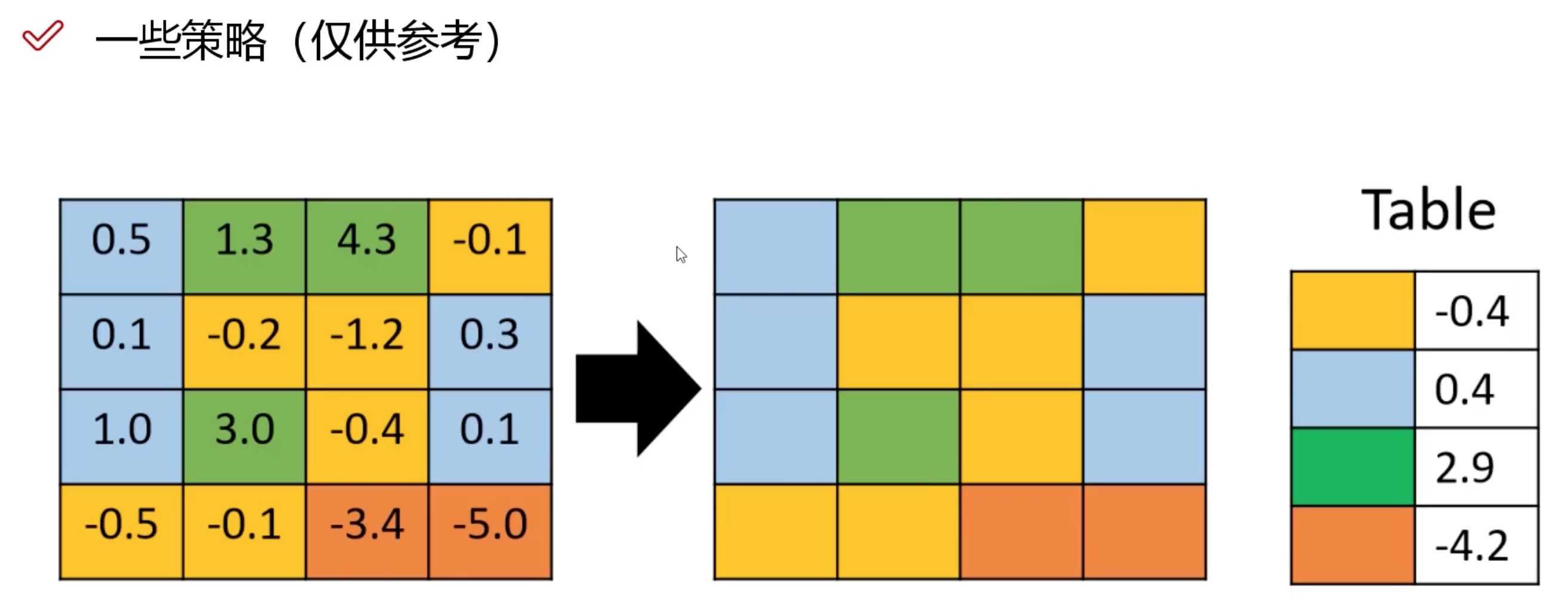

剪枝的一些操作:

-

聚类,效果不好

-

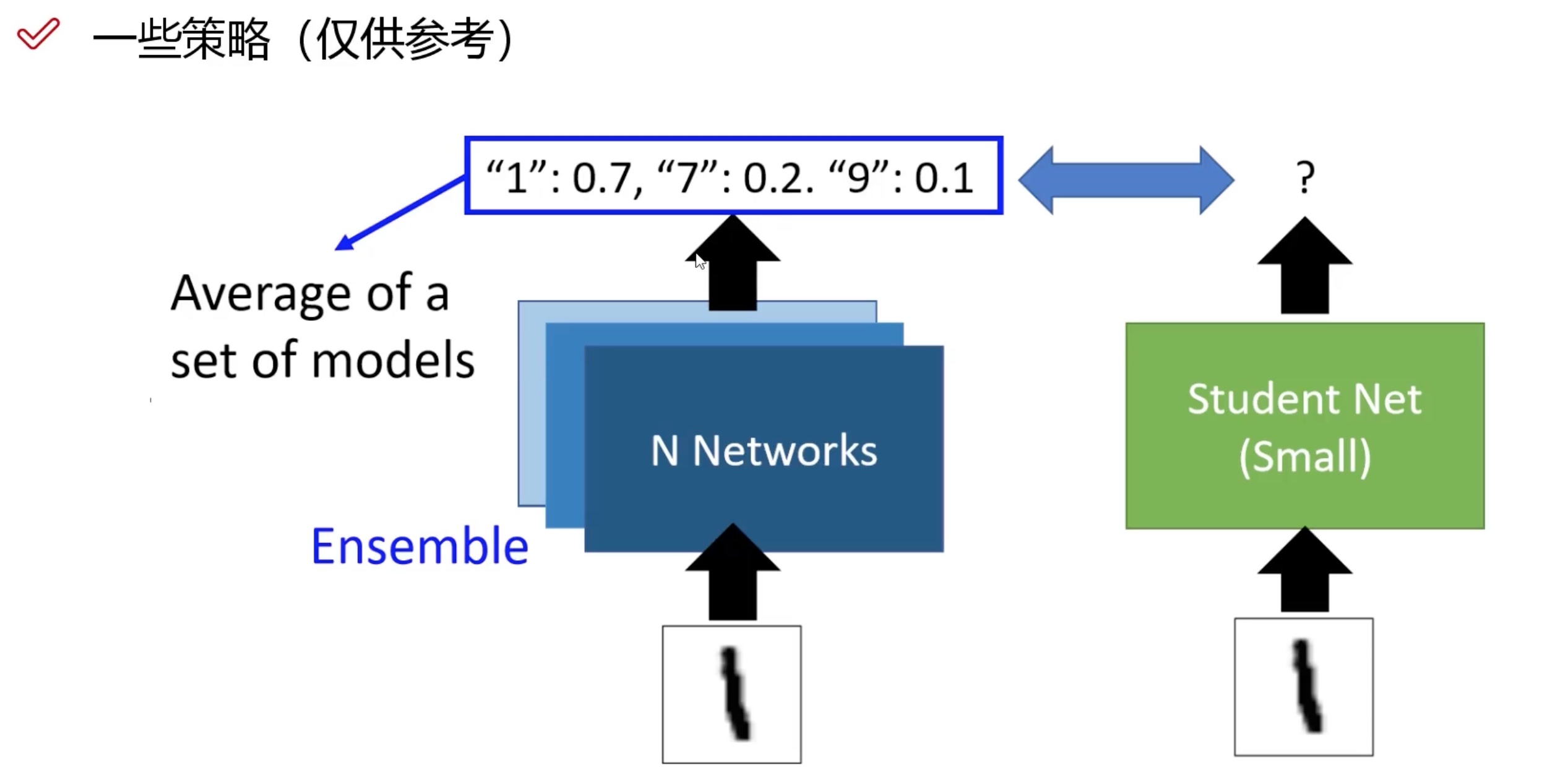

大网络训练作为小网络的先验知识(不常用)

-

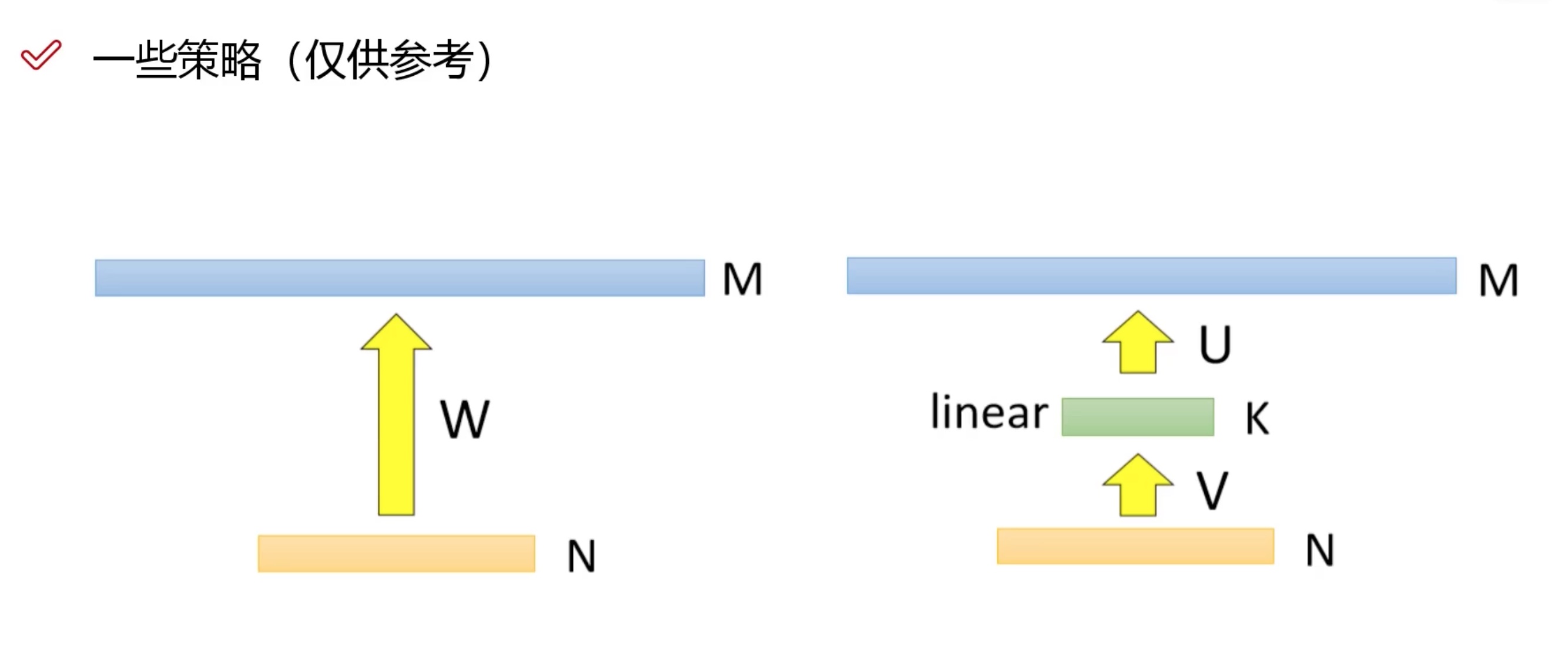

SVD,中间加上一个层(两个全连接层之间,减少参数)

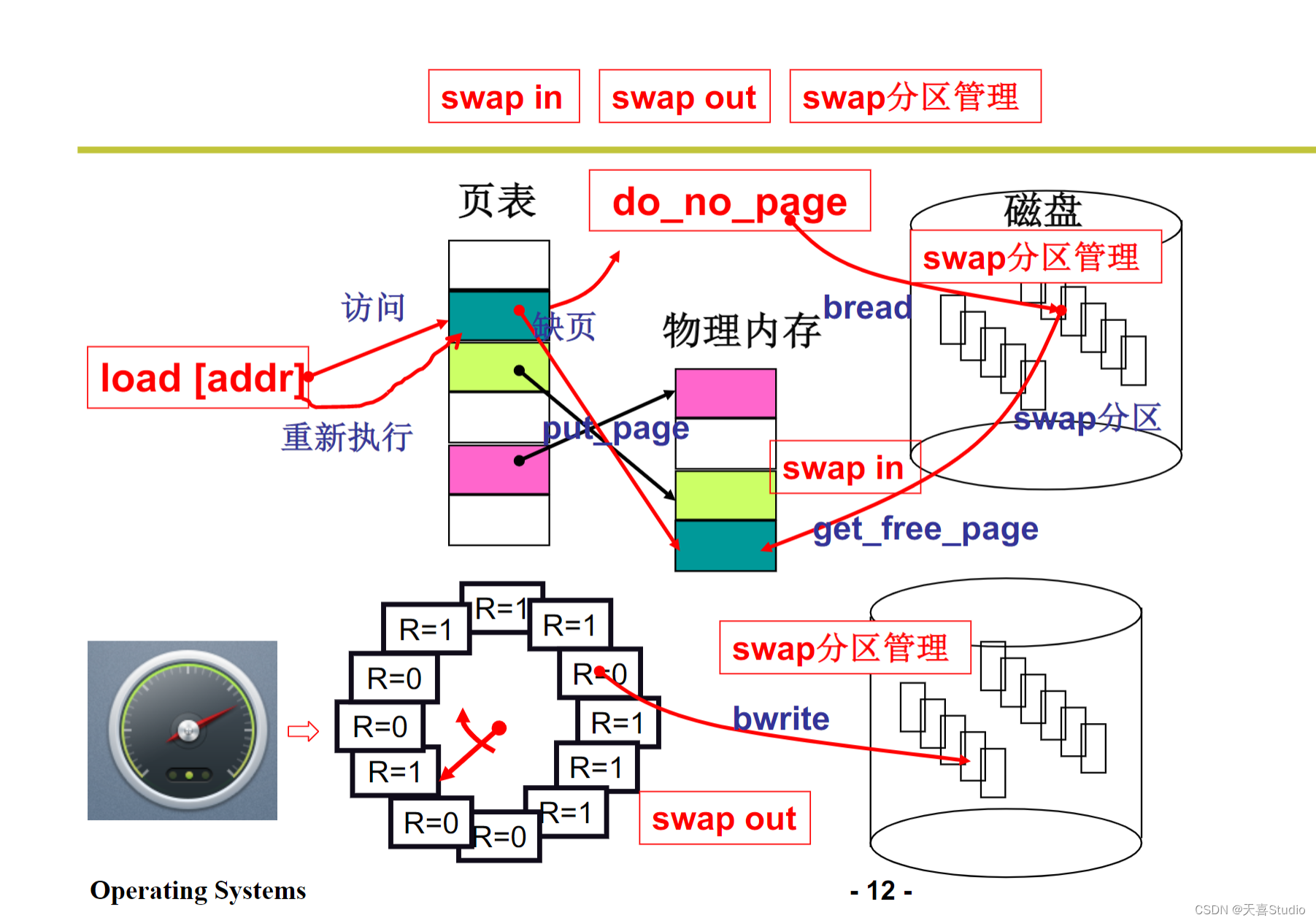

剪枝是什么?

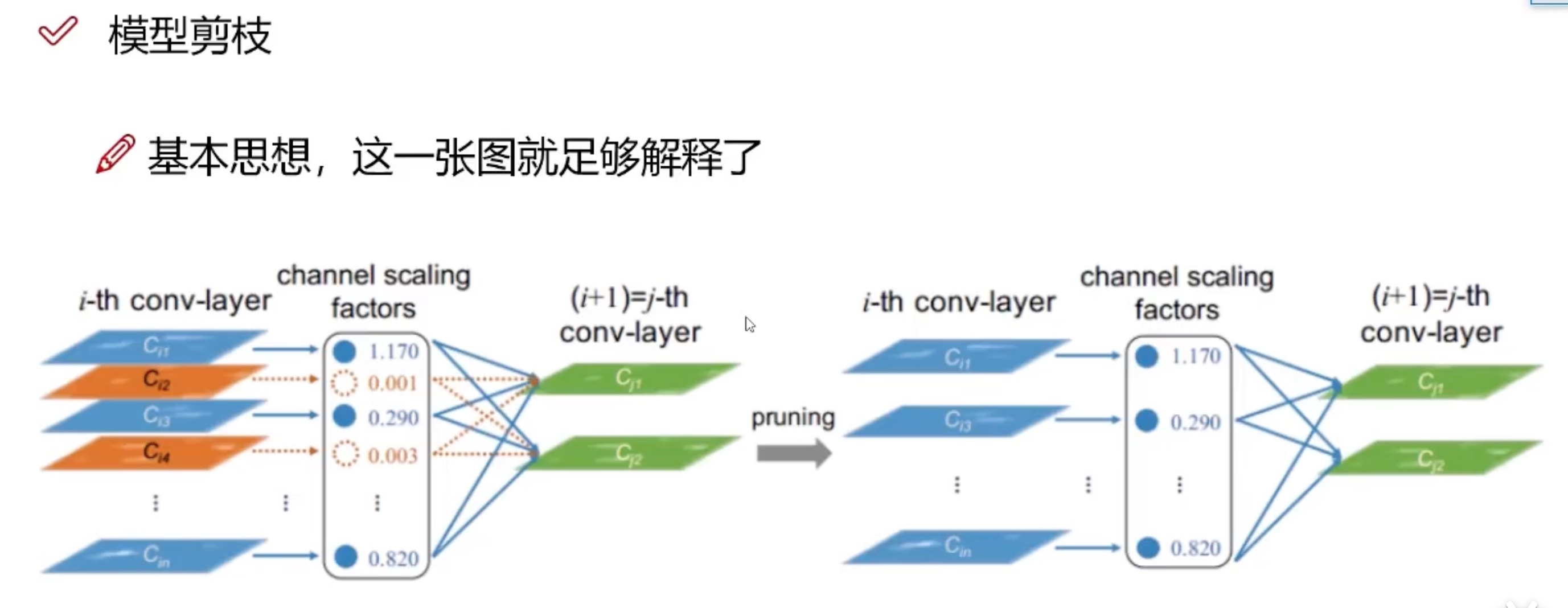

如何减少模型中无用的特征图

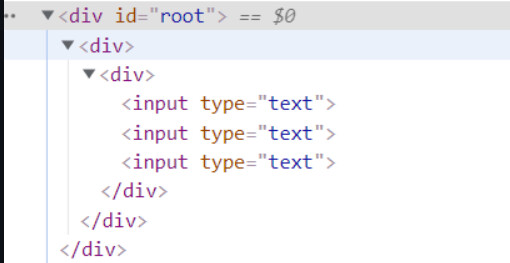

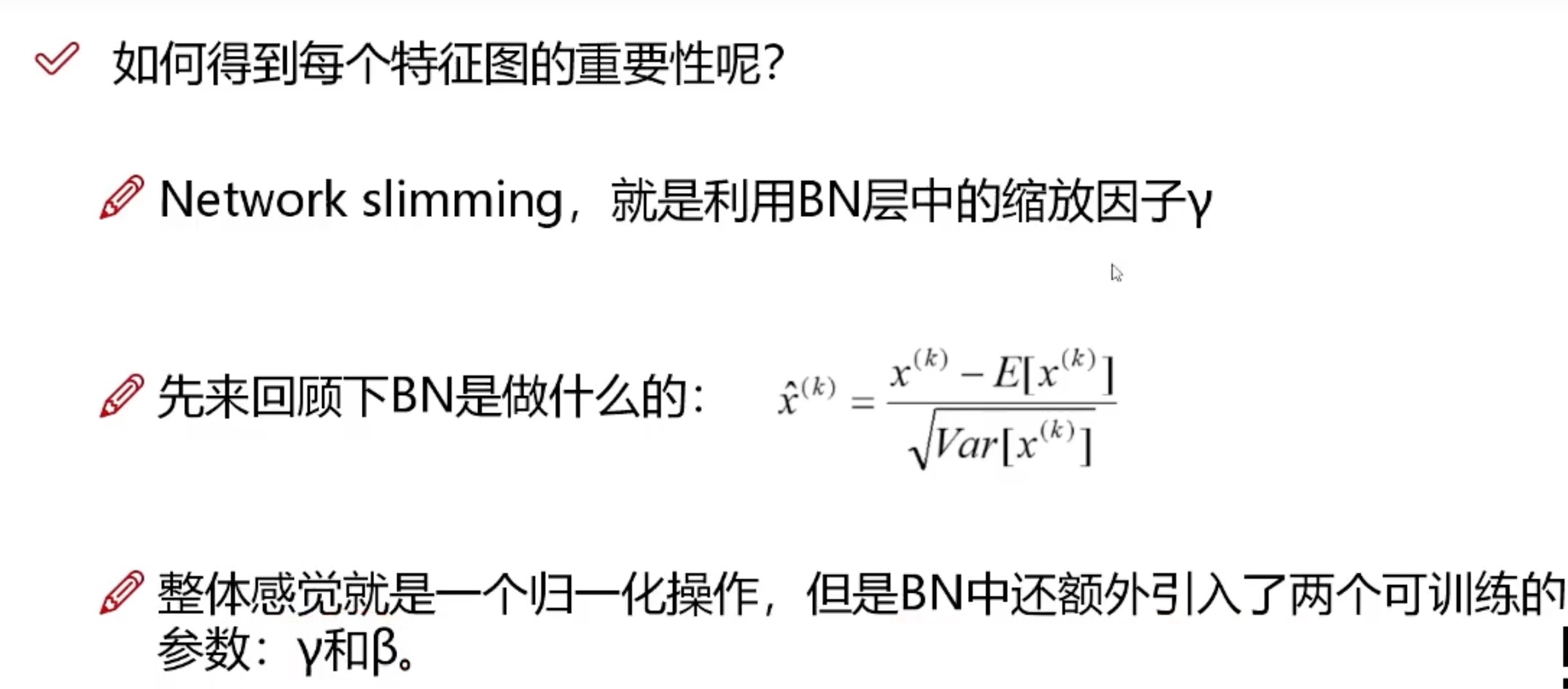

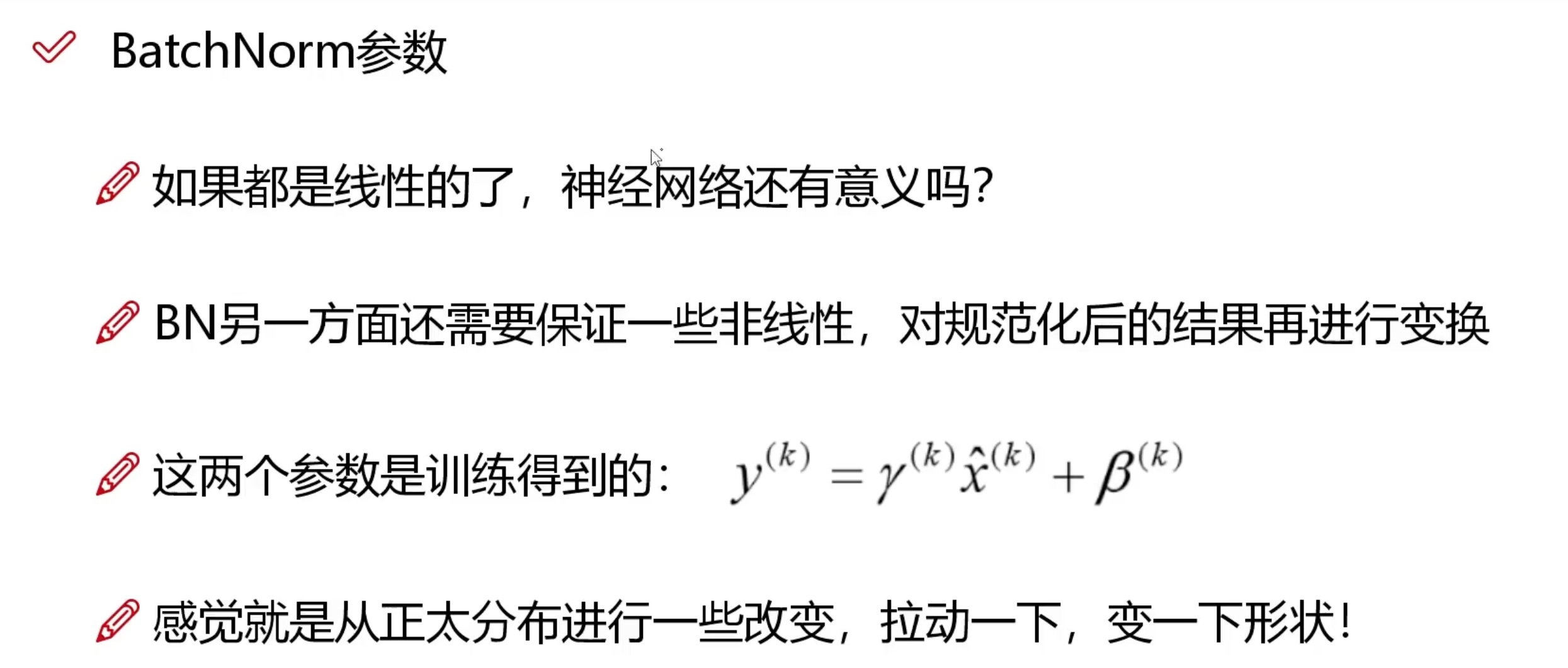

常规套路:Conv + BN + Relu激活函数

- BN的作用是为了防止卷积之后的梯度消失或者梯度爆炸

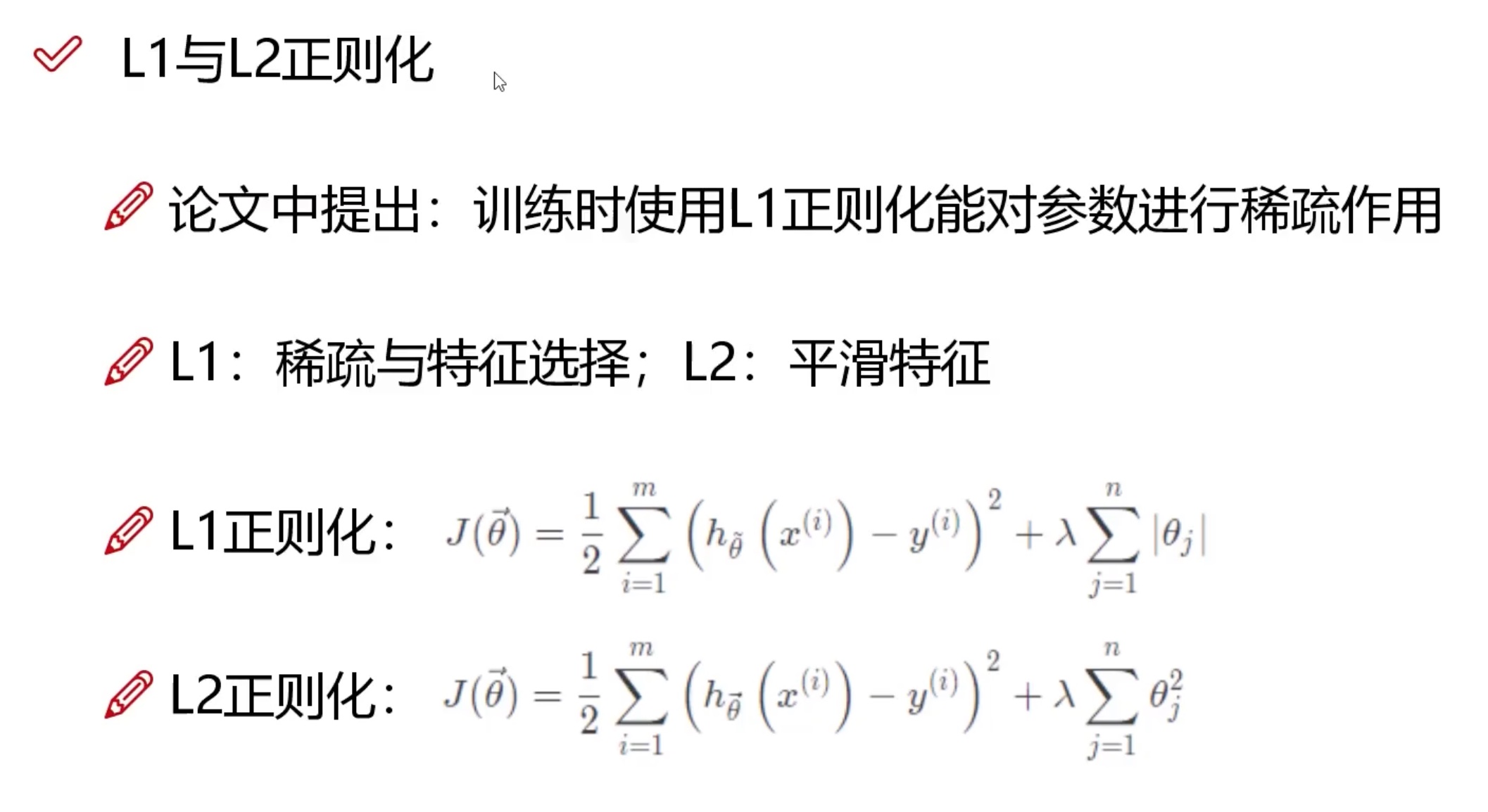

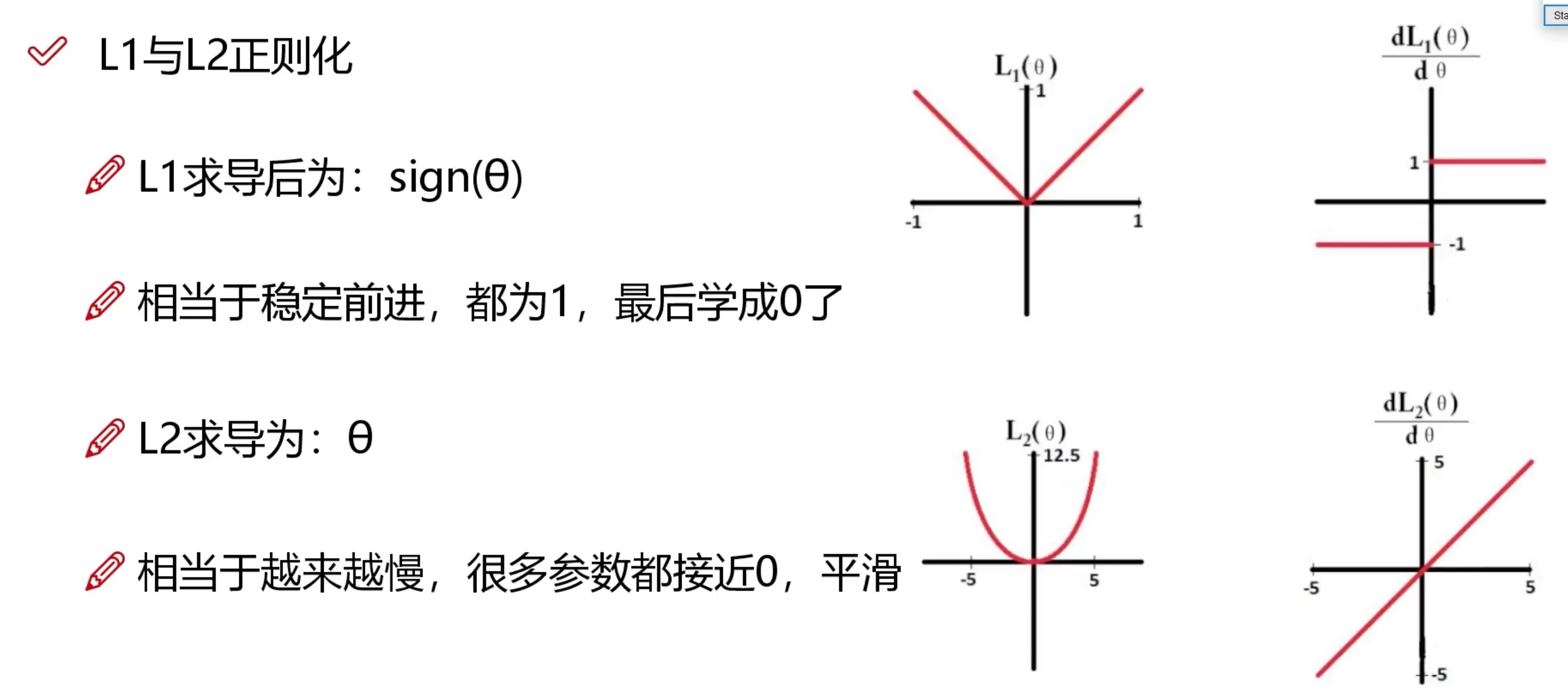

剪枝常用的正则化函数

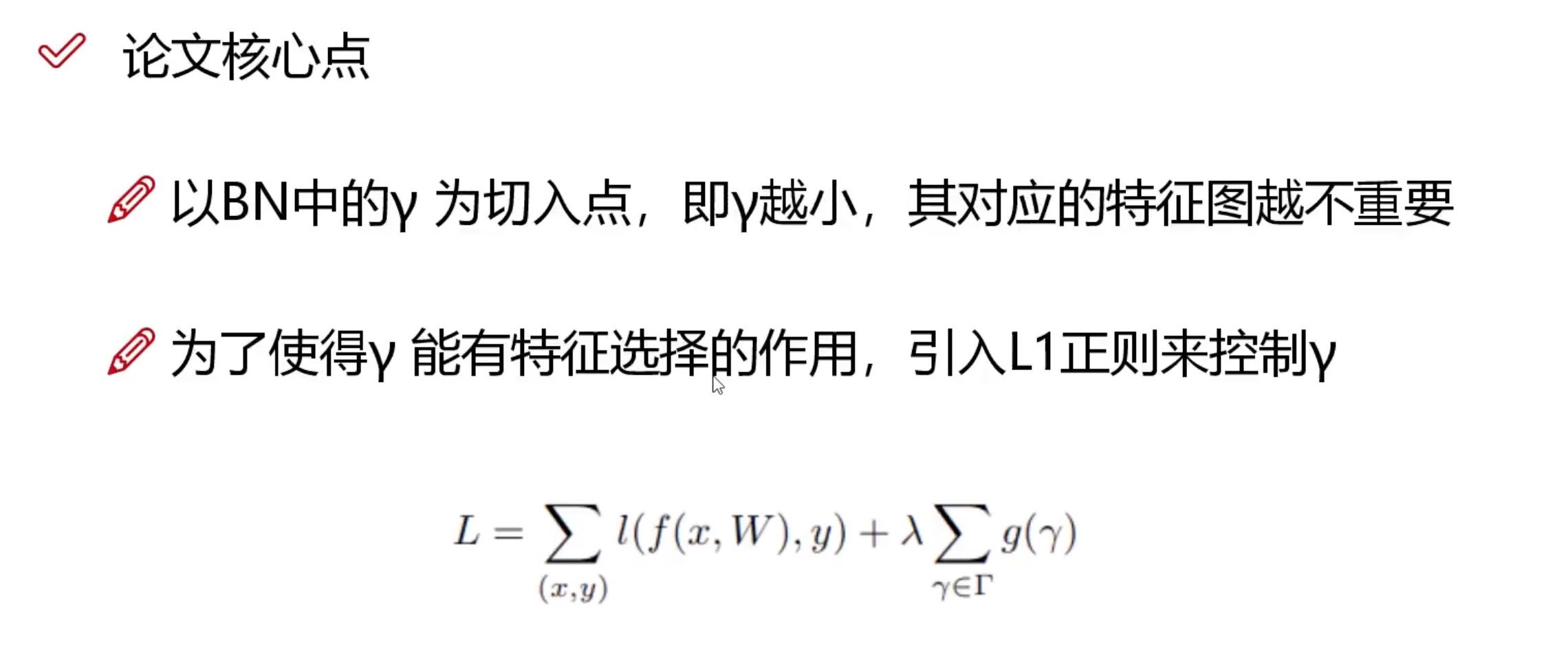

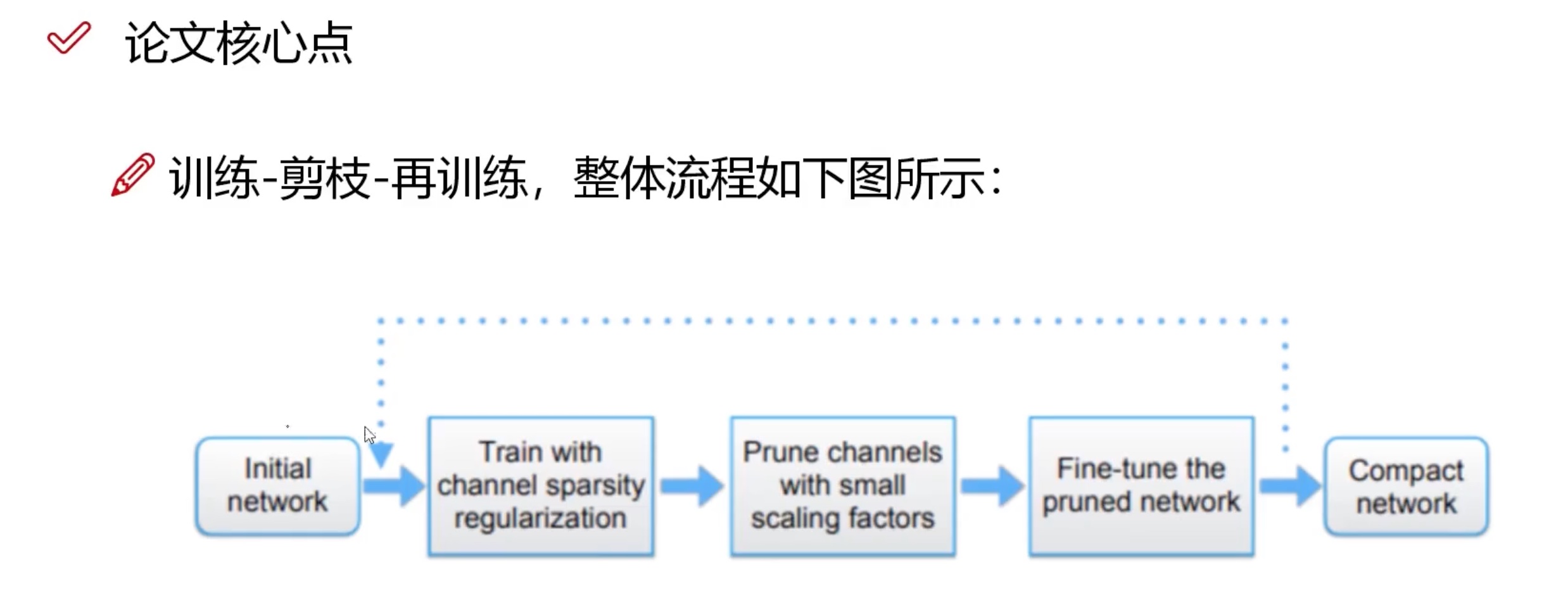

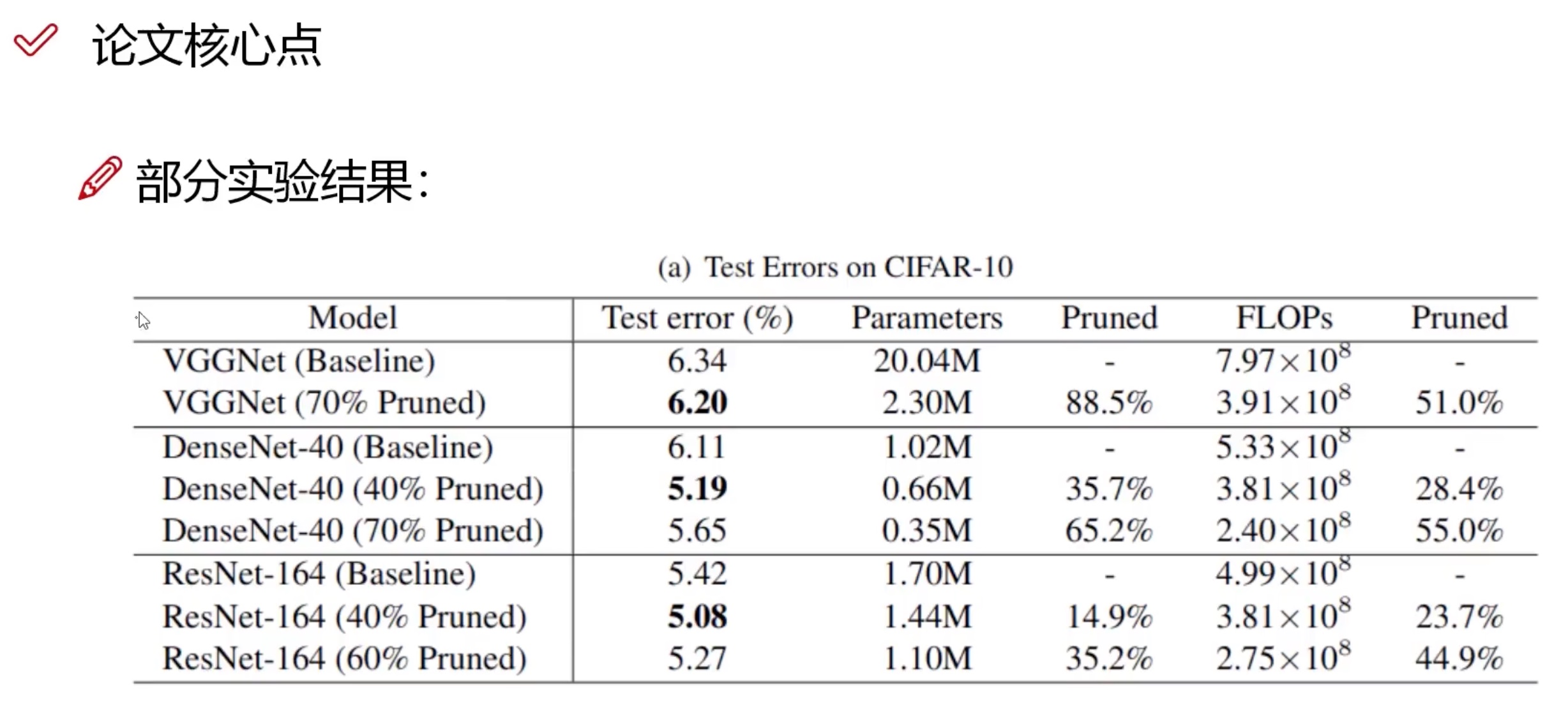

Learning Efficient Convolutional Networks through Network Slimming