来源:投稿 作者:摩卡

编辑:学姐

论文标题: Seeing Out of tHe bOx :End-to-End Pre-training for Visual-Language Representation Learning》

Motivation

本文针对目前大量Visual-Language(VL) tasks使用由Faster-RCNN提取出的region features这一问题,提出了使用region features的三个缺点:

-

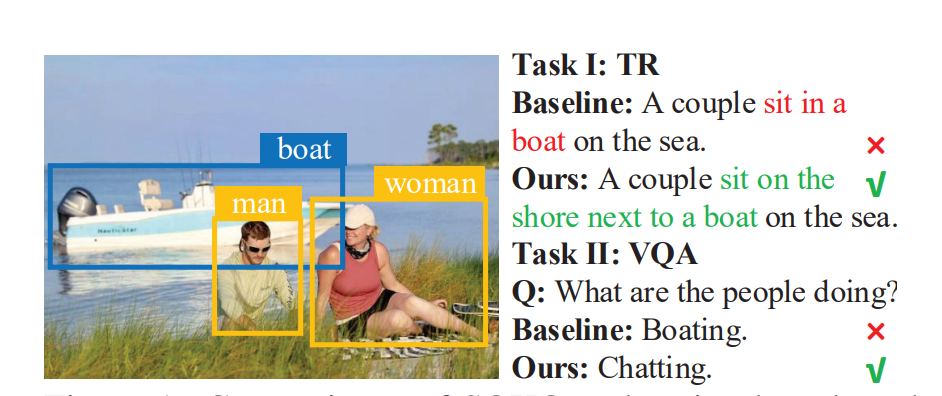

使用region features会忽略掉bounding box外的visual context,从而导致模型理解VL错误;

-

模型理解图像会受限于region features预先定义好的类别(e.g., MSCOCO数据集对bounding box定义了1600个类别);

-

由于region features由目标检测模型提取出来的会出现数据质量低,有噪声,过采样等问题。

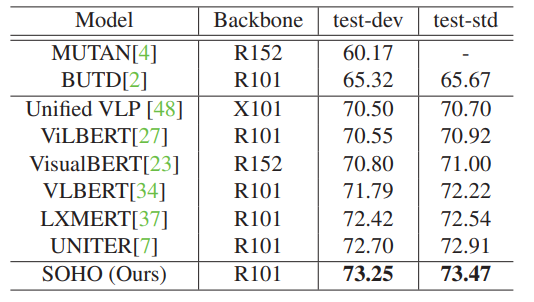

图1:在VQA任务和图像检索任务中Baseline和本文提出模型的结果对比

Method

由上述原因,本文提出了使用global features的预训练模型SOHO。此外受到语言模型字典的启发,本文提出了visual dictionary的概念,将图像特征进行聚类,每一个类别的每个图像特征都用其聚类中心的特征所代替。

做完这些工作后在其提出的三个预训练任务(Masked Language Modeling, Masked Visual Modeling, Image-Text Matching)上进行训练,每个任务的损失函数都采用同样的权重。

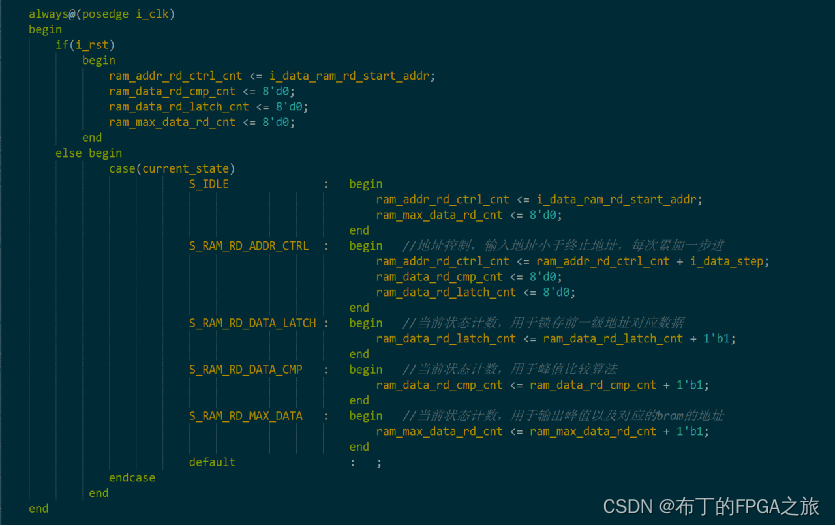

图2:SOHO模型框架

Result

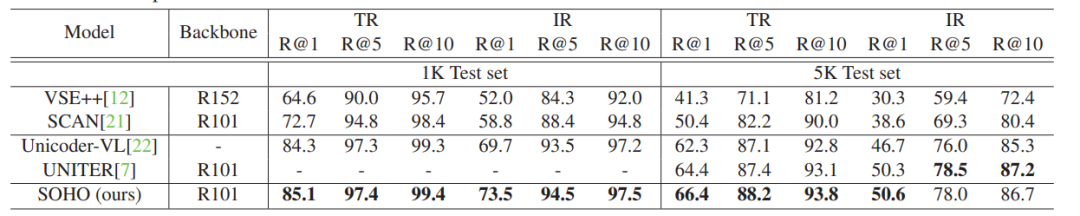

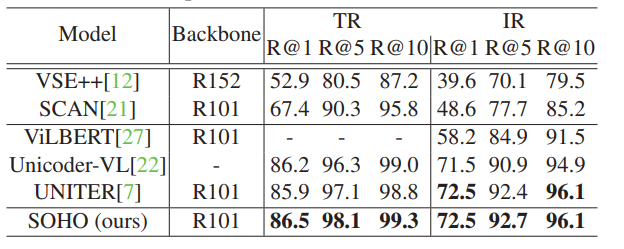

预训练完成后在下游任务上fine-tuning,分别在VQA,Image-Text Retrieval(ITR), Visual Reasoning with Natural Language(NLVR), Visual Entailment上进行验证。

在VQA任务上test-dev达到了73.25,test-std达到了73.47(相比于其基线LXMERT提高了0.83,0.93),在其他任务上也有不同程度的提高。

表1:SOHO在图像检索任务上的结果(MSCOCO dataset)

表2:SOHO在图像检索任务上的结果(Flickr30K dataset)

表3:SOHO在VQA任务上的结果

表4:SOHO在NLVR任务上的结果

最后

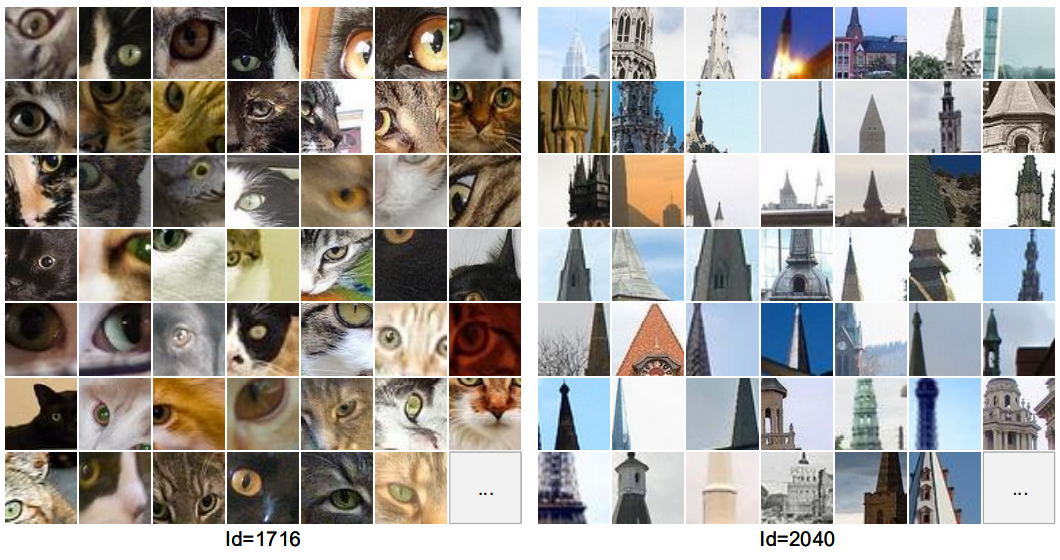

通过对视觉字典中部分 ID 对应的图片内容进行可视化(如图5所示),研究员们发现即使没有强监督的视觉类别标注,SOHO 也可以将具有相似语义的视觉内容聚类到同一个字典项中。

相对于使用基于目标检测的视觉语言模型,SOHO 摆脱了图片框的回归需求,推理时间(inference time)也加快了10倍,在真实场景应用中更加实际和便捷。

图5:Visual Dictionary 部分 ID 对应图片内容的可视化

关注下方《学姐带你玩AI》🚀🚀🚀

回复“500”获取更多经典高分论文

码字不易,欢迎大家点赞评论收藏!