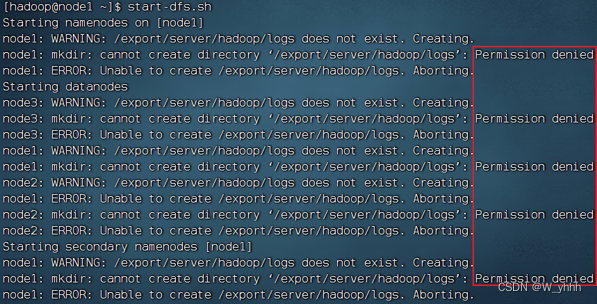

1、权限

•Permission denied(权限被拒绝)

Hadoop的运行日志在$HADOOP_HOME/logs内

也可以查看日志排错

只要出现Permission denied就是权限问题

hadoop安装文件夹或/data文件夹,未被授权给hadoop用户,所以无权限操作

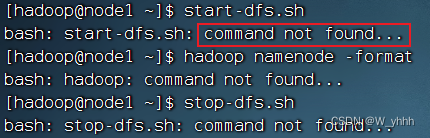

2、环境变量

•

command not found

没有配置好环境变量,导致

/export/server/ hadoop /bin/ hadoop/export/server/hadoop/sbin/start-dfs.sh & /export/server/hadoop/sbin/stop-dfs.sh

这些命令或脚本无法直接执行

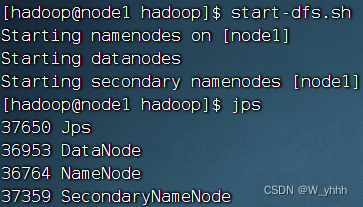

3、workers文件

•

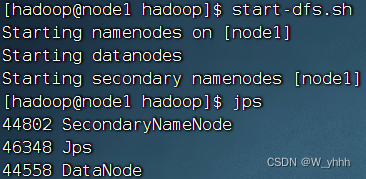

启动后仅

node1

有进程出现

•

node2

、

node3

无反应

![]()

![]()

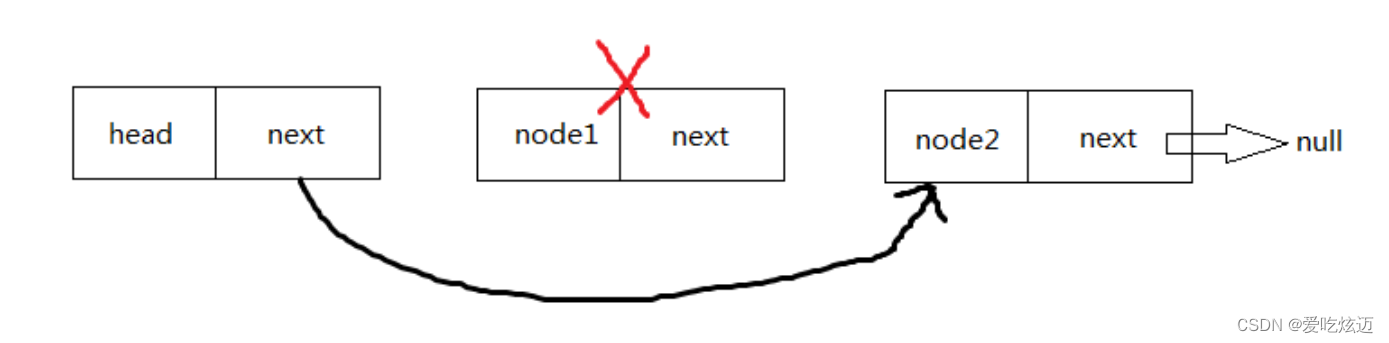

检查,是否workers文件内没有正确配置

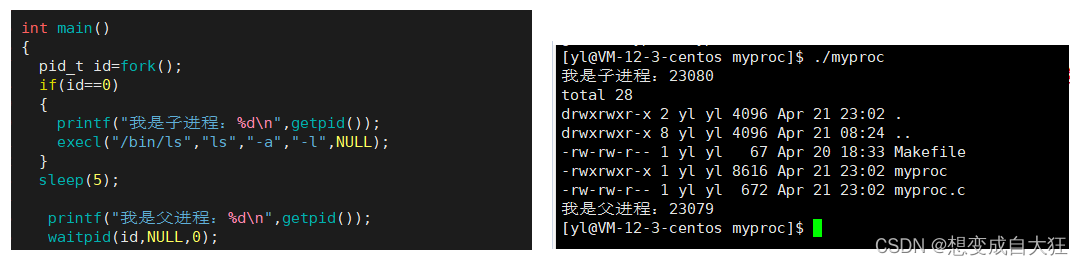

start-dfs.sh脚本会:

在当前机器启动 SecondaryNameNode ,并根据 core-site.xml 的记录启动 NameNode根据 workers 文件的记录 ,启动各个机器的 datanode

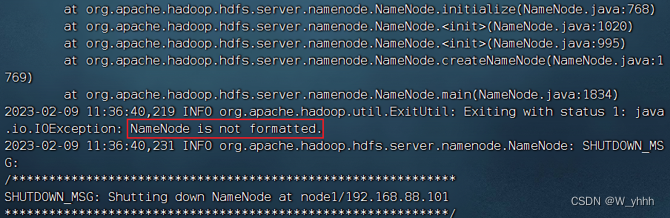

4、未格式化

•

启动后,

node1

无

NameNode

,仅有

DataNode

和

SecondaryNameNode

•

node2

、

node3

无反应

•

start-dfs.sh

脚本未报错

查看NameNode日志(/export/server/hadoop/logs/hadoop-hadoop-namenode-node1.log)提示NameNode未格式化

5、配置文件错误

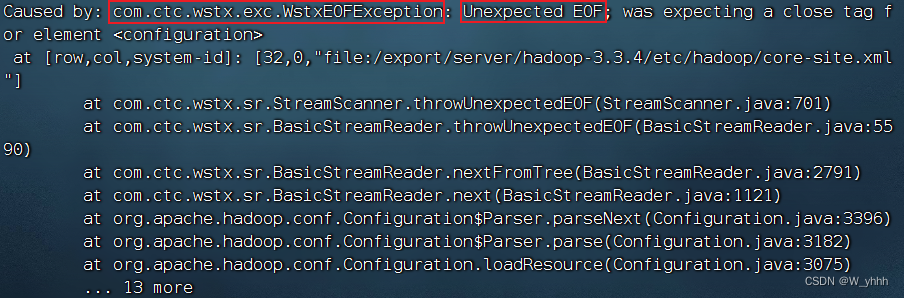

•WstxEOFException、Unexpected EOF

配置文件有问题,仔细检查每一个字符