深度学习训练营之鸟类识别

- 原文链接

- 理论知识储备

- 为什么会提出ResNet

- ResNet

- 环境介绍

- 前置工作

- 设置GPU

- 导入数据并进行查找

- 数据处理

- 可视化数据

- 配置数据集

- 残差网络的介绍

- 构建残差网络

- 模型训练

- 开始编译

- 结果可视化

- 训练样本和测试样本

- 预测

原文链接

- 🍨 本文为🔗365天深度学习训练营 中的学习记录博客

- 🍦 参考文章:365天深度学习训练营-第J1周:实现鸟类识别

动手学深度学习- 🍖 原作者:K同学啊|接辅导、项目定制

理论知识储备

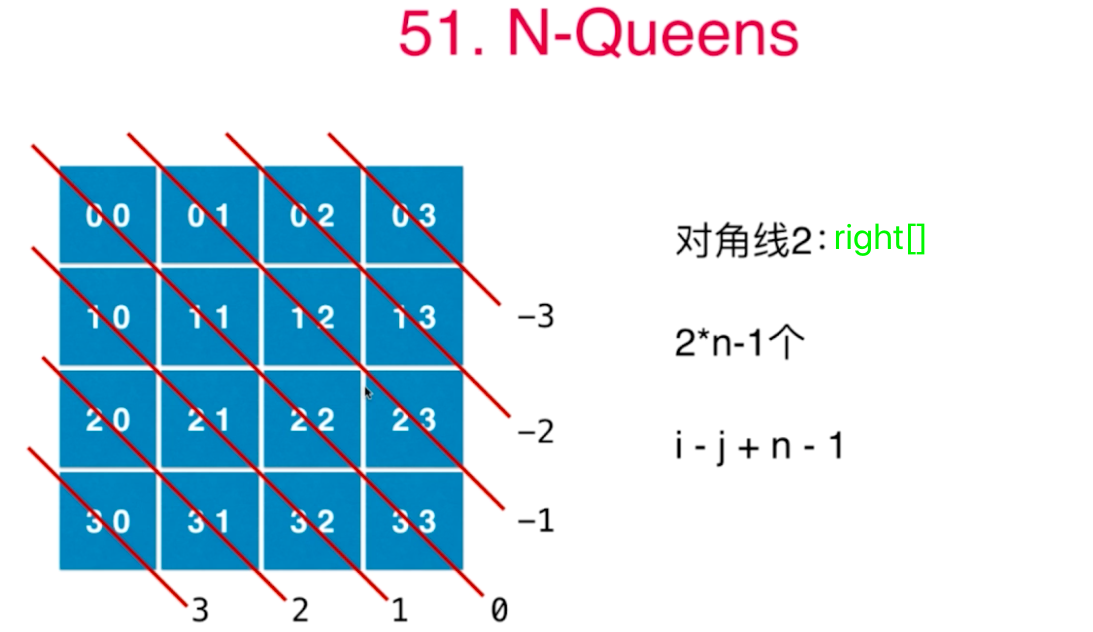

为什么会提出ResNet

简单看一下为什么会出现要提出ResNet这个方法,主要是为了解决什么样的问题?

首先,假设一类特定的神经网络架构

F

\mathcal{F}

F,它包括学习速率和其他超参数的设置,对于

∀

f

∈

F

\forall f\in \mathcal{F}

∀f∈F,存在可以在合适的训练集上进行训练而获得,假设

f

∗

f^*

f∗是需要找到的函数,但是经常存在

f

∗

∉

F

f^*\notin\mathcal{F}

f∗∈/F的问题,所以就会尝试寻找

f

F

∗

f^*_\mathcal{F}

fF∗,这是我们的最佳选择,

假设具有

X

X

X特性和

y

y

y标签的数据集,可以得到以下优化问题:

f

F

∗

:

=

argmin

f

L

(

X

,

y

,

f

)

subject to

f

∈

F

.

f_{\mathcal{F}}^{*}:=\underset{f}{\operatorname{argmin}} L(\mathbf{X}, \mathbf{y}, f) \text { subject to } f \in \mathcal{F} \text {. }

fF∗:=fargminL(X,y,f) subject to f∈F.

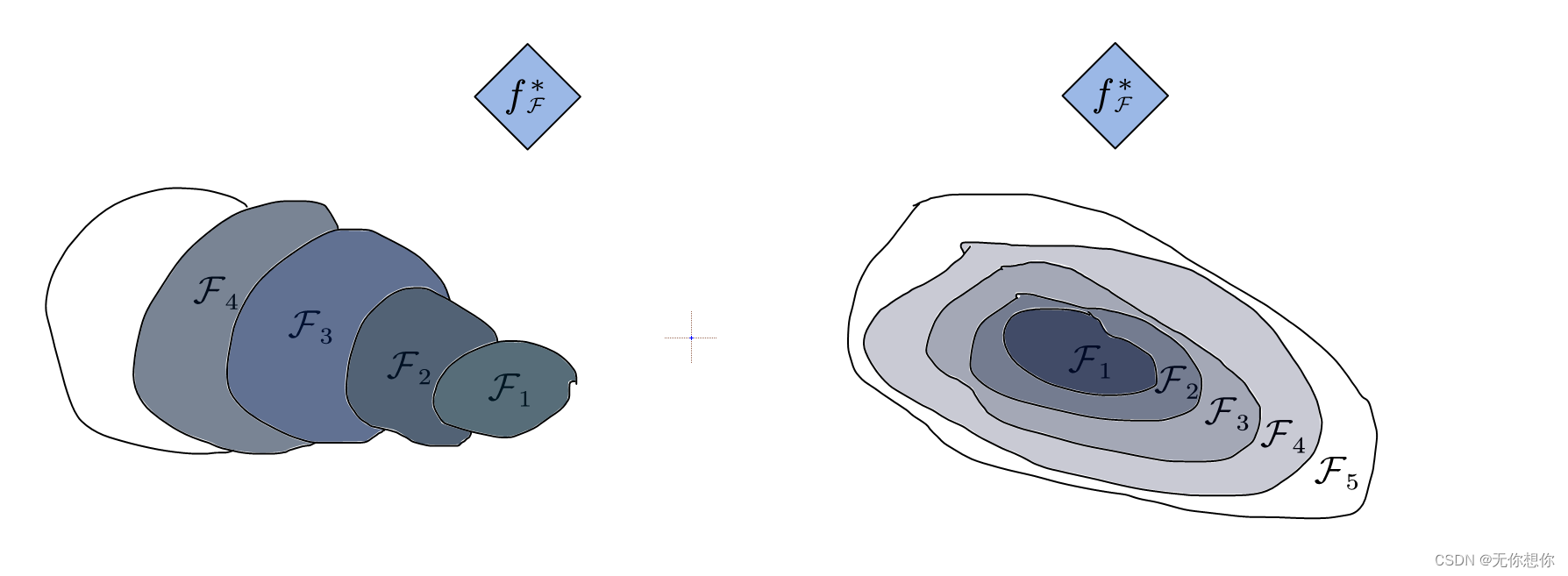

但是对于这类问题,会有如下图片的问题(图片手画,如果有问题可以和我提出,我会进行改进)对于非嵌套函数类,较为复杂的函数类并不一定可以更加接近我们需要的函数,但是在嵌套函数类当中不会发生这种问题

所以,只有当较为复杂的函数类包含较少的函数类时,我们才能确保提高其性能,对于深度神经网络,如果我们能将新添加的层训练成恒等映射(identity function)

f

(

x

)

=

x

f(x)=x

f(x)=x,新模型和原模型将同样有效,此时,由于新模型可能得出更优解来拟合训练数据集,添加层可以更容易降低训练误差

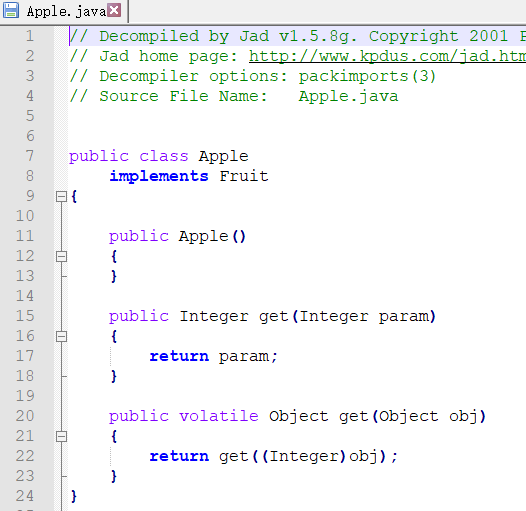

ResNet

深度残差网络Resnet(deep residual network)在2015年由何恺明等提出,因为其简单和使用,在随后的很多研究当中都发挥了重要的作用,其核心思想是:每个附加层都应该更容易地包含原始函数作为其元素之一

ResNet的重要意义就在与解决深度卷积网络在深度加深的时候的退化问题,在一般的卷积神经网络当中,增大网络深度带来的第一个问题就在于梯度消失,爆炸,这个在被Szegedy提出BN后得到的解决,BN层能对各层输出做归一化,这样梯度在方向层层传递后仍然能保持大小问题

BN提出的问题:准确率下降问题,由于当层数达到一定的大小时,网络过于复杂,以至于光靠不加约束的放养式训练很难达到理想的错误率.现阶段无论是SGD,RMSProp等方法都无法在网络深度提高之后达到理论上最优的收敛结果,可以简单证明出,网络A添加几层后形成新的网络B,变化较为简单,比如identity mapping,那么结果的错误率是相等的,也说明了加深之后的网路不会比加深前的网络效果差

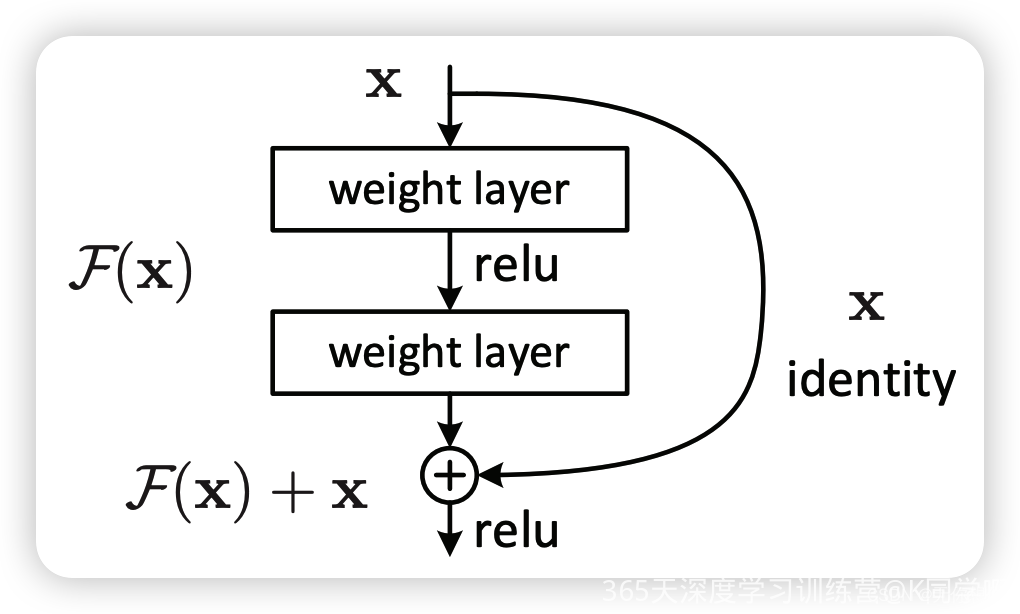

何恺明提出一种残差网络来实现上述恒等映射,除了正常的卷积层输出以外,还有一条跳过卷积层直接连接到输出上,该分支输出和卷积的输出进行简单的加法运算得到最终的输出(注:ResNet重要的就在于这一点,因为只是简单的加法运算,在整体的计算过程当中不会有太大的计算复杂度),公式表达式如下:

H

(

x

)

=

F

(

x

)

+

x

H(x)=F(x)+x

H(x)=F(x)+x

x

x

x表示输入,

F

(

x

)

F(x)

F(x)表示卷积的输出,

H

(

x

)

H(x)

H(x)表示整个结构的输出,可以得出如果

F

(

x

)

F(x)

F(x)分支所有的参数都是0,那么

H

(

x

)

H(x)

H(x)就是一个恒等映射.

残差结构人为制造恒等映射,就能让整个结构向恒等映射的方向去收敛,最终确保错误率不会因为深度的变大而很差

通过简单的人为设置参数值得到想要的结果,这种结构就很容易通过训练来收敛到结果,这是一条设计复杂的网络时通用的规则

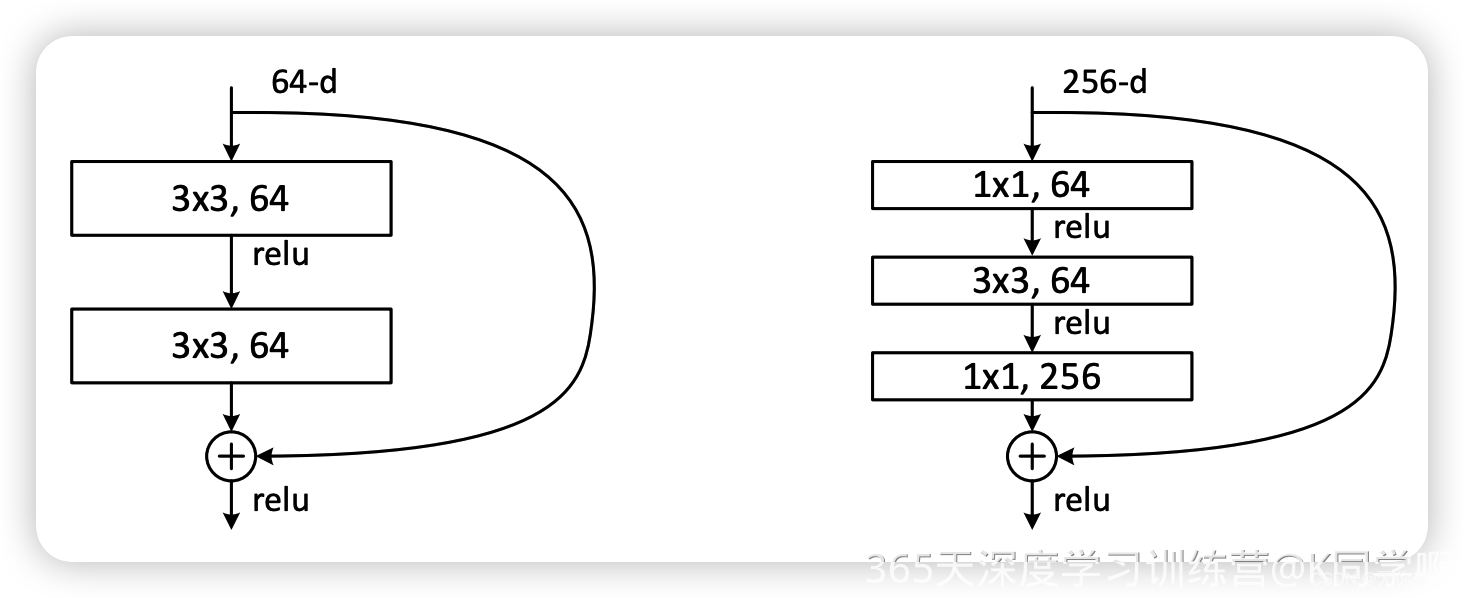

ResNet可以往更深的网络进行拓展,可以简单的看到图中先使用1*1卷积进行降维ui,然后3*3卷积,然后使用1*1升维恢复到原有维度。

三层的残差单元对于相同的数量层减少了参数量,所以在更深的模型是避免了大部分的计算

环境介绍

- 语言环境:Python3.9.13

- 编译器:jupyter notebook

- 深度学习环境:TensorFlow2

前置工作

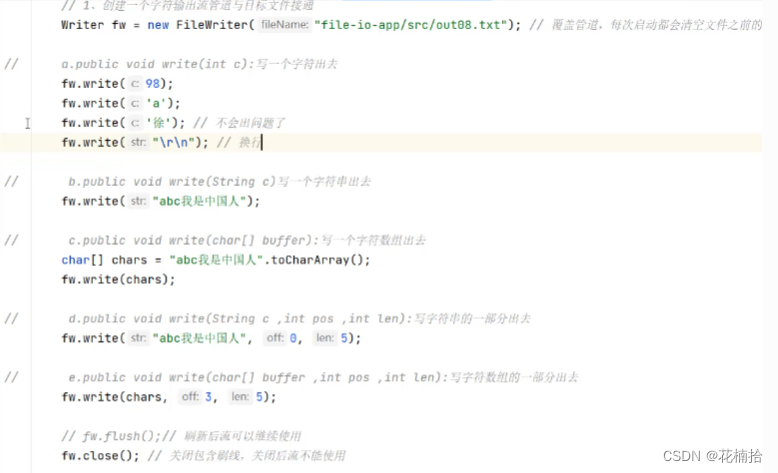

设置GPU

使用gpu可以加快运行速度

#设置gpu

import tensorflow as tf

gpus = tf.config.list_physical_devices("GPU")

if gpus:

tf.config.experimental.set_memory_growth(gpus[0], True) #设置GPU显存用量按需使用

tf.config.set_visible_devices([gpus[0]],"GPU")

导入数据并进行查找

# 导入数据

import matplotlib.pyplot as plt

# 支持中文

plt.rcParams['font.sans-serif'] = ['SimHei'] # 用来正常显示中文标签

plt.rcParams['axes.unicode_minus'] = False # 用来正常显示负号

import os,PIL

# 设置随机种子尽可能使结果可以重现

import numpy as np

np.random.seed(1)

# 设置随机种子尽可能使结果可以重现

import tensorflow as tf

tf.random.set_seed(1)

from tensorflow import keras

from tensorflow.keras import layers,models

import pathlib

查看数据

data_dir = "D:/BaiduNetdiskDownload/第8天-没有加密版本/第8天/bird_photos"

data_dir = pathlib.Path(data_dir)

#3. 查看数据

image_count = len(list(data_dir.glob('*/*')))

print("图片总数为:",image_count)

我们可以知道一共有565张照片

数据处理

| 文件夹 | 数量 |

|---|---|

| Bananaquit | 166 张 |

| Black Throated Bushtiti | 111 张 |

| Black skimmer | 122 张 |

| Cockatoo | 166张 |

对数据进行加载操作

使用image_dataset_from_directory方法将磁盘中的数据加载到tf.data.Dataset中

batch_size = 8

img_height = 224

img_width = 224

"""

关于image_dataset_from_directory()的详细介绍可以参考文章:https://mtyjkh.blog.csdn.net/article/details/117018789

"""

train_ds = tf.keras.preprocessing.image_dataset_from_directory(

data_dir,

validation_split=0.2,

subset="training",

seed=123,

image_size=(img_height, img_width),

batch_size=batch_size)

#使用当中的452张进行训练

使用当中的452张进行训练

"""

关于image_dataset_from_directory()的详细介绍可以参考文章:https://mtyjkh.blog.csdn.net/article/details/117018789

"""

val_ds = tf.keras.preprocessing.image_dataset_from_directory(

data_dir,

validation_split=0.2,

subset="validation",

seed=123,

image_size=(img_height, img_width),

batch_size=batch_size)

使用113张进行预测操作

# 使用class_name输出数据集的标签

class_names = train_ds.class_names

print(class_names)

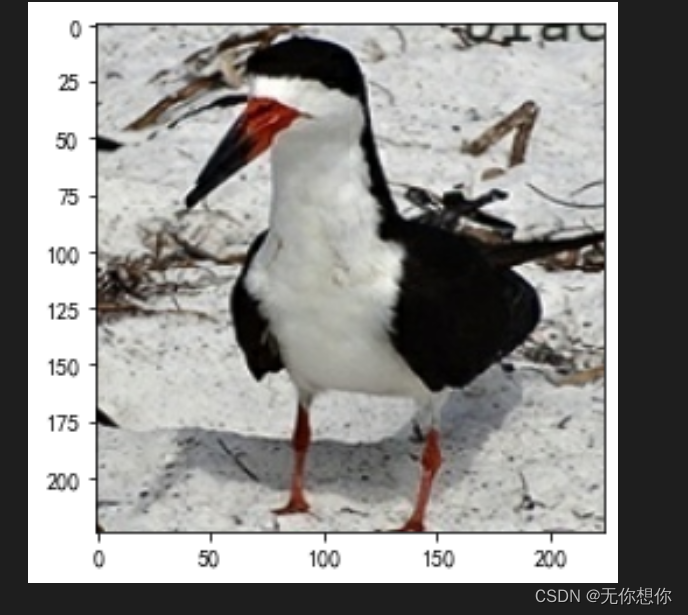

可视化数据

plt.figure(figsize=(10, 5)) # 图形的宽为10高为5

plt.suptitle("无你想你的学习训练")

for images, labels in train_ds.take(1):

for i in range(8):

ax = plt.subplot(2, 4, i + 1)

plt.imshow(images[i].numpy().astype("uint8"))

plt.title(class_names[labels[i]])

plt.axis("off")

plt.imshow(images[4].numpy().astype("uint8"))

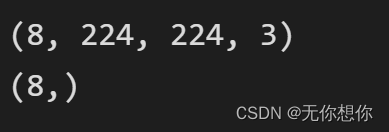

再次对数据进行检查

for image_batch, labels_batch in train_ds:

print(image_batch.shape)

print(labels_batch.shape)

break

- Image_batch是形状的张量(8, 224, 224, 3)。这是一批形状240x240x3的8张图片(最后一维指的是彩色通道RGB)。

- Label_batch是形状(8,)的张量,这些标签对应8张图片

配置数据集

- shuffle() :打乱数据,关于此函数的详细介绍可以参考:https://zhuanlan.zhihu.com/p/42417456

- prefetch() :预取数据,加速运行,其详细介绍可以参考我前两篇文章,里面都有讲解。

- cache() :将数据集缓存到内存当中,加速运行

AUTOTUNE = tf.data.AUTOTUNE

train_ds = train_ds.cache().shuffle(1000).prefetch(buffer_size=AUTOTUNE)

val_ds = val_ds.cache().prefetch(buffer_size=AUTOTUNE)

残差网络的介绍

残差网络是为了解决神经网络隐藏层过多时,而引起的网络退化问题。退化(degradation)问题是指:当网络隐藏层变多时,网络的准确度达到饱和然后急剧退化,而且这个退化不是由于过拟合引起的。

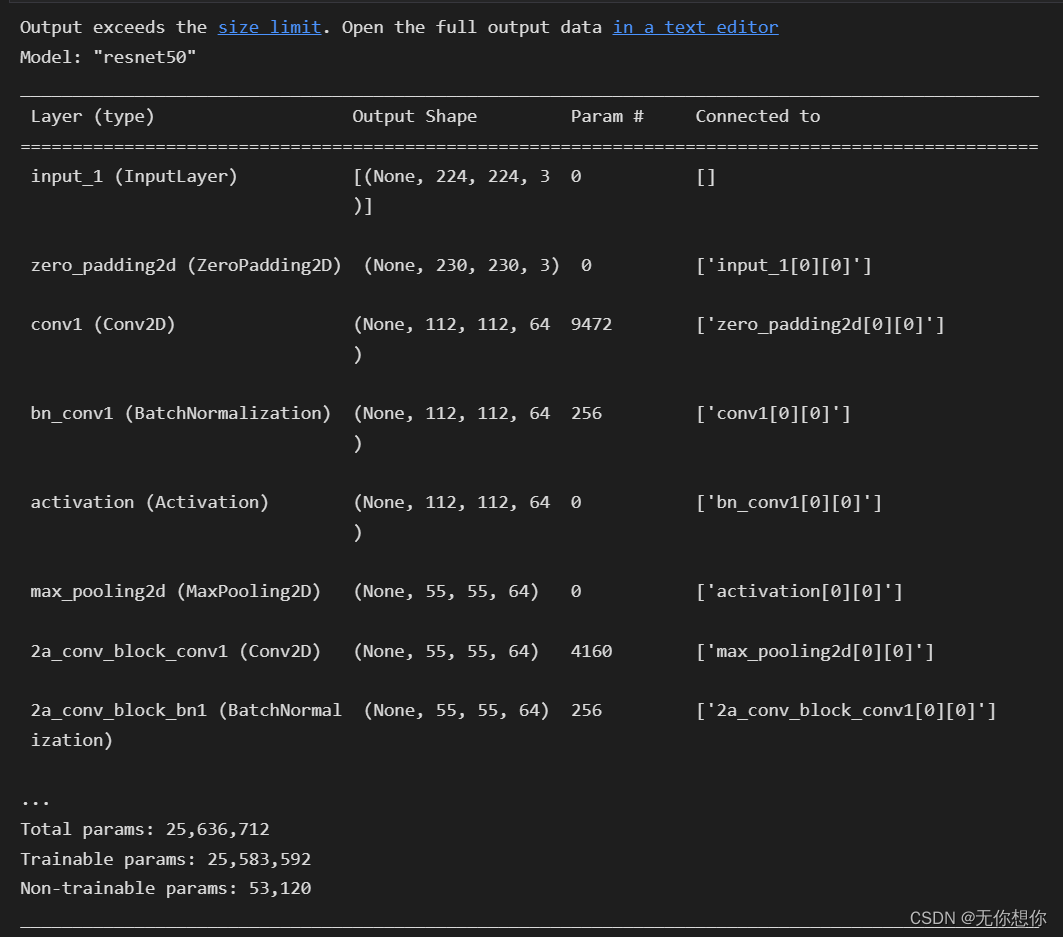

构建残差网络

from keras import layers

from keras.layers import Input,Activation,BatchNormalization,Flatten

from keras.layers import Dense,Conv2D,MaxPooling2D,ZeroPadding2D,AveragePooling2D

from keras.models import Model

def identity_block(input_tensor, kernel_size, filters, stage, block):

filters1, filters2, filters3 = filters

name_base = str(stage) + block + '_identity_block_'

x = Conv2D(filters1, (1, 1), name=name_base + 'conv1')(input_tensor)

x = BatchNormalization(name=name_base + 'bn1')(x)

x = Activation('relu', name=name_base + 'relu1')(x)

x = Conv2D(filters2, kernel_size,padding='same', name=name_base + 'conv2')(x)

x = BatchNormalization(name=name_base + 'bn2')(x)

x = Activation('relu', name=name_base + 'relu2')(x)

x = Conv2D(filters3, (1, 1), name=name_base + 'conv3')(x)

x = BatchNormalization(name=name_base + 'bn3')(x)

x = layers.add([x, input_tensor] ,name=name_base + 'add')

x = Activation('relu', name=name_base + 'relu4')(x)

return x

def conv_block(input_tensor, kernel_size, filters, stage, block, strides=(2, 2)):

filters1, filters2, filters3 = filters

res_name_base = str(stage) + block + '_conv_block_res_'

name_base = str(stage) + block + '_conv_block_'

x = Conv2D(filters1, (1, 1), strides=strides, name=name_base + 'conv1')(input_tensor)

x = BatchNormalization(name=name_base + 'bn1')(x)

x = Activation('relu', name=name_base + 'relu1')(x)

x = Conv2D(filters2, kernel_size, padding='same', name=name_base + 'conv2')(x)

x = BatchNormalization(name=name_base + 'bn2')(x)

x = Activation('relu', name=name_base + 'relu2')(x)

x = Conv2D(filters3, (1, 1), name=name_base + 'conv3')(x)

x = BatchNormalization(name=name_base + 'bn3')(x)

shortcut = Conv2D(filters3, (1, 1), strides=strides, name=res_name_base + 'conv')(input_tensor)

shortcut = BatchNormalization(name=res_name_base + 'bn')(shortcut)

x = layers.add([x, shortcut], name=name_base+'add')

x = Activation('relu', name=name_base+'relu4')(x)

return x

def ResNet50(input_shape=[224,224,3],classes=1000):

img_input = Input(shape=input_shape)

x = ZeroPadding2D((3, 3))(img_input)

x = Conv2D(64, (7, 7), strides=(2, 2), name='conv1')(x)

x = BatchNormalization(name='bn_conv1')(x)

x = Activation('relu')(x)

x = MaxPooling2D((3, 3), strides=(2, 2))(x)

x = conv_block(x, 3, [64, 64, 256], stage=2, block='a', strides=(1, 1))

x = identity_block(x, 3, [64, 64, 256], stage=2, block='b')

x = identity_block(x, 3, [64, 64, 256], stage=2, block='c')

x = conv_block(x, 3, [128, 128, 512], stage=3, block='a')

x = identity_block(x, 3, [128, 128, 512], stage=3, block='b')

x = identity_block(x, 3, [128, 128, 512], stage=3, block='c')

x = identity_block(x, 3, [128, 128, 512], stage=3, block='d')

x = conv_block(x, 3, [256, 256, 1024], stage=4, block='a')

x = identity_block(x, 3, [256, 256, 1024], stage=4, block='b')

x = identity_block(x, 3, [256, 256, 1024], stage=4, block='c')

x = identity_block(x, 3, [256, 256, 1024], stage=4, block='d')

x = identity_block(x, 3, [256, 256, 1024], stage=4, block='e')

x = identity_block(x, 3, [256, 256, 1024], stage=4, block='f')

x = conv_block(x, 3, [512, 512, 2048], stage=5, block='a')

x = identity_block(x, 3, [512, 512, 2048], stage=5, block='b')

x = identity_block(x, 3, [512, 512, 2048], stage=5, block='c')

x = AveragePooling2D((7, 7), name='avg_pool')(x)

x = Flatten()(x)

x = Dense(classes, activation='softmax', name='fc1000')(x)

model = Model(img_input, x, name='resnet50')

# 加载预训练模型

model.load_weights("resnet50_weights_tf_dim_ordering_tf_kernels.h5")

return model

model = ResNet50()

model.summary()

模型训练

开始编译

- 损失函数(loss):用于衡量模型在训练期间的准确率。

- 优化器(optimizer):决定模型如何根据其看到的数据和自身的损失函数进行更新。

- 指标(metrics):用于监控训练和测试步骤。以下示例使用了准确率,即被正确分类的图像的比率

# 设置优化器,我这里改变了学习率。

opt = tf.keras.optimizers.Adam(learning_rate=1e-7)

model.compile(optimizer="adam",

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

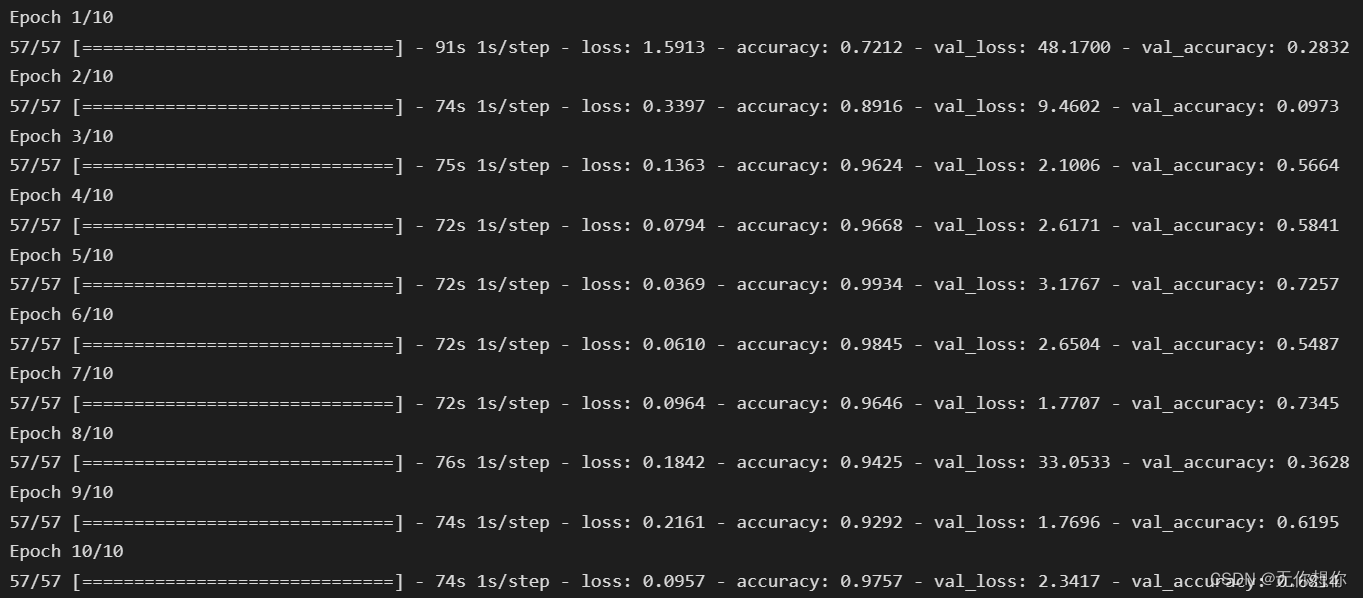

开始训练

epochs = 10

history = model.fit(

train_ds,

validation_data=val_ds,

epochs=epochs

)

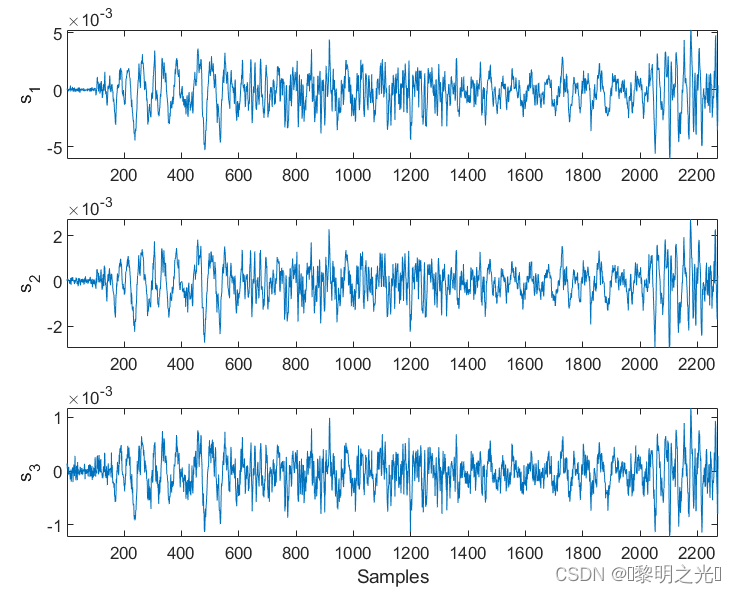

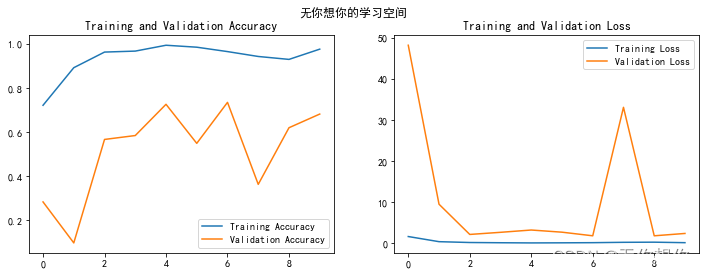

结果可视化

训练样本和测试样本

acc = history.history['accuracy']

val_acc = history.history['val_accuracy']

loss = history.history['loss']

val_loss = history.history['val_loss']

epochs_range = range(epochs)

plt.figure(figsize=(12, 4))

plt.subplot(1, 2, 1)

plt.suptitle("无你想你的学习空间")

plt.plot(epochs_range, acc, label='Training Accuracy')

plt.plot(epochs_range, val_acc, label='Validation Accuracy')

plt.legend(loc='lower right')

plt.title('Training and Validation Accuracy')

plt.subplot(1, 2, 2)

plt.plot(epochs_range, loss, label='Training Loss')

plt.plot(epochs_range, val_loss, label='Validation Loss')

plt.legend(loc='upper right')

plt.title('Training and Validation Loss')

plt.show()

预测

# 保存模型

model.save('model/my_model.h5')

# 加载模型

new_model = keras.models.load_model('model/my_model.h5')

# 采用加载的模型(new_model)来看预测结果

plt.figure(figsize=(10, 5)) # 图形的宽为10高为5

plt.suptitle("无你想你的学习空间")

for images, labels in val_ds.take(1):

for i in range(8):

ax = plt.subplot(2, 4, i + 1)

# 显示图片

plt.imshow(images[i].numpy().astype("uint8"))

# 需要给图片增加一个维度

img_array = tf.expand_dims(images[i], 0)

# 使用模型预测图片中的人物

predictions = new_model.predict(img_array)

plt.title(class_names[np.argmax(predictions)])

plt.axis("off")