本人环境

Ubuntu18.04,3090显卡,显卡驱动版本510.85.02,cuda版本11.6,docker版本20.10.12(注意:docker一定要通过apt安装,用snap安装会报错)

安装步骤

1. 根据驱动版本和cuda版本下载对应版本的Triton Docker 镜像,版本对应关系参照:Release Notes :: NVIDIA Deep Learning Triton Inference Server Documentation

执行以下命令, 注意将“22.01”换成你自己对应的版本。

$ docker pull nvcr.io/nvidia/tritonserver:22.01-py32. 下载模型库例程,注意将“22.01”换成你自己对应的版本。

$ git clone -b r22.01 https://github.com/triton-inference-server/server.git

$ cd server/docs/examples

$ ./fetch_models.sh3. 从 NGC Triton 容器中启动 triton

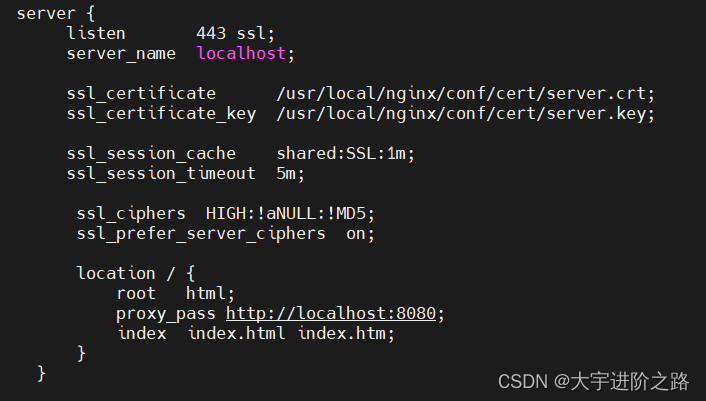

注意${PWD}/model_repository:/models是将当前路径下的model_repository文件夹挂载到容器的/model路径下,所以该命令要在路径 server/docs/examples下执行。注意将“22.01”换成你自己对应的版本。

$ cd server/docs/examples

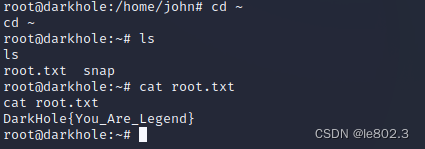

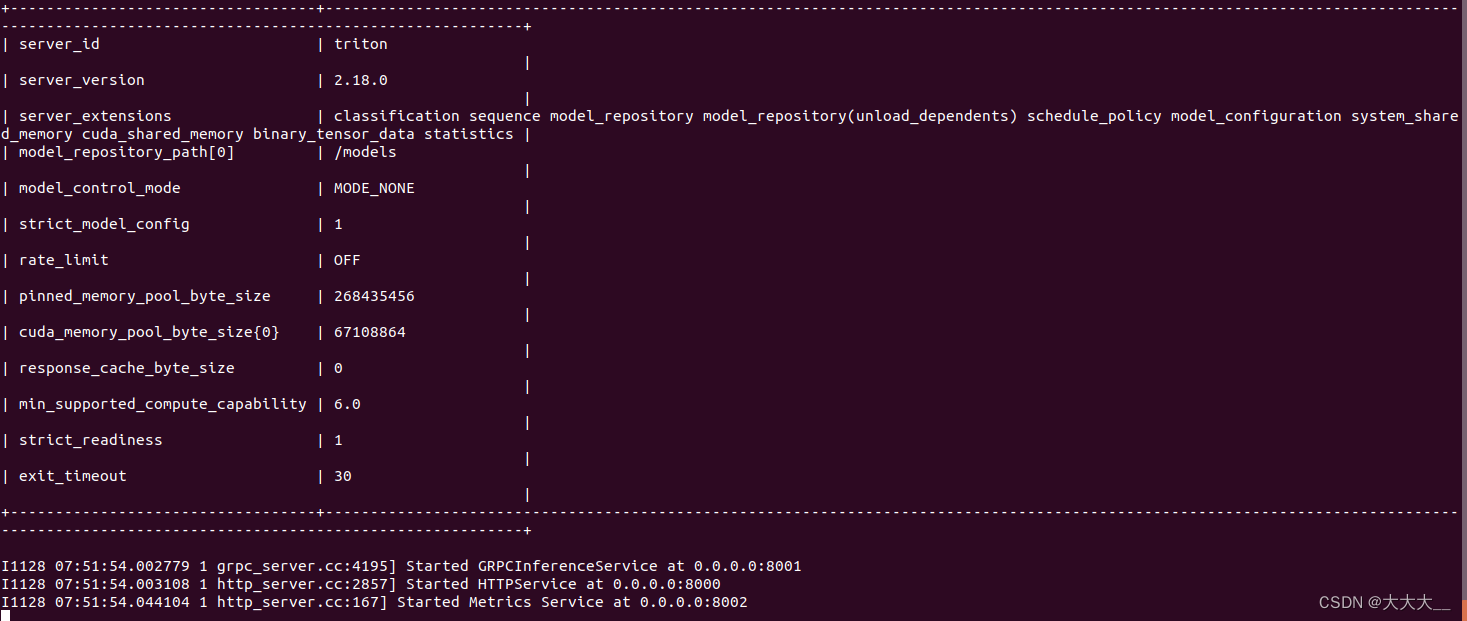

$ sudo docker run --gpus=0 --rm --net=host -v ${PWD}/model_repository:/models nvcr.io/nvidia/tritonserver:22.01-py3 tritonserver --model-repository=/models执行成功出现如下图所示结果:

4. 新建一个命令控制台,从 NGC Triton SDK 容器启动 image_client 示例

注意将“22.01”换成你自己对应的版本。

$ sudo docker run -it --rm --net=host nvcr.io/nvidia/tritonserver:22.01-py3-sdk执行成功后进入容器,然后再运行以下命令:

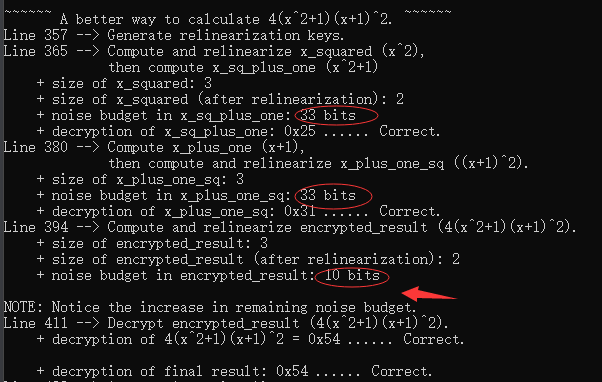

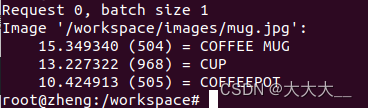

$ /workspace/install/bin/image_client -m densenet_onnx -c 3 -s INCEPTION /workspace/images/mug.jpg执行成功后结果如下图所示:

![[附源码]SSM计算机毕业设计网上鞋店管理系统JAVA](https://img-blog.csdnimg.cn/ddf9a1a15a4d4274b953fd41546d855c.png)

![[美国访问学者J1]签证的材料准备](https://img-blog.csdnimg.cn/f2acfe7e22034b488c3fadf372a1eede.jpeg)