Tip:仅供自己学习记录,酌情参考

1. 前馈与反馈神经网络

神经网络有前馈神经网络和反馈神经网络,前向神经网络也就是前馈神经网络。

前馈型神经网络各神经元接收前一层的输入,并输出给下一层,没有反馈。节点分为两类,即输入节点和计算节点,每一个计算节点可有多个输入,但只有一个输出,通常前馈型网络可分为不同的层,第i层的输入只与第i-1层的输出相连,输入与输出节点与外界相连,而其他中间层则称为隐层。

反馈型网络所有节点都是计算节点,同时可接收输入,并向外界输出。常见的前馈神经网络有BP网络,RBF网络等。

我不懂我在论文里写卷积神经网络是一种前向(前馈)神经网络被怼了,确实网络里有反向传播;但是网上或者论文里都默认这句话正确不是???(懂得老哥解释下不5555)

2.卷积神经网络各层含义

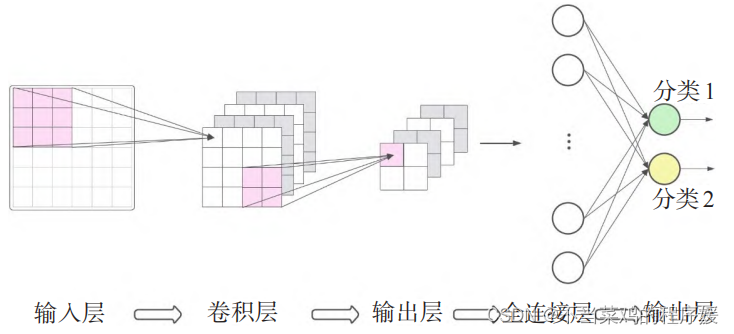

使用卷积的神经网络通常包括卷积层、池化层、全连接层和输出层,其架构如图所示。

卷积层的作用主要是对一个范围内的特征进行特征值的提取,使用不同的过滤器进行卷积操作之后能对同一个图像进行多次特征值提取而不会导致数据量的过度增加,能更好地对图像的特征值进行分解和利用,在此基础上结合非线性激活函数能更好地去除数据的冗余。

池化层的作用是对输入的Feature Map做下采样,减少每层的样本数量,得到更小的 Feature Map,以进行后续的卷积、池化操作;利用池化函数将邻近的特征进行总体的输出,得到近似不变的结果同时进一步提高网络的效率(降维,防止过拟合)。

全连接层可以将前面各层得到的抽象化的特征进行整合和归一化,得到高度提纯的特征分类概率(输出结果)。

输出层一般是根据实际需要进行的分类任务而设置的输出,可以直接根据输出的结果进行分类任务的结果确认。

3. LeNet

LeNet在1998年被提出,是进行手写数字识别的网络。它有连续的卷积层和池化层(正确地讲,是只“抽选元素”的子采样层),最后经全连接层输出结果(Gradient-based learning applied to document recognition)。

和“现在的CNN”相比,LeNet有几个不同点。第一个不同点在于激活函数。LeNet中使用sigmoid函数,而现在的CNN中主要使用ReLU函数。

此外,原始的LeNet中使用子采样(subsampling)缩小中间数据的大小,而现在的CNN中Max池化是主流。

4.AlexNet

在LeNet问世20多年后,AlexNet被发布出来。AlexNet是引发深度学习热潮的导火线,不过它的网络结构和LeNet基本上没有什么不同(ImageNet Classification with Deep Convolutional Neural Networks)。

AlexNet叠有多个卷积层和池化层,最后经由全连接层输出结果。虽然结构上AlexNet和LeNet没有大的不同,但有以下几点差异。

- 使用

ReLU激活函数加速收敛 - 使用

GPU并行,加速训练。也为之后的分组卷积(group convolution)理论奠定基础。 - 提出局部响应归一化(

Local Response Normalization,LRN)增加泛化特性 (虽然被后人证明无效 ) - 使用交叠池化 (

Overlapping Pooling) 防止过拟合 - 提出

Dropout,数据增强等手段防止过拟合

百度安全验证

百度安全验证