本篇文章从外行工科的角度尽量详细剖析激活函数,希望不吝指教!

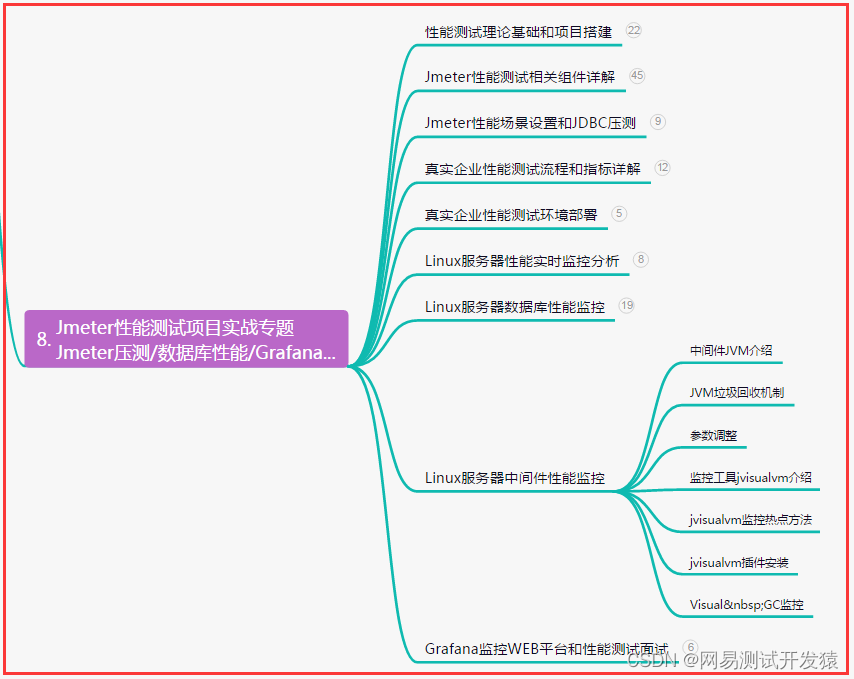

学习过程如下,先知道这个东西是什么,有什么用处,以及怎么使用它:

1. 为什么使用激活函数

2. 激活函数总类及优缺点

3. 如何选择激活函数

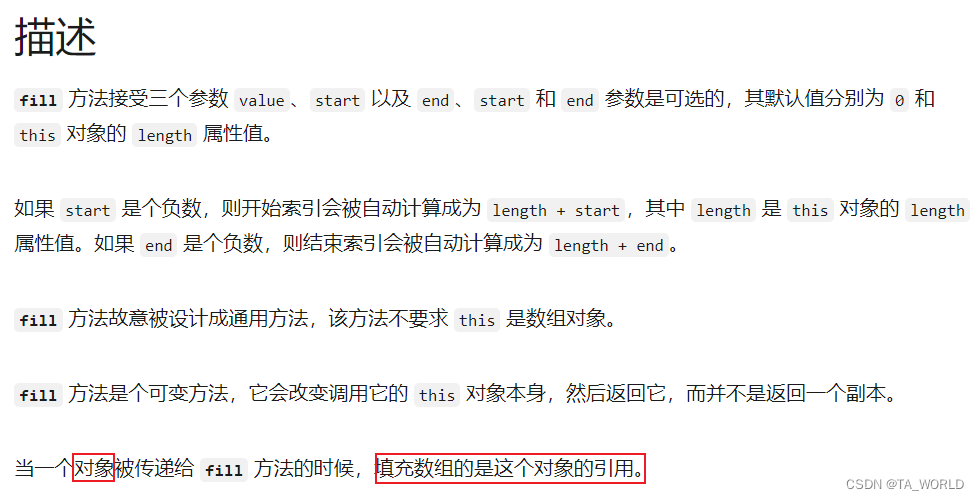

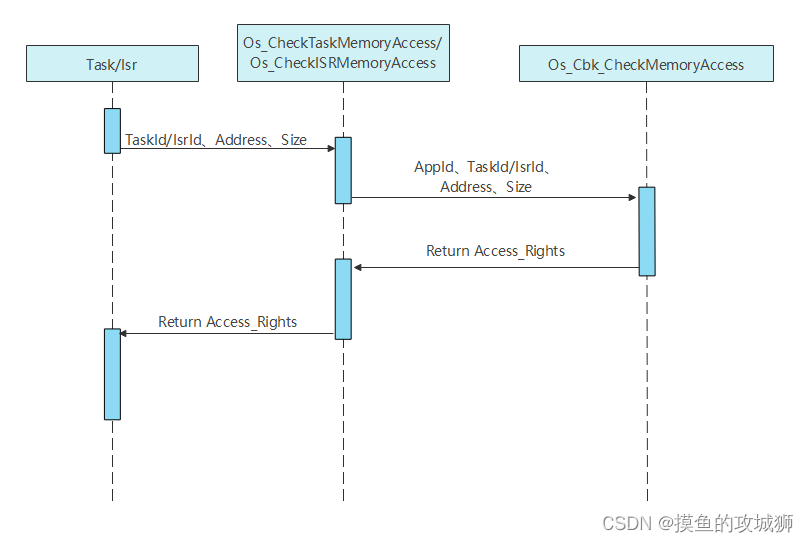

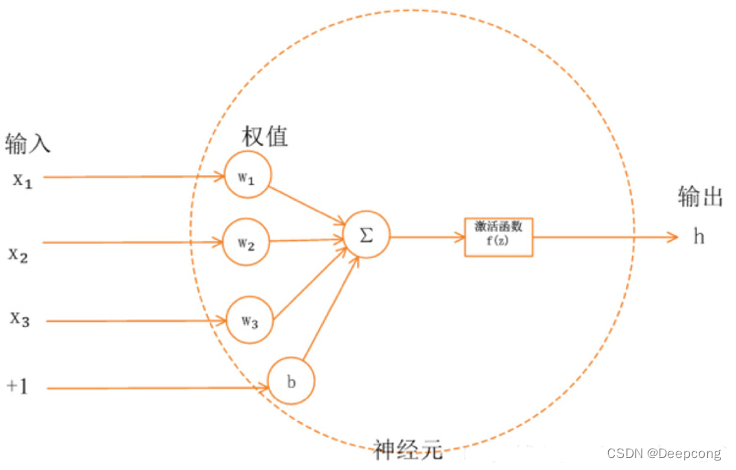

激活函数:神经网络神经元中,输入的 inputs 通过加权求和后,还被作用了一个函数,这个函数就是激活函数 Activation Function。

如下图所示:

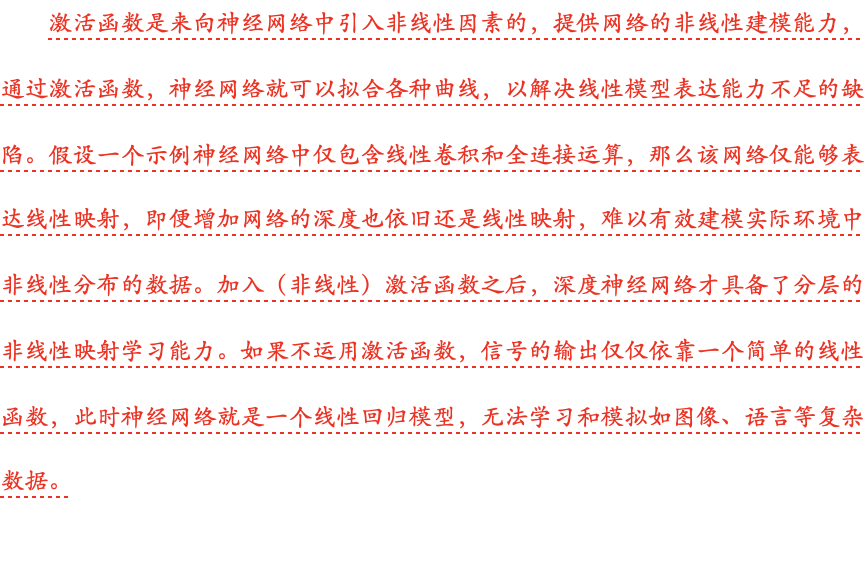

1.为什么使用激活函数?

2.激活函数总类及优缺点

3.如何选择激活函数?

- 如果输出是 0、1 值(二分类问题),则输出层选择 sigmoid 函数,然后其它的所有单元都选择 Relu 函数。

- 如果在隐藏层上不确定使用哪个激活函数,那么通常会使用 Relu 激活函数。有时,也会使用 tanh 激活函数,但 Relu 的一个优点是:当是负值的时候,导数等于 0。

- sigmoid 激活函数:除了输出层是一个二分类问题,基本不会用它。

- tanh 激活函数:tanh 是非常优秀的,几乎适合所有场合。

- ReLu 激活函数:最常用的默认函数,如果不确定用哪个激活函数,就使用 ReLu 或者 Leaky ReLu,再去尝试其他的激活函数。

- 如果遇到了一些死的神经元,我们可以使用 Leaky ReLU 函数。