单通道说话人语音分离——Conv-TasNet模型(Convolutional Time-domain audio separation Network)

参考文献:《Conv-TasNet: Surpassing Ideal Time-FrequencyMagnitude Masking for Speech Separation》

1.背景

在真实的声学环境中,鲁棒的语音处理通常需要自动的语音分离。由于这一研究课题对语音处理技术的重要性,人们已经提出了许多方法来解决这一问题。然而,语音分离的准确性,特别是对新演讲者,仍然不够。

大多数以前的语音分离方法都是在混合信号的时频(T-F,或谱图)表示中制定的,这是使用短时傅里叶变换(STFT)从波形中估计的。T-F域的语音分离方法的目的是从混合谱图中近似出单个源的干净谱图。

虽然时频掩蔽仍然是最常用的语音分离方法,但该方法存在几个缺点:

首先,STFT是一种通用的信号转换,它不一定是最优的语音分离。

其次,干净源相位的精确重构是一个重要的问题,对相位的错误估计引入了重构音频精度的上界。这个问题是明显的,即使是理想的混合物,理想的干净幅度谱图。虽然相位重建的方法可以用来缓解这一问题,但该方法的性能仍然不理想。

第三,成功地从时频表示中分离出来,需要对混合信号进行高分辨率的频率分解,这需要一个较长的时间窗口来计算STFT。

为了解决这些缺点,这里提出了一个全卷积时域音频分离网络(Conv-TasNet),一个用于端到端时域语音分离的深度学习框架。Conv-TasNet使用线性编码器生成语音波形的表示。

2.Conv-TasNet模型介绍

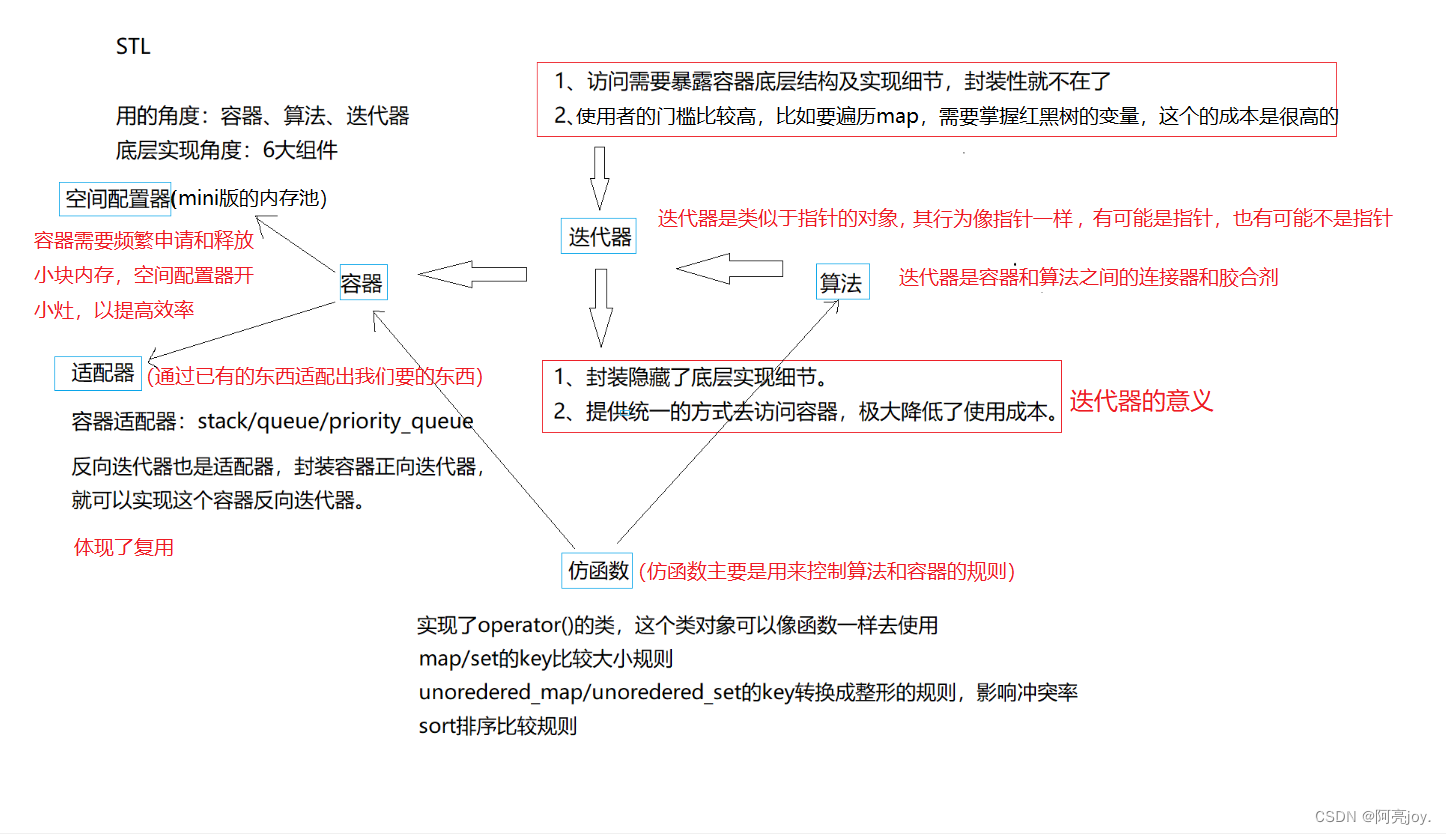

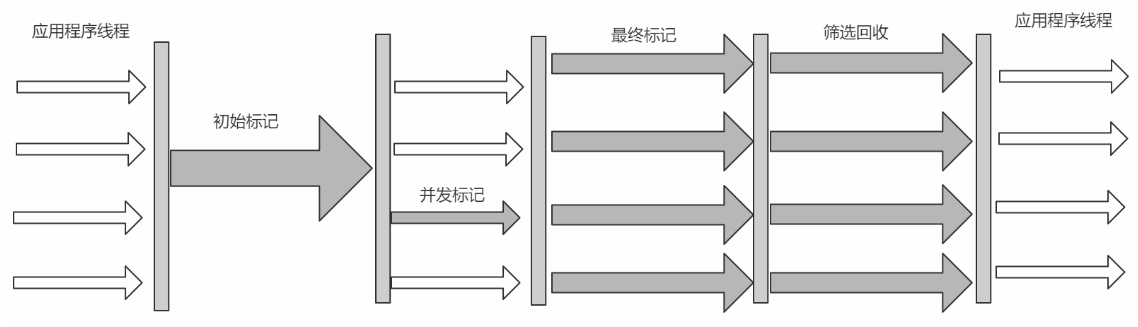

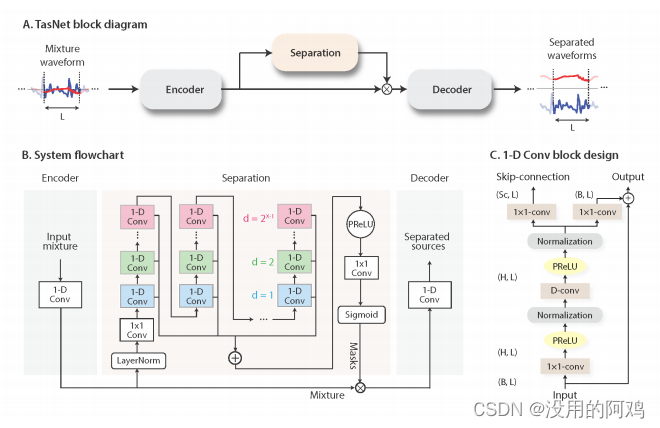

如图所示,

(A): TasNet系统的方框图。编码器将混合波形的一部分映射到高维表示法,并且分离模块计算每个目标源的乘法函数(即,掩模)。解码器从掩码特征重建源波形。

(B): 所建议的系统的流程图。一个一维卷积自动编码器对波形进行建模,而一个时间卷积网络(TCN)分离模块基于编码器的输出来估计掩模。TCN中一维卷积块的不同颜色表示不同的膨胀因子。

(C): 一维卷积块的设计。每个块由一个1×1-conv操作组成,然后是一个深度卷积(D−conv)操作,在每两个卷积操作之间添加非线性激活函数和归一化。两个线性的1×1−conv块分别作为剩余路径和跳过连接路径。

这里不对模型进行细讲,具体可以看原文

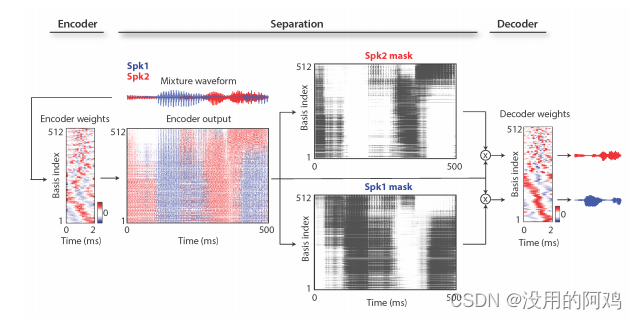

编码器和解码器基函数的可视化,编码器表示,和源掩码的样本2-扬声器混合物。扬声器用红色和蓝色表示。编码器表示法根据每个扬声器在每个基函数和时间点上的功率进行着色。基函数根据其欧几里得相似性进行排序,并在频率和相位调谐上显示出多样性。

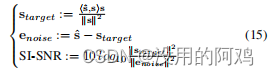

训练目标

训练端到端系统的目标是最大化尺度不变的源噪比(SI-SNR),这通常被用作源分离的评估度量,取代标准的源失真比(SDR)

其中,是分离的语音,

为目标的语音。

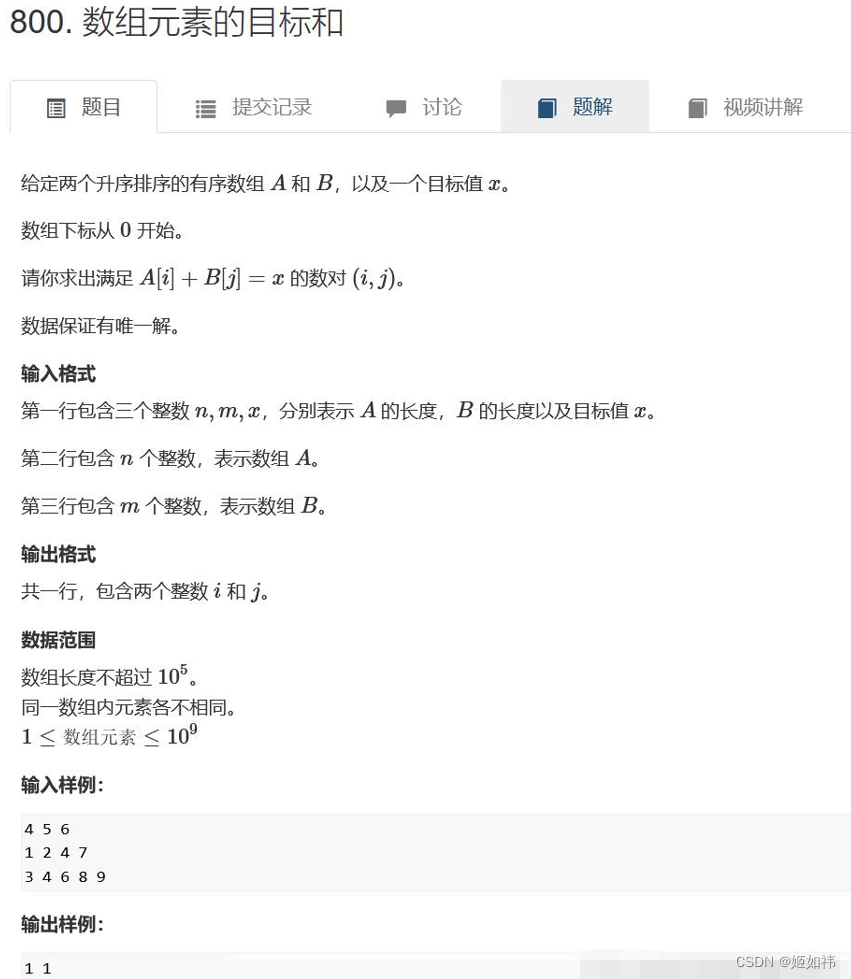

3.实验结果

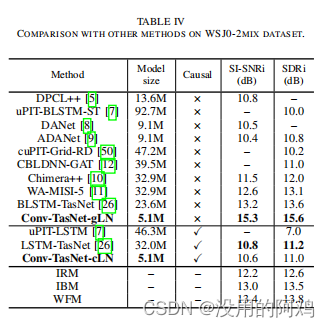

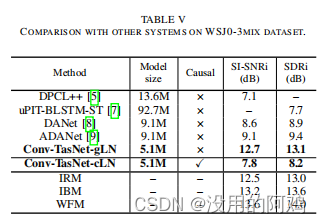

实验数据:华尔街日报的说话人数据集(要花钱买的,有钱请随意)

两个说话人

三个说话人

4.展望

说话人分离目前是热门方向,特别是在会议系统里面有很多的应用场景。

但目前关键在于,模型训练太久了,长串联式结构,一个batch只能用1或者2,如何减少训练代价也是一个值得研究的问题。

另外,因为该模型使用的是时域信息,不适用于高采样率音频也是问题,说话人分离的音频都是8kHz采样,16kHz也很勉强训练,同样也是训练代价问题。