概念

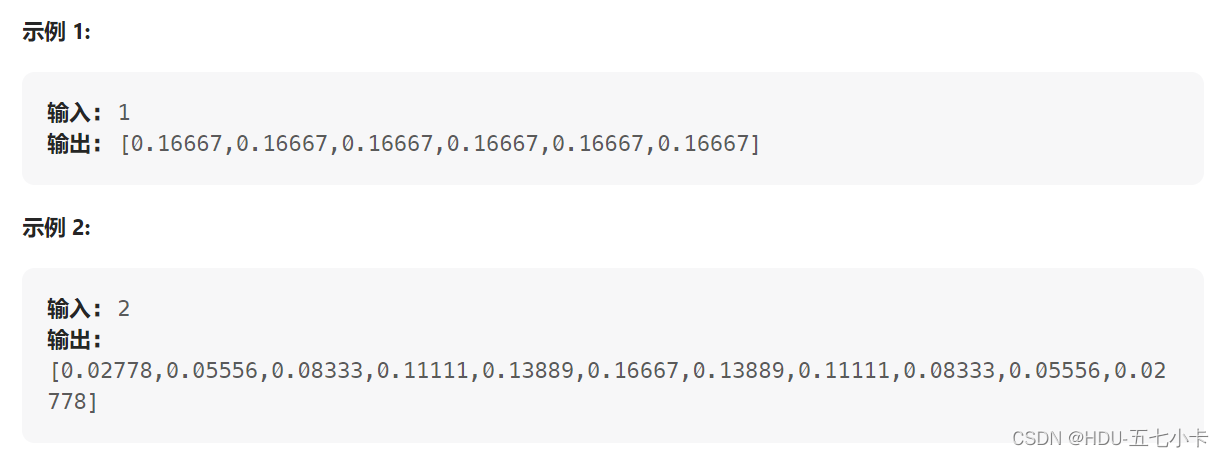

hudi的文件布局是能实现增量查询、数据更新等特性的基础,每个hudi表有一个固定的目录,存放元数据(.hoodie)以及数据文件,其中数据文件可以以分区方式进行划分,每个分区有多个数据文件(基础文件和日志文件),这些数据文件在逻辑上被组织为文件组、文件分片

- 基础文件(base file):列式存储的数据文件,可以是orc,hfile,parquet格式,默认是parquet

- 日志文件(log file):行存储的数据文件,为avro格式,保存的是数据的变更日志(redo log),只是mor表才有,会定期与base file进行合并

- 文件组(file group):同一分区下,具有相同的fileId的所有basefiles+logfiles集合,一个分区可以有多个文件组

- 文件切片(file slice):同一分区下,具有相同fileId以及相同instant的basefile + logfiles集合。即一个文件组由N个文件切片组成,每个一个文件切片中basefile最多一个,logfiles大于等于0个

上面的示例中,2023-02-15这个分区下有一个文件组,文件中组中有3个文件切片,其中一个只有log文件,一个只有base文件。

文件命名

base文件和log文件都有固定的命名格式,两者比较接近

base文件:

<fileId>_<writeToken>_<instant>.<fileExtension>

log文件:

.<fileId>_<instant>.<fileExtension>.<version>_<writeToken>

writeToken:

<taskPartitionId>-<stageId>-<taskAttemptId>

- fileId:随便生成的uuid

- writeToken:写token用来标识某一次IO操作,表示是哪个写任务的第几次写

- fileExtension:文件扩展名,base文件的默认为"parquet",log文件的默认为"log"

- version:日志版本,递增

- taskPartitionId:写task的序号,[0,stageId)

- stageId:写算子的并行度

- taskAttemptId:写task的重试次数

hudi采用的是多版本控制机制(MVCC),通过压缩动作合并log文件和base文件,生成新的文件切片;通过清理动作来删除过旧的文件切片,回收文件系统空间。