文章目录

- 2019

- 基于Mask R-CNN的芒果实例分割及采摘点检测研究与实现

- 2021

- A mango picking vision algorithm on instance segmentation and key point detection from RGB images in an open orchard

- 2022

- 基于深度学习的多品种鲜食葡萄采摘点定位

- Method for Identifying Litchi Picking Position Based on YOLOv5 and PSPNet

- Fast Location of Table Grapes Picking Point Based on Infrared Tube

- A Study on Long-Close Distance Coordination Control Strategy for Litchi Picking

- Detection method for table grape ears and stems based on a far-close-range combined vision system and hand-eye-coordinated picking test

2019

基于Mask R-CNN的芒果实例分割及采摘点检测研究与实现

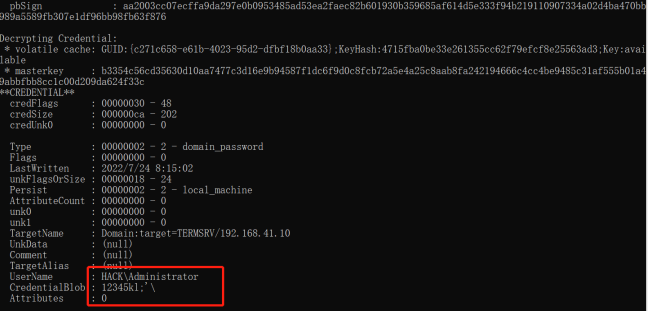

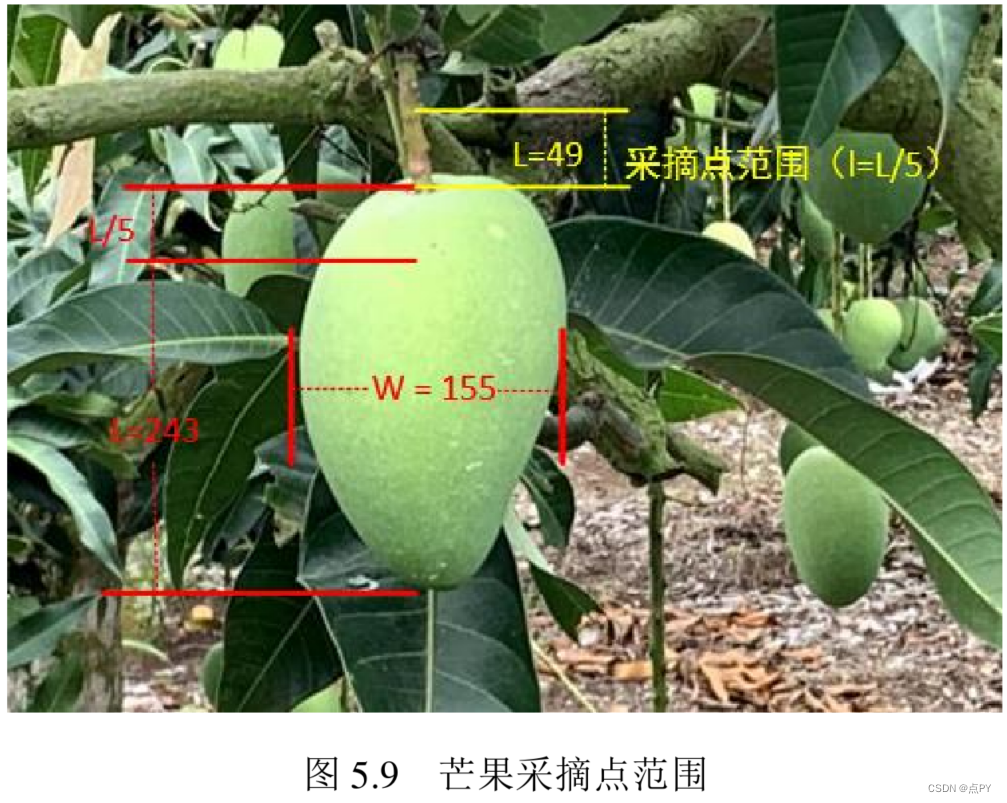

摘要:智能化农业的目标就是用机器取代人从而解放生产力,通过提高生产效率和降低劳动力成本,解决传统农业的弊端。可靠、准确的多类分割是高级机器人感知任务的关键组成部分。在农业机器人的背景下,图像分割算法使机器人能够理解环境、采摘作物、监测作物健康状况、产量估测,是机器人取代人力完成任务的前提和基础。针对实际果园场景下芒果分割和采摘过程中存在的遮挡、重叠、小目标等问题,本文研究了基于改进FCIS的芒果实例分割算法、基于改进Mask R-CNN的芒果实例分割算法,以及基于Mask R-CNN关键点检测的芒果采摘点检测算法。最后为了将研究落地,设计和开发了芒果实例分割及采摘点检测系统,实现了便携笔记本上的芒果实例分割及采摘点检测任务。本文主要研究内容和创新如下:(1)数据集及模型评价指标。数据是深度学习算法的基础,而且数据的好坏直接影响了训练得到的模型性能。数据的多样性使训练的模型可以应对更多的情况,鲁棒性更强。本文芒果数据采集于自然果园场景,涵盖了实际采摘过程中可能遇到的问题,如光线变化、背景干扰,特别是果实遮挡、重叠及小目标。另外人工对采集整理后的数据进行了图像增强和扩增,如改变图像的对比度、亮度、色度与锐度等。为了更准确的区分不同尺寸目标,本文按像素面积将芒果划分为大、中、小三个等级。使用Labelme工具对芒果进行人工标注,得到训练集、验证集以及测试集的JSON文件。本文采用COCO数据集的评价指标衡量模型性能,并分析了评价指标的全面性和准确性。(2)基于改进FCIS的芒果实例分割算法研究。FCIS是基于位置敏感分数图(score map)的实例分割算法。FCIS未针对每个ROI添加全连接层或卷积层进一步提取特征,而是直接通过位置敏感图分出前景与背景以及类别信息。本文引入PSROIAlign,使得ROI池化到位置敏感分数图上的位置更加精准,最后分割结果也更精确。在主干卷积引入特征金字塔结构(FPN),通过在不同尺寸特征图上生成ROI,实现对不同尺寸芒果个体的有效分割。为了进一步实现轻量化的目标,将基础卷积的Res50替换为Mobile Net V2结构,实现了模型的大幅压缩和提速。最终模型的AP达到70.10%,大小只有47.00M。(3)基于改进Mask R-CNN的芒果实例分割算法研究。Mask R-CNN算法是在Faster R-CNN的基础上通过增添一条FCN分支实现实例分割。本文为了进一步增强底层特征与高层特征的融合,在FPN的基础上搭建FPN-BU结构,大大缩短低层特征图与高层特征图的融合路径,实验结果证明FPN-BU结构带来分割精度的提升。为了进一步提高重叠果实的分割精度,用Soft-NMS代替NMS,避免对重叠锚点框的误删,增强了模型在果实重叠情况下的分割性能。为了进一步提高FCN掩码预测分支的特征提取能力和加强梯度的反向传播,将原本4层普通卷积替换为残差结构,带来了最终分割精度的提升并使网络易于训练。三种改进都带来了精度上不同的提升,最后AP达到了83.00%。在重叠、遮挡数据集上的效果也证明了改进策略的有效性。对比实验还体现了改进Mask R-CNN分割精度上的领先优势。(4)基于Mask R-CNN的芒果采摘点检测。传统方法定位水果采摘点需要复杂的步骤和人工干预,而且最终检测精度不高,鲁棒性差。在研究了深度学习关键点检测算法架构后,本文基于Mask R-CNN的人体关键点检测算法,设计了芒果采摘点的自动检测方法。模仿人体关键点在芒果及果梗选取三个关键点(P1、P2、P3),其中P1是真正的采摘点。将标注数据送入Mask R-CNN算法进行训练来预测关键点掩码,最终实现芒果采摘点的自动检测。针对297个标注采摘点的检测准确率达到92.90%,召回率达到96.97%。并且还与传统采摘点检测方法进行了对比实验,准确率占据优势,却没有传统方法复杂的步骤。(5)芒果实例分割及采摘点检测系统设计与实现。本文利用高性能便携笔记本、海康威视半球网络摄像机、海康威视硬盘录像机等硬件设备,通过Pycharm、Microsoft Visual Studio 2013等软件,将训练好的模型进行封装,设计了基于Windows下的芒果实例分割及采摘点检测系统。系统由数据获取、数据解码及预处理模块、模型选择及调用模块、自动分割及检测模块、结果显示模块五部分组成,实现了芒果目标的自动分割、采摘点定位、产量估测与计数等功能。

2021

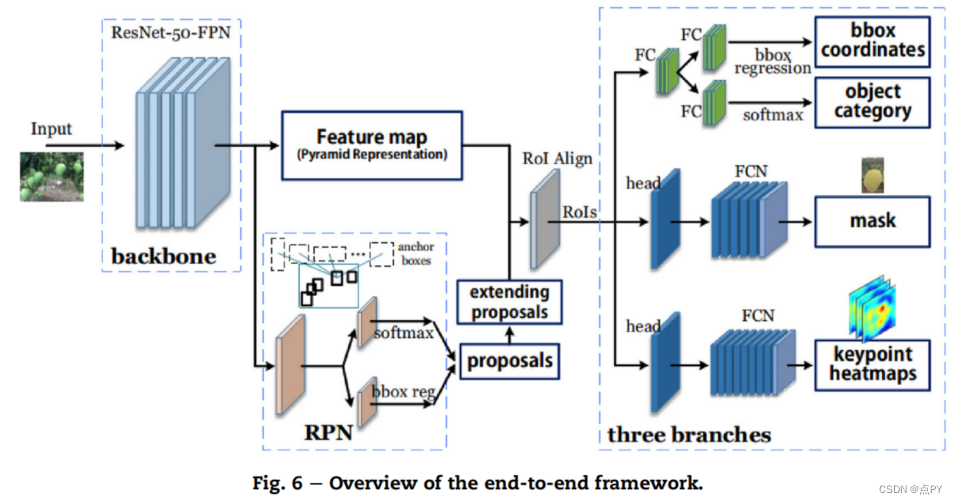

A mango picking vision algorithm on instance segmentation and key point detection from RGB images in an open orchard

摘要: 水果采摘机器人的视觉系统必须执行两个困难的任务:精确的水果像素级实例分割和正确的采摘点检测。由于视觉系统在这些任务上的性能不理想,机器人的拾取性能不足,其应用也不普遍。本研究通过水果实例分割和采摘点定位,在深度学习框架中设计了一种基于RGB图像的视觉算法,用于一个潜在的芒果采摘机器人视觉系统。该算法不仅成功地完成了这两个任务,而且还将它们集成到一个端到端网络中,其中并行分支同时执行这两个任务。实例分割的平均精度(IoU为0.75)和平均查全率分别为0.947和0.929,挑选点检测的最佳精度和查全率分别为0.984和0.908。此外,室外果园的任务面临各种光照和背景干扰,以及遮挡、重叠和物体尺度等复杂问题。本研究在各种复杂条件下的多个数据集和子集上详细分析了视觉系统的性能,并讨论了影响性能的主要因素。结果表明,该系统在不同光照和复杂背景下具有较强的鲁棒性,对小、中等遮挡或重叠、中等、大芒果具有较好的分割和拾点检测性能。模型可视化和模型训练的影响分析证明了深度学习网络的训练过程和建模效果。

2022

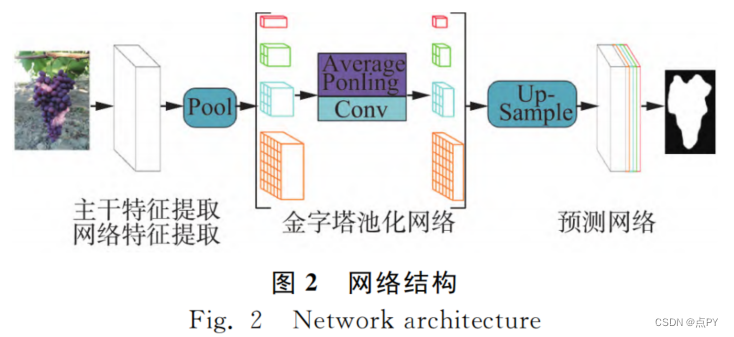

基于深度学习的多品种鲜食葡萄采摘点定位

摘要:鲜食葡萄品种多样,具有不同的形状和颜色。针对葡萄采摘机器人采摘不同品种鲜食葡萄时采摘点定位精度降低的问题,提出一种基于深度学习的多品种鲜食葡萄采摘方法。首先利用PSPNet(MobileNetv2)语义分割模型分割葡萄图像,在葡萄上方设置一个兴趣区域,在兴趣区域内使用自适应阈值果梗方向Canny边缘检测提取果梗边缘信息,然后采用霍夫变换检测果梗边缘上的直线段并进行直线拟合。最后将拟合的直线与兴趣区域的水平对称轴的交点作为采摘点。对晴天顺光、晴天逆光、晴天遮阴3种光照条件下的克瑞森、阳光玫瑰、红提和黑金手指4个品种的360幅葡萄图像进行采摘点定位试验。结果显示,采摘点定位准确率为91.94%,定位时间为187.47 ms,在模拟试验中采摘成功率为85.5%。

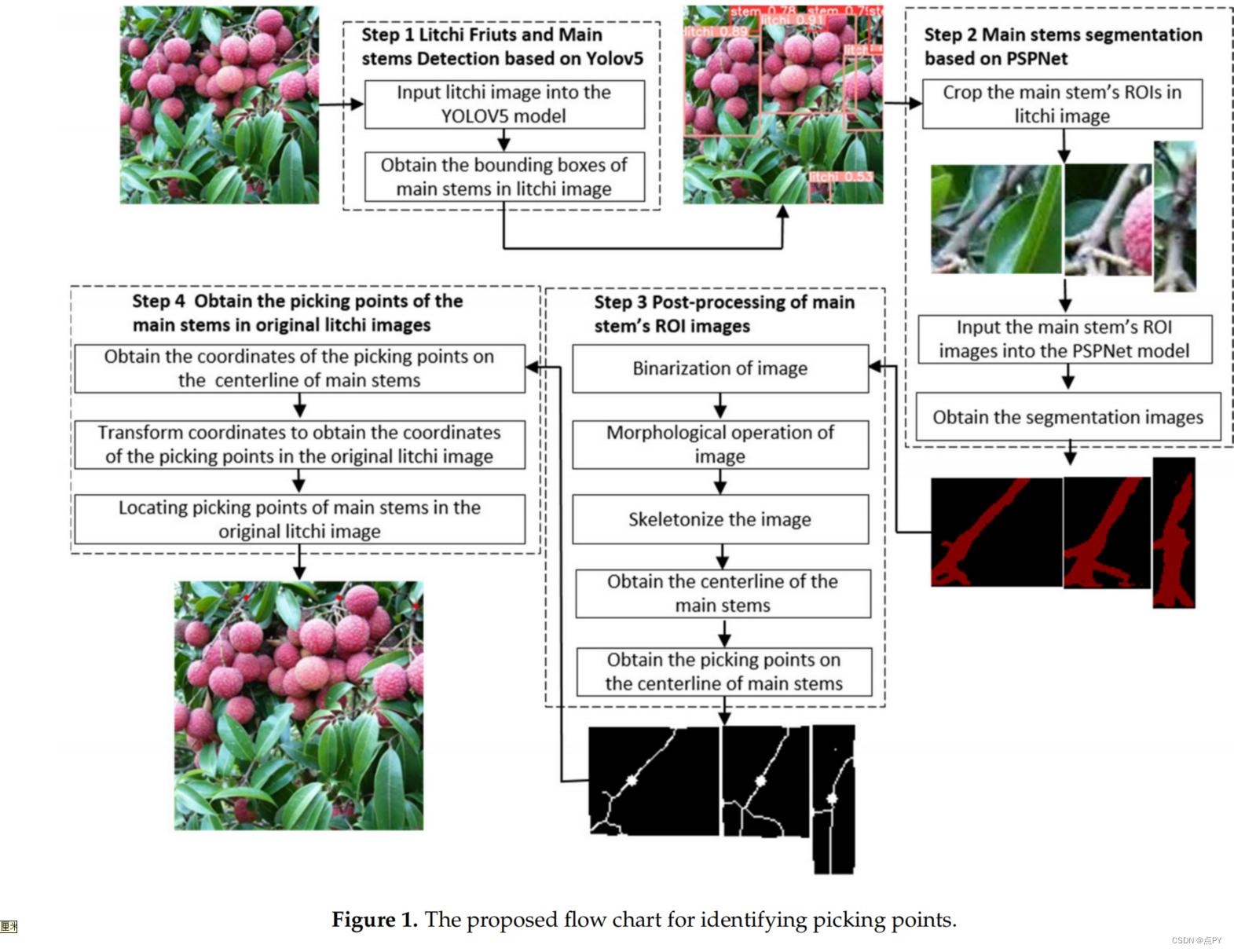

Method for Identifying Litchi Picking Position Based on YOLOv5 and PSPNet

摘要:中国是世界上荔枝产量最大的国家。但目前,荔枝以人工采摘为主,水果农户劳动强度高,生产效率低。这意味着智能无人采摘系统具有广阔的应用前景。荔枝主采干点的精确位置对无人系统的路径规划非常重要。一些研究人员已经鉴定了荔枝的果实和枝条,但对荔枝主要茎采摘点位置的研究相对较少。因此,本文提出了一种新的开放获取的工作流程,用于检测主茎上的准确采摘位置,并提出了在案例研究中使用的数据。同时,本文还比较了几种不同的主干检测和分割网络架构,并分别选择YOLOv5和PSPNet作为最有前途的主干检测和分割任务的模型。该工作流程结合深度学习和传统图像处理算法,计算荔枝图像中的准确定位信息。本工作流程以YOLOv5为目标检测模型,检测荔枝图像中的荔枝干,然后提取荔枝干的检测感兴趣区域(ROI),利用PSPNet语义分割模型对主干的ROI图像进行语义分割,对主干的ROI图像进行图像后处理,得到主干ROI图像中拾取点的像素坐标。经过坐标转换后,得到原荔枝图像的主茎拾取点的像素坐标,并在荔枝图像上绘制出拾取点。目前,该工作流程可以获得荔枝图像中主茎采摘点的准确位置信息。该方法的召回率和精度分别为76.29%和92.50%,这为后续工作提供基础的三维坐标根据图像深度信息,尽管我们在本文没有做这项工作。

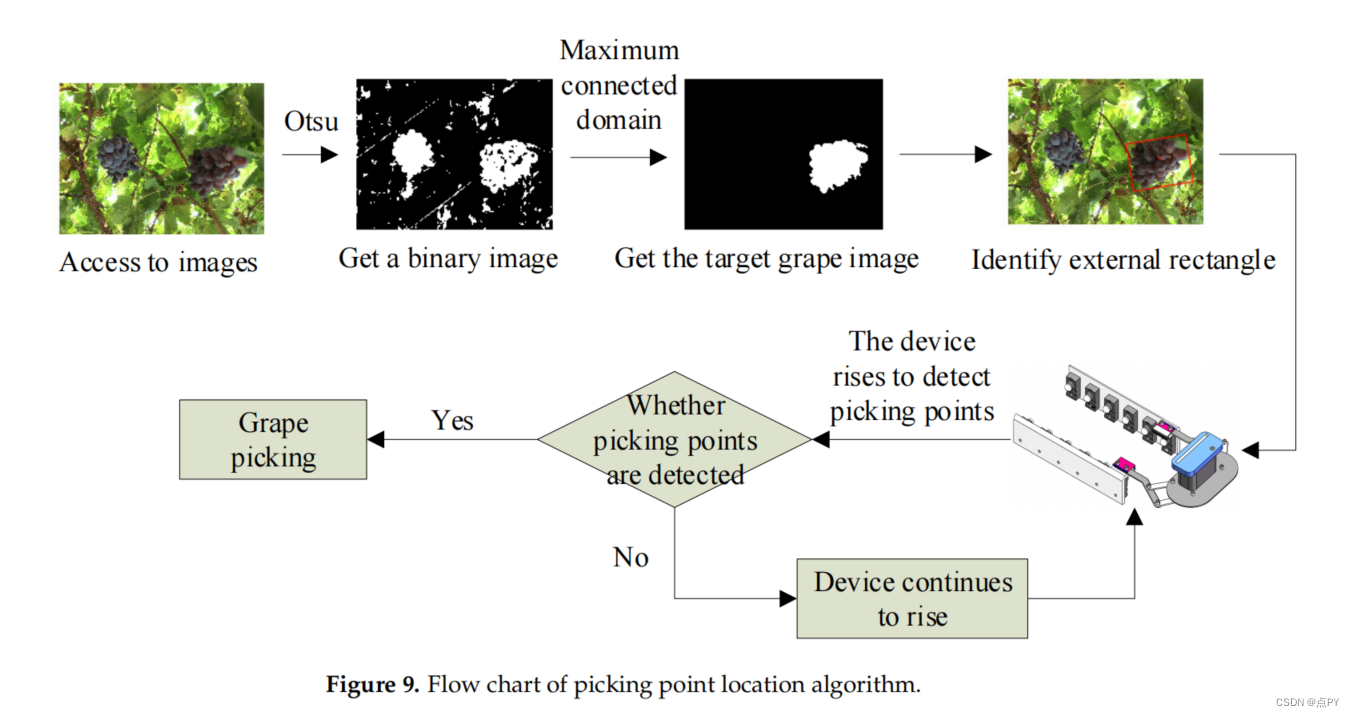

Fast Location of Table Grapes Picking Point Based on Infrared Tube

摘要:本研究探讨了葡萄采摘机械化水平较低,以及葡萄采摘点在三维空间中定位困难的问题。提出了一种基于红外管快速定位餐桌葡萄采摘点的方法。首先,利用Otsu算法和最大连接域获取目标葡萄的图像,实现了在二维空间中对目标葡萄的快速识别和分割。其次,设计了一种基于红外管的葡萄采摘点定位装置,解决了三维空间中采摘点定位困难的技术问题,实现了餐桌葡萄采摘点的准确定位。实验结果表明,该方法能在三维空间中快速、准确地定位餐桌葡萄的采摘点。该算法的平均运行时间为0.61 s,位置识别的成功率为90.0%。为机械化采摘提供了一种可行的方案。

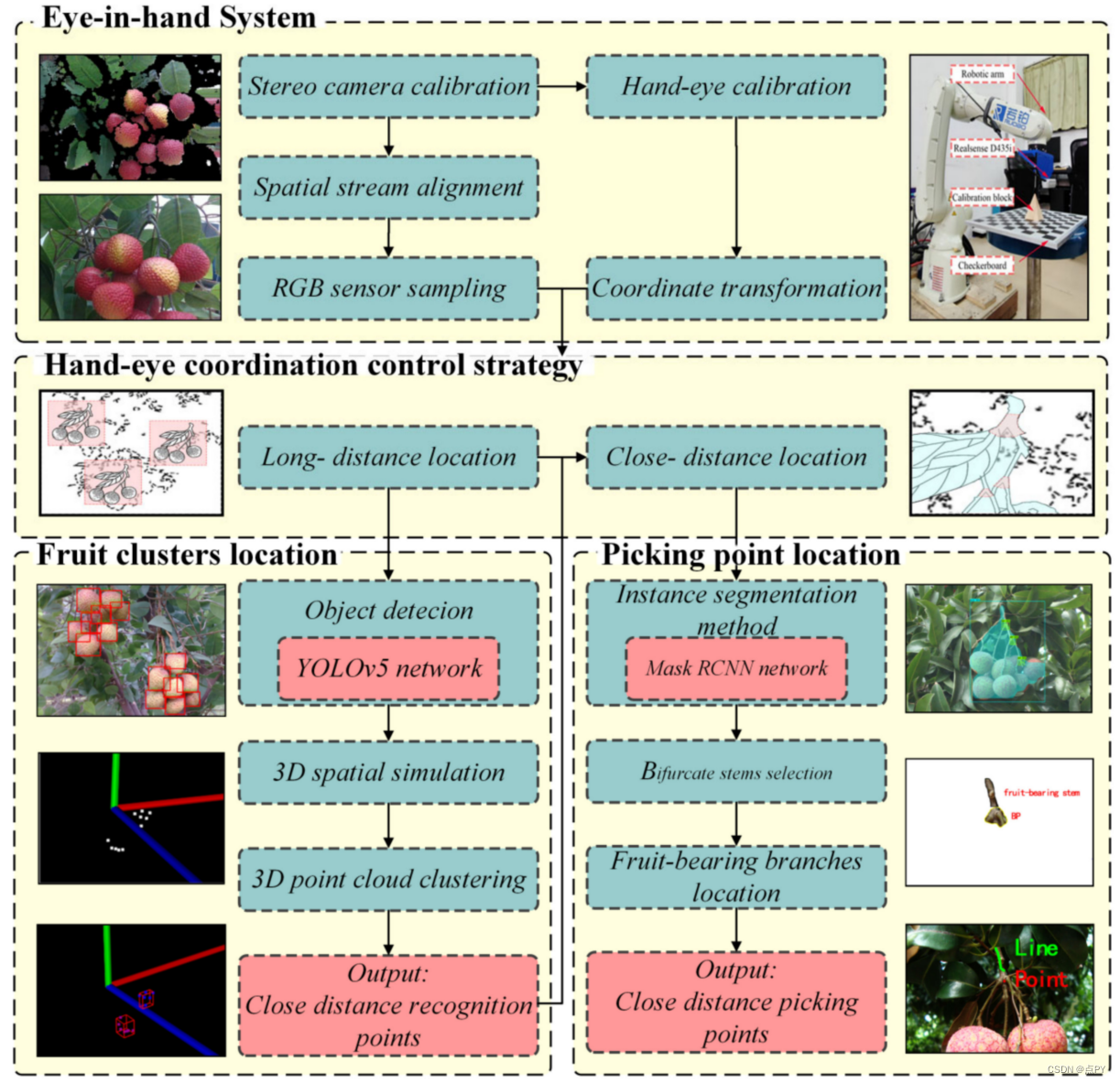

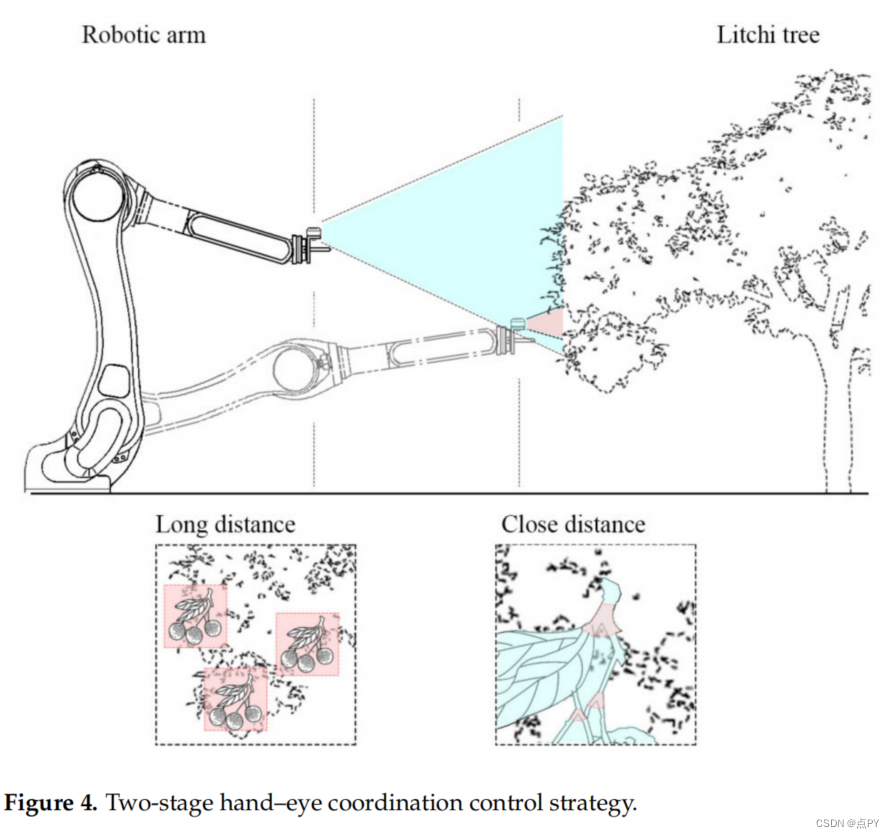

A Study on Long-Close Distance Coordination Control Strategy for Litchi Picking

摘要:对于机器人自动采摘串种类型的水果,策略是大致确定串种的位置,从一个遥远的位置计划采摘路线,然后将采摘点精确地定位在一个更合适、更近的位置。后者可以减少需要处理的信息量,获得更精确、更详细的特征,从而提高视觉系统的准确性。本研究利用一种基于英特尔遥感D435i相机和该相机收集的点云图,提出了一种荔枝采摘机器人的长近距离协调控制策略。利用YOLOv5目标检测网络和DBSCAN点云聚类方法,确定长距离串果实的位置,然后推导出采摘顺序。到达近距离位置后,采用Mask RCNN实例分割方法对视场中更明显的分叉茎进行分割。通过对分割掩模的处理,提出了一种“点+线”双参考模型,该线由机械臂引导采摘。与现有的研究相比,该策略考虑到了深度相机的优缺点。通过对完整过程的试验,长距离密度聚类方法能够在较近距离对不同束进行分类,而果实枝定位的成功率为88.46%。这是一项探索性的工作,为未来的水果采摘机器人的研究提供了理论和技术参考。

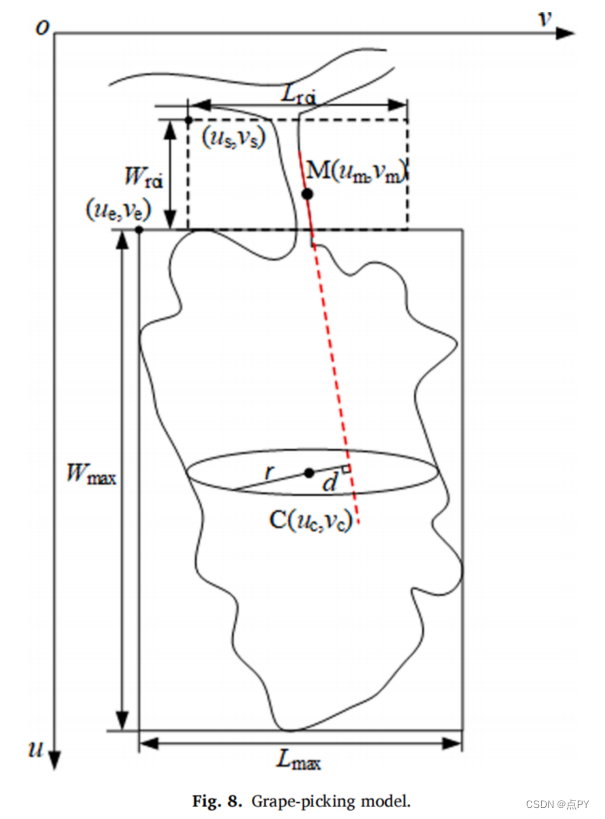

Detection method for table grape ears and stems based on a far-close-range combined vision system and hand-eye-coordinated picking test

摘要: 为了提高餐桌葡萄在自动采食过程中的采食成功率,准确定位葡萄穗的采食点和葡萄茎的切削点具有重要意义。本研究构建了一套近距离立体视觉系统的葡萄耳和葡萄茎检测系统。首先,提出了葡萄耳质心的识别算法。对远距离葡萄的识别和特征提取进行了一系列的图像操作,包括中值滤波、阈值分割、形态学操作、可执行区域标记和目标质心的提取。其次,建立了葡萄茎切削点的计算模型。对近距离葡萄茎的感兴趣区域(ROI)进行边缘检测,并采用累积概率Hough变换。完成了近距离葡萄茎的直线检测和切割点定位。最后,基于LabVIEW软件,开发了采葡萄机器人的测控系统。实验验证,葡萄茎的识别和切割点的定位算法具有较高的可靠性,晴天成功率为92%,阳光背光成功率为82%,阴天成功率为86%。葡萄采摘测试表明,在给定的计算机配置下,葡萄采摘机器人可以在平均53.4 s的桌面时间内完成葡萄采摘任务。