最近发现了一篇优秀的Nature子刊论文,作者提出了一种基于可解释GNN癌症基因分析新框架,在预测任务中实现了卓越的性能表现。

除此之外,还出现了很多可解释GNN的新研究,其中顶会不少,可见无论在学术界和工业界,这方向都相当受欢迎。这是因为可解释GNN不仅能处理复杂数据关系、辅助决策制定,也能促进模型优化、加强用户对模型的信任,在医疗诊断和金融分析这些领域拥有超绝竞争力。

目前这方向主要有基于梯度/特征的方法、基于扰动的方法等,都比较主流,如果有同学想以此发论文,建议从这些角度入手,有参考更好找idea。

这里为了给大家省掉点查找资料的时间,我整理了9篇最新的可解释GNN论文,挑的基本都是有开源代码的,拿来直接复现,希望能给大家的论文加快点进度。

论文原文+开源代码需要的同学看文末

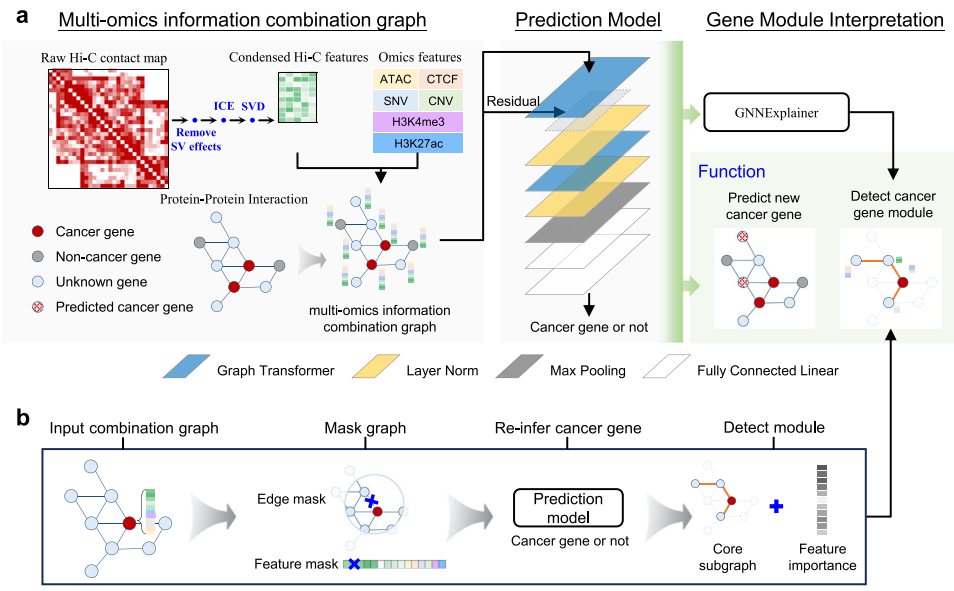

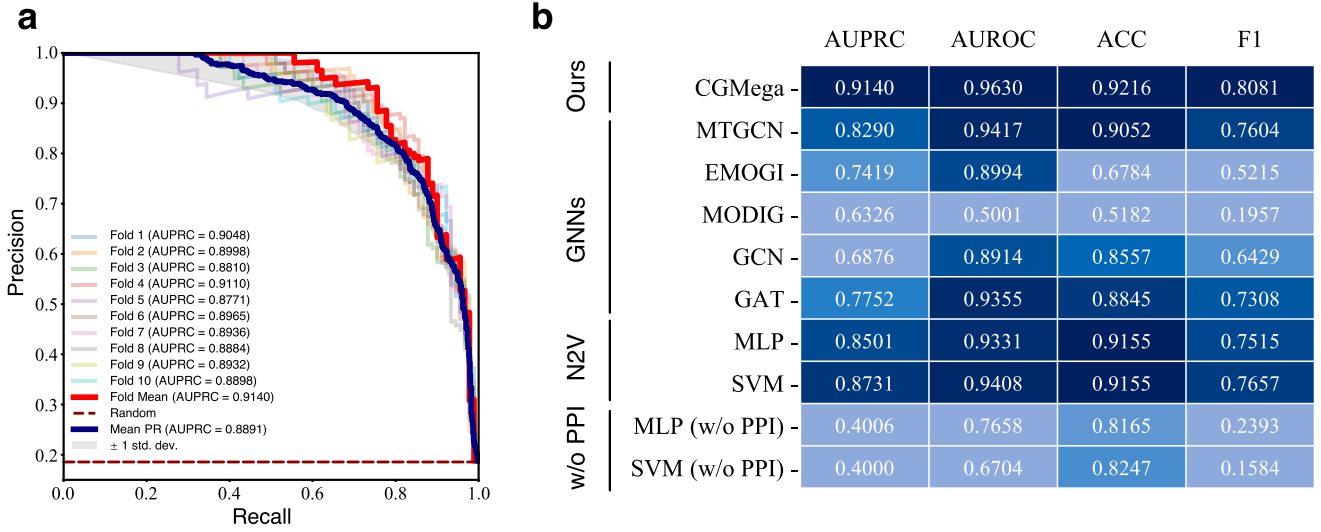

CGMega: explainable graph neural network framework with attention mechanisms for cancer gene module dissection

方法:论文提出了一种新的多组学数据整合方法CGMega,通过有效整合基因组、表观基因组、蛋白质相互作用和3D基因组结构,提升了癌症基因预测的性能。CGMega展示了在不同癌症类型间的知识迁移能力,证实其在预测癌症基因和解析基因模块方面的有效性。

创新点:

-

利用图注意力和图解释技术开发了一种新框架CGMega,用于研究癌症基因模块。

-

有效整合多组学数据,包括基因组、表观基因组、蛋白质相互作用(PPIs)及3D基因组结构。

-

通过GNNExplainer实现对癌症基因模块的检测,提供对高阶基因模块的深入解析。

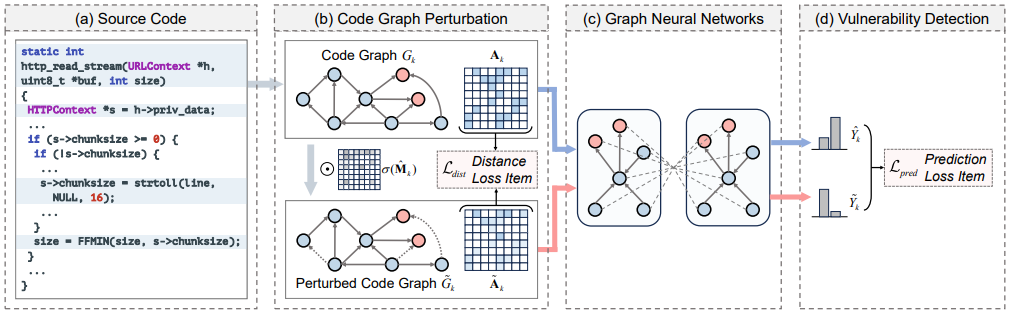

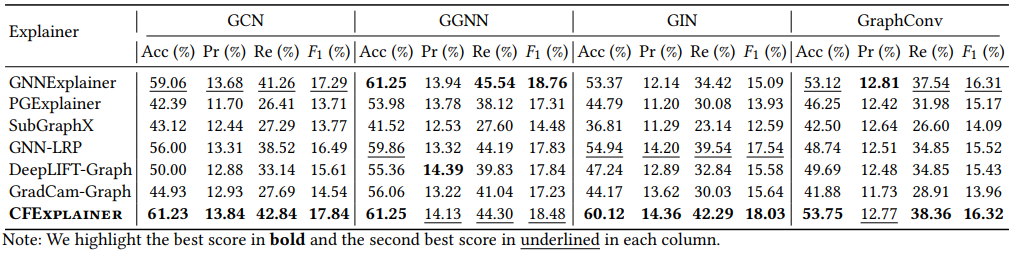

Graph Neural Networks for Vulnerability Detection: A Counterfactual Explanation

方法:论文通过引入CFExplainer,提出了一种基于反事实推理的解释器,旨在通过识别代码图的最小扰动来改变GNN模型的漏洞检测预测,从而回答关键的“如果...会怎样”的问题,填补了现有研究在解释深度学习模型中的缺口。

创新点:

-

提出CFExplainer:这是一个利用反事实推理来解释GNN在漏洞检测中预测的新方法。

-

边缘剪枝技术:开发了一种新的技术来识别和剪枝代码图中的恶意边缘。

-

模型无关性:CFExplainer不需要访问GNN模型的内部信息,使其适用于各种黑盒模型。

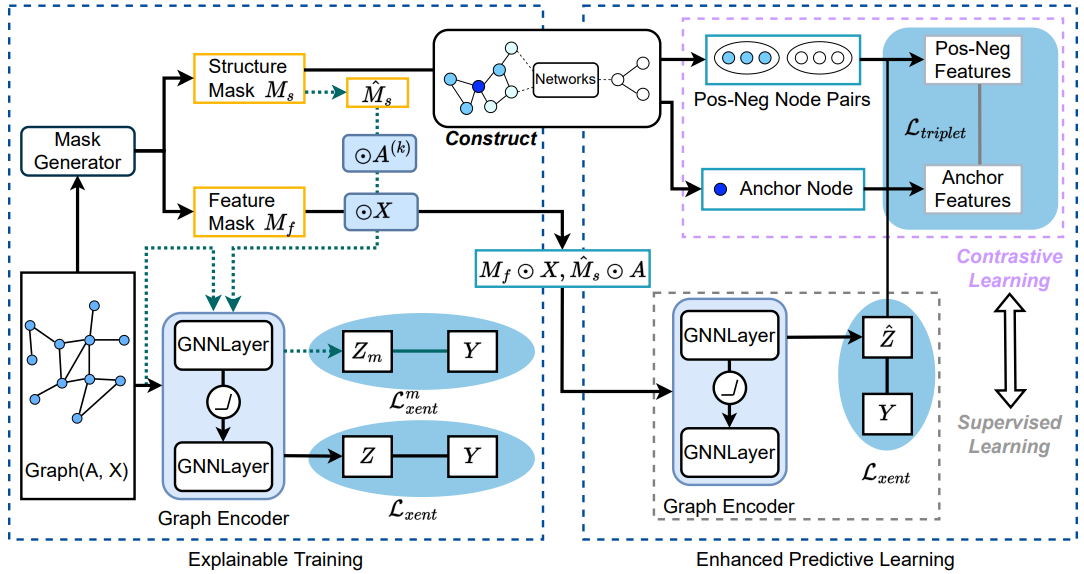

SES: Bridging the Gap Between Explainability and Prediction of Graph Neural Networks

方法:论文提出了一种自解释和自监督的GNN(SES),旨在解决现有图神经网络(GNNs)解释性和预测性能之间的差距,通过两个阶段的训练过程,即解释性训练和增强预测学习,SES利用全局掩码生成器提供可靠的实例级解释,并通过对比学习显著提升GNNs的预测准确性。

创新点:

-

提出了一个能够同时提供解释和预测的图神经网络(SES),解决了现有方法中解释性和预测性之间的脱节问题。

-

SES能够在训练过程中直接生成特征和结构的掩码,这些掩码有助于解释模型的决策过程。

-

通过使用对比学习增强模型的预测性能,使得解释信息能够反馈并提升模型的训练效果。

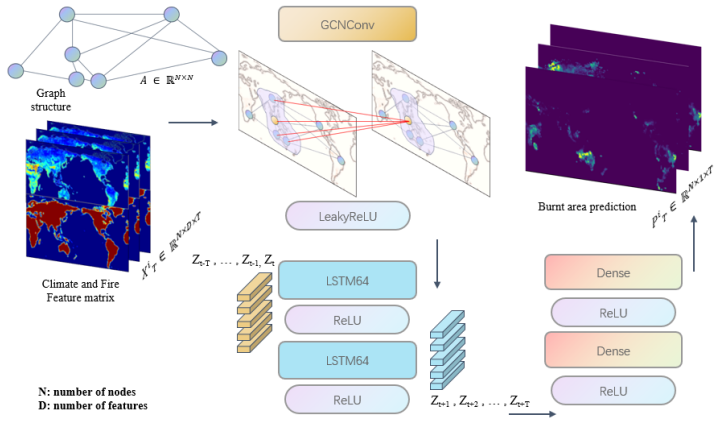

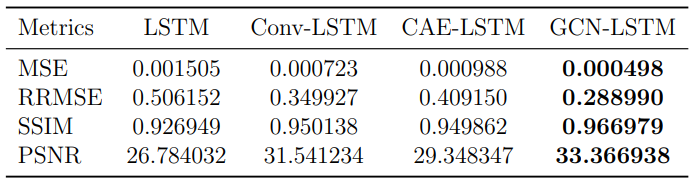

Explainable Global Wildfire Prediction Models using Graph Neural Networks

方法:论文提出了一种新颖的图神经网络(GNN)结合LSTM的可解释方法,用于全球野火预测,利用JULES-INFERNO模拟数据,通过将气候和野火数据表示为图形,解决了现有模型在处理海洋数据缺失和长距离依赖上的不足,展示了更高的预测准确性和解释性。

创新点:

-

提出了一个结合图神经网络和时间序列预测的混合模型,用于全球野火预测。

-

创新性地将气候和野火数据转化为图形结构,有效处理了数据缺失和远距离依赖问题。

-

通过特征和社区检测,模型能解释其预测结果,提高了决策的透明度。

关注下方《学姐带你玩AI》🚀🚀🚀

回复“可解释GNN”获取全部论文+开源代码

码字不易,欢迎大家点赞评论收藏

![[3]Opengl ES着色器](https://i-blog.csdnimg.cn/blog_migrate/73b82ae18ecf1bdd7fb8f98dae7e5b19.png)