RAG 整个流程不复杂,集成三大部分包括文档解析并生成向量、根据查询问题查找语意相似的数据文档块、把查询问题和召回文档作为上下文的数据传给模型进行解答。大语言模型的应用开发和传统的开发方式区别很大,以前开发完成,只要逻辑正确,结果肯定是固定的,但是由于模型的特性,结果是基于概率计算的,加上自然语言的特殊性,近义词很多,每次回答都是正确的,但是返回的内容确不一样,可能是有些词改为了近义词,也可能描述的角度不一样了。

如果不加以控制,可能模型回答正确率就达不到要求,例如,如果模型正确率 60%,5 次回答中有 2 次是错的,这个用户就无法接受了。所以监控和评估对于 RAG 来讲就尤其重要,本文将介绍如何使用 LlamaIndex 进行 RAG 整体流程监控以及跟踪。

RAG监控

如何跟踪监控 RAG流程,监控的方式可以分为日志监控和可视化监控,日志监控可以提高开发阶段的效率,清晰的了解每一步 RAG 都做了什么,传的参数是什么,返回结果是什么。大语言模型的开发需要集成多方组件,而且大量使用提示词,如果链路很长,找问题是一个比较耗时的工作。下面将介绍如何通过日志方式和可视化的方式进行 RAG 的跟踪。

打开Log 日志

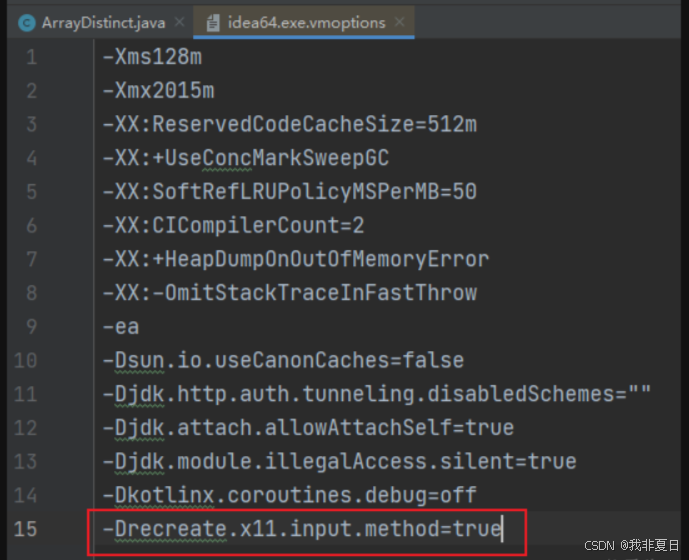

在 LlamaIndex 中通过以下代码打开 RAG 日志,运行 RAG 之后可以看到日志输出:

import logging

import sys

logging.basicConfig(stream=sys.stdout, level=logging.DEBUG)

logging.getLogger().addHandler(logging.StreamHandler(stream=sys.stdout))

Log 中可以看出文档导入,文档搜索以后后续模型调用情况

- 文档导入相关日志

- 搜索召回日志

- 大模型调用

可视化跟踪

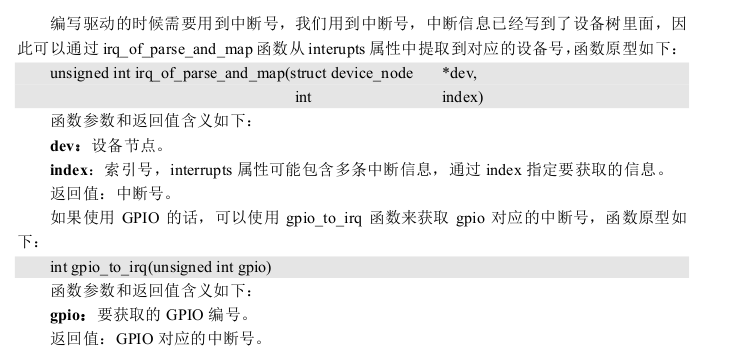

通过 Log 日志监控在开发阶段可以快速定位问题,但在测试环境定位问题比较困难,在大量的文字日志中查找问题是一个比较困难费时的事,在应用开发通常会使用 ES 全家桶对日志进行采集以及分析。LlamaIndex 同样集成了很多日志监控工具,在这里我们使用Arize Phoenix进行监控,Arize Phoenix 具体安装方式可以参考这篇文章。

安装 LlamaIndex Arize Phoenix 依赖库

pip install llama-index-callbacks-arize-phoenix

发送监控数据到 arize-phoenix 服务端,

#首先启动服务

import phoenix as px

px.launch_app(host="0.0.0.0")

接入数据

set_global_handler("arize_phoenix", endpoint="http://10.91.3.116:6006/v1/traces")

LlamaIndexInstrumentor().instrument()

进入 UI 管理界面 http://10.91.3.116:6006/,可以看到列表暂时没有数据

启动 RAG,程序运行完成之后,当回到列表页时可以看到 RAG 的端到端的运行过程传入的数据以及返回结果。

文档分块的详情

总结

LlamaIndex 中可以集成多种监控工具,现在开源、闭源的 AI 监控工具很多,无论选择何种工具,核心功能就是监控数据流、提示词、文档块。在测试过程中,需要根据大模型的返回进行评估,并根据结果进一步调优模型、提示词、Embedding 模型等等。RAG 过程数据非常重要,是后续优化的基础。下一篇我们看一下如何对 RAG 的结果进行评估,并持续优化 RAG 各个组件。