文章目录

- 简述

- 本地配置

- 配置文件

- model_settings.yaml

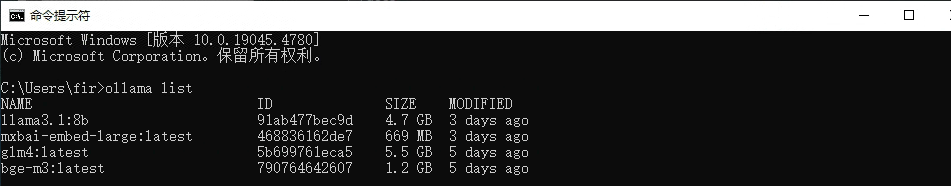

- 使用Ollama配置

- 模型配置

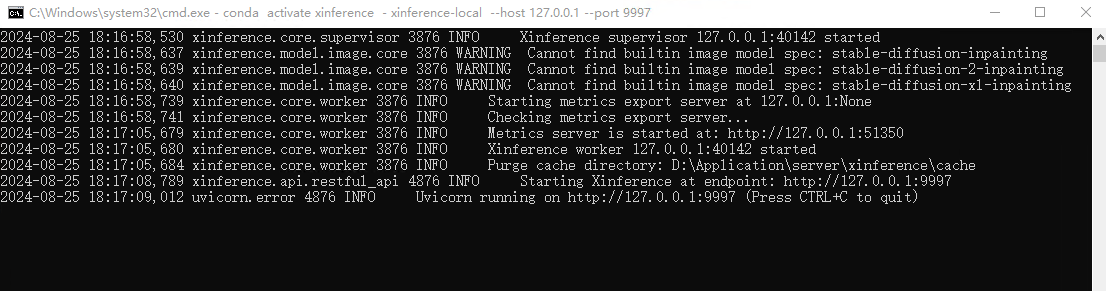

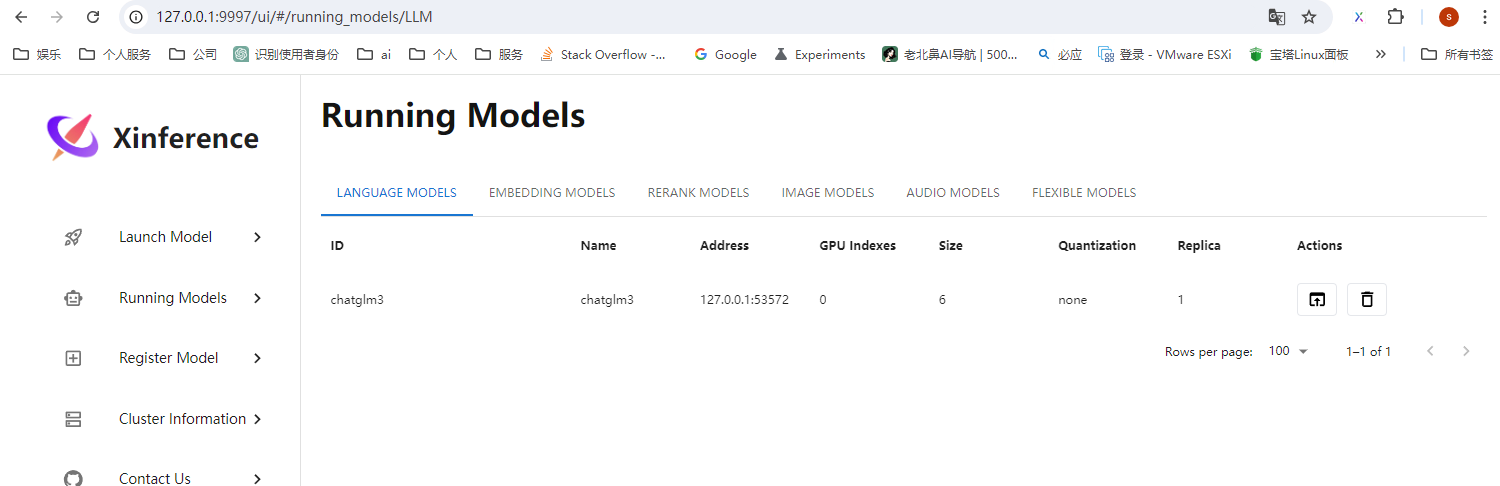

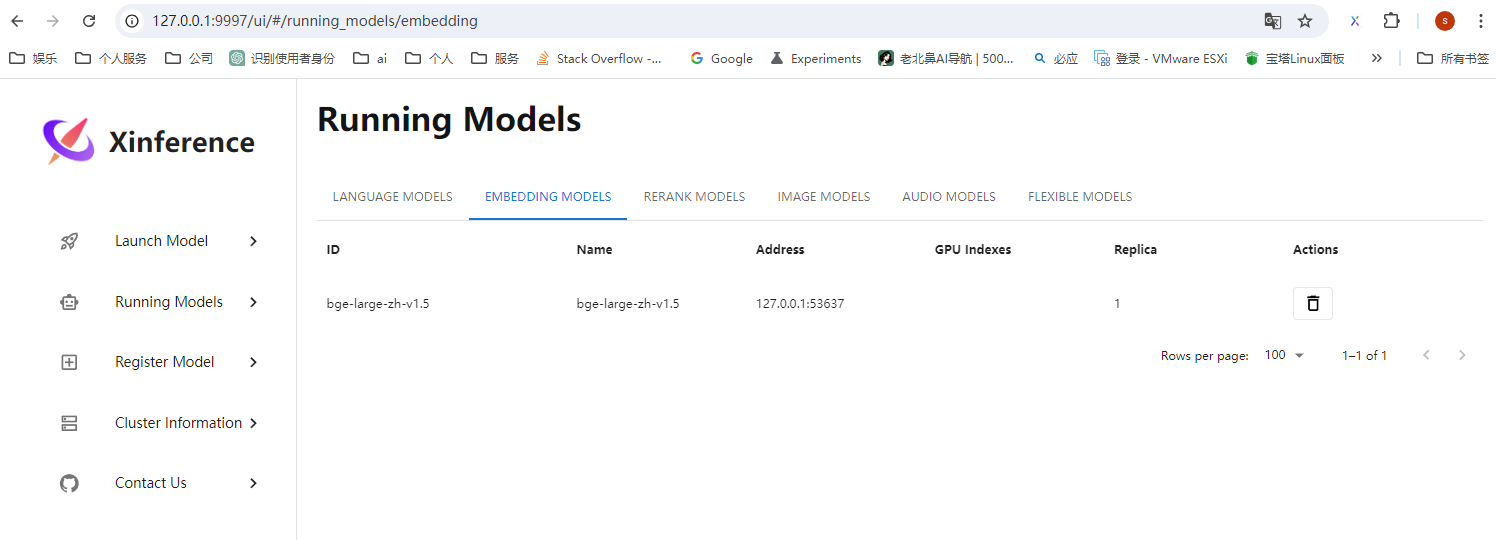

- 使用Xinference配置

- 模型配置

- 修改默认使用的模型

- 对话

- 基础对话

- 知识库对话

简述

针对Langchain-Chatchat-V0.3版本,对配置文件与模型使用说明,本文建议使用Ollama配合Chatchat使用。

Ollama安装方式查看以往教程。

[大模型]ollama本地部署自然语言大模型_ollama模型下载后存放位置-CSDN博客

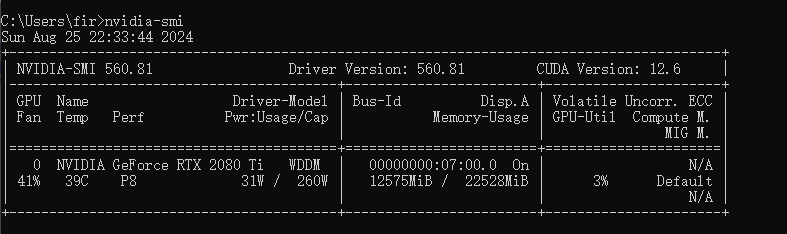

本地配置

nvidia-smi

配置文件

model_settings.yaml

默认使用的模型

# 默认选用的 LLM 名称

DEFAULT_LLM_MODEL: llama3.1

# 默认选用的 Embedding 名称

DEFAULT_EMBEDDING_MODEL: mxbai-enbed-large

在支持Agent模型中添加你想要的新模型

# 支持的Agent模型

SUPPORT_AGENT_MODELS:

- llama3.1

- chatglm3

使用ollama的LLM模型于Embedding模型

使用Ollama配置

模型配置

修改llm_models与embed_models配置,为自己想要使用的模型。

- platform_name: ollama

platform_type: ollama

api_base_url: http://127.0.0.1:11434/v1

api_key: EMPTY

api_proxy: ''

api_concurrencies: 5

auto_detect_model: false

llm_models:

- llama3

embed_models:

- mxbai-embed-large

找到Ollama双击启动

任务栏如下提示表示启动成功。使用模型时,Ollama会自动运行该模型,无需单独启动模型。

使用Xinference配置

启动模型

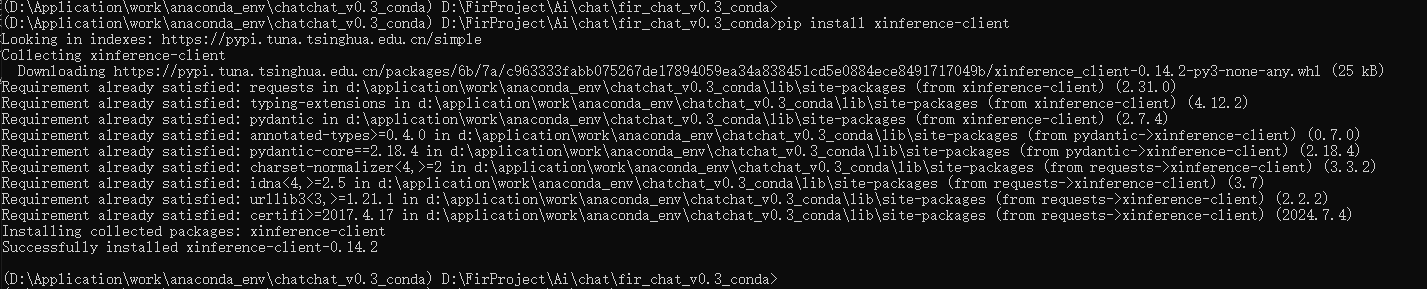

为chatchat安装客户端模块

pip install xinference-client

模型配置

修改llm_models与embed_models配置,为自己想要的

- platform_name: xinference

platform_type: xinference

api_base_url: http://127.0.0.1:9997/v1

api_key: EMPTY

api_proxy: ''

api_concurrencies: 5

auto_detect_model: true

llm_models:

- chatglm3

embed_models:

- bge-large-zh-v1.5

text2image_models: []

image2text_models: []

rerank_models: []

speech2text_models: []

text2speech_models: []

修改默认使用的模型

# 默认选用的 LLM 名称

DEFAULT_LLM_MODEL: chatglm3

# 默认选用的 Embedding 名称

DEFAULT_EMBEDDING_MODEL: bge-large-zh-v1.5

对话

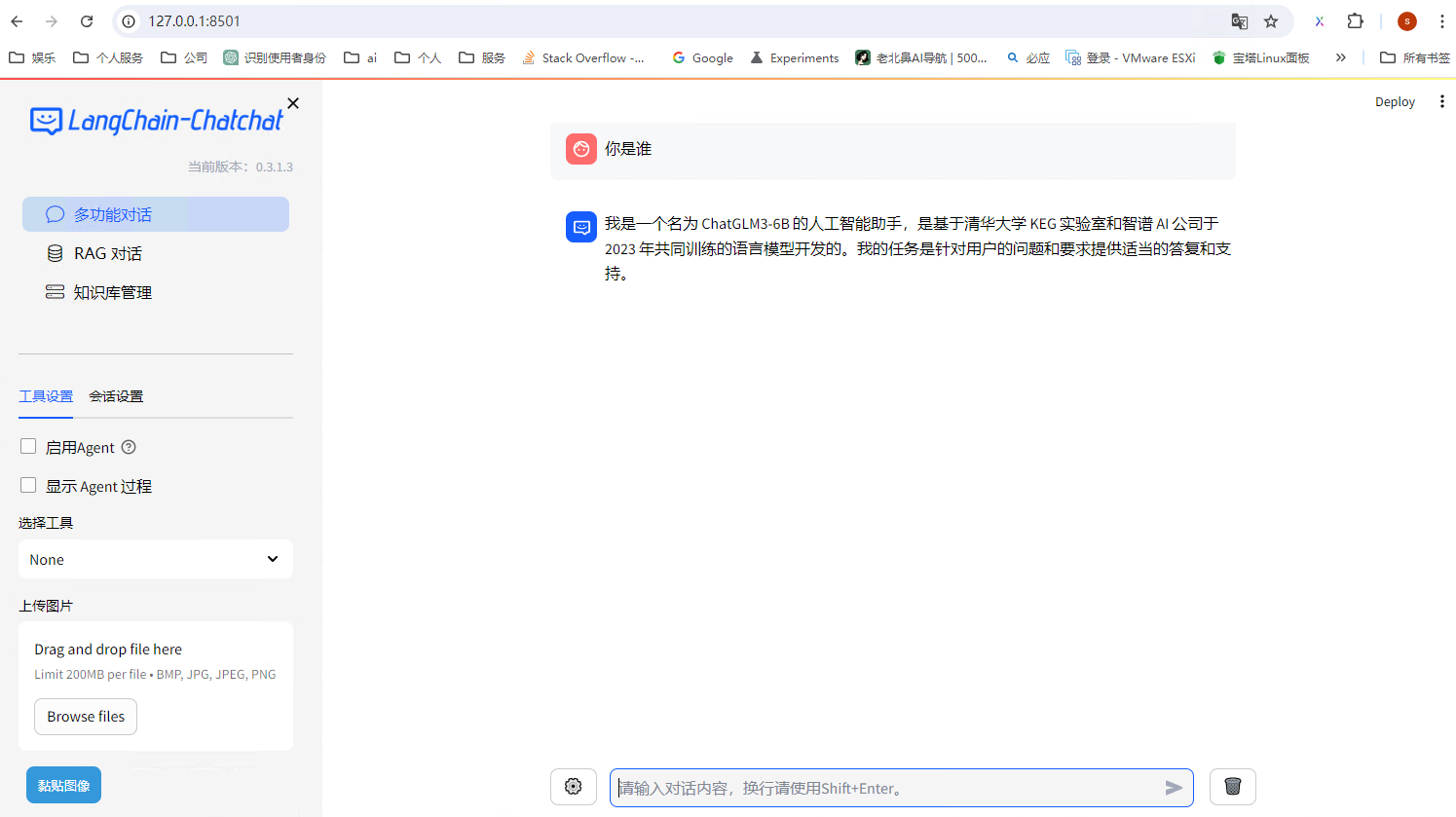

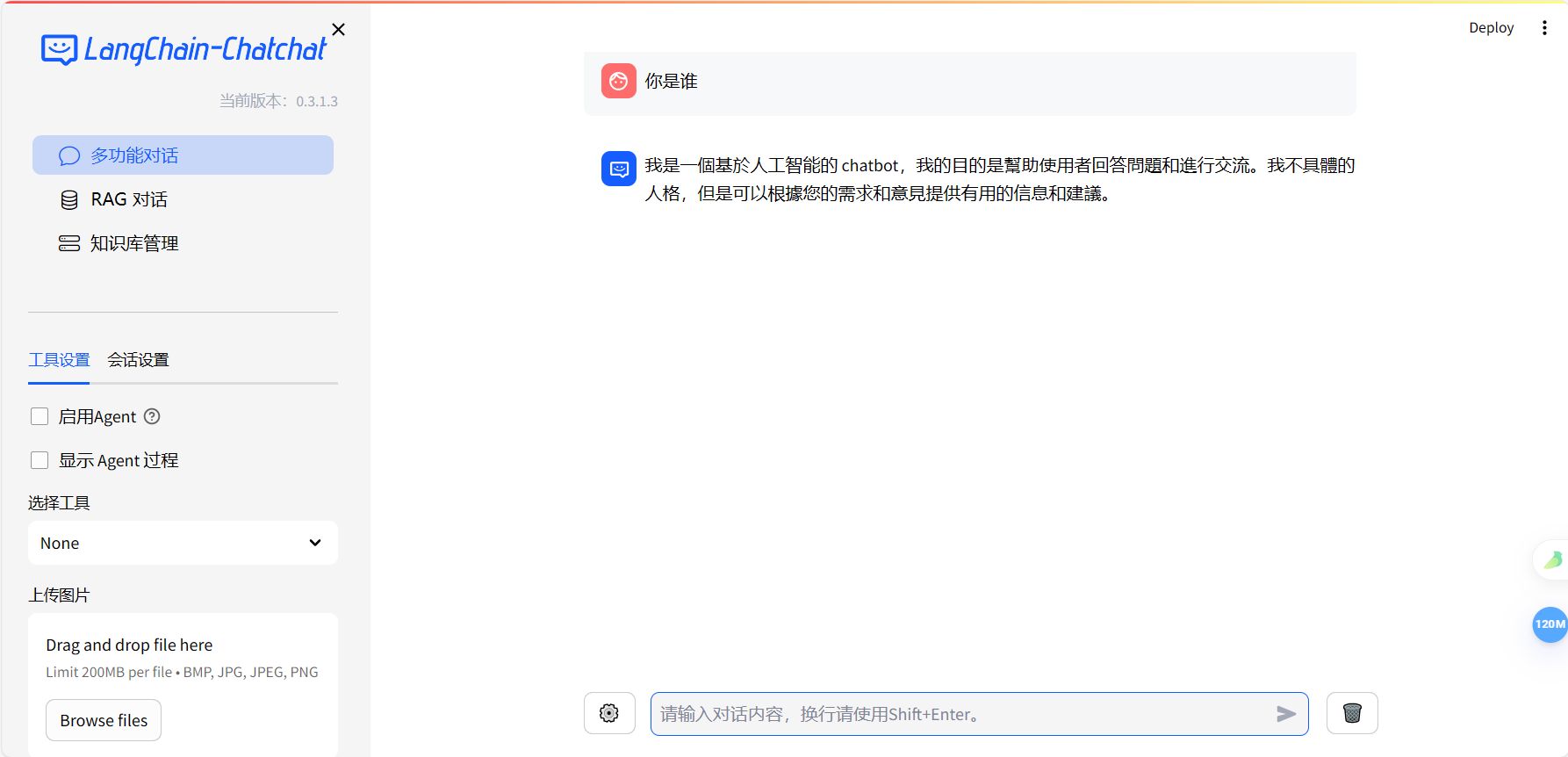

基础对话

配置好LLM模型,即可使用基础的对话。

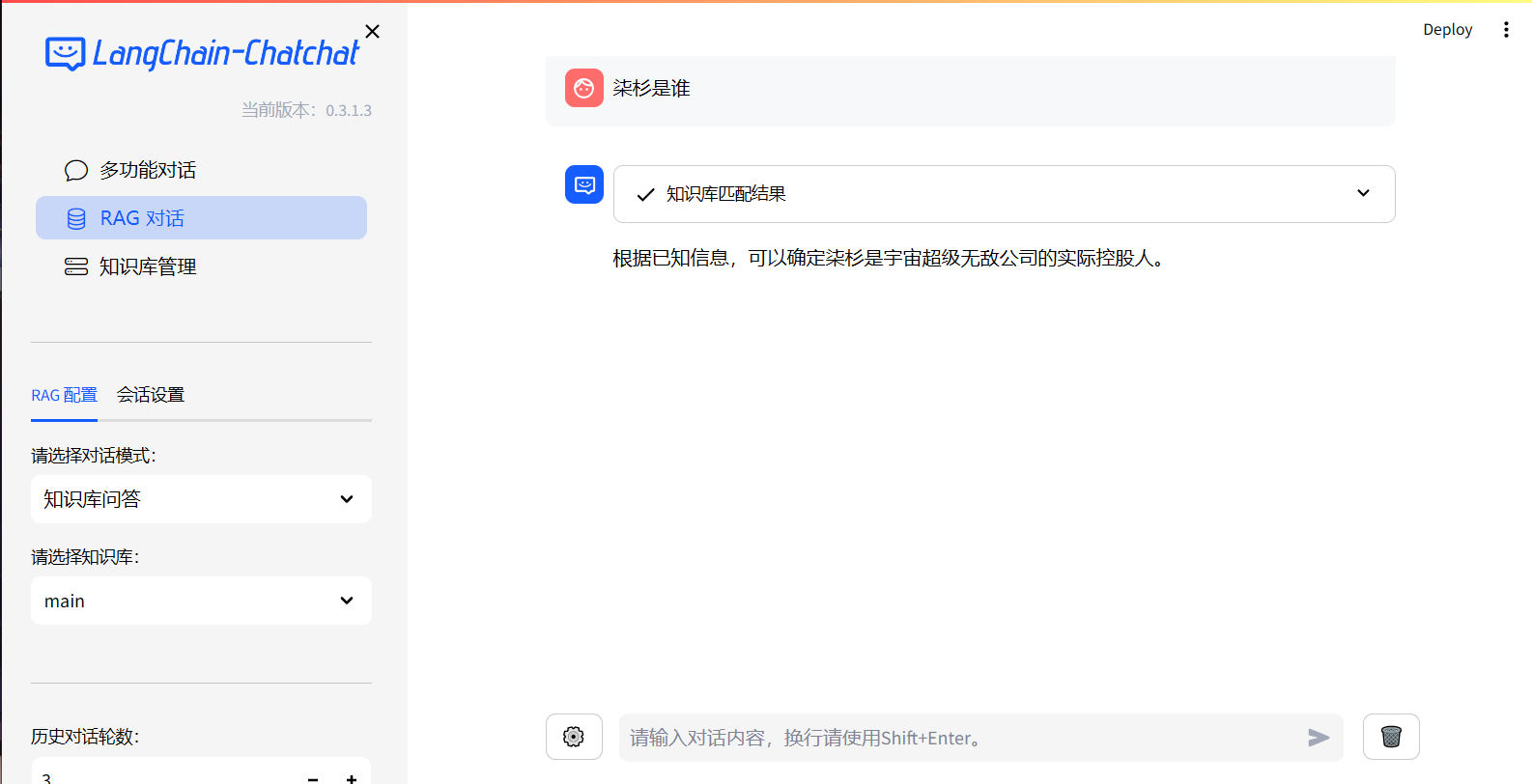

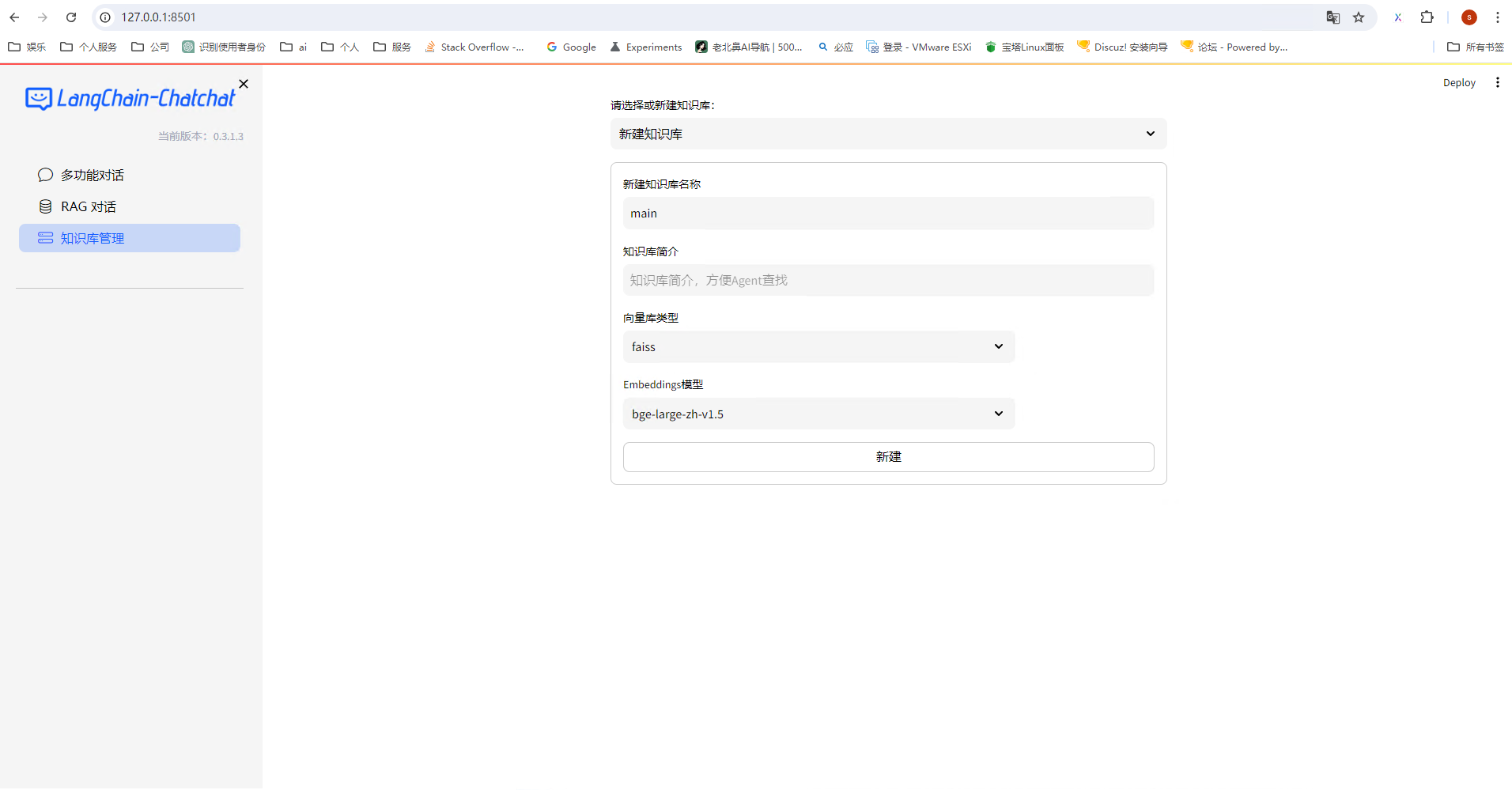

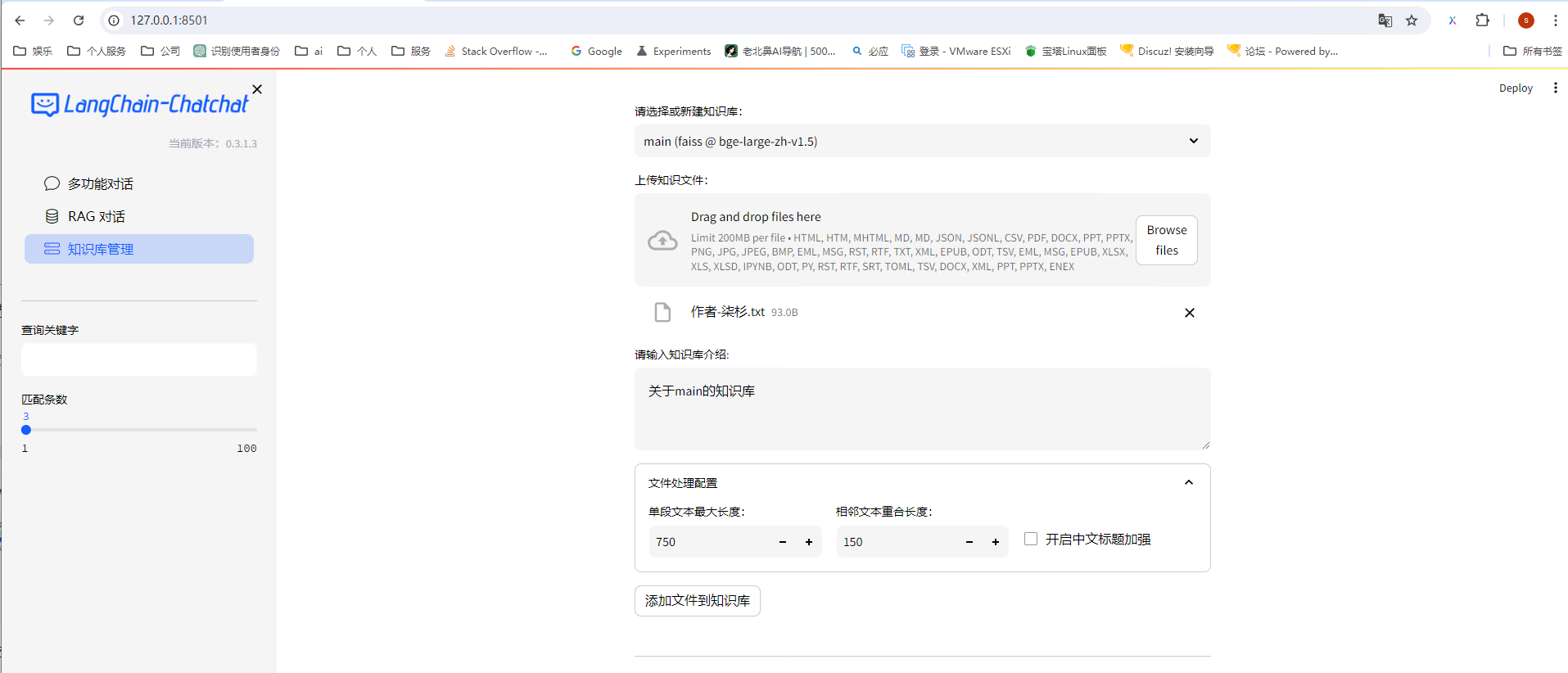

知识库对话

创建知识库

选择文件,并点击添加文件到知识库

之后就可看到,知识库中已经拥有了这一段记忆。

最后,我们询问可以访问知识库的模型,可以得到如下结果