大模型应用中常听说的投毒实验是什么?

大模型投毒实验是指在训练或使用大规模人工智能模型(如GPT-4等)时,通过有意加入恶意数据或修改训练过程,使模型产生不正确或有害输出的行为。随着人工智能技术的快速发展,投毒攻击成为了一个严重的安全问题。本文将详细探讨大模型投毒实验的类型、具体方法、潜在威胁以及防范措施。

一、什么是大模型投毒实验?

大模型投毒实验可以分为以下几种类型:

- 数据投毒(Data Poisoning)

- 模型中毒(Model Poisoning)

- 后门攻击(Backdoor Attacks)

1. 数据投毒(Data Poisoning)

数据投毒是指在模型训练过程中引入恶意或有偏的数据,导致模型学到错误或有害的模式。这种攻击可以通过以下几种方式实现:

- 引入错误标签:在分类任务中,攻击者可以将训练数据的标签错误地分配给不同的类别。这样,模型在训练过程中会学习到错误的分类规则。例如,在一个猫狗分类任务中,将猫的图片标签为狗。

公式表示:

Loss

=

∑

i

=

1

N

ℓ

(

f

(

x

i

;

θ

)

,

y

i

)

\text{Loss} = \sum_{i=1}^{N} \ell(f(x_i; \theta), y_i)

Loss=i=1∑Nℓ(f(xi;θ),yi)

其中,

x

i

x_i

xi 是输入,

y

i

y_i

yi 是错误标签,

θ

\theta

θ 是模型参数,

f

f

f 是模型,

ℓ

\ell

ℓ 是损失函数。

- 增加噪声数据:在训练数据中加入大量的随机噪声数据,干扰模型的学习过程,使其难以正确地识别和分类真实的数据。

公式表示:

x

i

′

=

x

i

+

η

x_i' = x_i + \eta

xi′=xi+η

其中,

η

\eta

η 是噪声数据。

- 注入有偏数据:在训练数据集中加入带有特定偏见的数据,从而使模型在推理时输出具有偏见的结果。例如,在一个性别分类任务中,故意加入大量某一性别的样本,使模型对该性别有更高的敏感度。

公式表示:

P

(

x

i

∣

y

i

=

male

)

≫

P

(

x

i

∣

y

i

=

female

)

P(x_i \mid y_i = \text{male}) \gg P(x_i \mid y_i = \text{female})

P(xi∣yi=male)≫P(xi∣yi=female)

2. 模型中毒(Model Poisoning)

模型中毒是指直接修改模型的参数或结构,使其在特定条件下产生预期的错误或有害输出。这种攻击主要通过以下方式实现:

- 梯度修改:在模型的训练过程中,攻击者可以通过修改梯度更新的过程来影响模型参数的调整方向,使其朝着错误的方向优化。

公式表示:

θ

t

+

1

=

θ

t

−

α

∇

θ

ℓ

(

f

(

x

i

;

θ

t

)

,

y

i

)

+

δ

\theta_{t+1} = \theta_t - \alpha \nabla_\theta \ell(f(x_i; \theta_t), y_i) + \delta

θt+1=θt−α∇θℓ(f(xi;θt),yi)+δ

其中,

δ

\delta

δ 是攻击者加入的恶意梯度。

- 参数篡改:在模型训练完成后,攻击者可以直接篡改模型的参数值,使其在推理时产生错误的结果。例如,攻击者可以在模型的权重矩阵中加入特定的噪声,使其在特定输入下输出预设的结果。

公式表示:

θ

′

=

θ

+

Δ

\theta' = \theta + \Delta

θ′=θ+Δ

其中,

Δ

\Delta

Δ 是攻击者加入的恶意参数修改。

3. 后门攻击(Backdoor Attacks)

后门攻击是指在模型训练过程中植入后门,使得模型在遇到特定触发条件时产生特定的输出。这种攻击方式的特点是模型在正常情况下表现正常,但在遇到特定的触发输入时会产生异常行为。例如:

- 触发模式:在训练数据中加入带有特定触发模式的数据(例如特定的图案或噪声),并让模型在遇到这种模式时输出攻击者预设的结果。

公式表示:

f

(

x

i

+

δ

;

θ

)

=

y

target

f(x_i + \delta; \theta) = y_{\text{target}}

f(xi+δ;θ)=ytarget

其中,

δ

\delta

δ 是触发模式,

y

target

y_{\text{target}}

ytarget 是攻击者预设的目标输出。

- 触发条件:设定特定的输入条件,使模型在满足这些条件时输出特定的结果。例如,在文本生成模型中,当输入中包含特定关键词时,输出攻击者预设的文本。

公式表示:

f

(

x

i

∣

keyword

∈

x

i

;

θ

)

=

y

target

f(x_i \mid \text{keyword} \in x_i; \theta) = y_{\text{target}}

f(xi∣keyword∈xi;θ)=ytarget

二、投毒攻击的潜在威胁

投毒攻击对大模型的威胁是多方面的,主要包括:

-

误导用户:通过让模型输出错误的信息来误导使用者。例如,搜索引擎模型被投毒后,可能会在搜索结果中显示虚假的信息。

-

传播有害内容:利用模型来传播虚假信息、仇恨言论或其他有害内容。例如,社交媒体平台上的推荐系统被投毒后,可能会推荐极端或有害的内容。

-

操控行为:通过特定的输出影响用户的决策或行为。例如,电商平台的推荐系统被投毒后,可能会推荐特定品牌的商品,影响用户的购买决策。

-

破坏系统稳定性:使模型在特定情况下崩溃或表现异常。例如,自驾车系统被投毒后,可能会在特定情况下失灵,造成安全隐患。

三、防范投毒攻击的措施

为了防范大模型投毒攻击,需要在数据收集、模型训练、验证和部署的各个环节采取措施:

1. 数据审查

-

数据清洗:对训练数据进行严格的清洗,去除噪声数据和异常数据,确保数据的质量和可靠性。

-

数据来源验证:验证数据的来源,确保其来源可靠,避免使用不可信的第三方数据。

-

数据多样性:确保训练数据的多样性,避免模型学习到有偏见的模式。

2. 模型验证

-

验证测试:在模型训练和更新过程中进行严格的验证测试,检测异常行为。使用不同的数据集进行交叉验证,确保模型的泛化能力。

-

鲁棒性测试:对模型进行鲁棒性测试,模拟各种攻击场景,检测模型的抗攻击能力。

3. 安全审计

-

定期审计:定期对模型和系统进行安全审计,发现和修复潜在的漏洞。

-

行为监控:实时监控模型的行为,检测异常输出和潜在的攻击行为。

4. 用户反馈

-

反馈机制:建立用户反馈机制,及时收集和分析用户反馈,发现和应对模型的异常行为。

-

持续改进:根据用户反馈和审计结果,持续改进模型和系统的安全性。

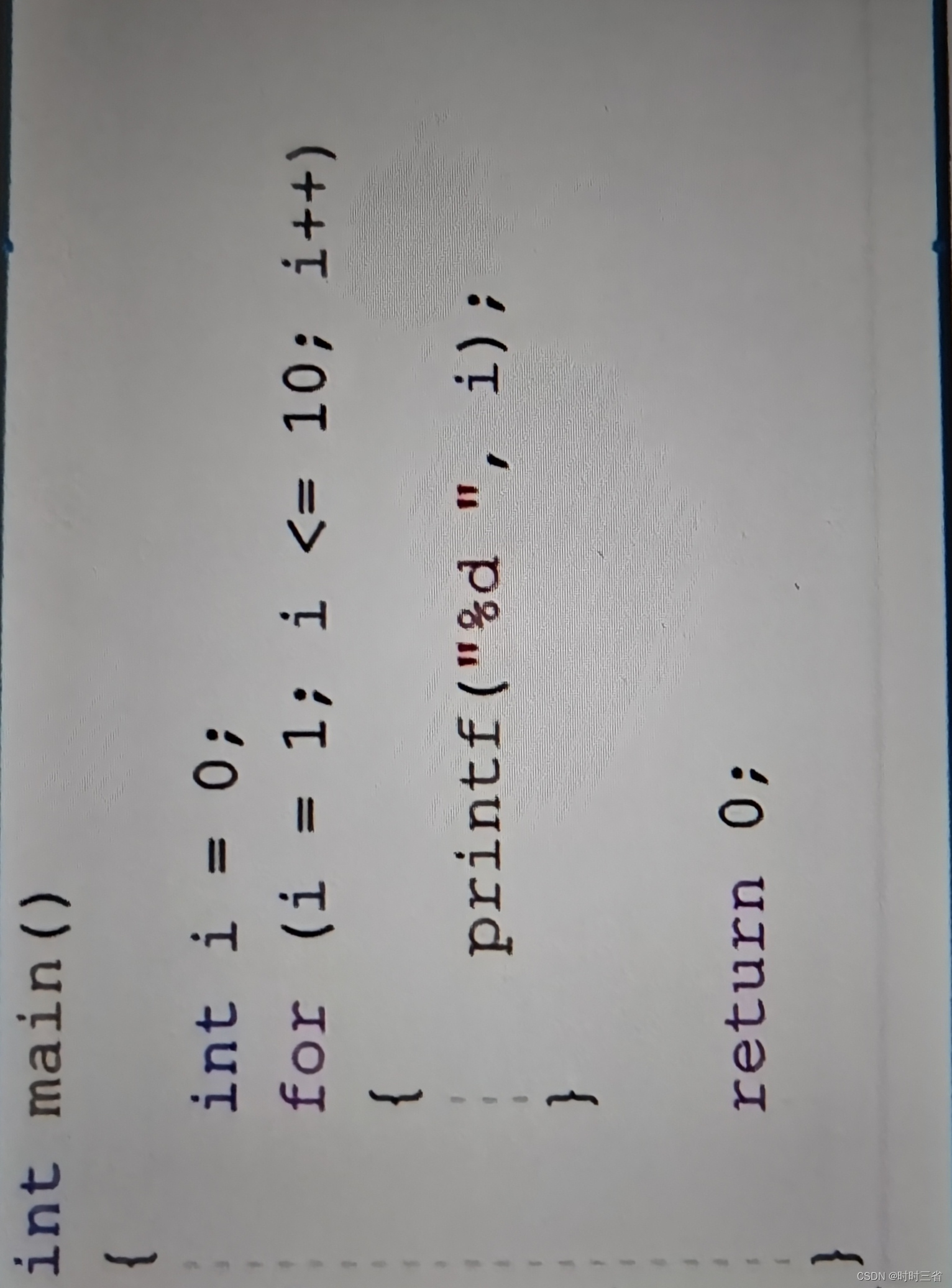

四、实际示例:推荐系统的投毒攻击

假设我们有一个电子商务平台的推荐系统,该系统使用机器学习模型来推荐用户可能感兴趣的产品。攻击者希望通过投毒攻击来提升某一特定产品的推荐概率。

攻击步骤:

-

数据投毒:攻击者购买大量该特定产品,并通过伪造的用户账户给该产品打高分,同时在评论中加入正面评价。这些数据被系统收集并用于训练推荐模型。

-

模型训练:由于训练数据集中包含了大量的伪造高分和正面评价,推荐系统在训练过程中会学到这个特定产品是用户喜欢的,从而提升其推荐概率。

-

验证效果:在系统上线后,攻击者的产品会频繁出现在用户的推荐列表中,达到了提升产品曝光率和销售的目的。

防范措施:

-

数据清洗和验证:对用户评论和评分数据进行严格的审核,识别和去除伪造账户和异常评分。

-

行为监控:监控系统上线后的推荐结果,检测异常的推荐模式和产品排名。

-

用户反馈:通过收集真实用户的反馈,及时发现和应对模型的异常行为,确保推荐系统的公平性和准确性。

五、总结

大模型投毒实验是一个严重的安全问题,需要在数据收集、模型训练、验证和部署的各个环节采取有效的防范措施。通过数据审查、模型验证、安全审计和用户反馈等手段,可以有效降低投毒攻击的风险,确保大模型的安全和可靠性。在人工智能技术不断发展的今天,模型的安全性问题将越来越受到关注,只有通过不断提升安全防护措施,才能应对日益复杂的安全威胁。通过以上方法,我们可以更好地保护大规模人工智能模型免受投毒攻击,确保其在各个应用场景中的安全和有效性。