Vocos: Closing the gap between time-domain and Fourier-based neural vocoders for high-quality audio synthesis

https://arxiv.org/abs/2306.00814

https://github.com/gemelo-ai/vocos?tab=readme-ov-file

文章目录

- Vocos:弥合时域和基于傅里叶的神经声码器之间的差距以实现高质量音频合成

- 摘要

- 1 引言

- 2 相关工作

- 基于GAN的声码器

- 相位和幅度估计

- 3 Vocos

- 3.1 概述

- 3.2 模型

- 3.3 损失

- 4 结果

- 4.1 Mel谱图

- 4.2 神经音频编解码器

- 4.3 推理速度

- 声码器简介

- Vocos的工作总结

Vocos:弥合时域和基于傅里叶的神经声码器之间的差距以实现高质量音频合成

Hubert Siuzdak ∗

摘要

近年来,神经声码器的进展主要由在时域中操作的生成对抗网络(GANs)驱动。尽管这种方法有效,但它忽视了时频表示所提供的归纳偏置,导致了冗余和计算密集的上采样操作。基于傅里叶的时频表示是一种有吸引力的替代方法,它更准确地与人类听觉感知对齐,并受益于为其计算而建立的快速算法。然而,复杂值谱图的直接重构一直存在问题,主要由于相位恢复问题。本研究旨在通过提出Vocos模型来弥合这一差距,该模型直接生成傅里叶频谱系数。我们的评估表明,Vocos不仅在音频质量上达到了最先进的水平,而且显著提高了计算效率,比现有的时域神经声码器方法快了一个数量级。源代码和模型权重已在https://github.com/gemelo-ai/vocos开源。

1 引言

声音合成是通过电子和计算手段生成音频信号的过程,具有悠久而丰富的创新历史。在文本到语音(TTS)的范围内,连接合成(Moulines & Charpentier, 1990; Hunt & Black, 1996)和统计参数合成(Yoshimura et al., 1999)曾是主要方法。后者策略依赖于语音产生的源-滤波器理论,其中语音信号被视为由源(声带)产生,然后由滤波器(声道)形状。根据这一框架,各种参数如音高、声道形状和发声被估计,然后用于控制声码器(Dudley, 1939),以重建最终的音频信号。尽管声码器显著演变(Kawahara et al., 1999; Morise et al., 2016),它们往往简化了语音生成,产生了独特的“嗡嗡”声,从而损害了语音的自然性。

语音合成领域的一个重大突破是WaveNet(Oord et al., 2016)的引入,这是一种用于原始音频波形的深度生成模型。WaveNet提出了一种通过在时域中自回归建模来处理音频信号的新方法,使用扩展卷积来扩大感受野,从而捕捉长程的时间依赖性。与传统的参数声码器依赖于音频信号的先验知识不同,WaveNet完全依赖于端到端学习。

自WaveNet问世以来,在时域中建模音频样本分布已成为音频合成领域最流行的方法。主要方法分为两大类:自回归模型和非自回归模型。自回归模型,如WaveNet,按顺序生成音频样本,每个新样本都以先前生成的样本为条件(Mehri et al., 2016; Kalchbrenner et al., 2018; Valin & Skoglund, 2019)。另一方面,非自回归模型独立生成所有样本,使过程并行化,从而提高计算效率(Oord et al., 2018; Prenger et al., 2019; Donahue et al., 2018)。

1.1 相位频谱建模的挑战

尽管时域音频合成取得了显著进展,生成信号的频谱表示的努力相对有限。虽然可以通过短时傅里叶变换(STFT)完美地重建原始信号,但在许多应用中,只使用STFT的幅度,导致固有的信息丢失。STFT的幅度通过指示不同频率分量在整个持续时间内的幅度,提供了对信号的清晰理解。相比之下,相位信息较不直观,其操作常常产生不可预测的结果。

由于相位谱在时频域中的复杂性质,建模相位分布面临挑战。相位谱表现出周期结构,导致在(−π, π]范围内的主值周围包裹(图1)。此外,文献中尚未就相位相关信息在语音感知中的重要性给出明确答案(Wang & Lim, 1982; Paliwal et al., 2011)。然而,改进的相位谱估计已被发现可以减少感知损伤(Saratxaga et al., 2012)。研究人员探索了使用深度学习直接建模相位谱,但这仍然是一个具有挑战性的领域(Williamson et al., 2015)。

1.2 贡献

使用生成模型来建模傅里叶相关系数的尝试并未取得与时域音频建模相同的成功。本研究旨在通过以下贡献来弥合这一差距:

- 我们提出了Vocos——一种基于GAN的声码器,训练生成音频片段的复杂STFT系数。与依赖转置卷积进行上采样的传统神经声码器架构不同,本工作建议在所有层中保持相同的特征时间分辨率。通过快速傅里叶变换逆变换实现波形的上采样。

- 为估计相位角,我们提出了一种简单的以单位圆定义的激活函数。这种方法自然地结合了隐式相位包络,确保了所有相位角的有意义值。

- 由于Vocos在网络中保持低时间分辨率,我们重新审视了使用典型于时域声码器的扩展卷积的需求。我们的结果表明,整合ConvNeXt(Liu et al., 2022)块有助于更好的性能。

- 我们的广泛评估表明,Vocos在音频质量上匹配了最先进水平,同时在速度上比时域对手快了一个数量级。源代码和模型权重已经开源,促进了神经声码器领域的进一步探索和潜在进展。

2 相关工作

基于GAN的声码器

生成对抗网络(GANs)(Goodfellow et al., 2014)在图像生成方面取得了显著成功,由于其快速和并行生成波形的能力,引起了音频研究人员的兴趣(Donahue et al., 2018;Engel et al., 2018)。通过引入高级评论家,如多尺度鉴别器(MSD)(Kumar et al., 2019)和多周期鉴别器(MPD)(Kong et al., 2020),取得了进展。这些工作还采用了特征匹配损失,以最小化真实和合成音频的鉴别器特征图之间的距离。为了区分真实和生成的样本,还使用了多分辨率谱图(MRD)(Jang et al., 2021)。

目前的标准做法是使用扩展卷积堆栈来增加感受野,并使用转置卷积将特征序列逐步上采样到波形。然而,这种设计容易受到混叠伪影的影响,并且有研究建议为鉴别器(Bak et al., 2022)和生成器(Lee et al., 2022)提供更专业的模块。质量的历史性跃升主要归因于能够通过在不同周期或尺度上检查输入音频信号来捕捉隐式结构的鉴别器。有观点认为(You et al., 2021),在一个完善的多分辨率鉴别框架下,生成器的架构细节不会显著影响声码器的结果。与这些方法相反,Vocos提出了一个精心设计的、频率感知的生成器,它建模傅里叶频谱系数的分布,而不是在时域中建模波形。

相位和幅度估计

历史上,相位估计问题一直是音频信号重构的核心。传统方法通常依赖Griffin-Lim算法(Griffin & Lim, 1984),通过强制谱图一致性迭代估计相位。然而,Griffin-Lim方法会在合成语音中引入不自然的伪影。已经提出了几种使用深度神经网络重构相位的方法,包括基于似然的方法(Takamichi et al., 2018)和GANs(Oyamada et al., 2018)。另一种工作方向建议感知相位量化(Kim, 2003),通过将相位估计问题视为分类问题,在深度学习中显示出希望(Takahashi et al., 2018)。

尽管这些模型有效,但它们假设了一个完整的幅度谱图的可用性,而现代音频合成管道通常使用更紧凑的表示,如mel谱图(Shen et al., 2018)。此外,最近的研究集中在利用预训练深度学习模型提取的潜在特征(Polyak et al., 2021;Siuzdak et al., 2022)。与本文更相关的是估计幅度和相位谱的研究。这可以通过隐式地预测STFT的实部和虚部,或显式地将模型参数化以生成相位和幅度分量。在前一种情况下,Gritsenko等人(2020)提出了一种变体模型,训练生成STFT系数。他们认识到对抗性目标在防止机器人声音质量方面的重要性,但由于其固有的不稳定性,他们未能成功训练。另一方面,iSTFTNet(Kaneko et al., 2022)提出了对HiFi-GAN的修改,使其能够返回幅度和相位谱。然而,他们的最佳模型仅用逆STFT替换了最后两个上采样块,而大部分上采样仍通过转置卷积实现。他们发现,替换更多的上采样层会显著降低质量。Pasini & Schl¨uter(2022)成功地以更高的频率分辨率建模了音频的幅度和相位谱,尽管这需要多步训练(Caillon & Esling, 2021),因为对抗性目标的不稳定性。此外,最初使用GAN生成可逆谱图的研究涉及估计瞬时频率(Engel et al., 2018)。然而,这些研究仅限于包含单个乐器音符的单一数据集,并假设瞬时频率是恒定的。

3 Vocos

3.1 概述

所提出的GAN模型的核心使用基于傅里叶的时频表示作为生成器的目标数据分布。Vocos的构建没有任何转置卷积;相反,上采样操作完全通过快速逆STFT实现。这种方法允许与时域声码器相比,采用独特的模型设计,后者通常采用一系列上采样层将输入特征膨胀到目标波形的分辨率,通常需要上采样几百倍。相比之下,Vocos在整个网络中保持相同的时间分辨率(图2)。这种设计,被称为各向同性架构,已在包括Transformer(Vaswani et al., 2017)在内的各种设置中表现良好。这种方法对于音频合成也特别有利。传统方法通常使用转置卷积,这可能引入混叠伪影,需要额外的措施来缓解这一问题(Karras et al., 2021;Lee et al., 2022)。Vocos消除了可学习的上采样层,而是使用公认的逆傅里叶变换来重建原始尺度的波形。在将mel谱图转换为音频信号的背景下,时间分辨率由STFT的跳跃大小决定。

Vocos使用短时傅里叶变换(STFT)在时频域中表示音频信号:

STFT

x

[

m

,

k

]

=

∑

n

=

0

N

−

1

x

[

n

]

w

[

n

−

m

]

e

−

j

2

π

k

n

/

N

\text{STFT} x [m,k] = \sum_{n=0}^{N-1} x[n]w[n − m]e^{-j2πkn/N}

STFTx[m,k]=n=0∑N−1x[n]w[n−m]e−j2πkn/N

STFT将傅里叶变换应用于信号的连续加窗部分。在实践中,STFT通过对数据的重叠、加窗帧序列进行快速傅里叶变换(FFT)来计算,随着窗口函数在时间上的推进或“跳跃”而创建这些帧。

3.2 模型

骨干网络 Vocos采用ConvNeXt(Liu et al., 2022)作为生成器的基础骨干网络。它首先将输入特征嵌入到一个隐藏维度中,然后应用一堆1D卷积块。每个块包括一个深度卷积,随后是一个反向瓶颈,使用点卷积将特征投影到更高的维度。GELU(高斯误差线性单元)激活函数用于瓶颈内,层归一化用于块之间。

头部 真实值信号的傅里叶变换是共轭对称的,因此我们只使用单侧带谱,每帧产生

n

f

f

t

/

2

+

1

n_{fft}/2 + 1

nfft/2+1个系数。当我们将模型参数化为输出相位和幅度值时,隐藏维度激活投影到一个具有

n

f

f

t

+

2

n_{fft} + 2

nfft+2通道的张量h,并分割为:

m

,

p

=

h

[

1

:

(

n

f

f

t

/

2

+

1

)

]

,

h

[

(

n

f

f

t

/

2

+

2

)

:

n

]

m,p = h[1 : (n_{fft}/2 + 1)],h[(n_{fft}/2 + 2) : n]

m,p=h[1:(nfft/2+1)],h[(nfft/2+2):n]

为了表示幅度,我们对m应用指数函数:

M

=

exp

(

m

)

M = \exp(m)

M=exp(m)。我们通过计算p的余弦和正弦将其映射到单位圆上,以分别获得x和y:

x

=

cos

(

p

)

y

=

sin

(

p

)

x = \cos(p) \\ y = \sin(p)

x=cos(p)y=sin(p)

最后,我们将复数系数表示为:

STFT

=

M

⋅

(

x

+

j

y

)

\text{STFT} = M \cdot (x + jy)

STFT=M⋅(x+jy)

重要的是,这种简单的公式允许表达相位角

ϕ

=

atan2

(

y

,

x

)

\phi = \text{atan2}(y,x)

ϕ=atan2(y,x),对于任何实参数p,它确保

ϕ

\phi

ϕ被正确地包裹在期望范围内(

−

π

,

π

−π,π

−π,π)。

鉴别器 我们采用多周期鉴别器(MPD)(Kong et al., 2020)和多分辨率鉴别器(MRD)(Jang et al., 2021)。

3.3 损失

遵循Kong等人(2020)提出的方法,Vocos的训练目标包括重建损失、对抗性损失和特征匹配损失。然而,我们采用了铰链损失公式,而不是最小二乘GAN目标,如Zeghidour等人(2021)所建议:

ℓ

G

(

x

^

)

=

1

K

∑

k

max

(

0

,

1

−

D

k

(

x

^

)

)

ℓ

D

(

x

,

x

^

)

=

1

K

∑

k

max

(

0

,

1

−

D

k

(

x

)

)

+

max

(

0

,

1

+

D

k

(

x

^

)

)

\ell_G(\hat{x}) = \frac{1}{K} \sum_k \max(0,1 − D_k(\hat{x})) \\ \ell_D(x,\hat{x}) = \frac{1}{K} \sum_k \max(0,1 − D_k(x)) + \max(0,1 + D_k(\hat{x}))

ℓG(x^)=K1k∑max(0,1−Dk(x^))ℓD(x,x^)=K1k∑max(0,1−Dk(x))+max(0,1+Dk(x^))

其中,

D

k

D_k

Dk是

第k个子鉴别器。重建损失表示为L1距离:

L

m

e

l

=

∣

∣

M

(

x

)

−

M

(

x

^

)

∣

∣

1

L_{mel} = ||M(x) − M(\hat{x})||_1

Lmel=∣∣M(x)−M(x^)∣∣1

特征匹配损失L_feat计算为kth子鉴别器的第l个特征图之间距离的平均值:

L

f

e

a

t

=

1

K

L

∑

k

∑

l

∣

∣

D

k

l

(

x

)

−

D

k

l

(

x

^

)

∣

∣

1

L_{feat} = \frac{1}{KL} \sum_k \sum_l ||D^l_k(x) − D^l_k(\hat{x})||_1

Lfeat=KL1k∑l∑∣∣Dkl(x)−Dkl(x^)∣∣1

4 结果

4.1 Mel谱图

从mel谱图重构音频波形已成为现代语音合成管道中声码器的基本任务。在本节中,我们评估了Vocos相对于已建立基线方法的性能。

数据 模型在LibriTTS数据集(Zen et al., 2019)上训练,我们使用了整个训练子集(包括train-clean和train-other)。音频文件的原始采样率为24 kHz。对于每个音频样本,我们使用以下参数计算mel谱图: n f f t = 1024 n_{fft} = 1024 nfft=1024,跳跃大小 n = 256 n = 256 n=256,Mel频带数设置为100。对音频样本应用随机增益,导致最大电平在-1到-6 dBFS之间。

训练细节 我们将模型训练到200万次迭代,每个生成器和鉴别器100万次迭代。训练期间,随机裁剪音频样本到16384个样本,批量大小为16。模型使用AdamW优化器进行优化,初始学习率为2e-4,贝塔参数设置为(0.9, 0.999)。学习率按照余弦调度衰减。

表1:各种模型的客观评估指标,包括基线模型(HiFi-GAN,iSTFTNet,BigVGAN)和Vocos。

| ------ | ------ | ------ | ------ | ------ |

|---|---|---|---|---|

| 模型 | UTMOS (↑) | VISQOL (↑) | PESQ (↑) | V/UV F1 (↑) |

| 真实值 | 4.058 | - | - | - |

| HiFi-GAN | 3.669 | 4.57 | 3.093 | 0.9457 |

| iSTFTNet | 3.564 | 4.56 | 2.942 | 0.9372 |

| BigVGAN | 3.749 | 4.65 | 3.693 | 0.9557 |

| Vocos | 3.734 | 4.66 | 3.70 | 0.9582 |

| 绝对相位 | 3.590 | 4.65 | 3.565 | 0.9556 |

| Snake激活 | 3.699 | 4.66 | 3.629 | 0.9579 |

| 无ConvNeXt | 3.658 | 4.65 | 3.528 | 0.9534 |

基线方法 我们的Vocos模型与iSTFTNet(Kaneko et al., 2022)、BigVGAN(Lee et al., 2022)和HiFi-GAN(Kong et al., 2020)进行了比较。这些模型在相同的LibriTTS子集上重新训练了200万次迭代,遵循作者推荐的原始训练细节。我们使用BigVGAN、HiFi-GAN的官方实现和一个社区开源版本的iSTFTNet。

评估

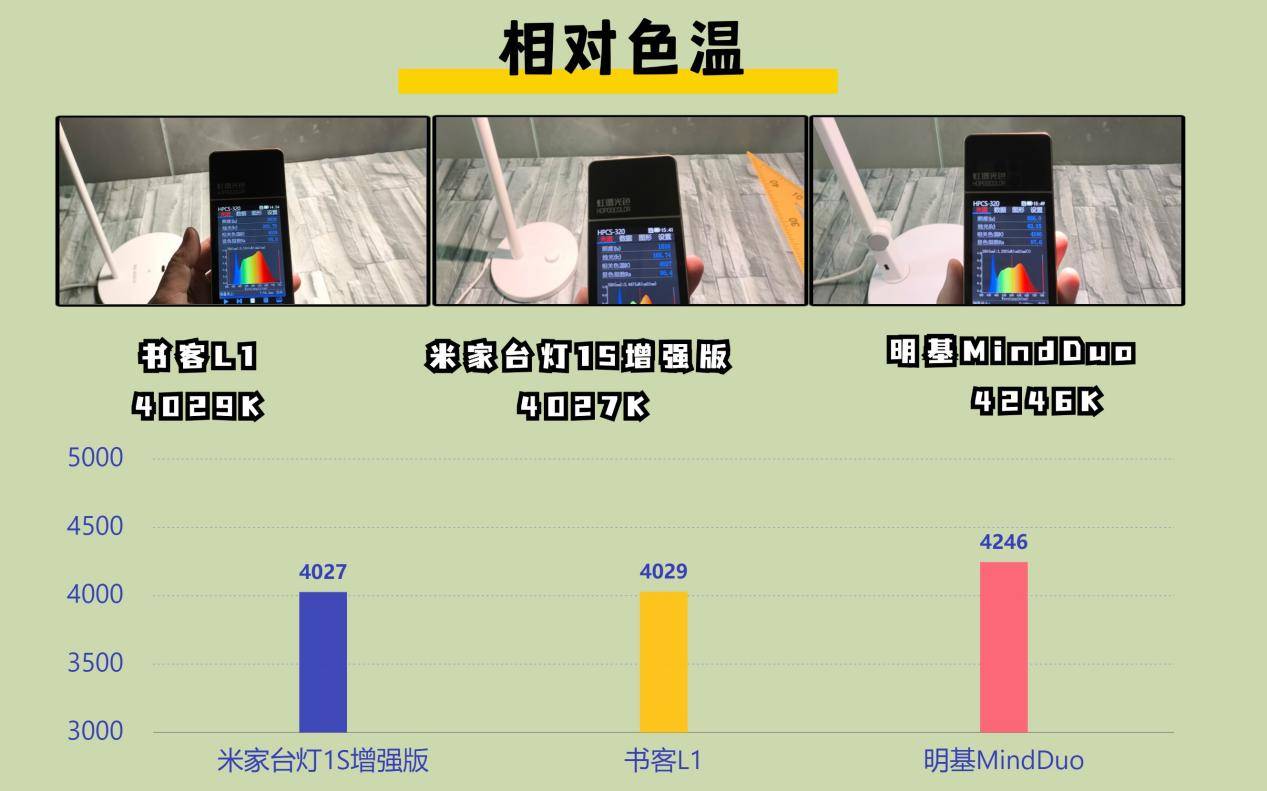

客观评估 我们使用UTMOS(Saeki et al., 2022)自动平均意见得分(MOS)预测系统对我们的模型进行客观评估。虽然UTMOS可以产生与人类评估高度相关的分数,但它仅限于16 kHz的采样率。为了评估感知质量,我们还使用ViSQOL(Chinen et al., 2020)音频模式,它在全频带上运行。我们的评估过程还包括其他几个指标,包括语音质量感知评估(PESQ)(Rix et al., 2001)、周期性误差和有声/无声分类(V/UV F1)的F1分数,方法参照Morrison等人(2021)。结果见表1。Vocos在大多数指标中比其他模型表现更优。它在VISQOL和PESQ中获得最高分。重要的是,它还有效地减轻了时域GANs中常见的周期性问题。BigVGAN在UTMOS指标中表现最接近,略微超过Vocos。

在我们的消融研究中,我们检查了特定设计决策对Vocos性能的影响:

- Vocos绝对相位:在这种变体中,我们使用tanh非线性缩放到 [ − π , π ] [−π,π] [−π,π]范围内预测相位角。此公式未给模型提供有关相位周期性的归纳偏置,结果显示其质量下降。这一发现强调了隐式相位包络在Vocos有效性中的重要性。

- Vocos使用Snake激活:尽管Snake(Ziyin等, 2020)在增强时域声码器如BigVGAN方面表现出色,但在我们的情况下,并未带来性能提升,实际上略有下降。Snake函数的主要目的是引入周期性,解决时域声码器的局限性。Vocos通过使用傅里叶基函数显式地结合了周期性,消除了对专门模块如Snake的需求。

- 无ConvNeXt的Vocos:将ConvNeXt块替换为传统的具有扩展卷积的ResBlocks,在所有评估指标中得分略低。这一发现突显了ConvNeXt块在Vocos中的重要作用,显著贡献了其整体成功。

表2:主观评估指标——具有95%置信区间的5级平均意见得分(MOS)和相似性平均意见得分(SMOS)。

| 模型 | MOS (↑) | SMOS (↑) |

|---|---|---|

| 真实值 | 3.81±0.16 | 4.70±0.11 |

| HiFi-GAN | 3.54±0.16 | 4.49±0.14 |

| iSTFTNet | 3.57±0.16 | 4.42±0.16 |

| BigVGAN | 3.64±0.15 | 4.54±0.14 |

| Vocos | 3.62±0.15 | 4.55±0.15 |

主观评估 我们进行了众包主观评估,使用5分制平均意见得分(MOS)评估所呈现录音的自然性。参与者对语音样本从1(“差——完全不自然的语音”)到5(“优秀——完全自然的语音”)进行了评分。根据(Lee等, 2022),我们还进行了重现录音和真实录音之间的5分制相似性平均意见得分(SMOS)。参与者被要求为音频文件对分配相似性分数,评分为5表示“极其相似”,评分为1表示“完全不相似”。

为了确保响应质量,我们通过第三方众包平台精心选择了参与者。我们的标准包括使用耳机、流利的英语水平和对音乐听作为爱好的声明。共收集了1560个评分,来自39名参与者。

结果详见表2。Vocos在感知质量和相似性方面表现与最先进技术相当。统计测试显示,Vocos和BigVGAN在MOS和SMOS分数上没有显著差异,来自Wilcoxon符号秩检验的p值均大于0.05。

表3:在MUSDB18数据集上测试的各种模型的VISQOL得分。更高的VISQOL得分表示更好的感知音质。

| 模型 | 混音 | 鼓 | 贝斯 | 其他 | 人声 | 平均 |

|---|---|---|---|---|---|---|

| HiFi-GAN | 4.46 | 4.40 | 4.12 | 4.44 | 4.54 | 4.39 |

| iSTFTNet | 4.47 | 4.48 | 3.80 | 4.40 | 4.53 | 4.34 |

| BigVGAN | 4.60 | 4.60 | 4.29 | 4.58 | 4.64 | 4.54 |

| Vocos | 4.61 | 4.61 | 4.31 | 4.58 | 4.66 | 4.55 |

分布外数据 声码器的一个关键方面是其泛化到未见声学条件的能力。在这种情况下,我们使用

MUSDB18数据集(Rafii et al., 2017)评估了Vocos在分布外音频上的性能,该数据集包括各种多轨音乐音频,如人声、鼓、贝斯和其他乐器,以及原始混音。此评估的VISQOL得分如表3所示。Vocos在所有类别中均表现优于其他模型,获得最高分。

图3展示了不同模型重现的分布外歌唱声音样本的谱图可视化。使用时域GANs时通常观察到周期性伪影。BigVGAN通过其抗混叠滤波器,能够恢复一些高频范围内的谐波,表现优于HiFi-GAN。然而,Vocos似乎能够更准确地重建这些谐波,无需额外模块。

4.2 神经音频编解码器

传统上,神经声码器从mel尺度谱图重建音频波形——这种方法在许多语音合成管道中被广泛采用——最近的研究开始利用学习到的特征(Siuzdak et al., 2022),通常以量化形式(Borsos et al., 2022)。

在本节中,我们与开源神经音频编解码器EnCodec(D´efossez et al., 2022)进行了比较,该编解码器采用典型的时域GAN声码器架构,并使用残差矢量量化(RVQ)(Zeghidour et al., 2021)压缩潜在空间。RVQ级联了多个矢量量化层,逐步量化前一阶段的残差,形成一个多阶段结构,从而支持多种带宽目标。在EnCodec中,为每个带宽训练专用鉴别器。相反,我们将Vocos调整为带有投影鉴别器(Miyato & Koyama, 2018)的条件GAN,并在生成器中加入自适应层归一化(Huang & Belongie, 2017)。

音频重建 我们利用24 kHz运行的开源EnCodec模型检查点。为了与EnCodec对齐,我们将Vocos缩小到匹配其参数数量(7.9M)并在DNS挑战赛(Dubey et al., 2022)中提取的干净语音片段上训练。我们的评估在DAPS数据集(Mysore, 2014)上进行,结果详见表4,尽管EnCodec的重建伪影不会显著影响PESQ和周期性得分,但在感知得分UTMOS中显著反映出来。在这方面,Vocos明显优于EnCodec。我们还进行了众包主观评估以评估这些样本的自然性。结果如表5所示,根据人类听众的评估,Vocos在多个带宽上表现更好。

表4:各种带宽计算的客观评估指标。

| 带宽 | UTMOS (↑) | VISQOL (↑) | PESQ (↑) | V/UV F1 (↑) | 周期性 (↓) |

|---|---|---|---|---|---|

| EnCodec 1.5 kbps | 1.527 | 3.74 | 1.508 | 0.8826 | 0.215 |

| EnCodec 3.0 kbps | 2.522 | 3.93 | 2.006 | 0.9347 | 0.141 |

| EnCodec 6.0 kbps | 3.262 | 4.13 | 2.665 | 0.9625 | 0.090 |

| EnCodec 12.0 kbps | 3.765 | 4.25 | 3.283 | 0.9766 | 0.062 |

| Vocos 1.5 kbps | 3.210 | 3.88 | 1.845 | 0.9238 | 0.160 |

| Vocos 3.0 kbps | 3.688 | 4.06 | 2.317 | 0.9380 | 0.135 |

| Vocos 6.0 kbps | 3.822 | 4.22 | 2.650 | 0.9439 | 0.124 |

| Vocos 12.0 kbps | 3.882 | 4.34 | 2.874 | 0.9482 | 0.116 |

表5:各种带宽的主观评估指标——具有95%置信区间的5级平均意见得分(MOS)。

| 带宽 | Vocos | EnCodec |

|---|---|---|

| 1.5 kbps | 2.73±0.20 | 1.09±0.05 |

| 3 kbps | 3.50±0.18 | 1.71±0.21 |

| 6 kbps | 3.84±0.16 | 2.41±0.15 |

| 12 kbps | 4.00±0.16 | 3.08±0.19 |

| 真实值 | 4.09±0.16 | - |

端到端文本到语音 最近在文本到语音(TTS)方面的进展显著由使用离散音频令牌的语言建模架构驱动。Bark(Suno AI, 2023)是一个广受认可的开源模型,利用GPT风格、仅解码器架构,以EnCodec的6 kbps音频令牌作为其词汇表。Vocos训练重构EnCodec令牌,可以有效地作为Bark的替代声码器。我们在我们的网站上提供了Bark和Vocos的文本到语音样本,鼓励读者直接聆听进行比较。

4.3 推理速度

我们的推理速度基准测试使用Nvidia Tesla A100 GPU和AMD EPYC 7542 CPU进行。代码在Pytorch中实现,没有硬件特定的优化。

表6:模型占用空间和生成速度。xRT表示相对于实时的速度因子。更高的xRT值表示模型能够比实时更快生成语音,值为1.0表示实时速度。

| 模型 | GPU | CPU | 参数 |

|---|---|---|---|

| HiFi-GAN | 495.54 | 5.84 | 14.0 M |

| BigVGAN | 98.61 | 0.40 | 14.0 M |

| ISTFTNet | 1045.94 | 14.44 | 13.3 M |

| Vocos | 6696.52 | 169.63 | 13.5 M |

| 无ConvNeXt | 4565.71 | 193.56 | 14.9 M |

结论

本文介绍了Vocos,一种新型的神经声码器,弥合了时域和基于傅里叶方法之间的差距。Vocos解决了直接重建复数谱图的挑战,通过精心设计的生成器正确处理相位包络。它能够准确重建傅里叶时频表示中的系数。结果表明,所提出的声码器在音频质量上匹配最先进水平,同时有效缓解了时域GAN中常见的周期性问题。重要的是,Vocos通过利用逆快速傅里叶变换进行上采样,提供了比传统时域方法显著的计算效率优势。

总体而言,本研究的发现通过结合基于傅里叶的时频表示的优点,为神经声码器技术的进步做出了贡献。源代码和模型权重的开源允许进一步探索和在各种音频处理任务中的应用。

声码器简介

声码器(Vocoder,全称为Voice Coder)是一种音频信号处理技术,最初用于语音信号的编码和解码。它的主要功能包括语音信号的分析、合成和变换。声码器的核心思想是通过将语音分解为若干特征参数(如频率、幅度、相位等),然后在解码时根据这些参数重新合成语音。

在文本到语音(Text-to-Speech,TTS)系统中,声码器的作用是将生成的声谱图转换为可听的音频信号。TTS系统一般包括三个主要阶段:

- 文本分析(Text Analysis): 解析输入文本,生成语音参数(如韵律、语调、音素序列等)。

- 声学模型(Acoustic Model): 根据语音参数生成对应的声谱图(如Mel谱图)。

- 声码器(Vocoder): 将声谱图转换为最终的音频波形。

声码器在TTS系统中工作于最后一个阶段,即将由声学模型生成的声谱图转换为实际的音频信号,使其能够被人耳听到。

Vocos的工作总结

Vocos是一种新型的基于生成对抗网络(GANs)的声码器,其主要贡献和特点如下:

-

傅里叶频谱系数生成: 与传统时域声码器通过转置卷积上采样不同,Vocos直接生成音频片段的复杂短时傅里叶变换(STFT)系数。上采样操作通过快速傅里叶逆变换(iSTFT)实现,从而避免了时域上采样过程中的混叠伪影问题。

-

相位估计方法: Vocos提出了一种基于单位圆的简单激活函数,用于估计相位角。这种方法自然地结合了隐式相位包络,确保了所有相位角的有意义值。

-

模型架构设计: Vocos采用了ConvNeXt作为生成器的基础骨干网络,并在网络中保持相同的时间分辨率(即各向同性架构),而不是传统的多层上采样。这种设计显著提高了计算效率,并改善了音频质量。

-

性能提升: Vocos在多个音频质量评估指标(如VISQOL、PESQ等)上匹配或超越了现有的最先进模型,并在计算速度上比时域声码器快了一个数量级。

-

开源: Vocos的源代码和模型权重已开源,促进了神经声码器领域的进一步探索和潜在进展。

总体而言,Vocos通过在生成对抗网络中直接建模傅里叶频谱系数,实现了高质量音频合成,并在计算效率上取得了显著的提升。