一 背景

GPT1:Generative Pre-Training。是一种生成式的预训练模型,由OpenAi团队发表自论文《Improving Language Understanding by Generative Pre-Training》。

h0=UWe+Wp

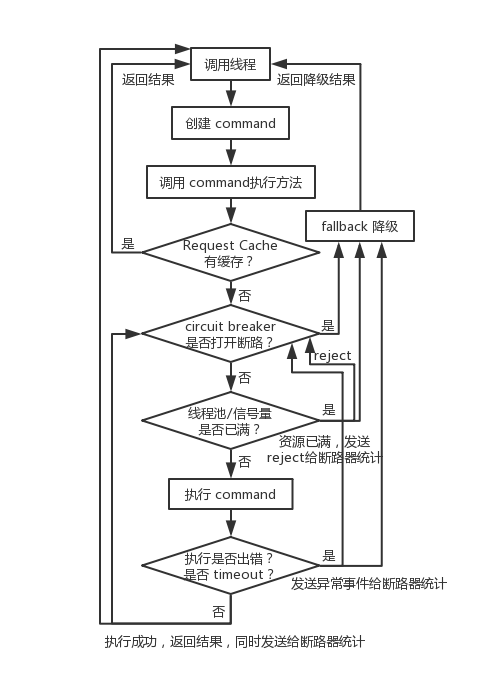

二 模型整体结构(宏观)

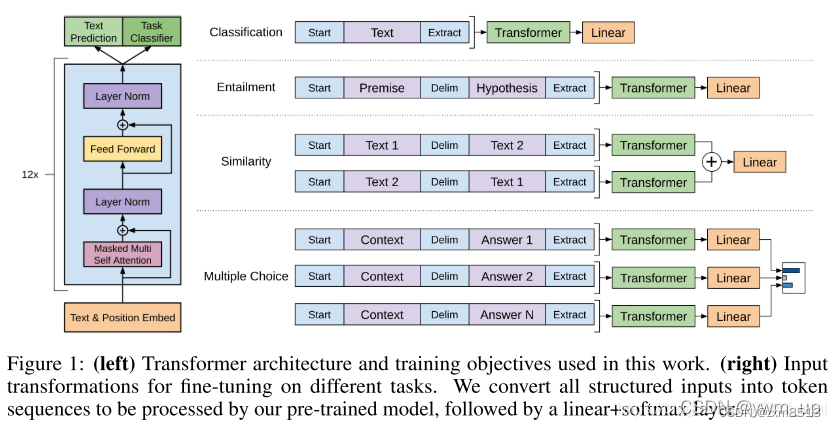

图1 GPT整体结构

左侧为模型的整体结构,由12个Transformer中的Decoder模块经修改后组成(Transformer本身是由6个Encoder和6个Decoder组成)。

三 模型细节(微观)

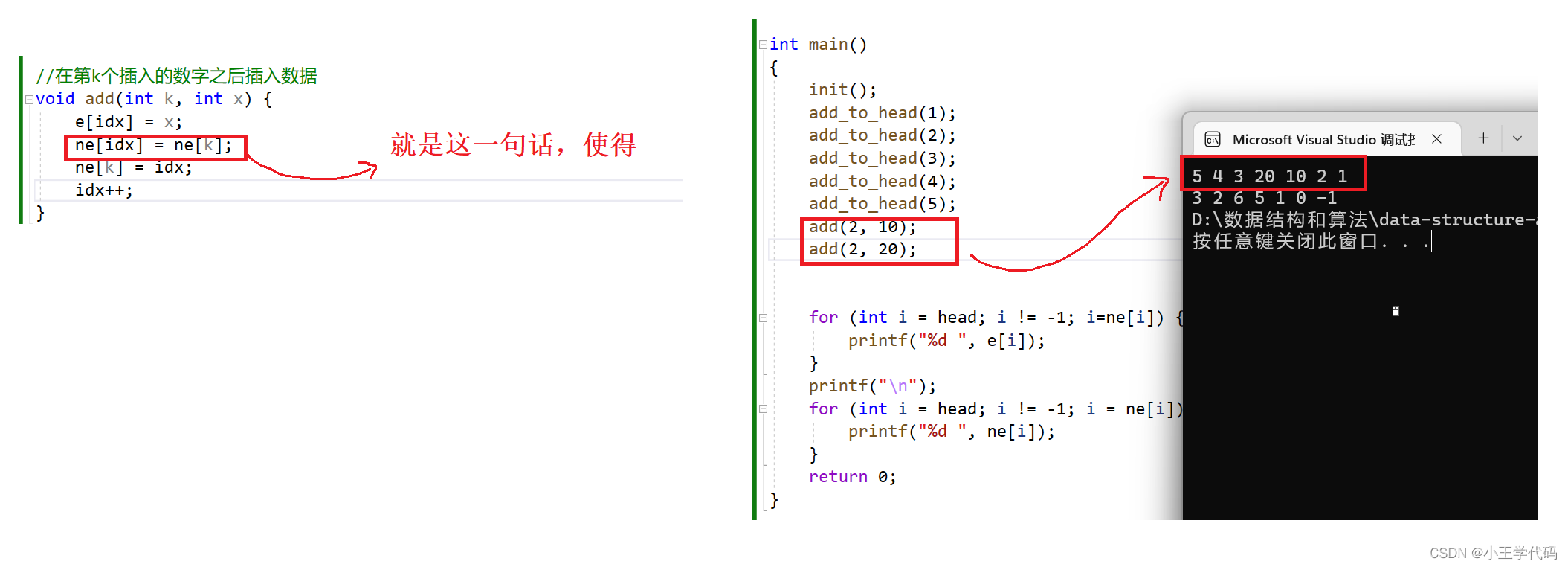

1.Decoder的