大坑从此开始~~~~

目录

1. 定义

2.发展历程和典型事件

2.1. 发展历程

2.2. 典型事件

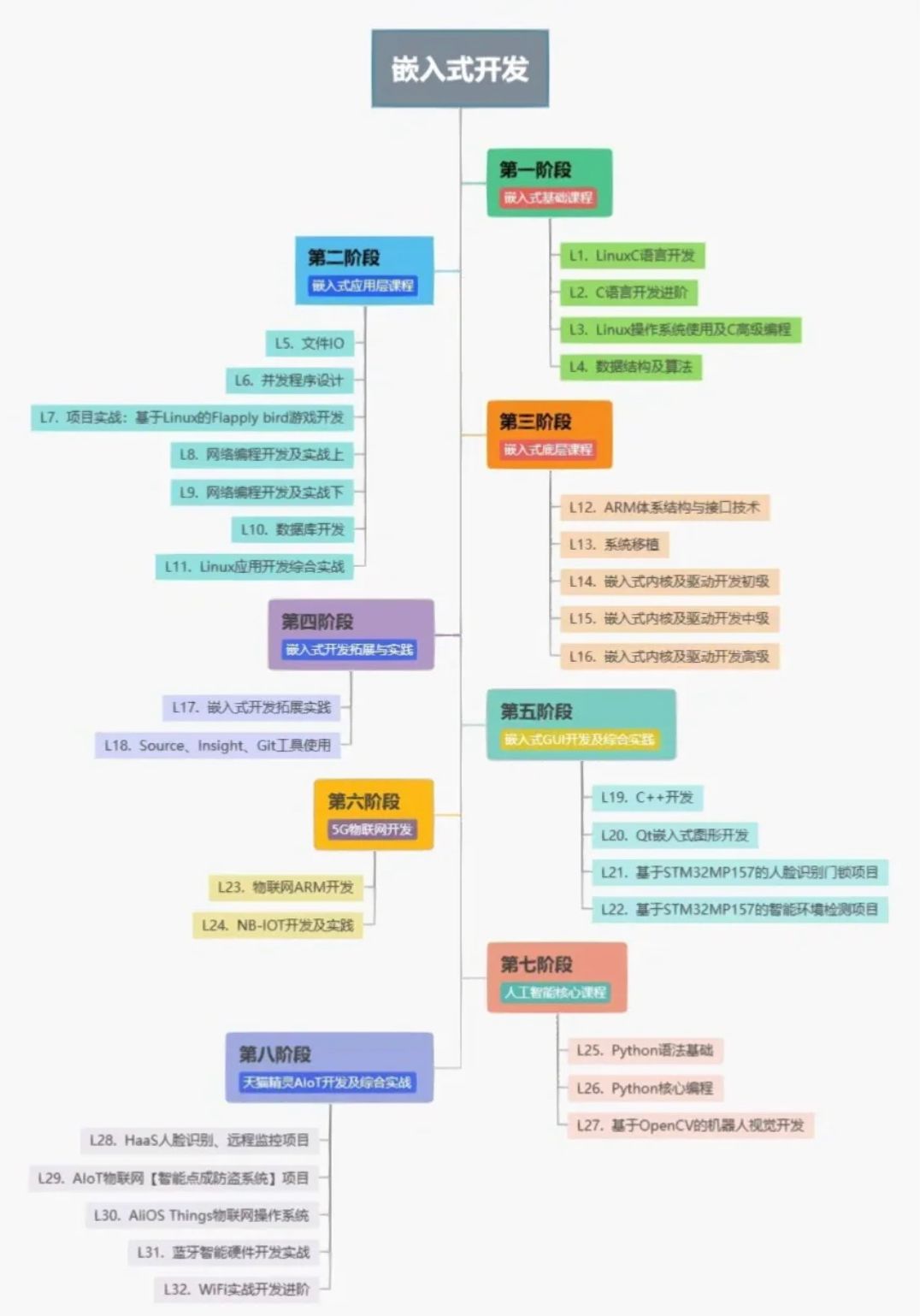

3. 学习类型

3.1. 监督学习

3.2. 无监督学习

3.3. 半监督学习

3.3.1.定义与基本思想

3.3.2. 发展历程与应用场景

3.3.3. 核心算法与优势

3.3.4. 实际应用案例

3.4. 游戏AI的半监督学习

3.4.1. 游戏AI为什么选择半监督学习

3.4.2. 典型示例

3.4.3. 代码示例

机器学习是一门多领域交叉学科,它涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。机器学习专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构,从而不断改善自身的性能。它是人工智能的核心,是使计算机具有智能的根本途径。

1. 定义

机器学习有多种定义,其中一些重要的定义包括:

- 机器学习是一门人工智能的科学,该领域的主要研究对象是人工智能,特别是如何在经验学习中改善具体算法的性能。

- 机器学习是对能通过经验自动改进的计算机算法的研究。

- 机器学习是用数据或以往的经验,以此优化计算机程序的性能标准。

2.发展历程和典型事件

2.1. 发展历程

机器学习的发展历程可以追溯到几个世纪前,但真正的快速发展是在过去几十年里。以下是一些重要的发展阶段:

- 起源阶段:机器学习的起源可以追溯到对人工神经网络的研究,这一研究早于1946年世界上第一台电子计算机ENIAC的发明。1943年,Warren McCulloch和Walter Pitts提出了神经网络层次结构模型(又称M-P神经元模型),为机器学习的发展奠定了基础。

- 推理期(20世纪50-70年代初):在这一阶段,人们认为只要给机器赋予逻辑推理能力,机器就具有智能。例如,A.Newell和H.Simon的“逻辑理论家”和“通用问题求解”程序,就是因为其逻辑推理能力而获得了1975年的图灵奖。

- 知识期(20世纪70年代中期):此时期人们认为,要使机器具有智能,就必须设法使机器拥有知识。E.A.Feigenbaum作为“知识工程”之父,因其在这一领域的贡献而获得了1994年的图灵奖。

- 学科形成与发展(20世纪80年代至今):20世纪80年代,机器学习开始形成一个独立的学科领域,并快速发展。1980年,美国卡内基梅隆大学举行了第一届机器学习研讨会,标志着这一学科的正式形成。此后,各种机器学习技术如百花齐放般涌现。到了20世纪90年代后,统计学方法在机器学习中占据主导地位,其中的代表是支持向量机(SVM)。而自2006年至今,基于大数据分析的需求,神经网络又被重新发现和应用,成为深度学习理论的基础。

2.2. 典型事件

- 神经网络模型的提出:如前所述,1943年Warren McCulloch和Walter Pitts提出的神经网络层次结构模型是机器学习的重要基石。

- 机器学习的概念提出:1952年Arthur Samuel提出了“机器学习”的概念,为这一领域的发展指明了方向。

- IBM的下棋程序:在20世纪50年代,IBM的Arthur Samuel开发了一种下棋的电脑程序。由于程序运行的计算机内存有限,Samuel发明了alpha-beta剪枝算法来优化搜索效率。这一事件不仅是机器学习在棋类游戏中的一个重要应用,也展示了机器学习在资源受限条件下的优化能力。

- 机器学习在信用卡欺诈检测中的应用:近年来,机器学习在信用卡欺诈检测中发挥了重要作用。例如,万事达卡使用多层机器学习和人工智能工具来清除恶意用户并防止欺诈损失。自2016年以来,这些工具已经帮助万事达卡避免了约10亿美元的欺诈损失。这一事件展示了机器学习在金融安全领域中的实际应用和显著效果。

3. 学习类型

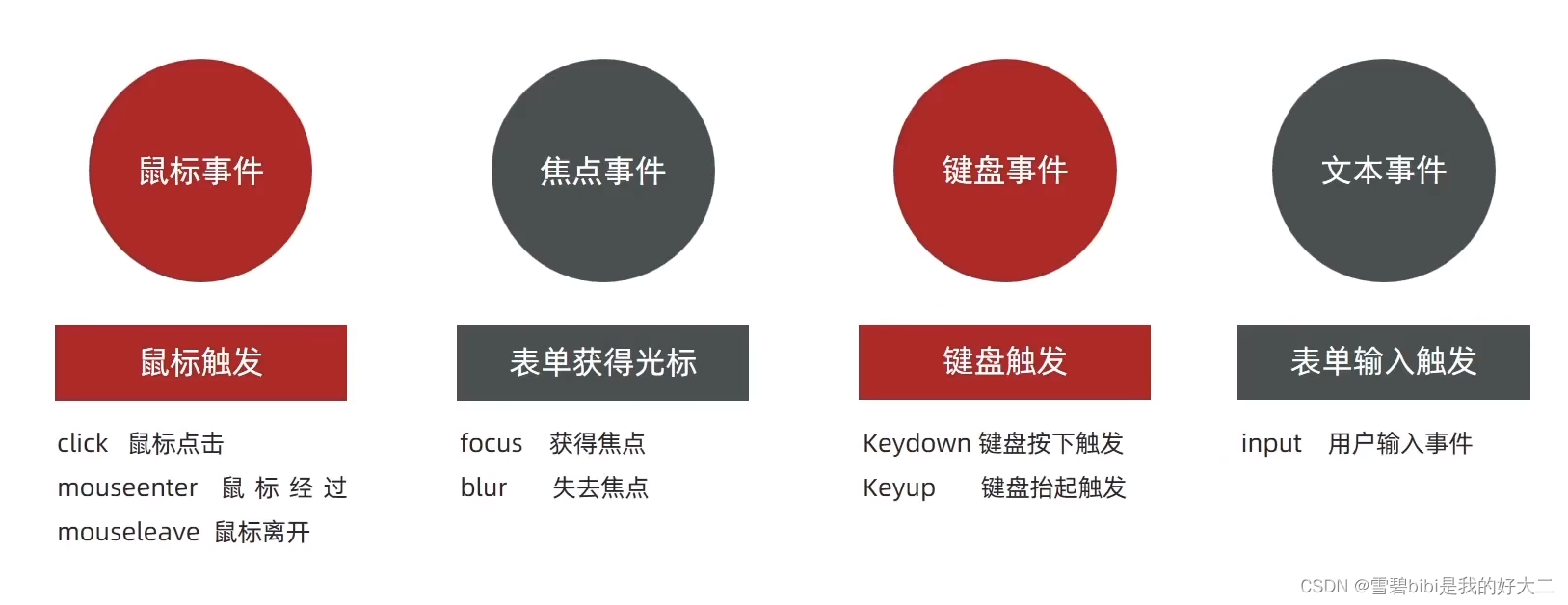

机器学习算法可以分为监督学习、无监督学习和半监督学习等类型。下面将详细介绍这三种学习方式。

3.1. 监督学习

定义:监督学习是机器学习的一种类型,其中模型通过学习带有标签的训练数据来预测新的、未知的输入数据的输出。标签为模型提供了“正确答案”,使其能够学习输入与输出之间的映射关系。

主要任务:监督学习的主要任务包括分类和回归。分类是预测离散值,如图像识别中的猫或狗;回归则是预测连续值,如根据房屋面积预测房价。

训练过程:在监督学习中,数据集通常被划分为训练集和测试集。训练集用于训练模型,而测试集用于评估模型在未见过的数据上的性能。

应用:监督学习广泛应用于图像识别、语音识别、自然语言处理等领域。

3.2. 无监督学习

定义:

无监督学习是另一种机器学习类型,其中算法在没有标签的数据上进行训练。算法必须自己发现数据中的结构和模式。

主要特点:

- 模式发现:无监督学习旨在发现数据中隐藏的模式或结构,如聚类算法可以识别数据集中的相似数据点群。

- 降维:无监督学习可用于将数据从高维空间转化到低维空间,便于可视化和解释。

- 异常检测:无监督学习算法能够检测数据集中的异常数据点,有助于识别罕见但重要的事件。

常见算法:

包括K-means、分层聚类等聚类算法,以及PCA(主成分分析)等降维算法。

应用:

无监督学习在市场营销、生物学、网络安全等领域有广泛应用,如客户细分、基因表达分析、异常检测等。

3.3. 半监督学习

半监督学习是机器学习领域的一个重要分支,它结合了监督学习和无监督学习的特点,旨在利用有限的标记数据和大量的未标记数据来提升模型的性能。以下是对半监督学习的详细解释:

3.3.1.定义与基本思想

定义:半监督学习是一种结合有标记数据和无标记数据进行学习的方法,旨在通过同时利用这两种类型的数据来提高模型的准确性和泛化能力。

基本思想:在训练过程中,半监督学习算法不仅依赖于标记数据提供的明确指导,还利用未标记数据中的潜在结构和信息来增强模型的学习效果。

3.3.2. 发展历程与应用场景

发展历程:半监督学习的研究可以追溯到20世纪70年代,自训练、直推学习等方法开始出现。到了90年代,随着新的理论的出现和应用领域的发展,半监督学习得到了更广泛的研究和应用,出现了协同训练、转导支持向量机等新方法。

应用场景:半监督学习在多个领域都有广泛应用,如文本分类、图像分类、推荐系统、社交网络分析和生物信息学等。特别是在数据集较大但标签较少的情况下,半监督学习能够充分利用无标签数据来提高模型的准确性和泛化能力。

3.3.3. 核心算法与优势

核心算法:

常见的半监督学习算法包括自编码器、生成对抗网络和迁移学习等。这些算法通过对有标记数据和无标记数据的学习,让模型建立起知识并进行优化。

优势:

半监督学习的主要优势在于它能够充分利用无标签数据进行学习,从而提高模型的准确性和泛化能力。在实际应用中,这意味着可以在有限的标签数据下实现较好的效果,降低对数据标注的依赖。

3.3.4. 实际应用案例

- 图像分类:在医学影像诊断中,利用半监督学习方法可以利用未标记的医学影像数据来扩充训练集,从而提高模型的分类准确性,为医生提供更可靠的诊断结果。

- 文本分类:在情感分析中,利用半监督学习算法可以将未标记的文本数据和少量的标记数据结合起来,训练出性能更好的情感分析模型。

- 异常检测:在工业设备故障检测中,利用半监督学习方法可以通过少量的标记异常数据和大量的未标记数据训练出更准确的异常检测模型。

3.4. 游戏AI的半监督学习

3.4.1. 游戏AI为什么选择半监督学习

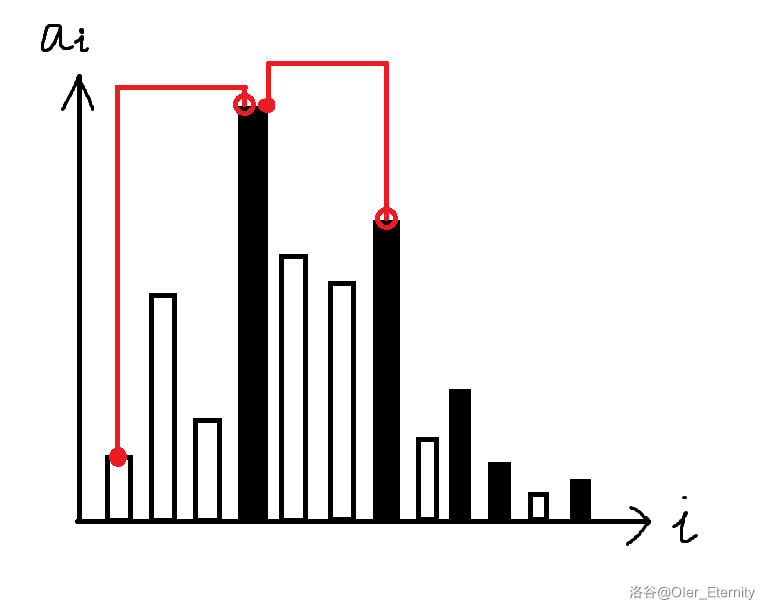

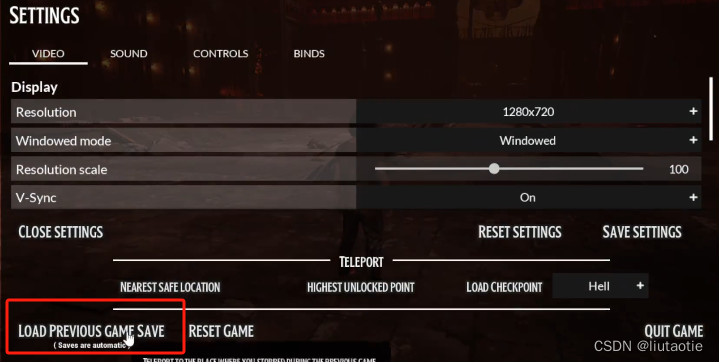

由于游戏类型的不同和游戏需求的不同,以及道德准则框架要求和特殊要求存在的约束条件下,为了最接近玩家使用需求,通常我们使用半监督学习方法,在“红框”内让机器进行学习。

最常使用在游戏游戏AI中使用半监督学习的方法通常是为了解决标记数据稀少的问题。在游戏中,获取大量标记数据可能非常耗时且成本高昂,因此利用未标记数据来增强模型的学习效果显得尤为重要。半监督学习能够在有限的标记数据基础上,结合大量的未标记数据,提升AI模型的性能和泛化能力。

3.4.2. 典型示例

假设我们正在开发一款角色扮演游戏,其中有一个任务是让NPC(非玩家角色)能够自主地进行战斗。我们可以使用半监督学习来训练NPC的战斗行为。具体步骤可能如下:

- 数据收集:首先,我们可以手动标记一部分NPC的战斗数据,包括其行动、攻击、防御等策略,作为训练集中的标记数据。同时,我们还可以收集大量的未标记战斗数据,这些数据可能来自于玩家与NPC的战斗记录、NPC之间的战斗等。

- 模型训练:利用半监督学习算法,如自训练(Self-Training)、协同训练(Co-Training)或转导支持向量机(TSVM)等,结合标记数据和未标记数据进行模型训练。这些方法通常首先使用标记数据训练一个初始模型,然后利用这个模型对未标记数据进行预测,并将预测结果作为新的标记数据加入到训练集中,如此迭代进行,直到满足停止条件。

- 模型应用:训练完成后,我们可以将得到的模型应用于游戏中的NPC,使其能够根据当前战斗情况自主选择合适的战斗策略。

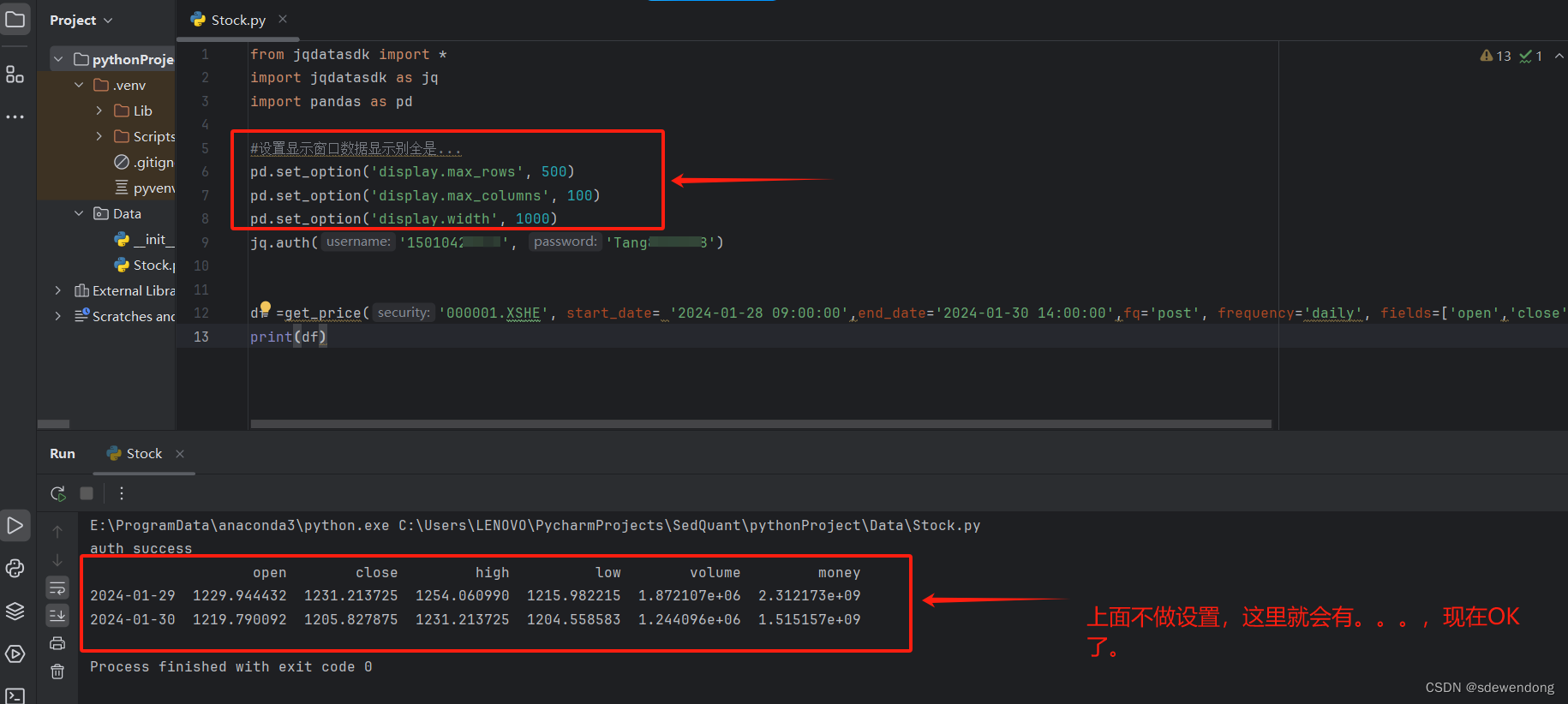

3.4.3. 代码示例

Python示例代码(使用scikit-learn的LabelSpreading模型)

from sklearn import datasets

from sklearn.semi_supervised import LabelSpreading

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report

# 加载数据集(以鸢尾花数据集为例)

iris = datasets.load_iris()

X = iris.data

y = iris.target

# 假设我们只有部分数据是标记的

labeled_size = 50 # 假设我们只有50个标记样本

labeled_idx = np.random.choice(len(y), labeled_size, replace=False)

X_labeled, y_labeled = X[labeled_idx], y[labeled_idx]

X_unlabeled = np.delete(X, labeled_idx, axis=0)

# 创建半监督学习模型

lp_model = LabelSpreading(kernel="knn", alpha=0.8)

# 训练模型

lp_model.fit(np.vstack((X_labeled, X_unlabeled)), y_labeled)

# 对未标记数据进行预测

y_pred_unlabeled = lp_model.predict(X_unlabeled)

# 评估(仅作为示例,实际应用中未标记数据没有真实标签)

print(classification_report(iris.target[labeled_idx], lp_model.predict(X_labeled)))

C++算法示例(伪代码)

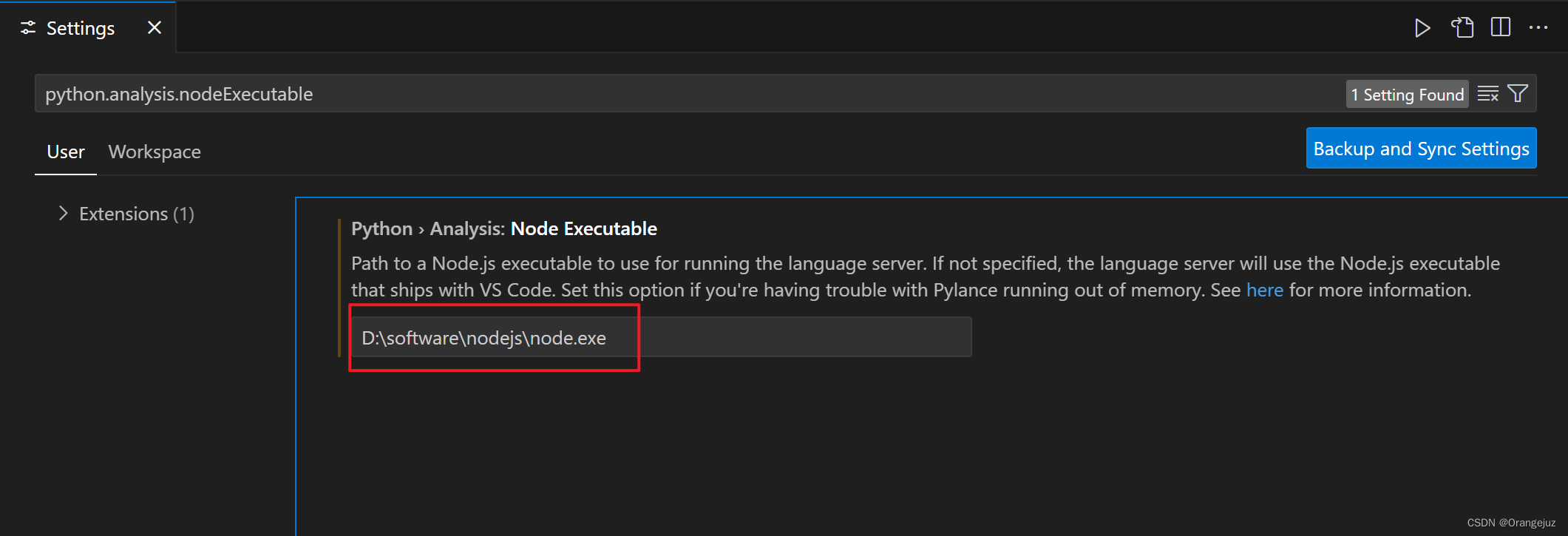

在C++中实现半监督学习算法相对复杂,因为C++标准库没有直接提供机器学习算法。但你可以使用如MLPACK、Shark等C++机器学习库,或者自己实现算法。以下是一个简化的半监督学习伪代码示例,用于说明基本概念:

// 伪代码,非实际可运行代码

// 假设我们有一些标记数据和大量未标记数据

vector<vector<double>> labeledData; // 标记数据特征

vector<int> labeledLabels; // 标记数据标签

vector<vector<double>> unlabeledData; // 未标记数据特征

// 初始化模型,这里以KNN为例

KNNModel model;

model.train(labeledData, labeledLabels); // 使用标记数据训练初始模型

// 半监督学习迭代过程

for (int iteration = 0; iteration < maxIterations; ++iteration) {

vector<int> predictedLabels = model.predict(unlabeledData); // 对未标记数据进行预测

// 将部分预测结果加入到训练集中(这里可以加入一些策略来选择哪些数据加入)

for (int i = 0; i < predictedLabels.size(); ++i) {

if (shouldAddToTrainingSet(predictedLabels[i])) { // 自定义的加入策略

labeledData.push_back(unlabeledData[i]);

labeledLabels.push_back(predictedLabels[i]);

}

}

// 重新训练模型

model.train(labeledData, labeledLabels);

}

// 使用最终模型进行预测或应用上述C++伪代码是为了说明半监督学习的基本流程,并不是一个完整的实现。在实际应用中,你需要根据具体的算法细节和实现环境来编写和调整代码。如果你打算在C++中实现具体的机器学习算法,建议参考相关的机器学习库或自行实现算法细节。

下一篇游戏AI的创造思路-技术基础-机器学习(2)-CSDN博客我们介绍下一些常见的机器学习算法和示例代码