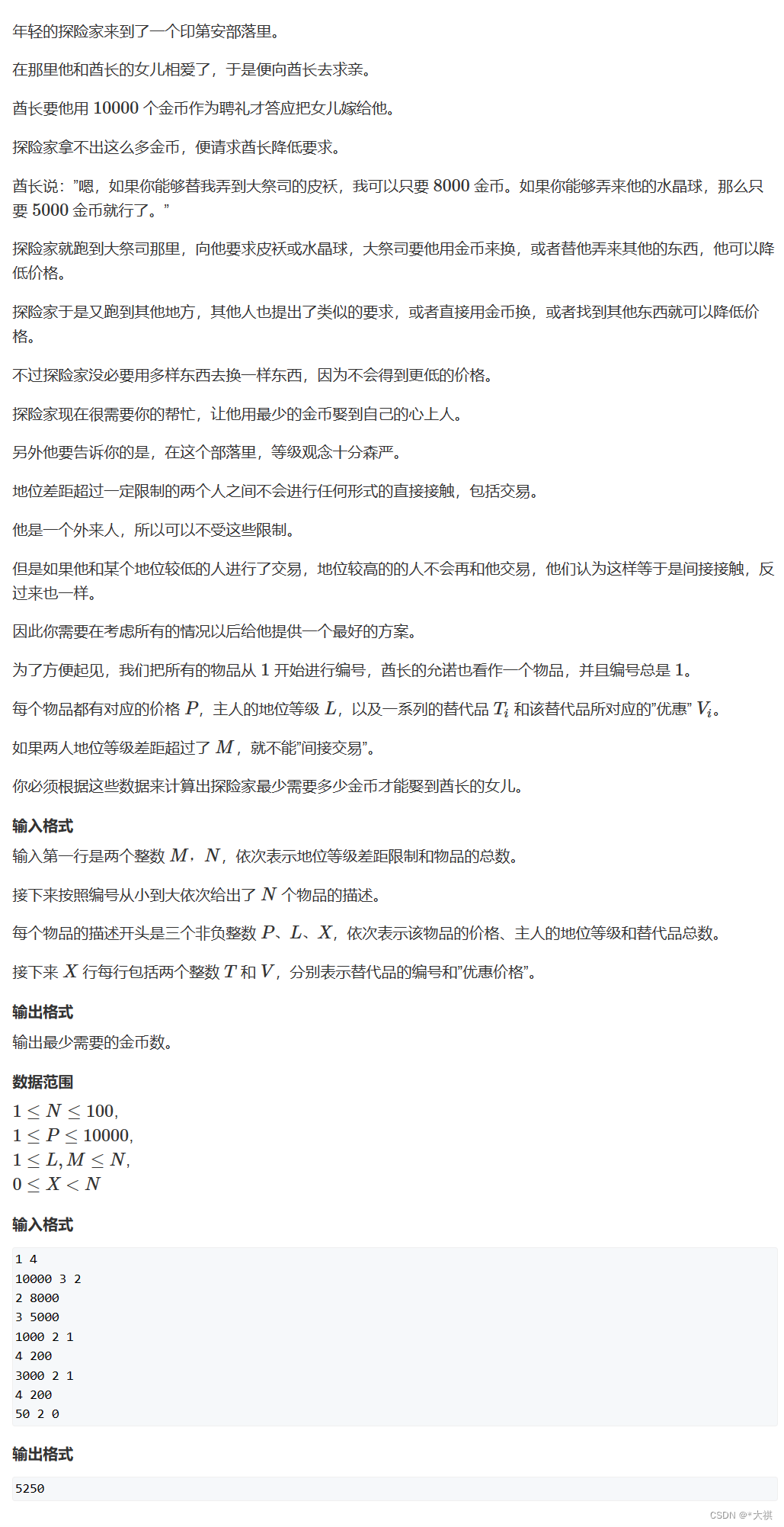

5. 性能问题

- Hbase默认只支持对行键的索引,那么如果要针对其它的列来进行查询,就只能全表扫描

- 之前介绍的查询是使用scan + filter组合来进行查询的,但查询地效率不高,因为要进行顺序全表扫描而没有其他索引。如果数据量较大,只能在客户端(client)来进行处理,如果要传输到Client大量的数据,然后交由客户端处理

- 网络传输压力很大

- 客户端的压力很大

- 如果表存储的数据量很大时,效率会非常低下,此时需要使用二级索引

- 也就是除了ROWKEY的索引外,还需要人为添加其他的方便查询的索引

如果每次需要我们开发二级索引来查询数据,这样使用起来很麻烦。再者,查询数据都是HBase Java API,使用起来不是很方便。为了让其他开发人员更容易使用该接口。如果有一种SQL引擎,通过SQL语句来查询数据会更加方便。

此时,使用Apache Phoenix就可以解决我们上述问题。

6. Apache Phoenix

6.1 Phoenix介绍

Phoenix官方网址:http://phoenix.apache.org/

简介

- Phoenix官网:「We put the SQL back in NoSQL」

Apache Phoenix让Hadoop中支持低延迟OLTP和业务操作分析。 - 提供标准的SQL以及完备的ACID事务支持

- 通过利用HBase作为存储,让NoSQL数据库具备通过有模式的方式读取数据,我们可以使用SQL语句来操作HBase,例如:创建表、以及插入数据、修改数据、删除数据等。

- Phoenix通过协处理器在服务器端执行操作,最小化客户机/服务器数据传输

Apache Phoenix可以很好地与其他的Hadoop组件整合在一起,例如:Spark、Hive、Flume以及MapReduce。

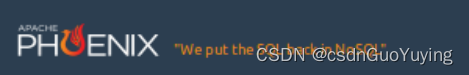

使用Phoenix是否会影响HBase性能

- Phoenix不会影响HBase性能,反而会提升HBase性能

- Phoenix将SQL查询编译为本机HBase扫描

- 确定scan的key的最佳startKey和endKey

- 编排scan的并行执行

- 将WHERE子句中的谓词推送到服务器端

- 通过协处理器执行聚合查询

- 用于提高非行键列查询性能的二级索引

- 统计数据收集,以改进并行化,并指导优化之间的选择

- 跳过扫描筛选器以优化IN、LIKE和OR查询

- 行键加盐保证分配均匀,负载均衡

哪些公司在使用Phoenix

官方性能测试

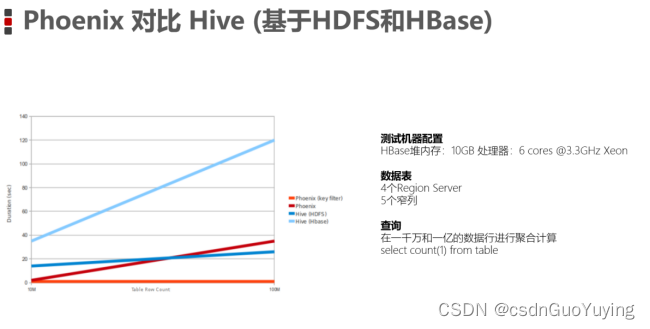

Phoenix对标Hive(基于HDFS和HBase)

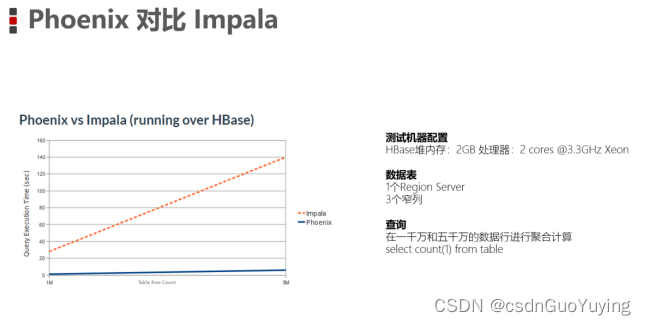

Phoenix对标Impala

关于上述官网两张性能测试的说明

上述两张图是从Phoenix官网拿下来的,这容易引起一个歧义。就是:有了HBase + Phoenix,那是不是意味着,我们将来做数仓(OLAP)就可以不用Hadoop + Hive了?

千万不要这么以为,HBase + Phoenix是否适合做OLAP取决于HBase的定位。Phoenix只是在HBase之上构建了SQL查询引擎(注意:我称为SQL查询引擎,并不是像MapReduce、Spark这种大规模数据计算引擎)。HBase的定位是在高性能随机读写,Phoenix可以使用SQL快插查询HBase中的数据,但数据操作底层是必须符合HBase的存储结构,例如:必须要有ROWKEY、必须要有列蔟。因为有这样的一些限制,绝大多数公司不会选择HBase + Phoenix来作为数据仓库的开发。而是用来快速进行海量数据的随机读写。这方面,HBase + Phoenix有很大的优势。

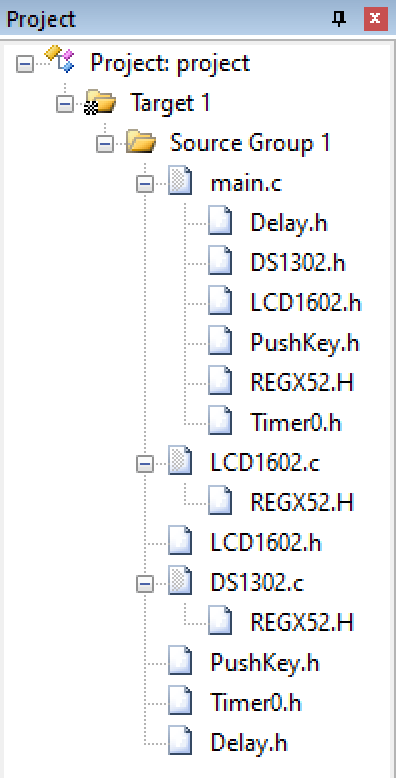

6.2 安装Phoenix

下载

大家可以从官网上下载与HBase版本对应的Phoenix版本。对应到HBase 2.1,应该使用版本「5.0.0-HBase-2.0」。

http://phoenix.apache.org/download.html

安装

- 上传安装包到Linux系统,并解压

cd /export/software

tar -xvzf apache-phoenix-5.0.0-HBase-2.0-bin.tar.gz -C ../server/

- 将phoenix的所有jar包添加到所有HBase RegionServer和Master的复制到HBase的lib目录

# 拷贝jar包到hbase lib目录

cp /export/server/apache-phoenix-5.0.0-HBase-2.0-bin/phoenix-*.jar /export/server/hbase-2.1.0/lib/

# 进入到hbase lib 目录

cd /export/server/hbase-2.1.0/lib/

# 分发jar包到每个HBase 节点

scp phoenix-*.jar node2.itcast.cn:$PWD

scp phoenix-*.jar node3.itcast.cn:$PWD

- 修改配置文件

cd /export/server/hbase-2.1.0/conf/

vim hbase-site.xml

- 将以下配置添加到 hbase-site.xml 后边

<!-- 支持HBase命名空间映射 -->

<property>

<name>phoenix.schema.isNamespaceMappingEnabled</name>

<value>true</value>

</property>

<!-- 支持索引预写日志编码 -->

<property>

<name>hbase.regionserver.wal.codec</name>

<value>org.apache.hadoop.hbase.regionserver.wal.IndexedWALEditCodec</value>

</property>

- 将hbase-site.xml分发到每个节点

scp hbase-site.xml node2.itcast.cn:$PWD

scp hbase-site.xml node3.itcast.cn:$PWD

- 将配置后的hbase-site.xml拷贝到phoenix的bin目录

- 重新启动HBase

stop-hbase.sh

start-hbase.sh

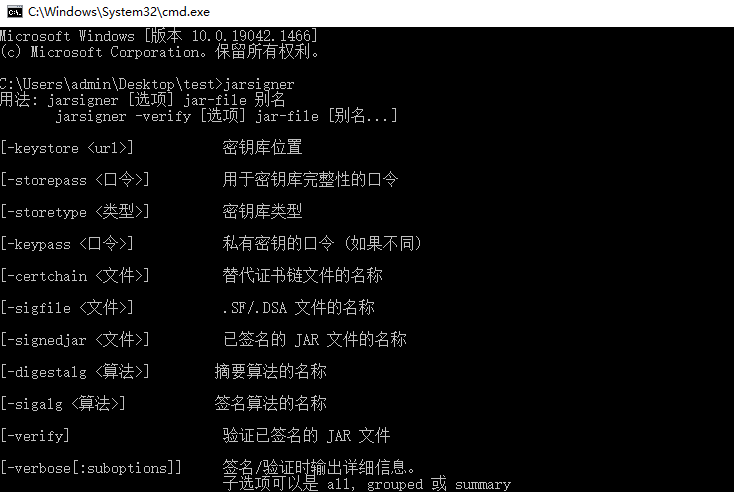

- 启动Phoenix客户端,连接Phoenix Server

注意:第一次启动Phoenix连接HBase会稍微慢一点。

cd /export/server/apache-phoenix-5.0.0-HBase-2.0-bin/

bin/sqlline.py node1.itcast.cn:2181

# 输入!table查看Phoenix中的表

!table

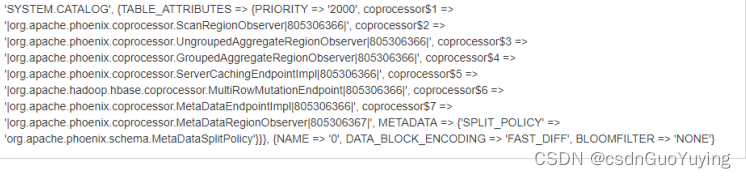

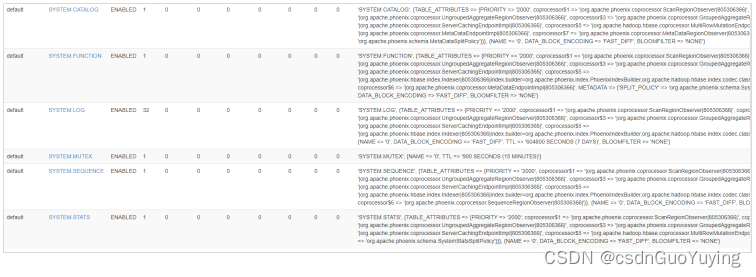

7.查看HBase的Web UI,可以看到Phoenix在default命名空间下创建了一些表,而且该系统表加载了大量的协处理器。