爬虫概念

网络爬虫 (网页蜘蛛, 网络机器人)

爬虫就是模拟客户端发送网络请求, 接受请求对应的响应, 一种按照一定的规则,自动地抓取互联网信息的程序。

理论上来说, 只要是用户通过客户端(浏览器)能够做到事情, 爬虫都能够去做。

爬虫: 模拟客户端访问, 抓取数据。

反爬: 保护重要数据, 阻止恶意网络攻击。

反反爬: 针对反爬做的措施。

爬虫分类

▲通用爬虫:通常指搜索引擎和大型 Web服务提供商的爬虫

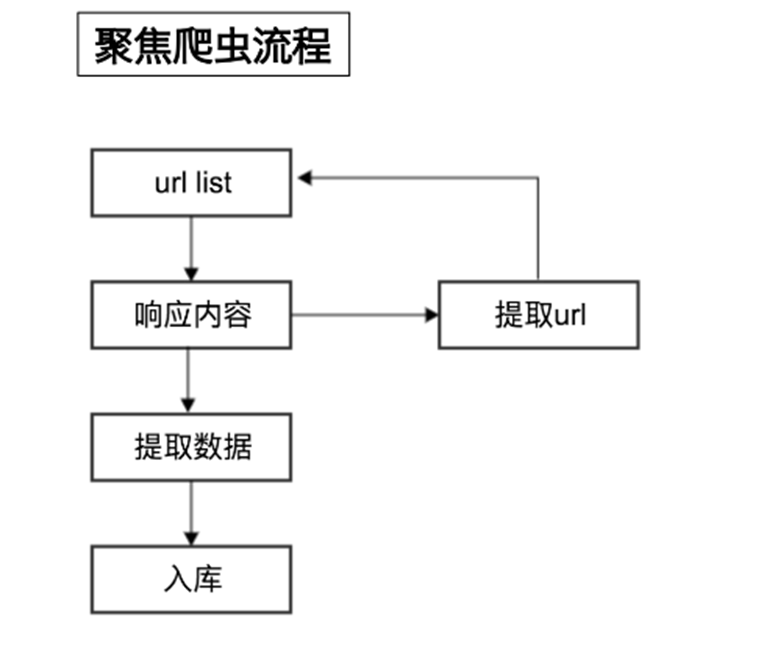

▲聚焦爬虫:针对特定网站的爬虫,定向的获取某方面数据的爬虫

●累积式爬虫:从开始到结束,不断进行爬取,过程中进行去重操作

●增量式爬虫:已下载网页采取增量式更新和只爬取新产生的或者已经发生变化网页的爬虫

●Deepweb爬虫(深层网络爬虫):不能通过静态链接获取的,隐藏在搜索表单后的, 只有用户提交一些关键词才能获得的web页面

意义与作用

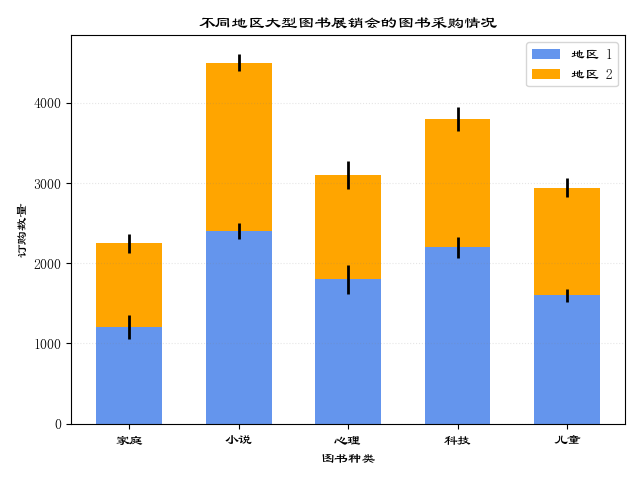

1.相对于人工搜集数据,通过爬虫,在速度上,可以让我们更快地爬取到数据;在数量上,可以让我们爬取到更多的数据。

2.可以把爬取到数据在网页或者是app上进行展示;也可进行数据分析或者是机器学习相关的项目

聚集爬虫工作流程

robots协议概念

Robots协议:网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取,但它仅仅是互联网中的一般约定。