斯坦福ALOHA机器人团队最新论文-HumanPlus,继续推进了机器人技术的前沿进展,我进行了部分翻译和解读:

HumanPlus人形机器人系统技术解读

1 简介

本教程将介绍一个名为HumanPlus的全栈式人形机器人系统。该系统能够让机器人从人类数据中学习运动技能和自主操作任务。通过本教程,读者将了解HumanPlus系统的关键技术细节,并学会如何复现这项工作。

2 硬件平台搭建

要复现HumanPlus,首先需要搭建一个合适的人形机器人硬件平台。本教程使用的机器人参数如下:

- 33个自由度,其中包括:

- 19个身体关节自由度(每条腿5个,每条胳膊4个,腰部1个)

- 每只手6个自由度,每个手腕1个自由度

- 身高180cm,体重87kg

- 手指力量可达10N,手臂可搬运7.5kg重物

- 腿部电机峰值扭矩360Nm

- 头部安装两个640x480分辨率的RGB摄像头,视野角度50度,瞳距160mm

读者可以参照这些参数,选择现有的人形机器人平台,或者定制开发一个新的平台。关键是要支持全身33自由度的实时控制和双目RGB视觉感知。

3 运动模仿学习

3.1 离线人体运动数据准备

HumanPlus使用AMASS数据集作为人体运动的离线训练数据。AMASS汇总了多个光学动作捕捉数据集,经过滤波处理后包含40小时、11000多个高质量人体运动序列。其中每一帧人体姿态都用SMPL-X模型参数化表示:

- 人体关节:22个,每个3自由度球面关节

- 手部关节:每只手30个,每个3自由度球面关节

- 身体全局平移:3维

- 身体全局旋转:3维

读者可以直接使用AMASS数据集,或者用自己采集的光学动作捕捉数据,只要对其进行类似的处理,用SMPL-X参数化即可。

3.2 人体到机器人的运动重定向

由于机器人和人体骨骼的差异,需要将人体运动数据重定向到机器人关节空间:

对于身体关节:

- 直接将SMPL-X相应关节的旋转角度复制到机器人关节

- 机器人的髋部和肩部关节都视为3自由度球面关节

对于手部关节:

- 机器人每根手指仅有1个自由度,取SMPL-X中对应手指中间关节的旋转角度即可

- 机器人手腕有1个自由度,通过前臂和手部的相对旋转计算得到

读者在实现时,需要根据自己的机器人关节定义,编写合适的运动重定向函数。

3.3 训练低级运动策略

HumanPlus用一个Transformer结构的策略网络作为低级运动控制器,称为Humanoid Shadowing Transformer。其输入为机器人当前的本体感受信息(关节角度、角速度等)和一个重定向后的人体目标姿态,输出为机器人关节的目标角度。

该网络在物理模拟环境中使用PPO算法训练,奖励函数包括:

- 匹配目标姿态

- 保持身体平衡

- 减少关节能耗

- 避免脚底打滑

此外还在训练时引入了域随机化,随机改变机器人的物理参数如关节摩擦力、电机力矩等,以增强策略的鲁棒性。

读者需要搭建一个与真实机器人参数相近的物理模拟环境(如MuJoCo、Bullet等),然后按照以上设置实现PPO算法来训练Humanoid Shadowing Transformer。本文的训练细节如下:

- 输入观测维度:154(关节角度、角速度、目标姿态等)

- 输出动作维度:33(关节目标角度)

- Transformer层数:3

- 隐藏层维度:512

- 注意力头数:4

- 学习率:5e-5

- PPO训练epoch数:3

3.4 运动模仿部署

将训练好的Humanoid Shadowing Transformer部署到真实机器人上,就可以实现运动模仿功能了。具体步骤如下:

- 使用RGB摄像头拍摄人类运动

- 用WHAM和HaMeR等算法从RGB图像中实时估计人体和手部关节角度

- 将估计的人体姿态重定向为机器人目标姿态

- 将机器人状态和目标姿态输入给Humanoid Shadowing Transformer,输出机器人关节的目标角度

- 用PD控制器将目标角度转换为关节扭矩,控制机器人运动

- 同时通过机器人头部的双目摄像头记录自己视角的运动数据

通过上述流程,人类就可以实时控制机器人模仿自己的动作,完成各种复杂的全身运动任务,如搬运重物、开关柜门、打拳击等。在这个过程中采集的视觉数据,可以用于后续的自主操作学习。

读者在部署时需要注意几点:

- 选择合适的人体姿态估计算法,在单RGB摄像头情况下达到实时(>20FPS)的性能

- 设计人性化的人机交互方式,如人直接站在机器人前方示范动作,而不需要佩戴各种传感器

- 保证通信延迟足够低,机器人的响应要及时

4 自主操作学习

4.1 视觉操作策略训练

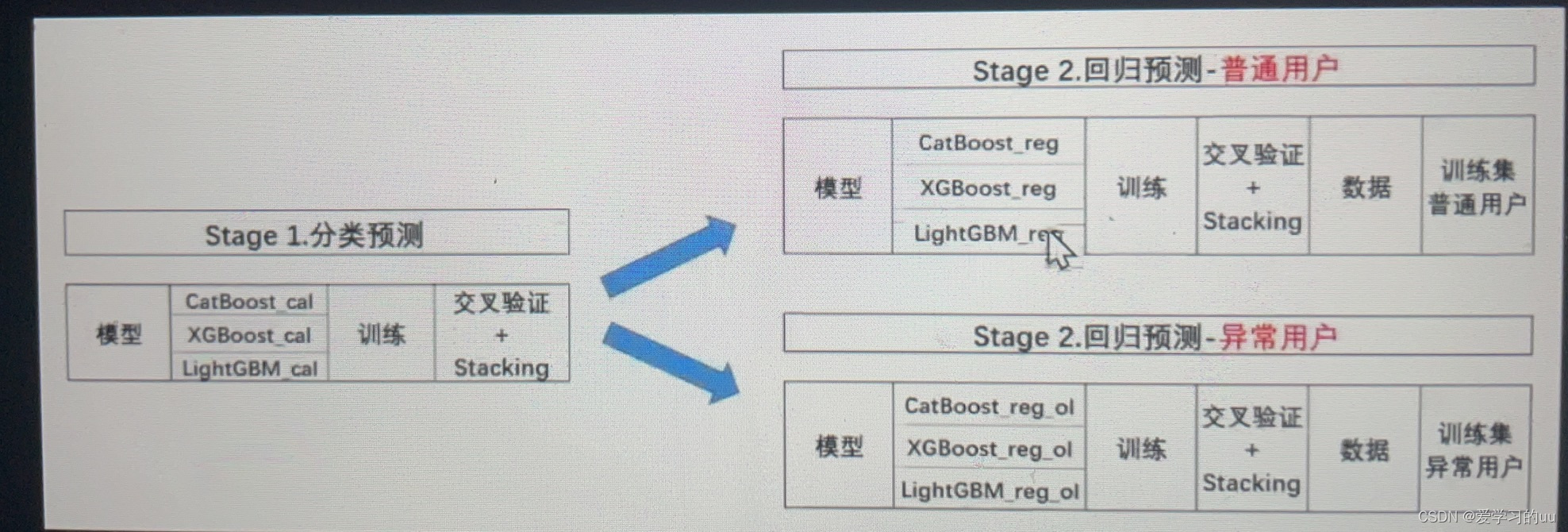

利用运动模仿采集的视觉数据,HumanPlus用监督学习训练高层视觉操作策略,称为Humanoid Imitation Transformer (HIT)。HIT也是一个Transformer网络,它的输入包括:

- 重建的人体关节角度(来自Humanoid Shadowing Transformer)

- 机器人两个摄像头的RGB图像的ResNet特征

- 一个长度为50的时间步位置嵌入向量

HIT的输出为未来50个时间步的机器人目标关节角度,以及每个时间步对应的RGB图像特征的预测值。网络除了预测关节角度外,还通过图像特征重建任务在像素空间对模型施加额外的监督,使其更好地利用视觉信息。

HIT的训练细节如下:

- 输入观测维度:532=154(关节角度)+2x128(图像特征)+50(位置编码)

- 输出维度:50x(33+128)=8050

- Transformer层数:12

- 隐藏层维度:1024

- 注意力头数:16

- 学习率:1e-4

- 训练样本:40个演示

4.2 自主任务执行

训练好的HIT策略可以完成多种复杂的自主操作任务:

- 穿鞋子并行走:从坐姿穿上鞋子并站立行走

- 仓库搬运:从架子上取下货物放到指定位置

- 衣物折叠:把衣服整理叠好

- 整理杂物:将不同形状和大小的物体摆放整齐

- 打字:用双手在键盘上打出特定文字

- 双机器人问候:通过握手动作与另一个机器人互动

读者可以根据自己的需求,设计合适的任务流程,采集相应的视觉演示数据,用于训练HIT策略。在测试时,只需将机器人状态和RGB图像输入给HIT,然后将其输出的关节角度作为Humanoid Shadowing Transformer的输入即可。

实验表明,HIT在以上任务中的成功率可以达到60%-100%,且通常只需要20-40个演示样本。它明显优于单目视觉和不利用图像特征的基线方法。说明视觉信息和自监督对策略的泛化很关键。

5 其他实验与分析

为了全面评估HumanPlus系统,本文还设计了一些其他实验:

- 用户研究:邀请6名受试者使用4种不同的人机交互方式(HumanPlus、动力学示教、外骨骼、VR控制器)完成指定任务,对比它们的使用体验。结果显示HumanPlus的任务完成时间最短,稳定性最高,且是唯一支持全身控制的方式。

- 鲁棒性测试:通过向机器人施加不同方向和大小的外力,考察Humanoid Shadowing Transformer的抗扰动能力。实验表明该策略可承受的扰动明显高于默认控制器,且恢复平衡也更快。

- 泛化性测试:在训练集之外的新任务上测试HIT的表现,如弹钢琴、打乒乓球等。结果显示只要任务差异不太大,HIT就可以较好地泛化。

这些实验进一步证明了HumanPlus的有效性、鲁棒性和实用价值。读者可以参考这些设置,设计自己的评估实验。

想要更全面的理解本文可以提前查看下面资料

如果读者想深入了解本文的技术细节,可以参考以下资料:

- AMASS数据集:https://amass.is.tue.mpg.de/

- SMPL-X人体模型:https://smpl-x.is.tue.mpg.de/

- WHAM人体姿态估计:https://wham.is.tue.mpg.de/

- HaMeR手部姿态估计:https://homer.is.tue.mpg.de/

- 域随机化技术:https://arxiv.org/abs/1710.06537

- PPO强化学习算法:https://arxiv.org/abs/1707.06347

- Transformer结构:https://arxiv.org/abs/1706.03762

- ResNet图像特征:https://arxiv.org/abs/1512.03385

下面我进行部分原文翻译

HumanPlus:从人类中学习的人形机器人影子(Shadowing)和模仿(Imitation)

https://humanoid-ai.github.io

摘要

构建与人类具有相似形态的机器人的一个关键论点是,我们可以利用大量的人类数据进行训练。然而,在实践中,由于人形机器人感知和控制的复杂性、人形机器人与人类在形态学和驱动方面仍然存在差距,以及缺乏一个数据管道供人形机器人从自我中心视觉中学习自主技能,这仍然是一个挑战。在本文中,我们介绍了一个全栈式系统,使人形机器人能够从人类数据中学习运动和自主技能。

首先,我们在模拟中通过强化学习训练一个低级别策略,使用现有的40小时人体运动数据集。该策略可以零样本迁移到真实世界,允许人形机器人仅使用一个RGB摄像头实时跟踪人体和手部运动,即所谓的"影子(Shadowing)"。通过影子,人类操作者可以遥控人形机器人,为真实世界中的不同任务收集全身数据。使用收集的数据,我们执行监督式行为克隆来训练使用自我中心视觉的技能策略,允许人形机器人通过模仿人类技能自主完成不同的任务。我们在定制的33自由度、180厘米高的人形机器人上演示该系统,使用最多40个演示,以60-100%的成功率自主完成穿鞋站立行走、从仓库货架卸载物体、折叠卫衣、重新布置物体、打字和与另一个机器人握手等任务。

- 简介

由于我们周围的环境、任务和工具都是基于人类形态结构设计的,因此人形机器人一直受到机器人学界的关注。人形机器人的人性化形态也提供了一个独特的机会,可以利用大量可用的人类运动和技能数据进行训练,绕过机器人数据的稀缺性。通过模仿人类,人形机器人可以潜在地利用人类所展示的丰富的技能和动作,为实现通用机器人智能提供一个有前景的途径。

然而,在实践中,人形机器人要学习人类数据仍然具有挑战性。人形机器人复杂的动力学以及高维状态和动作空间给感知和控制带来了困难。传统方法,如将问题分解为感知、规划和跟踪,以及将手臂和腿的控制分开模块化[10,10,23,40],可能耗时且范围有限,难以扩展到人形机器人预期运行的各种任务和环境。此外,尽管与其他形式的机器人相比,人形机器人与人类最为相似,但人形机器人和人类在形态学和驱动方面仍然存在物理差异,包括自由度、关节长度、身高、体重、视觉参数和机制、驱动力和响应能力等,这些差异阻碍了人形机器人有效地使用和学习人类数据。这个问题由于缺乏现成的集成硬件平台而进一步加剧。此外,我们缺乏一个可访问的数据管道,用于人形机器人的全身遥操作,阻碍研究人员利用模仿学习作为工具来教授人形机器人任意技能。多家公司开发的人形机器人已经展示了这种数据管道以及随后从收集的数据中进行模仿学习的潜力,但细节尚未公开,并且其系统的自主性演示仅限于几个任务。先前的工作使用动作捕捉系统、第一人称视角(FPV)虚拟现实(VR)头显和外骨骼来遥控人形机器人[17,20,38,59],这些系统昂贵且操作位置受限。

在本文中,我们提出了一个全栈式系统,使人形机器人能够从人类数据中学习运动和自主技能。为了解决人形机器人控制的复杂性,我们遵循最近在腿式机器人领域使用大规模模拟强化学习和从模拟到真实迁移的成功范例[41,51]来训练一个用于全身控制的低级别策略。通常,基于学习的低级别策略被设计为特定任务,由于耗时的奖励工程[19,68],使人形机器人硬件一次只能展示一项技能,如行走。这种限制约束了人形机器人平台能够执行的多样化任务范围。同时,我们有一个40小时的人体运动数据集AMASS[49],涵盖了广泛的技能。我们利用这个数据集,首先将人体姿态重定向到人形机器人姿态,然后训练一个以重定向的人形机器人姿态为条件的任务无关的低级别策略,称为人形机器人影子变换器(Humanoid Shadowing Transformer)。我们的以姿态为条件的低级别策略可以零样本迁移到真实世界。

在部署了给定目标姿态控制人形机器人的低级别策略后,我们可以使用单个RGB摄像头实时影子人类运动到定制的33自由度、180厘米高的人形机器人。使用最先进的人体和手部姿态估计算法[58,81],我们可以实时估计人体运动并将其重定向到人形机器人运动,作为低级别策略的输入。这个过程传统上是通过使用动作捕捉系统完成的,这种系统昂贵且操作位置受限。使用视线,附近站立的人类操作者可以遥控人形机器人,为真实世界中的各种任务收集全身数据,如拳击、弹钢琴、打乒乓球和打开柜门存放重锅。在遥操作期间,人形机器人通过双目RGB摄像头收集自我中心视觉数据。影子提供了一个高效的数据收集管道,用于各种真实世界任务,绕过了RGB感知的从模拟到真实的差距。

使用通过影子收集的数据,我们执行监督式行为克隆来训练基于视觉的技能策略。技能策略将人形机器人双目自我中心RGB视觉作为输入,预测期望的人形机器人身体和手部姿态。我们建立在最近从人类提供的演示中进行模仿学习的成功基础上[11,104],并引入了一种融合动作预测和前向动力学预测的基于Transformer的架构。通过对图像特征使用前向动力学预测,我们的方法通过在图像特征空间上进行正则化,并防止基于视觉的技能策略忽略图像特征和过度拟合本体感受,从而显示出改进的性能。使用最多40个演示,我们的人形机器人可以自主完成任务,如穿鞋站立行走、从仓库货架卸载物体、折叠卫衣、重新布置物体、打字,以及与另一个机器人打招呼,成功率达到60-100%。

本文的主要贡献是一个用于从人类数据中学习复杂自主技能的全栈式人形机器人系统,名为HumanPlus。该系统的核心是(1)一个实时影子系统,允许人类操作者使用单个RGB摄像头和人形机器人影子变换器(一个在模拟中使用大量人体运动数据训练的低级别策略)全身控制人形机器人,以及(2)人形机器人模仿变换器,一种模仿学习算法,使用40个演示就能高效地学习双目感知和高自由度控制。我们的影子系统和模仿学习算法的协同作用允许直接在真实世界中学习全身操纵和运动技能,如穿鞋站立行走,仅使用最多40个演示就达到60-100%的成功率。

- 相关工作

人形机器人的强化学习。人形机器人的强化学习主要集中在运动上。虽然基于模型的控制[16,36,40,55,69,92,98]在各种人形机器人上取得了巨大进展[13,32,37,54,65,89],但基于学习的方法由于在模拟高度随机环境中的训练以及适应能力,可以实现人形机器人[39,67,68,85,91,94,103]和双足机器人[4,42,44,45,83,84,93,100]的稳健运动性能。尽管使用人形机器人进行搬运操作和移动操作主要通过模型预测控制来实现[1,24,29,30,73,77],但最近在通过显式建模模拟场景和任务将强化学习和从模拟到真实应用于人形机器人方面取得了一些成功,用于重新定位箱子[19],以及生成多样化的上身运动[9]。相比之下,我们使用强化学习来训练任务无关的全身控制的低级别策略,不需要在模拟中显式建模真实世界的场景和任务。

人形机器人的遥操作。先前的工作通过使用人体运动捕捉服[14,17,20,21]、外骨骼[35,35,63,70,75]、触觉反馈设备[6,61,71]和用于视觉反馈的VR设备[7,38,59,90]以及用于末端执行器控制的VR设备[2,46,62,86]来开发人形机器人和灵巧的遥操作。例如,Purushottam等人使用连接到力板的外骨骼服开发了轮式人形机器人的全身遥操作,用于记录人体运动。在控制空间方面,先前的工作在操作空间[17,76]、上身遥操作[7,22]和全身遥操作[31,33,34,52,56,60,90]中进行了遥操作。例如,He等人使用RGB摄像头捕捉人体运动,对人形机器人进行全身遥操作。Seo等人使用VR控制器遥操作双手末端执行器,并在收集的数据上进行模仿学习,以学习静态操作技能。相比之下,我们的工作提供了一个全栈式系统,包括使用单个RGB摄像头控制人形机器人每个关节的低成本全身遥操作系统,支持操作、下蹲和行走,以及一个高效的模仿管道,用于学习自主操作和运动技能,支持穿鞋站立行走等复杂技能。

从人类数据中进行机器人学习。人类数据已广泛用于机器人学习,包括用于预训练视觉或中间表示或任务[8,28,50,53,66,79,86,99],利用互联网规模的数据[18,26,27],以及在领域内人类数据上进行模仿学习[3,12,43,47,64,78,80,82,87,88,95-97,101,102]。例如,Qin等人使用领域内人类手部数据进行灵巧的机器人手部模仿。最近,人类数据也被用于训练人形机器人[9,31]。Cheng等人使用离线人类数据来训练人形机器人生成多样化的上身运动,He等人使用离线人类数据来训练全身遥操作接口。相比之下,我们既使用离线人类数据来学习实时影子的低级别全身策略,也使用通过影子获得的在线人类数据来让人形机器人模仿人类技能,从而实现自主人形机器人技能。

-

HumanPlus硬件

我们的人形机器人具有33个自由度,包括两个6自由度的手、两个1自由度的手腕和一个19自由度的身体(两个4自由度的手臂、两个5自由度的腿和一个1自由度的腰部),如图2左侧所示。该系统基于Unitree H1机器人构建。每只手臂都集成了Inspire-Robots RH56DFX手,通过定制的手腕连接。每个手腕有一个Dynamixel伺服电机和两个推力轴承。手和手腕都通过串行通信控制。我们的机器人在头部安装有两个RGB网络摄像头(Razer Kiyo Pro),向下倾斜50度,瞳距为160mm。手指可以施加高达10N的力,而手臂可以举起重达7.5kg的物品。腿部电机在运行过程中可以产生高达360Nm的瞬时扭矩。我们机器人的其他技术规格如图2右侧所示。

-

人体和手部数据

离线人体数据。我们使用公开的基于光学标记的人体运动数据集AMASS[49]来训练我们的低级别人形机器人影子变换器(Humanoid Shadowing Transformer)。AMASS数据集汇总了几个人体运动数据集的数据,包含40小时的人体运动数据,涵盖了各种任务的11,000多个独特运动序列。为了确保运动数据的质量,我们应用了一个基于[48]中概述的方法的过滤过程。人体和手部运动使用SMPL-X[57]模型进行参数化,该模型包括22个身体和30个手部3自由度球面关节、3维全局平移变换和3维全局旋转变换。

重定向。我们的人形机器人身体具有SMPL-X身体自由度的一个子集,仅由19个旋转关节组成。为了重定向身体姿态,我们将SMPL-X中相应关节的欧拉角复制到我们的人形机器人模型中,即髋部、膝盖、脚踝、躯干、肩部和肘部。我们人形机器人的每个髋关节和肩关节由3个正交旋转关节组成,因此可以视为一个球面关节。我们的人形机器人手有6个自由度:每个食指、中指、无名指和小指各1个自由度,拇指2个自由度。为了重定向手部姿态,我们使用每个手指中间关节的旋转来映射相应的欧拉角。为了计算1自由度手腕角度,我们使用前臂和手部全局方向之间的相对旋转。

实时身体姿态估计和重定向。为了估计真实世界中用于影子的人体运动,我们使用带有准确运动的基于世界的人体(WHAM)[81]通过单个RGB摄像头实时联合估计人体姿态和全局变换。WHAM使用SMPL-X进行人体姿态参数化。如图3所示,我们使用上述方法执行实时人体到人形机器人的身体重定向。身体姿态估计和重定向在NVIDIA RTX4090 GPU上以25fps的速度运行。

实时手部姿态估计和重定向。我们使用HaMeR[58],一种使用单个RGB摄像头的基于Transformer的手部姿态估计器,来进行实时手部姿态估计。HaMeR使用MANO[72]手部模型预测手部姿态、相机参数和形状参数。我们使用上述方法执行实时人体到人形机器人的手部重定向。我们的手部姿态估计和重定向在NVIDIA RTX4090 GPU上以10fps的速度运行。

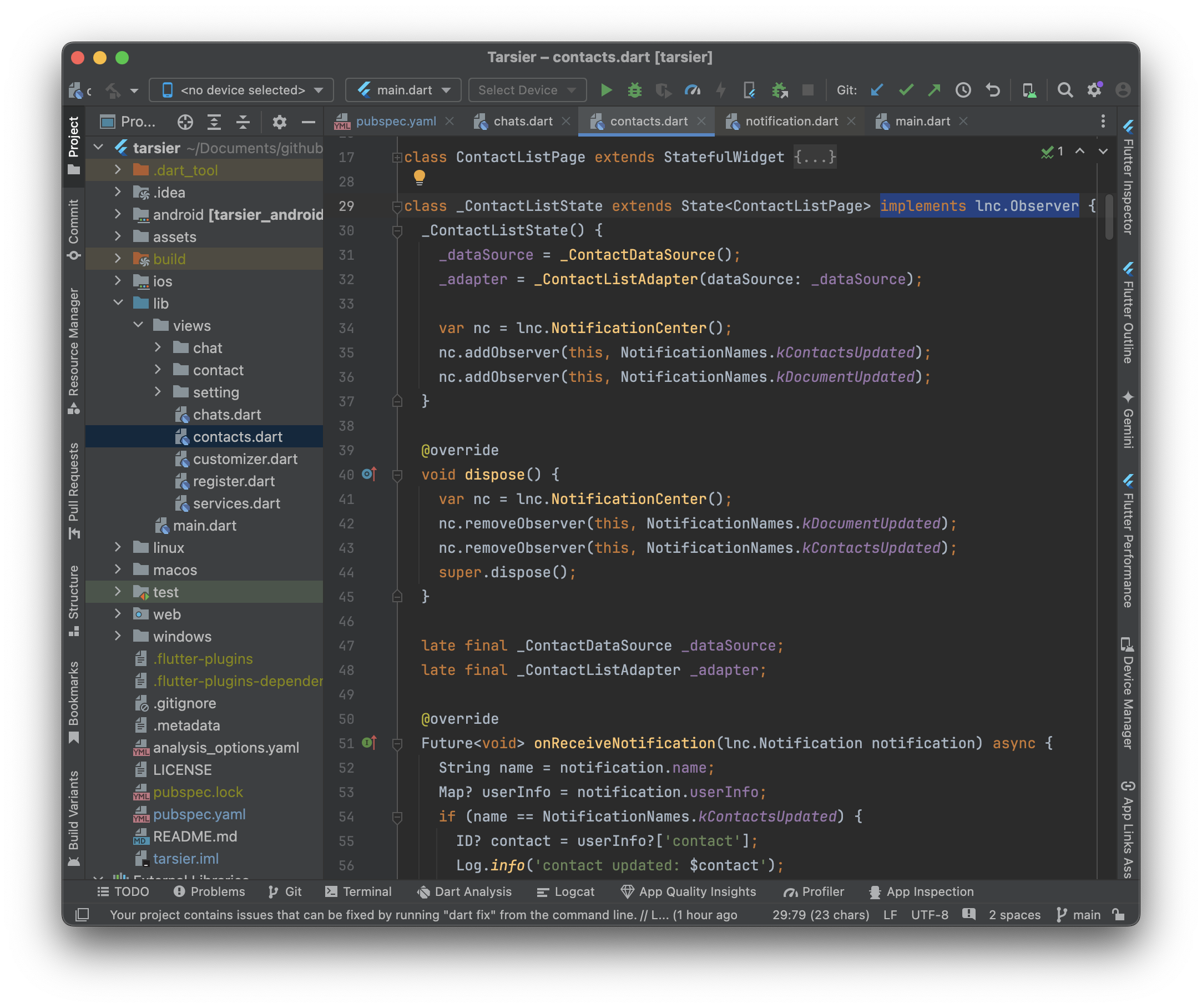

- 人类运动的影子

我们将低级别策略即人形机器人影子变换器(Humanoid Shadowing Transformer)制定为一个仅解码器的Transformer,如图4左侧所示。在每个时间步,策略的输入是人形机器人本体感受和一个人形机器人目标姿态。人形机器人本体感受包含根状态(横滚、俯仰和基座角速度)、关节位置、关节速度和最后一个动作。人形机器人目标姿态包括目标前向和侧向速度、目标横滚和俯仰、目标偏航速度和目标关节角度,并从AMASS数据集中采样的一个人体姿态重定向而来,如第4节所述。策略的输出是19维关节位置设定点,用于人形机器人身体关节,随后使用1000Hz PD控制器转换为扭矩。目标手部关节角度直接传递给PD控制器。我们的低级别策略以50Hz的频率运行,上下文长度为8,因此它可以根据观察历史适应不同的环境[67]。

我们在模拟中使用PPO[74]通过最大化折扣期望回报E[∑T−1t=0 γtrt]来训练我们的人形机器人影子变换器,其中rt是时间步t的奖励,T是最大情节长度,γ是折扣因子。奖励r是鼓励匹配目标姿态同时节省能量和避免脚部打滑的项的总和。我们在表1中列出了所有的奖励项。我们在表2中详细介绍了模拟环境和人形机器人物理参数的随机化。

在模拟中训练完人形机器人影子变换器后,我们将其零样本部署到真实的人形机器人上进行实时影子。本体感受观察仅使用机载传感器进行测量,包括IMU和关节编码器。如第4节所述,使用单个RGB摄像头实时估计人体和手部姿态,并将人体姿态重定向为人形机器人目标姿态。如图1所示,人类操作者站在人形机器人附近,将自己的实时全身运动影子到我们的人形机器人,并使用视线观察环境和人形机器人的行为,确保响应式遥操作系统。在遥操作期间,人形机器人通过双目RGB摄像头收集自我中心视觉数据。通过影子,我们为真实世界中的各种任务提供了一个高效的数据收集管道,规避了在模拟中拥有逼真RGB渲染、精确柔性物体模拟和多样化任务规范的挑战。

- 人类技能的模仿

模仿学习在从各种任务的演示中学习自主机器人技能方面取得了巨大成功[5,11,15,25,104]。鉴于通过影子收集的真实世界数据,我们将同样的方法应用于人形机器人,以训练技能策略。我们对其进行了几项修改,以实现使用有限的机载计算进行更快的推理,并利用双目感知和高自由度控制进行高效的模仿学习。

在这项工作中,我们修改了动作块变换器(Action Chunking Transformer)[104],通过移除其编码器-解码器架构,开发了一个仅解码器的人形机器人模仿变换器(Humanoid Imitation Transformer, HIT)用于技能策略,如图4右侧所示。HIT处理来自两个自我中心RGB摄像头的当前图像特征、本体感受和固定位置嵌入作为输入。这些图像特征使用预训练的ResNet编码器进行编码。由于其仅解码器设计,HIT通过根据输入中的固定位置嵌入预测50个目标姿态块来运行,并且它可以在各自的输入位置预测对应于图像特征的令牌。我们在这些预测的图像特征上合并了L2特征损失,迫使Transformer在执行ground truth目标姿态序列后为未来状态预测相应的图像特征令牌。这种方法允许HIT有效地融合目标姿态预测和前向动力学预测。通过在图像特征上使用前向动力学预测,我们的方法通过在图像特征空间上进行正则化,防止基于视觉的技能策略忽略图像特征和过度拟合本体感受,从而提高了性能。在部署期间,HIT在机载以25Hz的频率运行,异步地将预测的目标位置发送给低级别的人形机器人影子变换器,同时丢弃预测的未来图像特征令牌。

- 任务

我们选择了六个模仿任务和五个影子任务,需要双手灵巧性和全身控制。如图5所示,这些任务涵盖了与实际应用相关的各种能力和物体。

在穿鞋走路任务中,机器人(1)翻转鞋子,(2)拿起它,(3)穿上它,(4)按下它以确保左脚的合脚,(5)用双手缠绕鞋带,(6)抓住右边的一根,(7)抓住左边的一根,(8)系上它们,(9)站起来,(10)向前走。该任务展示了机器人使用灵巧的手进行复杂双手操作的能力以及穿着鞋子进行站立和行走等灵活运动的能力。鞋子均匀随机地放置在机器人正前方的一条2厘米的线上。每个演示有1250个步骤或50秒。

在仓库任务中,机器人(1)用右手接近仓库货架上的喷漆,(2)抓住喷雾器,(3)缩回右手,(4)蹲下,(5)接近四足动物背后的推车,(6)释放喷雾器,(7)站起来。该任务测试了机器人的全身操纵和协调能力。机器人的站立位置沿10厘米的线随机化。每个演示有500个步骤或20秒。

在折叠衣服任务中,在保持平衡的同时,机器人(1)折叠左袖,(2)折叠右袖,(3)折叠卫衣下摆,需要既能灵巧地操纵具有复杂动力学的织物,又能保持直立姿态。机器人从站立位置开始,根根偏航随机采样,偏离+10到-10度。卫衣在桌面上随机放置,偏离10厘米×10厘米,旋转-30度到30度。每个演示有500个步骤或20秒。

在重新排列物体任务中,在保持平衡的同时,机器人(1)接近物体,(2)拿起物体,(3)将物体放入篮子中。复杂性来自物体的不同形状、颜色和方向,要求机器人根据物体的位置选择合适的手,并相应地规划其动作。总共,我们从4个柔性物体中均匀采样,包括毛绒玩具和冰袋,其中物体沿篮子左侧或右侧的10厘米线随机放置。每个演示有250个步骤或10秒。

在打字"AI"任务中,机器人(1)键入字母’A’,(2)释放按键,(3)键入字母’I’,(4)释放按键。尽管是坐姿,机器人在操作中需要高精度。每个演示有200个步骤或8秒。

在双机器人问待任务中,机器人(1)在观察另一个双手机器人开始伸出一只手/手臂后,用正确的手接近另一个机器人,(2)与另一个机器人的手接触,(3)释放手。另一个机器人均匀地采样要伸出哪只手,并在5厘米×5厘米×5厘米的末端执行器区域内停止。机器人需要快速准确地识别要使用哪只手,并在保持平衡的同时用正确的手接近另一个机器人。每个演示有125个步骤或5秒。

对于影子任务,我们演示了五个任务:拳击、打开两门柜子存放锅、投掷、弹钢琴、打乒乓球和打字"Hello World",展示了在影子快速、多样化运动和操纵重物方面的机动性和稳定性。影子结果的定性视频可以在项目网站上找到:https://humanoid-ai.github.io。

- 影子实验

8.1. 与其他遥操作方法的比较

我们将影子系统与三种基线进行了比较:动力学示教(Kinesthetic Teaching)、ALOHA[104]和Meta Quest,如图6所示。对于动力学示教,两只手臂处于被动模式并手动定位。对于ALOHA,我们从两个WidowX 250机器人构建了一对双手手臂,其运动学结构与我们的人形机器人手臂相似。对于Meta Quest,我们使用控制器的位置通过重力补偿的逆运动学进行操作空间控制。如表3所示,所有基线都不支持全身控制,并且需要至少两名人类操作员进行手部姿态估计。相比之下,我们的影子系统同时控制人形机器人身体和手,只需要一名人类操作员。此外,ALOHA和Meta Quest都更昂贵。相比之下,我们的系统和动力学示教只需要一个RGB摄像头。

如表3所示,我们对6名参与者进行了用户研究,比较了我们的影子系统与三种基线在遥操作效率方面的差异。两名参与者没有遥操作经验,其余四名参与者具有不同程度的专业知识。没有参与者有我们影子系统的先前经验。参与者的任务是执行重新排列物体任务及其变体,即重新排列较低物体,其中物体放置在高度为0.55米的较低桌子上,需要机器人下蹲,因此需要全身控制。

我们记录了六名参与者的平均任务完成时间,每人三次试验和三轮未记录的练习。我们还记录了使用我们的低级别策略进行遥操作期间稳定站立的平均成功率。虽然ALOHA支持精确控制机器人关节角度,但其固定的硬件设置使其难以适应不同身高和体型的人,并且默认情况下不支持人形机器人的全身控制。Meta Quest由于每个人形机器人手臂加上手腕只有5个自由度,经常导致奇异点和笛卡尔空间中目标姿态与实际姿态之间的不匹配,导致完成时间最长且在手臂奇异点处站立不稳定。虽然动力学示教直观且完成时间短,但它需要多个操作员,有时在教学过程中手臂上的外力会导致人形机器人跌倒。相比之下,我们的系统具有最短的完成时间,最高的稳定站立成功率,并且是唯一可用于全身遥操作的方法,解决了重新排列较低物体任务。

8.2. 鲁棒性评估

如表4所示,我们通过将其与制造商默认控制器(H1 Default)进行比较来评估我们的低级别策略。机器人在操纵物体时必须保持平衡,因此我们通过向骨盆施加力并记录导致不稳定的最小力来评估鲁棒性。如图7所示,我们的策略可以承受明显更大的力,并且恢复时间更短。当机器人失去平衡时,制造商的默认控制器需要几个步骤和长达20秒才能稳定机器人,而我们的策略通常在一两个步骤内恢复,且在3秒以下。更多的恢复步骤会导致抖动行为并影响操纵性能。我们还表明,我们的策略支持默认控制器无法完成的更多全身技能,如下蹲、高跳、从坐在椅子上站起来。

- 模仿实验

如表5所示,我们将模仿学习方法人形机器人模仿变换器(Humanoid Imitation Transformer)与三种基线方法进行了比较:使用单目输入的HIT策略(Monocular)、ACT[104]和开环轨迹回放(Open-loop),跨所有任务:折叠衣服、重新排列物体、打字"AI"、双机器人问候、仓库和穿鞋走路,详见第7节和图5。尽管每个技能策略都连续自主地解决其任务而不停止,但我们记录了每个任务内连续子任务的成功率,以便更好地分析。我们进行了10次试验。通过将成功尝试的次数除以总尝试次数来计算子任务的成功率。例如,在穿上鞋子子任务的情况下,总尝试次数等于上一个拾起鞋子子任务的成功次数,因为机器人可能在任何子任务中失败并停止。

我们的HIT在所有任务中都实现了比其他基线更高的成功率。具体而言,我们的方法是唯一解决穿鞋走路任务的方法,在给定40个演示的情况下实现了60%的成功率,而所有其他方法都失败了。这是因为我们的方法使用双目感知,并避免过拟合本体感受。ACT在穿鞋走路和打字"AI"任务中失败,在成功完成拾起鞋子和离开"A"后,它反复尝试并停滞,避免使用视觉反馈。单目由于缺乏单个RGB摄像头的深度信息而显示出较低的成功率,在折叠衣服时与桌子的互动很粗糙。它完全失败了穿鞋走路任务,其中深度感知至关重要。然而,由于其视野较窄,它在打字"AI"任务中比其他方法更成功地完成了一些子任务。开环仅在没有随机化的打字"AI"中有效,在所有其他需要反应式控制的任务中都失败。

- 结论、局限性和未来方向

在这项工作中,我们提出了HumanPlus,一个用于从人类数据中学习复杂自主技能的全栈式人形机器人系统。在开发我们的系统的过程中,我们遇到了几个局限性。首先,我们的硬件平台提供的自由度与人体解剖结构相比较少。例如,它使用带有1自由度脚踝的脚,这限制了人形机器人执行敏捷动作的能力,如在另一只脚保持静止的同时抬起和摇晃一条腿。每只手臂只有5个自由度,包括一个手腕,这限制了在影子期间6自由度操作空间控制的应用,并可能导致无法到达的区域。此外,自我中心相机固定在人形机器人的头部,不是主动的,导致手和交互始终有掉出视野的风险。此外,我们目前使用固定的从人体姿态到人形机器人姿态的重定向映射,忽略了人形机器人上不存在的许多人体关节。这可能限制了人形机器人从人类运动的一小部分子集中学习。目前,在大面积遮挡的情况下,姿态估计方法效果不佳,限制了人类操作者的操作区域。最后,我们在这项工作中专注于操作任务和一些运动任务,如下蹲、站立和行走,因为处理长距离导航需要更大规模的人类演示和在真实世界中的精确速度跟踪。我们希望在未来解决这些局限性,并实现更加自主和鲁棒的人形机器人技能,可应用于各种现实世界任务。

参考文献

参考文献

[1] Hitoshi Arisumi, Jean-Rémy Chardonnet, Abderrahmane Kheddar, and Kazuhito Yokoi. Dynamic lifting motion of humanoid robots. In Proceedings 2007 IEEE International Conference on Robotics and Automation, 2007. 3

[2] Sridhar Pandian Arunachalam, Irmak Güzey, Soumith Chintala, and Lerrel Pinto. Holo-dex: Teaching dexterity with immersive mixed reality. In 2023 IEEE International Conference on Robotics and Automation (ICRA), pages 5962–5969. IEEE, 2023. 3

[3] Shikhar Bahl, Abhinav Gupta, and Deepak Pathak. Human-to-robot imitation in the wild. arXiv preprint arXiv:2207.09450, 2022. 4

[4] Hamid Benbrahim and Judy A Franklin. Biped dynamic walking using reinforcement learning. Robotics and Autonomous systems, 1997. 3

[5] Anthony Brohan, Noah Brown, Justice Carbajal, Yevgen Chebotar, Joseph Dabis, Chelsea Finn, Keerthana Gopalakrishnan, Karol Hausman, Alex Herzog, Jasmine Hsu, Julian Ibarz, Brian Ichter, Alex Irpan, Tomas Jackson, Sally Jesmonth, Nikhil Joshi, Ryan Julian, Dmitry Kalashnikov, Yuheng Kuang, Isabel Leal, Kuang-Huei Lee, Sergey Levine, Yao Lu, Utsav Malla, Deeksha Manjunath, Igor Mordatch, Ofir Nachum, Carolina Parada, Jodilyn Peralta, Emily Perez, Karl Pertsch, Jornell Quiambao, Kanishka Rao, Michael Ryoo, Grecia Salazar, Pannag Sanketi, Kevin Sayed, Jaspiar Singh, Sumedh Sontakke, Austin Stone, Clayton Tan, Huong Tran, Vincent Vanhoucke, Steve Vega, Quan Vuong, Fei Xia, Ted Xiao, Peng Xu, Sichun Xu, Tianhe Yu, and Brianna Zitkovich. Rt-1: Robotics transformer for real-world control at scale. In arXiv preprint arXiv:2212.06817, 2022. 7

[6] Anais Brygo, Ioannis Sarakoglou, Nadia Garcia-Hernandez, and Nikolaos Tsagarakis. Humanoid robot teleoperation with vibrotactile based balancing feedback. In Haptics: Neuroscience, Devices, Modeling, and Applications: 9th International Conference, EuroHaptics 2014, Versailles, France, June 24-26, 2014, Proceedings, Part II 9, 2014. 3

[7] Jean Chagas Vaz, Dylan Wallace, and Paul Y Oh. Humanoid loco-manipulation of pushed carts utilizing virtual reality teleoperation. In ASME International Mechanical Engineering Congress and Exposition, 2021. 3, 4

[8] Annie S Chen, Suraj Nair, and Chelsea Finn. Learning generalizable robotic reward functions from" in-the-wild" human videos. arXiv preprint arXiv:2103.16817, 2021. 4

[9] Xuxin Cheng, Yandong Ji, Junming Chen, Ruihan Yang, Ge Yang, and Xiaolong Wang. Expressive whole-body control for humanoid robots. arXiv preprint arXiv:2402.16796, 2024. 3, 4

[10] Joel Chestnutt, Manfred Lau, German Cheung, James Kuffner, Jessica Hodgins, and Takeo Kanade. Footstep planning for the honda asimo humanoid. In ICRA, 2005. 2

[11] Cheng Chi, Siyuan Feng, Yilun Du, Zhenjia Xu, Eric Cousineau, Benjamin Burchfiel, and Shuran Song. Diffusion policy: Visuomotor policy learning via action diffusion. In Proceedings of Robotics: Science and Systems (RSS), 2023. 3, 7

[12] Cheng Chi, Zhenjia Xu, Chuer Pan, Eric Cousineau, Benjamin Burchfiel, Siyuan Feng, Russ Tedrake, and Shuran Song. Universal manipulation interface: In-the-wild robot teaching without in-the-wild robots. In Proceedings of Robotics: Science and Systems (RSS), 2024. 4

[13] Matthew Chignoli, Donghyun Kim, Elijah Stanger-Jones, and Sangbae Kim. The mit humanoid robot: Design, motion planning, and control for acrobatic behaviors. In 2020 IEEE-RAS 20th International Conference on Humanoid Robots (Humanoids), 2021. 3

[14] R Cisneros, M Benallegue, K Kaneko, H Kaminaga, G Caron, A Tanguy, R Singh, L Sun, A Dallard, C Fournier, et al. Team janus humanoid avatar: A cybernetic avatar to embody human telepresence. In Toward Robot Avatars: Perspectives on the ANA Avatar XPRIZE Competition, RSS Workshop, 2022. 3

[15] Open X-Embodiment Collaboration, Abhishek Padalkar, Acorn Pooley, Ajinkya Jain, Alex Bewley, Alex Herzog, Alex Irpan, Alexander Khazatsky, Anant Rai, Anikait Singh, Anthony Brohan, Antonin Raffin, Ayzaan Wahid, Ben Burgess-Limerick, Beomjoon Kim, Bernhard Schölkopf, Brian Ichter, Cewu Lu, Charles Xu, Chelsea Finn, Chenfeng Xu, Cheng Chi, Chenguang Huang, Christine Chan, Chuer Pan, Chuyuan Fu, Coline Devin, Danny Driess, Deepak Pathak, Dhruv Shah, Dieter Büchler, Dmitry Kalashnikov, Dorsa Sadigh, Edward Johns, Federico Ceola, Fei Xia, Freek Stulp, Gaoyue Zhou, Gaurav S. Sukhatme, Gautam Salhotra, Ge Yan, Giulio Schiavi, Hao Su, Hao-Shu Fang, Haochen Shi, Heni Ben Amor, Henrik I Christensen, Hiroki Furuta, Homer Walke, Hongjie Fang, Igor Mordatch, Ilija Radosavovic, Isabel Leal, Jacky Liang, Jaehyung Kim, Jan Schneider, Jasmine Hsu, Jeannette Bohg, Jeffrey Bingham, Jiajun Wu, Jialin Wu, Jianlan Luo, Jiayuan Gu, Jie Tan, Jihoon Oh, Jitendra Malik, Jonathan Tompson, Jonathan Yang, Joseph J. Lim, João Silvério, Junhyek Han, Kanishka Rao, Karl Pertsch, Karol Hausman, Keegan Go, Keerthana Gopalakrishnan, Ken Goldberg, Kendra Byrne, Kenneth Oslund, Kento Kawaharazuka, Kevin Zhang, Keyvan Majd, Krishan Rana, Krishnan Srinivasan, Lawrence Yunliang Chen, Lerrel Pinto, Liam Tan, Lionel Ott, Lisa Lee, Masayoshi Tomizuka, Maximilian Du, Michael Ahn, Mingtong Zhang, Mingyu Ding, Mohan Kumar Srirama, Mohit Sharma, Moo Jin Kim, Naoaki Kanazawa, Nicklas Hansen, Nicolas Heess, Nikhil J Joshi, Niko Suenderhauf, Norman Di Palo, Nur Muhammad Mahi Shafiullah, Oier Mees, Oliver Kroemer, Pannag R Sanketi, Paul Wohlhart, Peng Xu, Pierre Sermanet, Priya Sundaresan, Quan Vuong, Rafael Rafailov, Ran Tian, Ria Doshi, Roberto Martín-Martín, Russell Mendonca, Rutav Shah, Ryan Hoque, Ryan Julian, Samuel Bustamante, Sean Kirmani, Sergey Levine, Sherry Moore, Shikhar Bahl, Shivin Dass, Shuran Song, Sichun Xu, Siddhant Haldar, Simeon Adebola, Simon Guist, Soroush Nasiriany, Stefan Schaal, Stefan Welker, Stephen Tian, Sudeep Dasari, Suneel Belkhale, Takayuki Osa, Tatsuya Harada, Tatsuya Matsushima, Ted Xiao, Tianhe Yu, Tianli Ding, Todor Davchev, Tony Z. Zhao, Travis Armstrong, Trevor Darrell, Vidhi Jain, Vincent Vanhoucke, Wei Zhan, Wenxuan Zhou, Wolfram Burgard, Xi Chen, Xiaolong Wang, Xinghao Zhu, Xuanlin Li, Yao Lu, Yevgen Chebotar, Yifan Zhou, Yifeng Zhu, Ying Xu, Yixuan Wang, Yonatan Bisk, Yoonyoung Cho, Youngwoon Lee, Yuchen Cui, Yueh hua Wu, Yujin Tang, Yuke Zhu, Yunzhu Li, Yusuke Iwasawa, Yutaka Matsuo, Zhuo Xu, and Zichen Jeff Cui. Open X-Embodiment: Robotic learning datasets and RT-X models. https://arxiv.org/abs/2310.08864, 2023. 7

[16] Steve Collins, Andy Ruina, Russ Tedrake, and Martijn Wisse. Efficient bipedal robots based on passive-dynamic walkers. Science, 2005. 3

[17] Stefano Dafarra, Kourosh Darvish, Riccardo Grieco, Gianluca Milani, Ugo Pattacini, Lorenzo Rapetti, Giulio Romualdi, Mattia Salvi, Alessandro Scalzo, Ines Sorrentino, et al. icub3 avatar system. arXiv preprint arXiv:2203.06972, 2022. 2, 3, 4

[18] Dima Damen, Hazel Doughty, Giovanni Maria Farinella, Sanja Fidler, Antonino Furnari, Evangelos Kazakos, Davide Moltisanti, Jonathan Munro, Toby Perrett, Will Price, et al. Scaling egocentric vision: The epic-kitchens dataset. In Proceedings of the European conference on computer vision (ECCV), 2018. 4

[19] Jeremy Dao, Helei Duan, and Alan Fern. Sim-to-real learning for humanoid box loco-manipulation. arXiv preprint arXiv:2310.03191, 2023. 2, 3

[20] Kourosh Darvish, Yeshasvi Tirupachuri, Giulio Romualdi, Lorenzo Rapetti, Diego Ferigo, Francisco Javier Andrade Chavez, and Daniele Pucci. Whole-body geometric retargeting for humanoid robots. In 2019 IEEE-RAS 19th International Conference on Humanoid Robots (Humanoids), 2019. 2, 3

[21] Anca D Dragan, Kenton CT Lee, and Siddhartha S Srinivasa. Legibility and predictability of robot motion. In 2013 8th ACM/IEEE International Conference on Human-Robot Interaction (HRI), 2013. 3

[22] Mohamed Elobaid, Yue Hu, Giulio Romualdi, Stefano Dafarra, Jan Babic, and Daniele Pucci. Telexistence and teleoperation for walking humanoid robots. In Intelligent Systems and Applications: Proceedings of the 2019 Intelligent Systems Conference (IntelliSys) Volume 2, pages 1106–1121. Springer, 2020. 4

[23] Siyuan Feng, Eric Whitman, X Xinjilefu, and Christopher G Atkeson. Optimization based full body control for the atlas robot. In International Conference on Humanoid Robots, 2014. 2

[24] Paolo Ferrari, Marco Cognetti, and Giuseppe Oriolo. Humanoid whole-body planning for loco-manipulation tasks. In 2017 IEEE International Conference on Robotics and Automation (ICRA), 2017. 3

[25] Zipeng Fu, Tony Z Zhao, and Chelsea Finn. Mobile aloha: Learning bimanual mobile manipulation with low-cost whole-body teleoperation. arXiv preprint arXiv:2401.02117, 2024. 7

[26] Raghav Goyal, Samira Ebrahimi Kahou, Vincent Michalski, Joanna Materzynska, Susanne Westphal, Heuna Kim, Valentin Haenel, Ingo Fruend, Peter Yianilos, Moritz Mueller-Freitag, et al. The" something something" video database for learning and evaluating visual common sense. In Proceedings of the IEEE international conference on computer vision, pages 5842–5850, 2017. 4

[27] Kristen Grauman, Andrew Westbury, Eugene Byrne, Zachary Chavis, Antonino Furnari, Rohit Girdhar, Jackson Hamburger, Hao Jiang, Miao Liu, Xingyu Liu, et al. Ego4d: Around the world in 3,000 hours of egocentric video. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2022. 4

[28] Nicklas Hansen, Zhecheng Yuan, Yanjie Ze, Tongzhou Mu, Aravind Rajeswaran, Hao Su, Huazhe Xu, and Xiaolong Wang. On pre-training for visuo-motor control: Revisiting a learning-from-scratch baseline. arXiv preprint arXiv:2212.05749, 2022. 4

[29] Kensuke Harada, Shuuji Kajita, Hajime Saito, Mitsuharu Morisawa, Fumio Kanehiro, Kiyoshi Fujiwara, Kenji Kaneko, and Hirohisa Hirukawa. A humanoid robot carrying a heavy object. In Proceedings of the 2005 IEEE International Conference on Robotics and Automation, 2005. 3

[30] Kensuke Harada, Shuuji Kajita, Fumio Kanehiro, Kiyoshi Fujiwara, Kenji Kaneko, Kazuhito Yokoi, and Hirohisa Hirukawa. Real-time planning of humanoid robot’s gait for force-controlled manipulation. IEEE/ASME Transactions on Mechatronics, 2007. 3

[31] Tairan He, Zhengyi Luo, Wenli Xiao, Chong Zhang, Kris Kitani, Changliu Liu, and Guanya Shi. Learning human-to-humanoid real-time whole-body teleoperation. arXiv preprint arXiv:2403.04436, 2024. 4

[32] Kazuo Hirai, Masato Hirose, Yuji Haikawa, and Toru Takenaka. The development of honda humanoid robot. In Proceedings. 1998 IEEE international conference on robotics and automation, 1998. 3

[33] Kai Hu, ChristianOtt, and Dongheui Lee. Online human walking imitation in task and joint space based on quadratic programming. In 2014 IEEE International Conference on Robotics and Automation (ICRA), pages 3458–3464. IEEE, 2014. 4

[34] Yasuhiro Ishiguro, Kunio Kojima, Fumihito Sugai, Shunichi Nozawa, Yohei Kakiuchi, Kei Okada, and Masayuki Inaba. High speed whole body dynamic motion experiment with real time master-slave humanoid robot system. In 2018 IEEE International Conference on Robotics and Automation (ICRA), pages 5835–5841. IEEE, 2018. 4

[35] Yasuhiro Ishiguro, Tasuku Makabe, Yuya Nagamatsu, Yuta Kojio, Kunio Kojima, Fumihito Sugai, Yohei Kakiuchi, Kei Okada, and Masayuki Inaba. Bilateral humanoid teleoperation system using whole-body exoskeleton cockpit tablis. IEEE Robotics and Automation Letters, 2020. 3

[36] Shuuji Kajita, Fumio Kanehiro, Kenji Kaneko, Kazuhito Yokoi, and Hirohisa Hirukawa. The 3d linear inverted pendulum mode: A simple modeling for a biped walking pattern generation. In Proceedings 2001 IEEE/RSJ International Conference on Intelligent Robots and Systems. Expanding the Societal Role of Robotics in the the Next Millennium (Cat. No. 01CH37180), 2001. 3

[37] Ichiro Kato. Development of wabot 1. Biomechanism, 1973. 3

[38] Doik Kim, Bum-Jae You, and Sang-Rok Oh. Whole body motion control framework for arbitrarily and simultaneously assigned upper-body tasks and walking motion. Modeling, Simulation and Optimization of Bipedal Walking, 2013. 2, 3

[39] Lokesh Krishna, Guillermo A Castillo, Utkarsh A Mishra, Ayonga Hereid, and Shishir Kolathaya. Linear policies are sufficient to realize robust bipedal walking on challenging terrains. IEEE Robotics and Automation Letters, 2022. 3

[40] Scott Kuindersma, Robin Deits, Maurice Fallon, Andrés Valenzuela, Hongkai Dai, Frank Permenter, Twan Koolen, Pat Marion, and Russ Tedrake. Optimization-based locomotion planning, estimation, and control design for the atlas humanoid robot. Autonomous robots, 2016. 2, 3

[41] Ashish Kumar, Zipeng Fu, Deepak Pathak, and Jitendra Malik. Rma: Rapid motor adaptation for legged robots. arXiv preprint arXiv:2107.04034, 2021. 2

[42] Ashish Kumar, Zhongyu Li, Jun Zeng, Deepak Pathak, Koushil Sreenath, and Jitendra Malik. Adapting rapid motor adaptation for bipedal robots. In 2022 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 2022. 3

[43] Sateesh Kumar, Jonathan Zamora, Nicklas Hansen, Rishabh Jangir, and Xiaolong Wang. Graph inverse reinforcement learning from diverse videos. In Conference on Robot Learning, 2023. 4

[44] Zhongyu Li, Xuxin Cheng, Xue Bin Peng, Pieter Abbeel, Sergey Levine, Glen Berseth, and Koushil Sreenath. Reinforcement learning for robust parameterized locomotion control of bipedal robots. In 2021 IEEE International Conference on Robotics and Automation (ICRA), 2021. 3

[45] Zhongyu Li, Xue Bin Peng, Pieter Abbeel, Sergey Levine, Glen Berseth, and Koushil Sreenath. Reinforcement learning for versatile, dynamic, and robust bipedal locomotion control. arXiv preprint arXiv:2401.16889, 2024. 3

[46] Toru Lin, Yu Zhang, Qiyang Li, Haozhi Qi, Brent Yi, Sergey Levine, and Jitendra Malik. Learning visuotactile skills with two multifingered hands. arXiv:2404.16823, 2024. 3

[47] YuXuan Liu, Abhishek Gupta, Pieter Abbeel, and Sergey Levine. Imitation from observation: Learning to imitate behaviors from raw video via context translation. In 2018 IEEE international conference on robotics and automation (ICRA), 2018. 4

[48] Zhengyi Luo, Jinkun Cao, Alexander W. Winkler, Kris Kitani, and Weipeng Xu. Perpetual humanoid control for real-time simulated avatars. In International Conference on Computer Vision (ICCV), 2023. 4

[49] Naureen Mahmood, Nima Ghorbani, Nikolaus F. Troje, Gerard Pons-Moll, and Michael J. Black. AMASS: Archive of motion capture as surface shapes. In International Conference on Computer Vision, 2019. 2, 4

[50] Arjun Majumdar, Karmesh Yadav, Sergio Arnaud, Jason Ma, Claire Chen, Sneha Silwal, Aryan Jain, Vincent-Pierre Berges, Tingfan Wu, Jay Vakil, et al. Where are we in the search for an artificial visual cortex for embodied intelligence? Advances in Neural Information Processing Systems, 2024. 4

[51] Takahiro Miki, Joonho Lee, Jemin Hwangbo, Lorenz Wellhausen, Vladlen Koltun, and Marco Hutter. Learning robust perceptive locomotion for quadrupedal robots in the wild. Science Robotics, 2022. 2

[52] Francisco-Javier Montecillo-Puente, Manish Sreenivasa, and Jean-Paul Laumond. On real-time whole-body human to humanoid motion transfer. 2010. 4

[53] Suraj Nair, Aravind Rajeswaran, Vikash Kumar, Chelsea Finn, and Abhinav Gupta. R3m: A universal visual representation for robot manipulation. arXiv preprint arXiv:2203.12601, 2022. 4

[54] Gabe Nelson, Aaron Saunders, Neil Neville, Ben Swilling, Joe Bondaryk, Devin Billings, Chris Lee, Robert Playter, and Marc Raibert. Petman: A humanoid robot for testing chemical protective clothing. Journal of the Robotics Society of Japan, 2012. 3

[55] Quan Nguyen, Ayush Agrawal, Xingye Da, William C Martin, Hartmut Geyer, Jessy W Grizzle, and Koushil Sreenath. Dynamic walking on randomly-varying discrete terrain with one-step preview. In Robotics: Science and Systems, 2017. 3

[56] Kazuya Otani and Karim Bouyarmane. Adaptive whole-body manipulation in human-to-humanoid multi-contact motion retargeting. In 2017 IEEE-RAS 17th International Conference on Humanoid Robotics (Humanoids), pages 446–453. IEEE, 2017. 4

[57] Georgios Pavlakos, Vasileios Choutas, Nima Ghorbani, Timo Bolkart, Ahmed A. A. Osman, Dimitrios Tzionas, and Michael J. Black. Expressive body capture: 3D hands, face, and body from a single image. In Proceedings IEEE Conf. on Computer Vision and Pattern Recognition (CVPR), pages 10975–10985, 2019. 4

[58] Georgios Pavlakos, Dandan Shan, Ilija Radosavovic, Angjoo Kanazawa, David Fouhey, and Jitendra Malik. Reconstructing hands in 3D with transformers. In CVPR, 2024. 2, 5

[59] Luigi Penco, Nicola Scianca, Valerio Modugno, Leonardo Lanari, Giuseppe Oriolo, and Serena Ivaldi. A multimode teleoperation framework for humanoid loco-manipulation: An application for the icub robot. IEEE Robotics & Automation Magazine, 2019. 2, 3

[60] Luigo Penco, Brice Clément, Valerio Modugno, E Mingo Hoffman, Gabriele Nava, Daniele Pucci, Nikos G Tsagarakis, J-B Mouret, and Serena Ivaldi. Robust real-time whole-body motion retargeting from human to humanoid. In 2018 IEEE-RAS 18th International Conference on Humanoid Robots (Humanoids), pages 425–432. IEEE, 2018. 4

[61] Luka Peternel and Jan Babič. Learning of compliant human–robot interaction using full-body haptic interface. Advanced Robotics, 2013. 3

[62] Tifanny Portela, Gabriel B Margolis, Yandong Ji, and Pulkit Agrawal. Learning force control for legged manipulation. arXiv preprint arXiv:2405.01402, 2024. 3

[63] Amartya Purushottam, Christopher Xu, Yeongtae Jung, and Joao Ramos. Dynamic mobile manipulation via whole-body bilateral teleoperation of a wheeled humanoid. IEEE Robotics and Automation Letters, 2023. 3

[64] Yuzhe Qin, Yueh-Hua Wu, Shaowei Liu, Hanwen Jiang, Ruihan Yang, Yang Fu, and Xiaolong Wang. Dexmv: Imitation learning for dexterous manipulation from human videos. In European Conference on Computer Vision, 2022. 4

[65] Nicolaus A Radford, Philip Strawser, Kimberly Hambuchen, Joshua S Mehling, William K Verdeyen, A Stuart Donnan, James Holley, Jairo Sanchez, Vienny Nguyen, Lyndon Bridgwater, et al. Valkyrie: Nasa’s first bipedal humanoid robot. Journal of Field Robotics, 2015. 3

[66] Ilija Radosavovic, Tete Xiao, Stephen James, Pieter Abbeel, Jitendra Malik, and Trevor Darrell. Real-world robot learning with masked visual pre-training. In Conference on Robot Learning, 2023. 4

[67] Ilija Radosavovic, Tete Xiao, Bike Zhang, Trevor Darrell, Jitendra Malik, and Koushil Sreenath. Real-world humanoid locomotion with reinforcement learning. Science Robotics, 2024. 3, 6

[68] Ilija Radosavovic, Bike Zhang, Baifeng Shi, Jathushan Rajasegaran, Sarthak Kamat, Trevor Darrell, Koushil Sreenath, and Jitendra Malik. Humanoid locomotion as next token prediction. arXiv preprint arXiv:2402.19469, 2024. 2, 3

[69] Marc H Raibert. Legged robots that balance. MIT press, 1986. 3

[70] Joao Ramos and Sangbae Kim. Humanoid dynamic synchronization through whole-body bilateral feedback teleoperation. IEEE Transactions on Robotics, 2018. 3

[71] Joao Ramos and Sangbae Kim. Dynamic locomotion synchronization of bipedal robot and human operator via bilateral feedback teleoperation. Science Robotics, 2019. 3

[72] Javier Romero, Dimitrios Tzionas, and Michael J. Black. Embodied hands: Modeling and capturing hands and bodies together. ACM Transactions on Graphics, (Proc. SIGGRAPH Asia), 2017. 5

[73] Shimpei Sato, Yuta Kojio, Kunio Kojima, Fumihito Sugai, Yohei Kakiuchi, Kei Okada, and Masayuki Inaba. Drop prevention control for humanoid robots carrying stacked boxes. In 2021 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). IEEE, 2021. 3

[74] John Schulman, Filip Wolski, Prafulla Dhariwal, Alec Radford, and Oleg Klimov. Proximal policy optimization algorithms. arXiv preprint arXiv:1707.06347, 2017. 6

[75] Max Schwarz, Christian Lenz, Andre Rochow, Michael Schreiber, and Sven Behnke. Nimbro avatar: Interactive immersive telepresence with force-feedback telemanipulation. In 2021 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), pages 5312–5319, 2021. 3

[76] Mingyo Seo, Steve Han, Kyutae Sim, Seung Hyeon Bang, Carlos Gonzalez, Luis Sentis, and Yuke Zhu. Deep imitation learning for humanoid loco-manipulation through human teleoperation. In 2023 IEEE-RAS 22nd International Conference on Humanoid Robots (Humanoids), 2023. 4

[77] Alessandro Settimi, Danilo Caporale, Przemyslaw Kryczka, Mirko Ferrati, and Lucia Pallottino. Motion primitive based random planning for loco-manipulation tasks. In 2016 IEEE-RAS 16th International Conference on Humanoid Robots (Humanoids), 2016. 3

[78] Nur Muhammad Mahi Shafiullah, Anant Rai, Haritheja Etukuru, Yiqian Liu, Ishan Misra, Soumith Chintala, and Lerrel Pinto. On bringing robots home. arXiv preprint arXiv:2311.16098, 2023. 4

[79] Lin Shao, Toki Migimatsu, Qiang Zhang, Karen Yang, and Jeannette Bohg. Concept2robot: Learning manipulation concepts from instructions and human demonstrations. The International Journal of Robotics Research, 40(12-14):1419–1434, 2021. 4

[80] Pratyusha Sharma, Deepak Pathak, and Abhinav Gupta. Third-person visual imitation learning via decoupled hierarchical controller. Advances in Neural Information Processing Systems, 2019. 4

[81] Soyong Shin, Juyong Kim, Eni Halilaj, and Michael J. Black. Wham: Reconstructing world-grounded humans with accurate 3d motion. In Computer Vision and Pattern Recognition (CVPR), 2024. 2, 5

[82] Maximilian Sieb, Zhou Xian, Audrey Huang, Oliver Kroemer, and Katerina Fragkiadaki. Graph-structured visual imitation. In Conference on Robot Learning, 2020. 4

[83] Jonah Siekmann, Yesh Godse, Alan Fern, and Jonathan Hurst. Sim-to-real learning of all common bipedal gaits via periodic reward composition. In 2021 IEEE International Conference on Robotics and Automation (ICRA), 2021. 3

[84] Jonah Siekmann, Kevin Green, John Warila, Alan Fern, and Jonathan Hurst. Blind bipedal stair traversal via sim-to-real reinforcement learning. arXiv preprint arXiv:2105.08328, 2021. 3

[85] Rohan P Singh, Zhaoming Xie, Pierre Gergondet, and Fumio Kanehiro. Learning bipedal walking for humanoids with current feedback. IEEE Access, 2023. 3

[86] Aravind Sivakumar, Kenneth Shaw, and Deepak Pathak. Robotic telekinesis: Learning a robotic hand imitator by watching humans on youtube. arXiv preprint arXiv:2202.10448, 2022. 3, 4

[87] Laura Smith, Nikita Dhawan, Marvin Zhang, Pieter Abbeel, and Sergey Levine. Avid: Learning multi-stage tasks via pixel-level translation of human videos. arXiv preprint arXiv:1912.04443, 2019. 4

[88] Shuran Song, Andy Zeng, Johnny Lee, and Thomas Funkhouser. Grasping in the wild: Learning 6dof closed-loop grasping from low-cost demonstrations. IEEE Robotics and Automation Letters, 2020. 4

[89] Olivier Stasse, Thomas Flayols, Rohan Budhiraja, Kevin Giraud-Esclasse, Justin Carpentier, Joseph Mirabel, Andrea Del Prete, Philippe Souères, Nicolas Mansard, Florent Lamiraux, et al. Talos: A new humanoid research platform targeted for industrial applications. In 2017 IEEE-RAS 17th International Conference on Humanoid Robotics (Humanoids), 2017. 3

[90] Susumu Tachi, Yasuyuki Inoue, and Fumihiro Kato. Telesar vi: Telexistence surrogate anthropomorphic robot vi. International Journal of Humanoid Robotics. 3, 4

[91] Annan Tang, Takuma Hiraoka, Naoki Hiraoka, Fan Shi, Kento Kawaharazuka, Kunio Kojima, Kei Okada, and Masayuki Inaba. Humanmimic: Learning natural locomotion and transitions for humanoid robot via wasserstein adversarial imitation. arXiv preprint arXiv:2309.14225, 2023. 3

[92] Yuval Tassa, Tom Erez, and Emanuel Todorov. Synthesis and stabilization of complex behaviors through online trajectory optimization. In 2012 IEEE/RSJ International Conference on Intelligent Robots and Systems, 2012. 3

[93] Russ Tedrake, Teresa Weirui Zhang, and H Sebastian Seung. Stochastic policy gradient reinforcement learning on a simple 3d biped. In 2004 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)(IEEE Cat. No. 04CH37566), 2004. 3

[94] Bart van Marum, Aayam Shrestha, Helei Duan, Pranay Dugar, Jeremy Dao, and Alan Fern. Revisiting reward design and evaluation for robust humanoid standing and walking. arXiv preprint arXiv:2404.19173, 2024. 3

[95] Chen Wang, Linxi Fan, Jiankai Sun, Ruohan Zhang, Li Fei-Fei, Danfei Xu, Yuke Zhu, and Anima Anandkumar. Mimicplay: Long-horizon imitation learning by watching human play. arXiv preprint arXiv:2302.12422, 2023. 4

[96] Chen Wang, Haochen Shi, Weizhuo Wang, Ruohan Zhang, Li Fei-Fei, and C. Karen Liu. Dexcap: Scalable and portable mocap data collection system for dexterous manipulation. arXiv preprint arXiv:2403.07788, 2024. 4

[97] Jianren Wang, Sudeep Dasari, Mohan Kumar Srirama, Shubham Tulsiani, and Abhinav Gupta. Manipulate by seeing: Creating manipulation controllers from pre-trained representations. In Proceedings of the IEEE/CVF International Conference on Computer Vision, pages 3859–3868, 2023. 4

[98] Eric R Westervelt, Jessy W Grizzle, and Daniel E Koditschek. Hybrid zero dynamics of planar biped walkers. IEEE transactions on automatic control, 2003. 3

[99] Tete Xiao, Ilija Radosavovic, Trevor Darrell, and Jitendra Malik. Masked visual pre-training for motor control. arXiv preprint arXiv:2203.06173, 2022. 4

[100] Zhaoming Xie, Glen Berseth, Patrick Clary, Jonathan Hurst, and Michiel Van de Panne. Feedback control for cassie with deep reinforcement learning. In 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 2018. 3

[101] Haoyu Xiong, Quanzhou Li, Yun-Chun Chen, Homanga Bharadhwaj, Samarth Sinha, and Animesh Garg. Learning by watching: Physical imitation of manipulation skills from human videos. In 2021 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 2021. 4

[102] Sarah Young, Dhiraj Gandhi, Shubham Tulsiani, Abhinav Gupta, Pieter Abbeel, and Lerrel Pinto. Visual imitation made easy. In Conference on Robot Learning. PMLR, 2021. 4

[103] Qiang Zhang, Peter Cui, David Yan, Jingkai Sun, Yiqun Duan, Arthur Zhang, and Renjing Xu. Whole-body humanoid robot locomotion with human reference. arXiv preprint arXiv:2402.18294, 2024. 3

[104] Tony Z Zhao, Vikash Kumar, Sergey Levine, and Chelsea Finn. Learning fine-grained bimanual manipulation with low-cost hardware. RSS, 2023. 3, 7, 9, 10

![[算法刷题—二分法]寻找插入位置](https://img-blog.csdnimg.cn/direct/4d5da675ec0a4b12a01b30e8cdc475ed.png)