- 原始项目可能主要的功能是接收下位机传送来的很多参数,然后将参数以不同形式表达出来,在此过程中会涉及到文件上传下载、excel表格导出…等,但是呢,这么多数据不玩一下岂不是太浪费。于是,额们决定这样来:

- 项目中有一个摄像头实时监控模块,但是我们项目用的摄像头有缺陷,识别不准确、只能进行离线计算【比如套牌车这种应用场景,等你离线去算时人家早没了,会花很多功夫,所以得搞实时时的】

- 具体实施思路的主要流程:

由我们的高速这个凝冰预警系统中的实时监控摄像头拍摄到数据,然后将数据给到我们留的Rest接口的服务,我们搞了俩【搞个集群是为了防止高并发以及高可用的情况】,这些接口就是用来接收我们其他系统发来的交通流数据的,比如拍的照片等等通过这个REST接口把数据保存到本地磁盘- 利用LOG4J日志技术把采集到的数据以文件的形式存到本地磁盘【log.info(“要存的数据”)】。主要的采集数据并存储的逻辑在咱们的DataService的子实现类中【代码要规范,该定义接口、异常类等都要定义,搞配置文件出来提高灵活性】

/** *接收数据,并通过Logger保存数据到文件中 */ ... @Service public class DataServiceImpl implements DataService{ ... public void process(String dataType, HttpServletRequest request){ //保护性的判断 if(StringUtils.isEmpty(dataType)){...} //判断请求头中是否传入了数据 int contentLength = request.getContentLength(); if(contentLength < 1){...} //通过字节流读数据,从Request中读取数据 byte[] datas = new byte[contentLength];//存放数据的字节数组 BufferInputStream input = new BufferedInputStream(request.getInputStream()); ... //把JSON字符串先解析出来再存储 ... logger.info(jsonStr); } } - 日志配置文件中,主要的<logger…>中要写项目中哪个包有日志操作行为【具体到本项目中就是存储采集回来的数据】,然后定义日志级别level为INFO,再就是,定义向文件中输出,在中配置文件输出路径

- 关于日志,再多唠唠。咱们这里的日志一般指的是用户的行为,不是之前咱们项目产生的那个狭义的错误日志

- 日志数据分析:涉及到大的数据量的平台系统都可以用

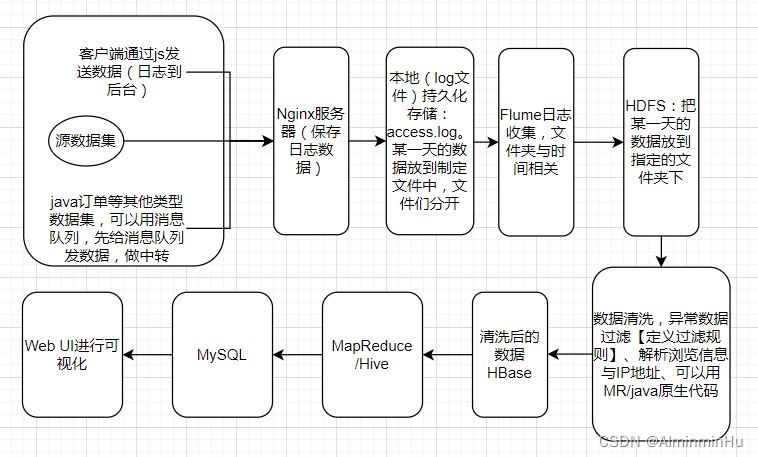

日志数据分分析项目&离线批处理项目的整体流程:一般咱们的代码部署在web容器中,flume一般要跨机器,如果发送数据过程中网络断了怎么办,所以中间搞了个Nginx暂存一下数据,放到本地文件中,然后Flume从本地文件中拿到数据给HDFS,然后…

- 数据收集:

- 数据来源:可以从前端得到用户提交的或者操作的数据【咱们通过写java代码向nginx中发送数据http://…?key1=val1&key2=val2&…。其实就是向队列中放数据,然后在另一端从队列中拿数据】

- Flume:可以从不同的Nginx服务器中收集到数据

- 数据来源:可以从前端得到用户提交的或者操作的数据【咱们通过写java代码向nginx中发送数据http://…?key1=val1&key2=val2&…。其实就是向队列中放数据,然后在另一端从队列中拿数据】

- 数据清洗

- 异常数据过滤:定义过滤规则

- 解析浏览信息与IP地址

- 数据存储:技术选型中存储引擎中可以使用HDFS、HBase

- 数据分析:用MapReduce、Hive来进行分析

- 数据可视化

- 数据收集:

- 日志数据分析:涉及到大的数据量的平台系统都可以用

- 利用LOG4J日志技术把采集到的数据以文件的形式存到本地磁盘【log.info(“要存的数据”)】。主要的采集数据并存储的逻辑在咱们的DataService的子实现类中【代码要规范,该定义接口、异常类等都要定义,搞配置文件出来提高灵活性】

然后通过多个Flume去采集多个磁盘的数据,采集来的数据先汇总到一个总的Flume,由这个总的Flume把数据采集到kafka中【kafka只能保存7天】- Flume经常用于数据采集

kafka传给Flink去进行计算,实时分析... @RestController @RequestMapping("/xxx") /** * 这个控制器是,只要有采集的数据请求来http://localhost/...,因为咱们用的是Post方式,所以请求头中有参数来 */ public class DataController{ @PostMapping("/sendData/{dataType}") /** * 因为数据有很多类型,所以得有表示数据类型的字符串变量 * 还因为数据是通过请求参数传进来的,所以得加个@PathVariable() */ public Object collect(@PathVariable("dataType") String dataType, HttpServletRequest request){ ...; } }- 可以用Flink先进行数据清洗

- 利用SpringBoot进行数据采集的实现。比如定义DataController为数据采集的一个控制器

- 然后,进而利用数据进行:

- 实时监控交通流三参数:流密速,基本上车速居多

可以根据逻辑回归去预测某个路段拥堵情况

- 实时智能报警:页面上有路况的预警处理,LED警示牌,师兄去隧道那边做的

- 实时监控交通流三参数:流密速,基本上车速居多

java基础巩固-宇宙第一AiYWM:为了维持生计,做项目经验之~高速项目大数据及机器学习算法方面的思路总结~整起

news2026/2/12 19:20:42

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/181901.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

Metasploit工具使用(上)

Metasploit工具使用1.Metasploit简介1.1.Metasploit下载1.2.Metasploit框架结构1.2.1.框架路径1.2.2.框架内容介绍1.2.2.1.data目录文件1.2.2.2.modules目录文件1.2.2.3.scripts目录文件1.2.2.4.tools目录文件1.2.2.5.plugins目录文件1.3.Metasploit更新2.MSF中数据库设置2.1.数…

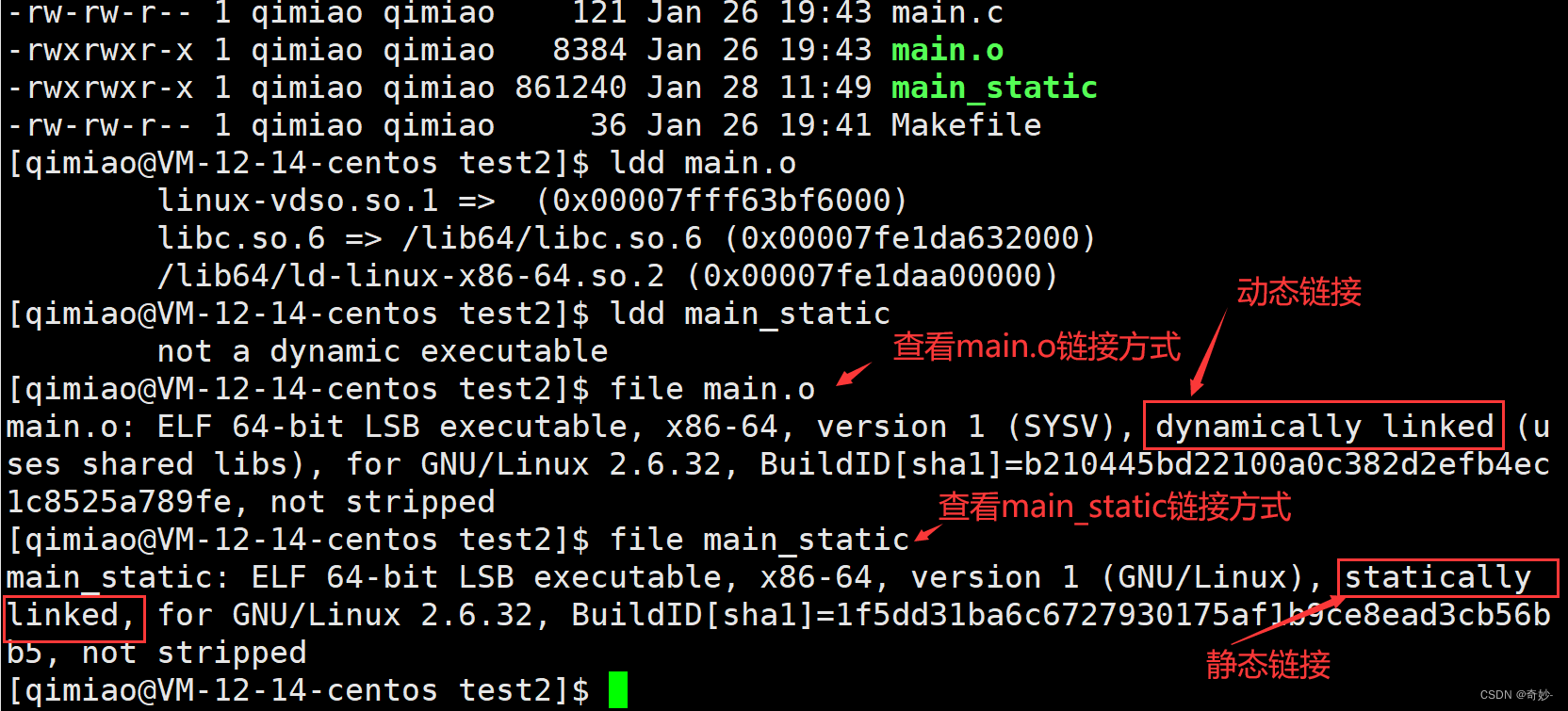

动态与静态函数库的的使用 和 区别 及 优缺点

这里写目录标题初识静态库与动态库静态函数库动态函数库初识静态库与动态库

静态函数库与动态函数库的使用中,有人也把他称为程序的静态链接及动态链接。 静态链接:指程序链接时使用静态库的链接方式,把所有需要的库函数加入(拷贝…

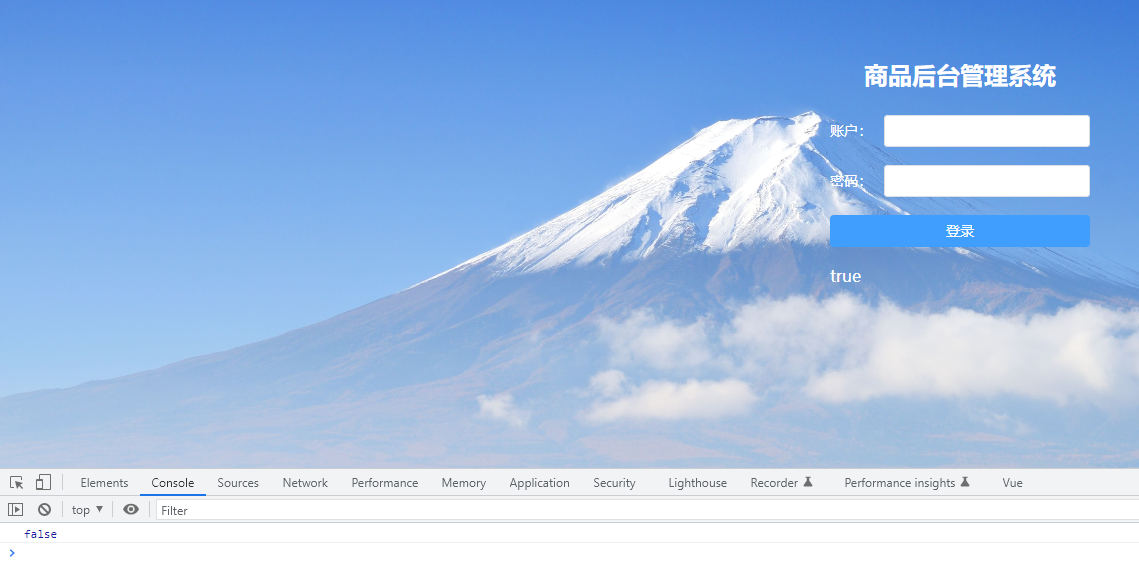

Vue3商店后台管理系统设计文稿篇(七)

记录使用vscode构建Vue3商店后台管理系统,这是第七篇,主要记录系统登录页面的创建过程,包含完整vue登录页面代码;Vuex的相关知识以及具体的使用,对state中值得获取,修改,异步修改,分…

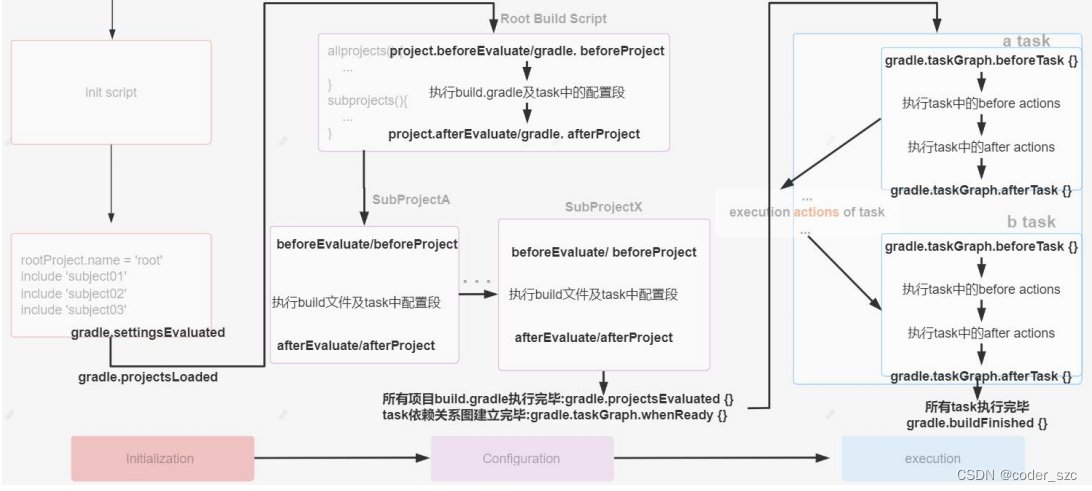

Gradle学习笔记之Hook生命周期

简介

Gradle生命周期中的hook(钩子)函数是由gradle自动回调的,可以用来帮助我们实现一些功能: Gradle在生命周期各个阶段都提供了用于回调的钩子函数:

Gradle初始化阶段: 在settings.gradle执行完后,会回调Gradle对…

2022爱分析・智能客服厂商全景报告 | 爱分析报告

报告编委 张扬 爱分析联合创始人&首席分析师 文鸿伟 爱分析高级分析师 王鹏 爱分析分析师 目录

研究范围定义厂商全景地图市场分析与厂商评估入选厂商列表研究范围定义

研究范围 在数字化快速发展的大背景下,随着消费人群及其消费意识的转变,客户对…

亚马逊云科技凭借多年云业务经验,协同合作伙伴快速展开生态化创新

在过去的两周里,ChatGPT的热度居高不下,引发全网讨论。虽然AlphaGo这类AI产品也曾引起热议,但是在应用层面终究还是离用户太远了。而ChatGPT更像是「民用级」的产品,真正意义上让AI技术跨入广泛破圈应用时代。在当下,机…

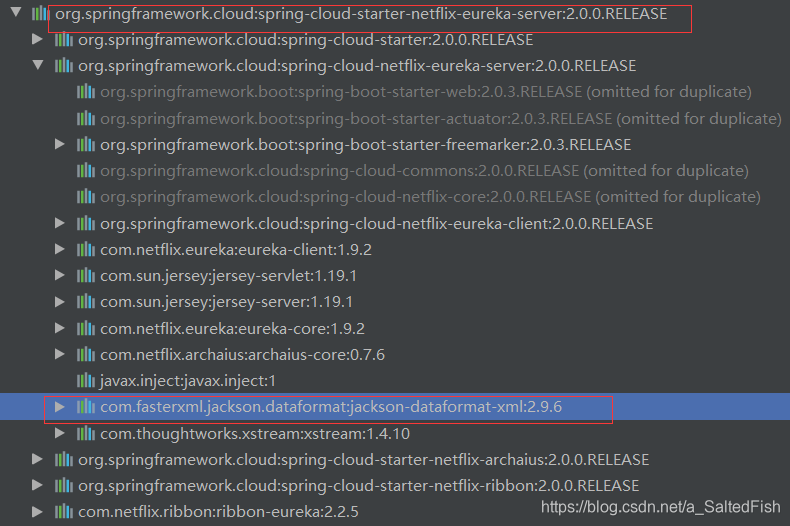

springboot项目解决@ResponseBody注解返回xml格式数据而不是json格式的问题

目录 1.说明

2.解决 1.说明

一般情况下,RestController中的接口默认响应数据格式都是 json 格式的数据,但有时候使用某些依赖包,会影响ResponseBody的响应数据类型为xml格式,

例: 2.解决

但我们希望响应数据格式是…

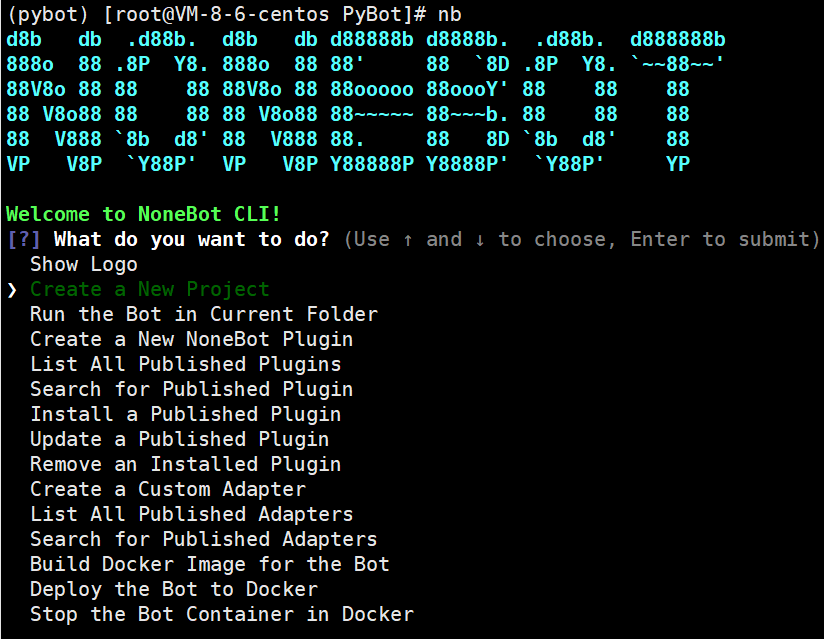

使用腾讯云服务器+Nonebot2+go-cqhttp搭建QQ聊天机器人

文章目录一、查看conda版本二、查看系统版本三、配置go-cqhttp1.请切换至同一网络下扫码2.打包Docker镜像四、创建NoneBot环境安装脚手架一、查看conda版本 二、查看系统版本

uname -a

arch

getconf LONG_BIT三、配置go-cqhttp

下载go-cqhttp

这里有不同版本的cqhttp,并且对…

【数据结构】——如何设计一个链表?(设计链表)

本文主题:通过一道题目,学习链表的基本操作 更多算法:动态规划 ✔️ 边界控制 我的主页:蓝色学者的主页 文章目录一、前言二、题目信息三、解决方案3.0什么是链表?3.1节点的概念虚拟头节点3.2链表创建3.3头插/尾插3…

JUC面试(十三)——锁膨胀

锁膨胀

monitor概念 Monitor是 Java中用以实现线程之间的互斥与协作的主要手段,它可以看成是对象或者 Class的锁。每一个对象都有,也仅有一个 monitor。上面这个图,描述了线程和 Monitor之间关系,以及线程的状态转换图。

进入区…

windows11 永久关闭windows defender的方法

1、按键盘上的windows按键,再点【设置】选项。 2、点击左侧菜单的【隐私和安全性】,再点击列表的【Windows安全中心】选项。 3、点击界面的【病毒和威胁保护】设置项。 4、病毒保护的全部关闭 5、别人的图(正常是都开着的) 6、终极…

为什么看上去很简单的智慧功能点要价上千万?

人工智能(Artificial Intelligence,AI)已经不是什么新概念,第三次浪潮于2016年AlphaGo战胜李世石为标志正式开启,至今也已经走过6个年头。 发展至今,AI已经进入老百姓的日常生活,比如随处可见的…

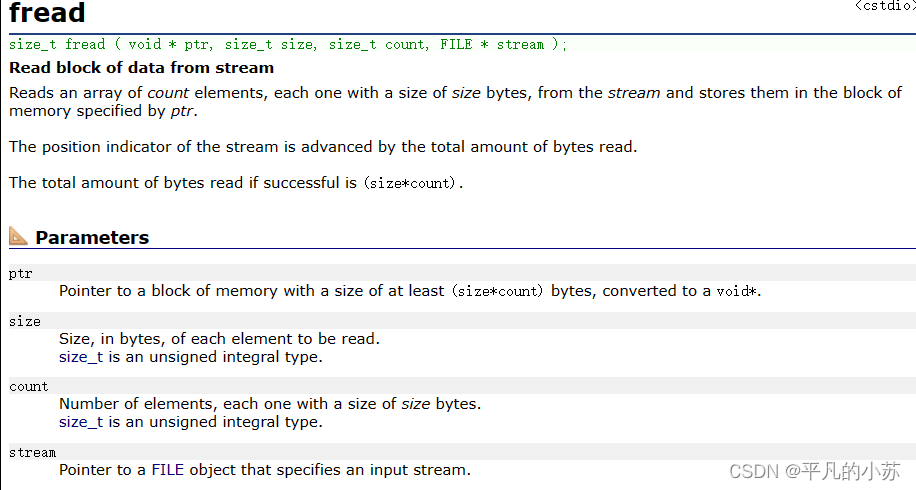

【C语言】从0到1带你学会文件版动态通讯录

🌇个人主页:平凡的小苏 📚学习格言:别人可以拷贝我的模式,但不能拷贝我不断往前的激情 🛸C语言专栏:https://blog.csdn.net/vhhhbb/category_12174730.html 小苏希望大家能从这篇文章中收获到许…

初学者试试,HarmonyOS应用开发者基础认证

一些初学HarmonyOS应用开发的同学往往不知道如何开始,建议先试试《HarmonyOS应用开发者基础认证》,基础认证是华为进一步大范围布局推广“鸿蒙世界”的新举措。也是初学者开启鸿蒙世界的一把钥匙。

【说说鸿蒙世界】 相信大家已经对鸿蒙不陌生了&#x…

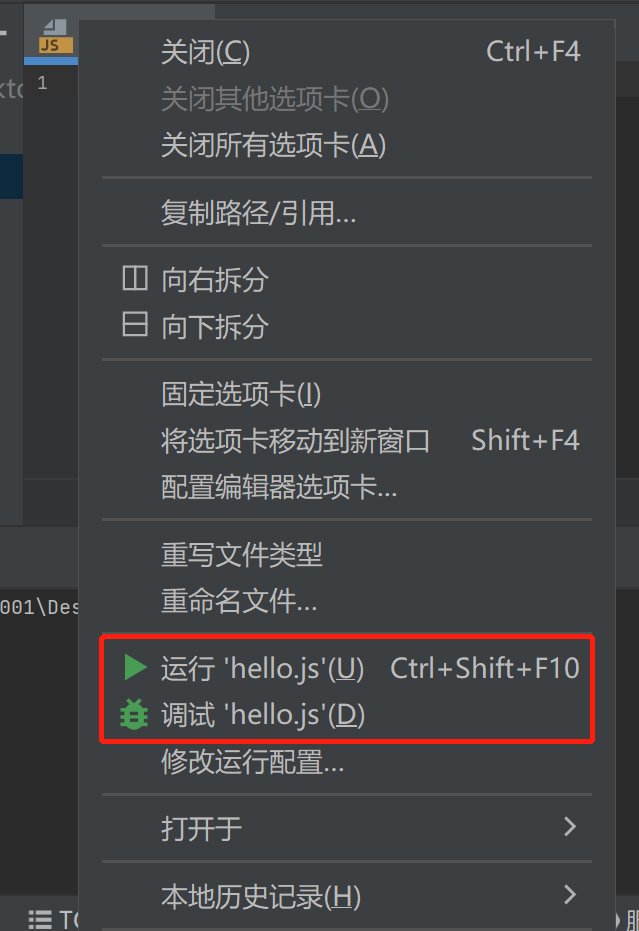

IDEA新建js项目和执行js脚本

一)、安装Node.js具体操作参考:https://blog.csdn.net/xijinno1/article/details/128774375二)、IDEA中新建js项目(hello world)1.按照下图,新建js项目2.选中示例代码文件后点击运行->运行3.选择【编辑配置】4.更新一下节点解释器(nodejs.exe),点击运…

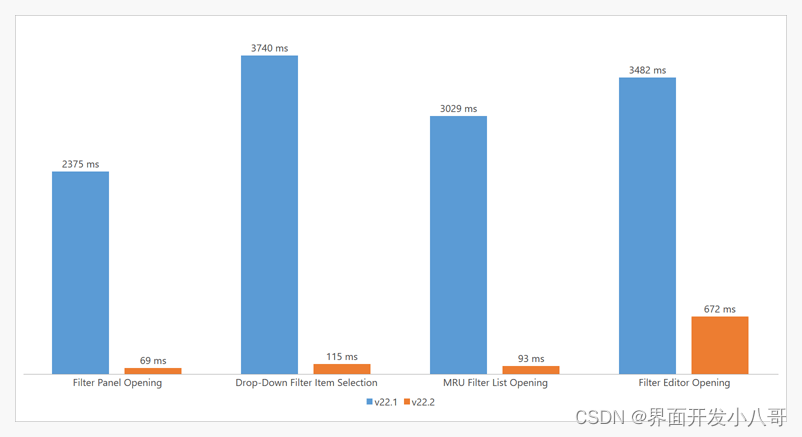

界面组件DevExpress WPF v22.2 - Windows 11暗黑主题发布

DevExpress WPF拥有120个控件和库,将帮助您交付满足甚至超出企业需求的高性能业务应用程序。通过DevExpress WPF能创建有着强大互动功能的XAML基础应用程序,这些应用程序专注于当代客户的需求和构建未来新一代支持触摸的解决方案。 无论是Office办公软件…

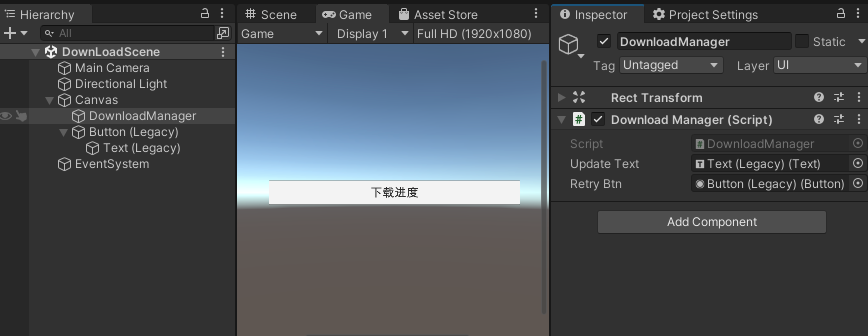

Unity 之 Addressable可寻址系统 -- 资源远程加载 | 资源预下载

可寻址系统远程加载 -- 资源预下载 -- 进阶(三)一,Unity 云资源分发 -- 使用介绍1.1 CCD 的介绍1.2 后台准备工作二,CDD的使用2.1 CCD可视化界面的使用2.2 CDD命令行界面使用2.2.1 准备工作2.2.2 CLI 用法三,AA CCD资…

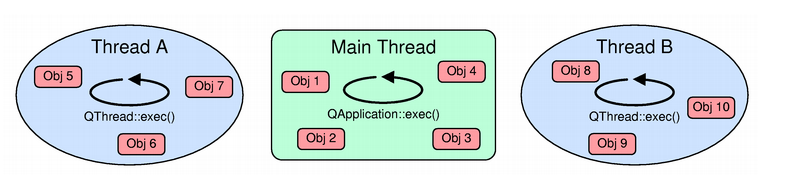

Qt扫盲-QObject对象和线程

QObject对象和线程一、概述二、QObjectReentrant性三、每个线程事件的循环四、从其他线程访问QObject的子类五、跨线程的信号和槽函数一、概述

QThread继承QObject。QThread它发出信号来指示线程开始或结束执行,还提供了一些任务槽。

Qobject可以在多个线程中使用…

L1-006 连续因子

一个正整数 N 的因子中可能存在若干连续的数字。例如 630 可以分解为 3567,其中 5、6、7 就是 3 个连续的数字。给定任一正整数 N,要求编写程序求出最长连续因子的个数,并输出最小的连续因子序列。

输入格式:

输入在一行中给出一…