MiniCPM-2B-chat 介绍

MiniCPM 是面壁智能与清华大学自然语言处理实验室共同开源的系列端侧大模型,主体语言模型 MiniCPM-2B 仅有 24亿(2.4B)的非词嵌入参数量。

经过 SFT 后,MiniCPM 在公开综合性评测集上,MiniCPM 与 Mistral-7B相近(中文、数学、代码能力更优),整体性能超越 Llama2-13B、MPT-30B、Falcon-40B 等模型。

经过 DPO 后,MiniCPM 在当前最接近用户体感的评测集 MTBench上,MiniCPM-2B 也超越了 Llama2-70B-Chat、Vicuna-33B、Mistral-7B-Instruct-v0.1、Zephyr-7B-alpha 等众多代表性开源大模型。

以 MiniCPM-2B 为基础构建端侧多模态大模型 MiniCPM-V,整体性能在同规模模型中实现最佳,超越基于 Phi-2 构建的现有多模态大模型,在部分评测集上达到与 9.6B Qwen-VL-Chat 相当甚至更好的性能。

经过 Int4 量化后,MiniCPM 可在手机上进行部署推理,流式输出速度略高于人类说话速度。MiniCPM-V 也直接跑通了多模态大模型在手机上的部署。

一张1080/2080可高效参数微调,一张3090/4090可全参数微调,一台机器可持续训练 MiniCPM,二次开发成本较低。

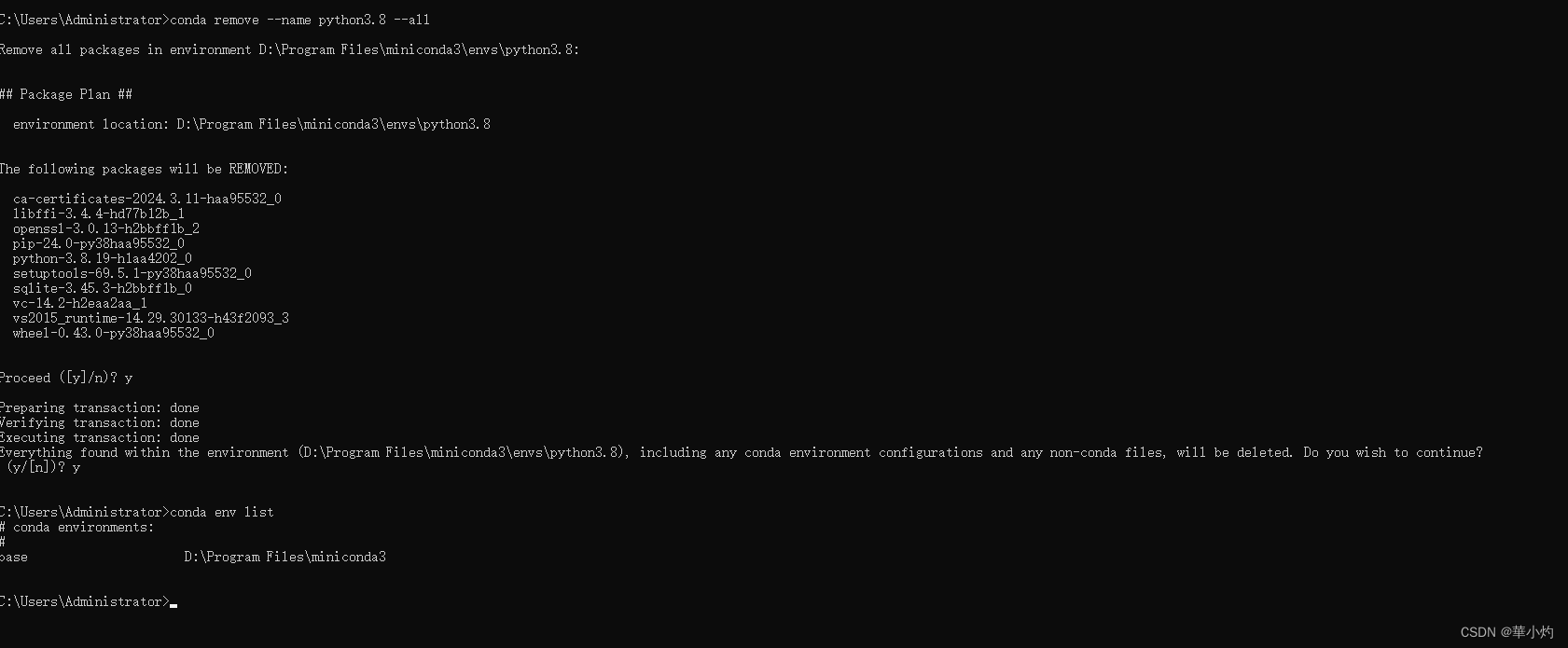

环境准备

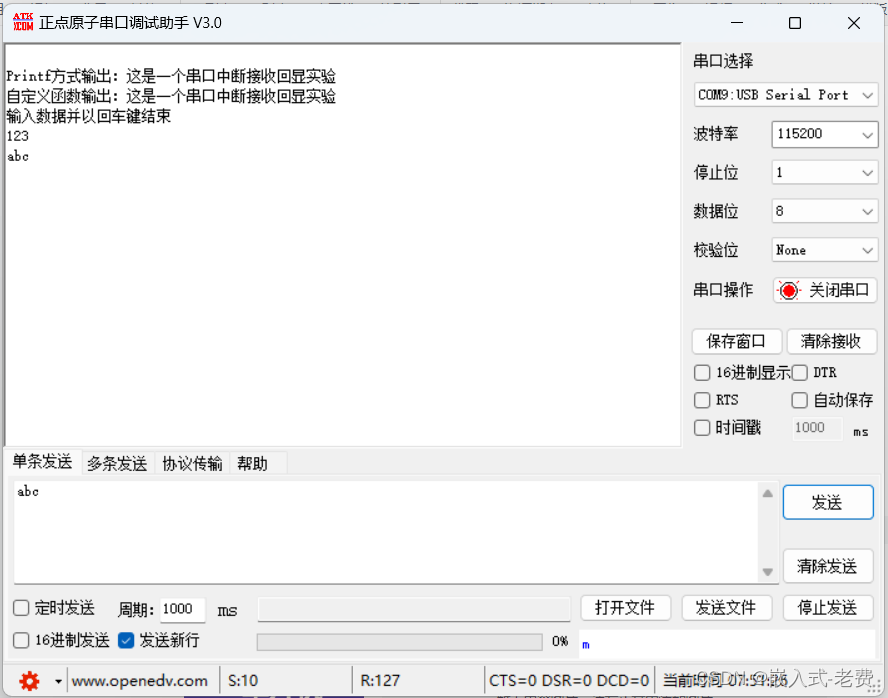

在autodl平台中租一个单卡3090等24G显存的显卡机器,如下图所示镜像选择PyTorch–>2.1.0–>3.10(ubuntu22.04)–>12.1

接下来打开刚刚租用服务器的JupyterLab, 图像 并且打开其中的终端开始环境配置、模型下载和运行演示。

注意:这里要选择一个

cpu是intel的机器,amd的cpu有可能会导致deepspeed zero2 offload加载失败。

接下来打开刚刚租用服务器的JupyterLab,并且打开其中的终端开始环境配置、模型下载和运行demo。

pip换源和安装依赖包

# 升级pip

python -m pip install --upgrade pip

# 更换 pypi 源加速库的安装

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

pip install modelscope transformers sentencepiece accelerate langchain

MAX_JOBS=8 pip install flash-attn --no-build-isolation

pip install peft deepspeed

注意:flash-attn 安装会比较慢,大概需要十几分钟。

模型下载

使用 modelscope 中的snapshot_download函数下载模型,第一个参数为模型名称,参数cache_dir为模型的下载路径。

在 /root/autodl-tmp 路径下新建 download.py 文件并在其中输入以下内容,粘贴代码后记得保存文件,如下图所示。并运行 python /root/autodl-tmp/download.py执行下载,模型大小为 10 GB,下载模型大概需要 5~10 分钟

import torch

from modelscope import snapshot_download, AutoModel, AutoTokenizer

import os

model_dir = snapshot_download('OpenBMB/MiniCPM-2B-sft-fp32', cache_dir='/root/autodl-tmp', revision='master')

数据集构建

LLM 的微调一般指指令微调过程。所谓指令微调,是说我们使用的微调数据形如:

{

"instrution":"回答以下用户问题,仅输出答案。",

"input":"1+1等于几?",

"output":"2"

}

其中,instruction 是用户指令,告知模型其需要完成的任务;input 是用户输入,是完成用户指令所必须的输入内容;output 是模型应该给出的输出。

即我们的核心训练目标是让模型具有理解并遵循用户指令的能力。因此,在指令集构建时,我们应针对我们的目标任务,针对性构建任务指令集。例如,在本节我们使用由笔者合作开源的 Chat-甄嬛 项目作为示例,我们的目标是构建一个能够模拟甄嬛对话风格的个性化 LLM,因此我们构造的指令形如:

{

"instruction": "现在你要扮演皇帝身边的女人--甄嬛",

"input":"你是谁?",

"output":"家父是大理寺少卿甄远道。"

}

我们所构造的全部指令数据集在根目录的dataset下。

数据格式化

Lora 训练的数据是需要经过格式化、编码之后再输入给模型进行训练的,如果是熟悉 Pytorch 模型训练流程的同学会知道,我们一般需要将输入文本编码为 input_ids,将输出文本编码为 labels,编码之后的结果都是多维的向量。我们首先定义一个预处理函数,这个函数用于对每一个样本,编码其输入、输出文本并返回一个编码后的字典:

def process_func(example):

MAX_LENGTH = 512 # Llama分词器会将一个中文字切分为多个token,因此需要放开一些最大长度,保证数据的完整性

input_ids, attention_mask, labels = [], [], []

instruction = tokenizer(f"<用户>{example['instruction']+example['input']}<AI>", add_special_tokens=False) # add_special_tokens 不在开头加 special_tokens

response = tokenizer(f"{example['output']}", add_special_tokens=False)

input_ids = instruction["input_ids"] + response["input_ids"] + [tokenizer.pad_token_id]

attention_mask = instruction["attention_mask"] + response["attention_mask"] + [1] # 因为eos token咱们也是要关注的所以 补充为1

labels = [-100] * len(instruction["input_ids"]) + response["input_ids"] + [tokenizer.pad_token_id]

if len(input_ids) > MAX_LENGTH: # 做一个截断

input_ids = input_ids[:MAX_LENGTH]

attention_mask = attention_mask[:MAX_LENGTH]

labels = labels[:MAX_LENGTH]

return {

"input_ids": input_ids,

"attention_mask": attention_mask,

"labels": labels

}

MiniCPM 所使用的 Prompt_Template为transformers默认的Prompt_Template,感兴趣的同学可以在transformers仓库查看源码构造哦~

加载模型

模型以半精度形式加载,如果你的显卡比较新的话,可以用torch.bfolat形式加载。对于自定义的模型一定要指定trust_remote_code参数为True。

tokenizer = AutoTokenizer.from_pretrained('./OpenBMB/miniCPM-bf32', use_fast=False, trust_remote_code=True)

tokenizer.padding_side = 'right'

tokenizer.pad_token_id = tokenizer.eos_token_id

model = AutoModelForCausalLM.from_pretrained('./OpenBMB/miniCPM-bf32', trust_remote_code=True, torch_dtype=torch.half, device_map="auto")

定义LoraConfig

LoraConfig这个类中可以设置很多参数,但主要的参数没多少,简单讲一讲,感兴趣的同学可以直接看源码。

task_type:模型类型target_modules:需要训练的模型层的名字,主要就是attention部分的层,不同的模型对应的层的名字不同,可以传入数组,也可以字符串,也可以正则表达式。r:lora的秩,具体可以看Lora原理lora_alpha:Lora alaph,具体作用参见Lora原理

config = LoraConfig(

task_type=TaskType.CAUSAL_LM,

target_modules=["q_proj", "k_proj", "v_proj", "o_proj"],

inference_mode=False, # 训练模式

r=8, # Lora 秩

lora_alpha=32, # Lora alaph,具体作用参见 Lora 原理

lora_dropout=0.1# Dropout 比例

)

注意:如果要进行全量微调的话,可以在加载模型的时候选择不加载

LoraConfig。

自定义 TrainingArguments 参数

TrainingArguments这个类的源码也介绍了每个参数的具体作用,当然大家可以来自行探索,这里就简单说几个常用的。

output_dir:模型的输出路径per_device_train_batch_size:顾名思义batch_sizegradient_accumulation_steps: 梯度累加,如果你的显存比较小,那可以把batch_size设置小一点,梯度累加增大一些。logging_steps:多少步,输出一次lognum_train_epochs:顾名思义epoch

等等,还有很多参数可以调整,感兴趣的同学可以去看看transformers的源码哦,也欢迎各位同学来给本项目提交PR哦~

使用deepspeed训练

deepspeed 是一个分布式训练的工具,可以很方便的进行分布式训练,这里我们使用deepspeed进行训练。

- 如果你要进行

lora训练,那请在train.py中将67行代码的注释取消掉,然后运行train.sh脚本即可。

lora 训练大概需要14G显存左右,因为没有开梯度检查所以显存占用会多一点。

# 创建模型并以半精度形式加载

model = AutoModelForCausalLM.from_pretrained(finetune_args.model_path, trust_remote_code=True, torch_dtype=torch.half, device_map={"": int(os.environ.get("LOCAL_RANK") or 0)})

model = get_peft_model(model, config)

- 全量训练直接运行

train.sh脚本即可。

全量训练,大概需要22G显存左右,因为开启了deepspeed zero2 的 cpu offload 功能,优化器参数会加载到cpu上进行计算,所以降低了显存。

完整train.py源码

from datasets import Dataset

import pandas as pd

from transformers import AutoTokenizer, AutoModelForCausalLM, DataCollatorForSeq2Seq, TrainingArguments, HfArgumentParser, Trainer

import os

import torch

from peft import LoraConfig, TaskType, get_peft_model

from dataclasses import dataclass, field

import deepspeed

deepspeed.ops.op_builder.CPUAdamBuilder().load()

@dataclass

class FinetuneArguments:

# 微调参数

# field:dataclass 函数,用于指定变量初始化

model_path: str = field(default="./OpenBMB/miniCPM-bf32")

# 用于处理数据集的函数

def process_func(example):

MAX_LENGTH = 512 # Llama分词器会将一个中文字切分为多个token,因此需要放开一些最大长度,保证数据的完整性

input_ids, attention_mask, labels = [], [], []

instruction = tokenizer(f"<用户>{example['instruction']+example['input']}<AI>", add_special_tokens=False) # add_special_tokens 不在开头加 special_tokens

response = tokenizer(f"{example['output']}", add_special_tokens=False)

input_ids = instruction["input_ids"] + response["input_ids"] + [tokenizer.pad_token_id]

attention_mask = instruction["attention_mask"] + response["attention_mask"] + [1] # 因为eos token咱们也是要关注的所以 补充为1

labels = [-100] * len(instruction["input_ids"]) + response["input_ids"] + [tokenizer.pad_token_id]

if len(input_ids) > MAX_LENGTH: # 做一个截断

input_ids = input_ids[:MAX_LENGTH]

attention_mask = attention_mask[:MAX_LENGTH]

labels = labels[:MAX_LENGTH]

return {

"input_ids": input_ids,

"attention_mask": attention_mask,

"labels": labels

}

# loraConfig

config = LoraConfig(

task_type=TaskType.CAUSAL_LM,

target_modules=["q_proj", "v_proj"], # 这个不同的模型需要设置不同的参数,需要看模型中的attention层

inference_mode=False, # 训练模式

r=8, # Lora 秩

lora_alpha=32, # Lora alaph,具体作用参见 Lora 原理

lora_dropout=0.1# Dropout 比例

)

if "__main__" == __name__:

# 解析参数

# Parse 命令行参数

finetune_args, training_args = HfArgumentParser(

(FinetuneArguments, TrainingArguments)

).parse_args_into_dataclasses()

# 处理数据集

# 将JSON文件转换为CSV文件

df = pd.read_json('./huanhuan.json')

ds = Dataset.from_pandas(df)

# 加载tokenizer

tokenizer = AutoTokenizer.from_pretrained(finetune_args.model_path, use_fast=False, trust_remote_code=True)

tokenizer.padding_side = 'right'

tokenizer.pad_token_id = tokenizer.eos_token_id

# 将数据集变化为token形式

tokenized_id = ds.map(process_func, remove_columns=ds.column_names)

# 创建模型并以半精度形式加载

model = AutoModelForCausalLM.from_pretrained(finetune_args.model_path, trust_remote_code=True, torch_dtype=torch.half, device_map={"": int(os.environ.get("LOCAL_RANK") or 0)})

# model = get_peft_model(model, config)

# 使用trainer训练

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_id,

data_collator=DataCollatorForSeq2Seq(tokenizer=tokenizer, padding=True),

)

trainer.train() # 开始训练

trainer.save_model() # 保存模型

train.sh

num_gpus=1

deepspeed --num_gpus $num_gpus train.py \

--deepspeed ./ds_config.json \

--output_dir="./output/MiniCPM" \

--per_device_train_batch_size=4 \

--gradient_accumulation_steps=4 \

--logging_steps=10 \

--num_train_epochs=3 \

--save_steps=500 \

--learning_rate=1e-4 \

--save_on_each_node=True \