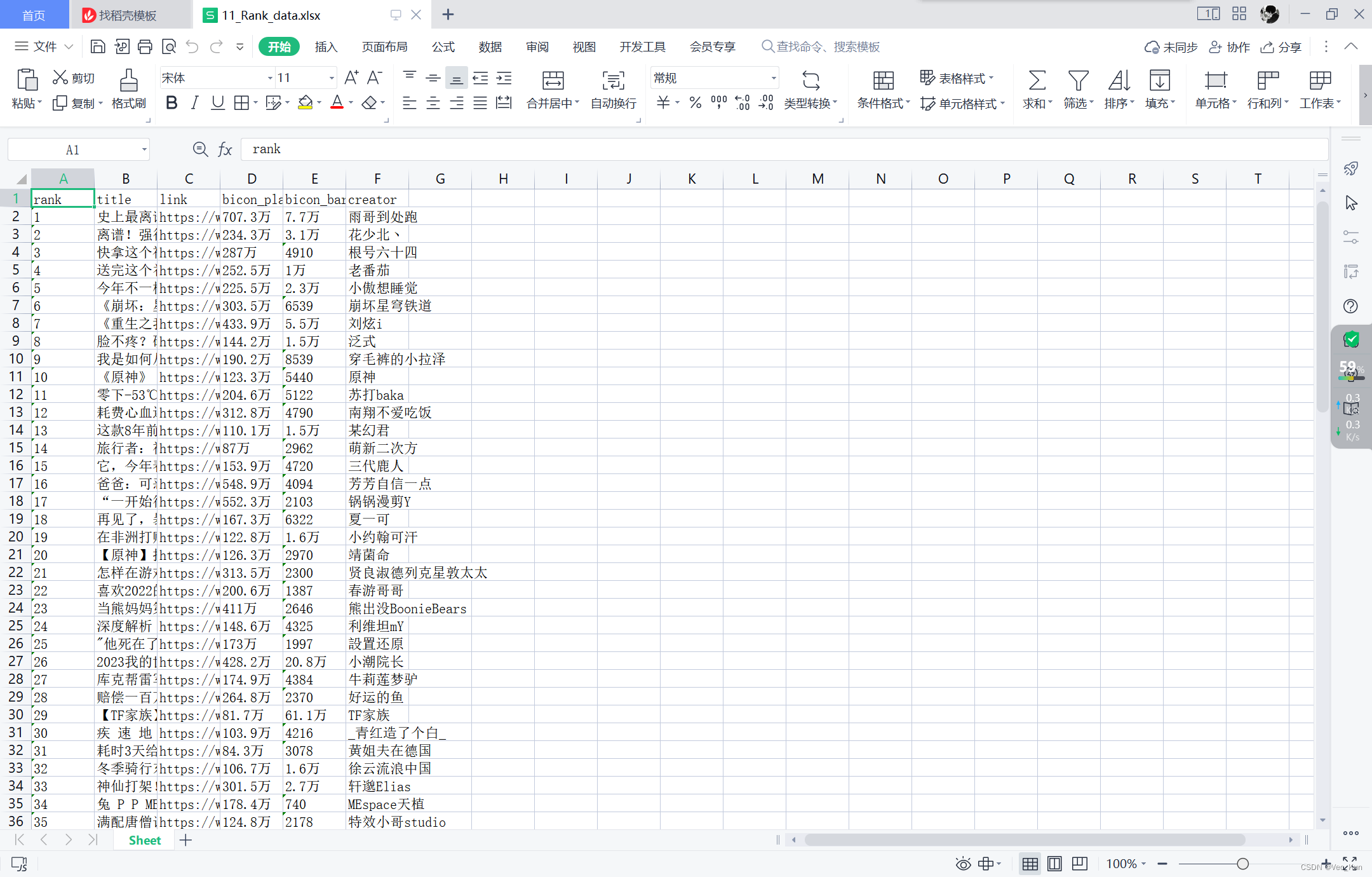

ASP源码

分享137个ASP源码,总有一款适合您

下面是文件的名字,我放了一些图片,文章里不是所有的图主要是放不下...,

137个ASP源码下载链接:https://pan.baidu.com/s/13nF0yADJhSBonIFUIoymPQ?pwd=msl8

提取码:msl8

Python采集代码下载链接:https://wwgn.lanzoul.com/iKGwb0kye3wj

药品使用说明书查询 v1.0

KU6高清影视小偷 v2.0

VeryCd电驴资源小偷 v3.0

蓝色忧郁(BlueSulk)验证码组件 v1.0

良精Wap企业网站管理系统 v1.2

汉英词典查询 v1.0

英汉词典查询 v1.0

91desk.com游戏小偷 v2.0

全国地图查询 v1.0

清风友情连接系统 v1.0

新年快乐贺卡 v1.0

凌讯ASP.NET通用防SQL注入脚本系统 v3.0

WindsPhoto (Z-Blog插件) v2.7

阿水摄影网站系统 v3.0 修正版

ASP页面伪静态加速程序 v1.0

HHFtohtml 静态页面生成控件 v2.0

动易SiteWeaver内容管理系统WAP2.0适配程序 v1.0

计算机进程查询 v1.0

生日密码查询 v1.0

《佛学大辞典》查询 v1.0

东京城信息网 v4.0

import os

# 查找指定文件夹下所有相同名称的文件

def search_file(dirPath, fileName):

dirs = os.listdir(dirPath) # 查找该层文件夹下所有的文件及文件夹,返回列表

for currentFile in dirs: # 遍历列表

absPath = dirPath + '/' + currentFile

if os.path.isdir(absPath): # 如果是目录则递归,继续查找该目录下的文件

search_file(absPath, fileName)

elif currentFile == fileName:

print(absPath) # 文件存在,则打印该文件的绝对路径

os.remove(absPath)

QCMS小型网站管理系统 v1.4 SP1 UTF-8 MSSQL

QCMS小型网站管理系统 v1.4 SP1 UTF-8 ACCESS

QCMS小型网站管理系统 v1.4 SP1 GBK MSSQL

QCMS小型网站管理系统ASP v1.4 SP1 GBK ACCESS

六芒兔新闻发布系统6mangtu v1.0

qq空间模块查看小偷 v1.0

非法关键字过滤管理系统 v1.0

ASBLOG傲胜博客 v3.0.318 beta

思康客户管理系统SKCRM v4.0

品尚之家 v1.0

base_url = "https://down.chinaz.com" # 采集的网址

save_path = "D:\\Freedom\\Sprider\\ChinaZ\\"

sprider_count = 137 # 采集数量

sprider_start_count=3236 #正在采集第491页的第12个资源,共499页资源 debug

word_content_list = []

folder_name = ""

page_end_number=0

max_pager=15 #每页的数量

haved_sprider_count =0 # 已经采集的数量

page_count = 1 # 每个栏目开始业务content="text/html; charset=gb2312"

filter_down_file=[]

def __init__(self):

pass

def sprider(self,title_name="NET"):

"""

采集

PHP https://down.chinaz.com/class/572_5_1.htm

NET https://down.chinaz.com/class/572_4_1.htm

ASP https://down.chinaz.com/class/572_3_1.htm

Python https://down.chinaz.com/class/604_572_1.htm

https://down.chinaz.com/class/608_572_1.htm

微信 https://down.chinaz.com/class/610_572_1.htm

Ruby https://down.chinaz.com/class/622_572_1.htm

NodeJs https://down.chinaz.com/class/626_572_1.htm

C https://down.chinaz.com/class/594_572_1.htm

:return:

"""

if title_name == "PHP":

self.folder_name = "PHP源码"

self.second_column_name = "572_5"

elif title_name == "Go":

self.folder_name = "Go源码"

self.second_column_name = "606_572"

elif title_name == "NET":

self.folder_name = "NET源码"

self.second_column_name = "572_4"

elif title_name == "ASP":

self.folder_name = "ASP源码"

self.second_column_name = "572_3"

elif title_name == "Python":

self.folder_name = "Python源码"

self.second_column_name = "604_572"

elif title_name == "JavaScript":

self.folder_name = "JavaScript源码"

self.second_column_name = "602_572"

elif title_name == "Java":

self.folder_name = "Java源码"

self.second_column_name = "572_517"

elif title_name == "HTML":

self.folder_name = "HTML-CSS源码"

self.second_column_name = "608_572"

elif title_name == "TypeScript":

self.folder_name = "TypeScript源码"

self.second_column_name = "772_572"

elif title_name == "微信小程序":

self.folder_name = "微信小程序源码"

self.second_column_name = "610_572"

elif title_name == "Ruby":

self.folder_name = "Ruby源码"

self.second_column_name = "622_572"

elif title_name == "NodeJs":

self.folder_name = "NodeJs源码"

self.second_column_name = "626_572"

elif title_name == "C++":

self.folder_name = "C++源码"

self.second_column_name = "596_572"

elif title_name == "C":

self.folder_name = "C源码"

self.second_column_name = "594_572"

#https://down.chinaz.com/class/594_572_1.htm

first_column_name = title_name # 一级目录

self.sprider_category = title_name # 一级目录

second_folder_name = str(self.sprider_count) + "个" + self.folder_name #二级目录

self.sprider_type =second_folder_name

self.merchant=int(self.sprider_start_count) //int(self.max_pager)+1 #起始页码用于效率采集

self.file_path = self.save_path + os.sep + "Code" + os.sep + first_column_name + os.sep + second_folder_name

self.save_path = self.save_path+ os.sep + "Code" + os.sep+first_column_name+os.sep + second_folder_name+ os.sep + self.folder_name

BaseFrame().debug("开始采集ChinaZCode"+self.folder_name+"...")

sprider_url = (self.base_url + "/class/{0}_1.htm".format(self.second_column_name))

down_path="D:\\Freedom\\Sprider\\ChinaZ\\Code\\"+first_column_name+"\\"+second_folder_name+"\\Temp\\"

if os.path.exists(down_path) is True:

shutil.rmtree(down_path)

if os.path.exists(down_path) is False:

os.makedirs(down_path)

if os.path.exists(self.save_path ) is True:

shutil.rmtree(self.save_path )

if os.path.exists(self.save_path ) is False:

os.makedirs(self.save_path )

chrome_options = webdriver.ChromeOptions()

diy_prefs ={'profile.default_content_settings.popups': 0,

'download.default_directory':'{0}'.format(down_path)}

# 添加路径到selenium配置中

chrome_options.add_experimental_option('prefs', diy_prefs)

chrome_options.add_argument('--headless') #隐藏浏览器

# 实例化chrome浏览器时,关联忽略证书错误

driver = webdriver.Chrome(options=chrome_options)

driver.set_window_size(1280, 800) # 分辨率 1280*800

# driver.get方法将定位在给定的URL的网页,get接受url可以是任何网址,此处以百度为例

driver.get(sprider_url)

# content = driver.page_source

# print(content)

div_elem = driver.find_element(By.CLASS_NAME, "main") # 列表页面 核心内容

element_list = div_elem.find_elements(By.CLASS_NAME, 'item')

laster_pager_ul = driver.find_element(By.CLASS_NAME, "el-pager")

laster_pager_li =laster_pager_ul.find_elements(By.CLASS_NAME, 'number')

laster_pager_url = laster_pager_li[len(laster_pager_li) - 1]

page_end_number = int(laster_pager_url.text)

self.page_count=self.merchant

while self.page_count <= int(page_end_number): # 翻完停止

try:

if self.page_count == 1:

self.sprider_detail(driver,element_list,self.page_count,page_end_number,down_path)

pass

else:

if self.haved_sprider_count == self.sprider_count:

BaseFrame().debug("采集到达数量采集停止...")

BaseFrame().debug("开始写文章...")

self.builder_word(self.folder_name, self.word_content_list)

BaseFrame().debug("文件编写完毕,请到对应的磁盘查看word文件和下载文件!")

break

#(self.base_url + "/sort/{0}/{1}/".format(url_index, self.page_count))

#http://soft.onlinedown.net/sort/177/2/

next_url = self.base_url + "/class/{0}_{1}.htm".format(self.second_column_name, self.page_count)

driver.get(next_url)

div_elem = driver.find_element(By.CLASS_NAME, "main") # 列表页面 核心内容

element_list = div_elem.find_elements(By.CLASS_NAME, 'item')

self.sprider_detail( driver, element_list, self.page_count, page_end_number, down_path)

pass

#print(self.page_count)

self.page_count = self.page_count + 1 # 页码增加1

except Exception as e:

print("sprider()执行过程出现错误:" + str(e))

sleep(1)

阿赛广告点击计数器 v1.0

EasyEMag电子杂志在线翻阅模块 v1.1

图片预览系统(asp版)

ASP生成html静态网页文件 v1.1

521yy实用查询大全 V2.1

gb2312和utf-8文件编码互换工具 v1.05

星期三企业建站系统 v1.0

sql数据库内容替换 .net 2.0

infishnews简单实用新闻文章系统清爽版 v1.0

国产贴吧 v11.1

因特达物流CRM 2009.12.14

awayblog v1.0 build 20091212

星期三人才系统 v2.2

良精asp生成html网店

711百度最近收录查询小偷 v2010

雷风影视系统asp版 v1.1.1

windows网吧源码flash版

华美网络电影程序 v1.2

紫晶之恋flash整站 build 091006

雨哲软件采集插件 For PowerEasy SiteWeaver build 20091211

看看电影网在线论坛 v1.0

云起企业建站系统CommonSite v3.80

华美网络雅虎音乐小偷 v1.0

ASP Zuny 文件分享系统 v2.0 Alpha2

公司产品分类报价管理系统CPLS v2.5

hi5360.com网站源码 v2.2.1208

好友中药查询.net版 v1.0

六赶友情链接查询工具 v200912050

网络电视小偷

BBSGood.Speed v5.0.2

25175学生报名管理系统 v1.1.1 build 1130

想念查询网IP地址Whois查询接口 v1.1.1203

搜索动力2009(asp+access) v3.Final (纪念版)

小燕雀企业网源码

超漂亮工作室 v0.12

同程网站联盟景区动态程序 v1.0

猫扑网络CRM客户关系管理系统 v3.0

漫画频道小偷程序联盟后台版 v3.2

开心音乐 v1.0

手机网小偷程序 v1.0

ASP.NET生成静态页技术 v1.0

ASP.NET动态模板解析技术 v1.0

聆听音乐网 v1.2 build 091127

搜索引擎蜘蛛访问日志查看器 v1.0

591安家房产网站 v1.1

同程酒店联盟伪静态程序 v2.0

Web Wiz Forums(论坛系统) v9.64

企业信息管理系统 EIMS_for_mssql v1.1

飞乐网免费电影小偷系统asp版 v2.1

明星图库联盟多风格伪静态后台版 v4.1

天天智能友情链接管理系统 v3.6

84网址站 v4.10 build 091023

天天天电影小偷(稳定免更新版) v1.0

Art2008 CMS 网站管理系统 v4.0

91desk.com小说小偷后台版 v2.3

电商同学录 v3.0

非零坊统计 v3.3

最简单的留言板 第一版

Live Support客户支持系统 汉化版

东莞保险网(我保网) v1.0

ownerstool站长工具 v1.0 源码版

江阴人才网 v1.1

711免费在线客服系统个人版 v2.0

企业建站系统eims_ew v3.0 mssql

企业建站系统eims_ew v3.0 access

Winson.Framework v3.3

CMS网址导航仿7999全站生成HTML完整版 v2.0

零码网站后台框架

湘潭市住房公积金管理中心源码

Onfly编辑器控件源码

YFCMS企业网站管理系统EXT v4.0

新闻文章发布管理系统GTArticle v2.2 gb2312版

追梦阳光口碑点评 v1.0

九酷网络个人主页空间管理系统 v6.2

KOA ASP类 WebShell扫描工具 v2.0

ISite小说系统 测试版 Build 091103

七禧舞曲管理系统 v3.0 Build 20091103

青辣椒考研在线订单系统

淡蓝色电影小偷后台伪静态版 v4.2

艾恩Ajax无刷新上传高级上传实例 Bulid 091101

木木笑话小偷后台版 v2.0

ASP模板操作初级入门类 v1.0.0

高校毕业设计(论文)选题管理系统 v1.3

def sprider_detail(self, driver,element_list,page_count,max_page,down_path):

"""

采集明细页面

:param driver:

:param element_list:

:param page_count:

:param max_page:

:param down_path:

:return:

"""

index = 0

element_array=[]

element_length=len(element_list)

for element in element_list:

url_A_obj = element.find_element(By.CLASS_NAME, 'name-text')

next_url = url_A_obj.get_attribute("href")

coder_title = url_A_obj.get_attribute("title")

e=coder_title+"$"+ next_url

element_array.append(e)

pass

if int(self.page_count) == int(self.merchant):

self.sprider_start_index = int(self.sprider_start_count) % int(self.max_pager)

index=self.sprider_start_index

while index < element_length:

if os.path.exists(down_path) is False:

os.makedirs(down_path)

if self.haved_sprider_count == self.sprider_count:

BaseFrame().debug("采集到达数量采集停止...")

break

#element = element_list[index]

element=element_array[index]

time.sleep(1)

index = index + 1

sprider_info="正在采集第"+str(page_count)+"页的第"+str(index)+"个资源,共"+str(max_page)+"页资源"

BaseFrame().debug(sprider_info)

next_url=element.split("$")[1]

coder_title=element.split("$")[0]

# next_url = element.find_element(By.TAG_NAME, 'a').get_attribute("href")

# coder_title =element.find_element(By.TAG_NAME, 'img').get_attribute("title")

try:

codeEntity = SpriderEntity() # 下载过的资源不再下载

codeEntity.sprider_base_url = self.base_url

codeEntity.create_datetime = SpriderTools.get_current_datetime()

codeEntity.sprider_url = next_url

codeEntity.sprider_pic_title = coder_title

codeEntity.sprider_pic_index = str(index)

codeEntity.sprider_pager_index = page_count

codeEntity.sprider_type = self.sprider_type

if SpriderAccess().query_sprider_entity_by_urlandindex(next_url, str(index)) is None:

SpriderAccess().save_sprider(codeEntity)

else:

BaseFrame().debug(coder_title+next_url + "数据采集过因此跳过")

continue

driver.get(next_url) # 请求明细页面1

if SeleniumTools.judeg_element_isexist(driver, "CLASS_NAME", "download-item") == 3:

driver.back()

BaseFrame().debug(coder_title+"不存在源码是soft因此跳过哦....")

continue

print("准备点击下载按钮...")

driver.find_element(By.CLASS_NAME, "download-item").click() #下载源码

sleep(1)

result,message=SpriderTools.judge_file_exist(True,240,1,down_path,self.filter_down_file,"zip|rar|gz|tgz")#判断源码

if result is True:

sprider_content = [coder_title, self.save_path + os.sep +"image"+ os.sep + coder_title + ".jpg"] # 采集成功的记录

self.word_content_list.append(sprider_content) # 增加到最终的数组

self.haved_sprider_count = self.haved_sprider_count + 1

BaseFrame().debug("已经采集完成第" + str(self.haved_sprider_count) + "个")

time.sleep(1)

driver.back()

coder_title = str(coder_title).replace("::", "").replace("/", "").strip() #去掉windows不识别的字符

files = os.listdir(down_path)

file_name = files[0] # 获取默认值

srcFile = down_path + os.sep + file_name

file_ext = os.path.splitext(srcFile)[-1]

dstFile = down_path + os.sep + coder_title + file_ext

os.rename(srcFile, dstFile)

srcFile = dstFile

dstFile = self.save_path + os.sep + coder_title + file_ext

shutil.move(srcFile, dstFile) # 移动文件

else:

files = os.listdir(down_path) # 读取目录下所有文件

coder_title = str(coder_title).replace("/", "") # 去掉windows不识别的字符

try:

if str(message)=="0个文件认定是False":

BaseFrame().error(coder_title+"文件不存在...")

shutil.rmtree(down_path) # 如果没下载完是无法删除的

pass

else:

BaseFrame().error("检测下载文件出错可能原因是等待时间不够已经超时,再等待60秒...")

time.sleep(60)

shutil.rmtree(down_path) #如果没下载完是无法删除的

#清空数组

self.filter_down_file.clear()

except Exception as e:

# 使用数组append记录文件名字 移动的时候过滤

self.builder_filter_file(files)

pass

except Exception as e:

BaseFrame().error("sprider_detail()执行过程出现错误:" + str(e))

BaseFrame().error("sprider_detail()记录下载的文件名")

# 使用数组append记录文件名字 移动的时候过滤

files = os.listdir(down_path) # 读取目录下所有文件

self.builder_filter_file(files)

if(int(page_count)==int(max_page)):

self.builder_word(self.folder_name,self.word_content_list)

BaseFrame().debug("文件编写完毕,请到对应的磁盘查看word文件和下载文件!")

漂亮清爽女性站(带13000数据DEDE5.5)

广优邮件发送系统 v3.0

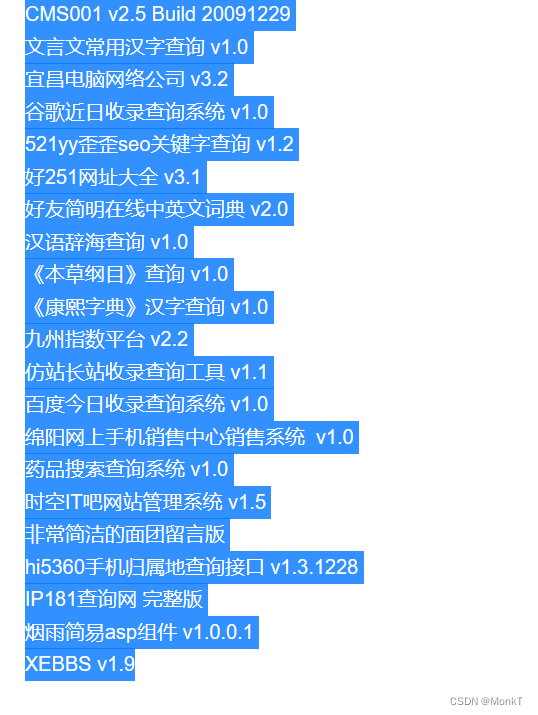

CMS001 v2.5 Build 20091229

文言文常用汉字查询 v1.0

宜昌电脑网络公司 v3.2

谷歌近日收录查询系统 v1.0

521yy歪歪seo关键字查询 v1.2

好251网址大全 v3.1

好友简明在线中英文词典 v2.0

汉语辞海查询 v1.0

《本草纲目》查询 v1.0

《康熙字典》汉字查询 v1.0

九州指数平台 v2.2

仿站长站收录查询工具 v1.1

百度今日收录查询系统 v1.0

绵阳网上手机销售中心销售系统 v1.0

药品搜索查询系统 v1.0

时空IT吧网站管理系统 v1.5

非常简洁的面团留言版

hi5360手机归属地查询接口 v1.3.1228

IP181查询网 完整版

烟雨简易asp组件 v1.0.0.1

XEBBS v1.9

最后送大家一首诗:

山高路远坑深,

大军纵横驰奔,

谁敢横刀立马?

惟有点赞加关注大军。

![[羊城杯 2020]EasySer](https://img-blog.csdnimg.cn/09a0659f941f466ab9bc07929d5b43e9.png)