文章目录

- 特征图尺寸计算与参数共享

- 池化层的作用

- 整体网络架构

- VGG网络架构(了解向,背景向)

- 残差网络Resnet(了解向,背景向)

- 感受野的作用

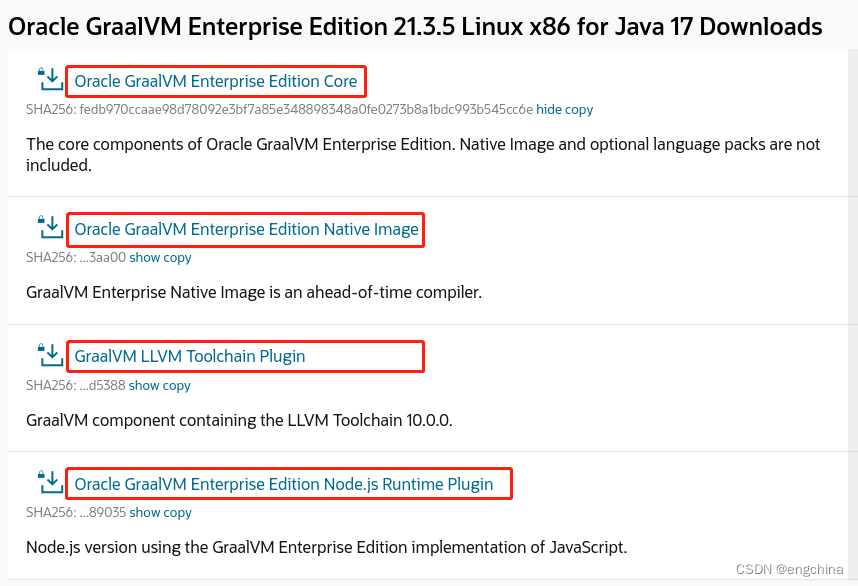

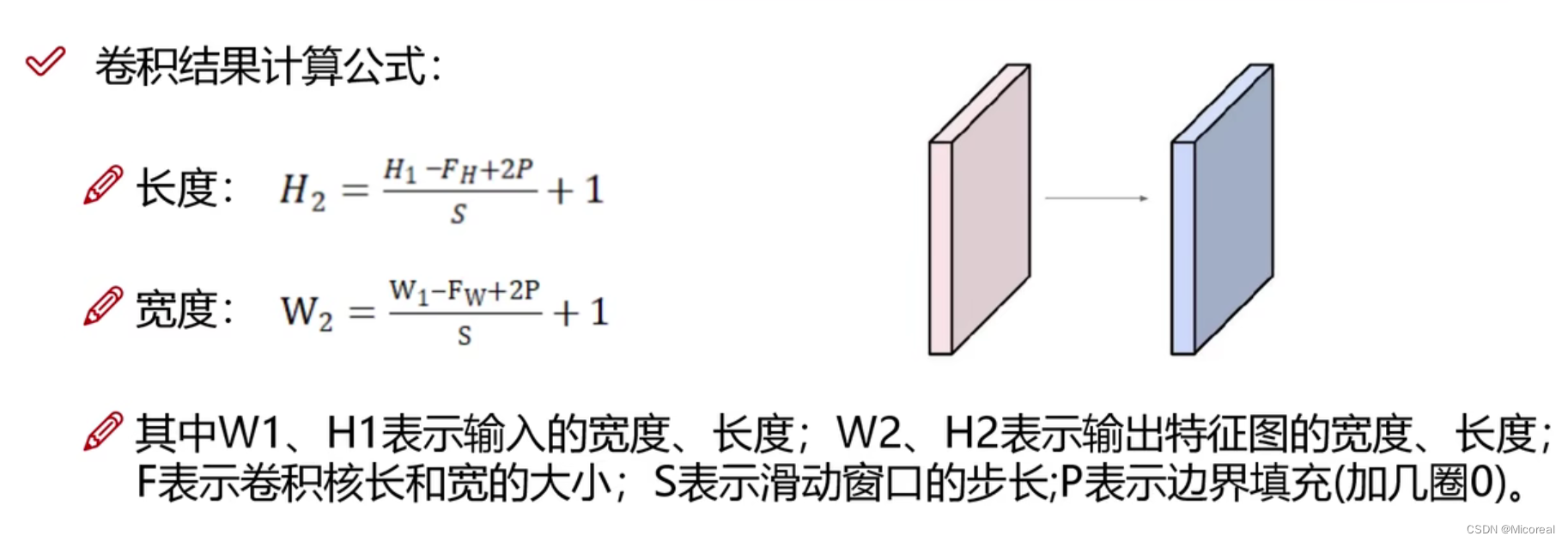

特征图尺寸计算与参数共享

给个例子:

如果输入的数据是32323的图像,用10个553的filter来进行卷积操作,指定步长为1,边界填充为2,最终的输入的规模为:

计算过程:

(32-5+22)/1+1 =32,所以输出的规模为3232*10。

卷积参数共享:

指的是对于不同的卷积核来说,其对应的权重是同一个。

池化层的作用

池化层的作用在于卷积层得出的数据过大,我们可以使用池化层进行压缩其内部特征点,达到简化的地步。

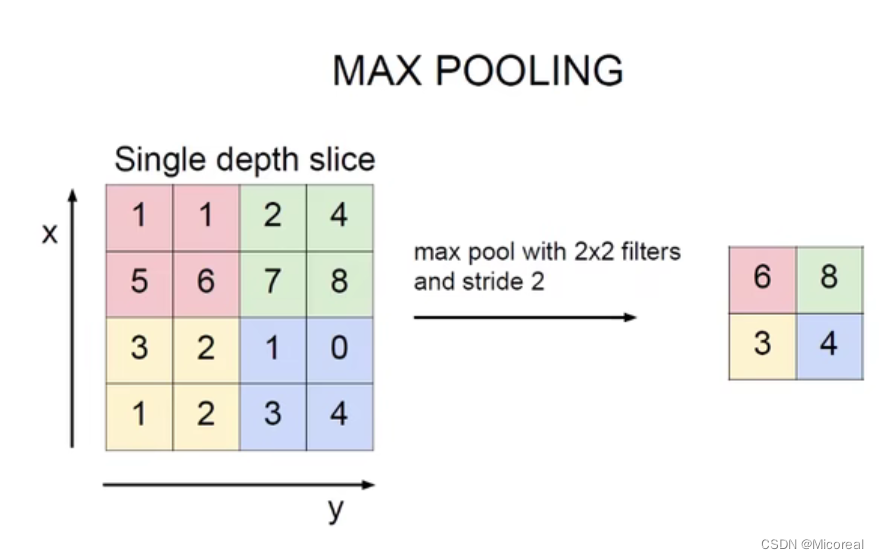

例子:最大池化

可以看出实际上就是在四个方块中进行取出最大的数,作为这所有特征部分的代表。

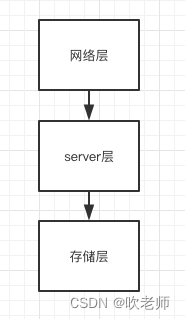

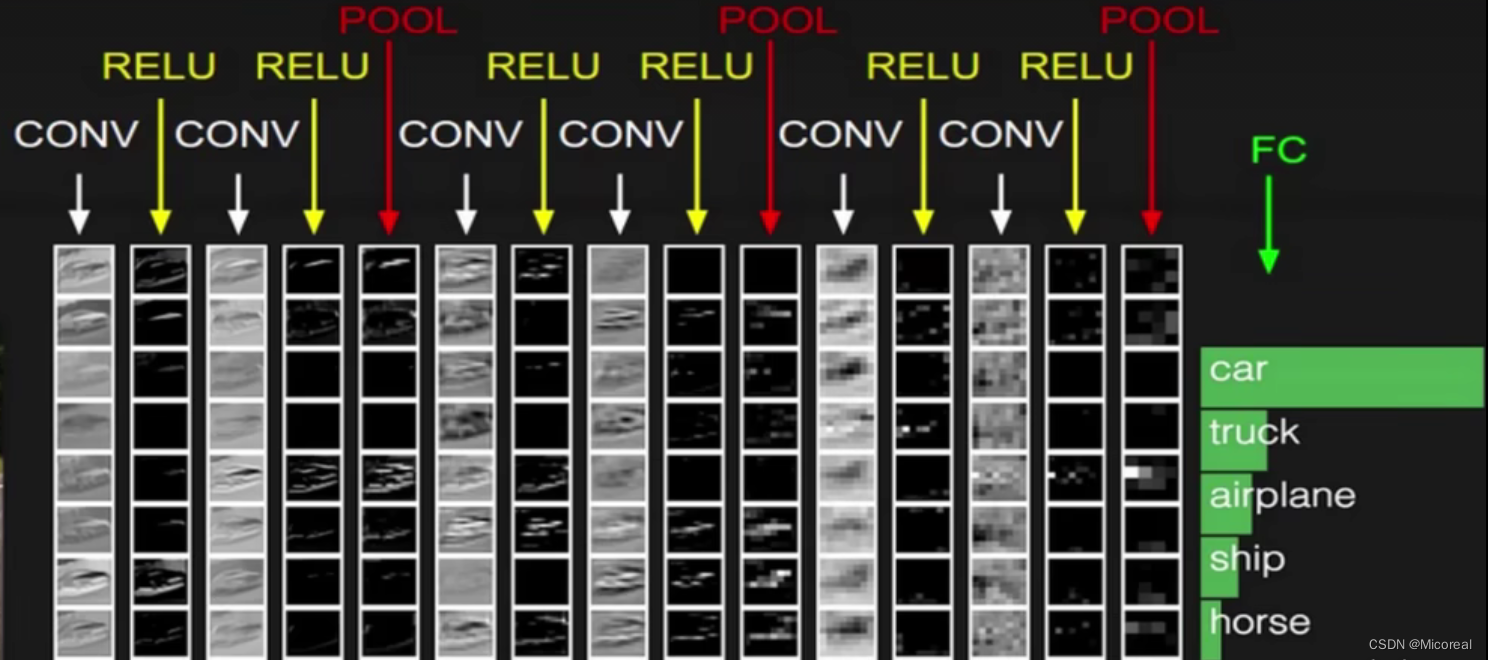

整体网络架构

整个卷积神经网络的过程:实际上就是先conv(卷积)再relu(激活函数),然后conv(卷积)再relu(激活函数)接着Pool(池化),等等,到最后的FC,但在FC的前一步是需要讲得到的三维的向量拉长变成一个一维向量(一条线),然后再去FC进行操作得到最后的概率。

对于神经网络仅有卷积层和最后的FC被当作层数对象。例如上述的照片就是一个7层的神经网络。

VGG网络架构(了解向,背景向)

-经典网络Alexnet(可以网络上百度了解一下)

-经典网络Vgg(可以网络上百度了解一下)

通过以此pool之后将下一次卷积之后让特征图翻倍,来弥补。

16层是基本最为理想化的神经网络。

残差网络Resnet(了解向,背景向)

-经典网络残差网络Resnet

通过Resnet的操作使得20,30,上千层的卷积神经网络的error率逐渐变好。

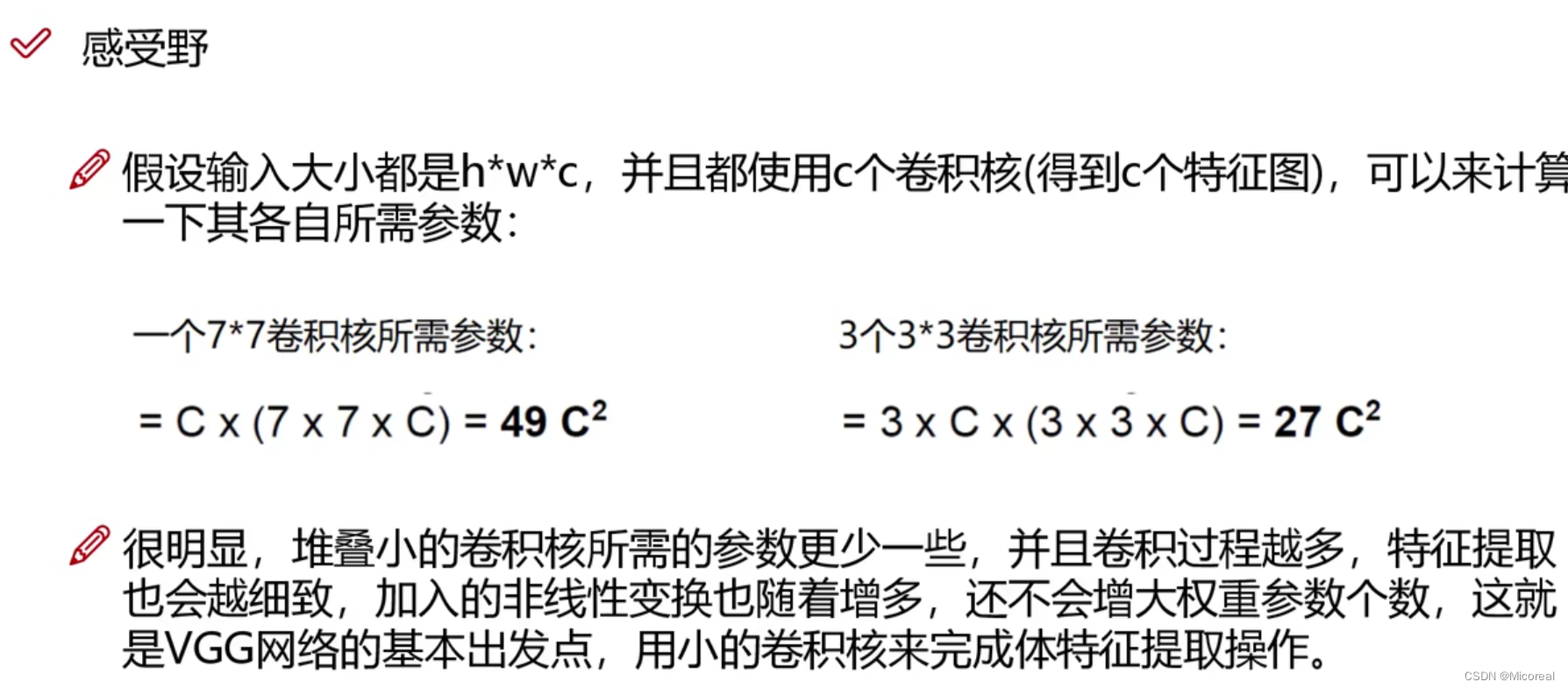

感受野的作用

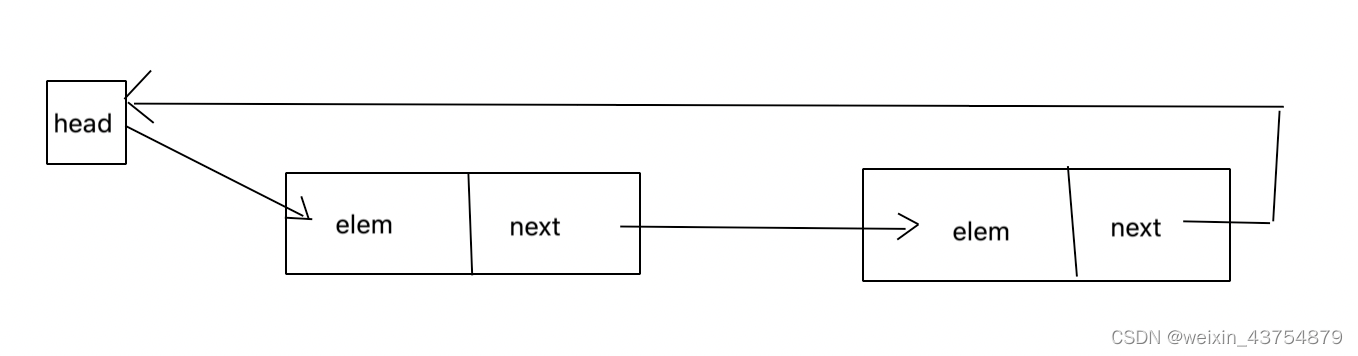

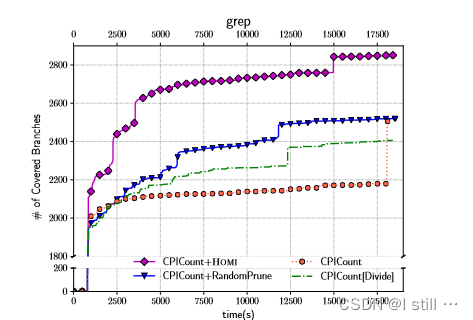

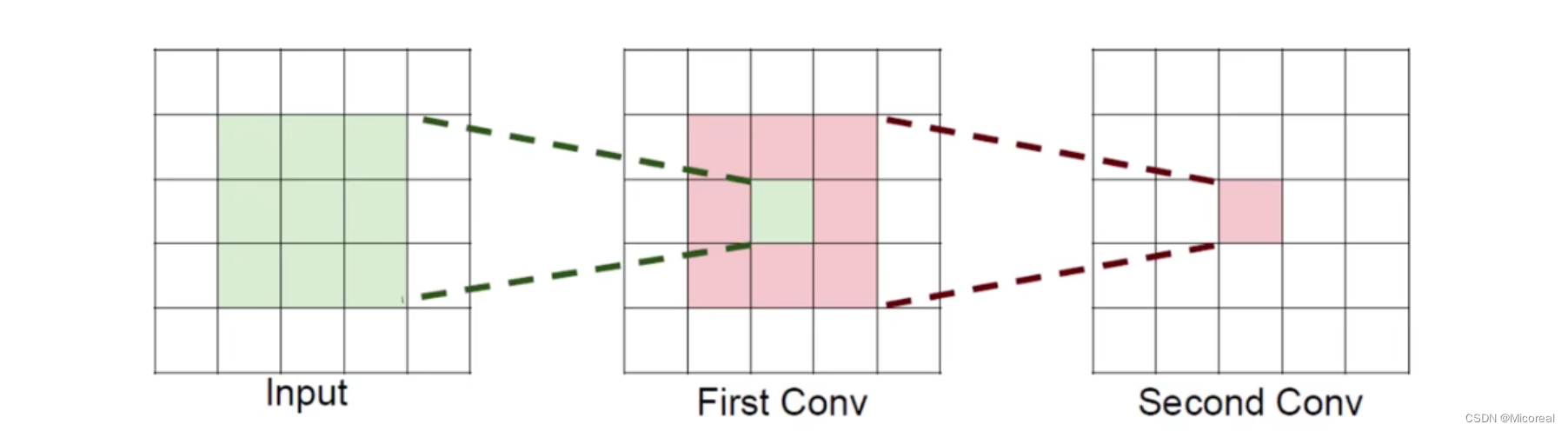

感受野(越大越好):拿下面的2层神经网络进行介绍:

对于First Conv当中的绿色区域来说它的感受野就是input当中的绿色33的区域块,因为他是由那三块区域计算得出的,那再次卷积之后呢,对于Second Conv来说最为中心的红色方块,他就是由First Conv当中的红色方块33区域计算得出的,也就是由input当中55的区域计算得出的,所以他的感受野就是55。